Command Palette

Search for a command to run...

vLLM+Open WebUI 導入 MiniCPM4-8B

1. チュートリアルの概要

OpenBMBが2025年6月6日にリリースしたMiniCPM 4.0は、高性能なエッジサイド大規模言語モデル(LLM)です。スパースアーキテクチャ、量子化圧縮、そして効率的な推論フレームワークにより、低い計算コストで高性能な推論を実現し、長文テキスト処理、プライバシーに配慮したシナリオ、そしてエッジコンピューティングデバイスの導入に特に適しています。MiniCPM4-8Bは、長いシーケンスの処理においてQwen3-8Bと比較して大幅に高速な処理速度を実証しています。関連研究論文もご覧いただけます。 MiniCPM4: エンドデバイス上の超高効率LLM 。

このチュートリアルでは、単一の RTX 4090 カードのリソースを使用します。

2. プロジェクト例

3. 操作手順

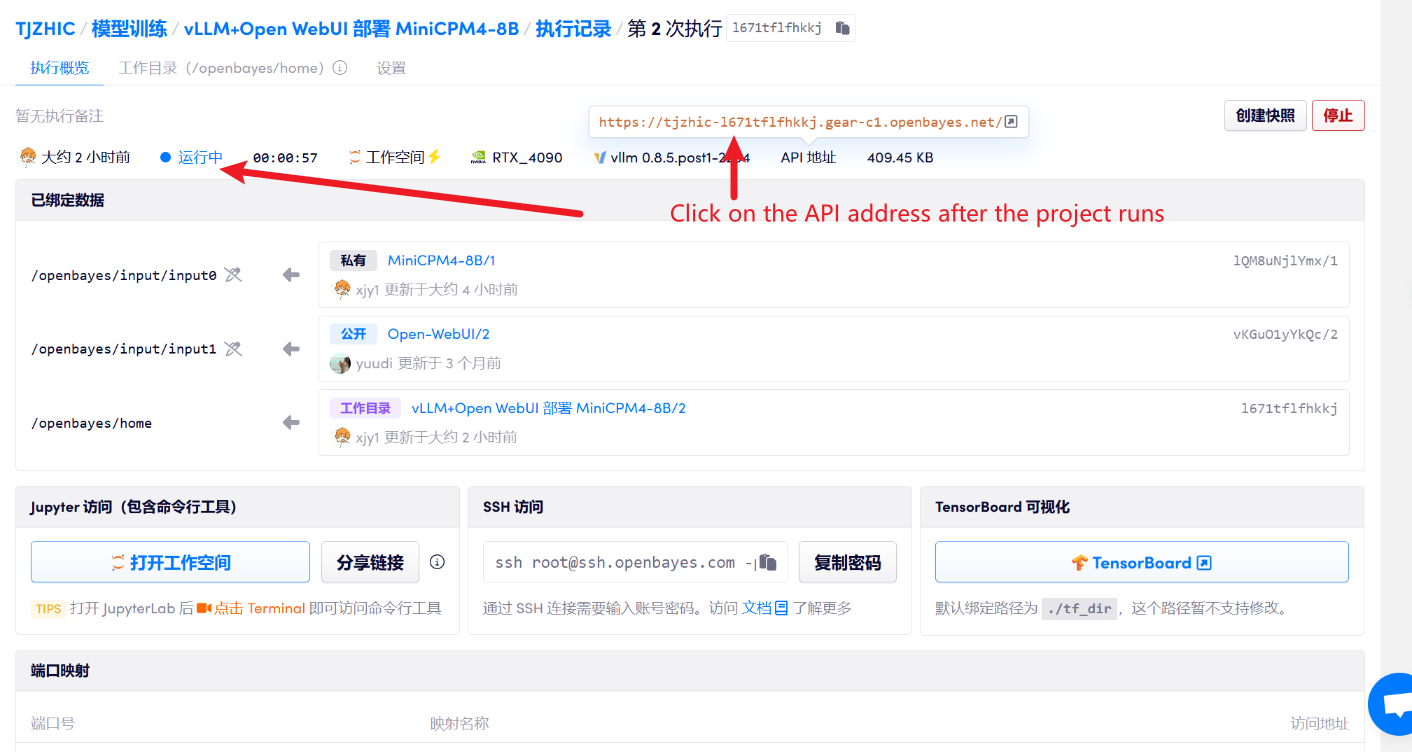

1. コンテナを起動した後、API アドレスをクリックして Web インターフェイスに入ります

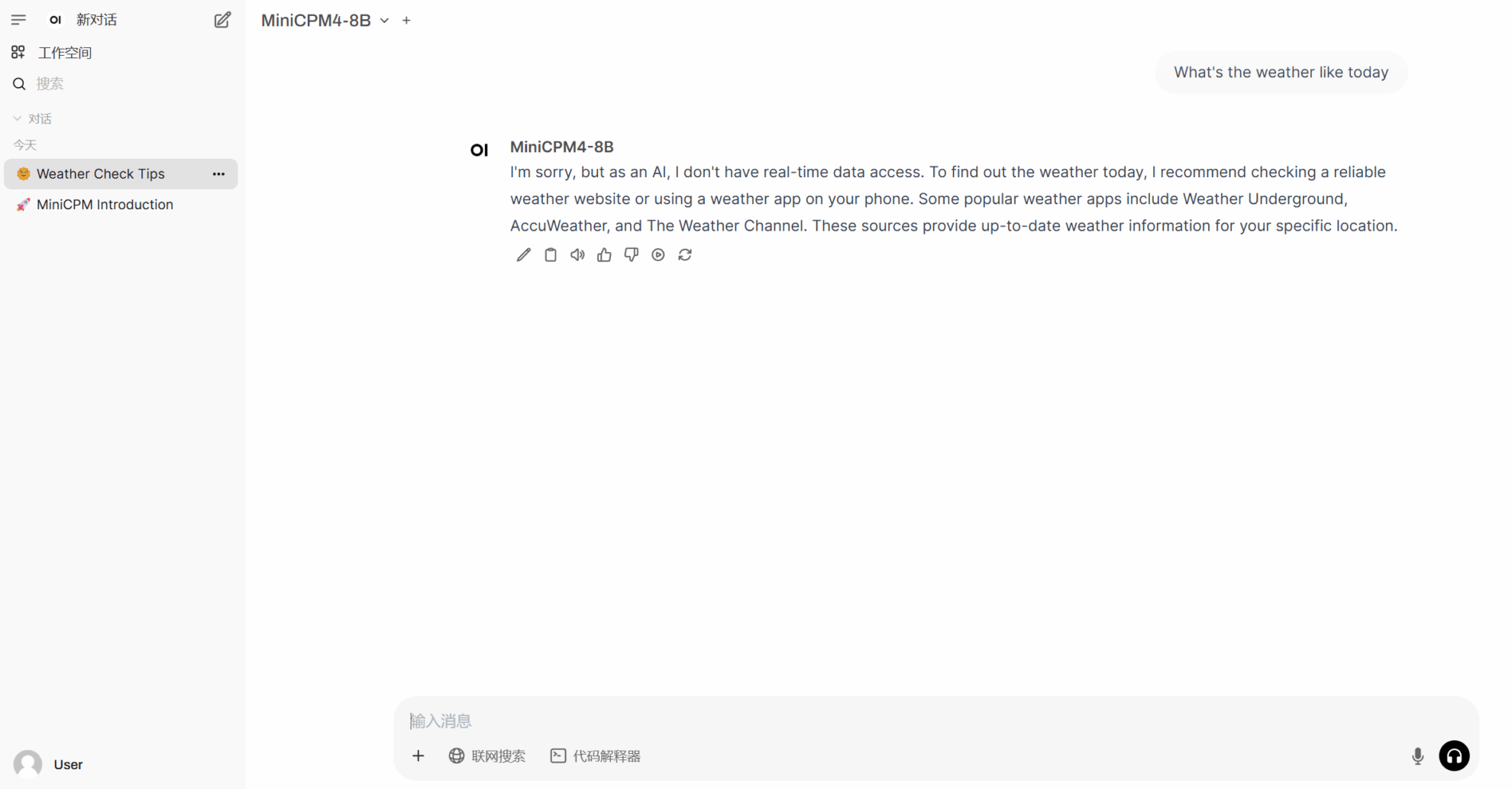

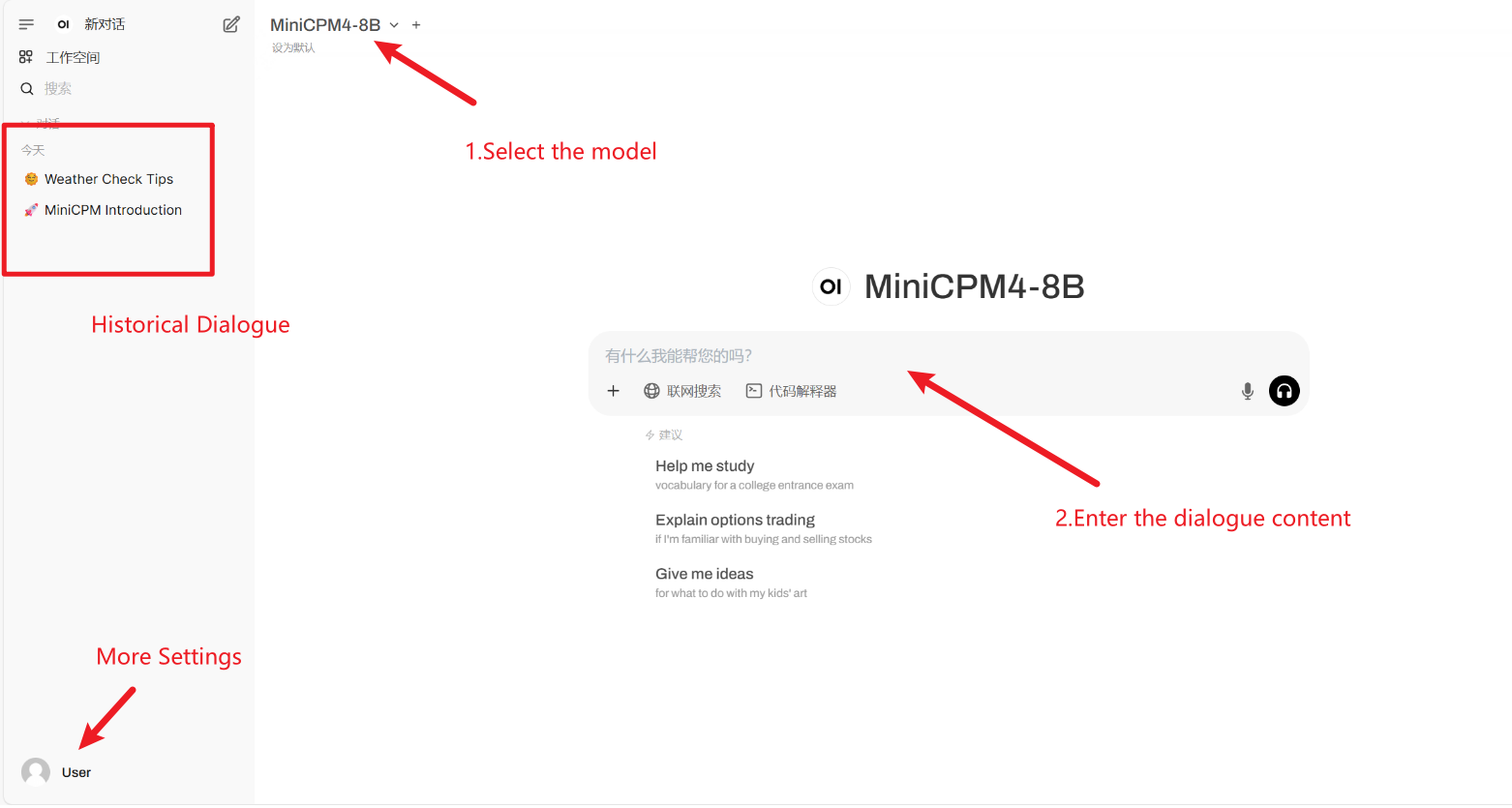

2. Web ページに入ると、モデルと会話を開始できます。

「モデル」が表示されない場合は、モデルが初期化中です。モデルのサイズが大きいため、2~3分ほどお待ちいただき、ページを更新してください。

利用手順

4. 議論

🖌️ 高品質のプロジェクトを見つけたら、メッセージを残してバックグラウンドで推奨してください。さらに、チュートリアル交換グループも設立しました。お友達はコードをスキャンして [SD チュートリアル] に参加し、さまざまな技術的な問題について話し合ったり、アプリケーションの効果を共有したりできます。

引用情報

Githubユーザーに感謝 xxxjjjyyy1 このチュートリアルの展開。このプロジェクトの引用情報は次のとおりです。

@article{minicpm4,

title={MiniCPM4: Ultra-Efficient LLMs on End Devices},

author={MiniCPM Team},

year={2025}

}

@inproceedings{huminicpm,

title={MiniCPM: Unveiling the Potential of Small Language Models with Scalable Training Strategies},

author={Hu, Shengding and Tu, Yuge and Han, Xu and Cui, Ganqu and He, Chaoqun and Zhao, Weilin and Long, Xiang and Zheng, Zhi and Fang, Yewei and Huang, Yuxiang and others},

booktitle={First Conference on Language Modeling},

year={2024}

}