Command Palette

Search for a command to run...

vLLM+Open WebUIデプロイメントII-Medical-8B医療推論モデル

1. チュートリアルの概要

II-Medical-8Bは、インテリジェントインターネット企業が新たに開発した高度な大規模言語モデルです。医療推論におけるAI機能の強化を目的として設計されており、従来のII-Medical-7B-Previewから大幅に改良され、医療分野の質問応答機能を大幅に向上させています。Qwen/Qwen3-8Bモデルをベースに、医療分野特有の推論データセットを用いた教師ありファインチューニングと、ハード推論データセットを用いたDAPO(最適化手法の一つ)の学習によって、モデルの性能が最適化されています。関連研究論文もご覧いただけます。 大規模言語モデルのトレーニングを強化する 140 万のオープンソースの蒸留推論データセット 。

このチュートリアルでは、単一の RTX 4090 カードのリソースを使用します。

2. プロジェクト例

3. 操作手順

1. コンテナを起動した後、API アドレスをクリックして Web インターフェイスに入ります

「モデル」が表示されない場合は、モデルが初期化中であることを意味します。モデルが大きいため、1〜2分ほど待ってからページを更新してください。

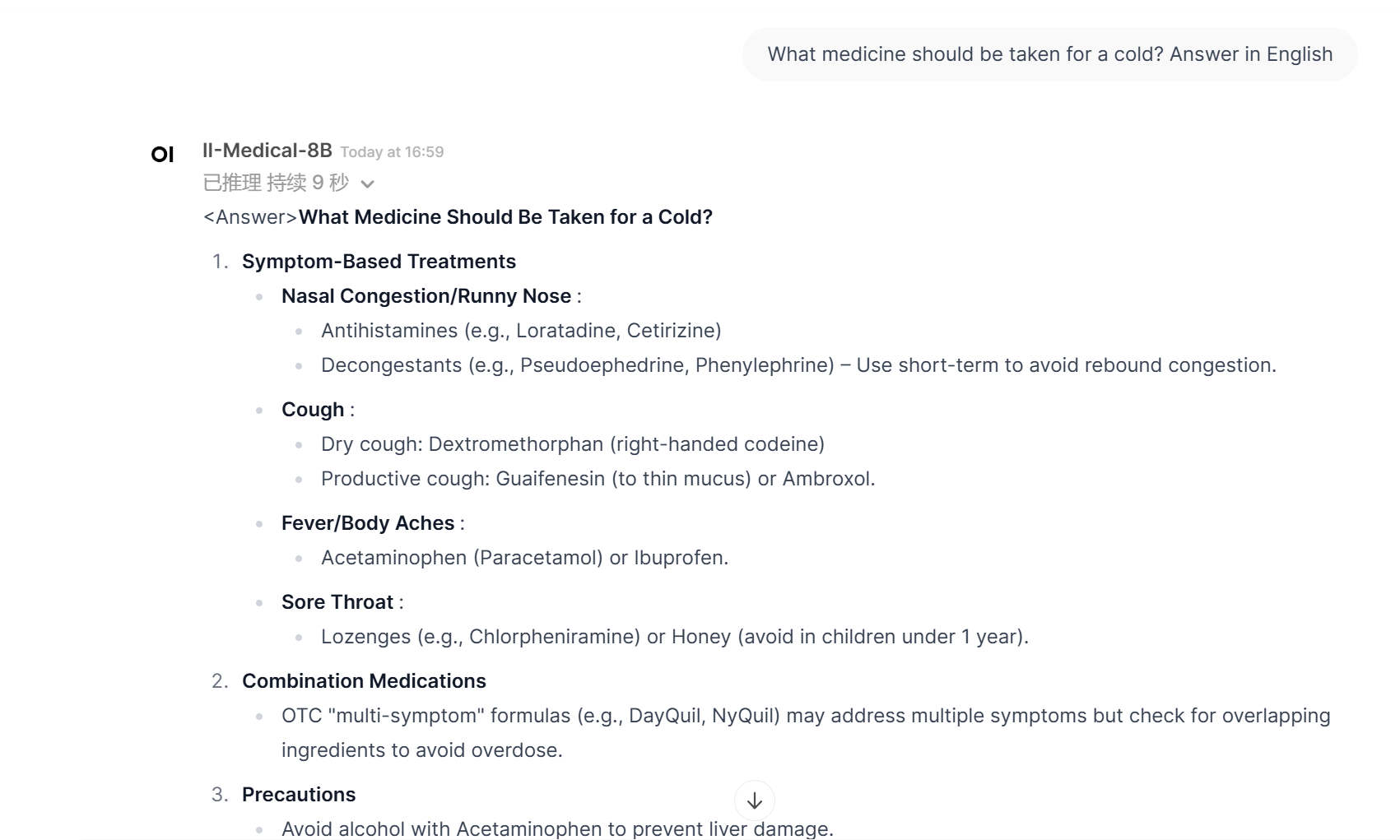

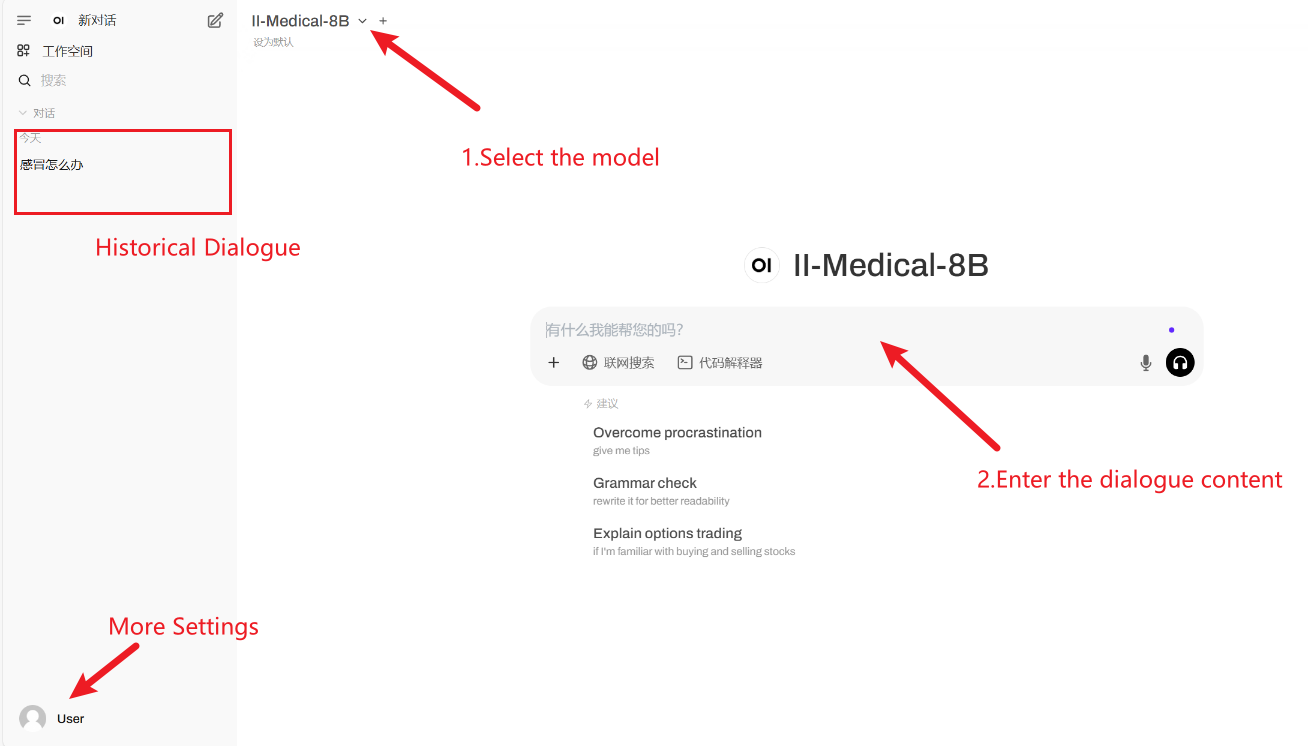

2. Web ページに入ると、モデルと会話を開始できます。

利用手順

4. 議論

🖌️ 高品質のプロジェクトを見つけたら、メッセージを残してバックグラウンドで推奨してください。さらに、チュートリアル交換グループも設立しました。お友達はコードをスキャンして [SD チュートリアル] に参加し、さまざまな技術的な問題について話し合ったり、アプリケーションの効果を共有したりできます。

引用情報

Githubユーザーに感謝 xxxjjjyyy1 このチュートリアルの展開。このプロジェクトの引用情報は次のとおりです。

@misc{2025II-Medical-8B,

title={II-Medical-8B: Medical Reasoning Model},

author={Intelligent Internet},

year={2025}

}