Command Palette

Search for a command to run...

PixelFlow: ピクセル空間画像生成ソリューション

1. チュートリアルの概要

香港大学のAdobeチームによって2025年4月にリリースされたPixelFlowプロジェクトは、主要な潜在空間モデルとは対照的に、元のピクセル空間で直接動作するAI画像生成モデルシリーズです。関連論文には以下が含まれます… PixelFlow: フローを用いたピクセル空間生成モデル 。

このアプローチは、事前トレーニング済みの変分オートエンコーダー (VAE) の必要性を排除し、モデル全体をエンドツーエンドでトレーニング可能にすることで、画像生成プロセスを簡素化します。 PixelFlow は、効率的なカスケード フロー モデリングを通じて、ピクセル空間での計算コストを低く抑えます。 256×256 ImageNet クラス条件付き画像生成ベンチマークで FID 1.98 を達成しました。テキストから画像への変換の定性的な結果では、PixelFlow が画像品質、芸術性、意味制御の点で優れたパフォーマンスを発揮していることがわかりました。この新しいパラダイムが、次世代の生成ビジョン モデルに刺激を与え、新たな機会を切り開くことを願っています。

このチュートリアルでは、単一の RTX 4090 カードのリソースを使用します。

👉 このプロジェクトでは以下のモデルを提供します:

- クラスからイメージへ: 256×256 ImageNet クラス条件付き画像生成ベンチマークで FID 1.98 を達成しました。

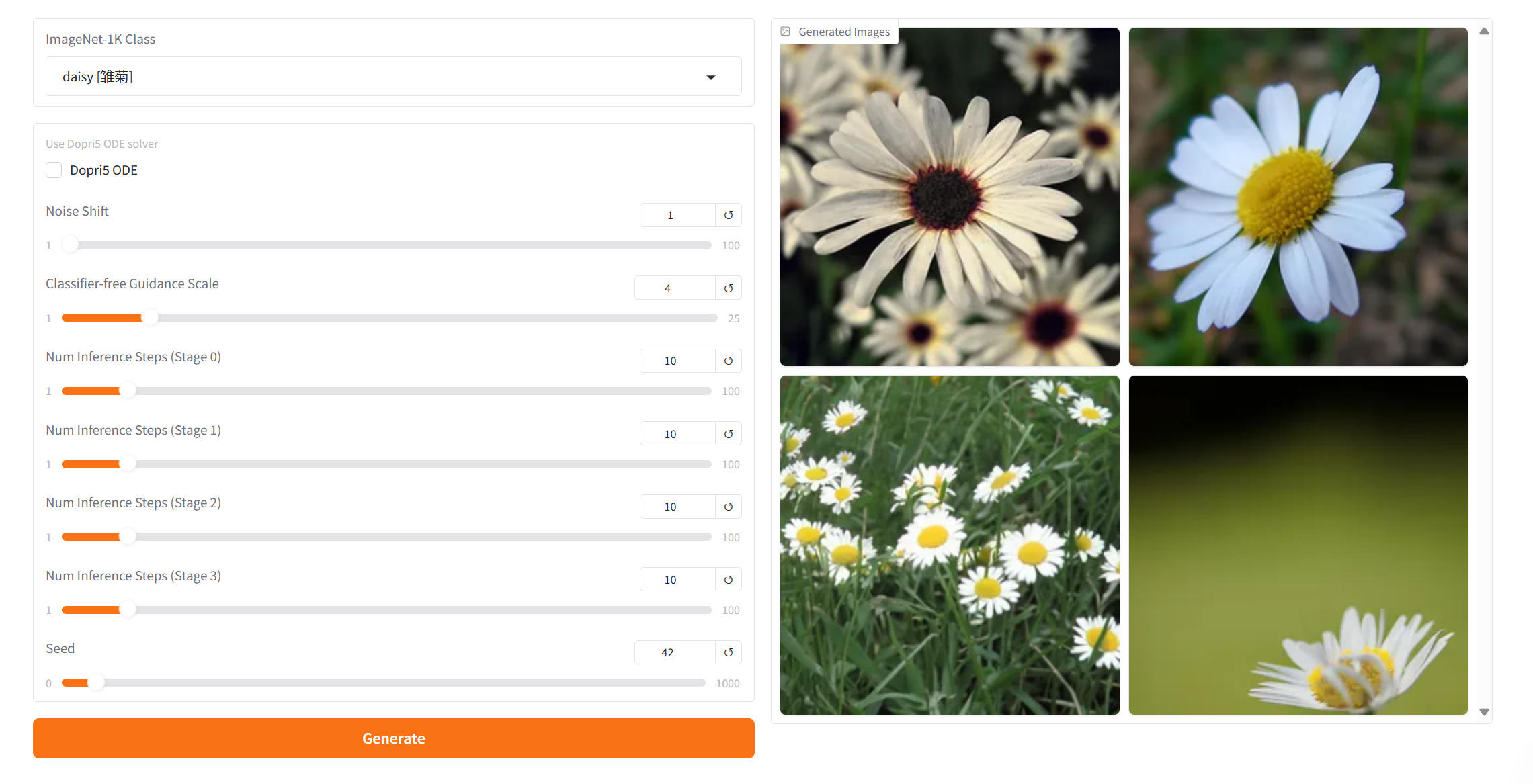

プロジェクト例

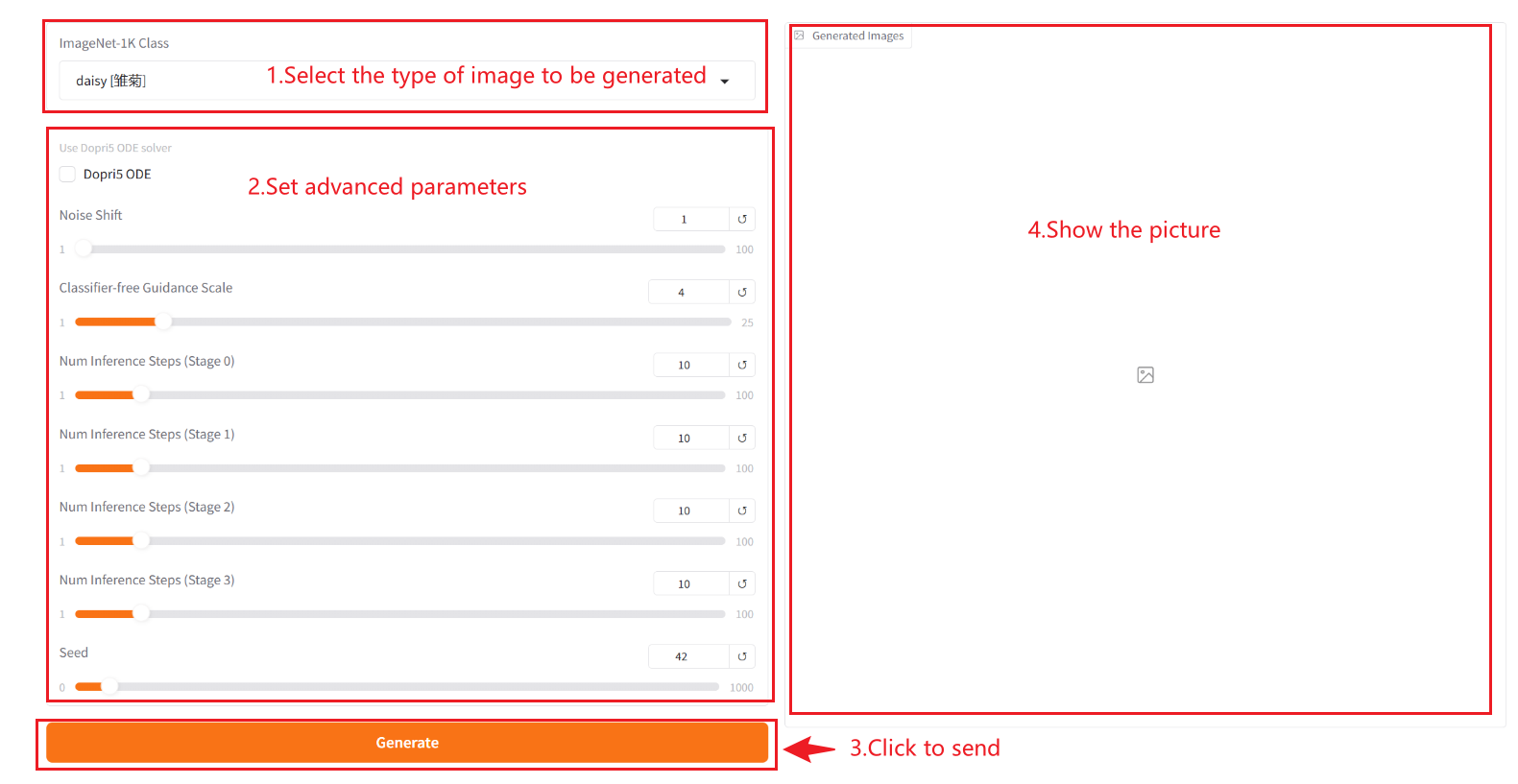

2. 操作手順

1. コンテナを起動した後、API アドレスをクリックして Web インターフェイスに入ります

「Bad Gateway」と表示される場合、モデルが初期化中であることを意味します。モデルが大きいため、1〜2分ほど待ってページを更新してください。

2. Web ページに入ると、モデルと会話を開始できます。

❗️重要な使用上のヒント:

- ImageNet-1k クラス: 生成された画像では、ドロップダウン ボックスで指定されたカテゴリのみを選択でき、カスタマイズすることはできません。

- Dopri5 ODE: これは Dormand-Prince 5 次適応ステップ サイズ ODE ソルバーであり、高品質の生成が必要な場合 (高解像度画像の生成など) に有効になります。

- ノイズシフト: 生成プロセスにおけるノイズのオフセットを制御します。値を大きくするとノイズの強度が増し、生成される結果はよりランダムかつ多様になります。値が小さいほどノイズの干渉が減り、生成される結果がトレーニング データの分布に近くなります (より保守的になります)。

- 分類器を使用しないガイダンススケール: これは、生成モデル内の条件付き入力 (テキストや画像など) が生成される結果に影響を与える度合いを制御するために使用されます。ガイダンス値を高くすると、生成される結果が入力条件に近くなりますが、値を低くするとランダム性が高まります。

- 推論ステップ数 [ステージ 0]: モデルの反復回数または推論プロセスのステップ数を表し、モデルが結果を生成するために使用する最適化ステップの数を表します。通常、ステップ数が多いほど、より正確な結果が生成されますが、計算時間が長くなる可能性があります。 [ステージ0]は生成された画像を示します。その後の数字に 1 を加えたものが章番号を示します。画像は全部で4枚あります。

- シード: 生成プロセスのランダム性を制御するために使用される乱数シードです。同じシード値では同じ結果が生成されます (他のパラメータが同じである場合)。これは、結果を再現する上で非常に重要です。

利用手順

引用情報

このプロジェクトの引用情報は次のとおりです。

@article{chen2025pixelflow,

title={PixelFlow: Pixel-Space Generative Models with Flow},

author={Chen, Shoufa and Ge, Chongjian and Zhang, Shilong and Sun, Peize and Luo, Ping},

journal={arXiv preprint arXiv:2504.07963},

year={2025}

}