Command Palette

Search for a command to run...

DiffRhythm: 1 分で完全な音楽デモを生成

DiffRhythm-fullのワンクリック展開

1. チュートリアルの概要

DiffRhythm は、潜在拡散モデルに基づくエンドツーエンドの音楽生成ツールであり、西北工科大学 (ASLP@NPU) のオーディオ音声言語処理研究所と香港中文大学 (深圳) が共同で開発しました。ボーカルと伴奏を含めた最長4分45秒の完全な曲を短時間で生成できます。ユーザーは歌詞とスタイルのヒントを提供するだけで、DiffRhythm は歌詞に一致するメロディーと伴奏を自動的に生成し、多言語入力をサポートします。

DiffRhythm(中国語:狄韵、Dì Yùn)は、完全な曲を作曲できる最初の拡散ベースの曲生成モデルです。この名前は、「Diff」(拡散したアーキテクチャへの言及)と「Rhythm」(音楽と作詞作曲への重点を強調)を組み合わせたものです。中国名の Dì Yùn (Di Yun) は発音が「DiffRhythm」に似ており、「Dì」(注意深く聞く) は聴覚を象徴し、「Yun」(旋律の魅力) は音楽性を表しています。

2. 操作手順

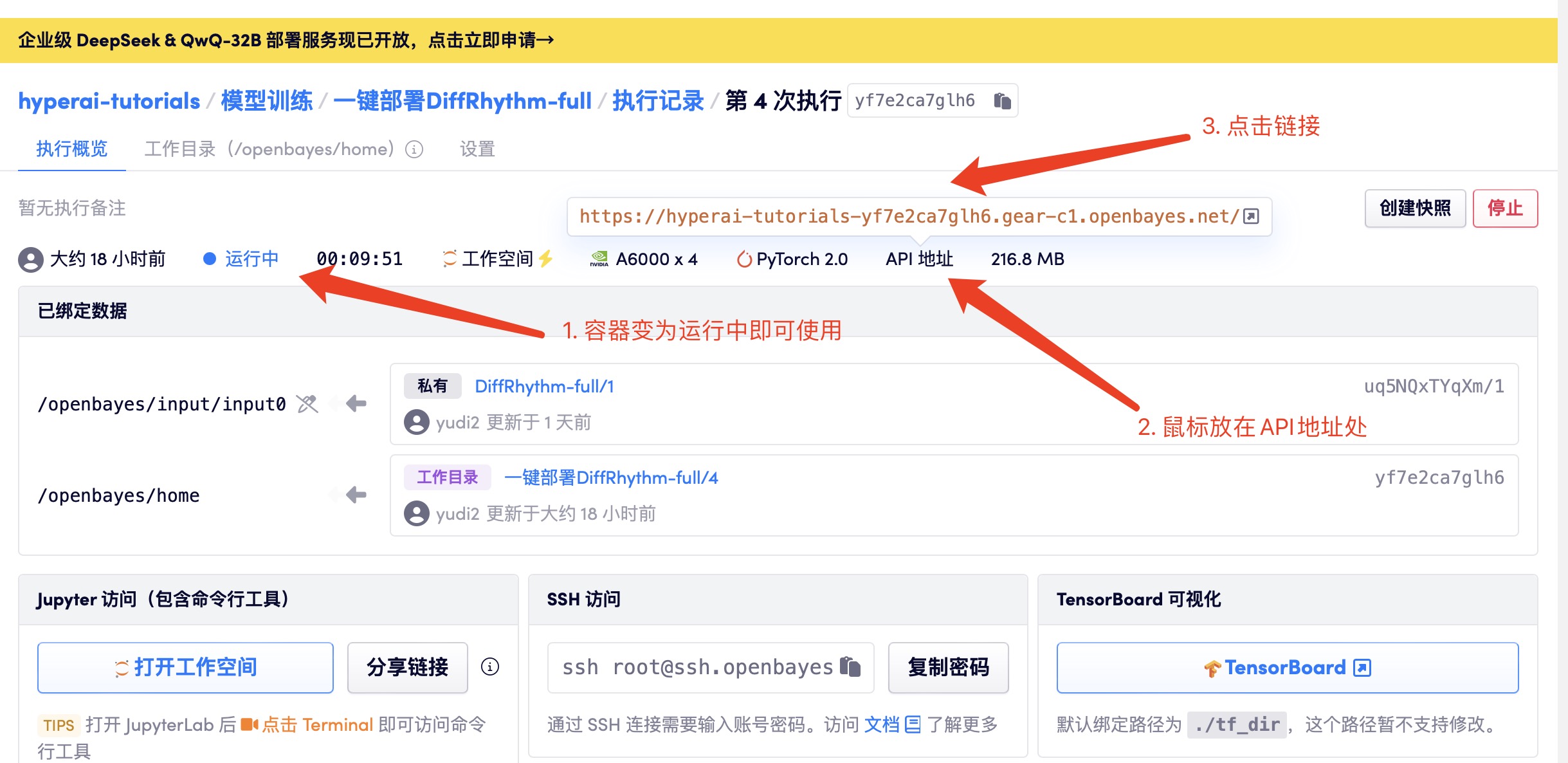

1. コンテナを起動します

コンテナを起動した後、APIアドレスをクリックしてWebインターフェースに入ります。モデルが大きいため、WebUIインターフェースが表示されるまでに約3分かかります。そうでない場合は、「Bad Gateway」と表示されます。

2. 音楽生成

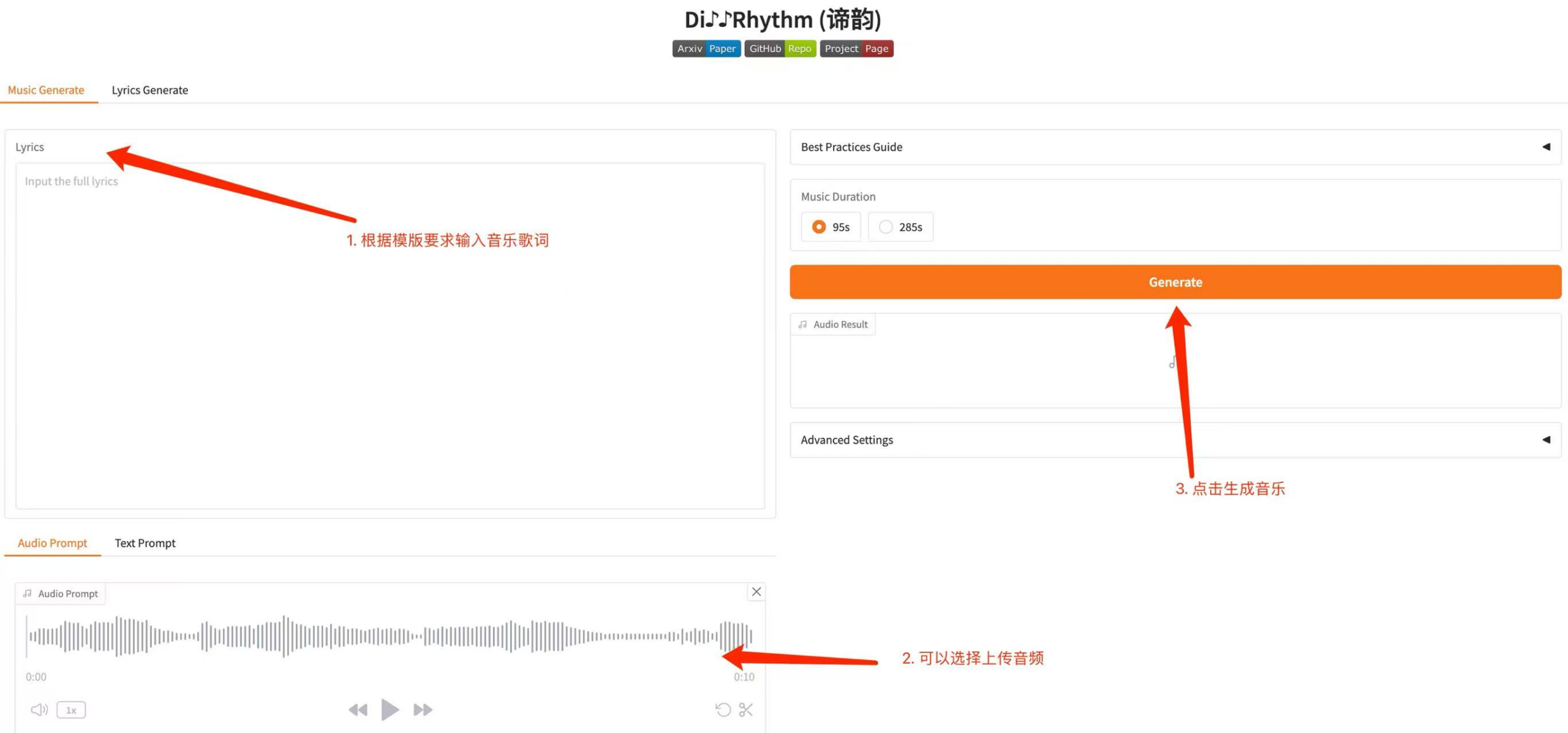

2.1 歌詞または音声に基づいて音楽を生成することを選択する

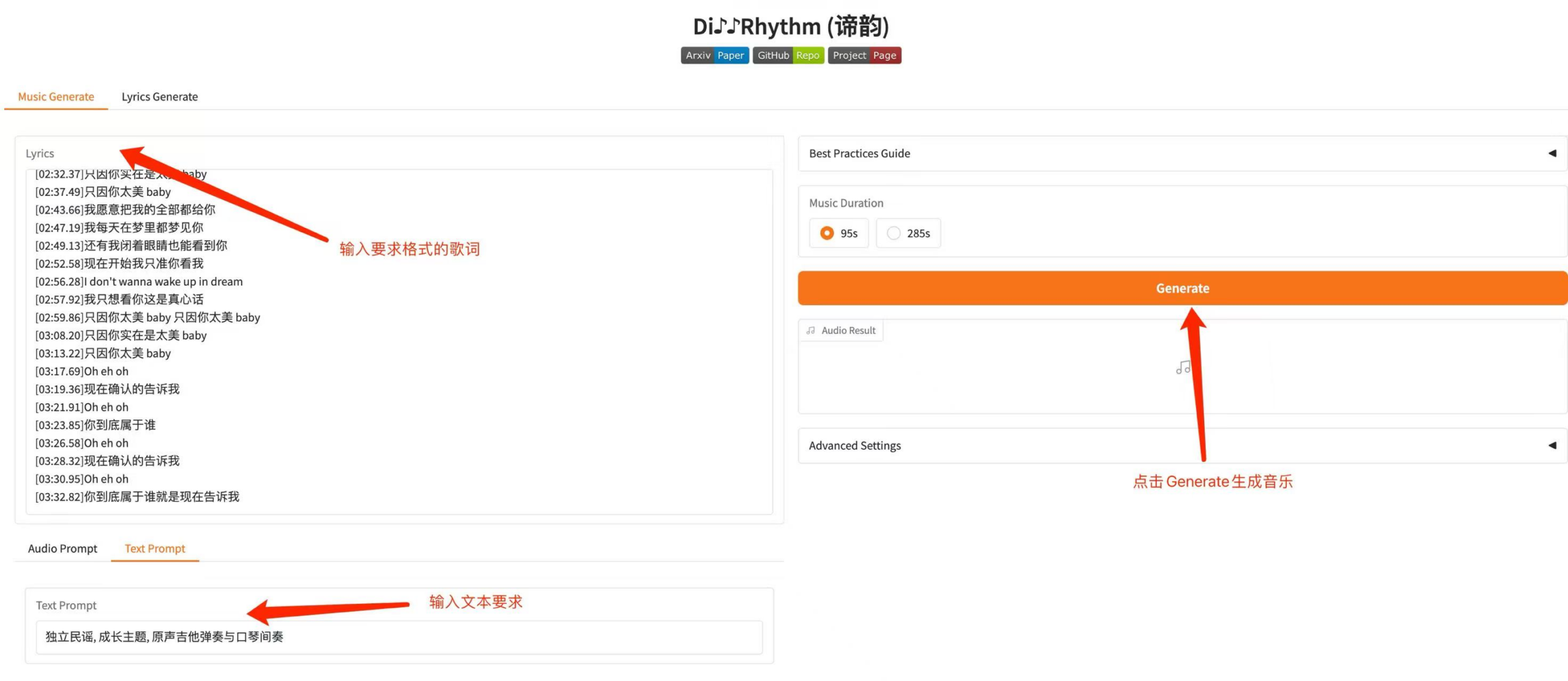

2.2 歌詞やテキストに基づいて音楽を生成することができます

3. 議論

🖌️ 高品質のプロジェクトを見つけたら、メッセージを残してバックグラウンドで推奨してください。さらに、チュートリアル交換グループも設立しました。お友達はコードをスキャンして [SD チュートリアル] に参加し、さまざまな技術的な問題について話し合ったり、アプリケーションの効果を共有したりできます。