Command Palette

Search for a command to run...

私は『Nature』誌の表紙を担当し、この運動の科学研究のストーリーについておしゃべりしました。

10月17日、清華大学科学技術協会スパークフォーラム、清華大学脳インスピレーションコンピューティング研究センター、HyperAIスーパーニューラル主催の「AlphaGoから脳にインスピレーションを得た天吉チップスまで、人工知能はどこへ行くのか?」が孟で開催された。清華大学民威ビル無事開催されました。オープニングラウンドテーブルフォーラムでは、清華初のブレインライクコンピューティング博士である鄧磊氏が、ブレインライクコンピューティングに関する自身の経験を詳しく説明し、ブレインライクコンピューティングを多角的に解釈し、学生の質問に答え、ブレインライクコンピューティングを理解できるようにしてくれました。そして人工知能の発展についての新たな理解があります。

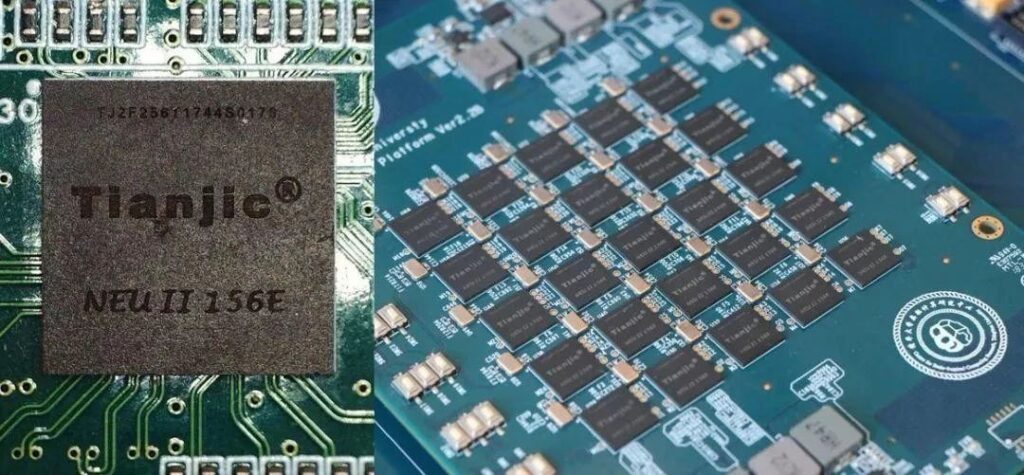

Deng Lei は、清華大学初のブレイン・インスピレーション・コンピューティングの博士課程の学生であり、カリフォルニア大学サンタバーバラ校の博士研究員です。 Nature 誌の 8 月 1 日号の表紙にはこの記事が掲載されています「汎用人工知能のための異種 Tianji チップ アーキテクチャ」、最初の著者として、彼はチップの設計とアルゴリズムの詳細を担当しました。

先週の木曜日、清華大学科学技術協会、清華大学脳インスピレーション・コンピューティング研究センター、およびHyperAIのSparkフォーラムは、「AlphaGoから脳にインスピレーションを得たTianjiチップまで、人工知能はどこへ向かうのか?」をテーマにしたフォーラムを開催した。鄧磊氏は特別ゲストとして出席するよう招待され、ラウンドテーブルフォーラムの形式で彼の見解の一部を共有した。この記事では、フォーラムでの質問に従い、AI と脳にインスピレーションを得たコンピューティングの分野における彼の洞察の一部をレビューします。

学習と探索: Center for Brain-inspired Computing からの最初の Ph.D.

質問: どのようにして脳にインスピレーションを得たコンピューティングの研究方向に進むようになったのですか?この主題には具体的にどのような内容が含まれますか?私がブレイン・インスパイア・コンピューティングの博士号取得を目指して勉強していたとき、ブレイン・インスパイア・コンピューティングはまだ普及していませんでしたが、あまり有用な情報が見つからず、講師に具体的に尋ねました。

Brain-inspired Computing Research Center の最初の Ph.D メンバーとして、私は Brain-inspired Computing Research Center がゼロから現在に至るまで発展するのを目撃してきました。その後の起業や研究も含めて。 2017 年以降、卒業して渡米し、コンピューター サイエンスに転向しました。現在、理論用の 50% とチップ用の 50% があります。

学部では機械学を専攻していましたが、その後、自分には機械学の才能があまりないことに気づき、その後、ロボットにも取り組み、材料やマイクロエレクトロニクスの研究にも取り組み始めました。 AI のアルゴリズムと理論をいくつか学び、最終的にはチップにたどり着き、ゆっくりと脳のようなコンピューティングに入りました。歩き続け、その過程で学んでいく、それがおそらくそのようなプロセスです。

注: 清華大学の Brain-inspired Computing Research Center は、2014 年 9 月に設立されました。これには、基礎理論、Brain-inspired Computing Research Center、Brain-inspired Computing Research Center、Brain-inspired Computing Research Center が含まれます。このセンターは清華大学内の 7 つの学部によって形成され、脳科学、エレクトロニクス、マイクロエレクトロニクス、コンピューター、オートメーション、材料、精密機器などの分野を統合しています。

脳にヒントを得たコンピューティングの研究には、複数の分野の相互統合が含まれます。ソースは確かにまだ残っています医学(脳科学)、現在の人工知能はもともと心理学と医学から生まれ、モデルの基礎を提供します。

次は機械学習、将来的には間違いなく一緒になるでしょうが、機械学習は製品を作る経験があり、通常はアプリケーションの観点から考えるため、現在は分離されています。

さらに、コンピュータサイエンス、現在、GPU では解決できない問題があるため、Alibaba と Huawei は独自の特別なチップを製造し始めており、コンピューティング アーキテクチャの分野の学生もこの方向での開発を検討できます。

さらに下には、チップおよびその他のハードウェアいくつかの非常に基本的なメモリユニットが現在も使用されているため、これにはマイクロエレクトロニクスや材料さえも含まれます。カーボンナノチューブ、グラフェン、その他の材料など、将来的には間違いなく新しいデバイスが登場するでしょう。適用されますか?

さらに、自動化の方向性, 自動化は制御と最適化に関するものであり、機械学習と似ているため、機械学習を行う人の多くは通常、コンピューター サイエンスおよびオートメーション学科の出身です。脳にインスピレーションを得たコンピューティングでは、これらの分野がうまく統合されています。

質問:その時の原動力や、最終的にこの方向を選んだきっかけは何でしたか?

一言で言えば、この方向性の最大の魅力は、終わりがないことです。

脳のようなコンピューティングの研究は人間の脳と切り離せないものですが、人間の脳について考えるのにどこまで到達するかはわかりません。それに関する研究は決して終わることはありません。 なぜなら、人間の自分自身についての思考は常に存在し、絶頂期を迎え、そして突然の突破口が訪れるからです。この観点からも研究する価値はある。

質問: 現在のポスドク段階での研究の違いは何ですか?

清華大学でチップの開発に取り組んでいたときは、どちらかというと実用的な観点からデバイスや機器を作ることができると考えていました。しかし、米国に行った後、私はこの問題を、コンピューティング専攻のコンピューティング アーキテクチャなどの専門的な観点から検討しました。多くの ACM チューリング賞は、同じことを行っているにもかかわらず、すべてこの側面から問題を検討しています。角度が違うと考えてください。

コンピューティング アーキテクチャの観点から見ると、どのチップも、コンピューティング ユニット、ストレージ ユニット、および通信にすぎません。どうやってもこの3つの範囲内に収まります。

天吉コアと脳からインスピレーションを得たコンピューティング: 自転車は焦点ではありません

質問: この Nature の記事は画期的な出来事です。過去数十年間の画期的な出来事は何だと思いますか?ブレイン・インスピレーション・コンピューティングの分野では、どのような出来事が業界の発展を促進しましたか?

脳にインスピレーションを得たコンピューティングの分野は、人工知能の文脈から整理すると、より明確になります。 人工知能は単一の主題ではなく、基本的に 4 つの方向に分けることができます。

1 つ目はアルゴリズム、2 つ目はデータ、3 つ目はコンピューティング能力、最後はプログラミング ツールです。マイルストーンイベントはこれら 4 つの方向から見ることができます。

アルゴリズムの観点から見ると、これはもちろんディープ ニューラル ネットワークです。データの観点から見ると、ImagNet はマイルストーンです。以前は、ディープ ニューラル ネットワークはほとんど埋もれていました。 コンピューティング能力の観点から見ると、GPU は素晴らしい誕生です。 Google の TensorFlow などの人気のあるアプリケーションなどのプログラミング ツールは、開発を促進する上で重要な要素です。

これらは AI の進歩を促進するものであり、これらのいずれかがなければ、私たちは今日ここにいないでしょう。しかし、AI には独自の制限もあります。たとえば、AlphaGo は 1 つのタスクしか実行できず、チェス以外のことはうまくできません。これは脳とは異なります。

2 つ目は解釈可能性です。ディープ ニューラル ネットワークを使用して強化学習を追加しますが、その内部で何が起こっているかはまだ不明です。

3つ目は、AIは人間ほど安定していないということです。例えば、自動運転においては、現在のAIは絶対的な安全性を保証できないため、運転支援にのみ活用されています。 これらの欠点があるため、私たちは脳科学の発展に注意を払い、より多くの脳科学メカニズムを導入する必要があります。私の意見では、最も緊急なことは、知性をより普遍的なものにすることです。

マイルストーンイベントに関しては、AlphaGo は 1 回としてカウントされます。それは、AI が世間の注目を集めるようになり、誰もが AI に注目するようになり、強化学習が普及したのは後になってからです。 チップの観点から見ると、アルゴリズムに焦点を当てたチップと、生物学的な脳からインスピレーションを得たチップの 2 種類があります。これら 2 種類のチップの開発には 2 つのマイルストーンがあります。

1 つ目のカテゴリは機械学習です。現在、ディープ ニューラル ネットワークは GPU で計算されていますが、GPU の代替手段を探している Cambrian のような企業グループがあります。

もう 1 つのタイプは、機械学習に限定されず、この点で専用チップをより良く機能させるために脳の観点からモデルを探します。

Tianji チップがこれほど注目を集める理由は、これら 2 つのタイプのそれぞれの利点を 1 つのアーキテクチャに統合しているためです。

質問: あなたのチームは自転車での Tianji コアのテストをリリースしました。この点について詳しく紹介していただけますか。

インターネット上の誰もが自転車に惹かれていますが、私たちのチームは皆、自転車が私たちの焦点ではなく、単なるデモ プラットフォームであることを知っています。なぜなら、当時私たちは皆に見せるための良いプラットフォームを見つけることを考えていたからです。

自転車のデモでは、視覚、聴覚、運動制御があり、これらの機能をチップで実現するのに最適なプラットフォームです。当時の考えは、バイクのコントロールは難しくなく、ただ新しいモードを見せたいだけだった。

脳からインスピレーションを得たコンピューティングの未来: ノイマン型アーキテクチャの打破

質問: 将来の人工知能または脳のようなコンピューティングと既存のフォン ノイマン アーキテクチャとの間にはどのような関係がありますか?人間の脳の形に向かって進化するのでしょうか?

これは非常に重要な問題であり、2018 年のチューリング賞もコンピューティング アーキテクチャの研究を行う研究者に授与されるなど、現在の半導体業界には基本的な傾向があります。 GPU のパフォーマンスを向上させるには 2 つの方向があります。1 つはトランジスタを小さくすることであり、これは物理的な収縮であり、ムーアの法則に従うことです。しかし、過去 2 年間で、ムーアの法則が破綻し始め、関連開発の速度がますます遅くなり、いつか規模を小さくすることができなくなることを誰もが認識しました。

もう 1 つの方向は、コンピューティング アーキテクチャを構築し、設計フレームワークを使用してコンピューティング ユニット、ストレージ ユニット、通信の 3 つの部分を高効率にすることです。 人間の脳は驚くべきものであり、学習の蓄積を通じて、私たちは知識の進化から学ばなければなりません。

前世紀において、汎用プロセッサの開発は基本的にムーアの法則に従っていました。これは、過去にトランジスタをどんどん小さくすることができたためであり、コンピューティング アーキテクチャの開発はある程度まで埋もれていました。ムーアの法則が阻止され、高い処理効率を必要とする AI などのアプリケーションがコンピューティング アーキテクチャの研究に改めて注目を集めている今、次の 10 年は専用プロセッサの黄金時代でもあります。

脳にインスピレーションを得た研究に関して、最もよく聞かれる質問は、脳にインスピレーションを得たコンピューティングで何ができるのかということです。

これは非常に致命的な問題です。現在、人工知能や脳科学に取り組んでいる人の多くは、その背後にあるメカニズムを知りません。脳科学を例に挙げると、現在あまり理解されていないレベルが 3 つあります。

1つ目は、神経細胞がどのように正確に機能するかです。多くの医学者や生物学者が、この問題に関して依然として困難な調査と研究を行っています。

2つ目は、神経細胞がどのように接続されているかです。脳には10の11乗の神経細胞があり、それらがどのように接続されているかを解明するのは光学と物理学の助けが必要です。

最後に、彼らがどのように学習するのかを知る必要があります。これは最も難しいですが重要な質問でもあります。

あらゆる面でギャップはありますが、困難だからといって探索を諦める理由にはなりません。何もしなければチャンスはまったくありません。あらゆるレベルで何かを行うと、最終的には常に新しいものが生まれ、それが継続的に繰り返されます。

脳科学が解明されるまで待ってから先に進めても手遅れとなり、他の企業が確実に先を行くことになるでしょう。

たとえば、CPU を作るのは誰もが思っているほど簡単ではありません。エンジンについても同様です。しかし、それをうまくやるのは簡単ではありません。技術の蓄積は一日にして成らず。

理由の1つは、多くの物事は大きな産業チェーンを持っているため、最初にそれを行わないと、多くの試行錯誤の機会を失うことになります。 この分野は急速なブレークスルーを達成することはできません。それは地道に行うことによってのみ可能です。将来について言えば、今日の人工知能、強力な人工知能、人工知能 2.0、そして脳からインスピレーションを得たコンピューティングは、いずれも脳に由来するものですが、方向性が異なるため、最終的には同じ目標に到達すると思います。

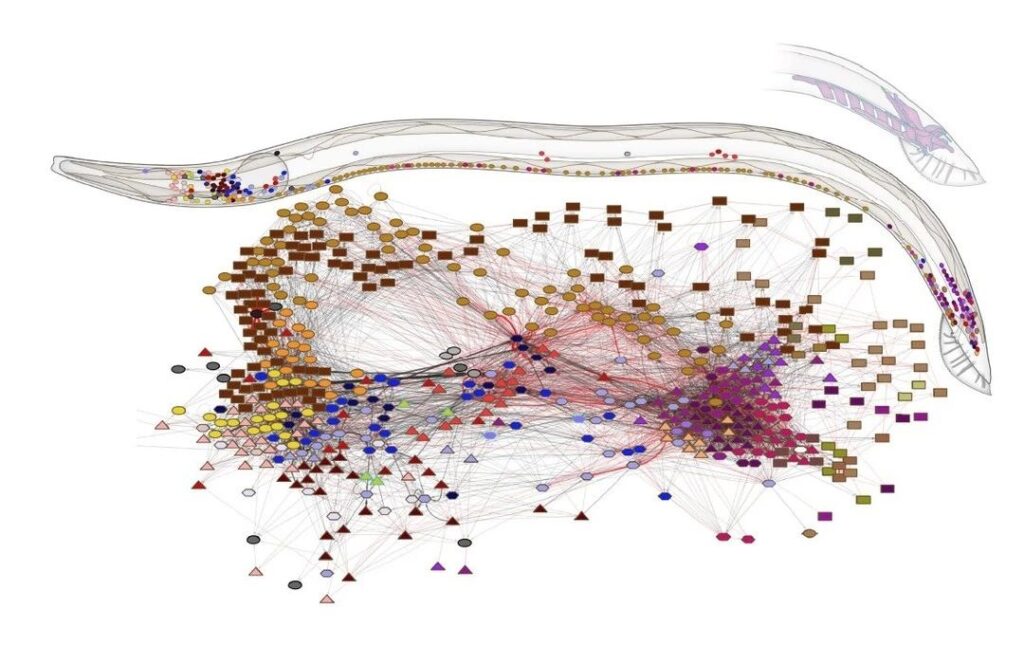

質問: 少し前に、Nature に別の記事がありました。研究者たちは、C. elegans のすべてのニューロンと、すべてのニューロン間の 7,000 の接続すべての完全なマップを作成しました。

質問: この研究と脳にインスピレーションを得た研究の間には何か関係がありますか?既存のテクノロジーやフォン・ノイマンの CPU を使用して C. elegans の働きをシミュレートできるでしょうか? 今後 3 ~ 5 年でどのようなことが起こると予想できますか?

脳のような研究に大きな影響を与える線虫の構造に関する研究を見てきました。実際、現在の AI モデルは、脳からインスピレーションを得たコンピューティングであれ、人工知能であれ、その接続構造のほとんどは依然として、実際には非常に表面的な現在の階層型ディープ ニューラル ネットワークから派生しています。

私たちの脳は単純な層状のネットワークではなく、グラフに似ています。さらに、さまざまな脳領域間の接続は非常に複雑です。この接続方法から学ぶことができるかどうかを考えさせることが、この研究の意義である。

以前は、ニューラル ネットワークの構造において、接続構造の役割は、実際には各接続の特定の重みよりも大きくなります。つまり、接続の意味は各パラメータの意味よりも大きくなります。

畳み込みニューラル ネットワークが以前のニューラル ネットワークよりも強力である理由は、その接続構造が異なるため、特徴を抽出する能力がより強力になるためです。これは、接続構造が結果の変化につながることを示しています。

この結果が従来のプロセッサで達成できるかどうかは、実際には少し難しいです。フォン ノイマン アーキテクチャで最も典型的なのは、非常に明確なストレージ ユニットと非常に明確なコンピューティング ユニットを必要とすることです。

しかし、私たちの脳にはそのような明確な境界はありませんが、長期記憶を司る海馬はありますが、ニューロンネットワークレベルからは、脳内のどのグループの細胞が貯蔵庫であり、どれが単なる貯蔵庫であるかはわかりません。計算。

脳はむしろ混沌としたネットワークに似ており、コンピューティングとストレージを区別するのが難しいため、この観点から従来のチップやプロセッサー技術を使用することは困難です。

したがって、私たちはいくつかの新しい非ノイマン手法を開発し、新しいアーキテクチャ手法でそれらをサポートし、頭脳のような研究を行う必要があります。

たとえば、2018 年のチューリング賞では、専門分野のチップがますます人気になることが発表されました。 NVIDIA が現在推進しているのは、1 つのプラットフォームにさまざまな小型チップ IP コアが存在するヘテロジニアス アーキテクチャです。これは人間の脳に似ているかもしれません。

したがって、以前のように CPU を使用してすべてを解決することはできなくなり、すべてを効率的に解決できる 1 つのチップは存在しません。将来的には、さまざまな効率的かつ専用の開発テクノロジーに徐々に移行していきます。これが現在の傾向です。

現在、脳科学や脳に似たコンピューティングに対する理解は、人工知能ほど完全ではありません。非常に重要な理由の 1 つは、投資家や業界がまだあまり関与していないことです。 したがって、データ計算力にしろ、ツールにしろ、それは難しいのです。脳にインスピレーションを得たコンピューティングは非常に初期段階にあり、より多くの大学や企業がそれに投資することで、より明確になると私は信じています。

質問: 脳のようなチップのアーキテクチャと従来のフォン ノイマン アーキテクチャの違いは何ですか?

脳型チップは、脳型チップとコンピューティングに分類できます。脳シミュレーションの観点から見ると、AI のディープ ニューラル ネットワークだけでなく、いくつかの脳科学計算も組み合わせられています。

アーキテクチャに関して言えば、フォン ノイマン システムにはボトルネックがあり、半導体業界全体のアーキテクチャは実際にこの問題に直面しています。つまり、ストレージ容量はますます大きくなり、その速度はますます遅くなります。規模を拡大して高速性を求めると、それは不可能です。基本的に、アーキテクチャを設計する人々は主に、ストレージ階層を最適化する方法とそれを高速化する方法を研究しています。

Tianji は、拡張する必要があるメモリを使用しないという点で他のアーキテクチャとは異なります。Tianjiチップはむしろ脳に似ており、多くの小さな回路に接続された細胞に相当し、小さな回路は多くのネットワークに拡張され、最終的に機能領域とシステムを構成します。GPU とは異なり、拡張が容易な構造です。

Tianji Core のメニーコア分散アーキテクチャは、ストレージの壁の制約を受けることなく、簡単に大規模システムに拡張できることを特徴としています。これは、実際には、ストレージとコンピューティングを統合する非フォン ノイマン アーキテクチャです。これは、アーキテクチャ レベルと既存のプロセッサとの最大の違いであり、前のものはモデル レベルでの違いであり、基本的にはこれら 2 つのカテゴリの違いです。