超神経質で

私たちは囲碁と DOTA2 をプレイしましたが、今度は AI が IQ テストの推理問題を行う番です。

従来の知能テストに触発されて、DeepMind チームは最近、AI 推論能力をテストする実験を開始しました。この結果は、AI がいくつかの抽象的な概念を理解できるだけでなく、新しい概念について推論できることを示しています。

おっと、AIが追加点を加えました~

チェスをやめて推論質問を使って AI をテストしましょう

今年7月にスウェーデンのストックホルムで開催された「国際機械学習会議」で、DeepMindは人間のIQをテストするのと同じように、一連の抽象的な要素を通じてニューラルネットワークの推論能力を測定できるとする論文を発表した。

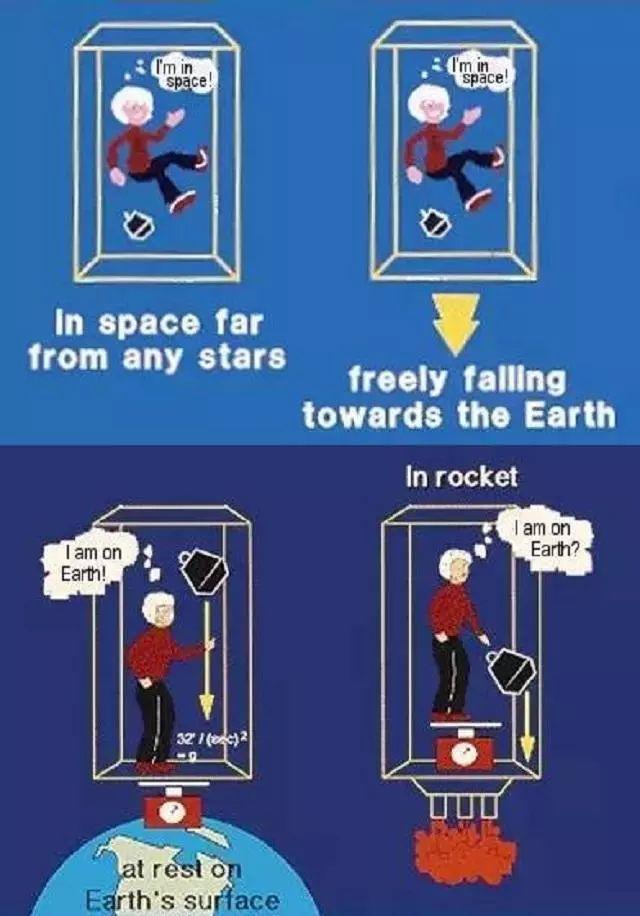

研究者は、この抽象的な推論能力を、パターンを検出し、概念レベルで問題を解決する能力であると定義しています。抽象的推論は人間の知性の象徴の一つです。有名な例としては、アインシュタインがエレベーターの思考実験によって導き出した一般相対性理論があります。

この実験において、アインシュタインは、一様な加速度下にある観察者と一様な重力場内の観察者との間には同等性があると理論化しました。

これら 2 つの抽象的な概念を結びつけるこの能力が、彼を一般相対性理論に導き、それに基づいて時空の曲率を導き出しました。この抽象的な能力は人間の知性の特徴の 1 つです。

注: アインシュタインは、「特殊相対性理論と一般相対性理論の簡単な紹介」の中で、外部重力がなければ外部を見ることができない、加速度が 9.8 メートルであると例えました。 /s^2 は箱を上方に引っ張るので、箱の中の人は、手にボールを持っていても、その重さが地球の重力によるものかどうか区別できません。 g の上向き加速度のため、重力質量は慣性質量に等しくなります。

AI はデータの処理に加えて、抽象化する機能も備えています。

では、AIには抽象的な要素を通じて新しい概念を推論する能力もあるのだろうか? DeepMind チームによる実験により、答えは「はい」であることが証明されました。

チームは当初、トレーニング素材の形状、位置、線の色などの属性に基づいて AI の推論能力をテストすることを計画していましたが、結果は理想的ではなく、AI の推論能力を正確に反映することが困難でした。

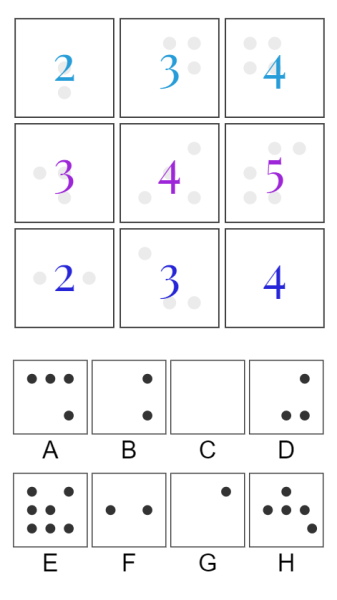

一般的な知能テストの問題の種類

その主な理由は、用意された実験材料が多すぎる、または具体的すぎる場合、ニューラルネットワークはその強力な学習能力に依存して推論することを拒否し、人間も同様のことを行うからです。

研究チームの解決策は、問題生成ツールを構築することでした。この質問ジェネレーターは、一連の抽象要素から作成された一連の質問で構成されており、特に AI の推論能力をトレーニングおよびテストするために使用されます。これらの抽象要素には、関係 (物事の展開など) や属性 (色や属性など) が含まれます。サイズ)。

ほとんどの AI モデルはテストで良好なパフォーマンスを示し、中には 75% のパフォーマンスに達するものもありました。研究者らは、問題セットの精度が抽象概念を推論する AI の能力と強い相関関係があり、その推論能力は問題セットの特性を調整することで向上できることを発見しました。

画像推論の質問はほとんどの AI を苦しめます

対照的に、視覚的推論はより難しく、画像に表示されている要素に基づいて AI が問題セットを作成する必要があります。しかし、DeepMindチームは、視覚的な推論を実行できるAIモデルがすでにいくつかあると述べた。

視覚的な推論を可能にするために、これらのモデルは、論理演算や等差数列などの抽象的な概念を画像の生のピクセルから一般化してテストし、これらの概念をこれまで観察されたことのないオブジェクトに適用する必要があります。

凡例: DeepMind チームが設計した機械学習モデルによって完了した視覚的推論テスト

テスト全体では、ニューラル ネットワークによって AI に推論機能を持たせることができることが証明されましたが、現時点ではこの機能にはまだ大きな制限があり、最高のワイルド リレーション ネットワーク (WReN) でさえ完全には解決できません。

AI推論の限界

この制限は主に、ニューラル ネットワークが問題セットの外の要素を発見することが難しく、推論プロセス中の一般化能力の低下につながるという事実にあります。

研究チームはブログで次のように書いています。「ニューラルネットワークの推論能力は、ある特定の条件下では非常に優れていますが、条件が変化すると推論能力は急激に低下します。また、モデル推論の成功には、モデルのアーキテクチャなどの多くの要因も関係しています」 、トレーニング後など。」

モデルの一般化能力を向上させるいくつかの方法を見つけて、将来のモデルで「構造が豊富で普遍的に適用可能な」帰納的バイアスの使用を検討できれば、この制限は解決されるかもしれません。

しかし、もしかしてエンジニアはみんな傲慢なのでしょうか?

GoからDOTA2まで、人類は何度もAIに敗北してきましたが、本当に面白いでしょうか?

名言を紹介します↓↓↓