Command Palette

Search for a command to run...

オンラインチュートリアル: マルチモーダル協調型ビデオ生成フレームワーク HuMo-1.7B: 統合グラフィックス、テキスト、オーディオによるビデオ作成エクスペリエンスの実現

最近、AIが生成する動画はますますリアルになっています。一見すると驚くほど美しいのですが、よく見るとどこか違和感を覚えることがよくあります。この「不気味の谷効果」、つまり本物と偽物の間に生じる現象は、驚くべきものであり、同時に避けられないものです。

クリエイティブな仕事におけるよくあるシナリオを考えてみましょう。クライアントが漠然としたアイデアだけを提示した場合、最終的な成果物は期待に応えられないことがよくあります。スタイル、キャラクター、トーン、雰囲気といった要素にまで要件を絞り込むことで、初めて理想に近づくことができます。動画制作でも同じことが言えます。写真やテキストとは異なり、動画は音、キャラクター、アクションなど、複数の情報を伝えることができます。つまり、モデルはテキストの意味を「理解」するだけでなく、視覚的表現と聴覚的表現を「調整」する必要があるということです。

しかし、現在のモデルのほとんどは、入力に単一のモダリティに依存しています。近年のマルチモーダル制御の試みは、音声、表情、動作の効果的な連携を実現するのに苦労することがよくあります。これらの異なるモダリティを真に連携させ、自然でリアルな人間のような動画を生成することは、依然として困難な課題です。

これを考慮して、清華大学とByteDance Intelligent Creation Labが共同でHuMoフレームワークをリリースした。 HuMo は、「協調型マルチモーダル条件付き生成」という概念を提案し、テキスト、参照画像、音声を同じ生成モデルに組み込み、漸進的なトレーニング戦略と時間適応型ガイダンス メカニズムを通じて、ノイズ除去ステップでガイダンスの重みを動的に調整します。キャラクターの外観とオーディオとビデオの一貫性を維持する上で画期的な進歩を遂げただけでなく、ビデオ生成を「多段階のスプライシング」から「ワンストップ生成」へと進化させました。

用紙のアドレス:

https://arxiv.org/abs/2509.08519

元の倉庫:

https://github.com/phantom-video/humo

さらに、テキスト追跡や画像の一貫性など、複数のサブタスクにおける HuMo のパフォーマンスは SOTA に達しました。このプロジェクトでは、1.7Bと17Bという2つのモデルを提供しています。どちらも軽量でプレイアブル、プロフェッショナル向け、研究向けと、クリエイターや開発者のさまざまなニーズに対応しています。17Bモデルで生成されたエフェクトを見てみましょう。

「HuMo-1.7B:マルチモーダル動画生成フレームワーク」と「HuMo-17B:トライモーダル協働制作」が、HyperAI公式サイト(hyper.ai)の「チュートリアル」セクションに公開されました。ぜひお試しください。より多くの情報を与えることで、モデルは満足のいく動画を生成できるでしょうか?

チュートリアルのリンク:

HuMo-1.7B:https://go.hyper.ai/BGQT1

HuMo-17B:https://go.hyper.ai/RSYA

デモの実行

1. hyper.ai ホームページで「チュートリアル」ページを選択し、「HuMo-1.7B: マルチモーダル ビデオ生成フレームワーク」を選択して、「このチュートリアルをオンラインで実行」をクリックします。

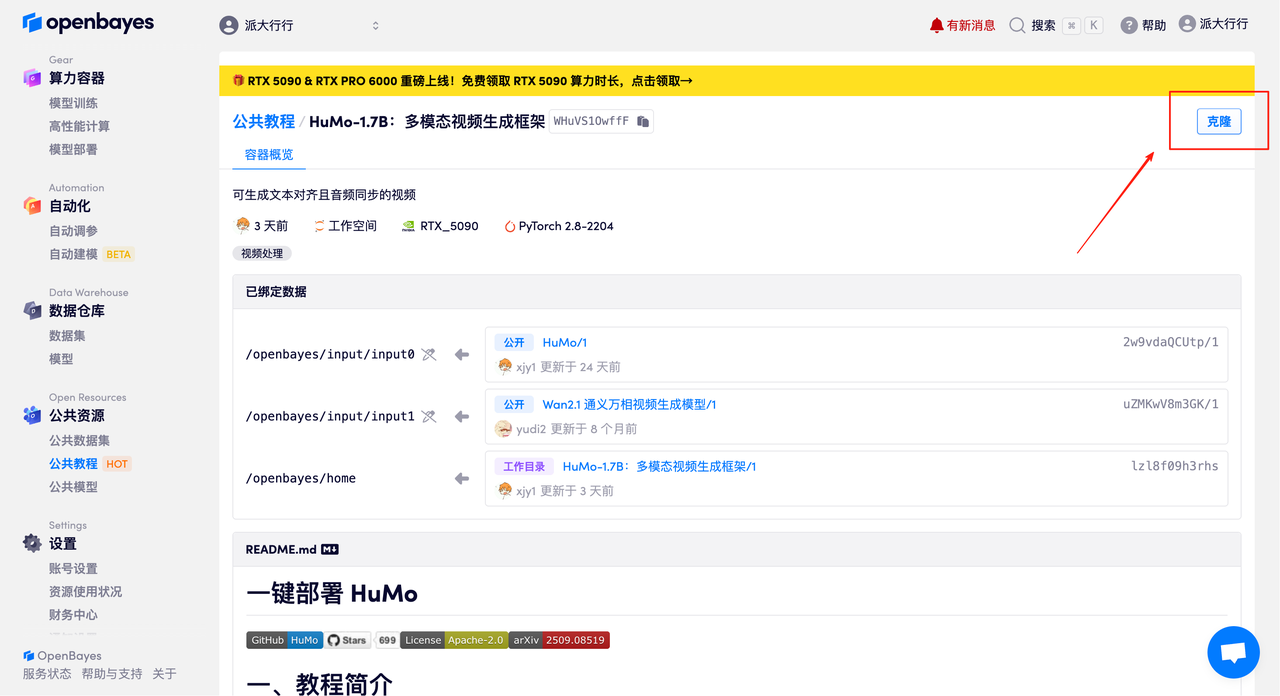

2. ページがジャンプしたら、右上隅の「クローン」をクリックしてチュートリアルを独自のコンテナにクローンします。

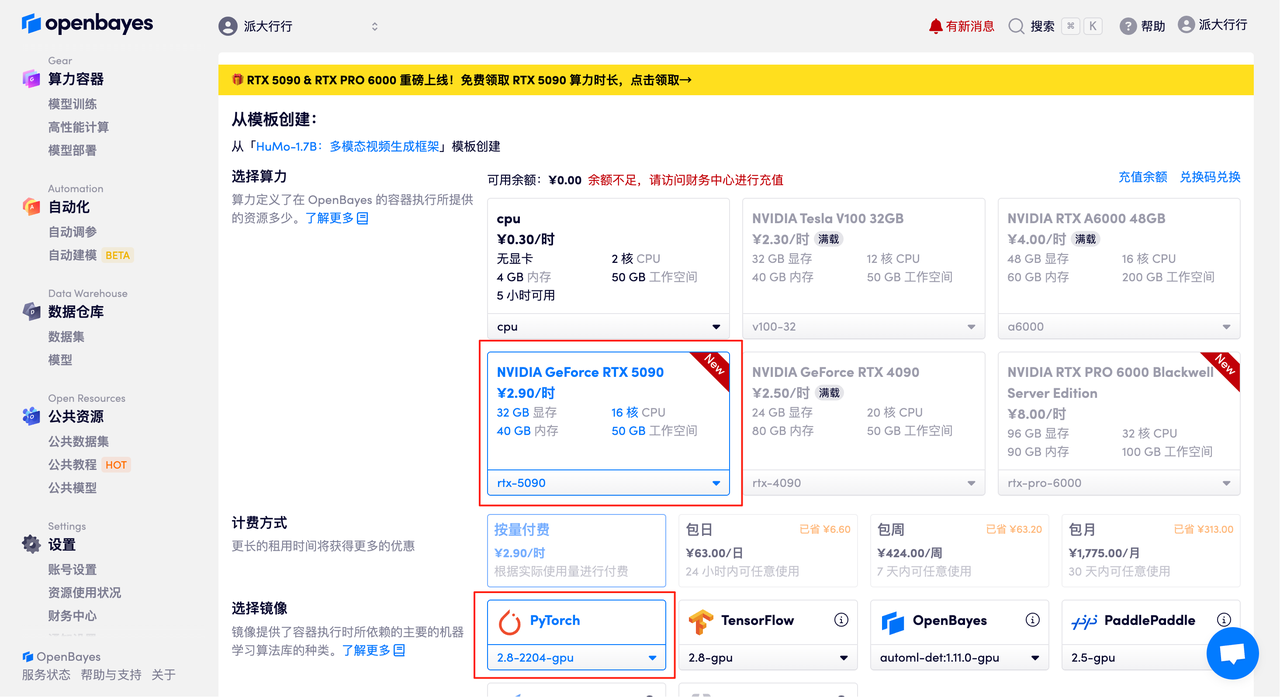

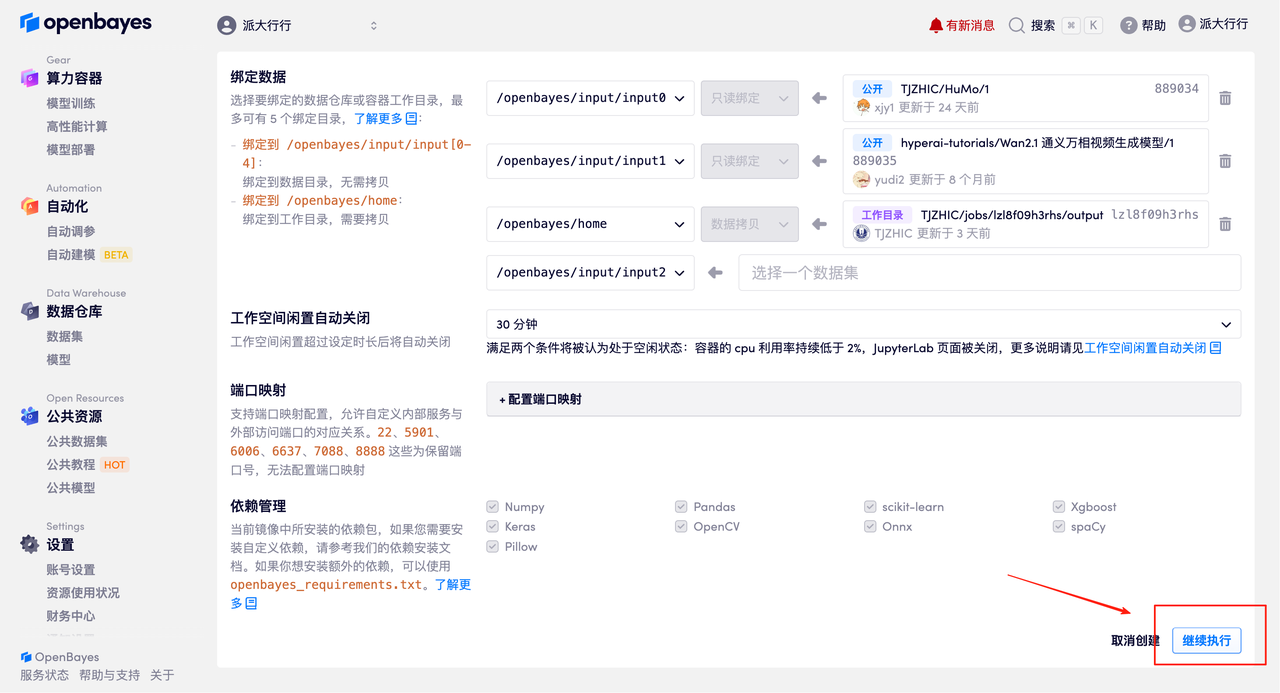

3. NVIDIA GeForce RTX 5090とPyTorchのイメージを選択し、「続行」をクリックします。OpenBayesプラットフォームでは、従量課金制、日単位/週単位/月単位の4つの課金オプションをご用意しています。新規ユーザーは、以下の招待リンクから登録すると、RTX 5090を4時間分、CPU時間を5時間分無料でご利用いただけます。

HyperAI ハイパーニューラルの専用招待リンク (ブラウザに直接コピーして開きます):

https://openbayes.com/console/signup?r=Ada0322_NR0n

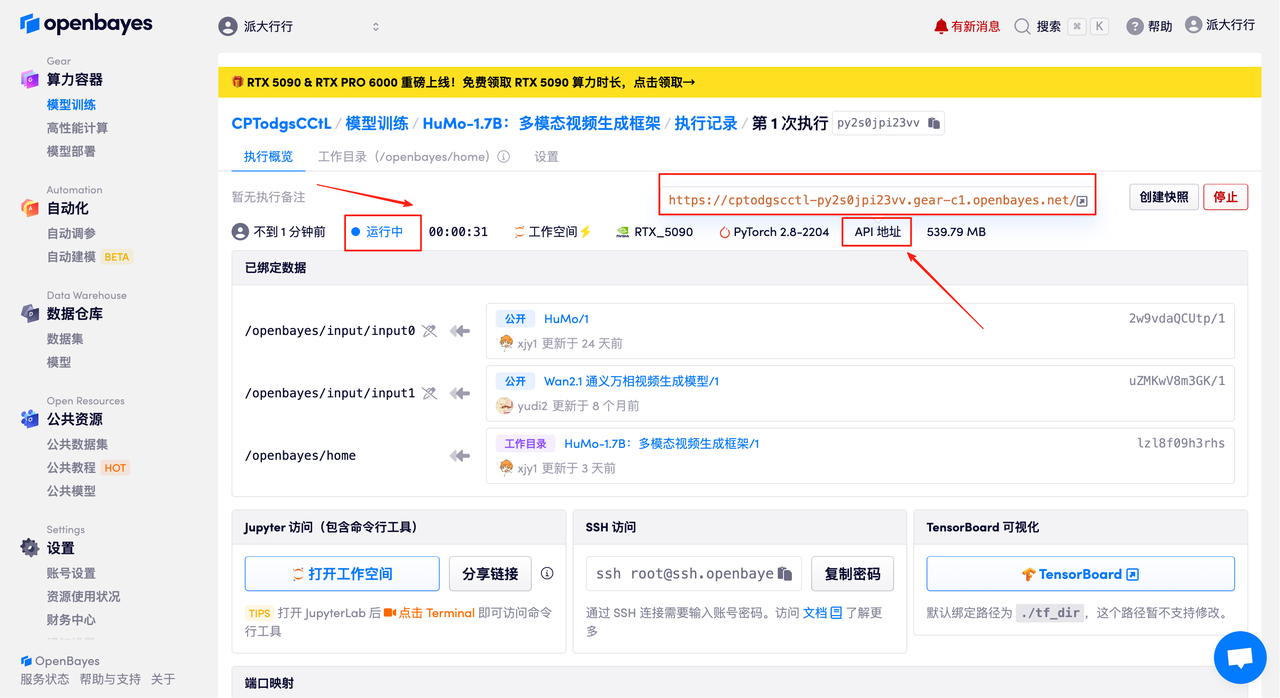

4. リソースが割り当てられるのを待ちます。最初のクローン作成には約2分かかります。ステータスが「実行中」に変わったら、「ワークスペースを開く」をクリックしてデモページに移動します。

効果実証

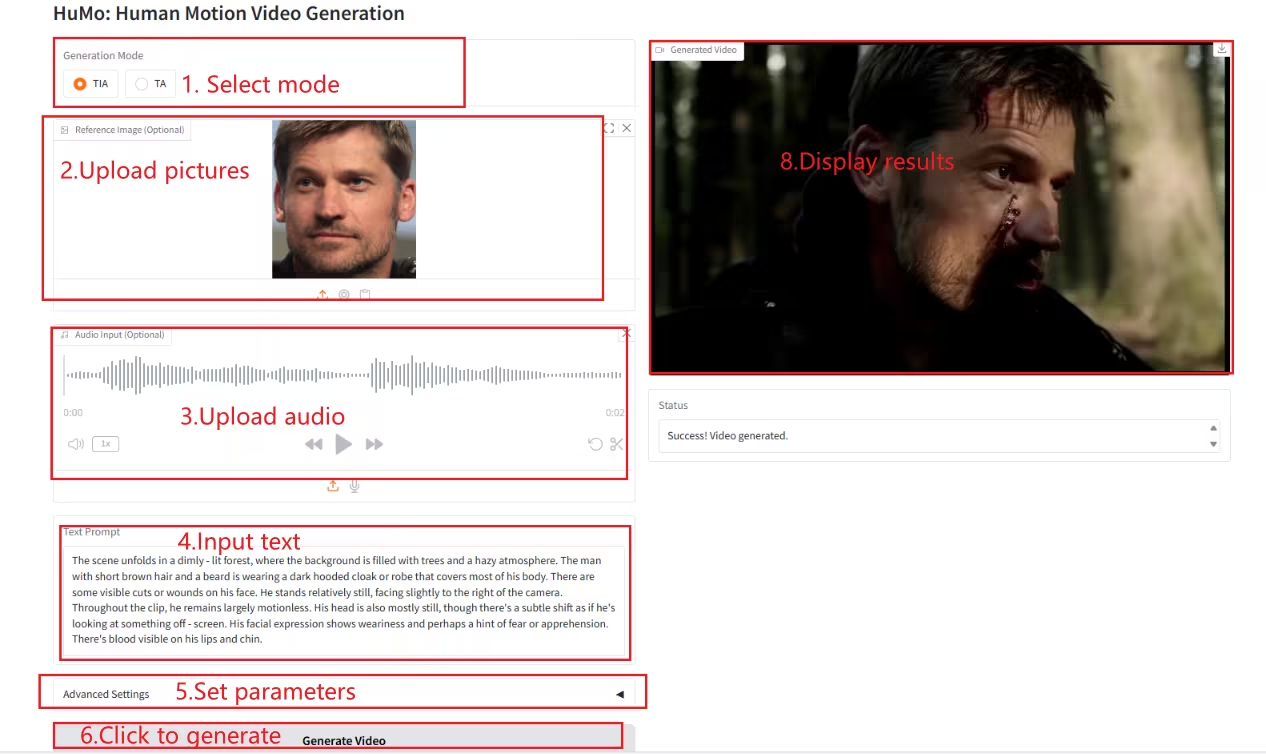

デモページにアクセスしたら、テキストボックスに説明を入力し、画像と音声をアップロードし、必要に応じてパラメータを調整して、「ビデオを生成」をクリックしてビデオを生成します。(注:サンプリングステップを10に設定した場合、ビデオの生成には約3~5分かかります。)

例を生成する

以上が今回HyperAIがおすすめするチュートリアルです。ぜひ皆さんも体験してみてください!

チュートリアルのリンク:

HuMo-1.7B:https://go.hyper.ai/BGQT1

HuMo-17B:https://go.hyper.ai/RSYA私