Command Palette

Search for a command to run...

NeurIPS 2025:華中科技大学などがOCRBench v2をリリース。Geminiは中国語ランキングで1位を獲得したが、合格点にとどまった。

過去数十年にわたり、光学文字認識(OCR)技術の位置付けと価値は飛躍的な進化を遂げ、従来の画像認識ツールからインテリジェント情報システムの中核機能へと進化しました。当初は、主に画像から印刷文字や手書き文字を抽出し、コンピュータが理解できるテキストデータに変換することが主な役割でした。今日では、多様なニーズに支えられたディープラーニングやマルチモーダルモデルの発展により、OCR技術の限界は絶えず拡大しています。文字認識だけでなく、文書の構造と意味も理解できるようになっています。複雑なシナリオにおける表、レイアウト、混合テキストとグラフィックを正確に解析します。

さらに、大規模マルチモーダル事前学習では、モデルはウェブページのスクリーンショット、UIインターフェース、ポスター、ドキュメントなど、テキストを含む大量の画像データにさらされ、教師なし学習プロセスの中でOCR機能が自然に構築されます。これにより、大規模モデルは外部のOCRモジュールに依存する必要がなくなります。代わりに、エンドツーエンドの推論プロセスで認識、理解、回答を直接完了できます。さらに重要なのは、OCR技術が高度なインテリジェントタスクの前提条件になりつつあることです。モデルが画像内のテキストを正確に認識できる場合にのみ、チャート解析、文書の質問回答、知識抽出、さらにはコード理解といった機能をさらに完成させることができます。

OCRタスクにおけるパフォーマンスも、大規模マルチモーダルモデルの能力を評価する重要な指標の一つと言えるでしょう。現在のニーズは「テキストの読み上げ」をはるかに超えています。表、グラフ、手書きのメモ、文書内の複雑なレイアウト、テキスト画像におけるテキスト配置、テキストベース推論などは、モデルが克服すべき困難な課題です。しかし、従来の OCR 評価ベンチマークのほとんどは単一のタスクと限られたシナリオで構成されているため、モデル スコアが急速に飽和し、複雑なアプリケーションでその機能を真に反映することが困難になります。

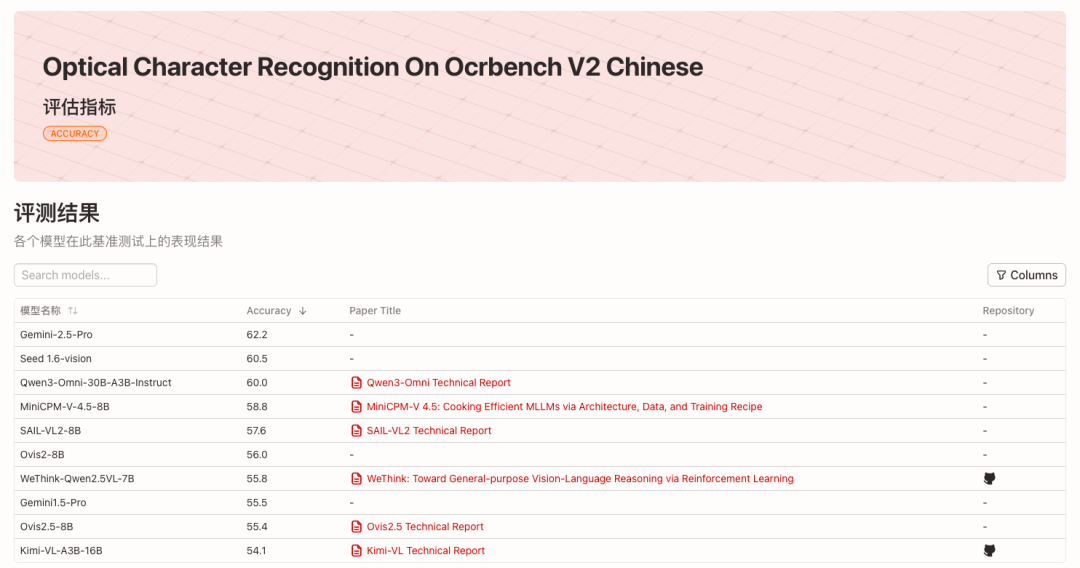

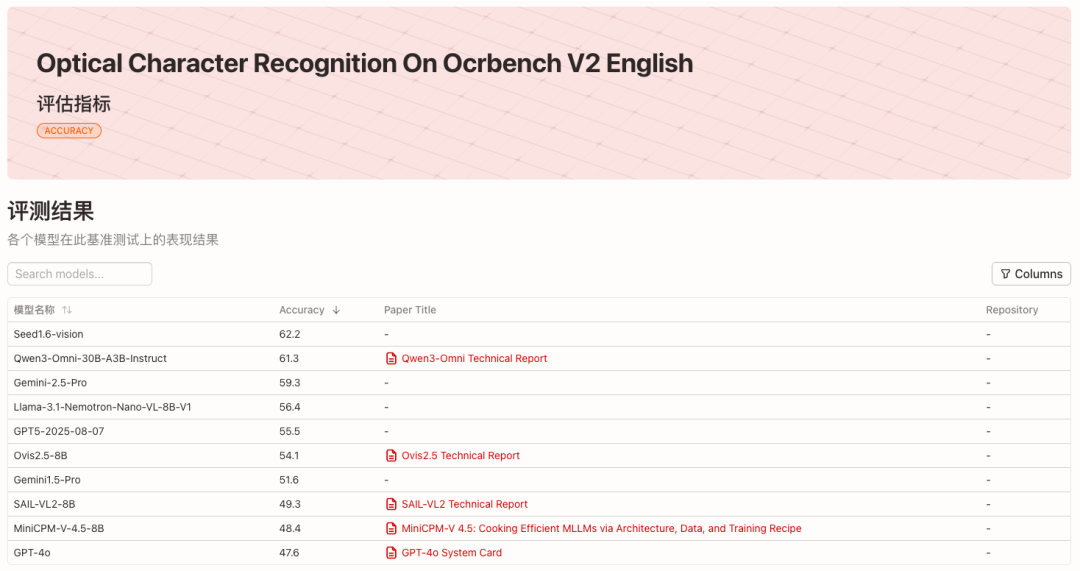

これを考慮して、華中科技大学の白翔氏のチームは、華南理工大学、アデレード大学、ByteDance と共同で、次世代 OCR ベンチマーク OCRBench v2 を発表しました。2023年から2025年にかけて、中国語と英語の両方で主流のマルチモーダルモデル58種類を評価しました。各リストの上位10モデルを下図に示します。

* 英語のランキングを見る:

* 中国語リストを見る:

* プロジェクトのオープンソースアドレス:

https://github.com/Yuliang-Liu/MultimodalOCR

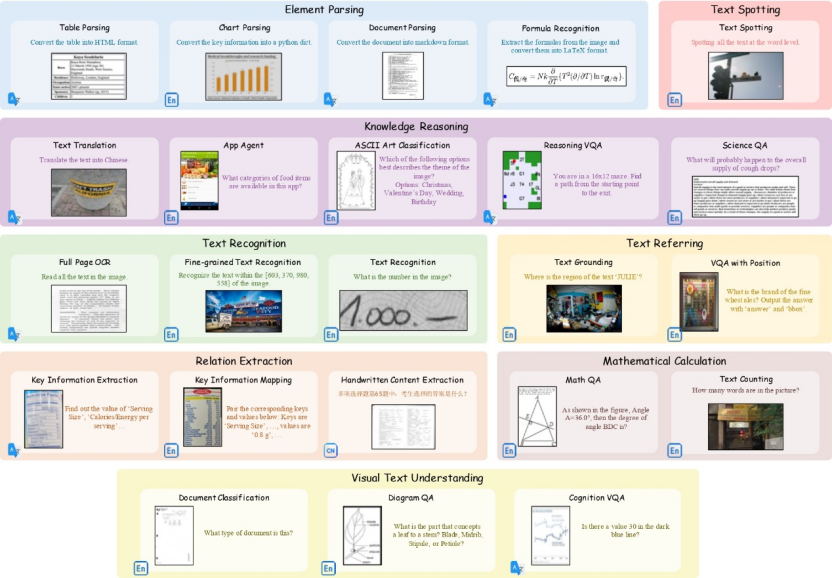

多様なシナリオをカバーする23のサブタスク

OCRBench v2 は、23 のサブタスクと 8 つのコア機能ディメンションをカバーします。——テキスト認識、テキストの配置、テキストの検出と認識、関係の抽出、要素の解析、数学的計算、視覚的なテキストの理解と知識の推論。

OCRBench v2の公開データセットには、80以上の学術データセットと一部の独自データから抽出された10,000件の高品質なQAが含まれています。これらは、実世界のOCRアプリケーションにおける多様なシナリオを網羅できるよう、手作業でレビューされています。さらに、OCRBench v2には、手作業で収集・注釈付けされた1,500件のQAからなる独立したプライベートデータも含まれています。タスク設定とシナリオカバレッジは、公開データセットと一致しています。

* データセットのダウンロードアドレス:

https://go.hyper.ai/VNHSX

チームの実験により、公開データと非公開データのランキングは非常に一貫していることが判明しました。これは、OCRBench v2 のタスク設計、データ構築、評価指標の合理性を証明しています。これは、大規模なマルチモーダル モデルの既存の制限を測定する上での重要な価値を示しています。

関連研究論文「OCRBench v2: ビジュアルテキストローカリゼーションおよび推論に関する大規模マルチモーダルモデルを評価するための改良ベンチマーク」が、NeurIPS 2025 (データセットおよびベンチマークトラック) に掲載されました。

* 紙のアドレス:

https://go.hyper.ai/VNHSX

主流のモデルは一般的に偏っており、最高スコアは合格点程度です。

OCRBench v2が公開した最新の評価リストでは、Gemini-2.5-Proは中国語リストで1位、英語リストで3位を獲得し、Seed1.6-visionは英語リストで1位、中国語リストで2位を獲得しました。オープンソース陣営では、Qwen3-Omni-30B-A3B-Instruct が、英語リストで 2 位、中国語リストで 3 位にランクされました。

モデルのコア機能のパフォーマンスを分析すると、これらの大規模なマルチモーダルモデルは一般的に「偏り」のある現象を示すことがわかります。すべてのコア機能において優れたパフォーマンスを発揮できるモデルはほとんどありません。上位にランクされたモデルでさえ、英語と中国語の両方のタスクで平均スコアが100点満点中60点程度しか達成できませんでした。さらに、各モデルにはそれぞれ若干異なる強みがあります。例えば、Gemini-2.5-Proなどの市販モデルは、計算問題において明確な優位性を示し、強力な論理的推論能力を発揮しています。Llama-3.1-Nemotron-Nano-VL-8B-V1は、強力なテキストローカリゼーション機能を備えており、英語ランキングで4位を獲得しました。

ほとんどのモデルは基本的なテキスト認識ではまずまずの性能を発揮しますが、参照、スポッティング、構文解析といった、きめ細かな空間認識と構造的理解を必要とするタスクでは、一般的に低いスコアしか出ません。例えば、トップランクのSeed1.6-visionモデルでさえ、スポッティングのスコアはわずか38.0で、テキストベースのシーンやテキストと画像が混在する文書といった現実世界のシナリオでは、その有効性が限られています。

さらに、中国語と英語のリストを比較すると、多くのモデルの多言語機能は不均一であることがわかります。たとえば、Llama-3.1-Nemotron-Nano-VL-8B-V1 は英語のリストでは 4 位 (平均スコア 56.4) ですが、中国語のリストでは 31 位 (平均スコア 40.1) に過ぎません。これは、データ配分やトレーニング戦略に関連している可能性があり、英語のシナリオでより大きな利点があることを示しています。

同時に、クローズドソースモデルは依然として優位を維持しているものの、優れたオープンソースモデルも競争力を高めています。リストを見ると、Geminiシリーズ、GPT5、Seed1.6-visionなどのクローズドソースモデルは全体的なパフォーマンスが優れていますが、Qwen-Omni、InternVL、SAIL-VL、Ovisなどのオープンソースモデルも競争力を高めています。英語のリストの上位 10 モデルのうち 5 つはオープンソース モデルであり、中国語のリストの上位 10 モデルのうち 7 つはオープンソース モデルです。オープンソース モデルは、テキストのローカリゼーション、要素の抽出、視覚的なテキストの理解などのタスクでも最先端のパフォーマンスを実現できます。

OCRBench v2 のランキングは四半期ごとに更新され、HyperAI は最新の評価結果を継続的に追跡します。