Command Palette

Search for a command to run...

オンラインチュートリアル: 映画品質のビデオ生成モデルである Wan2.2-S2V-14B は、静止画像と音声のみを使用して 1 分間のデジタルヒューマンビデオを生成します。

HyperAIは先日、アリババのTongyi Wanxiang Labが開発したオープンソースのAI動画生成モデル「Wan2.2」のオンラインチュートリアルを公開しました。世界初のMoEベースの動画モデルであるWan2.2は、その映画のようなクオリティと高い計算効率で私たちを驚かせました。Wan2.2を使った感想はいかがでしたか?ぜひコメント欄でご意見をお聞かせください。

今年8月、同義万向チームは新たな進歩を遂げました。Wan2.2テキスト動画変換基本モデルをベースに、Wan-14Bを開発しました。これを基に、オーディオ駆動型ビデオ生成オープンソースモデル Wan2.2-S2V-14B がリリースされました。このモデルに必要なのは静止画像とオーディオ クリップだけです。映画レベルの品質で最長数分の長さのデジタルヒューマンビデオを生成でき、さまざまな画像タイプとフレームをサポートします。研究チームは既存の最先端モデルと比較する実験を行い、その結果、Wan2.2-S2V-14Bは表現力と生成されたコンテンツの信憑性の両方において大幅な向上が見られました。

複雑なシナリオでのモデル生成品質をサポートするために、研究チームは 2 つの戦略を採用し、より包括的なトレーニング データセットをコンパイルしました。研究チームは、OpenHumanViDなどの大規模オープンソースデータセットからデータを自動的に選別しました。一方で、研究者らは高品質なサンプルデータを手動で選定し、カスタマイズしました。両方のデータセットは、姿勢追跡、明瞭度と美観の評価、音声と映像の同期検出など、複数の手法を用いて均一にフィルタリングされ、最終的にトーキングヘッドデータセットが構築されました。ハイブリッドな並列学習戦略を用いることで、効率的なモデルパフォーマンスマイニングを実現しました。

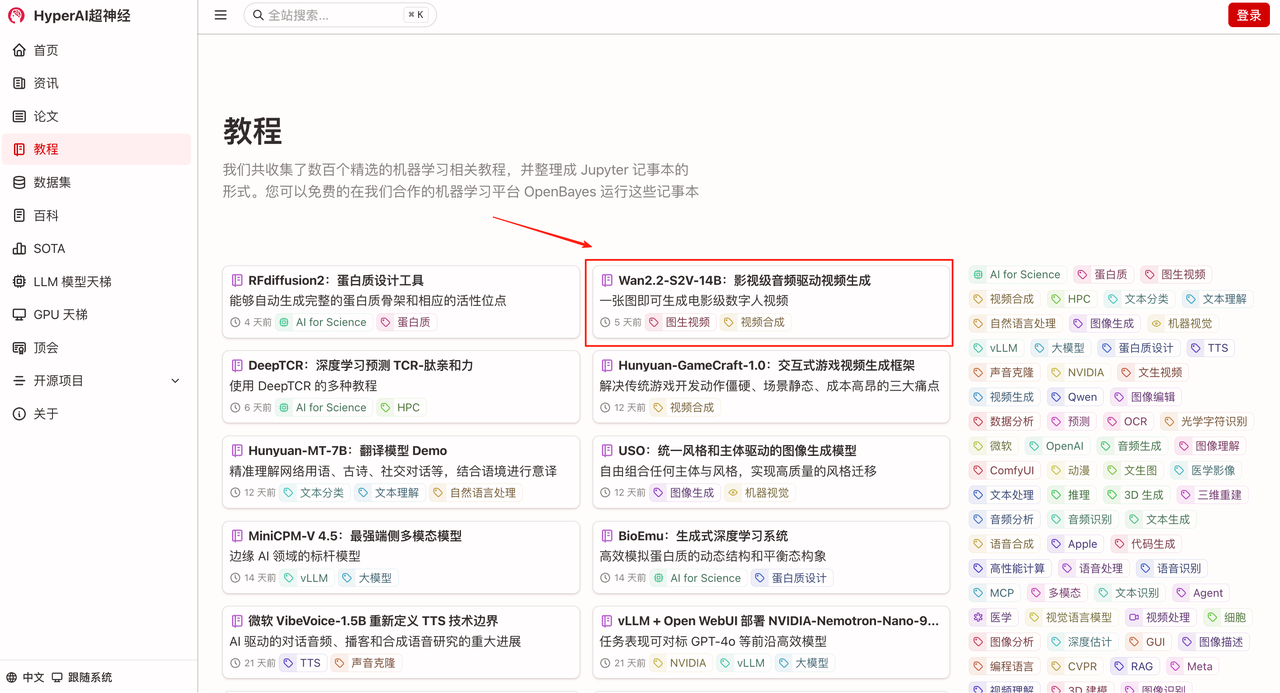

「Wan2.2-S2V-14B: シネマティックオーディオ駆動型ビデオ生成」が、HyperAI公式サイト(hyper.ai)の「チュートリアル」セクションで公開されました。さあ、あなただけのデジタルヒューマンを作りましょう!

チュートリアルのリンク:

デモの実行

1. hyper.ai ホームページで「チュートリアル」ページを選択し、「Wan2.2-S2V-14B: 映画品質のオーディオ駆動型ビデオ生成」を選択して、「このチュートリアルをオンラインで実行」をクリックします。

2. ページがジャンプしたら、右上隅の「クローン」をクリックしてチュートリアルを独自のコンテナにクローンします。

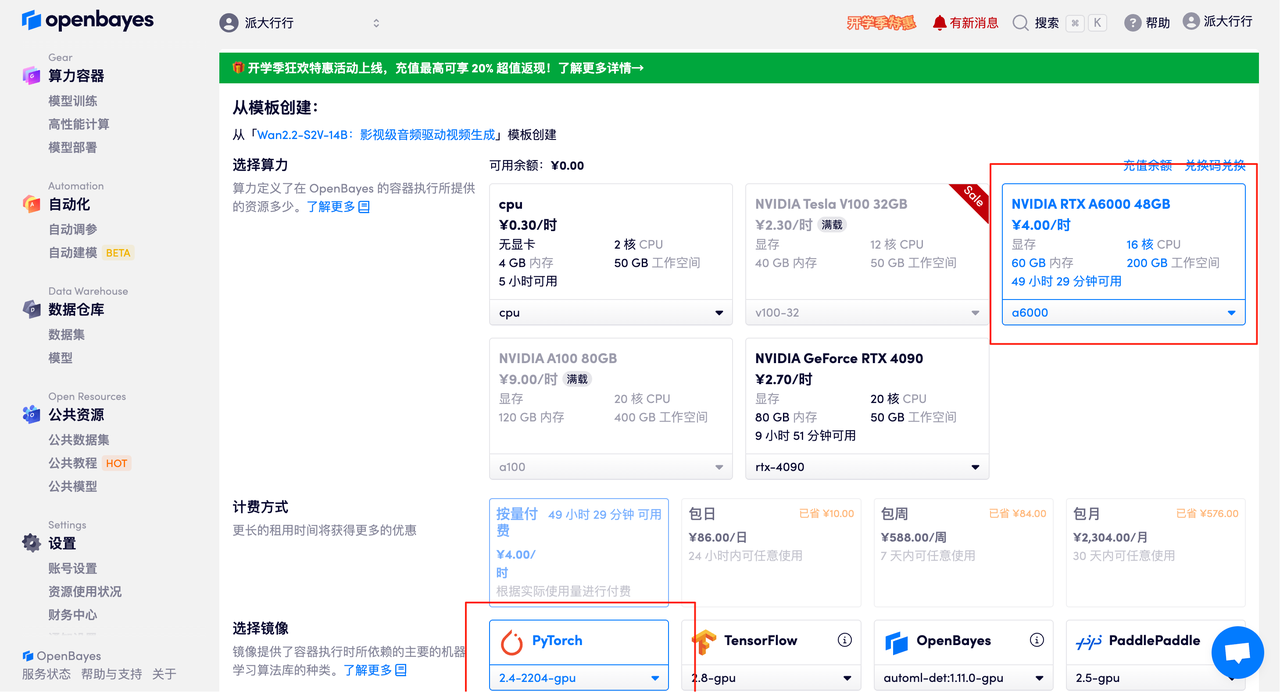

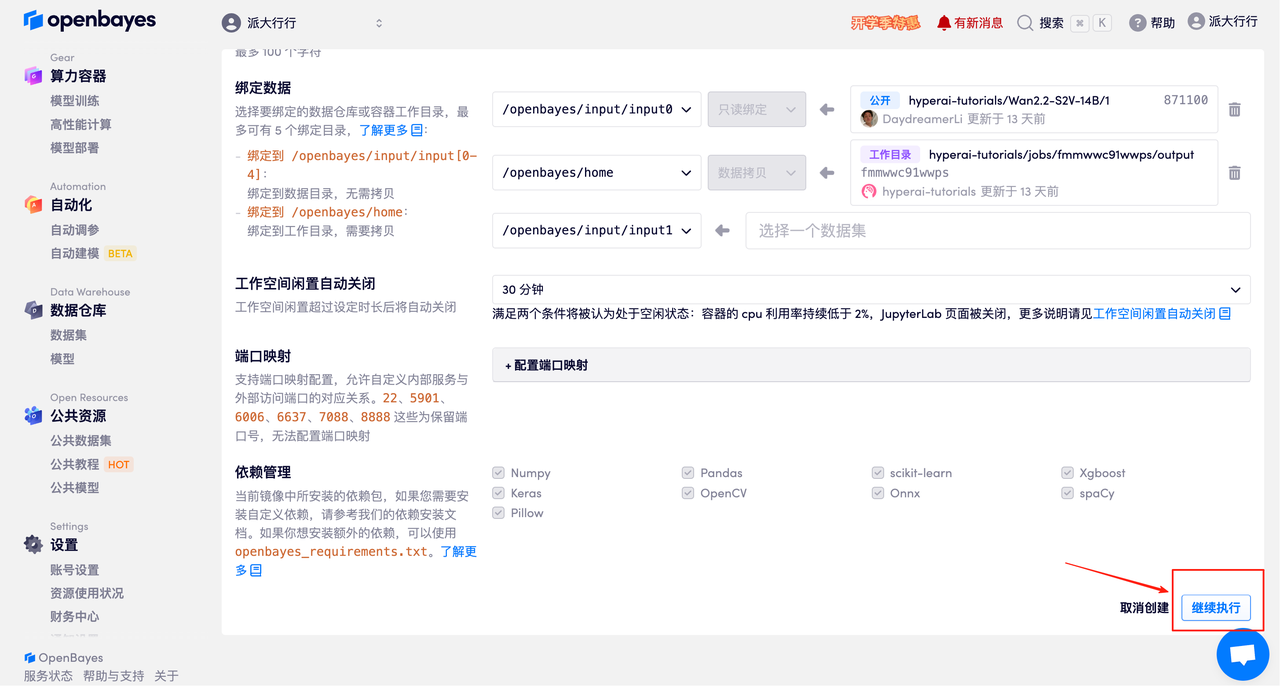

3. NVIDIA RTX A6000 48GBとPyTorchのイメージを選択し、「続行」をクリックします。OpenBayesプラットフォームでは、従量課金制、日単位/週単位/月単位の4つの課金オプションをご用意しています。新規ユーザーは、以下の招待リンクから登録すると、RTX 4090を4時間分、CPU時間を5時間分無料でご利用いただけます。

HyperAI ハイパーニューラルの専用招待リンク (ブラウザに直接コピーして開きます):

https://openbayes.com/console/signup?r=Ada0322_NR0n

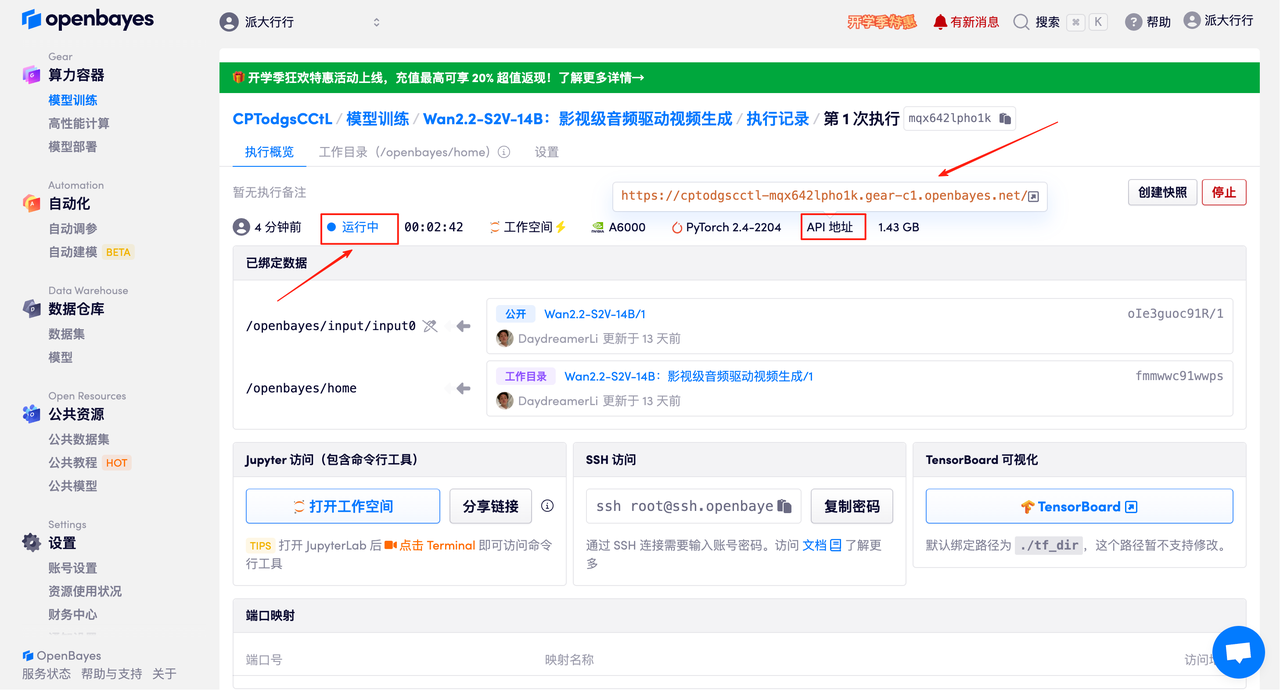

4. リソースが割り当てられるまでお待ちください。最初のクローン作成プロセスには約3分かかります。ステータスが「実行中」に変わったら、「APIアドレス」の横にある矢印をクリックしてデモページに移動します。APIアドレスを使用する前に、実名認証を完了する必要がありますのでご注意ください。

効果実証

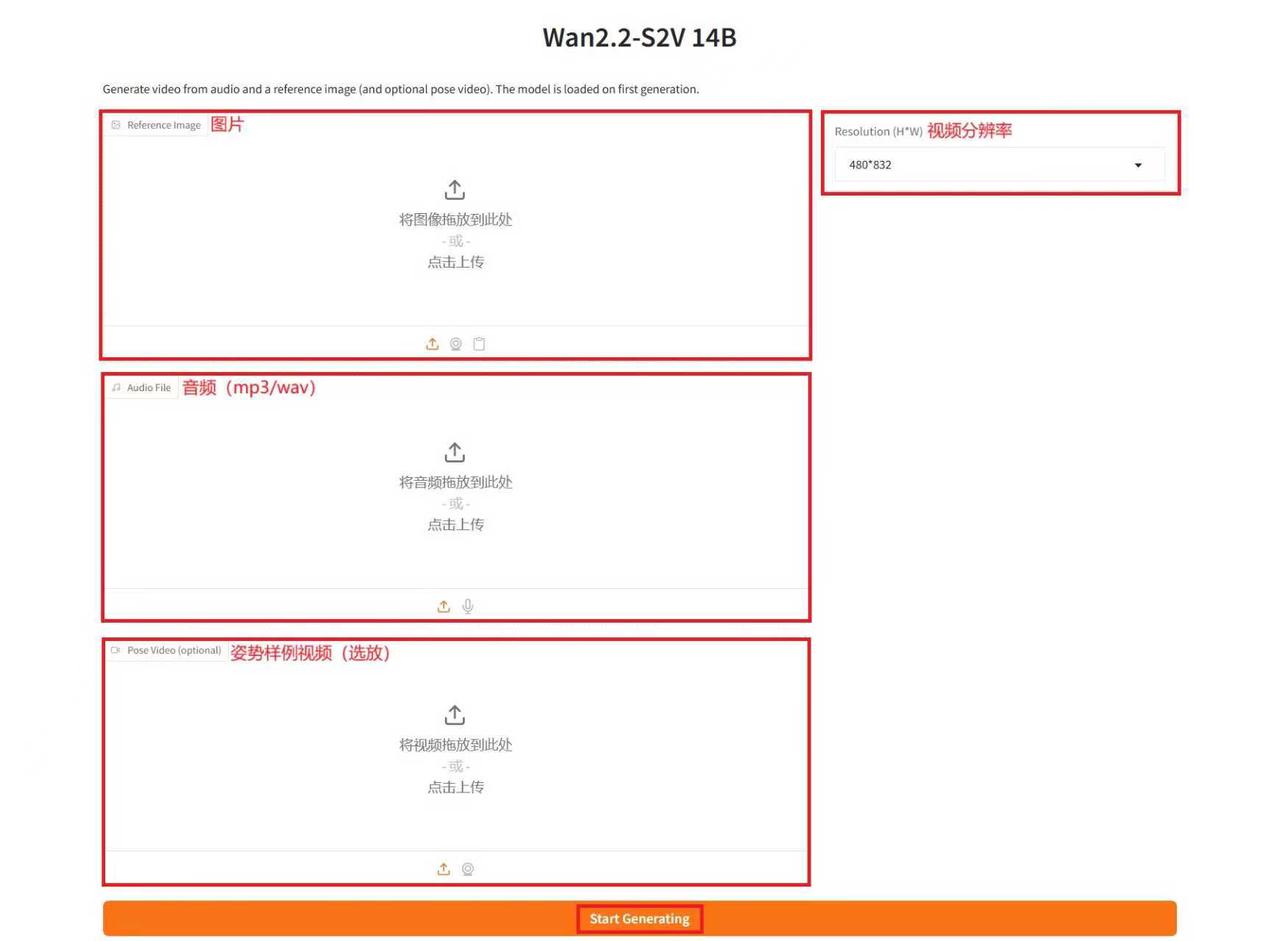

デモ実行ページにアクセスしたら、テキストボックスに説明を入力し、画像と音声をアップロードし、必要に応じてパラメータを調整して、「生成を開始」をクリックしてビデオを生成します。(注:推論ステップ数が多いほど結果は良くなりますが、生成に時間がかかります。推論ステップ数は適切に設定してください。例えば、推論ステップ数が10の場合、ビデオの生成には約15分かかります。)

例を生成する

以上が今回HyperAIがおすすめするチュートリアルです。ぜひ皆さんも体験してみてください!

チュートリアルのリンク: