Command Palette

Search for a command to run...

オンラインチュートリアル丨9秒で画像を処理します! In-Context Editの効率的な画像編集フレームワークがリリースされました

既存の画像編集方法は、主に、精度と効率性のバランスを取るのが難しいという問題に直面しています。微調整法には大量のコンピューティング リソースと高品質のデータセットが必要ですが、トレーニングなしの手法では、指示の理解と編集の品質を満たすことが困難です。この点について、浙江大学とハーバード大学の研究チームは、コマンドベースの画像編集フレームワークであるIn-Context Edit(ICEdit)を立ち上げました。いくつかのテキスト コマンドだけで正確な画像修正が可能になり、画像処理やコンテンツ作成の可能性が広がります。

In-Context Edit は、コンテキスト編集フレームワーク、LoRA-MoE ハイブリッド チューニング戦略、および早期フィルター推論時間スケーリング法という 3 つの主要な貢献を通じて、既存の手法の限界に対処します。従来の方法と比較すると、1% のトレーニング可能なパラメータ (200M) と 0.1% のトレーニング データ (50k) のみを使用しますが、より優れた一般化能力を示し、さまざまな画像編集タスクを処理できます。同時に、ジェミニとGPT-4oと比較すると、このオープンソース ツールは、安価で高速なだけでなく (画像の処理には約 9 秒しかかかりません)、非常に強力なパフォーマンスも備えています。

現在のところ、HyperAI の公式 Web サイトの「チュートリアル」セクションで、「In-Context Edit: コマンド駆動型画像生成および編集」が開始されました。ワンクリックデプロイチュートリアルを体験するには、以下のリンクをクリックしてください⬇️

チュートリアルのリンク:https://go.hyper.ai/SHowG

デモの実行

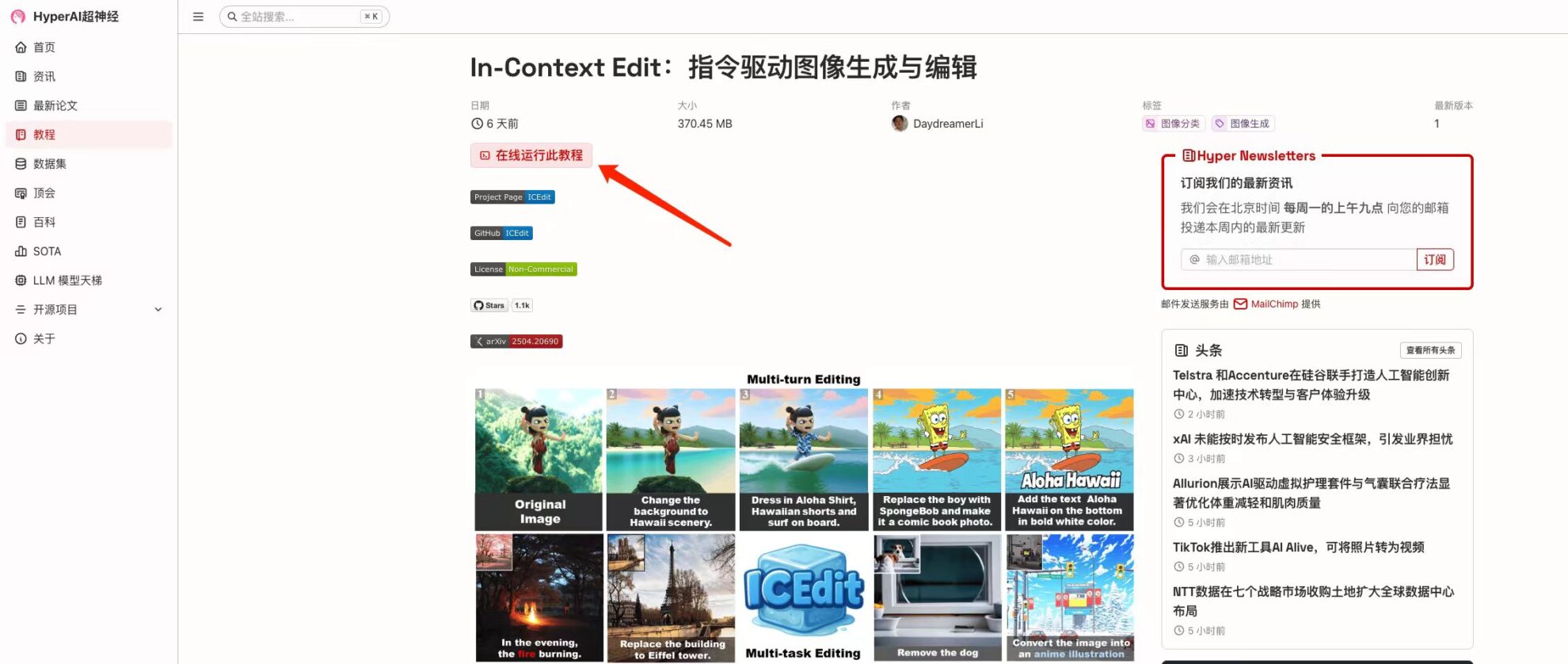

1. hyper.ai ホームページにアクセス後、「チュートリアル」ページを選択し、「インコンテキスト編集: コマンド駆動型画像生成および編集」を選択して、「このチュートリアルをオンラインで実行」をクリックします。

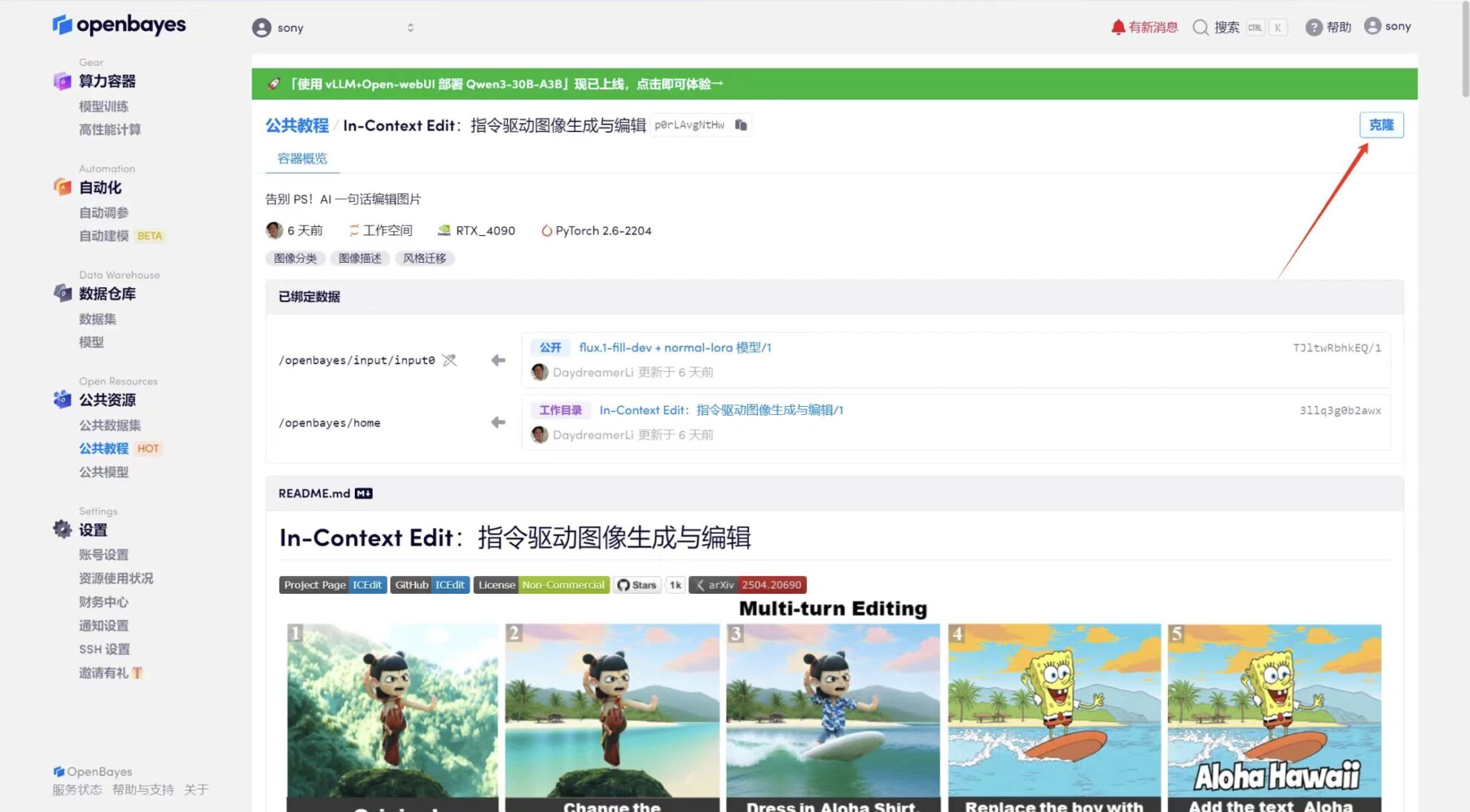

2. ページがジャンプしたら、右上隅の「クローン」をクリックしてチュートリアルを独自のコンテナにクローンします。

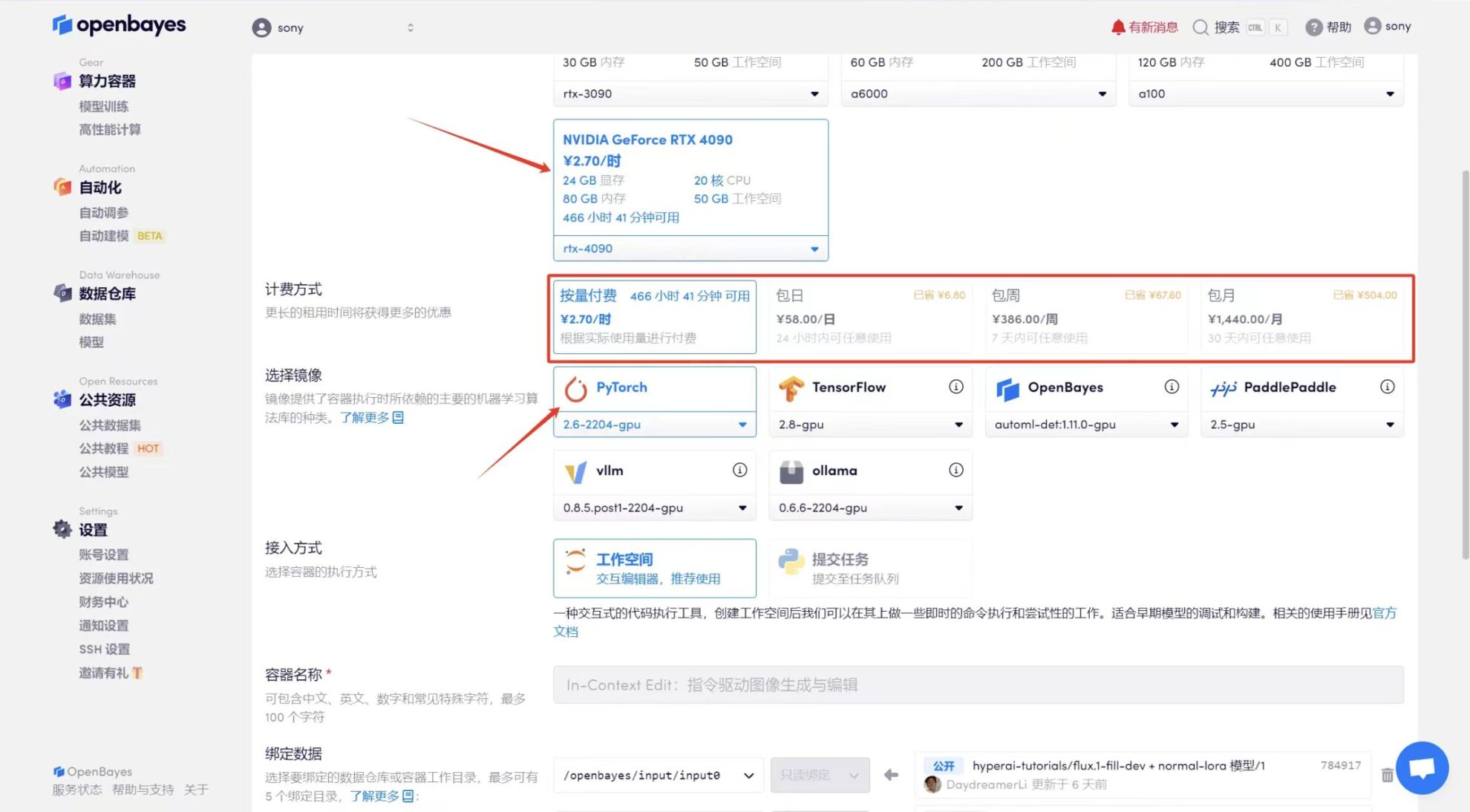

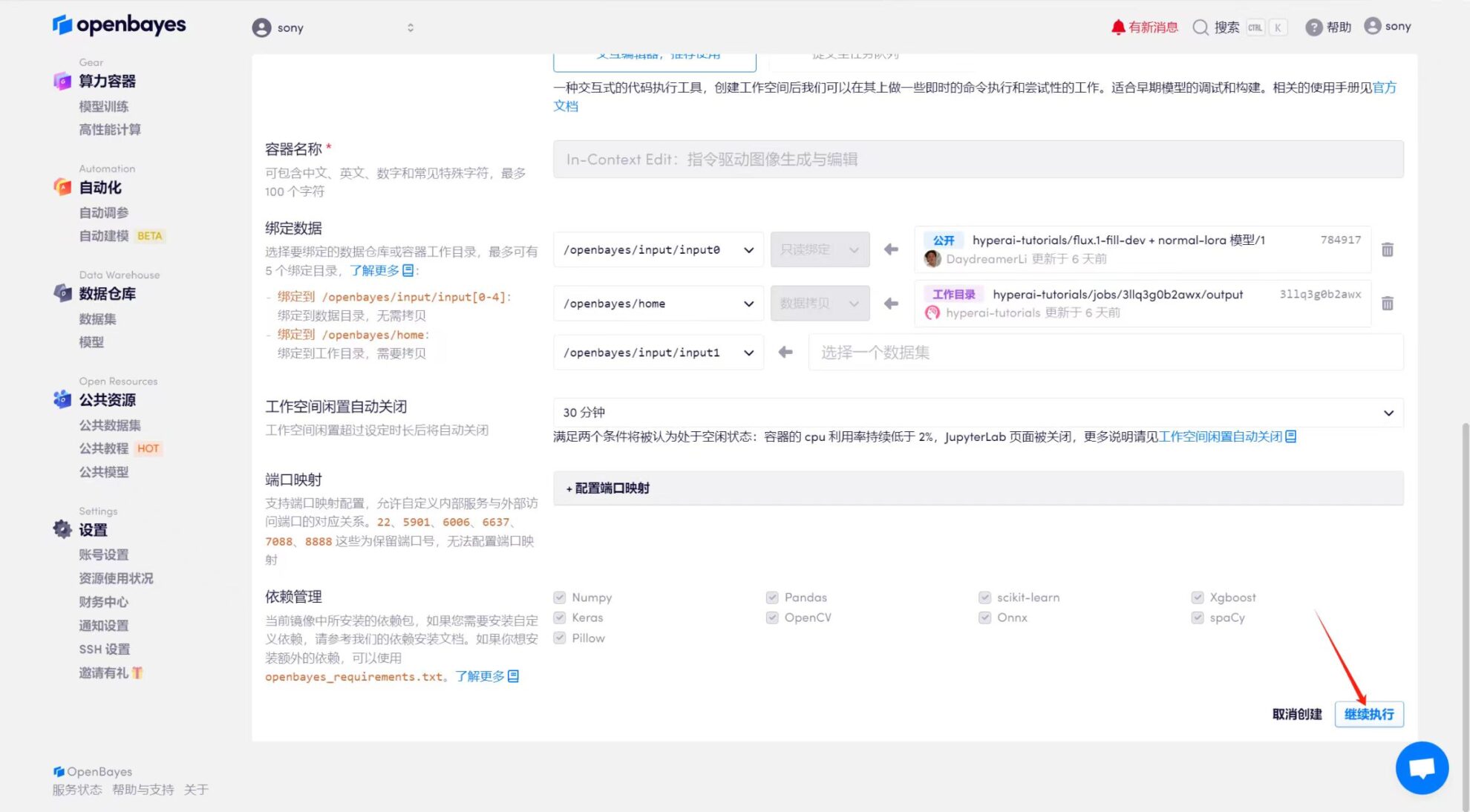

3. 「NVIDIA GeForce RTX 4090」と「PyTorch」のイメージを選択します。 OpenBayes プラットフォームは 4 つの課金方法を提供します。ニーズに応じて、「従量制」または「日次/週次/月次」を選択できます。 「続行」をクリックします。新規ユーザーは、以下の招待リンクを使用して登録すると、4 時間の RTX 4090 + 5 時間の CPU フリー時間を獲得できます。

HyperAI ハイパーニューラルの専用招待リンク (ブラウザに直接コピーして開きます):

https://openbayes.com/console/signup?r=Ada0322_NR0n

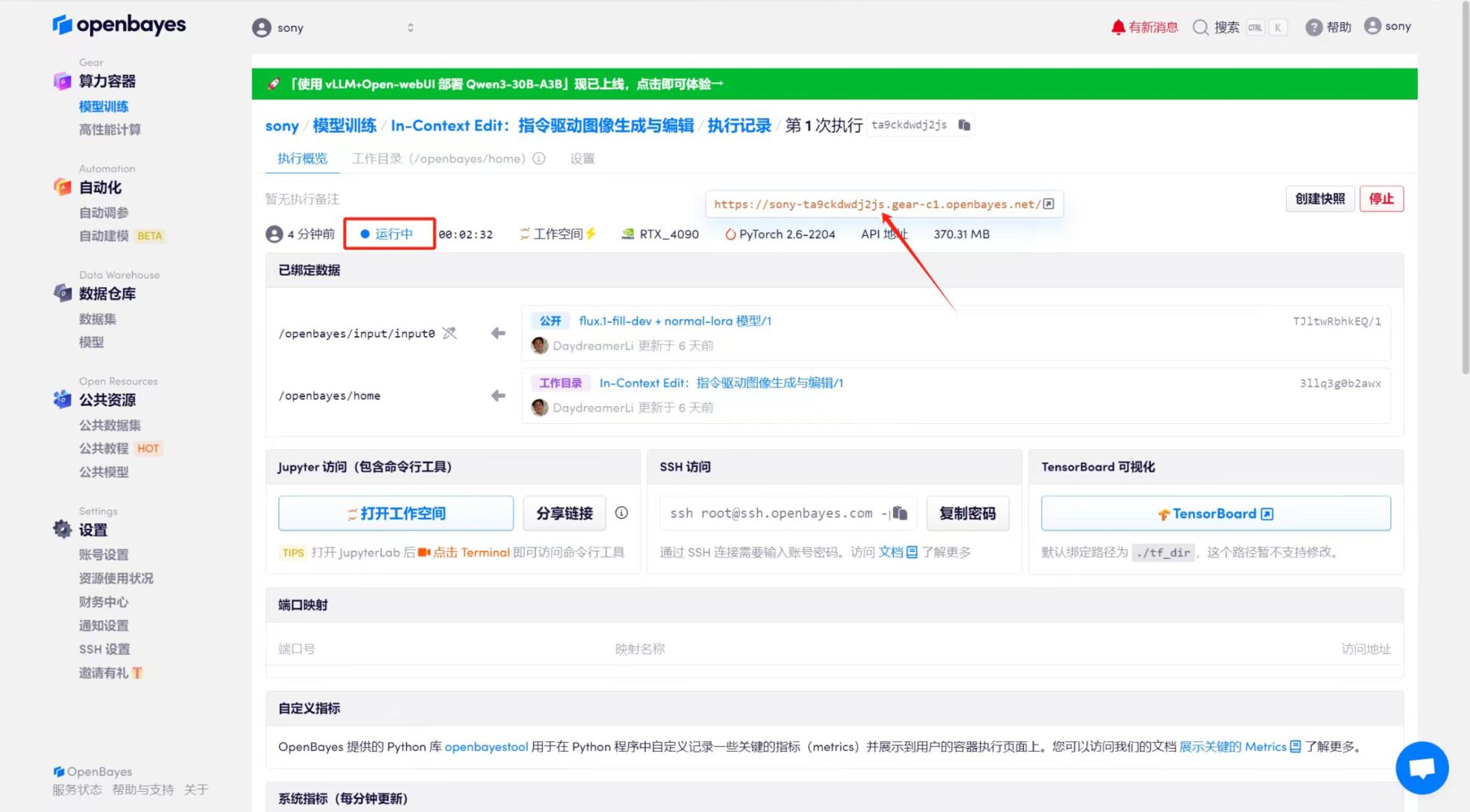

4. リソースが割り当てられるのを待ちます。最初のクローン作成プロセスには約 2 分かかります。ステータスが「実行中」に変わったら、「API アドレス」の横にあるジャンプ矢印をクリックしてデモ ページに移動します。モデルが大きいため、WebUI インターフェイスが表示されるまでに約 3 分かかります。そうでない場合は、「Bad Gateway」と表示されます。 APIアドレスアクセス機能を使用する前に、ユーザーは実名認証を完了する必要がありますのでご注意ください。

エフェクト表示

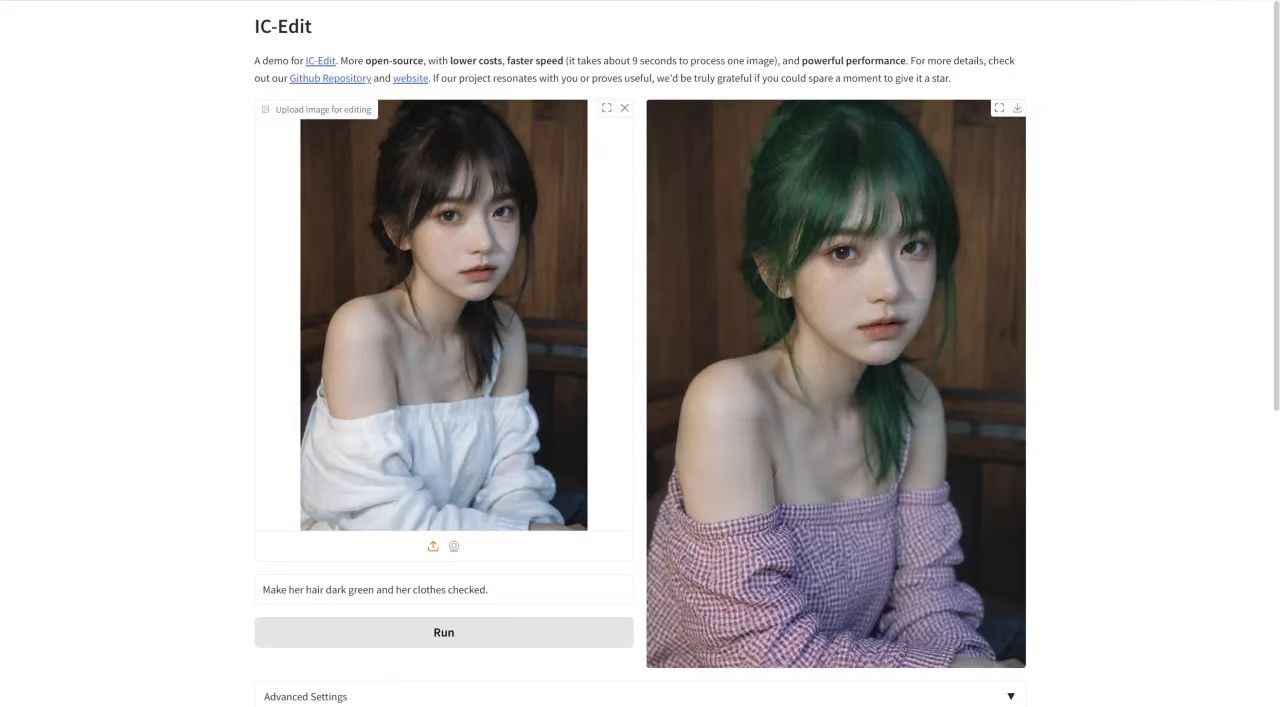

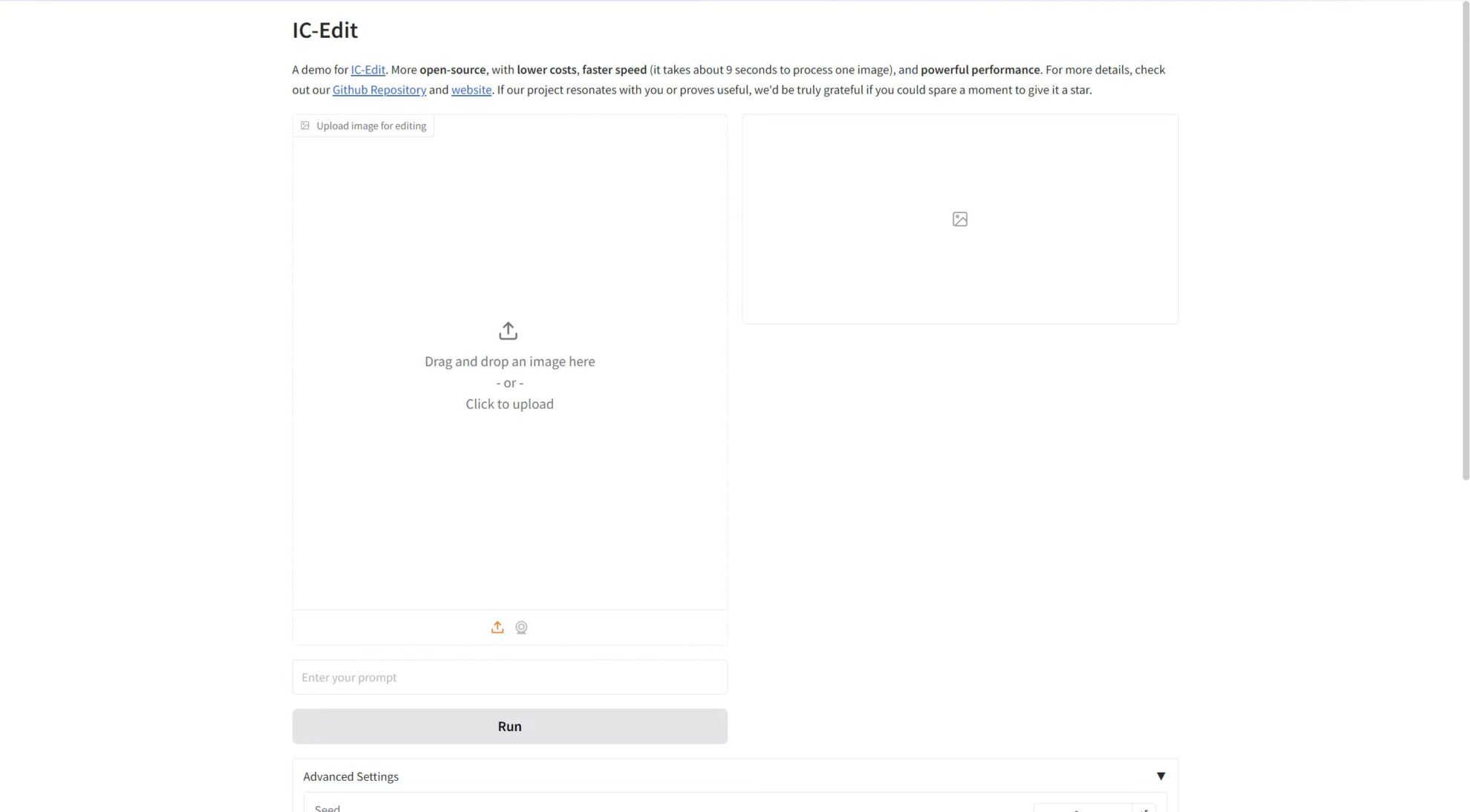

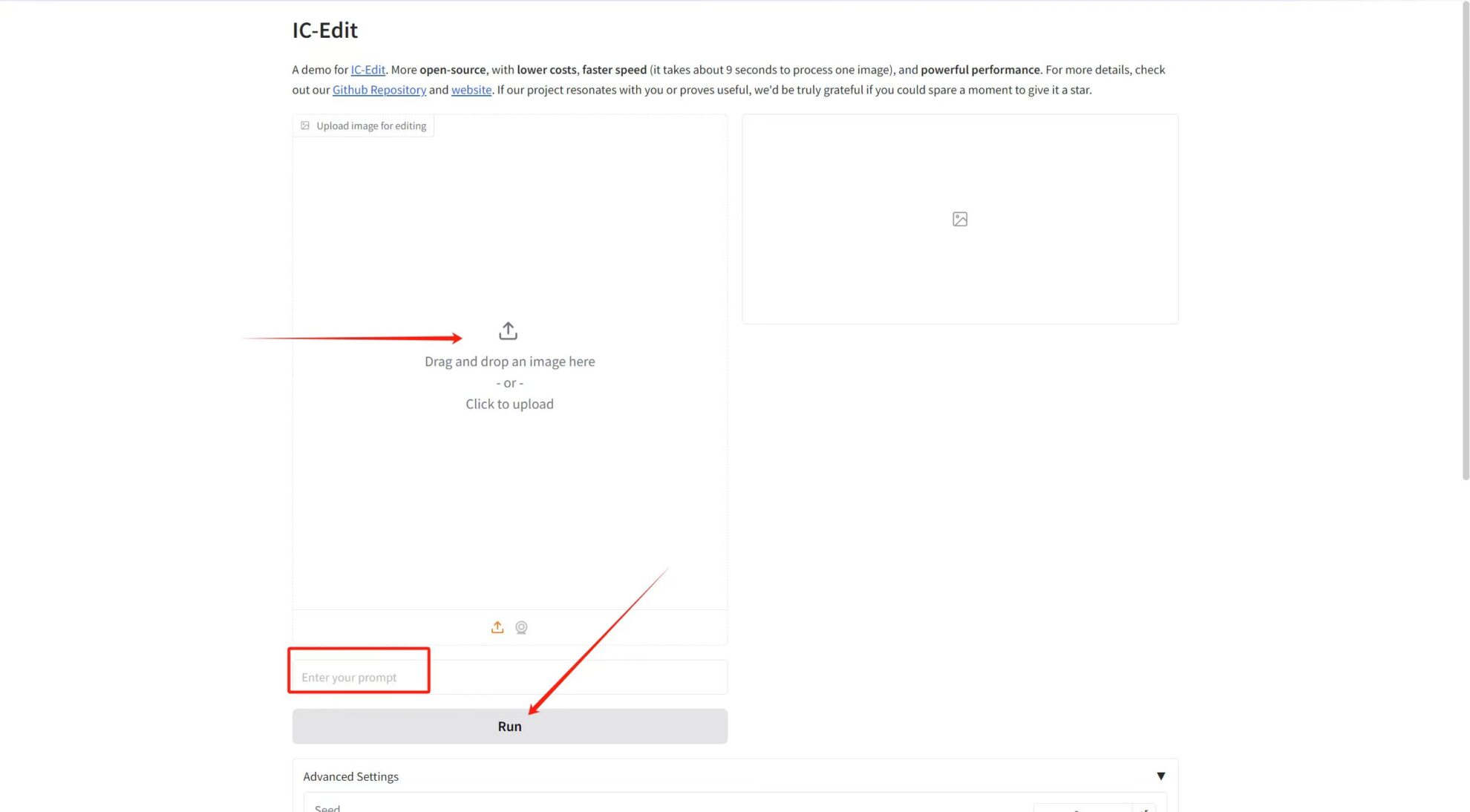

「編集用に画像をアップロード」で画像をアップロードし、テキストボックスにプロンプトワードを入力し、最後に「実行」をクリックして生成します。

パラメータ調整の紹介:

* ガイダンススケール: 生成モデルで生成された結果に対する条件付き入力 (テキストや画像など) の影響を制御するために使用されます。ガイダンス値を高くすると、生成される結果が入力条件に近くなりますが、値を低くするとランダム性が高まります。

* 推論ステップ数: 推論プロセスにおけるモデルの反復回数またはステップ数を表し、モデルが結果を生成するために実行する最適化ステップの数を表します。通常、ステップ数が多いほど、より正確な結果が生成されますが、計算時間が長くなる可能性があります。

* シード: 生成プロセスのランダム性を制御するために使用される乱数シード。同じシード値では同じ結果が生成されます (他のパラメータが同じである場合)。これは、結果を再現する上で非常に重要です。

「髪の色はダークグリーン、服はチェック柄にしてください」というプロンプトを添えて、ポートレート写真をアップロードしました。効果は以下の通り〜