Command Palette

Search for a command to run...

マルチエージェント駆動型生成能力はSOTAに達し、バイトUNOモデルは様々な画像生成タスクを処理できる。

現在、被写体駆動型生成は画像生成の分野で広く使用されていますが、データのスケーラビリティと被写体のスケーラビリティにおいて依然として多くの課題に直面しています。たとえば、単一被験者データセットから複数被験者データセットに切り替えて拡張することは特に困難です。現在注目されている研究の方向性は単一被験者ですが、複数被験者生成タスクに直面した場合、パフォーマンスが低下します。

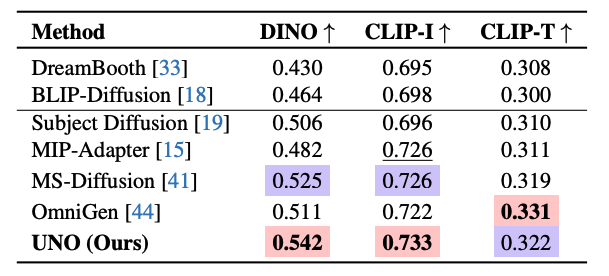

これを考慮して、中国のインターネットテクノロジー企業であるByteDanceのインテリジェントクリエーションチームは、拡散トランスフォーマーモデルのコンテキスト生成機能を使用して、一貫性の高いマルチエージェントペアデータを生成し、画像生成タスクでさまざまな入力条件を処理できるFLUXに基づくUNOモデルを提案しました。「モデルとデータの共進化」という新しいパラダイムを使用して、トレーニング データを充実させ、生成される画像の品質と多様性を向上させながら、モデルのパフォーマンスを最適化します。研究者らは、DreamBench とマルチエージェント駆動型生成ベンチマークに関して広範な実験を実施しました。 UNO は両方のタスクで最高の DINO および CLIP-I スコアを達成し、主題の類似性とテキストの制御性において優れたパフォーマンスを発揮し、SOTA レベルに達しました。

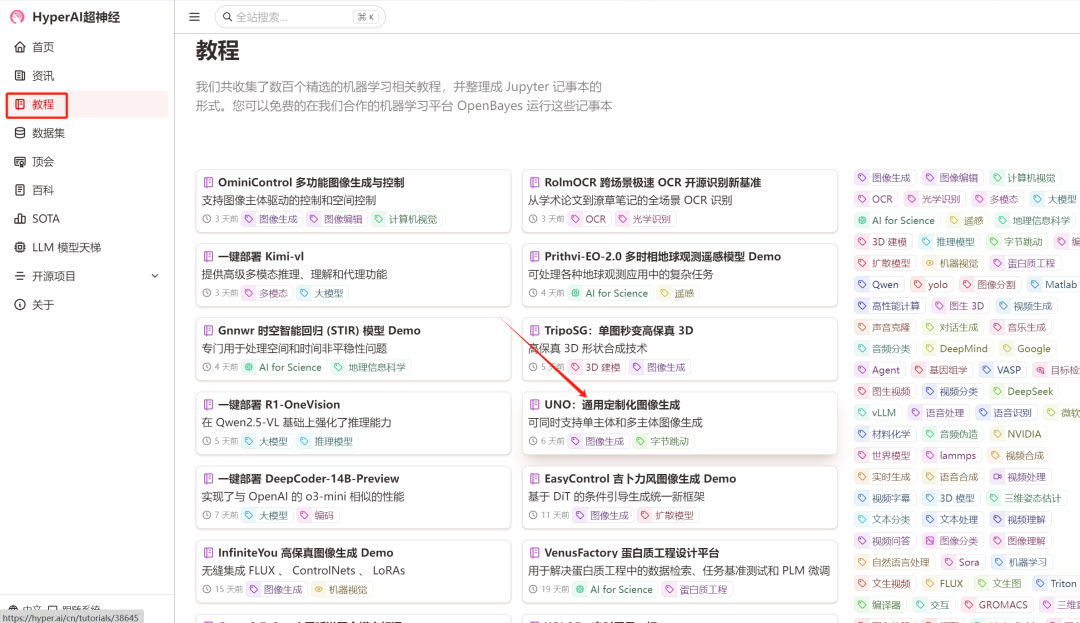

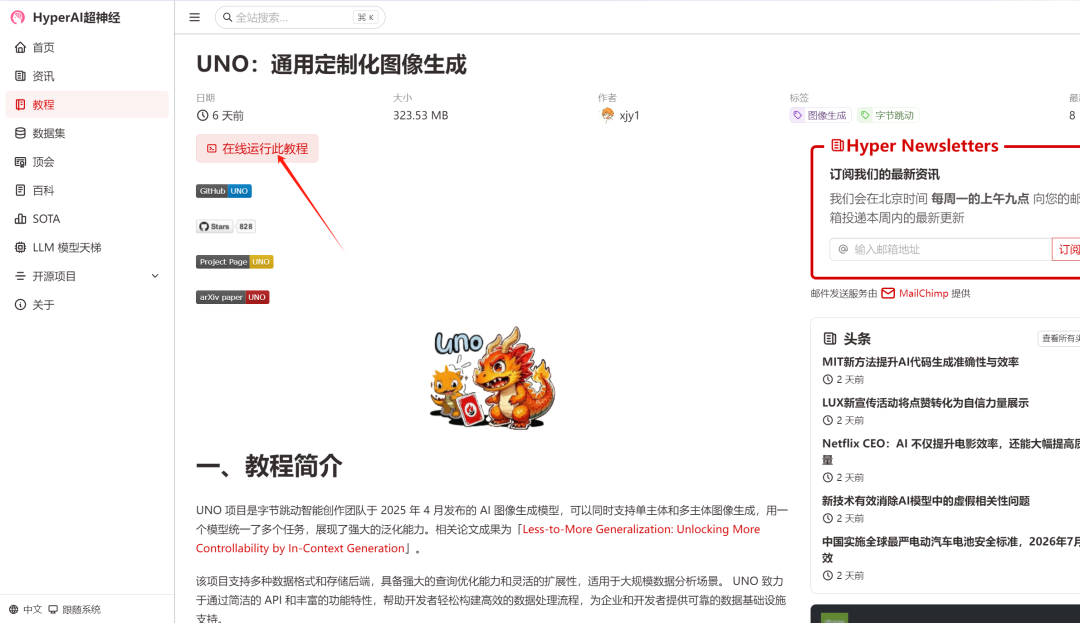

現在、HyperAI公式サイトのチュートリアルセクションにて「UNO: Universal Customized Image Generation」チュートリアルが公開されています。早速体験するには下のリンクをクリック↓

チュートリアルのリンク:https://go.hyper.ai/XELg5

デモの実行

1. hyper.ai にログインし、チュートリアル ページで UNO: Universal Customized Image Generation を選択し、このチュートリアルをオンラインで実行をクリックします。

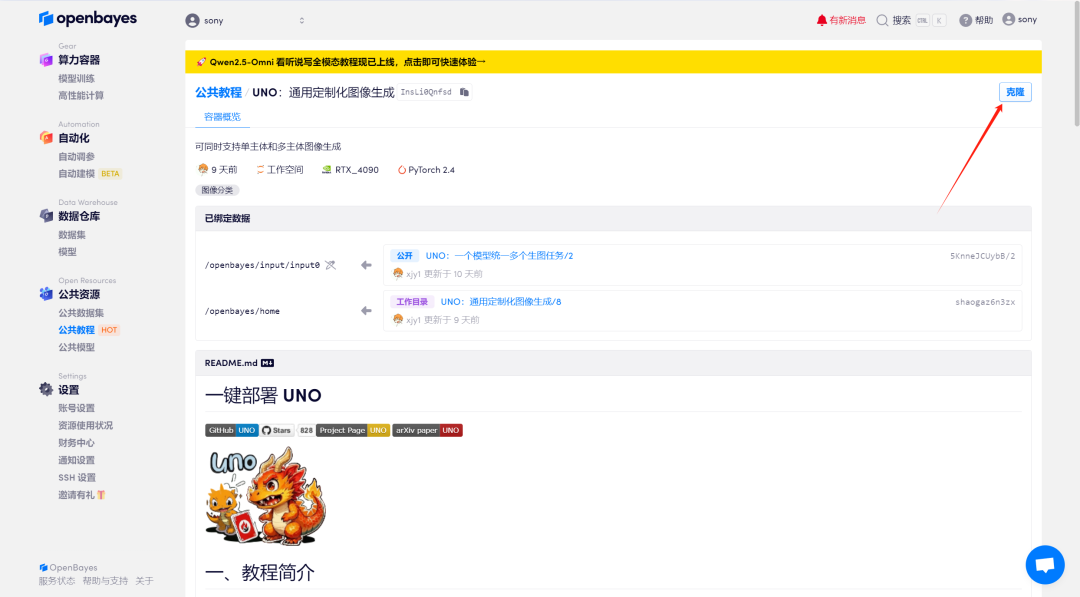

2. ページがジャンプしたら、右上隅の「クローン」をクリックしてチュートリアルを独自のコンテナにクローンします。

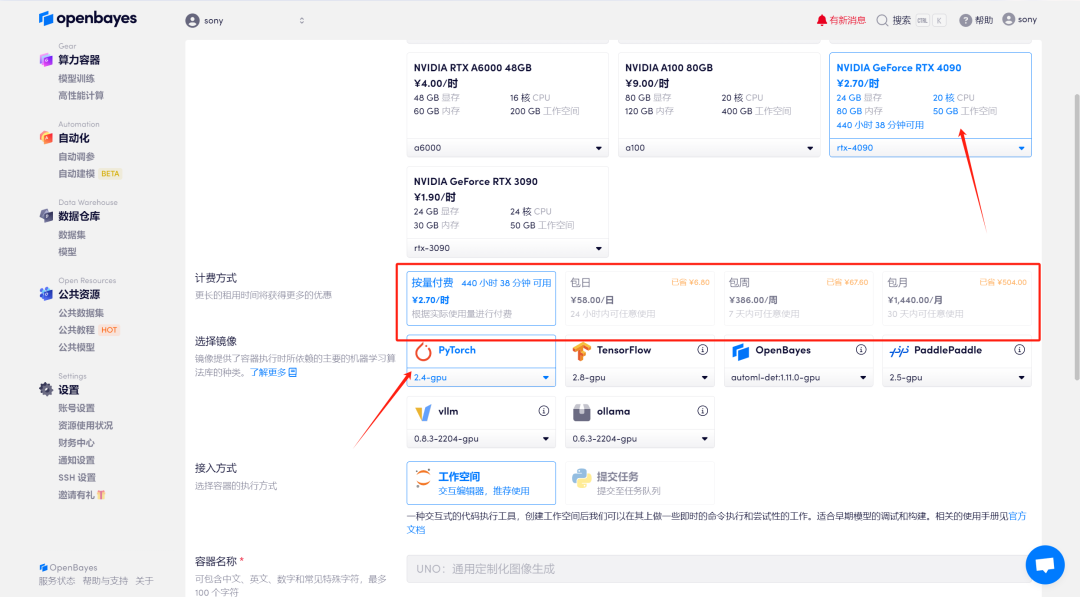

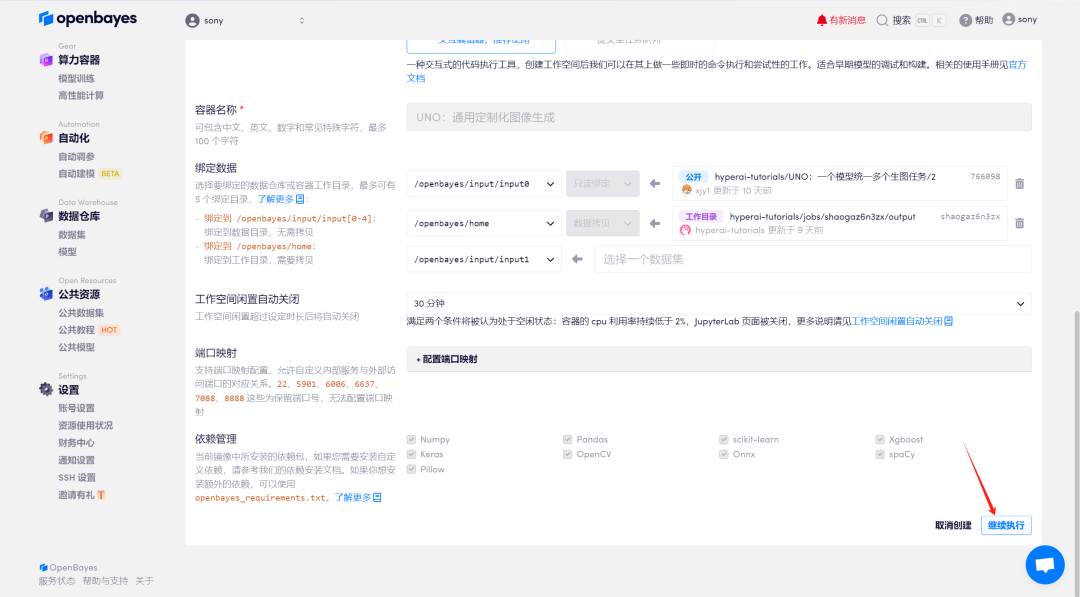

3. 「NVIDIA GeForce RTX 4090」と「PyTorch」のイメージを選択します。 OpenBayes プラットフォームは 4 つの課金方法を提供します。ニーズに応じて、「従量制」または「日次/週次/月次」を選択できます。 「続行」をクリックします。新規ユーザーは、以下の招待リンクを使用して登録すると、4 時間の RTX 4090 + 5 時間の CPU フリー時間を獲得できます。

HyperAI ハイパーニューラルの専用招待リンク (ブラウザに直接コピーして開きます):

https://openbayes.com/console/signup?r=Ada0322_NR0n

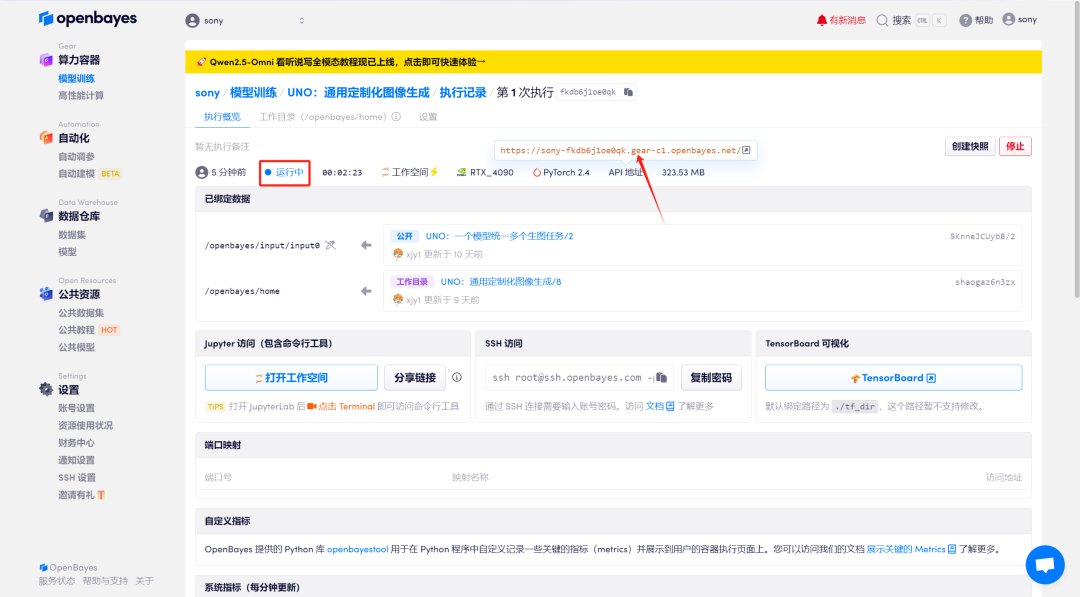

4. リソースが割り当てられるのを待ちます。最初のクローン作成プロセスには約 2 分かかります。ステータスが「実行中」に変わったら、「API アドレス」の横にあるジャンプ矢印をクリックしてデモ ページに移動します。 APIアドレスアクセス機能を使用する前に、ユーザーは実名認証を完了する必要がありますのでご注意ください。

効果実証

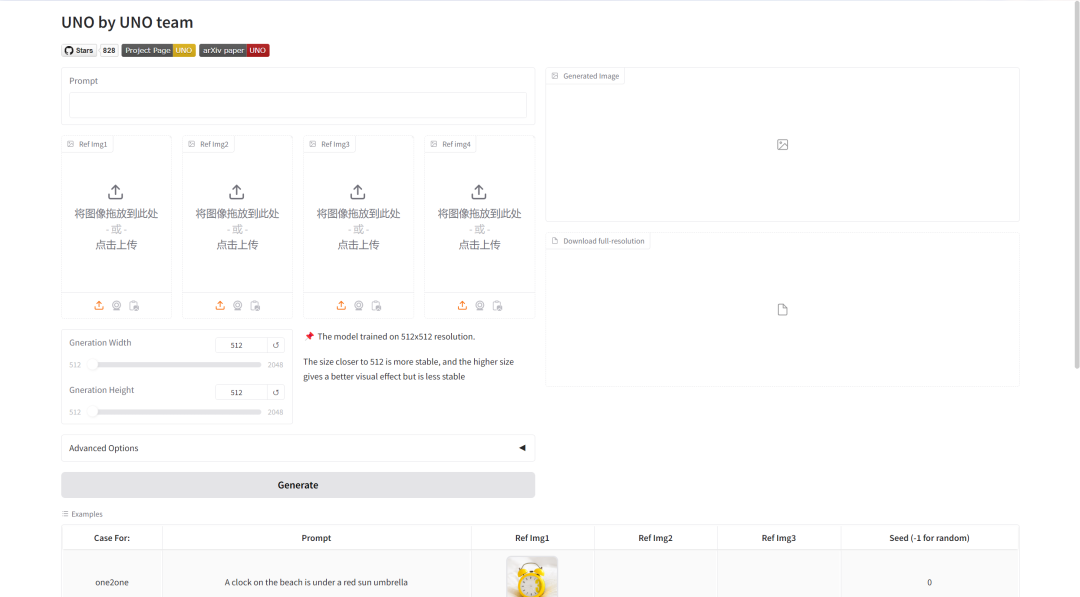

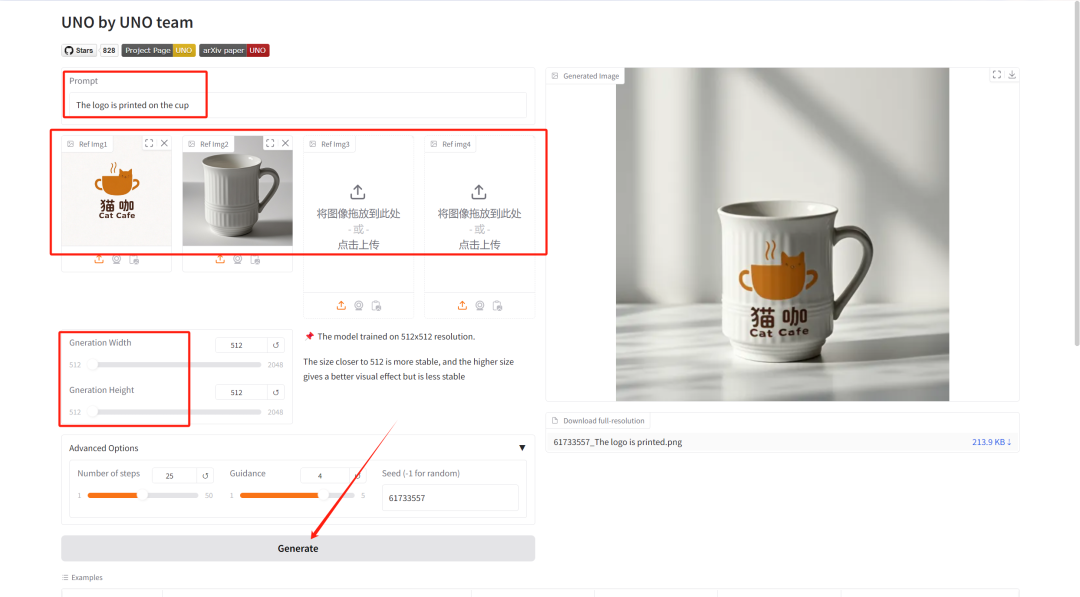

「プロンプト」に生成された画像を説明するテキストを入力し、「参照画像」に生成された画像の画像コンテンツをアップロードします。 「生成幅/高さ」を調整して、生成される画像の長さ/幅を選択し、最後に「生成」をクリックします。

パラメータ調整の紹介:

- ステップ数: モデルの反復回数または推論プロセスのステップ数を表し、モデルが結果を生成するために使用する最適化ステップの数を表します。通常、ステップ数が多いほど、より正確な結果が生成されますが、計算時間が長くなる可能性があります。

- ガイダンス: これは、生成モデル内の条件付き入力 (テキストや画像など) が生成される結果に影響を与える度合いを制御するために使用されます。ガイダンス値を高くすると、生成される結果が入力条件に近くなりますが、値を低くするとランダム性が高まります。

- シード: 生成プロセスのランダム性を制御するために使用される乱数シードです。同じシード値では同じ結果が生成されます (他のパラメータが同じである場合)。これは、結果を再現する上で非常に重要です。

ここでは、ロゴとカップの写真をアップロードし、テキストの説明は次のとおりです。ロゴはカップに印刷されています。モデルが画像を非常に正確に処理していることがわかります。