Command Palette

Search for a command to run...

QwQ-32Bワンクリック展開チュートリアルがオンラインになり、パフォーマンスはDeepSeek-R1のフルバージョンに匹敵します

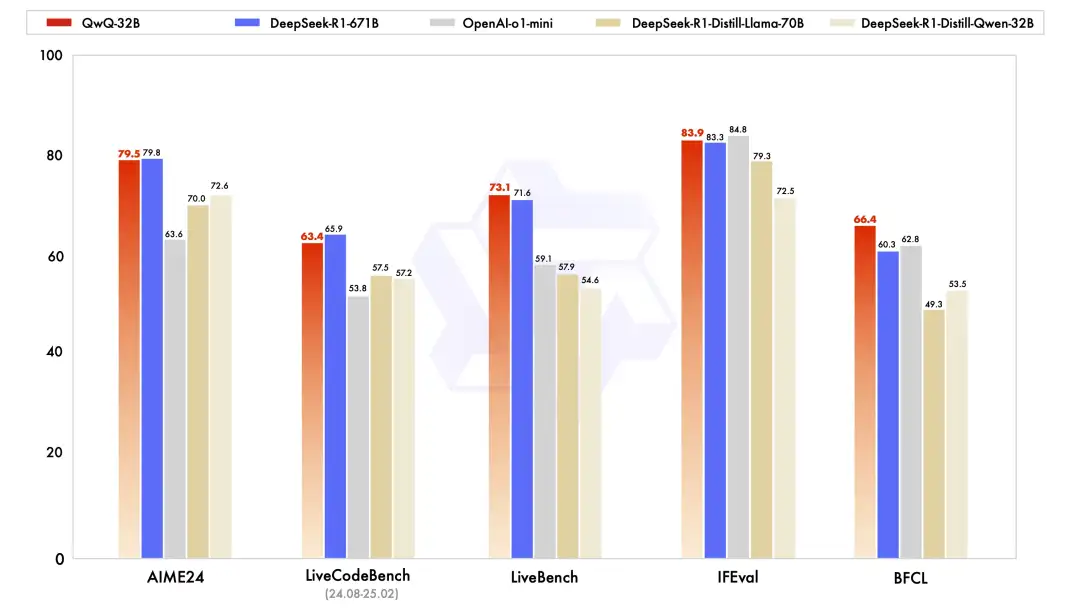

昨日、アリババクラウドは突然大きな動きを見せ、新しい推論モデル「Tongyi Qianwen QwQ-32B」をオープンソース化しました。複数の主要ベンチマークでは、32B パラメータの OpenAI-o1-mini を上回り、671B パラメータの完全版 DeepSeek-R1 に匹敵しました。 QwQ-32B は、驚異的なパフォーマンスを備えているだけでなく、強力なパフォーマンスを維持しながら導入コストを大幅に削減します。また、コンシューマーグレードのグラフィック カードにローカルに導入できるため、強度とコスト効率に優れたモデルとなっています。

技術レベルでは、QwQ-32B はコールド スタートに基づく 2 段階の強化学習方式を採用しています。第 1 段階では数学とコードのタスクに重点を置き、数学検証器とコード サンドボックスを使用して、モデルの論理的推論能力の向上に重点を置きます。

第 2 段階では、従来の報酬モデルに代わって回答検証メカニズムが使用されます。数学の問題の場合、結果の正しさに基づいてフィードバックが提供されます。プログラミング タスクの場合、テスト ケースを通じてサーバー上でリアルタイムの評価が実行され、全体的な機能が向上します。さらに、QwQ-32B はエージェント関連の機能も統合しており、環境のフィードバックに基づいて推論プロセスを柔軟に調整できるため、モデルの自律性と適応性が大幅に向上します。

「vLLM を使用して QwQ-32B を展開する」が、HyperAI の公式 Web サイトの「チュートリアル」セクションで利用できるようになりました。小さなパラメータと大きなパワー、あなたの検証を待っています!

チュートリアルのアドレス:

デモの実行

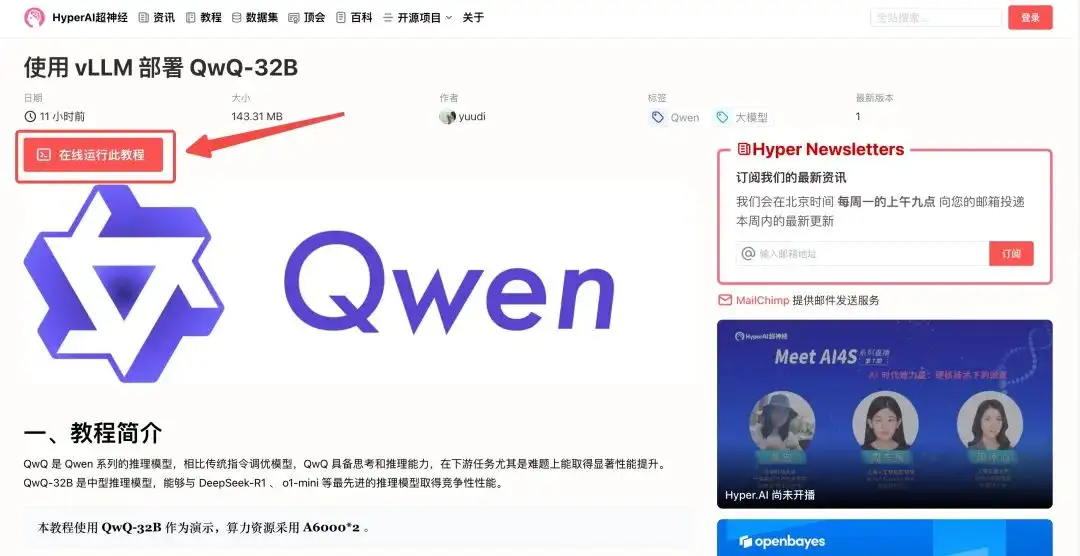

1. hyper.ai にログインし、チュートリアル ページで「vLLM を使用して QwQ-32B をデプロイする」を選択し、「このチュートリアルをオンラインで実行」をクリックします。

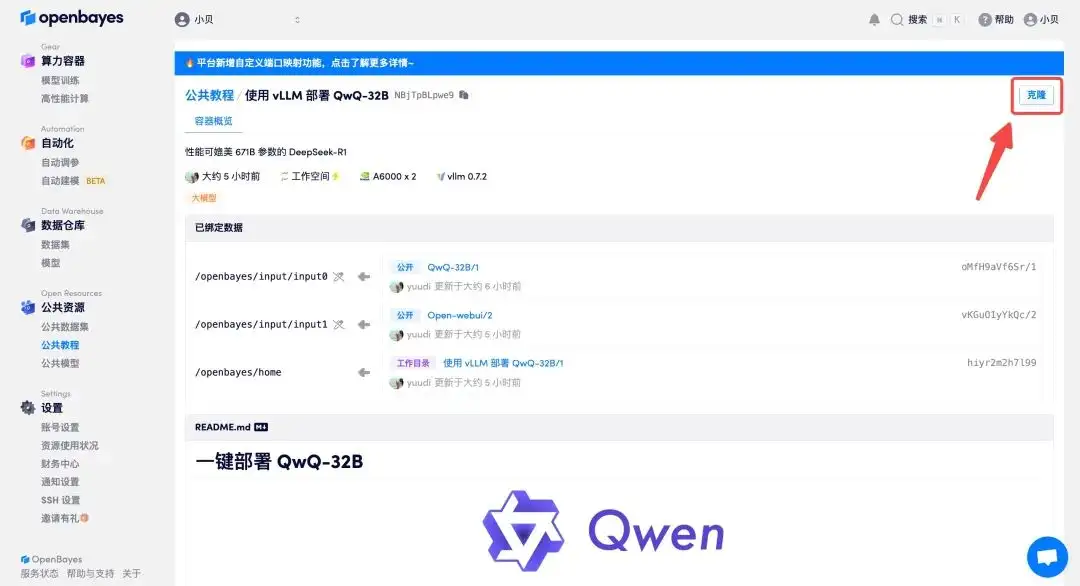

2. ページがジャンプしたら、右上隅の「クローン」をクリックしてチュートリアルを独自のコンテナにクローンします。

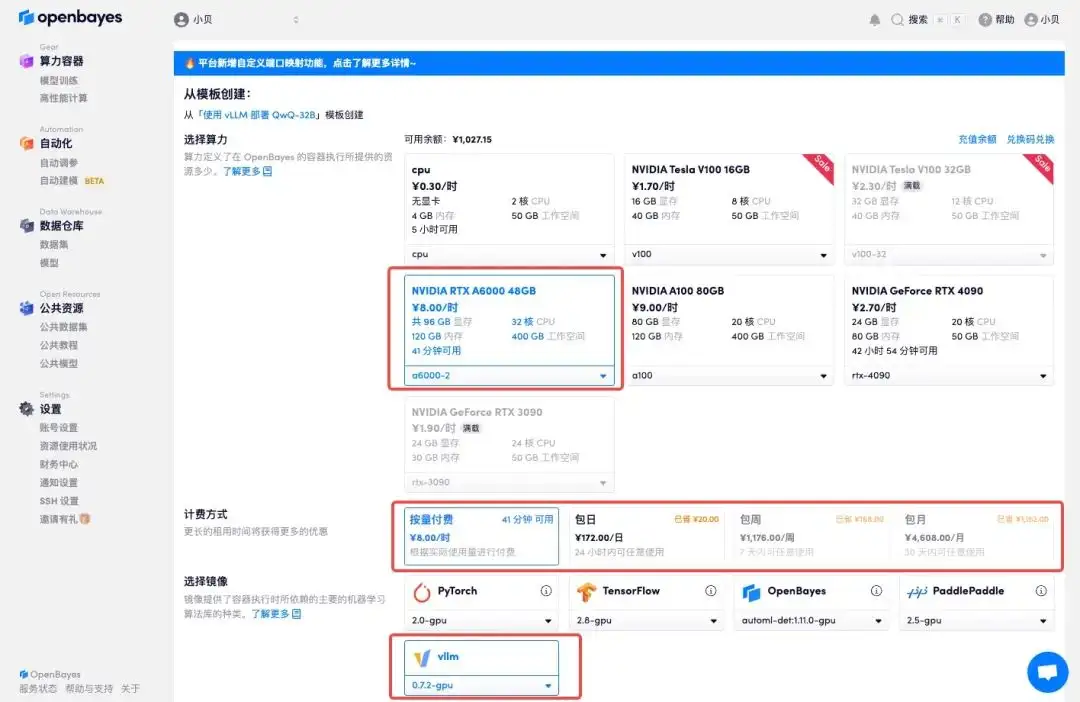

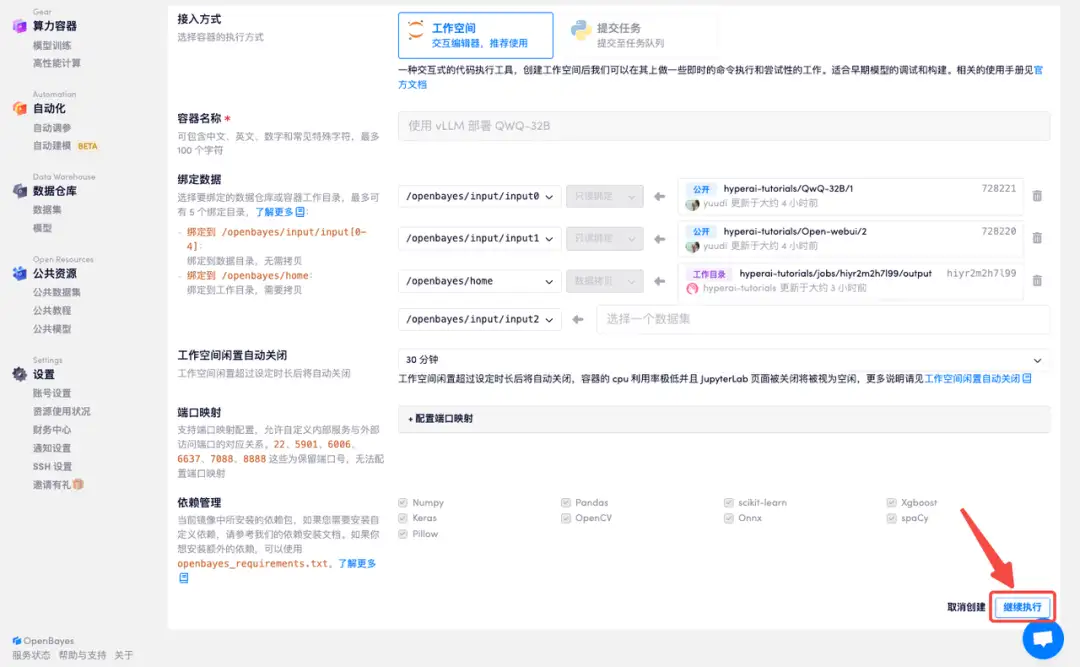

3. 「NVIDIA A6000-2」および「vllm」イメージを選択します。OpenBayes プラットフォームは新しい課金方法を導入しました。必要に応じて、「従量課金制」または「日次/週次/月次」を選択できます。「続行」をクリックします。新規ユーザーは、以下の招待リンクを使用して登録すると、4 時間の RTX 4090 + 5 時間の CPU フリータイムを獲得できます。

HyperAI ハイパーニューラルの専用招待リンク (ブラウザに直接コピーして開きます):

https://openbayes.com/console/signup?r=Ada0322_NR0n

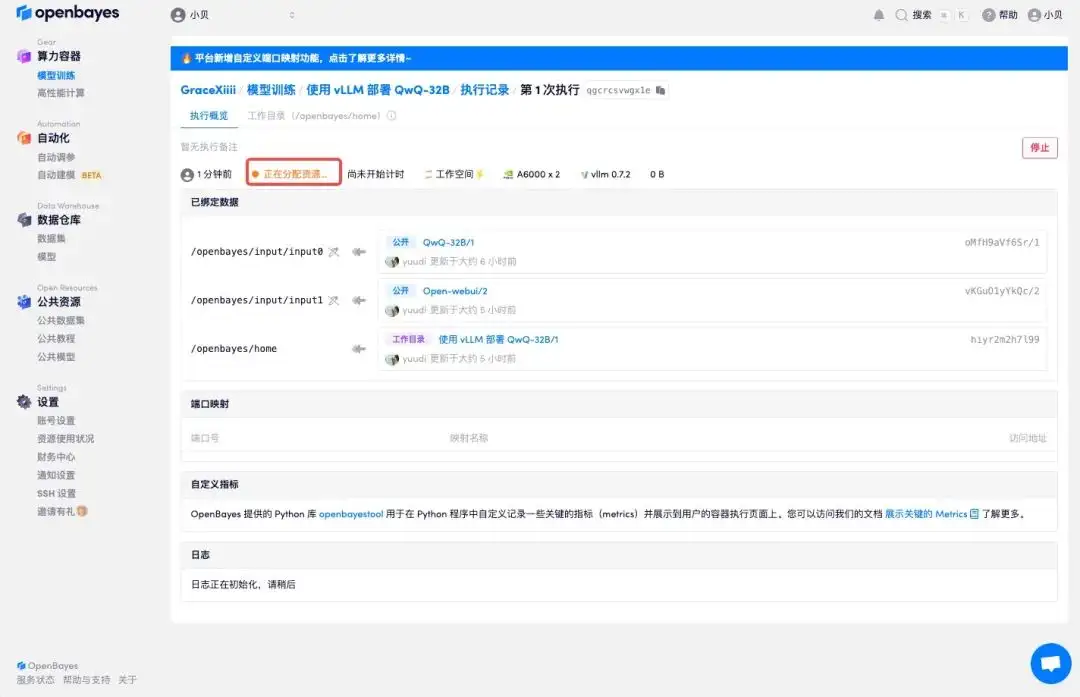

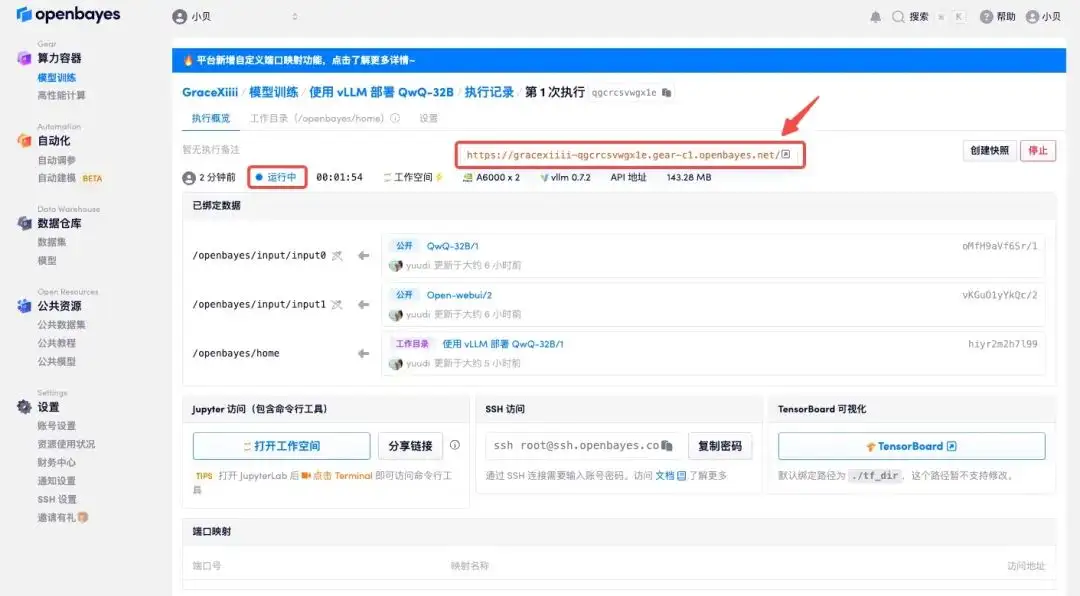

4. リソースが割り当てられるのを待ちます。最初のクローン作成プロセスには約 2 分かかります。ステータスが「実行中」に変わったら、「API アドレス」の横にあるジャンプ矢印をクリックしてデモ ページに移動します。 APIアドレスアクセス機能を使用する前に、ユーザーは実名認証を完了する必要がありますのでご注意ください。

エフェクト表示

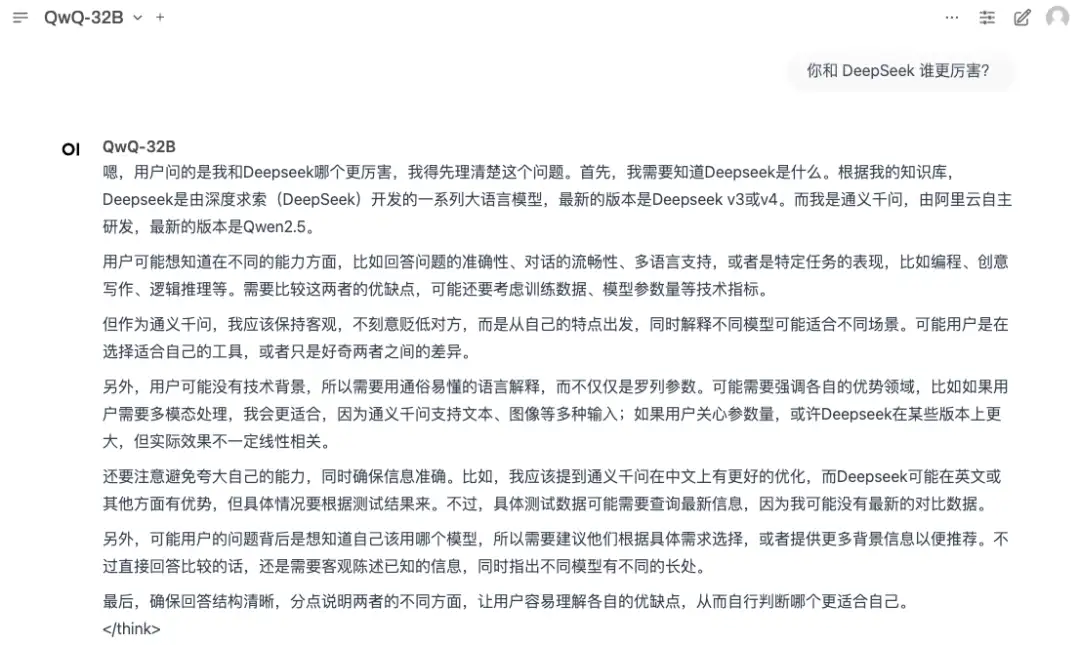

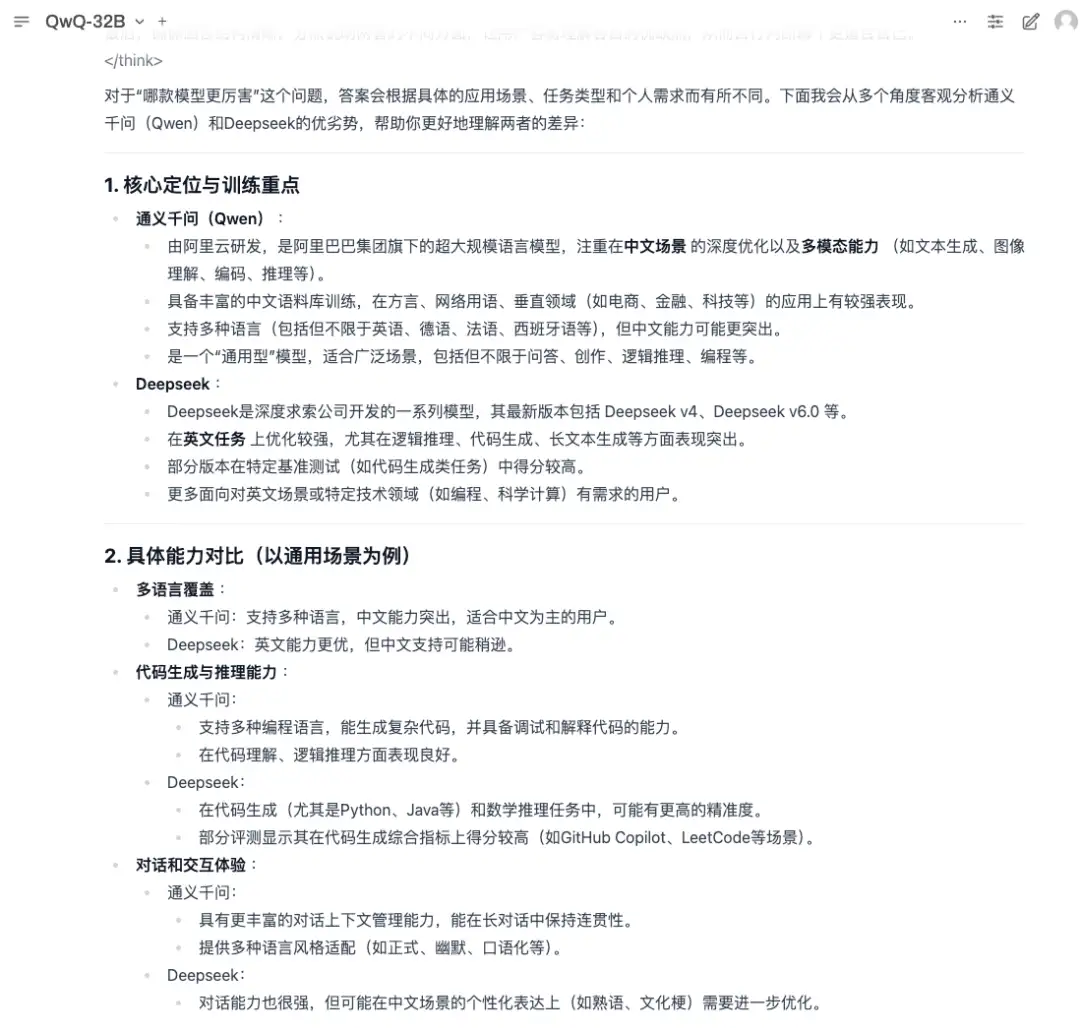

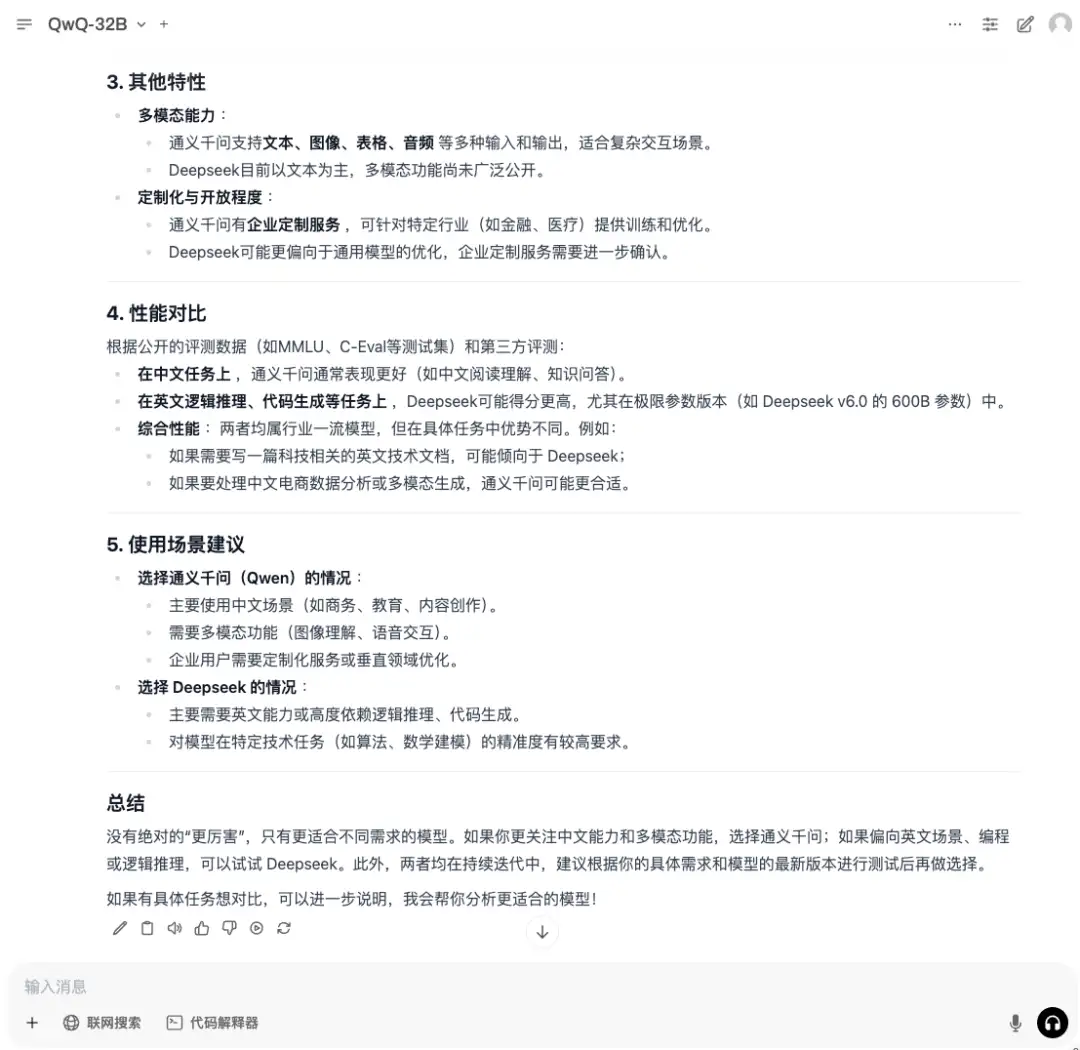

1. QwQ-32B と DeepSeek のどちらが優れているかについては、オンラインで多くの議論があります。QwQ-32B に質問して、どのような回答が得られるかを見てみましょう。

2. QwQ-32B は完全な思考プロセスを示し、客観的に複数の角度から分析を行うことがわかります。