Command Palette

Search for a command to run...

ECCV2024に選出されました! 5.4w+ 画像をカバーする MIT は、SAM よりも優れたパフォーマンスを備えた医療画像セグメンテーションの一般的なモデルである ScribblePrompt を提案しました

素人には興奮しか見えず、専門家には扉が見えるというこの格言は、医療画像の分野ではまさに真実です。それだけでなく、専門家であっても、X 線、CT 線、MRI などの複雑な医療画像上の「出入口」を正確に見ることは容易ではありません。医療画像セグメンテーションは、複雑な医療画像の中で特別な意味を持つ特定の部分をセグメント化し、関連する特徴を抽出することです。これにより、医師が患者に対してより正確な診断と治療計画を提供できるようになり、研究者に病理学的分析を提供することもできます。 。

近年、コンピューターやディープラーニング技術の発展により、医療画像のセグメンテーションの手法は、手動セグメンテーションから自動セグメンテーションへと徐々に加速しており、訓練された AI システムは医師や科学研究者にとって重要なアシスタントとなっています。しかし、医療画像自体の複雑さと専門性により、システムトレーニングの多くの作業は依然として経験豊富な専門家に手動でセグメント化してトレーニングデータを作成することに依存しており、これは時間と労力がかかるプロセスです。同時に、既存の深層学習ベースのセグメンテーション手法は、実際には、適用性の問題や柔軟なインタラクション要件など、多くの課題に直面しています。

実際のアプリケーションにおける既存のインタラクティブ セグメンテーション システムの限界を解決するために、MIT コンピューター サイエンスおよび人工知能研究所 (MIT CSAIL) チームは、マサチューセッツ総合病院およびハーバード大学医学部の研究者と協力しました。インタラクティブな生物医学画像セグメンテーションの一般的なモデルである ScribblePrompt は、アノテーターが落書き、クリック、バウンディング ボックスなどのさまざまなアノテーション方法を使用して柔軟に生物医学画像分析を実行できるようにするニューラル ネットワーク ベースのセグメンテーション ツールです。未トレーニングのラベルと画像タイプの場合。

「ScribblePrompt: あらゆる生物医学画像に対する高速かつ柔軟なインタラクティブ セグメンテーション」と題されたこの研究は、国際的に有名な学術プラットフォーム arXiv に組み込まれ、トップの国際学術会議 ECCV 2024 に採択されました。

研究のハイライト:

* 特にトレーニングされていないラベルや画像タイプに対して、既存の最先端モデルを上回る性能を備え、あらゆる生物医学画像セグメンテーション タスクを迅速かつ正確に完了します。

* 落書き、クリック、境界ボックスなど、柔軟で多様な注釈スタイルを提供します

* 計算効率が向上し、単一の CPU でも高速な推論が可能になります

* 関連分野の専門家によるユーザー調査では、このツールは SAM と比較してアノテーション時間を 28% 短縮しました。

用紙のアドレス:

https://arxiv.org/pdf/2312.07381

MedScribble データ セットのダウンロード アドレス:

「ScribblePrompt Medical Image Segmentation Tool」は、HyperAI スーパー ニューラル チュートリアル セクションで起動されており、ワンクリックで開始できます。

大規模なデータセット、モデルのトレーニングとパフォーマンス評価を包括的にカバー

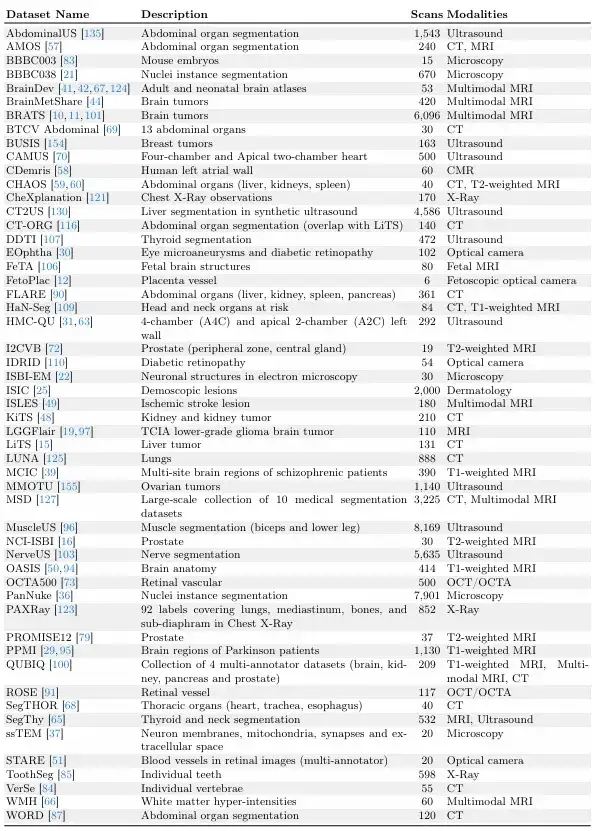

この研究は、MegaMedical などの大規模なデータセット収集活動に基づいて構築されています。MegaMedical は、54,000 枚のスキャン画像、16 種類の画像、711 個のラベルをカバーする、トレーニングと評価用に 77 のオープンアクセスの生物医学画像データセットを編集しました。

これらのデータセット画像は、目、胸部、脊椎、細胞、皮膚、腹筋、首、脳、骨、歯のスキャンを含むさまざまな生物医学分野をカバーし、画像タイプには顕微鏡、CT、X 線、MRI が含まれます。 、超音波、写真など。

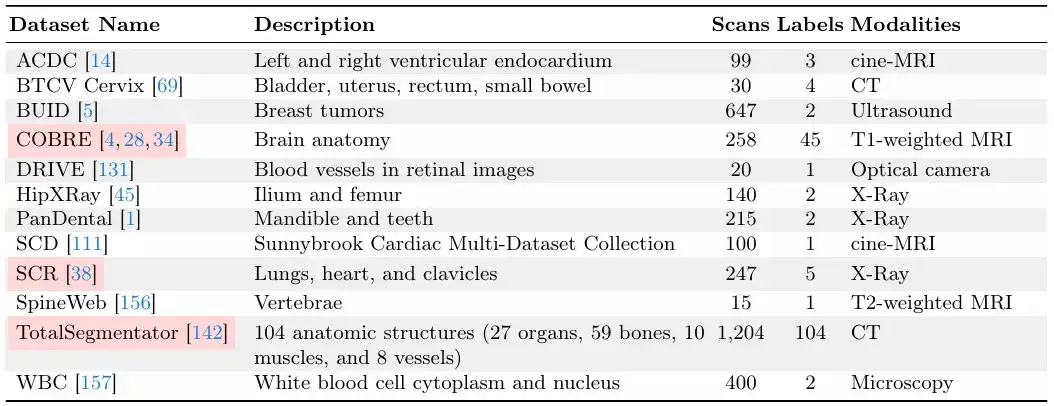

研修と評価の分け方としては、研究チームは、77 のデータセットを 65 のトレーニング データ セットと 12 の評価データ セットに分割しました。12 個の評価データセットのうち、9 個の評価データセットのデータはモデル開発とモデル選択および最終評価に使用され、残りの 3 個の評価データセットのデータは最終評価のみに使用されます。

以下の図に示すように、各データ セットは 6:2:2 の比率でトレーニング セット、検証セット、テスト セットに分割されます。

次の 2 つの図は、それぞれ「検証およびテスト データ セット」と「トレーニング データ セット」です。このうち、「検証およびテスト データ セット」は、ScribblePrompt モデルのトレーニング中には表示されません。

データセットの相対的なサイズに関して、研究チームは各データセットに固有のスキャン数があることを確認しました。

実用的なセグメンテーション ツールを構築するための迅速な推論のための効率的なアーキテクチャ

研究チームが提案しているのは、実用的な有用性が高く、新しい生物医学イメージング分野や関心領域に拡張できる、柔軟なインタラクティブなセグメンテーション手法です。

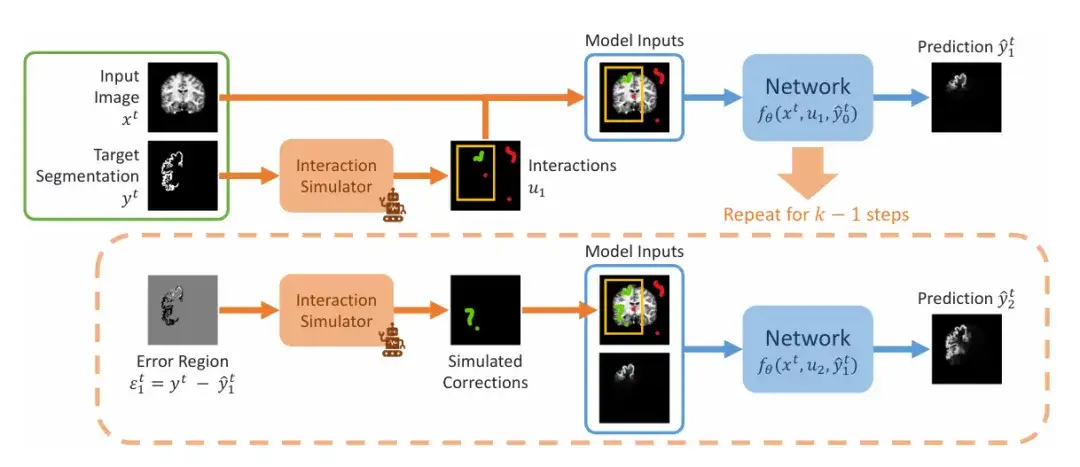

研究チームは、以下の図に示すように、トレーニングでインタラクティブ セグメンテーションをシミュレートする一連の手順を示しています。入力は、指定された画像セグメンテーション ペア (xᵗ、yᵗ) です。チームはまず、境界ボックス、クリック、または落書きを含む一連の初期インタラクション u₁ をシミュレートし、次に、初期値を 0 に設定して予測の最初のステップに入ります。 2 番目のステップでは、チームは誤差領域で以前の予測をシミュレーションし、シミュレーションを通じてそれを修正し、それを初期相互作用セットに追加して u₂ を取得します。これにより、一連の予測が繰り返し生成されます。

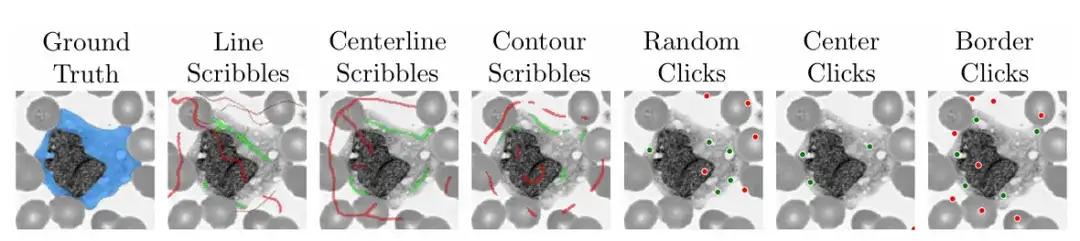

モデルの実用性と使いやすさを確保するために、研究チームはまた、トレーニング中にこのアルゴリズムを使用して、実際のシナリオで医療画像のさまざまな領域に落書きしたり、クリックしたり、境界ボックスを入力したりする方法をシミュレートしました。

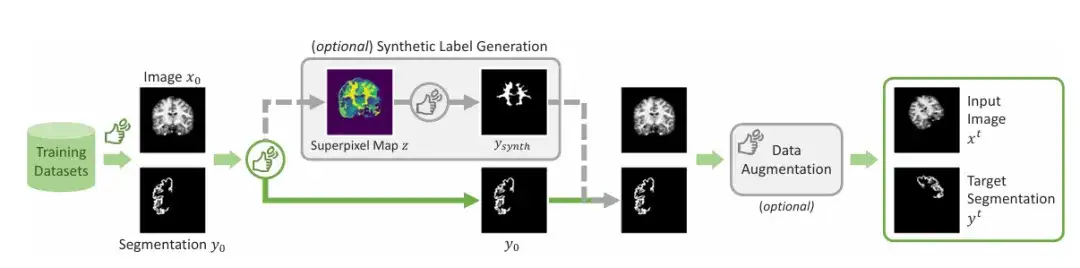

共通のマーク領域に加えて、研究チームは、合成ラベルを生成するメカニズムを導入しました。最終結果は、スーパーピクセル アルゴリズムを適用して潜在的な合成ラベルのマップを生成し、ラベルをサンプリングして図に示す「Ysynth」を生成し、最後にランダム データ拡張を適用することによって得られます。このアプローチは、類似した値を持つ画像の部分を見つけて、医療研究者が関心を持つ可能性のある新しい領域を特定し、それらをセグメント化するように ScribblePromt をトレーニングすることによって機能します。以下に示すように。

この研究プレゼンテーションでは、主に 2 つのネットワーク アーキテクチャをデモンストレーションに使用します。1 つは、UNet に似た効率的な完全畳み込みアーキテクチャを使用した ScribblePrompt のデモンストレーションであり、もう 1 つは、ビジュアル コンバータ アーキテクチャを使用した ScribblePrompt のデモンストレーションです。

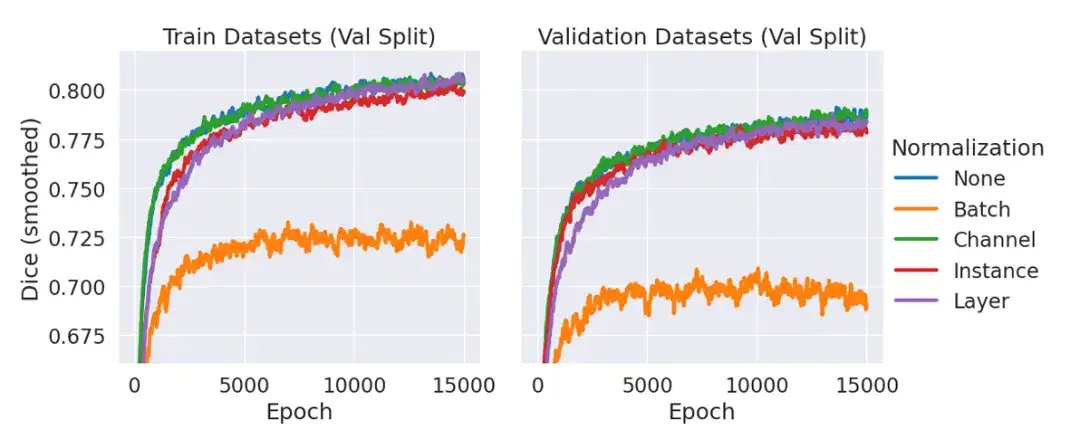

その中で、ScribblePrompt-UNet は 8 層 CNN を使用し、一般的な UNet アーキテクチャと同様のデコーダ構造に従い、バッチ ノルム (Batch Norm) を持ちません。各畳み込み層には 192 の機能があり、PReLu アクティベーションを使用します。正規化レイヤーがないことを説明する必要があります。これは、以下の図に示すように、予備実験で正規化を含めても、正規化レイヤーを使用しない場合と比較して検証データの平均ダイスが改善されないことが判明したためです。

ScribblePrompt-SAM は最小の SAM モデル ViT-b を採用し、そのデコーダーを微調整しています。 SAM アーキテクチャは、シングルマスク モードまたはマルチマスク モードで予測を実行できます。デコーダは、入力画像とユーザー インタラクションを考慮して単一の予測セグメンテーションを出力します。マルチマスク モードでは、デコーダは 3 つの可能なセグメンテーションを予測し、MLP 出力を通じて最も高い IoU を持つセグメンテーションを予測します。アーキテクチャの表現力を最大化するために、マルチマスキング モードでの ScribblePrompt-SAM のトレーニングと評価を研究します。

ScribblePrompt は既存の方法よりも優れていることを示します

この研究では、研究チームは、手作業による落書き実験、模擬インタラクション、および経験豊富な注釈によるユーザー調査を通じて、ScribblePrompt-UNet および ScribblePrompt-SAM を、SAM、SAM-Med2D、MedSAM などの既存の最先端の手法と比較しました。とMIディープセグ。

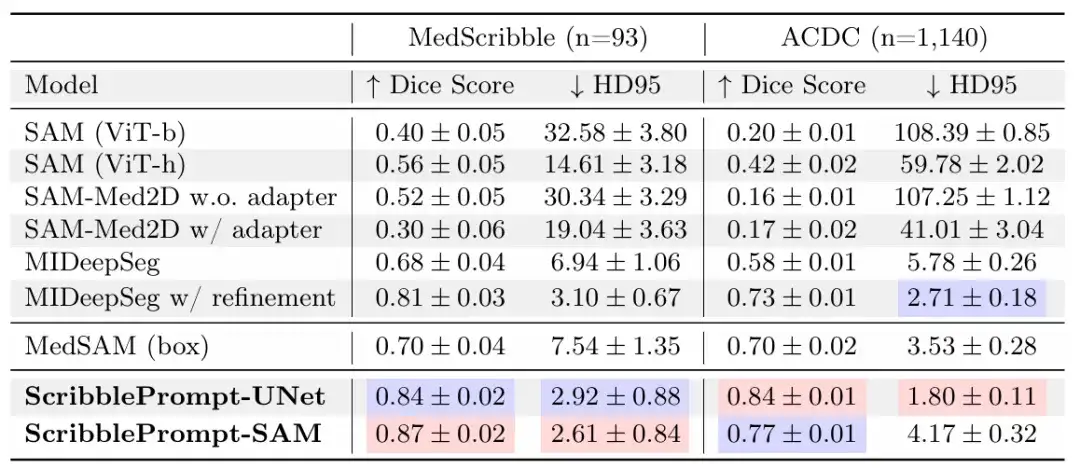

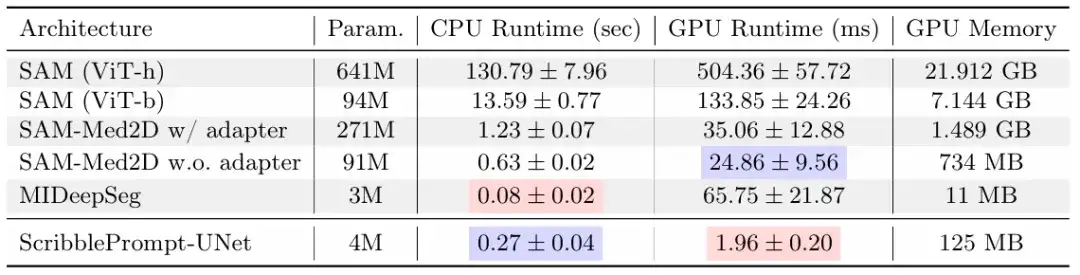

手書き落書き実験では、結果は、以下の表に示すように、ScribblePrompt-UNet と ScribblePrompt-SAM が実験的な手動落書きデータセットと ACDC 落書きデータセットのシングルステップ手動落書きで最も正確なセグメンテーションを生成することを示しています。

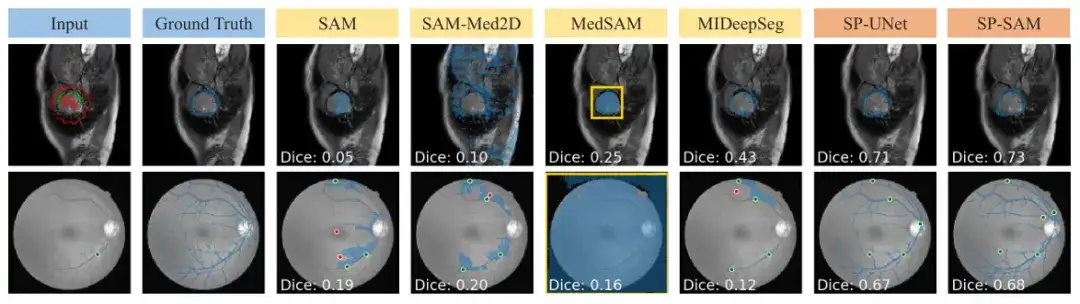

SAM および SAM-Med 2D は、関連するトレーニングを受けていないため、落書き入力にうまく一般化できません。 MedSAM は、SAM アーキテクチャを使用する他の SAM ベースラインよりも優れた予測を行いますが、ネガティブ スクリブルを利用できないため、次の図に示すように、穴のあるセグメンテーションを見逃すことがよくあります。さらに、MIDeepSeg ネットワークからの最初の予測は不十分でしたが、改良プロセスを適用した後は改善されました。

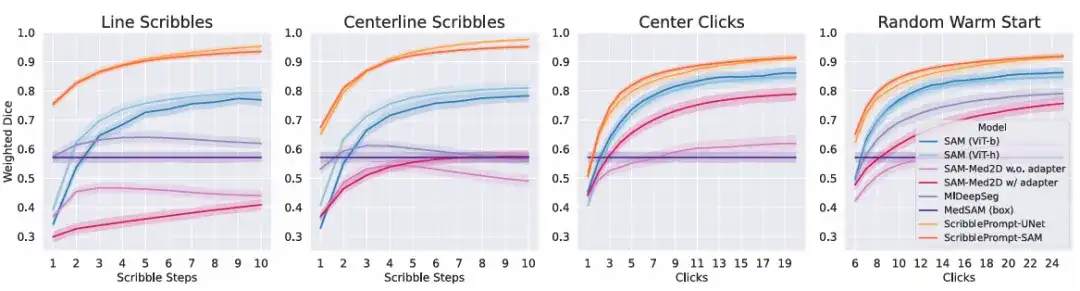

模擬相互作用実験では、結果は、ScribblePrompt の両方のバージョンが、すべてのインタラクション時間におけるすべてのシミュレートされたインタラクション プロセスのベースライン方法よりも優れていることを示しています。以下に示すように。

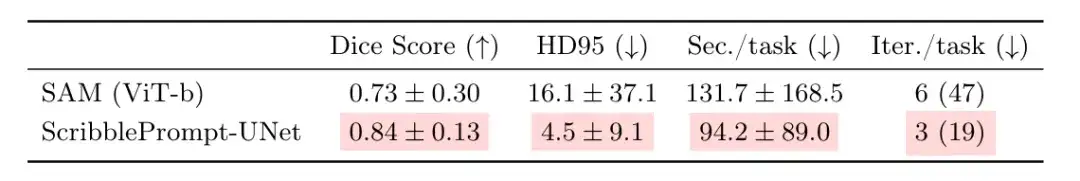

ScribblePrompt の実際の有効性をさらに評価するには、チームは経験豊富なアノテーターとともにユーザー調査を実施しました。このラウンドの比較は、上記のクリック実験で最高のサイコロ スコアを達成した ScribblePrompt-UNet と SAM (Vit-b) の間のものです。その結果、以下の表に示すように、参加者は ScribblePrompt-UNet を使用するとより正確なセグメンテーションを生成できることがわかりました。一方、ScribblePrompt-UNet を使用すると、1 スプリットあたり平均約 1.5 分かかりましたが、SAM を使用した場合は 1 スプリットあたり 2 分以上かかりました。

16 人の参加者の実験レポートでは、SAM と比較して ScribblePrompt を使用する方がターゲット セグメンテーションを達成しやすいことが示され、そのうち 15 人が ScribblePrompt を使用することを好むと回答し、残りの 1 人の参加者は好みがないと回答しました。さらに、SAM ベースラインと比較して、93.81 人の TP3T 参加者が、落書き修正のための対応するスニペットが改善されたため ScribblePrompt を好み、同様に 87.51 人の TP3T 参加者が、クリックベースの編集に ScribblePrompt を使用することを好みました。

上記の結果は、参加者が ScribblePrompt を好む最も一般的な理由、つまり自己修正と豊富なインタラクティブ機能を再度証明しています。これは、他の方法では達成できないことです。たとえば、網膜静脈のセグメンテーションでは、SAM では複数の補正を行っても正確な予測を達成することが困難です。

さらに、ScribblePrompt は低コストで導入が簡単であることも示しています。この調査では、単一の CPU 上で、ScribblePrompt-UNet が各予測にかかる時間はわずか 0.27 秒で、誤差は 0.04 秒以内であることがわかりました。上の写真に示すように、GPU は Nvidia Quatro RTX8000 GPU です。 SAM (Vit-h) は CPU での各予測に 2 分以上かかりますが、SAM (Vit-b) の各予測には約 14 秒かかります。これは間違いなく、リソースが非常に少ない環境でもモデルが適用できることを示しています。

医療スタッフと科学研究者を時間と労力のかかる仕事から解放します

人工知能は、生体医用画像の解析および処理における最も一般的なタスクとして、画像解析および他の高次元データの処理において大きな可能性を示しており、当然のことながら、人工知能のエンパワーメントの重要な実験分野となっています。

この記事の調査に加えて、記事で述べたように、SAM は近年、関連する科学研究チームから最も注目を集めている主要ツールの 1 つです。HyperAI はこれまでに、次のような関連研究の追跡調査を実施してきました。 「SAM 2 の最新アプリケーションがリリースされました! オックスフォード大学チームが Medical SAM 2 をリリースし、医療画像セグメンテーションの SOTA リストを更新しました。」、オックスフォード大学チームによる医療画像セグメンテーションにおける SAM の可能性の探求について共有しました。

この研究では、オックスフォード大学チームによって開発された Medical SAM 2 と呼ばれる医療画像セグメンテーション モデルを実証します。これは、SAM 2 フレームワークに基づいて設計されており、医療画像をビデオとして処理するだけでなく、3D 医療画像セグメンテーション タスクでも優れたパフォーマンスを発揮します。新しい単一キューを分割する機能。ユーザーは、新しい特定のオブジェクトに対するヒントを提供するだけで済み、後続の画像内の類似オブジェクトのセグメンテーションは、追加の入力なしでモデルによって自動的に完了されます。

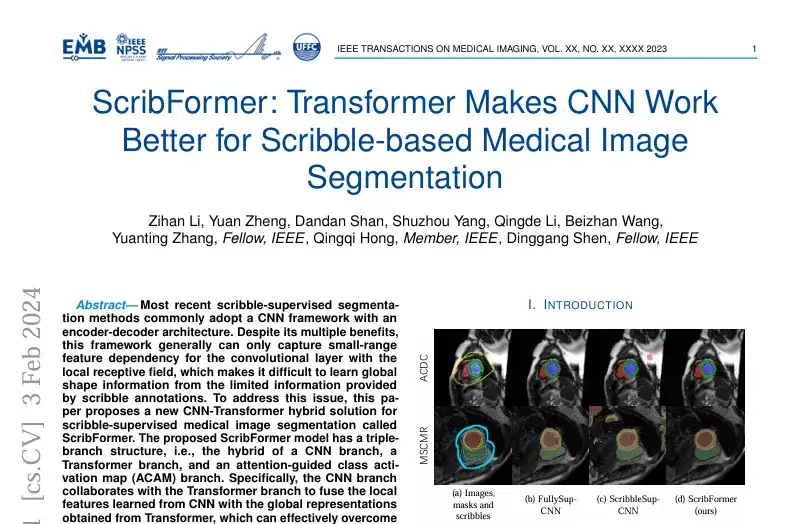

確かに、SAM に加えて、深層学習に基づいた医用画像セグメンテーションの研究手法は他にも多数あります。たとえば、「Scribformer: Transformer Makes CNN Works Better for Scribble-based Medical Image Segmentation」というタイトルの研究は、国際的に有名なジャーナルおよび雑誌 IEEE Transactions on Medical Imaging に掲載されました。

この研究は、アモイ大学、北京大学、香港中文大学、上海科学技術大学、英国のハル大学など複数の機関の研究者チームによって発表された。この研究では、ScribFormer と呼ばれる、Scribing 監視付き医療画像セグメンテーションのための新しい CNN と Transformer のハイブリッド ソリューションを提案しています。

MIT の研究結果であれ、SAM に基づくイノベーションであれ、その他の新しい手法であれ、全体として目的は同じです。すべての道はローマに通ずということわざにあるように、医療分野における人工知能の応用はすべて医療と社会の利益のためです。

ScribblePrompt に関する上記の論文の主著者であり、MIT の博士課程の学生である Hallee E Wong 氏は次のように述べています。「私たちは、対話型システムを通じて医療従事者の努力を代替するのではなく、強化したいと考えています。」

参考文献:

1.https://news.mit.edu/2024/scribbleprompt-helping-doctors-annotate-medical-scans-0909

2.https://arxiv.org/pdf/2312.0738