Command Palette

Search for a command to run...

マルチモーダルかつオープンソースの Llama 3.2 が登場しました! Jen-Hsun Huang 氏の AR メガネ初体験、Quest 3S ヘッドセットの価格は驚くほど安い

OpenAI の ChatGPT が「数百のモデルの戦い」を開始した場合、メタ社のレイバンメタスマートグラスが「百鏡戦争」の引き金になったのは間違いない。昨年 9 月の Meta Connect 2023 開発者カンファレンスでデビューして以来、Ray-Ban Meta はわずか数か月で販売数 100 万件を超えました。マーク・ザッカーバーグそれを直接「素晴らしい」と呼ぶことで、Google、Samsung、ByteDance、その他の国内外の主要企業がゲームに参加するようになりました。

1 年後、Meta は Connect Developer Conference で新しいスマート グラス製品である Orion を再び発表しました。同社が発売する初のホログラフィックARグラスとなる。ザッカーバーグ氏はこれを、将来人々が世界と関わる方法を変える世界で最も先進的なメガネであると述べた。

さらに、例年のように、Meta は Connect カンファレンスで Quest ヘッドセットの新製品を発表することが多く、今年も例外ではありません。昨年リリースされたメタを考慮して クエスト3 ユーザーは一般に、価格が高すぎると報告しました。今年、Meta は Quest 3 と同様のパフォーマンスを持ちながら、より手頃な価格の新しいヘッドセット Quest 3S を発売しました。このヘッドセットは、現在市場に出ている中で最高の複合現実デバイスと考えられており、優れたハイパーリアリティ体験を提供できます。

もちろん、Meta の注目を集めるコア テクノロジーの 1 つとして、Llama モデルもこのカンファレンスで大幅なアップデートを受けました。マルチモーダル Llama 3.2 は画像とテキストを同時に理解でき、携帯電話でも大規模なモデルを実行できるため、オープンソース エコシステムにさらなる支援が加わります。

メタの AR の夢が実現、オリオン グラスがインタラクションの新時代を開く

今年 4 月、Reality Labs の 10 周年を記念して、Meta は同部門の開発の歴史を概説し、次の中核製品である初の AR メガネのプレビューを紹介する記事を公開しました。メタ氏は、クエスト 3 により、ユーザーはレイバン メタ メガネにより、メタ AI の実用性とエンターテイメント性を享受できるようになり、その両方の利点を最適に組み合わせることができると述べました。統合。

Meta Connect 2024が近づくにつれ、市場ではこのARグラスがこのカンファレンスで発表されるのではないかと推測する声が増えている。予想通り、本日、Meta は初の AR メガネ、Orion をリリースしました。

ザッカーバーグ氏は、Orion はこれまでに作られた中で最も先進的な AR メガネであり、10 年間の研究開発を経て開発されたと述べた。最先端のARディスプレイ、カスタマイズされたシリコンチップ、炭化ケイ素レンズ、複雑な光導波路(導波路)、uLEDプロジェクターなどを搭載しています。さまざまな技術的利点により、MR ヘッドセットの電力と重量のほんの一部しか消費せず、メガネ上で強力な AR エクスペリエンスを実行できるようになります。

簡単に言えば、この種のARグラスは新しいディスプレイアーキテクチャを採用しており、使用ミニプロジェクター光を導波管に投影し、それをさまざまな深さとサイズに移動しますホログラムユーザーの目の前に世界を投影し、神殿に内蔵されたバッテリーによって電力を供給します。たとえば、ユーザーが遠くの友達と集まりたい場合、まるで本当にそこにいるかのように、リビングルームに友達がホログラムとして表示されます。

Orion にはフレームの端に 7 が埋め込まれていることは言及する価値があります。マイクロカメラ音声、目の動き、ジェスチャー追跡と組み合わせたセンサーと、ユーザーが簡単にスワイプ、クリック、スクロールできるEMGリストバンドを備えたセンサー。たとえば、朝のランニング中に写真を撮りたい場合、Orion は指先でタップするだけでその瞬間を静止させることができます。さらに、カード ゲーム、チェス、ホログラフィック卓球などのエンターテイメント アクティビティを、指でタップするだけで呼び出すことができます。

NVIDIA の創設者兼 CEO ジェンスン・ファン試してみるのが待ちきれません!

最高の複合現実デバイス Quest 3S、優れたコストパフォーマンス

昨年の Connect カンファレンスで Meta が世界初の複合現実ヘッドセット Meta Quest 3 をリリースした後、メタは今年、クエスト 3 の合理化バージョンであるクエスト 3S を発売しました。

ザッカーバーグ氏はこう語った。「Quest 3S は費用対効果が高いだけでなく、現在市場で入手可能な最高の複合現実デバイスでもあります。」Quest 3 と同様のコア機能、つまり高解像度フルカラー複合現実を備えており、ユーザーは現実世界と仮想世界の間を「シームレスに移動」でき、エンターテイメントやフィットネスなどの一連のアクティビティを実行できます。 、ゲーム、ソーシャル体験。違いは、Quest 3S ではレンズが改良され、テクノロジー スタック、実効解像度と遅延が最適化されており、複合現実ハンド トラッキング ソフトウェアのパフォーマンスがさらに向上していることです。

複合現実の魔法は、現実的な空間を現実の世界にもたらすことです。メタバース、ユーザーは没入感を味わい、異なるエクスペリエンスを自由に切り替えることができます。たとえば、ユーザーはシアター モードを選択して画面を映画館のように拡大し、最高の劇場鑑賞体験を得ることができます。

ザッカーバーグ氏は、ライブ デモンストレーションで、2D モバイル アプリからリモート デスクトップ PC までの没入型エクスペリエンスを披露しました。ユーザーは画面をオンにして、どこにでも配置して巨大な画面を形成できます。仮想ディスプレイ、それに取り組みます。同氏は、Meta が Microsoft と協力してリモート デスクトップ機能をアップグレードしており、間もなくこの機能が Windows 11 コンピュータに接続できるようになる可能性があると述べました。

Meta Quest 3S は、わずか 299.99 ドルからという信じられない価格で超現実的な体験を提供し、10 月 15 日に発売されることは注目に値します。この秋に購入 クエスト3S ユーザーは「バットマン:アーカム・シャドウ」ゲームのVR体験も受けられる。

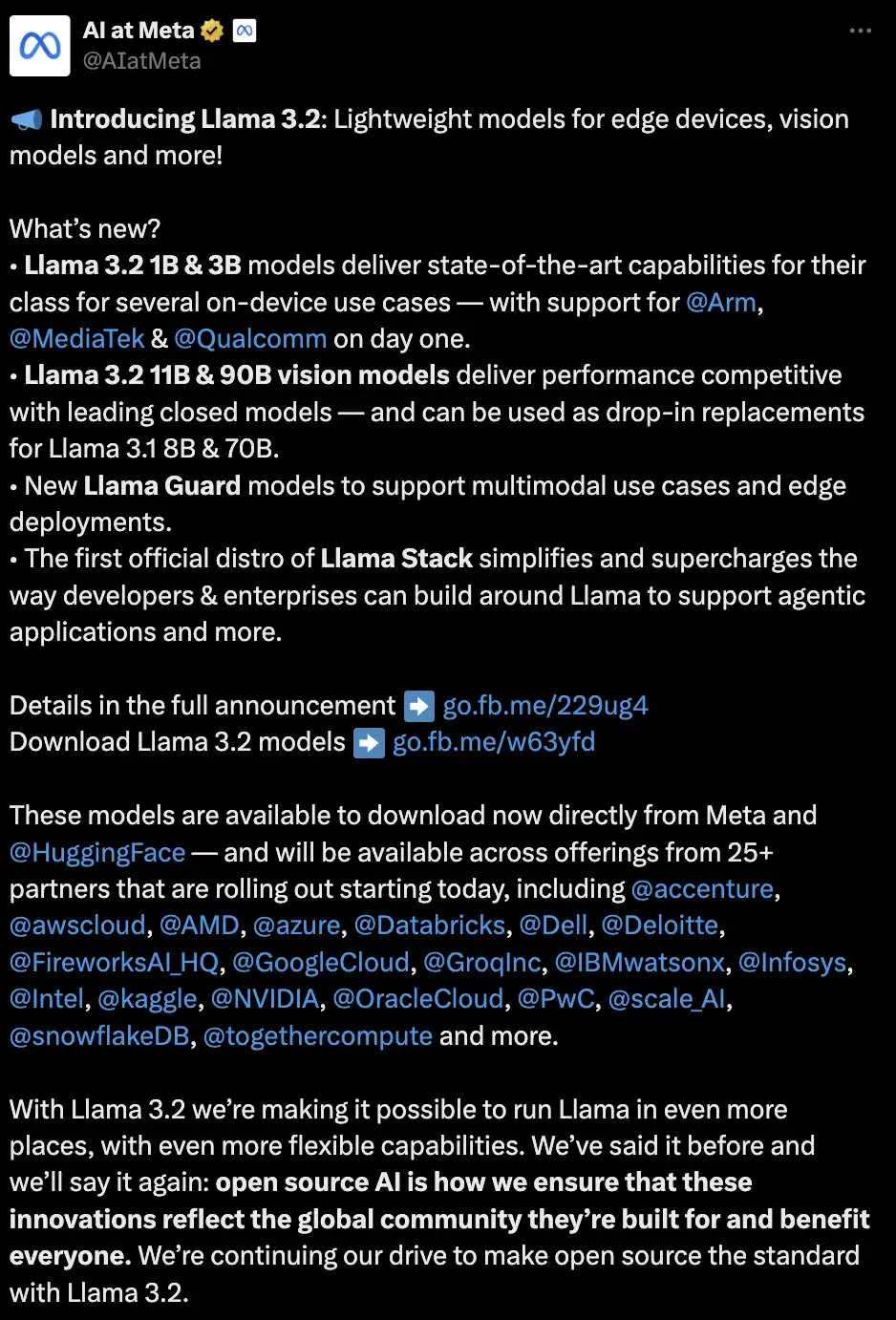

ビジョンタスク、マルチモーダル、オープンソースをサポートする最初の Llama モデル

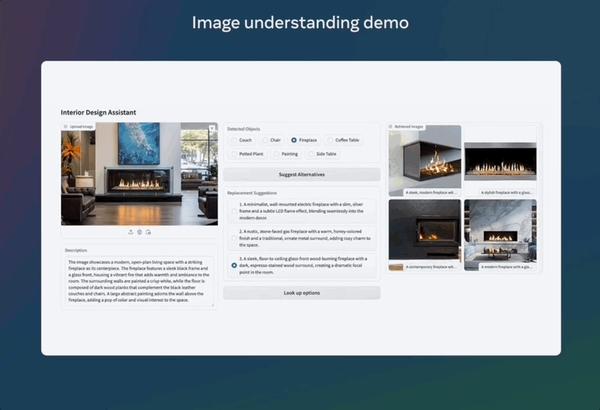

主要なハードウェア リリースに加えて、Xiao Zha は Llama にアップデートをもたらし、Llama 3.2 モデルを発表しました。視覚タスクをサポートする最初の Llama モデルとして、Llama 3.2 は画像とテキストを同時に理解できます。これらには、エッジ デバイスやモバイル デバイスに適した小型および中型のビジョン モデル (11B および 90B) と、軽量のテキスト専用モデル (1B および 3B) が含まれます。どちらのカテゴリにも、事前トレーニング済みバージョンと命令で微調整されたバージョンが含まれます。特筆すべきは、これらの異なる仕様のモデルをメタ AI を通じて試すことができるということです。

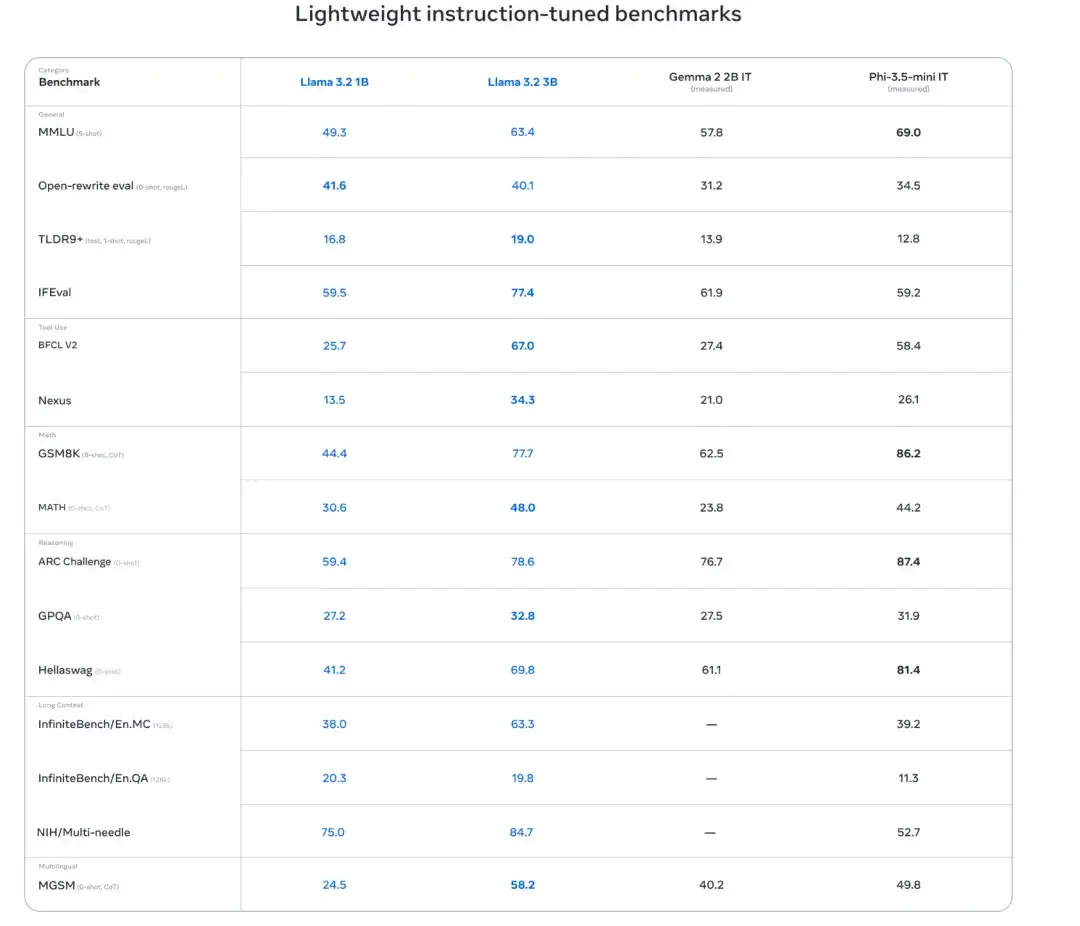

モデル性能評価

研究者は150以上の言語を超えた言語を研究してきました。ベンチマーク データセットモデルのパフォーマンスを評価します。結果は、Llama 3.2 1B および 3B モデルが 128K トークンのコンテキスト長をサポートしていることを示しています。3B モデルは、指示に従う、要約、プロンプト書き換え、ツールなどのタスクにおいて Gemma 2 2.6B および Phi 3.5-mini モデルよりも優れています。 1B モデルは Gemma モデルと競合できます。

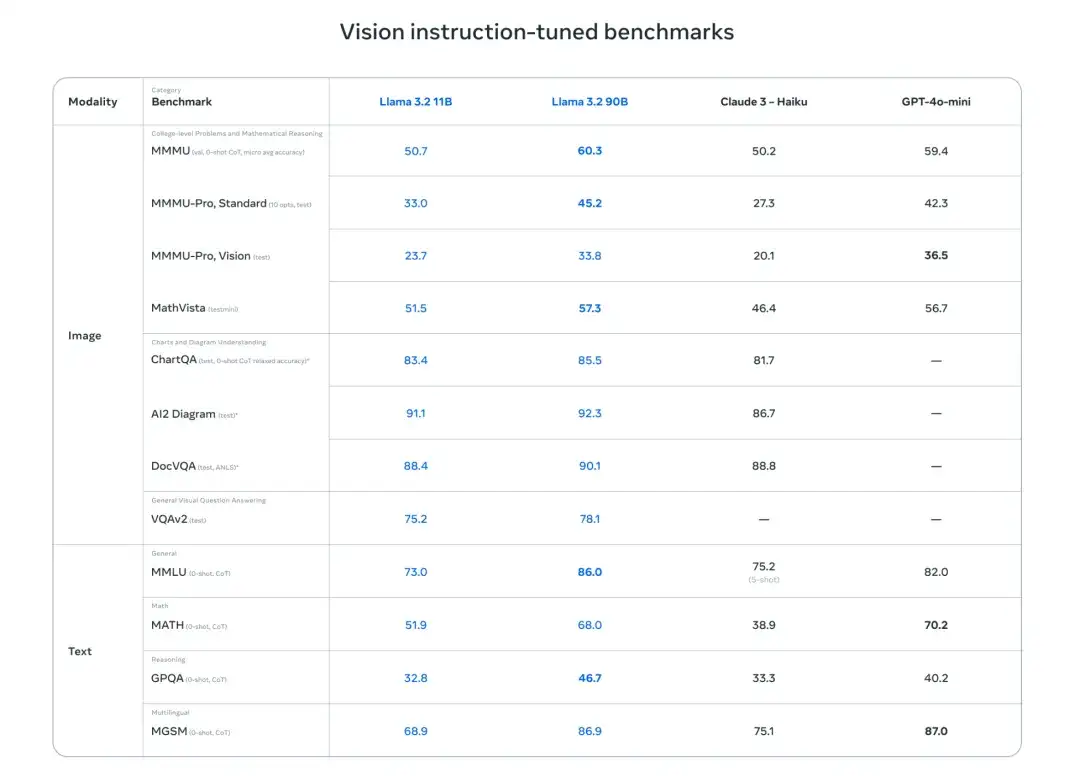

さらに研究者らは、画像理解と視覚的推論のベンチマークにおけるモデルのパフォーマンスを評価しました。結果は、Llama 3.2 11B および 90B のビジュアル モデルが、対応するテキスト モデルをシームレスに置き換えることができると同時に、画像理解タスクに関しては Claude 3 Haiku などのクローズド ソース モデルを上回っていることを示しています。

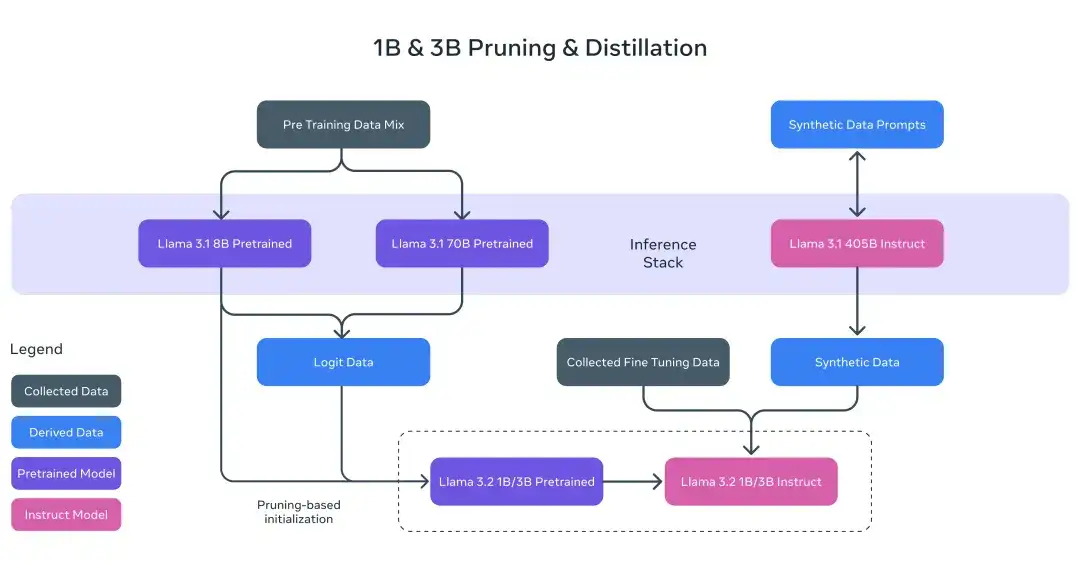

軽量モデルのトレーニング

Llama 3.2 1B および 3B モデルの場合、研究者は枝刈りおよび蒸留手法を使用して、8B/70B モデルから効率的な 1B/3B モデルを抽出しました。

具体的には、研究者らは、Llama 3.1の8Bおよび70Bモデルのロジット日付を事前トレーニング段階に組み込み、これらのより大きなモデルの出力(ロジット日付)を構造化プルーニングを実行するためのトークンレベルのターゲットとして使用しました。剪定が完了した後、研究者は知識の蒸留モデルのパフォーマンスを復元します。

ビジョンモデルトレーニング

Llama 3.2 のトレーニング プロセスは複数の段階に分かれています。まず、事前トレーニング済みの Llama 3.1 テキスト モデルから始めます。次に、研究者らは画像アダプターとエンコーダーを追加し、大規模なノイズを含む (画像、テキスト) ペア データで事前トレーニングしました。次に、中規模の高品質のドメイン内データと知識拡張された (画像、テキスト) のペア データでトレーニングされます。

トレーニング後の研究では、研究者らはテキスト モデルに対して同様のアプローチを使用し、教師付き微調整、拒否サンプリング、および直接優先最適化のために複数回のアライメントを使用しました。研究者らは、Llama 3.1 モデルを使用して合成データを生成し、ドメイン内画像の質問と回答をフィルタリングして強化し、報酬モデルを使用してすべての回答候補をランク付けし、高品質の微調整データを確保しました。

さらに、研究者らはセキュリティ緩和データも導入して、安全性と実用性の両方を備えたモデルを作成しました。最後に、画像とテキストを同時に理解できる Llama 3.2 モデルの誕生は、Llama モデルがより豊富なエージェント機能を実現するための新たな重要な一歩を踏み出しました。

モデルをローカルにデプロイするのはタイムリーかつ安全です

研究者らは、Llama 3.2 モデルをローカルで実行すると 2 つの大きな利点があると指摘しました。まず応答速度に関しては、すべての処理がローカルで完了するため、プロンプトと応答速度はほぼ即時に効果を得ることができます。

次に、プライバシーとセキュリティの点で、ローカル実行モデルはメッセージやカレンダーなどのデータをクラウドに送信する必要がないため、ユーザーのプライバシーが保護され、アプリケーションのプライベート性が高まります。ローカル処理を使用すると、アプリケーションはどのクエリをデバイス上に残し、どのクエリをクラウド内のより大きなモデルで処理する必要があるかを明示的に制御できます。

守り抜くオープンソース当初の目的、モデルのデプロイメントがより簡素化され、効率的になる

Meta は、開発者がさまざまな環境 (単一ノード、オンプレミス展開、クラウド、デバイスなど) で Llama モデルを使用するプロセスを大幅に簡素化するために、オープンソースであるという当初の目的を常に遵守してきました。検索の強化統合されたセキュリティ機能を備えたビルド (RAG) およびツール対応アプリケーションのワンクリック展開を提供する Meta は、最初の公式 Llama スタック リリースを共有すると発表しました。

公式レポートによると、Llama 3.2 モデルは 2019 年に発売される予定です。 http://llama.com Hugging Face は、AMD、AWS、Databricks、Dell、Google Cloud、Groq、IBM、Intel、Microsoft Azure、NVIDIA、Oracle Cloud、Snowflake などのパートナー プラットフォーム上で即時開発サポートを提供します。

オープンソースの一貫した支持者として、ザッカーバーグ氏はかつて黄仁訓氏との会話の中で「メタはオープンソースエコシステムの恩恵を受け、数十億ドルを節約した」と紹介した。 Llama は間違いなくそのオープンソース エコシステムにとって重要な触手であり、Llama 3.2 はビジュアル タスクにさらに拡張し、マルチモダリティを実現し、オープンソース エコシステムにさらなる恩恵をもたらすでしょう。