Command Palette

Search for a command to run...

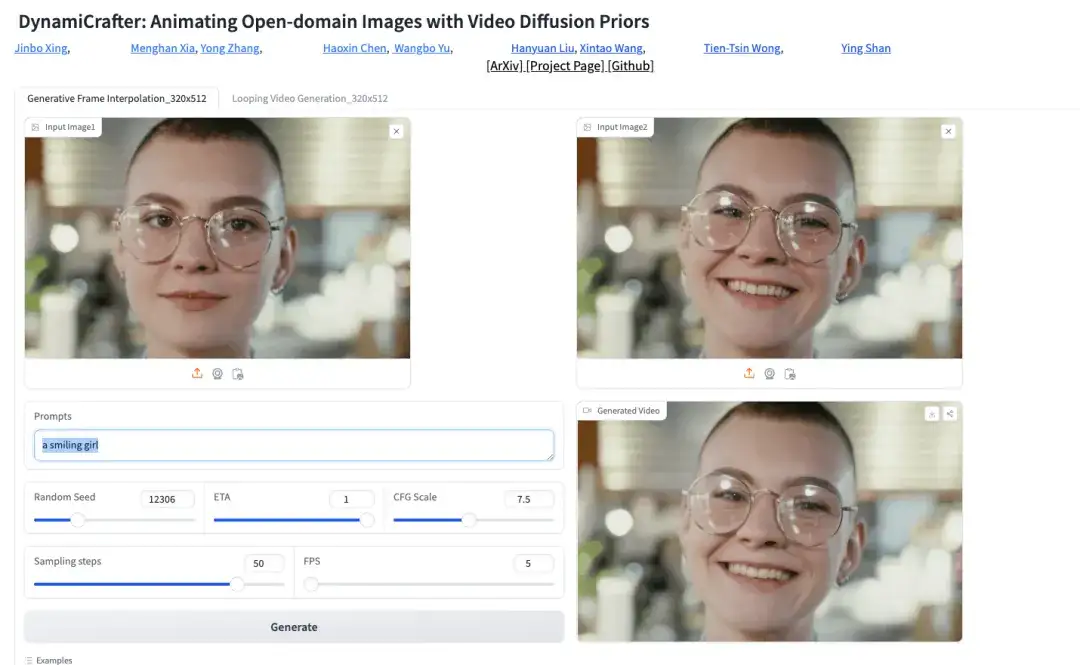

香港華人、テンセントなどが共同リリース! DynamiCrafter: 超高解像度とシームレスな接続により、あらゆる画像が数秒でダイナミックなビデオになります

1986 年に CCTV-1 で放送された「Calabash Baby」は、デビューと同時に大きな反響を呼び、80 年代と 90 年代に生まれた多くの人々にとって貴重な子供時代の思い出となりました。実際、スタッフが約20万枚の画像を描き、組み合わせたという。

プロットの展開に合わせて、スタッフがキャラクターの関節を動きにつなぎ合わせ、1秒あたり24フレームでビデオ形式で撮影します。観客に視覚を養わせ、つまり、キャラクターはアクティブであると考えられます。

実際には、ダイナミックビデオはフレームごとに連続的に再生されます。最初は画用紙に絵をスケッチし、画用紙を素早く回転させて画像を「生きた」ものにしていましたが、その後、コンピューターとカメラが 1 秒間に 24 フレーム以上を保持できるようになり、高速で一貫性のあるダイナミックな視覚効果を生み出すことができました。これまでに、ビデオ テクノロジは、自然のシーン (雲や流体など) や領域固有の動き (人間の動きなど) のランダムなダイナミクスをシミュレートする点で大きな進歩を遂げてきました。

しかし、実際のシーンショットであれ、仮想アニメーションであれ、ダイナミックなビデオのプレゼンテーションは連続した素材によってサポートされる必要があります。たとえば、花が咲く完全なサイクルを示すには、人々は実際に花が咲くのを待つ必要があります。 、フレームごとに記録します。

AIの登場はこの限界を打ち破ります。香港華人、テンセント著 AIラボ 他の強力な企業が共同で立ち上げた DynamiCrafter モデルは、ビデオ拡散先行技術を使用して現実世界の動きパターンをシミュレートします。テキストコマンドと組み合わせると、風景、人物、動物、乗り物、彫刻など、ほぼすべての種類の静止画像を処理できます。生成されるダイナミックビデオは、高解像度で非常に滑らかで、シームレスです。そしてあらゆる細部が完璧に捉えられています。

DynamiCrafter は、次のようなアプリケーション シナリオでもその優れた能力を発揮します。

エンターテイメント メディア: 映画、ゲーム、仮想現実環境用の動的な背景とキャラクター アニメーションを作成します。

文化教育: 歴史的な写真を動的な形式に変換して、文化遺産に新しいインタラクティブな方法を提供します。教育用ビデオを作成し、複雑な概念を説明するために画像をアニメーション化して、科学研究のコミュニケーション障壁を軽減します。

ソーシャル マーケティング: ソーシャル メディア広告やブランド プロモーション用に魅力的な動的な画像や短いビデオを生成し、動的な画像を通じてストーリーを伝え、書籍や電子書籍の宣伝に視覚効果を追加します。

皆様に DynamiCraafter をより良く体験していただくために、HyperAI Super Neural が「DynamiCrafter AI ビデオ生成ツール」チュートリアルを開始しました。このチュートリアルでは、誰もが利用できる環境をセットアップしました。モデルがダウンロードされてトレーニングされるまで待つ必要はなくなり、ワンクリックで開始し、滑らかなビデオを瞬時に作成できます。

チュートリアルのアドレス:https://hyper.ai/tutorials/31974

上記のチュートリアルは、シンプルで使いやすい WebUI に基づいていますが、ローカル精度の制御が制限されています。 ComfyUI はノードベースのインターフェイスとワークフローに基づいており、ノードを変更することでさまざまな効果を得ることができ、ユーザーに高度な機能を提供します。自由と創造的な空間。したがって、HyperAI はまた、「ComfyUI DynamiCrafter Tusheng Video Workflow」チュートリアルを開始しました。具体的なチュートリアルの詳細については、本日HyperAI Super Neuralが公開した以下のコンテンツをご覧ください。

デモの実行

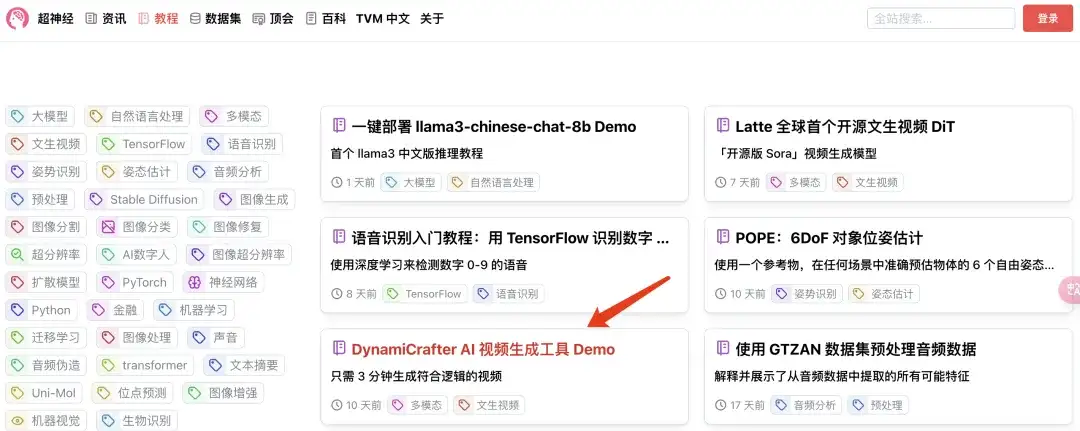

1. hyper.ai にログインし、「チュートリアル」ページで「DynamiCrafter AI ビデオ生成ツール」を選択し、「このチュートリアルをオンラインで実行する」をクリックします。

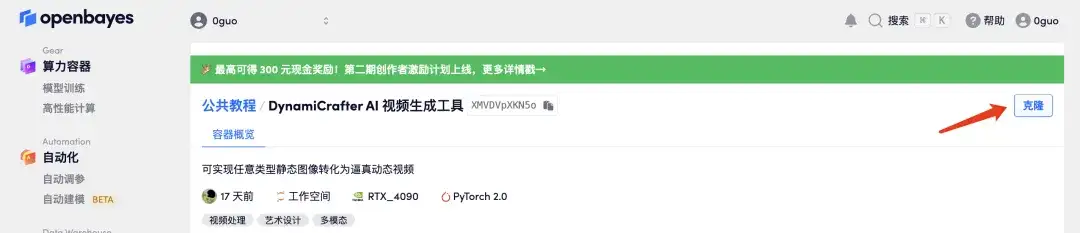

2. ページがジャンプしたら、右上隅の「クローン」をクリックしてチュートリアルを独自のコンテナにクローンします。

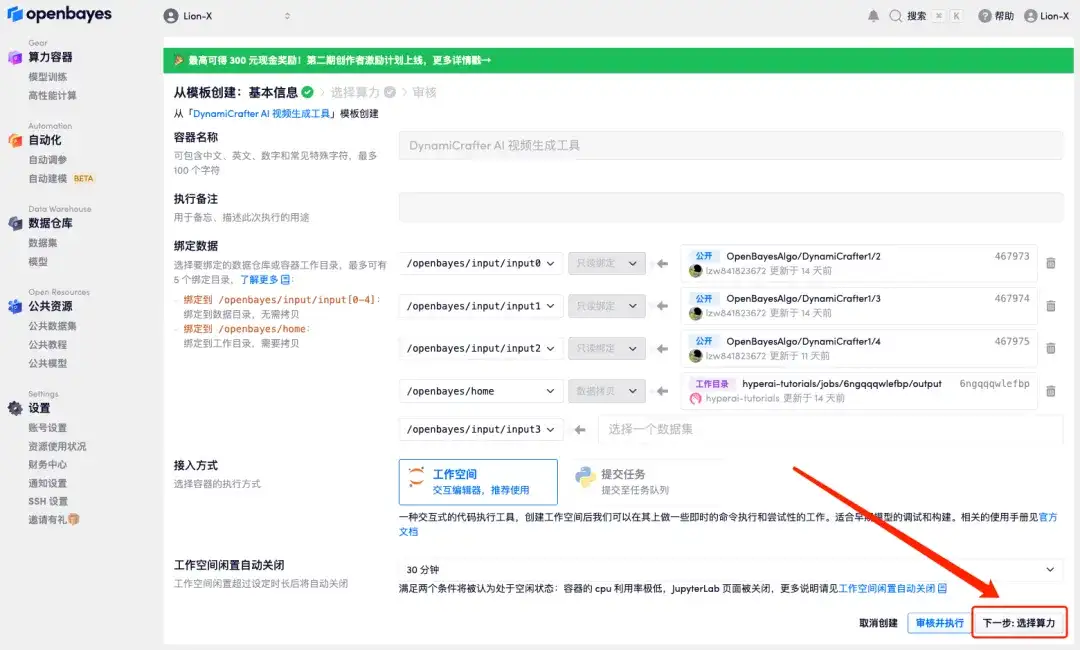

3. 右下隅の「次へ: コンピューティング能力の選択」をクリックします。

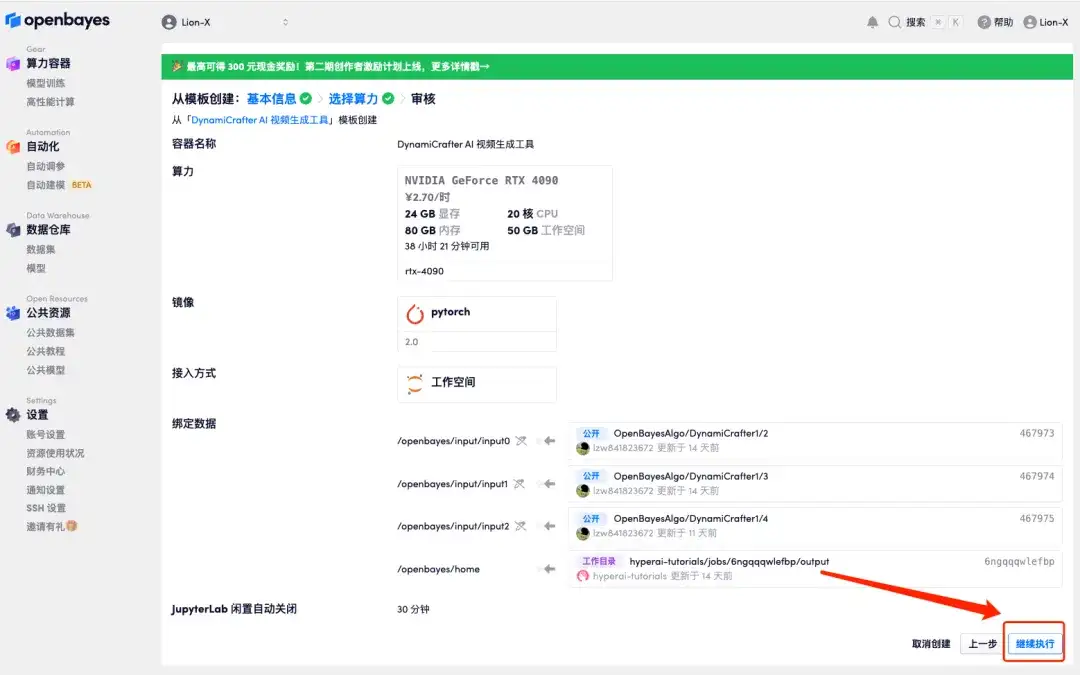

4. ジャンプ後、「NVIDIA GeForce RTX 4090」を選択し、「次へ: 確認」をクリックします。以下の招待リンクを使用してサインアップした新規ユーザーは、4 時間の RTX 4090 + 5 時間の CPU を無料で入手できます。

HyperAI ハイパーニューラルの専用招待リンク (ブラウザに直接コピーして開きます):https://openbayes.com/console/signup?r=6bJ0ljLFsFh_Vvej

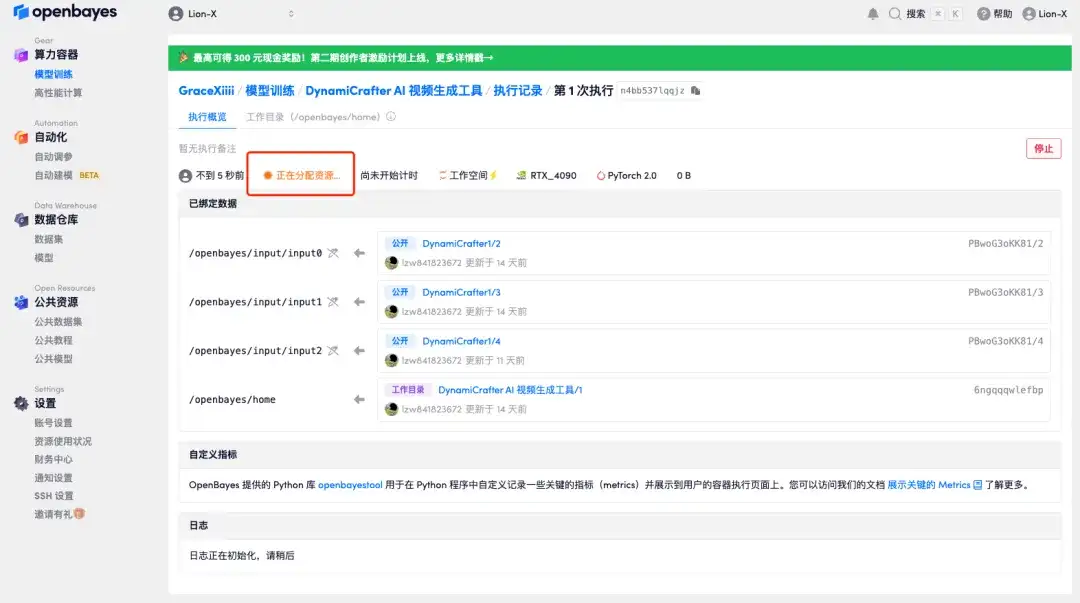

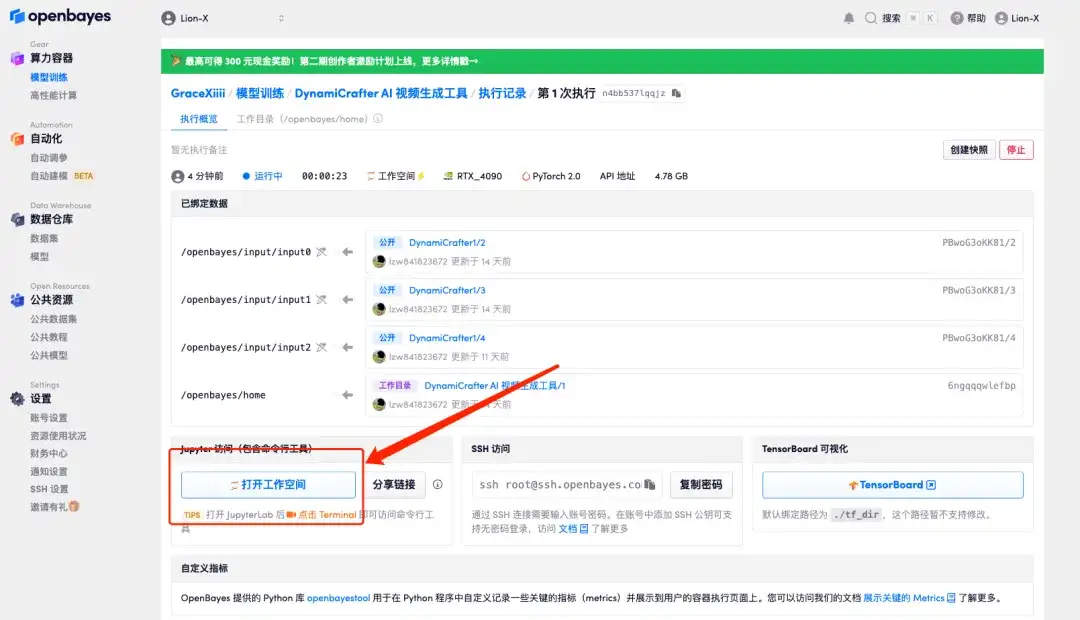

5. [続行] をクリックし、リソースが割り当てられるまで待ちます。最初のクローンには約 3 ~ 5 分かかります。ステータスが「実行中」に変わったら、「ワークスペースを開く」をクリックします。

10 分以上「リソースを割り当てています」状態が続く場合は、コンテナを停止して再起動してみてください。再起動しても問題が解決しない場合は、公式 Web サイトのプラットフォーム カスタマー サービスにお問い合わせください。

6. このチュートリアルでは、以下の 2 つの効果を実現できます。これについては、以下で説明します。

画像とテキストプロンプトからビデオを生成します。

開始フレーム、終了フレーム、プロンプトワードからビデオを生成します。

画像とテキストプロンプトからビデオを生成

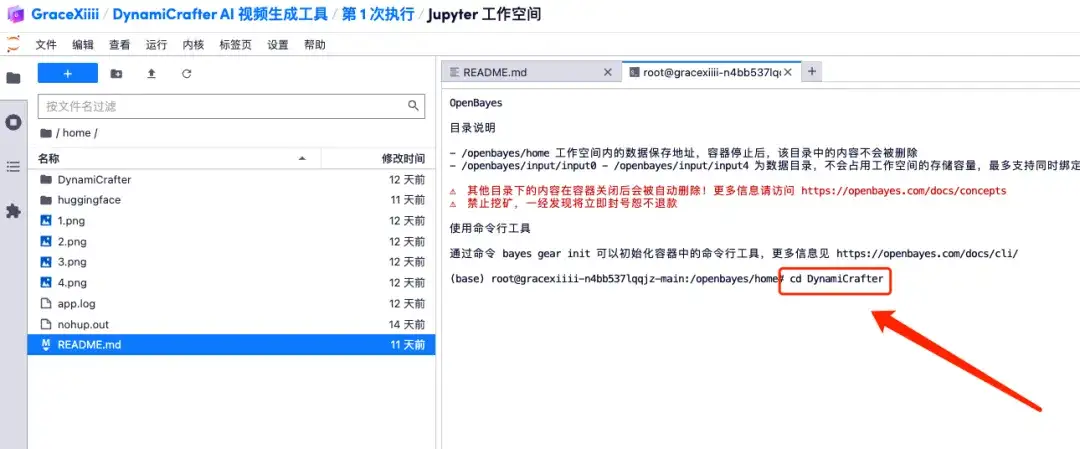

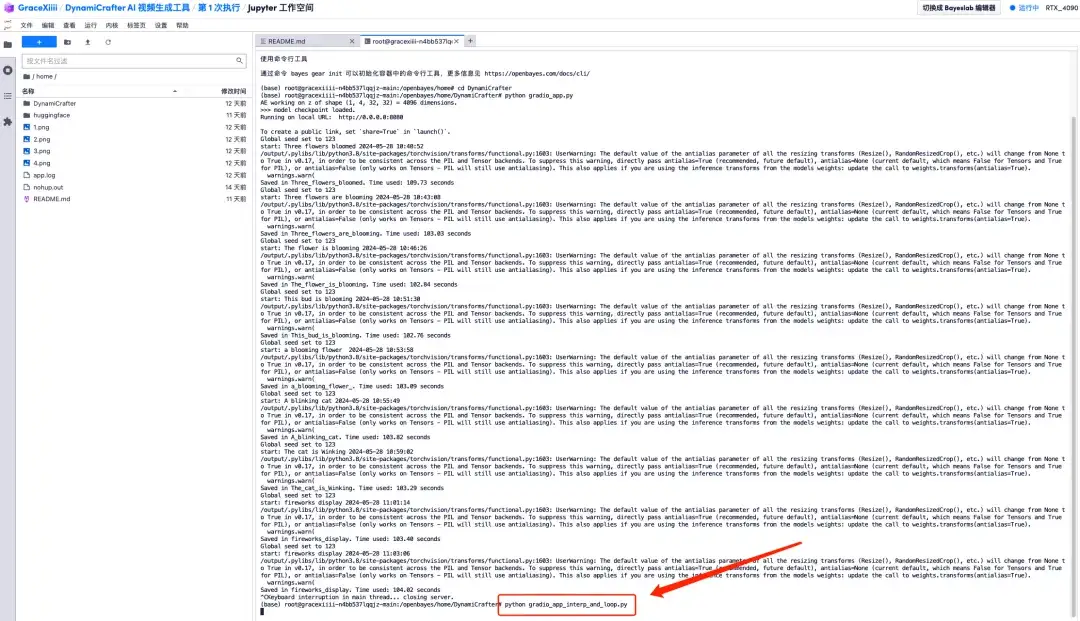

1. 新しいターミナルを作成し、「cd DynamiCrafter」を実行して DynamiCrafter ディレクトリに切り替えます。

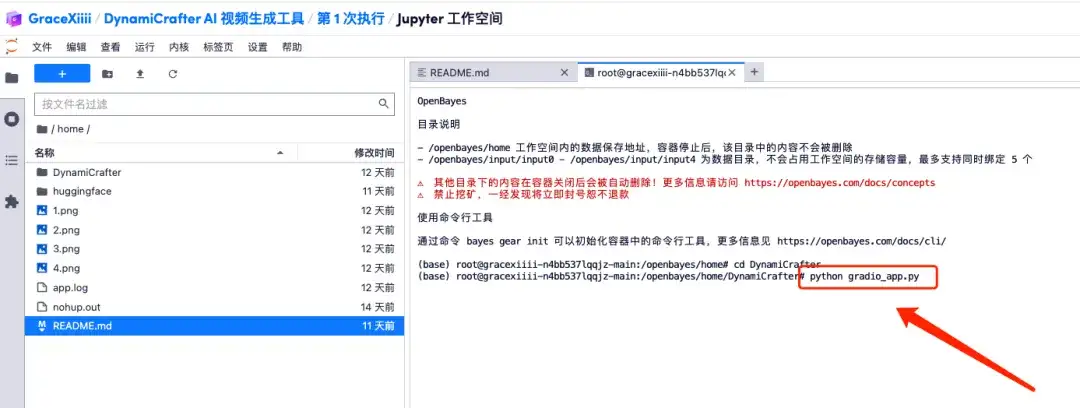

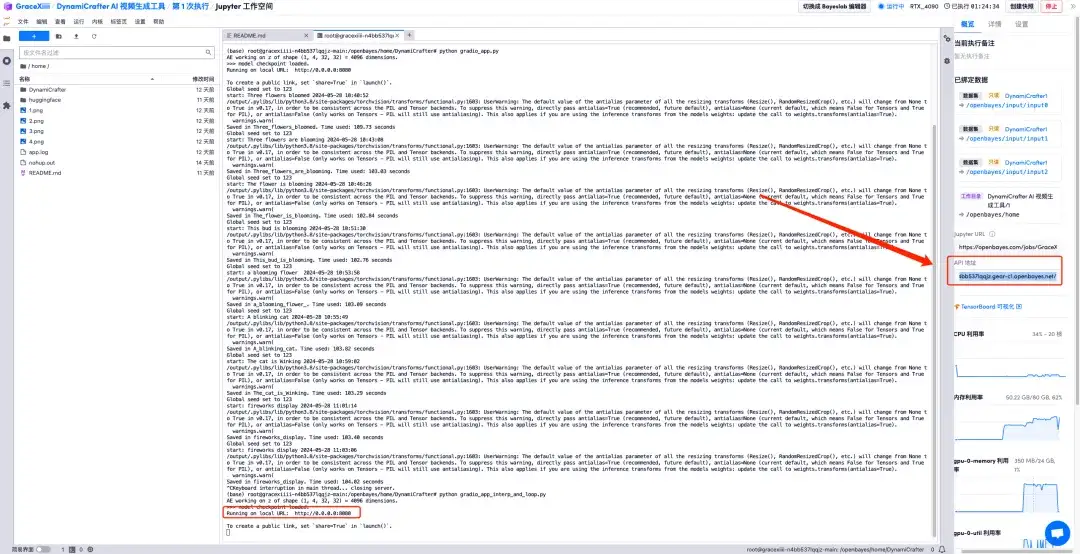

2. 「python grario_app.py」コマンドを実行し、コマンドラインに「」が表示されるまでしばらく待ちます。https://0.0.0.0:8080その後、右側の API アドレスをブラウザのアドレス バーにコピーして、Gradio インターフェイスを開きます。APIアドレスアクセス機能を利用するには実名認証が必要となりますのでご注意ください。

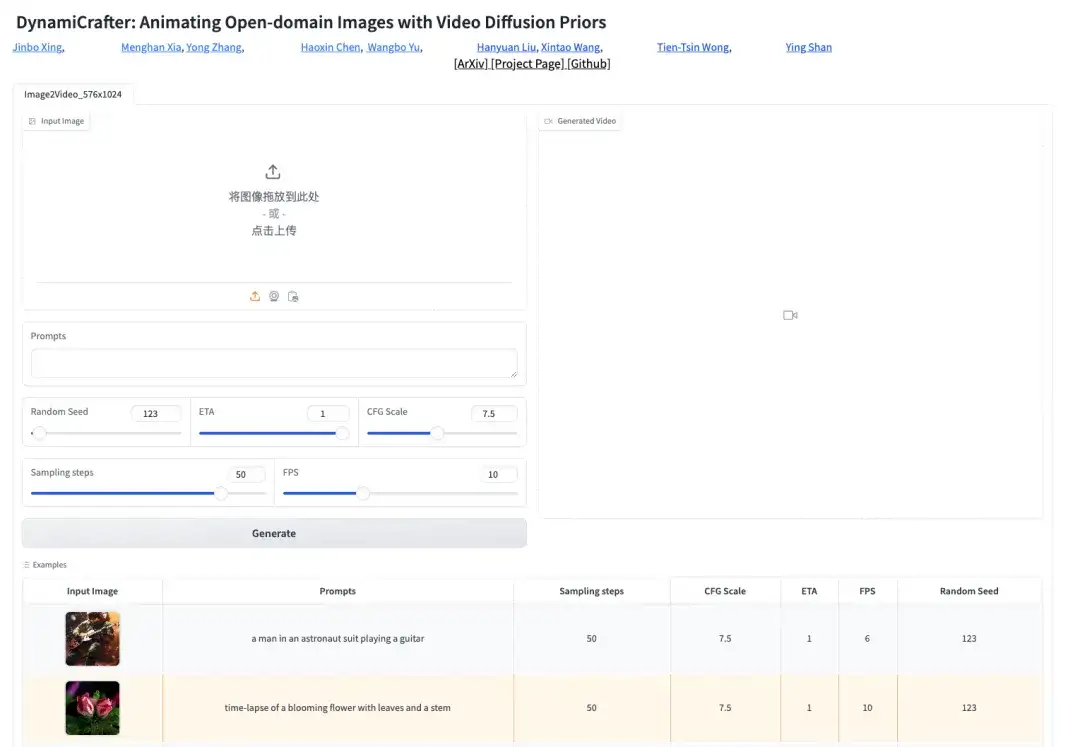

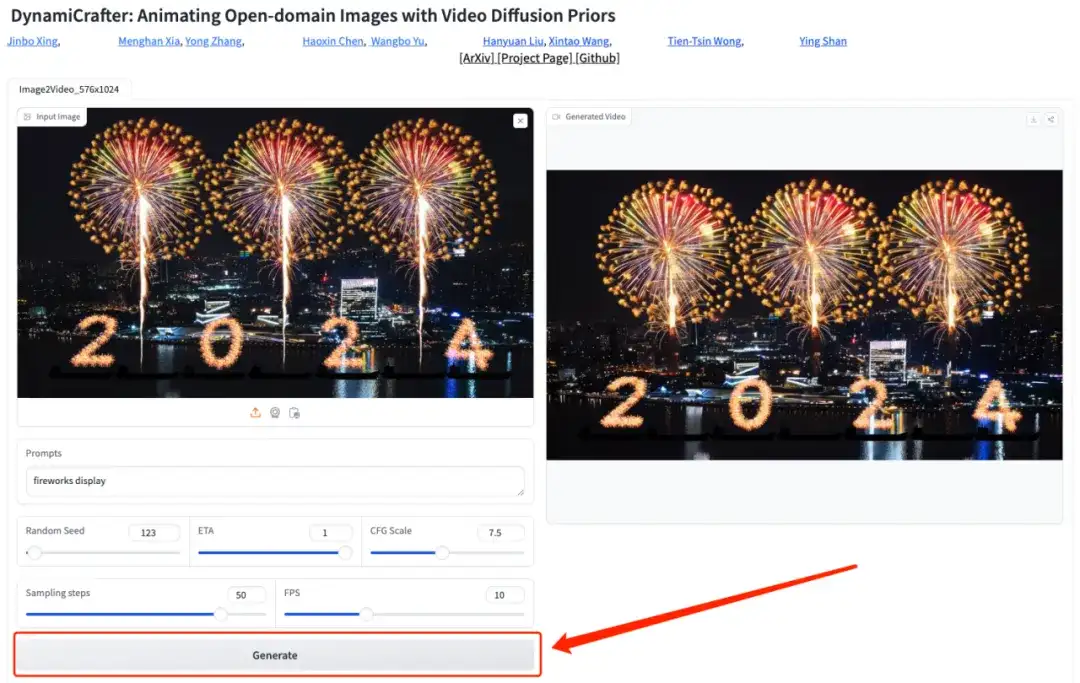

3. Gradio ページを開いた後、写真をアップロードし、テキストの説明 (例: 花火大会) を追加し、「生成」をクリックしてしばらく待つと、ビデオが生成されます。

開始フレーム、終了フレーム、プロンプトワードからビデオを生成

1. ターミナルインターフェイスに戻り、「Ctrl + C」で現在のプロセスを終了し、「python grario_app_interp_and_loop.py」コマンドを実行して「」になるまで待ちます。https://0.0.0.0:8080」をクリックし、右側のAPIアドレスを開きます。

2. Gradio ページで、開始フレーム画像、終了フレーム画像、テキスト説明 (例: 笑顔の女の子) をアップロードし、[生成] をクリックしてビデオを生成します。

現在、HyperAI 公式 Web サイトでは、Jupyter Notebook にまとめられた数百の厳選された機械学習関連のチュートリアルを公開しています。

リンクをクリックして、関連するチュートリアルとデータ セットを検索します。https://hyper.ai/tutorials

以上が今回 HyperAI Super Neural が共有したコンテンツのすべてです。高品質なプロジェクトを見つけたら、バックグラウンドでメッセージを残してください。