Command Palette

Search for a command to run...

GPT-4o はドラゴンを殺すのと同じくらい衝撃的です。マルチモーダル、リアルタイム インタラクション、すべてのメンバーに無料、スムーズな音声インタラクションを備えた ChatGPT が優れています。

5 月初旬から、検索エンジンが 9 日から 5 月 11 日にリリースされることが明らかになり、ChatGPT と GPT-4 のアップデートは現地時間の 5 月 13 日の 10 時にリリースされることが正式に発表されました。サム・アルトマンは、「これは GPT-5 ではなく、検索エンジンではない」が「魔法のような新しいもの」であるという噂に個人的に反論しました。その後、ネチズンはさまざまな手がかりを通じてその公開コンテンツをさらに深く掘り下げ始め、最終的には GPT-4.5 となりました。と ChatGPT の通話機能が人気の候補となりました。

当初、一部のネチズンは、この行動が Google I/O カンファレンスから脚光を奪うことだとサム・アルトマンをからかったが、ジェミニ 1.5 とソラの決闘に比べれば、「ハードグッズ」がなければ、アルトマンは乗り気ではないかもしれない。 Google の年次カンファレンスの前日にリスクを冒して最新情報を投稿してください。

OpenAI のオンライン ライブ ブロードキャスト カンファレンスは、一時的なもののように見えましたが、実際には周到に準備されていました。

この OpenAI の春のアップデートには Sam Altman 氏は参加していませんでしたが、代わりに同社の CTO Muri Murati 氏が次のような一連のアップデートを行いました。

- GPT-4o

- ChatGPTの音声対話機能

- ChatGPT のビジュアル機能

GPT-4o: 音声バフの祝福、すべてのユーザーに無料

GPT-4は2023年3月の発売以来、長らくランキングを独占しており、新モデルが発売されるたびに比較対象から外されるほど、その強力な性能が証明されています。さらに、GPT-4は現段階でOpenAIにとって商業的価値の高い「ドル箱」でもあり、マスク氏から「オープンではない」と繰り返し批判されてきた。

さらに重要なことは、Meta のオープンソース Llama、Google のオープンソース Gemma、Musk のオープンソース Grok に直面して、GPT-3.5 ベースの ChatGPT の無料版に対するプレッシャーが 2 倍になったことです。 GPT-5 はまだ登場していませんが、多くのネチズンは、OpenAI が GPT-3.5 に代わる GPT-4 の新バージョンをリリースすると推測しています。

予想通り、今日のライブブロードキャストで、OpenAI は GPT-4o の新バージョンをリリースしました。これはすべてのユーザーに無料であり、有料ユーザーには無料ユーザーの 5 倍の容量制限があります。その中の「o」は「オムニ」を意味し、より自然な人間とコンピューターの対話への移行を意味します。

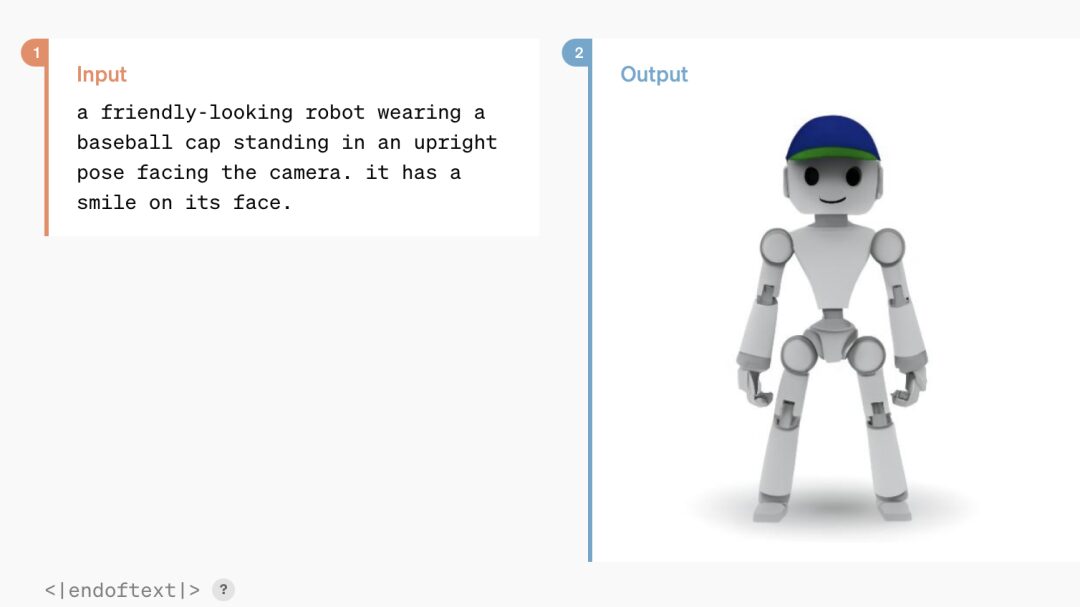

OpenAIの最高技術責任者(CTO)であるムリ・ムラティ氏は、GPT-4oはGPT-4レベルのAI機能を提供し、音声、テキスト、視覚に基づいて推論を実行できると述べた。テキスト、音声、画像の任意の組み合わせを入力として受け入れ、テキスト、音声、画像の任意の組み合わせを出力として生成できます。

リンクをクリックして GPT-4o のデモ ビデオをご覧ください。

https://www.bilibili.com/video/BV1PH4y137ch

GPT-4o より前は、音声モードを使用して ChatGPT と会話する場合の平均遅延は 2.8 秒 (GPT-3.5) と 5.4 秒 (GPT-4) でした。インタラクティブなエクスペリエンスを最適化するために、OpenAI はテキスト、ビジョン、オーディオにわたって新しいモデルをエンドツーエンドでトレーニングしました。つまり、すべての入力と出力が同じニューラル ネットワークによって処理され、情報損失が軽減されます。

パフォーマンスの点では、GPT-4o は音声入力に 232 ミリ秒で反応でき、平均反応時間は 320 ミリ秒で、これは会話中の人間の反応時間とほぼ同じです。さらに、GPT-4o のパフォーマンスは、英語およびコード テキストについては GPT-4 Turbo と同等ですが、英語以外の言語テキストについては大幅に向上しており、50 の異なる言語での品質と認識速度が向上しています。同時に API 速度はオリジナルの 2 倍ですが、価格は 50% より安価です。

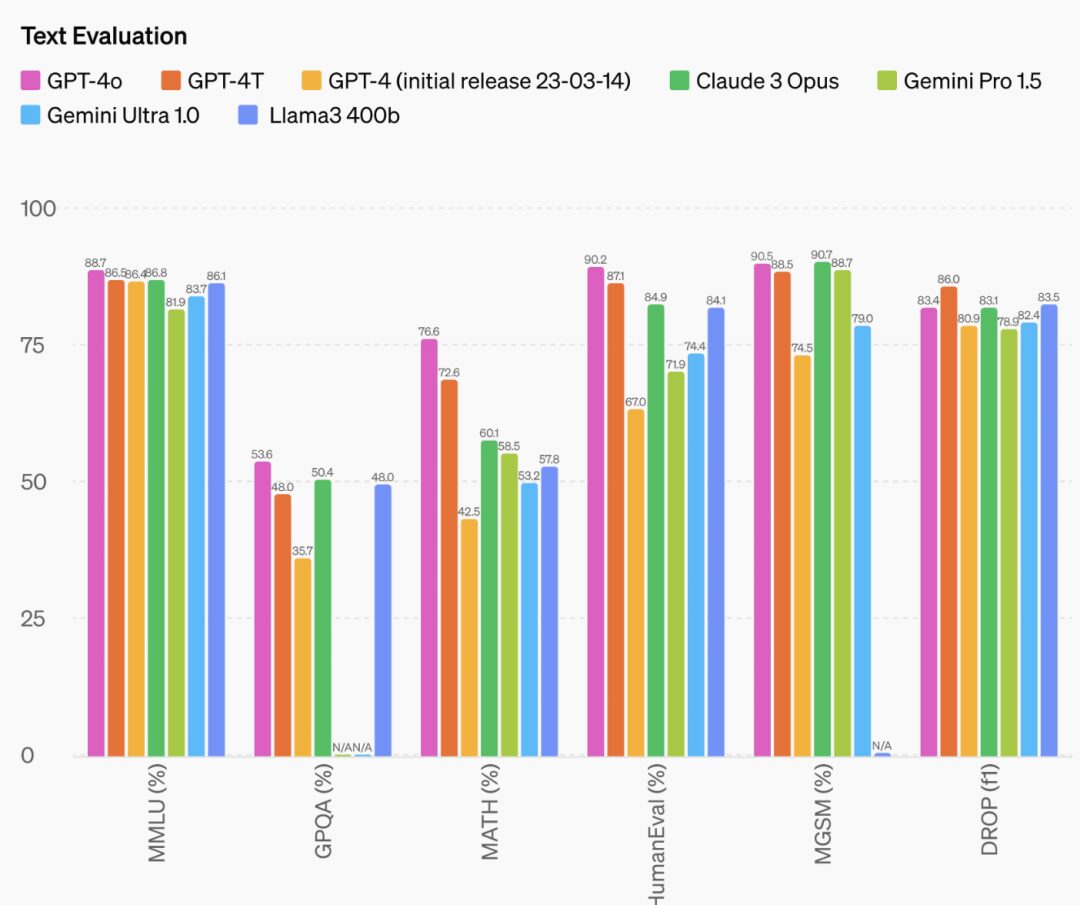

さらに、GPT-4o の推論能力も大幅に向上しており、公式データによると、GPT-4o は 0 ショット COT MMLU (一般知識問題) で 88.7% という新たな高得点を記録しました。

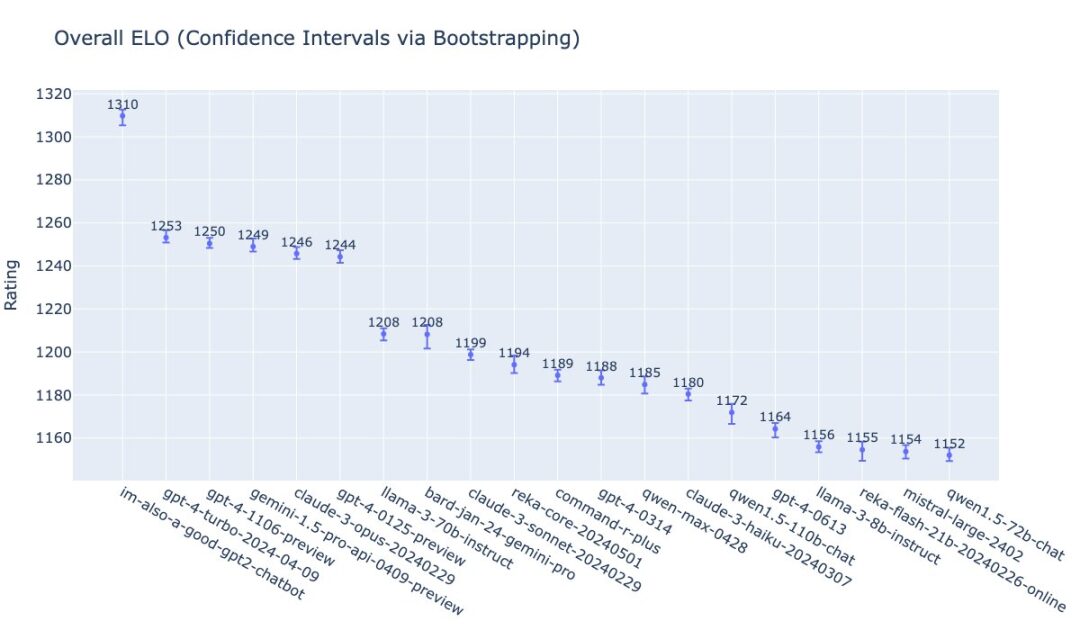

OpenAI の William Fedus は、LMSys リストにおける GPT-4o のランキングを明らかにしました。GPT-4o のチーム名も興味深いです: im-only-a-good-gpt2-chatbot。

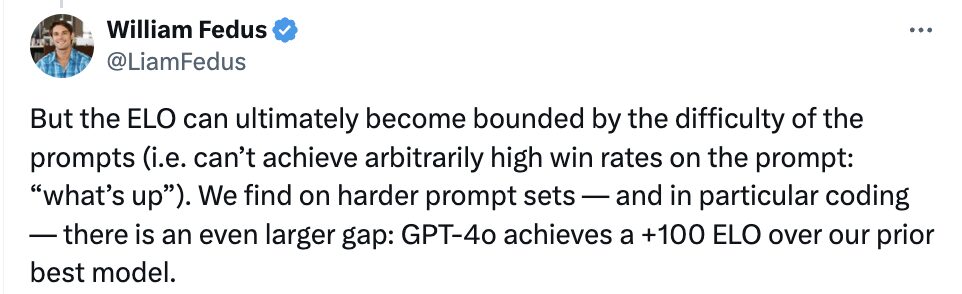

また、より難しいプロンプト セット、特にコーディング能力の点で、GPT-4o は OpenAI の以前の最も先進的な大規模モデルよりも +100 ELO 高いとも述べました。

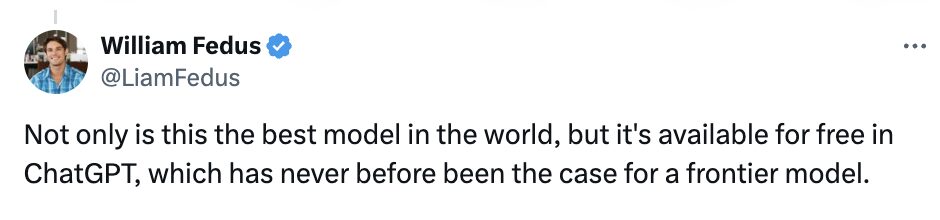

William Fedus 氏は、GPT-4o は世界最高のモデルであるだけでなく、ChatGPT で無料で提供されており、最先端モデルの先例となっていると率直に述べました。

ある意味、GPT-4o は OpenAI の「オープンソース」製品のアップデートであると見ることができます。外部から繰り返し批判されている「OpenAI はオープンではない」について、サム アルトマン氏もブログで次のように述べています。 OpenAI の使命の 1 つは、人々に強力な AI ツールを無料 (または割引価格) で提供することであり、ChatGPT で世界最高のモデルを広告などなしで無料で提供できることを非常に誇りに思っています。」

GPT-4o のパフォーマンスについて、サム アルトマンもためらうことなく次のように称賛しました。「新しい音声 (およびビデオ) モードは、私がこれまで使用した中で最高のコンピューティング インターフェイスです。まるで映画の中の人工知能のような気分です。私は今でも、そのように感じています。」あまりのリアルさに少し驚きましたが、大きな変化の 1 つは人間レベルの応答時間とパフォーマンスです。」

その後、アルトマン氏も自身のアカウントに「her」と投稿し、自身の新型モデルが「Herの時代」を迎えることを示唆した。

GPT-4o API では音声機能がすべてのクライアントで利用できるわけではないことに注意してください。

OpenAI は、GPT-4o は、トレーニング データのフィルタリングやトレーニング後のモデルの動作の調整などのテクノロジーを通じて、設計においてさまざまなモードのセキュリティを考慮しており、チームは新しいセキュリティ システムも作成して、音声の保護を提供していると述べました。出力。

それでもOpenAIは、悪用のリスクを理由に、GPT-4oの新しいオーディオおよびビデオ機能を今後数週間のうちにまず「信頼できるパートナーの小グループ」に展開する計画だと述べた。

GPT-4o のテキストおよび画像機能は、本日より ChatGPT で開始されます。今後数週間のうちに、OpenAI は ChatGPT Plus の GPT-4o を使用した新しい音声モード アルファ版をリリースする予定です。開発者は、API のテキスト モードとビジュアル モードでも GPT-4o にアクセスできるようになりました。

彼女の時代が到来: ChatGPT の感情的な音声インタラクション

今年 2 月の時点で、OpenAI 開発者関係の元責任者は、ChatGPT の究極の形は単なるチャットではないと述べていました。

5 月 11 日、Sam Altman 氏もポッドキャストで、OpenAI は ChatGPT の音声機能の品質を改善および強化し続けると述べ、音声インタラクションはインタラクションの未来への重要な方法であると述べました。

本日の記者会見では、OpenAI が ChatGPT の音声品質を段階的に改善し、GPT-4o に基づいて音声対話が実現され、応答速度が大幅に向上したことも実証されました。

具体的には、ChatGPT のアップグレードと更新は主に、リアルタイム インタラクション、マルチモーダル入出力、感情認識の 3 つの側面に反映されます。

リアルタイムの対話に関しては、ライブ デモンストレーションでは、ChatGPT は質問者のほぼすべての質問に即座に応答でき、質問者が ChatGPT の回答を中断した場合、停止することもできます。ムリ・ムラティ氏は、聴衆のリクエストに応じて GPT-4o のリアルタイム翻訳機能も実演しました。

GPT-4o ベースの ChatGPT は、テキスト、音声、視覚情報を認識し、ニーズに応じて任意の形式で応答することができます。

感情認識と感情フィードバックの点で、アップグレードされた ChatGPT は、セルフィーに基づいて人々の顔の感情を迅速に分析できます。同時に、話し手の要求に応じて、誇張したドラマから冷たい機械的な話し方、さらには歌まで、話し方のトーンを調整することができ、その優れた可塑性を示しています。

これに関して、ムリ・ムラティ氏は次のように述べています。「これらのモデルがますます複雑になっていることは承知していますが、インタラクティブなエクスペリエンスがより自然でシンプルになり、ユーザー インターフェイスにまったく注意を払う必要がなくなることを願っています」ただし、GPT との連携にのみ焦点を当てます。これは非常に重要です。

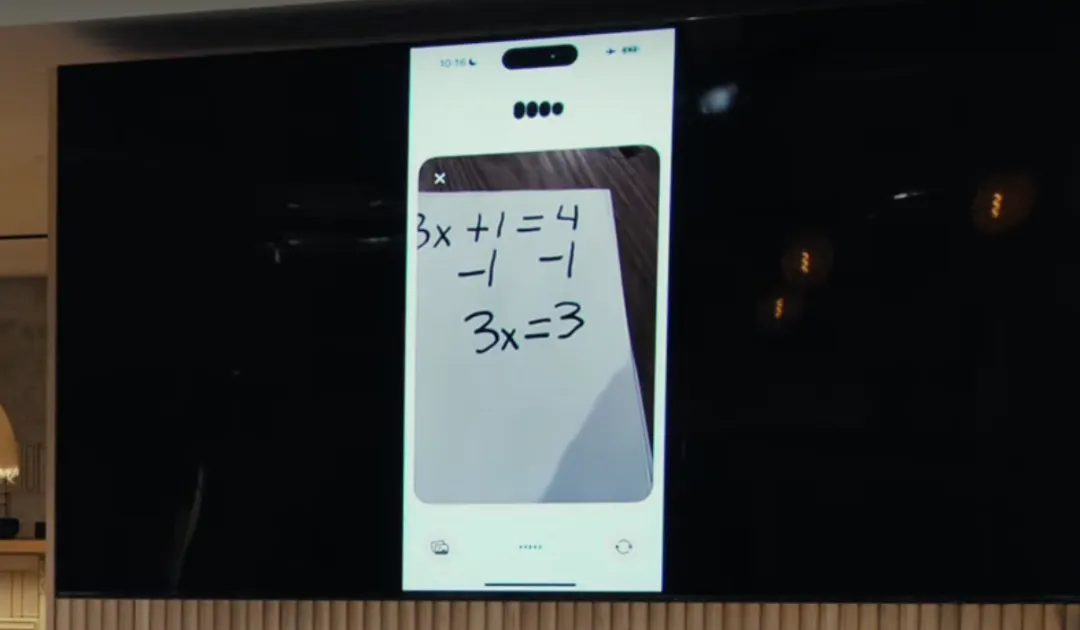

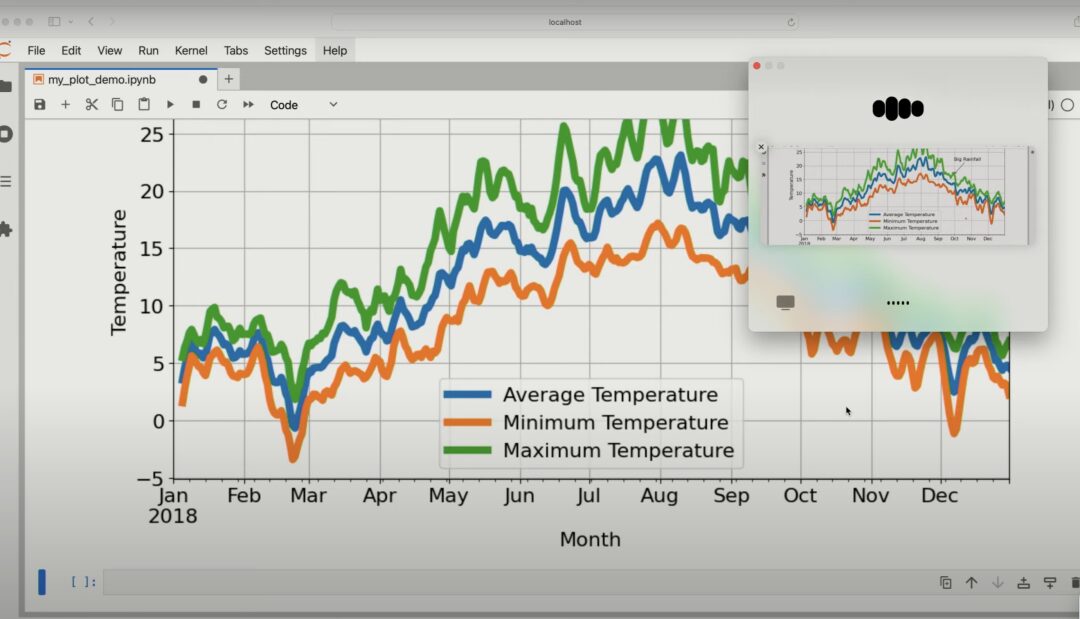

さらに、GPT-4o は、推論分析の観点から、ChatGPT の視覚的な機能も向上させています。撮影した写真を与えると、ChatGPT は画像のコンテンツをすばやく参照し、数学の問題を解くために写真を撮るなど、関連する質問に答えることができます。

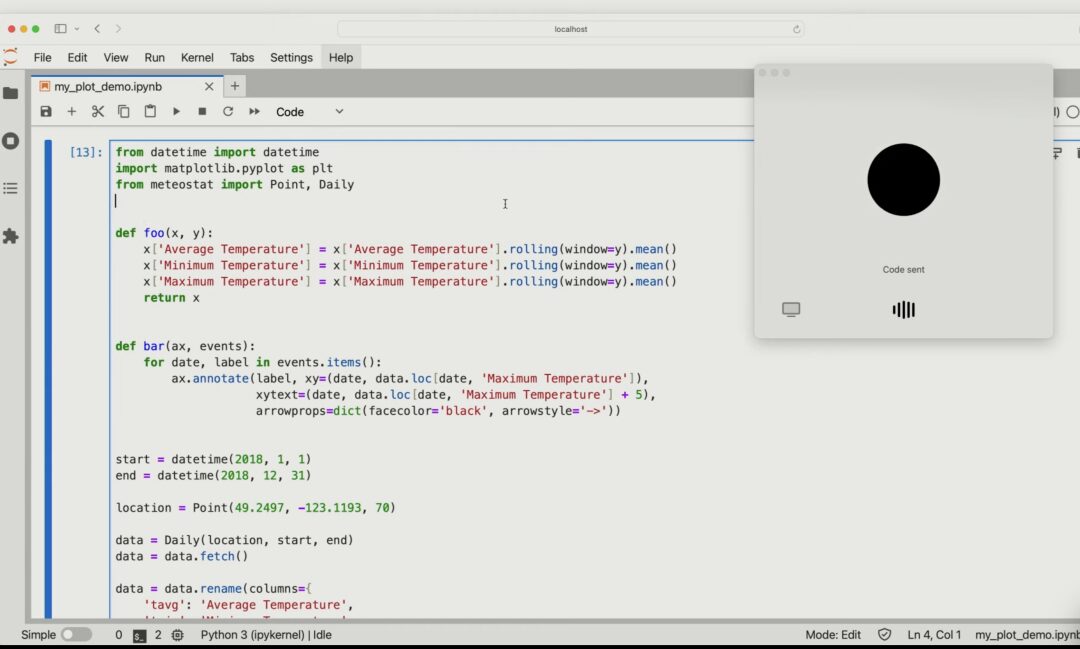

また、共有されたコード ピクチャに基づいてコードの特定の内容を記述し、コード内の変数の 1 つが変更された場合の具体的な影響を分析することもできます。

GPT-4o にチャートを与えると、チャートの内容を詳細に分析することもできます。

ChatGPT を音声、テキスト、視覚に適用するという OpenAI の革新的な試みは、将来的には人間とコンピューターの対話がより自然でスムーズになる可能性があることを示しています。

この点に関して、OpenAIは、視覚および音声機能を備えたAI音声アシスタントには、理論上、論文や数学の講師としての役割など、現在のAIアシスタントではできない一連のことができると述べた。 、または交通標識を翻訳したり、車の問題の解決を手伝ったりします。

最後に書きます

GPT の誕生以来、OpenAI はかつては大型モデルの時代の「羽根」とみなされていました。シリコンバレーの伝統的な巨人の内訳は次のとおりです。

- Microsoft と OpenAI の関係は微妙です。同社は主要な投資家であるだけでなく、自社のビジネスに GPT モデルを導入しており、OpenAI にクラウド サービスも提供しています。

- Appleは今年、生成AIへの投資を増やし始め、自社開発の大型モデルをリリースしたが、それがOpenAIの地位を揺るがすことができるかどうかはまだ不透明だ。すでに大規模モデルでOpenAIとGoogleとの協力を計画している。

- 世界最大のクラウドインフラプロバイダーであるAmazonも、独自の大規模モデルAmazon Titanを立ち上げているが、これは同社のクラウドホスティングサービスBedrockの一部にすぎない AmazonもAnthropicに投資しているが、現時点ではOpenAIと競合するのは難しいようだ。

いくつか比較した結果、Google は OpenAI と競合する最も有望な企業であるようです。Google は深い技術的蓄積を持っているだけでなく (Transformer アーキテクチャは Google のものです)、大規模モデルがその才能を発揮できる豊富なエコシステムを持っています。

しかし、Google をフォローしている読者なら、このベテランの巨人が、Bard や PaLM 2 の性能が GPT-4 ほど優れていないことから、大型モデルの時代には少々「犬頭」的な体格をしていることに気づくかもしれません。破壊的な傑作 Gemini 1.5 Sora のリリースが注目を集め、3 月に予定されていた Google I/O カンファレンスは、キャンペーンの最高の時期に OpenAI による「急襲された」ライブ ブロードキャストによって影が薄くなりました...

ちょうど今日(5月14日)の早朝、OpenAIは「世界最高のモデル」を発表したが、ピチャイ氏は今日の記者会見を見て一晩で「台本を変える」だろうか?

その答えは明日の早朝に明らかになるでしょう。Google の「方向転換」を楽しみにしています。HyperAI の超神経質な人々が引き続き直接のレポートを提供してくれるでしょう。