Command Palette

Search for a command to run...

Google、HEALアーキテクチャをリリース、医療AIツールが公平かどうかを評価する4つのステップ

健康な状態を維持することをレースとして考えると、誰もが同じスタートラインに立てるわけではなく、スムーズにレースを完走できる人もいれば、転倒してもすぐに助けてもらえる人もいるかもしれません。経済的状況、住んでいる場所、教育レベル、人種、またはその他の要因による追加の障壁。

「健康の公平性」とは、より落ち着いてレースを完走し、最適な健康状態を達成できるように、誰もが平等に健康と医療リソースにアクセスできるようにすることを意味します。人種的少数派、社会経済的地位が低い人々、医療へのアクセスが制限されている個人など、特定のグループに対する病気の予防、診断、治療における不公平な扱いは、彼らの生活の質と生存の可能性に重大な影響を与える可能性があります。不平等の根本原因にさらに取り組むためには、「健康の公平性」への関心を高めることが世界的なコンセンサスとなるべきであることに疑いの余地はありません。

現在、機械学習やディープラーニングなどが医療・健康分野で「成果を上げ」ていますが、それらは研究室を飛び出し臨床現場にも進出しています。 AIの強力な機能を嘆く一方で、人々はこの種の新興テクノロジーの導入が医療資源の不平等を悪化させるかどうかにもっと注意を払うべきではないだろうか。

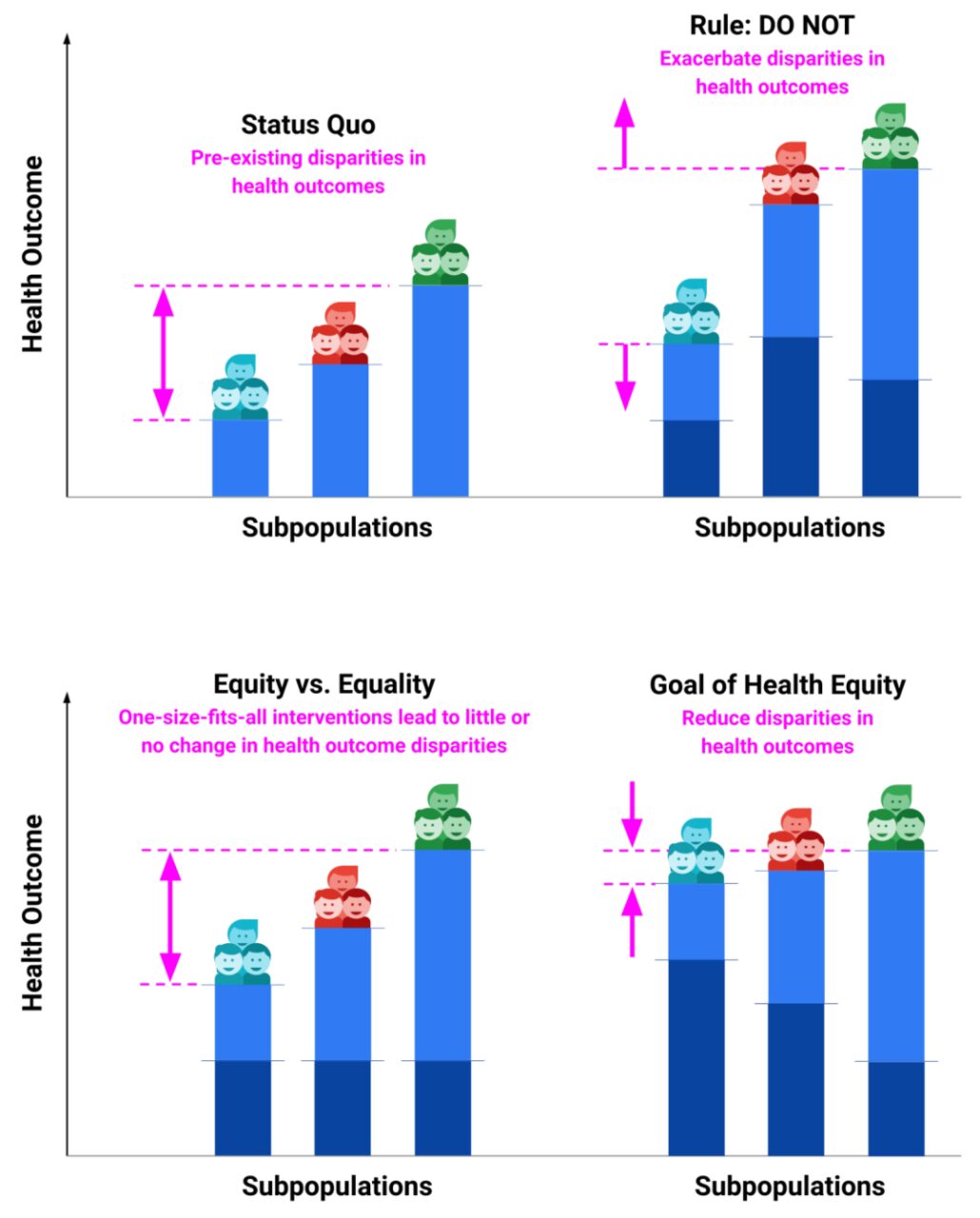

*水色のバーは既存の健康状態を示します

*濃い青色のバーは、既存の健康結果に対する介入の影響を示しています。

この目的を達成するために、Google チームは、機械学習に基づいた医療および健康ソリューションが「公平」であるかどうかを定量的に評価できる HEAL (The health equity Framework) フレームワークを開発しました。このアプローチを通じて、研究チームは、新興の医療技術が健康の不平等を不用意に悪化させるのではなく、効果的に削減することを目指しています。

HEAL アーキテクチャ: 皮膚科 AI ツールの公平性を評価する 4 つのステップ

HEAL フレームワークは 4 つのステップで構成されます。

- 健康の不平等に関連する要因を特定し、AI ツールのパフォーマンス指標を定義する

- 既存の健康格差を特定して定量化する

- AIツールのパフォーマンステスト

- AI ツールが健康の公平性の格差を優先する可能性を測定する

ステップ 1: 皮膚科における健康の不平等に関連する要因を特定し、AI ツールのパフォーマンスを評価するための指標を特定する

研究者らは文献をレビューし、利用可能なデータを考慮して、年齢、性別、人種/民族、フィッツパトリック肌タイプ (FST) の要素を選択しました。

FST は、紫外線 (UV) 放射、特に日焼けや日焼けに対する反応に基づいて人間の皮膚を分類するシステムです。 FST I から FST VI までの各タイプは、皮膚、目、髪のメラニン生成の異なるレベル、および紫外線に対する感受性を表します。

さらに研究者らは、AI ツールのパフォーマンスを評価する指標として上位 3 つの一致を選択しました。これは、AI によって提案された上位 3 つの条件のうち少なくとも 1 つが一致するケースの割合として定義されます。皮膚科専門家パネルによる参考診断。

ステップ 2: 皮膚科における既存の「健康格差」を特定する

健康格差指標は、異なるグループ間の健康状態の不平等を定量化して説明するために使用される特定の尺度です。これらのグループは、人種、経済的地位、地理的位置、性別、年齢、障害、またはその他の社会的決定要因に基づいて区別されます。

健康格差を示す一般的な指標は次のとおりです。

障害調整生存年 (DALY): 病気、障害、または早期死亡により失われた健康な生活の年数を反映します。 DALY は、潜在的生命損失年数 (YLL) と障害を抱えて生存した年数 (YLD) の合計である複合指標です。

失われた命の年数(YLL): 早死により失われると予想される健康年数。

同時に研究者らは、高リスク条件下で AI ツールのパフォーマンスがどのように変化するかを理解するために、皮膚がんに関するサブ分析も実施しました。この研究では、世界的疾病負担(GBD)の「非黒色腫皮膚がん」および「皮膚悪性黒色腫」のカテゴリーを使用して、すべてのがんの健康転帰を推定し、がん以外のすべての状態については「皮膚および皮下疾患」のカテゴリーを使用しました。

ステップ 3: AI ツールのパフォーマンスを測定する

上位 3 位の一致度は、AI が予測したランク付けされた病理を、評価データセット (年齢、性別、人種/民族、および eFST で階層化されたサブグループ) の参照診断と比較することによって測定されました。

ステップ 4: 健康格差を考慮した AI ツールのパフォーマンスを調査する

皮膚疾患のHEAL指標を数値化するAIツールの具体的な方法は以下の通りです。

部分母集団ごとに、次の 2 つの入力が必要です。既存の健康格差と AI ツールのパフォーマンスの定量的測定。

特定の不平等要因 (人種/民族など) について、すべてのサブグループにわたる健康成果と AI パフォーマンスの間の逆相関 R を計算します。R の正の値が大きいほど、健康の公平性がより包括的に考慮されます。

AI ツールの HEAL 指標を p(R > 0) と定義すると、AI が既存の健康格差を優先する可能性が、9,999 サンプルの R 分布を通じて推定されました。 50% を超える HEAL 指標は、健康の公平性を達成する可能性が高いことを意味し、50% を下回る HEAL 指標は、公正なパフォーマンスを達成する可能性が低いことを意味します。

皮膚科 AI ツールの評価: 一部のサブグループはまだ改善が必要

人種/民族: HEAL 指標は 80.5% であり、これらのサブグループに存在する健康格差の優先度が高いことを示しています。

性別: HEAL 指標は 92.1% であり、AI ツールのパフォーマンスにおける健康格差を考慮する際に性別が高い優先順位を持っていることを示しています。

年齢: HEAL 指標は 0.0% であり、年齢グループ間の健康格差を優先する可能性が低いことを示しています。癌状態の場合、HEAL 指標は 73.8% ですが、非癌状態の場合、HEAL 指標は 0.0% です。

研究者らはロジスティック回帰分析を実施し、その結果、年齢と特定の皮膚疾患(基底細胞がんや扁平上皮がんなど)がAIのパフォーマンスに大きな影響を与える一方、他の疾患(嚢胞など)ではパフォーマンスの精度が低いことが示されました。

さらに、研究者らは交差性分析を実施し、セグメント化された GBD 健康アウトカム測定ツールを使用して、年齢、性別、人種/民族にわたる拡張 HEAL 分析を実施し、全体的な HEAL 指標は 17.0% でした。特に、健康成果と AI パフォーマンスの両方における下位順位の共通部分に焦点を当て、50 歳以上のヒスパニック系女性、50 歳以上の黒人女性、50 歳以上の白人女性、20 歳の白人男性など、AI ツールのパフォーマンスを向上させる必要があるサブグループを特定しました。 49歳、アジアおよび太平洋諸島の男性は50歳以上。

とはいえ、健康の公平性を達成するには、これらのグループを対象とした AI ツールのパフォーマンスを向上させることが重要です。

健康の公平性だけではない: AI における公平性のより広範な全体像

さまざまな人種・民族、性別、年齢層の間で健康格差が顕著に存在することは明らかであり、特にハイテク医療技術の急速な発展の下では、医療資源の傾きはさらに増大しています。関連する問題を解決する過程において、AI が果たすべき道のりは長いです。しかし、デジタルデバイドによる情報へのアクセス、オンライン教育、デジタルサービスの不平等など、テクノロジーの進歩による不平等は実際に人々の生活のあらゆる側面に存在していることは注目に値します。

Google AI の責任者であり「プログラマー マスター」であるジェフ ディーンは、Google は AI の公平性を非常に重視しており、データ、アルゴリズム、通信分析、モデルの解釈可能性、文化的差異の研究、大規模モデルのプライバシー保護に多くの取り組みを行っているとかつて述べました。 。例: * 2019 年、Google Cloud の責任ある AI 製品検討委員会と Google Cloud の責任ある AI トランザクション検討委員会は、アルゴリズムの不公平性や偏見の悪化を避けるために、クレジット関連の人工知能製品の開発を一時停止しました。 * 2021 年、先端技術審査委員会は大規模な言語モデルを含む研究を検討し、慎重に進めることができるが、人工知能の原理の包括的な見直しが行われるまではモデルを正式に開始できないと結論付けました。 * Google DeepMind チームは、「人間の価値観を AI システムに統合する方法」を検討し、AI に哲学的アイデアを統合して社会的公平性を確立するのに役立つ論文を発表しました。

将来的には、AI技術の公平性を確保するために、次のような複数の角度から介入とガバナンスを実行する必要があります。

* 公正なデータ収集と処理:トレーニング データが、さまざまな性別、年齢、人種、文化、社会経済的背景などの多様性をカバーしていることを確認します。同時に、バイアスによるデータの選択を回避し、データセットの代表性とバランスを確保する必要があります。

* アルゴリズムのバイアスを排除します:モデルの設計段階で、不公平な結果につながる可能性のあるアルゴリズムのバイアスを積極的に特定して排除します。これには、モデルへの入力特徴を慎重に選択することや、バイアスを軽減または排除するための特定の手法の使用が含まれる場合があります。

※公平性評価:公平性評価は、モデルの展開の前後に実施する必要があります。これには、さまざまな公平性指標を使用してさまざまなグループに対するモデルの影響を評価し、評価結果に基づいて必要な調整を行うことが含まれます。

* 継続的なモニタリングと反復的な改善:AI システムの導入後は、不公平性の可能性がある問題を迅速に特定して解決するために、実際の環境でのパフォーマンスを継続的に監視する必要があります。これには、環境の変化や新しい社会規範に適応するためにモデルを定期的に反復する必要がある場合があります。

AI テクノロジーの発展に伴い、関連する倫理原則、法律、規制もさらに改善され、AI テクノロジーがより公平な枠組みの中で発展することが可能になります。ダイバーシティとインクルージョンへの注目も高まるでしょう。そのためには、データ収集、アルゴリズム設計、製品開発のあらゆる側面において、さまざまなグループのニーズと特性を考慮する必要があります。

長期的には、AI が生活を変える本当の意味は、さまざまな性別、年齢、人種、文化、社会経済的背景の人々により良いサービスを提供し、テクノロジーの適用によって引き起こされる不平等を軽減することであるはずです。国民の意識レベルが向上し続けるにつれて、より多くの人が AI 開発の計画に参加し、AI 技術の開発に提案を行って、技術の開発が社会全体の利益に確実に一致するようにすることができるでしょうか。

AI技術の公平性を実現する広範な青写真には、技術、社会、法律など複数の分野の共同の取り組みが必要である。先端技術が「マシュー効果」を引き起こすことを許すべきではない。