Command Palette

Search for a command to run...

オンラインチュートリアル丨Liu Qiangdongのデジタルデビュー、取引量は5,000万を超えました! GeneFace++ を使用してリアルタイムで話すデジタル人物を生成する

最近、JD.comの創設者であるLiu Qiangdong氏は「購買マーケティング東格AIデジタルマン」に変身し、JD.comの家電製品、家電製品、スーパーマーケットの購買マーケティングライブブロードキャストルームで初のライブブロードキャストを開始しました。この生放送の視聴者数は2,000万人を超え、総取引額は5,000万を超えました。これは、電子商取引ライブブロードキャストの分野における AI デジタルヒューマンの大きな可能性を十分に示しています。

出典: Observer.com

「購買およびマーケティング東格AIデジタルヒューマン」は、劉強東の画像と音声を学習および訓練することによって、劉強東の個人化された表情、姿勢、ジェスチャー、音色特性などを正確に表示できることがわかります。デジタルヒューマンを区別することは困難です。 120秒以内に本物の人との違いがわかります。

IDCはかつて「2022年中国AIデジタルヒューマン市場の現状と機会分析」の中で、中国のAIデジタルヒューマン市場規模は2026年までに102億4000万元に達すると予想されていると述べた。 AI デジタル ヒューマンは、セルフメディア運用、短いビデオ配信、人間を支援するデジタル ヒューマン ブロードキャストなどのシナリオに適用すると、コピー可能で低コストで 24 時間稼働できると言わざるを得ません。さまざまなタスクを完了することで、将来的には大きなトレンドになる可能性があります。

この分野では、音声による話し顔の生成が注目されています。この技術に基づいて、音声クリップを入力するだけで対象者の顔の発話ビデオを構築することができるため、実際の人物が出演できない、または不便なシーンに対象者が参加することができます。で、GeneFace++ は、多用途で安定したリアルタイムのオーディオ駆動型 3D トーキングフェイス生成テクノロジーとして、リップシンク、ビデオ品質、システム効率を向上させることで、リアルタイムのスピーカー生成を初めて実現しました。

具体的には、GeneFace++ は、オーディオからモーションへのモジュールとリアルタイムのモーションからビデオへのモジュールを個別にトレーニングします。トレーニング プロセスでは、音声と顔の動きの間のマッピング学習、ドメイン適応性転移学習、ランドマーク駆動型 3D ポートレート リアルタイム レンダリング技術の学習などが行われ、最終的にモデルが高品質でリアルタイムに生成できるようになります。 、任意の音声に基づいたリップシンク 3D 画像、顔のビデオに話しかける機能。

ただし、リアルな口パクのデジタル ヒューマンを作成するのは簡単な作業ではありません。初心者がすぐに始められるようにし、一般的な環境セットアップや技術的な問題を回避できるように、ハイパーAI超緊張「GeneFace++ Digital Human Demo」チュートリアルを開始しました。このチュートリアルでは、誰でも使用できる環境をセットアップし、デジタル ヒューマンの制作プロセスを簡素化します。環境構成、ハードウェア要件、バージョンの互換性などについて心配する必要はありません。クローンをクリックすると、ワンクリックで開始できます。とてもリアルです!

HyperAI スーパー ニューラルの公開チュートリアルのアドレス:

https://hyper.ai/tutorials/31157

事前準備

3 ~ 5 分のビデオを準備します。

* 鮮明な画像、正方形サイズ (できれば 512*512 サイズ)。

* モデルが背景をより適切に抽出するには、ビデオの背景が他の干渉要因のない単色であることが最適です。

* ビデオ内のキャラクターの顔は鮮明で比較的大きく、正面を向いている必要があります。また、キャプチャされた画像は肩より上にある必要があり、キャラクターの動きの範囲は大きすぎたり小さすぎたりしないでください。

* ビデオ内の音声にノイズはありません。

※動画の名前は英語にするのがベストです。

注: このビデオはモデルのトレーニングに使用されます。ビデオの品質が高いほど、結果も良くなります。したがって、データの準備部分にはもう少し時間と労力を費やす必要があります。

下の図はビデオ画面の例です。

デモの実行

1. hyper.aiにログインし、「チュートリアル」ページで「GeneFace++ Digital Human Demo」を選択します。 「このチュートリアルをオンラインで実行する」をクリックします。

2. ページがジャンプしたら、右上隅の「クローン」をクリックしてチュートリアルを独自のコンテナにクローンします。

3. 右下隅の「次へ: コンピューティング能力の選択」をクリックします。

4. ジャンプ後、「NVIDIA GeForce RTX 4090」を選択し、「次へ: 確認」をクリックします。新規ユーザーは、以下の招待リンクを使用して登録すると、4 時間の RTX 4090 + 5 時間の無料 CPU コンピューティング時間を取得できます。

HyperAI ハイパーニューラルの専用招待リンク (ブラウザに直接コピーし、開いて登録します):

https://openbayes.com/console/signup?r=6bJ0ljLFsFh_Vvej

5. [続行] をクリックし、リソースが割り当てられるまで待ちます。最初のクローンには約 3 ~ 5 分かかります。ステータスが「実行中」に変わったら、「ワークスペースを開く」をクリックします。 10 分以上「リソースを割り当てています」状態が続く場合は、コンテナを停止して再起動してみてください。再起動しても問題が解決しない場合は、公式 Web サイトのプラットフォーム カスタマー サービスにお問い合わせください。

6. ワークスペースを開いた後、起動ページで新しいターミナル セッションを作成し、コマンド ラインに次のコードを入力して環境を開始し、コピーして貼り付けます。

conda env export -p /output/geneface

conda activate /output/geneface

7. しばらく待ってから、ターミナルで次のコマンドを実行して環境変数を構成します。

ソースbashrc

8. しばらく待ってから、コマンド ラインに次のコードを入力し、WebUI を起動して、約 1 分間待ちます。

/openbayes/home/start_web.sh

9. コマンド ラインに「ローカル URL で実行中: https://0.0.0.0:8080」と表示されたら、右側の API アドレスをブラウザのアドレス バーにコピーして、GeneFace++ インターフェイスにアクセスします。APIアドレスアクセス機能を利用するには実名認証が必要となりますのでご注意ください。

エフェクト表示

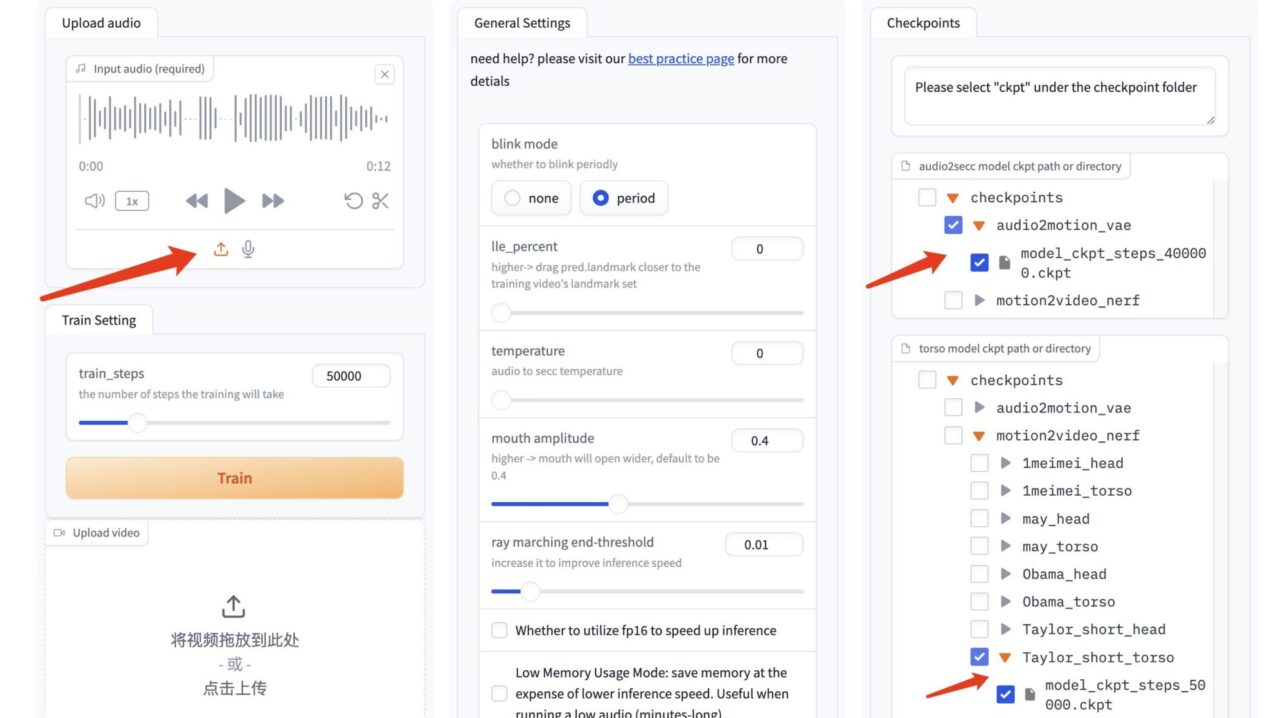

1. GeneFace++ インターフェースを開いた後、準備したビデオをインポートし、トレーニングステップ数「50000」を選択し、「トレーニング」をクリックしてトレーニングを開始します。

注: このステップでは 2 時間以上待つ必要があります。この間にトレーニングが正常に実行されているかどうかを 1 ~ 2 回確認して、プロセスが中断され続けることによる時間のロスを避けることができます。

ここでのトレーニング ステップ数「50000」はデフォルトです。50000 ステップのトレーニング結果が非常に悪い場合は、トレーニング データを変更して再トレーニングしてください。

2. 「Train Success」が表示されたら、GeneFace++ インターフェイスを更新します。

3. GeneFace++ インターフェースで、左側のオーディオをアップロードします。中央のモジュールのパラメーターを変更する必要はありません。

右側のモデルでは、オーディオ ドライバー モデル「model_ckpt_steps_400000.ckpt」を選択します。

50,000 ステップでのトレーニングに対応する胴体モデル「model_ckpt_steps_50000.ckpt」を選択します。

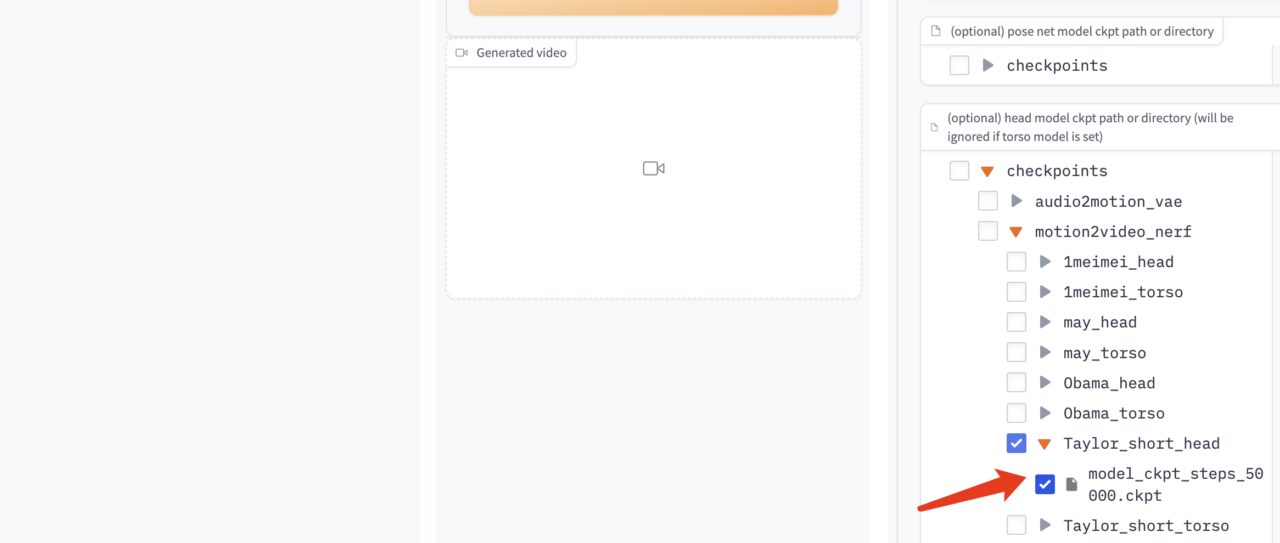

50,000 ステップ未満のトレーニングには、対応するヘッド モデル「model_ckpt_steps_50000.ckpt」を選択します。

4. 「生成」をクリックしてエフェクトを生成します。

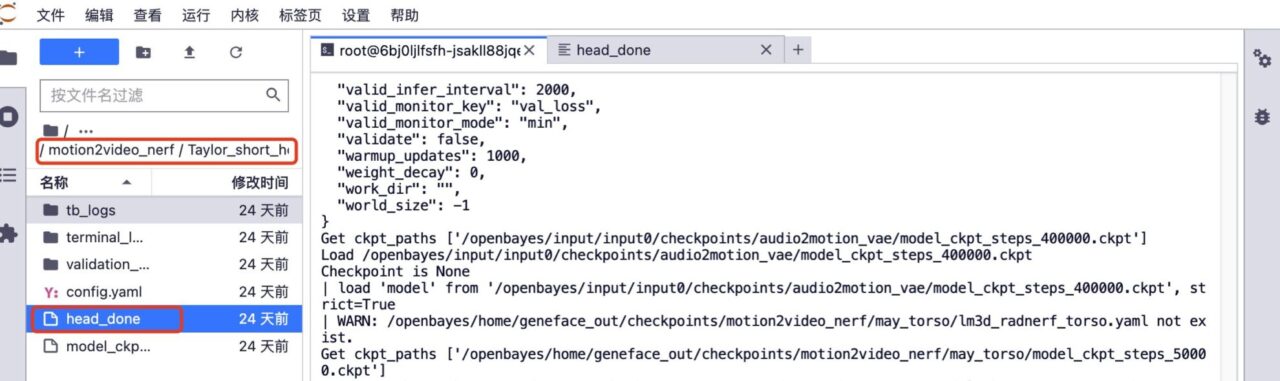

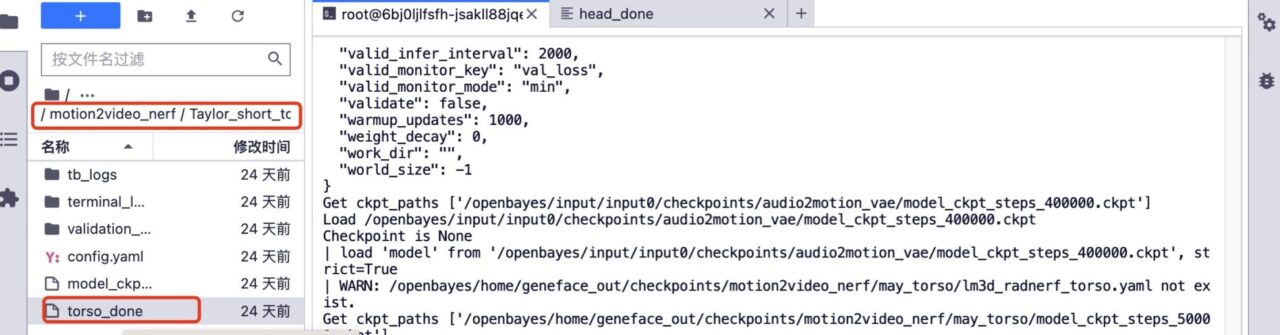

5. さらにトレーニングしたい場合。該当モデル配下のhead_doneフォルダとtorso_doneフォルダを削除します。

6. 以前のトレーニング ビデオをアップロードし、ビデオ ファイル名を変更せずに、トレーニング ステップの数を増やし、[トレーニング] をクリックしてトレーニングを開始します。

7. トレーニング後、GeneFace++ インターフェイスで、デフォルトのオーディオ ドライバー モデル、150,000 ステップでトレーニングされた対応する胴体モデル、および右側のモデルの 150,000 ステップでトレーニングされた対応する頭部モデルを選択します。 「生成」をクリックして最終的な効果を生成します。

現在、HyperAI 公式 Web サイトでは、Jupyter Notebook にまとめられた数百の厳選された機械学習関連のチュートリアルを公開しています。

リンクをクリックして、関連するチュートリアルとデータ セットを検索します。

以上が今回編集者が共有した内容ですので、ご参考になれば幸いです。他の楽しいチュートリアルを学びたい場合は、メッセージまたはプライベート メッセージを残してプロジェクトのアドレスをお知らせください。編集者が AI の遊び方を教えるコースをカスタマイズします。

参考文献:

https://blog.csdn.net/c9Yv2cf9I06K2A9E/article/details/128895215