Command Palette

Search for a command to run...

オンライン チュートリアル | ワンクリックで Sora オープンソースの置き換えを開始し、450,000 人の AI 開発者を獲得

1888年、エジソンは「キネトスコープ」と呼ばれる特許を提出しました。この装置は、初めて静止画を連続再生して動的な写真と同様の効果を生み出す装置であり、これによりビデオの開発が始まりました。

歴史を振り返ると、ビデオは白黒からカラーへ、そしてアナログ信号からデジタル信号へと、ゼロからの繰り返しを経てきました。かつての映像制作には、台本・脚本の作成、撮影、編集、アフレコ、校正といった複数の工程が必要でした。現在でも、ショートビデオ プラットフォームのヒットビデオから劇場で人気のある高額予算の映画に至るまで、すべてがこの長い一連の制作形式に従っています。

近年、生成AIの登場により、映像制作にもイノベーションが起きています。ChatGPT の誕生以来、テキスト理解における生成 AI の能力は繰り返し驚きをもたらしてきました。

OpenAIは2月26日、テキストの指示を受けて1分間の動画を生成できるSoraモデルをリリースした。長いテキストを理解する優れた能力を備えているだけでなく、現実世界の物理的状況を理解してシミュレートし、複数のキャラクターと特定の種類の動きを含む複雑なシーンを論理性とリアリズムの両方で生成することもできます。ただし、現時点では OpenAI は Sora モデルのデモビデオを公開しているだけであり、そのアクセスは少数の研究者やクリエイティブな人々にのみ許可されています。

同時に、誰もが無料で使用できるオープンソースの AI 生成ビデオ モデルが複数存在します。 Station B の人気新進気鋭の Jack-Cui 氏は、ビデオ チュートリアルの中で、現時点でより優れたオープンソース AI ビデオ生成ソリューションは、Stable Diffusion + Prompt Travel + AnimateDiff の組み合わせであると紹介しました。

このうち、Stable Diffusion は、元の高次元データ (画像など) をエンコーダを通じて潜在空間にマッピングし、その空間内で拡散とノイズ除去を行った後、デコーダを使用して変換します。潜在空間を浄化したデータを高次元空間に再構築し、最終的には、テキストの指示に基づいて、対応する静止画像が生成されます。

AI ビデオ生成分野における現在の主流の拡散モデルと比較して、安定拡散では追加のエンコード/デコード段階が導入されており、重要な情報が含まれる低レベル画像内の高次元データ (画像など) に適用できます。次元潜在空間で実行される元のデータの特徴。モデルの効率と生成品質が向上しました。

プロンプトトラベルは調整ですテキストコマンドこのようにして、ユーザーは創造的な意図に応じてビデオのさまざまなタイムラインにさまざまなキーワードや説明を提供することができ、AI モデルが一連の一貫した変化する画像を生成するように導きます。

最後に、AnimateDiff は新しく初期化されたモーションモデリングモジュール、ビデオ クリップ データ セットを使用して、合理的なモーションの事前知識をトレーニングします。モーション モジュールがトレーニングされると、ヴィンセント グラフ モデルに挿入され、多様でパーソナライズされたテキスト駆動のビデオ クリップを生成する機能がモデルに与えられます。

現在、モデル展開チュートリアルは HyperAI 公式 Web サイトにオンラインで公開されており、ワンクリックで複製できます。

https://hyper.ai/tutorials/30038

Station B の人気アップマン、Jack-Cui 氏が制作した「Stable-Diffusion Online Tutorial」は次のとおりです。このチュートリアルでは、AI ペイントと AI 生成のビデオを 1 つで遊ぶ方法をステップバイステップで説明します。クリック!

キングボム! AI 音声クローン + Sora オープンソース置換はワンクリックで開始でき、ネットワーク全体で最も簡単です。 _bilibili_ビリビリ

チュートリアルによると、エディターはさまざまな美しい写真やビデオを生成することに成功しており、その効果は驚くべきものです。

デモの実行

1. [このチュートリアルをオンラインで実行する] をクリックして OpenBayes に移動し、RTX 4090 を無料で受け取ります。

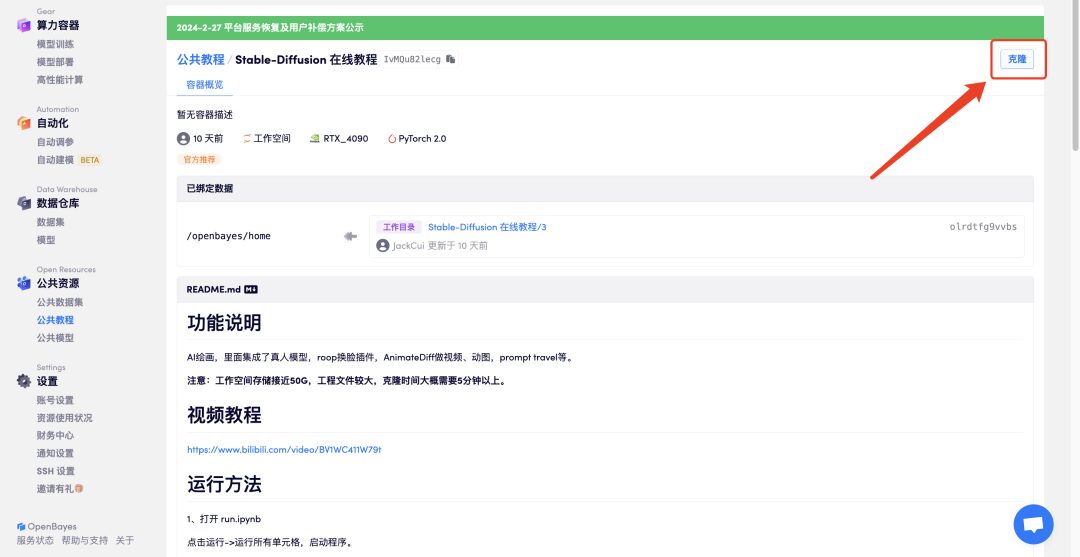

2. 右上隅の [クローン] をクリックして、このチュートリアルを独自のコンテナにクローンします。

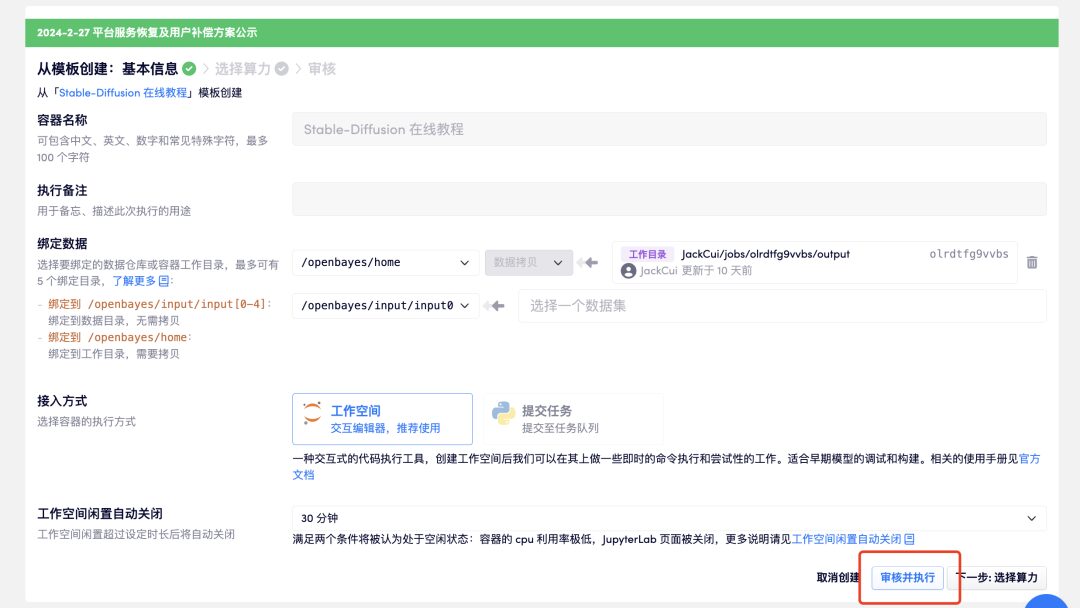

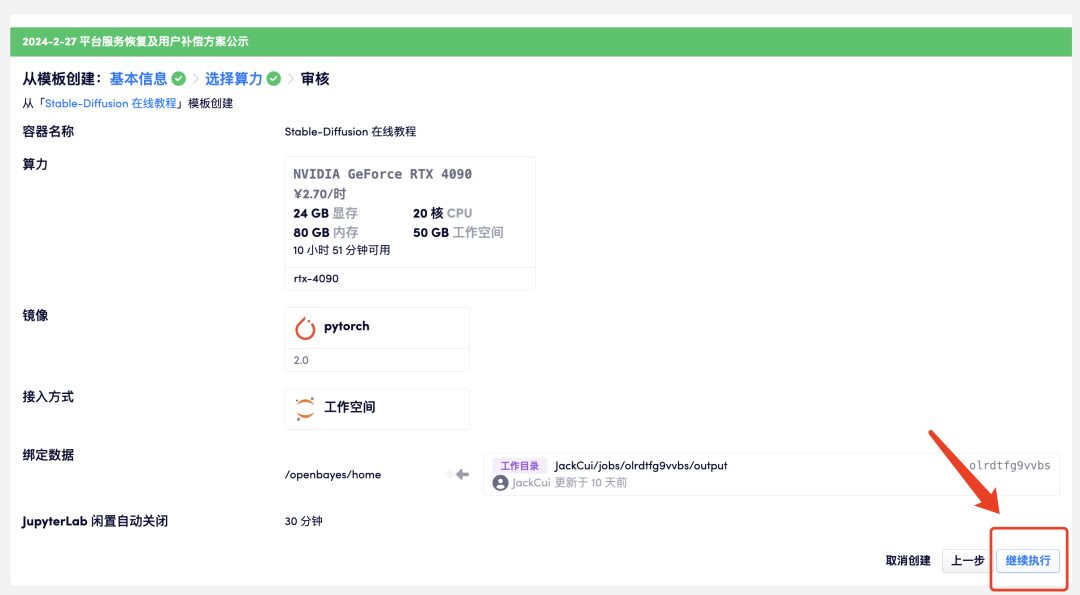

3. 「確認と実行」-「実行の続行」をクリックします。 RTX 4090 の使用をお勧めします。新規ユーザーは、下の招待リンクを使用して登録すると、4 時間の RTX 4090 + 5 時間の無料 CPU コンピューティング時間を取得できます。

招待リンク:

https://openbayes.com/console/signup?r=GraceXiii_W8qO

4. しばらく待ち、ステータスが「実行中」に変わったら、「ワークスペースを開く」をクリックします。コンテナには大量のデータが含まれています。初回起動には 8 ~ 10 分ほどかかります。しばらくお待ちください。

15 分以上「リソースの割り当て」状態が続く場合は、コンテナを停止して再起動してみてください。再起動しても問題が解決しない場合は、公式 Web サイトのプラットフォーム カスタマー サービスにお問い合わせください。

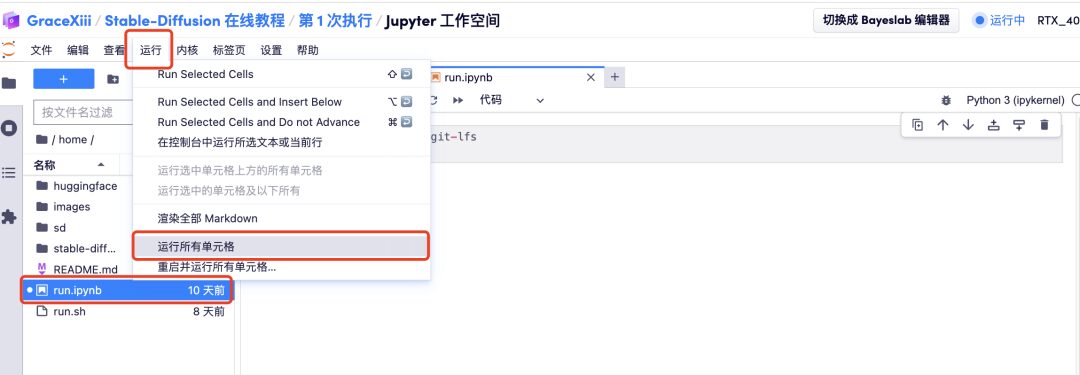

5. ワークスペースを開いたら、左側の「run.ipynb」をクリックし、メニューバーの「実行」ボタンから「すべてのセルを実行」をクリックします。

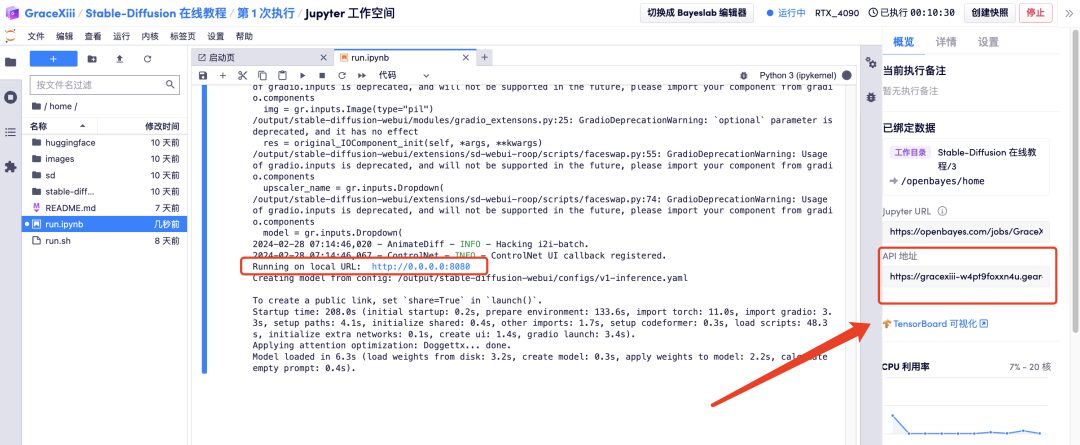

6. ローカル URL が生成されたら、右側の「API アドレス」を開きます。API アドレス アクセス機能を使用するには、事前に実名認証を受ける必要があることに注意してください。

エフェクト表示

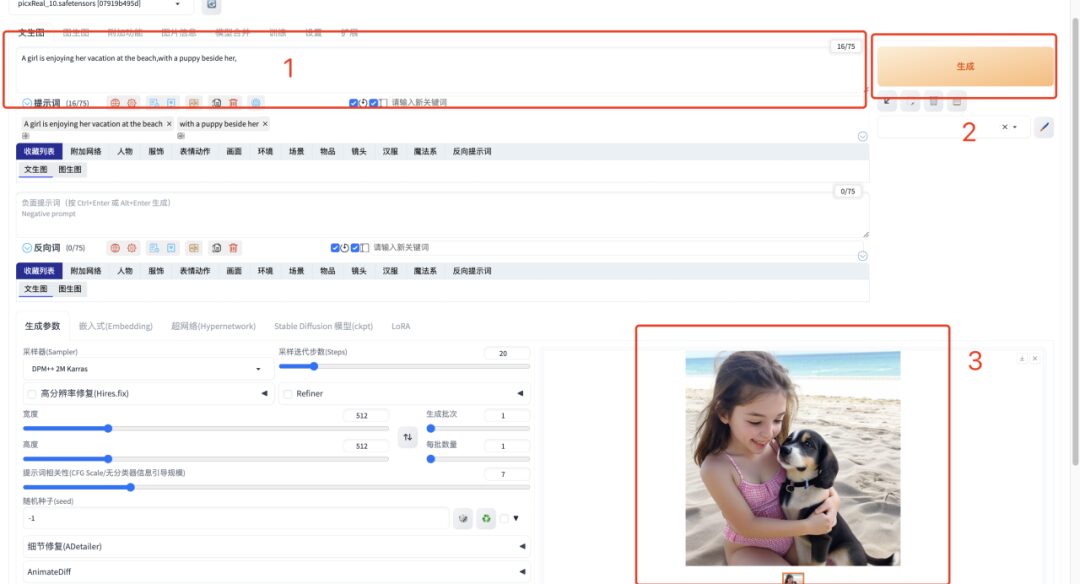

1. 「API アドレス」を開いた後、テキストボックスに英語のプロンプトワードを入力し、「生成」をクリックします。画像の生成には 1 秒しかかかりません。

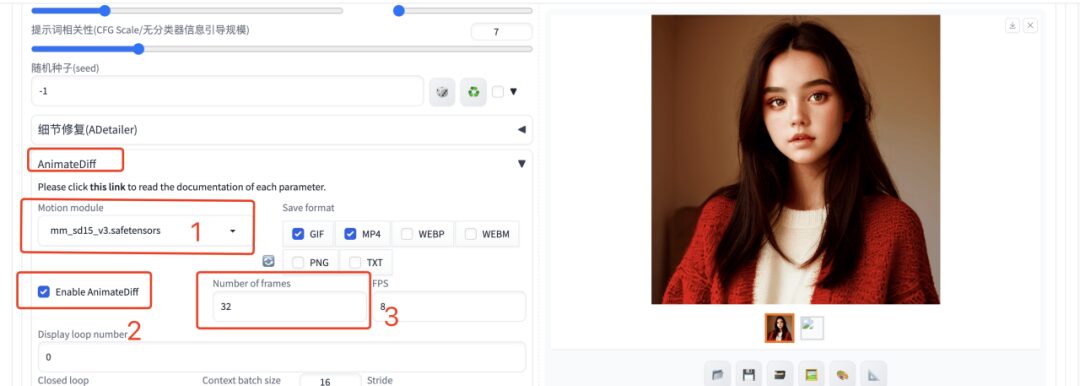

2. ビデオを生成する場合は、英語のプロンプト単語を入力した後、AnimateDiff プラグインを選択し、生成されるフレーム数を 32 フレームとして入力し、他のパラメータはデフォルトのままにする必要があります。アニメーションやビデオが生成されます。

現在、HyperAI 公式 Web サイトでは、Jupyter Notebook にまとめられた数百の厳選された機械学習関連のチュートリアルを公開しています。

リンクをクリックして、関連するチュートリアルとデータ セットを検索します。

以上が今回編集者が共有した内容ですので、ご参考になれば幸いです。他の楽しいチュートリアルを学びたい場合は、メッセージを残してプロジェクトのアドレスを教えてください。編集者が AI の遊び方を教えるコースをカスタマイズします。

参考文献:

1.https://zhuanlan.zhihu.com/p/627133524

2.https://fuxi.163.com/database/739

3.https://zhuanlan.zhihu.com/p/669814884