Command Palette

Search for a command to run...

GTC 2023 | 「革の剣士」Huang Renxun が語る AI トップ 5、科学技術コンピューティング、生成 AI、オムニバースがリスト入り

超神経質で

内容の概要:北京時間 3 月 21 日の 23 時、NVIDIA の創設者兼 CEO のジェンスン フアン氏は GTC 2023 で基調講演を行い、生成 AI、メタバース、大規模言語モデル、クラウド コンピューティングなどの分野における最新の開発について紹介しました。

キーワード:NVIDIA ジェンセン ファン GTC 2023

「AI におけるこの決定的瞬間を見逃すな」, 中国語で「AIの決定的瞬間を見逃すな」という意味です。北京時間2023年3月21日23時、GTC 2023で「革の剣士」黄焦珠氏が上記のテーマで基調講演を行い、こう述べた。 「これは私たちにとってこれまでで最も重要な GTC になります。」, Nvidiaの公式TwitterもこのGTCのAI Wave Top 5を公開しました、事実はどうなっているのでしょうか?今年のKeynoteの主要リリースを見てみましょう~ 検索画像を編集する

検索画像を編集する

AI ウェーブ トップ 5

キーワードの一つ:生成AI

生成 AI テクノロジーは、データを学習するための基本的なパターンと構造を提供し、画像、音声、コード、テキスト、3D モデルなどの新しいコンテンツを生成します。プロフェッショナルな生成 AI ツールはクリエイターの生産性を向上させ、テクノロジーに詳しくないユーザーにも利益をもたらします。 NVIDIA AI Foundations クラウド サービスと NVIDIA Piccasso は GTC 2023 で発表されました。

AI テクノロジーは 3D コンテンツ作成に革命をもたらしています。GTC 2023 では、Jensen Huang 氏は、生成 AI の分野における Omniverse Audio2Face アプリケーションの新バージョンの登場を発表しました。

検索画像を編集する オムニバース Audio2Face エフェクト

検索画像を編集する オムニバース Audio2Face エフェクト

Omniverse Audio2Face は人工知能を応用して、3D アーティストがオーディオ ファイルからリアルな顔のアニメーションを迅速に作成できるようにし、時間と労力のかかる手動プロセスを回避します。 Audio2Face では、リップシンク品質の向上、より強力な多言語サポート、新しい事前トレーニング済みモデルとともに、標準中国語のサポートをプレビューできるようになりました。

製薬業界向けの第 1 世代生成 AI スーパーコンピューティング システムが発売される

日本の三井物産は、NVIDIA DGX をベースとしたスーパーコンピューティング システムである Tokyo-1 の創設を発表しました。 Tokyo-1 は、製薬業界向けの世界初の生成 AI スーパーコンピューティング システムであり、分子動力学シミュレーションと生成 AI モデルの探索に使用されます。このプロジェクトは2023年後半に稼働する予定で、三井物産の子会社であるゼウレカ社が運営する。ゼウレカ社は、日本人が直面している医薬品開発の遅れという長年の問題を変えるために東京1を利用したいと考えている。製薬業界。

Tokyo-1 は NVIDIA DGX H100 をベースにしており、第 1 フェーズには 16 台の NVIDIA DGX H100 システムが含まれており、それぞれに 8 個の NVIDIA H100 Tensor コア GPU が搭載されています。 Xeurekaは今後もシステム規模を拡大し、日本の関連業界の顧客向けにノード接続機能を提供し、分子動力学シミュレーション、大規模言語モデルトレーニング、量子化学、新薬候補の革新的な分子構造のAI生成などを提供していきます。同時に、Tokyo-1 のユーザーも NVIDIA BioNeMo を通じて創薬とサービスを提供できます。

キーワード2:デジタルバイオロジー

NVIDIA は、タンパク質と治療、ゲノミクス、化学、生物学、分子動力学の分野での研究を加速するために、AI 基本モデルをカスタマイズする一連の生成 AI クラウド サービスをリリースしました。

生成 AI モデルは、潜在的な薬物分子を迅速に特定し、場合によっては化合物やタンパク質ベースの治療法をゼロから設計できます。これらのモデルは、小分子、タンパク質、DNA、RNA 配列の大規模データセットでトレーニングすることにより、タンパク質の三次元構造と、分子が標的タンパク質とドッキングする程度を予測できます。 検索画像を編集する

検索画像を編集する

新しい BioNeMo™ クラウド サービスは、AI モデルのトレーニングと推論をターゲットとしており、医薬品開発を加速します。これにより、研究者は自身のデータに基づいて生成 AI アプリケーションを微調整し、AI モデル推論をブラウザーで直接実行したり、新しいクラウド API を通じて既存のアプリケーションに簡単に統合したりすることができます。

BioNeMo クラウド サービスには、研究者が医薬品開発用の AI パイプラインを作成するのに役立つ事前トレーニングされた AI モデルが含まれており、現在、Evozyne や Insilico Medicine などのバイオ医薬品企業が医薬品設計に使用しています。

BioNeMo サービスに接続された新しい生成 AI モデルには次のものがあります。

* MegaMolBART生成化学モデル

* ESM1nv タンパク質言語モデル

* OpenFoldタンパク質構造予測モデル

※AlphaFold2タンパク質構造予測モデル

* 分子ドッキングのための DiffDock 拡散生成モデル

※ESMFoldタンパク質構造予測モデル

* ESM2タンパク質言語モデル

* MoFlow 生成化学モデル

* 新しいタンパク質配列を生成するための ProtGPT-2 言語モデル

キーワード 3: 履歴書

CV-CUDA は、クラウド コンピューター ビジョン用のオープンソース GPU アクセラレーション ライブラリであり、企業が GPU 上でエンドツーエンドの AI ベースのコンピューター ビジョンおよび画像処理パイプラインを構築および拡張できるように設計されています。 検索画像を編集する

検索画像を編集する

Microsoft の Bing ビジュアル検索エンジンは、AI コンピューター ビジョンを使用して Web 上の画像を検索します

(写真は写真でドッグフードを探している様子)

CV-CUDA は、前処理ステップと後処理ステップを CPU から GPU に移動するため、クラウド コンピューティングの 4 分の 1 のコストで、同じワークロードに対して単一の GPU で 4 倍のストリームを処理します。

CV-CUDA ライブラリは、開発者に 30 を超える高性能コンピュータ ビジョン アルゴリズムを提供します。ネイティブ Python API と、PyTorch、TensorFlow2、ONNX、TensorRT などの機械学習フレームワークとのゼロコピー統合が含まれており、クラウド AI 運用と比較して、より高いスループット、より低いコンピューティング コスト、より小さな二酸化炭素排出量を実現します。

CV-CUDA alpha のリリース以来、500 社以上の企業が 100 以上のユースケースを作成しました。

キーワード 4: 自律型マシン

2021 年、NVIDIA は、企業にリアルタイム データに適応する機能を提供するリアルタイム ルート最適化ソフトウェア cuOpt を提案しました。 cuOpt は、1 秒あたり数十億の実行可能な移動を分析することで配送ルートを最適化します。

cuOpt は現在、システム インテグレーターおよびサービス プロバイダー、物流および輸送ソフトウェア ベンダー、最適化ソフトウェアの専門家、位置情報サービス プロバイダーを含む、繁栄しているパートナー エコシステムの中心となっています。 cuOpt は、ルート効率を測定するために Li と Lim が提案した一連の集配問題ベンチマークである Li & Lim 集配ベンチマークで 3 つの記録を樹立しました。

検索画像を編集する

検索画像を編集する

Li & Lim ベンチマークでは、研究者たちは 20 年前に最適なルートを計画し、世界で最も有名なソリューションを設定およびリセットするアルゴリズムを発明し、以前の勝者は以前のルート調整の小さな改善に焦点を当てていました。 cuOpt によって作成されたルートは、以前の勝者によって作成されたルートとは異なります。 cuOpt は、ベンチマークで以前に記録された改善と比較して 7.2 倍の改善、以前の記録破りの結果と比較して 26.6 倍の改善を提供します。

キーワード5: 会話型AI

さまざまな業界の企業が、インタラクティブなアバターを使用してデジタル エクスペリエンスを向上させることを検討しています。しかし、それらの作成は複雑で時間のかかるプロセスであり、ユーザーが見て、聞いて、理解し、コミュニケーションできる高度な人工知能モデルの適用が必要です。 検索画像を編集する

検索画像を編集する

このプロセスを簡素化するには、NVIDIA は、Omniverse Avatar Cloud Engine (ACE) を通じて開発者にリアルタイムの人工知能ソリューションを提供します。これは、インタラクティブなアバターのエンドツーエンド開発のためのクラウドネイティブのマイクロサービス スイートです。 NVIDIA は、ユーザーに必要なツールを提供するために継続的に改善を行っています。インタラクティブなチャットボットからインテリジェントなデジタル ヒューマンに至るまで、アバターを簡単に設計して導入できます。

AT&T は、Omniverse ACE と Tokkio AI アバター ワークフローを使用して、カスタマー サービスと従業員のヘルプ デスク用の仮想アシスタントを構築、カスタマイズ、展開することを計画しています。 AT&T は、NVIDIA のサービス提供パートナーの 1 つである Quantiphi と協力して、地域全体で現地の言語で 24 時間年中無休のサポートを提供できる対話型アバターを開発しています。これにより、企業はコストを削減しながら、世界中の従業員により良いエクスペリエンスを提供できます。 AT&T は、顧客サービスに加えて、同社のさまざまなユースケースに対応するデジタル ヒューマンを構築および開発する予定です。

今回の GTC 2023 では、基調講演で流れた上記 5 つのキーワードに加えて、他にも注目すべき点があります。黄仁勲氏「オンラインで商品を提供」 グレース スーパーチップ スーパーチップ。

Grace CPU: エネルギー節約への道を開く

実際のテストでは、Grace CPU スーパーチップは、主要なデータセンター CPU アプリケーションの同じエンベロープ下で x86 プロセッサよりも 2 倍優れたパフォーマンスを示し、データセンターがピーク トラフィックの 2 倍を処理できるか、電気代を半分に削減できることを示しています。

3 つの主要な CPU イノベーション:

* シングル ダイでは、Grace CPU は超高速ファブリックを使用して 72 Arm Neoverse V2 コアに接続し、標準スループットであるファブリック帯域幅 3.2TB/s を実現します。

* NVIDIA NVLink-C2C インターコネクトを使用して 2 つのチップをスーパーチップ パッケージに接続し、900 GB/秒の帯域幅を提供します。

* Grace CPU は、サーバー グレードの LPDDR5X メモリを使用する最初のデータセンター CPU です。これにより、同様のコストで最大 50% のメモリ帯域幅が提供されますが、コンパクトなサイズで一般的なサーバー メモリの 1/8 の能力と、一般的なカードベースのメモリ設計の 2 倍の密度を実現します。 検索画像を編集する

検索画像を編集する

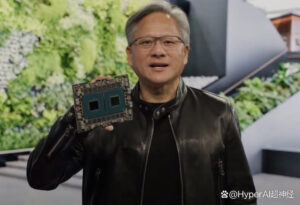

Lao Huang ライブ ディスプレイ グレース・スーパーチップ

テストの結果、データセンターで同じ消費電力を使用する主要な x86 CPU と比較して、Grace CPU は次の点を備えています。

* マイクロサービスの速度は 2.3 倍に向上します。

* メモリを大量に消費するデータ処理速度が 2 倍に向上しました。

* 数値流体力学の速度が 1.9 倍向上しました。

NVIDIA: AI 世界のエンジン

昨年末以来、ChatGPT は開始されるやいなや、生成 AI と大規模言語モデルを最前線に押し上げてきました。Huang Renxun 氏の見解では、ChatGPT は次の分野への扉を開きました。 AIの「iPhoneモーメント」、しかし今日の基調講演生放送で彼も認めた 「生成 AI の優れた機能により、企業は自社の製品とビジネス モデルを再考する必要性を感じています。」NVIDIA は、AI のトレーニングから展開、半導体からソフトウェア ライブラリ、システムからクラウド サービスに至るまで、多次元のブレークスルーを達成し始めていることがわかります。

現在、グローバルな NVIDIA エコシステムは、NVIDIA Inception の 400 万人の開発者、40,000 の企業、および 14,000 のスタートアップをカバーしています。GTC 2023 の前夜に CNBS のインタビューで Jen-Hsun Huang 氏が語ったように、NVIDIA はそのような企業になりたいと考えています。

私たちの活動のおかげで、かろうじて可能だったものを実現したり、非常にエネルギーを消費するものや非常にエネルギー効率の高いものを作ったり、多額の費用がかかるものを変えてより手頃な価格にしたりすることができます。

- 以上 -