Command Palette

Search for a command to run...

GPT-4 はマルチモダリティを目指しています。Google PaLM-E は以前から存在していましたが、AI の状況は変わるのでしょうか?

内容の概要:GPT-4 は、3 月 14 日にテクノロジー界全体を爆発させた核爆弾のようなものでした。この核爆発の中心部では、待望の GPT-4 がその筋肉を収縮させていましたが、一方、核爆発の周縁部では、Google やその他の神々が熱心に監視し、絶え間なく動き続けていました。

東部時間3月14日OpenAI は大規模マルチモーダル モデル GPT-4 を発表します。 GPT-4 は、ChatGPT および Bing AI チャットボットを支える技術基盤です。 OpenAIによると、GPT-4は画像とテキストの入出力を受け入れ、テキストコンテンツを出力できるが、その機能は現実世界の多くのシナリオにおいて人間ほど優れていないという。しかし、さまざまな専門的および学術的なベンチマークで人間のパフォーマンスを示してきました。

GPT-4 奇襲着陸:注目の 3 つの大きな特徴

GPT-4 のこのアップデートには主に 3 つの新機能があり、大幅に改善されました。テキスト入力制限の改善、画像認識機能、および推論能力の強化。

より長く、より充実したコンテンツ

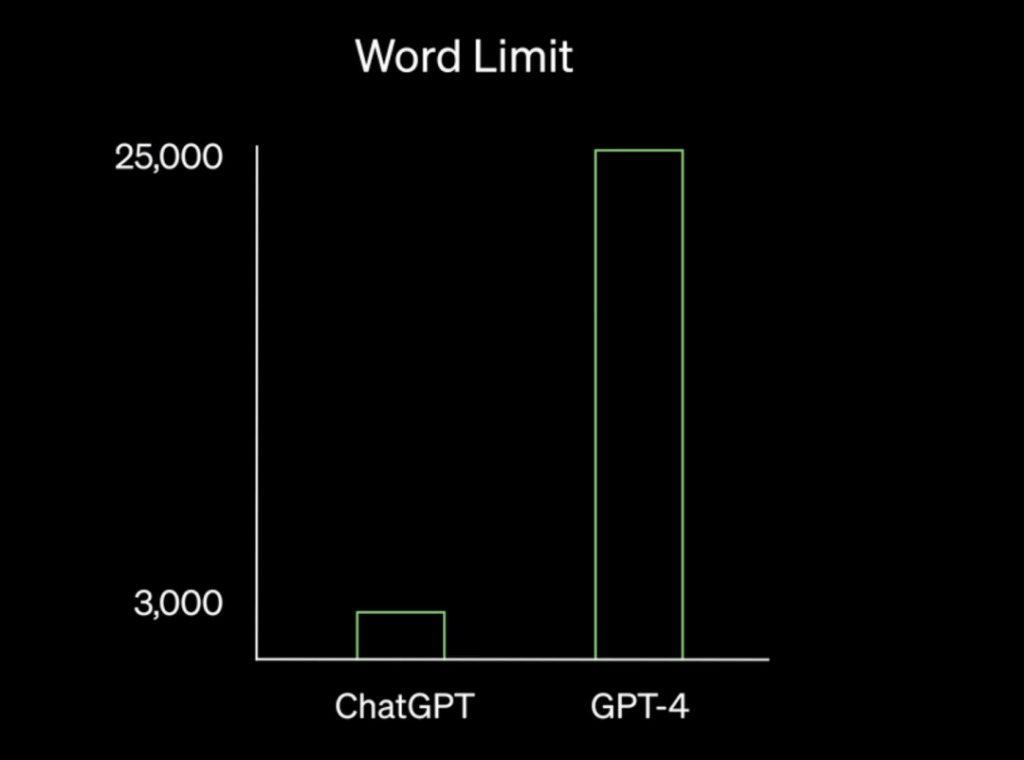

OpenAIによると、GPT-4 は 25,000 ワードを超えるテキストを処理できます。 Mediumライターのマイケル・キング氏は、この機能により記事やブログなどの長文コンテンツの作成が可能になり、企業や個人の時間とリソースが節約できると述べた。

さらに、GPT-4 による大量のテキストの処理により、会話の延長が可能になります。つまり、接客業などの業界では、AI チャットボットが顧客の質問に対してより詳細で洞察力に富んだ応答を提供できるようになります。この機能により、文書の効率的な検索と分析も可能になり、金融、法律、医療などの業界にとって有益なツールになります。

さらなる推理力

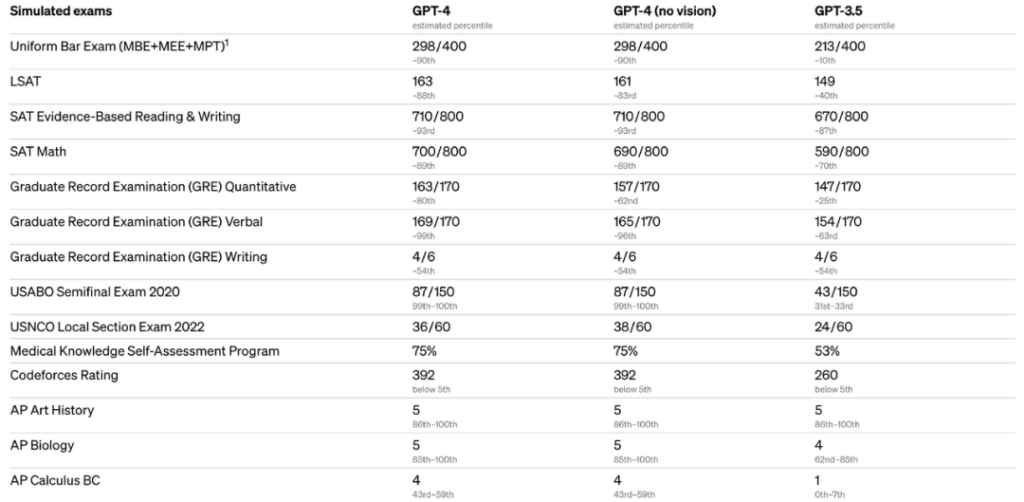

OpenAI は、GPT-4 は GPT-3.5 よりもエラーが少なく、40% より正確な回答を生成すると述べました。同時に、チャットする場合、GPT-3.5 と GPT-4 に大きな違いはありませんが、タスクが十分に複雑な場合、GPT-4 は GPT-3.5 よりも信頼性が高く、より創造的で、より微妙な指示を処理できます。 GPT-4 はさまざまなベンチマーク テストに参加したことが報告されています。その中でも、統一司法試験やLSATなどの試験では、88%受験者よりも高いスコアを獲得しています。

目を引く新機能: マルチモダリティ

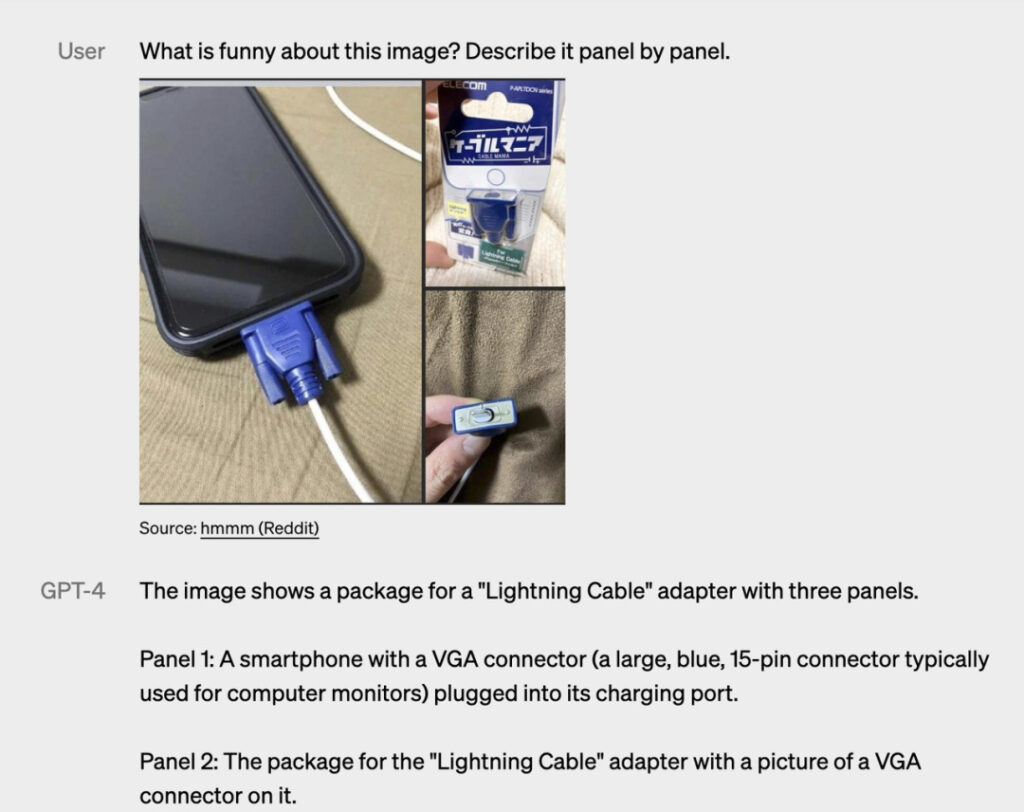

質問にうまく答えることができるだけでなく、GPT-4 のもう 1 つの優れた特徴は、テキストと画像の形式で入力を受け入れることができることです。画像の種類には、写真、グラフ、スクリーンショットなどがあります。例えば:

質問: この写真のどこがおかしいのか、項目ごとに説明してください。

GPT-4 回答: この画像は、3 つの画像を含む「Lightning Cable」アダプターを示しています。

図 1: VGA コネクタ (コンピュータのモニタで一般的に使用される大きな青色の 15 ピン コネクタ) が充電ポートに接続されたスマートフォン。

図 2: VGA コネクタの写真が記載された「Lightning Cable」アダプタのパッケージ。

図 3: VGA コネクタの拡大図。最後は小さな Lightning コネクタ (iPhone およびその他の Apple デバイスの充電に使用) で終わります。

この画像のユーモアは、大型の時代遅れの VGA コネクタを、小型の最新のスマートフォンの充電ポートに差し込むという不条理から生まれています。

この機能はまだ研究者のプレビュー バージョンにあることに注意してください。外の世界に対しては開かれていません。OpenAIはオープン時期を明らかにしていない。

「完璧ではない」

GPT-4 の新機能を導入する一方で、OpenAI はその限界の一部も認めました。 GPT の以前のバージョンと同様に、GPT-4 には、社会的偏見、幻覚、敵対的プロンプトなどの問題が依然として残っています。つまり、現時点では GPT-4 は完璧ではありません。しかしOpenAIはまた、これらは解決に向けて懸命に取り組んでいる問題であるとも述べた。

マルチモーダル モデル: Google が最初に「前菜」を提供

マルチモダリティは GPT-4 の目を引く機能ですが、次のことは言わなければなりません。マルチモーダル モデルは GPT-4 だけではありません。

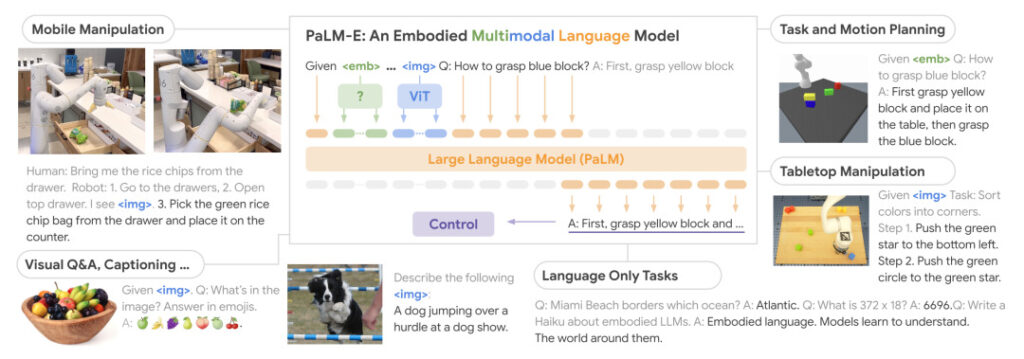

Microsoft AI 技術専門家 Holger Kenn 氏は、いわゆるマルチモーダル モデルを導入しました。これは、テキストを画像に適切に変換するだけでなく、音声やビデオにも変換できます。そして今月初めには、Google が史上最大のビジュアル言語モデル PaLM-E (Pathways Language Model with Embodied) をリリースしました、ロボット工学用の組み込みマルチモーダル言語モデル。 PalM-E は 540B PaLM 言語モデルと 22B ViT ビジュアル モデルを統合しているため、562B のパラメータがあります。

研究者らは、ロボットの操作ルール、視覚的な質問応答、画像キャプションなどの複数のタスクについてエンドツーエンドのトレーニングを実施しました。その評価結果では、モデルがさまざまな推論タスクを効果的に解決でき、さまざまな観察モダリティや物理的に複数の機能を備えていることがわかりました。は「ポジティブな伝達」を実証し、ロボットタスクでトレーニングされたことに加えて、このモデルは視覚言語タスクでも優れたパフォーマンスを発揮しました。

この例では、人間が「引き出しの中のポテトチップスを持ってきて」と命令すると、PaLM-Eはロボットアームを備えたロボットの動作コマンドを生成し、ロボットのカメラからのデータを解析して動作を実行することができます。シーンを前処理せずに実装されます。

ロボットに上記の機能を与えることに加えて、PaLM-E 自体も視覚言語モデルでもあり、写真を見てストーリーを伝えたり、写真の内容に基づいて質問に答えたりすることができます。

マルチモーダルモデルは「iPhone」リリースに相当するのでしょうか?

現在、AI 分野全体で軍拡競争が本格化しているように思えます。 ChatGPTの人気に直面して、Googleは最近、それに歩調を合わせるためにBardを緊急リリースし、独自の大規模言語モデルAPI「PaLM API」をオープンし、開発者がAIプログラムを迅速に構築するのに役立つツールであるMakerSuiteもリリースした。

OpenAI CEO のサム・アルトマン氏は、つい最近のインタビューで GPT-4 のリリース時期について依然として謎を残しており、「リリースする際には、それが安全で責任あるものであることを確認したい」と主張していましたが、この GPT-4 の驚きの波は、グーグルのような巨人による絶え間ない反撃と包囲がそのペースを加速させているためではないかと人々が推測するのは避けられない。

サムはインタビューの中で次の点にも言及していることに注意してください。人工知能の次の進化段階は、大規模なマルチモーダル モデルの到来です。「これは大きなトレンドになると思います...より一般的には、これらの強力なモデルは、モバイル プラットフォーム以来存在しなかった真に新しいテクノロジー プラットフォームの 1 つになるでしょう。」

GPT-4 のこのメジャー リリースがマルチモーダル モデル時代の正式な到来を示すものであるかどうかを証明するには時間がかかりますが、その強力な機能により、多くの開発者や一般の人々さえも、GPT-4 に取って代わられるのではないかと心配し始めています。この点については、おそらく、マイクロソフト ドイツの CEO、マリアンヌ ヤニク氏の数日前の公の場での発言が答えになるかもしれません。彼女は、現在の AI の発展は当時の「iPhone の出現」に似ていると信じています。それを明らかにするそれは仕事を置き換えることではなく、反復的なタスクを以前とは異なる方法で完了することです。

「変化は従来のワークモデルに変化をもたらしますが、この変化によって多くの新たな可能性が追加され、したがってエキサイティングな新しいキャリアも出現することも理解する必要があります。」

参考リンク:

[1]https://openai.com/research/gpt-4

[2]https://venturebeat.com/ai/openai-releases-highly-anticipated-gpt-4-model-in-surprise-payment/

[3]https://palm-e.github.io/

[4]https://medium.com/@neonforge