一定の科学リテラシーを備えた若者の観点からは、これらの見出しはクリックするまでもなく噂や誇張であることが知られていますが、これらの記事は親世代の WeChat グループやモーメントで毎日激しく拡散されています。

仮想世界では、ニュースの出所や信憑性を判断するのが難しく、特に親にとっては、記事が複雑な科学知識や馴染みのない科学機関に言及している限り、あるいは愛国的感情や感傷的な感情を煽るものであれば、噂される可能性が高くなります。混乱も拡大の一因となっている。

多くのプラットフォームは、噂を反論するメカニズムを確立するために最善を尽くしています。これまで、このメカニズムは主に苦情 + 手動レビューで構成されていましたが、手動形式ではまだ不十分です。

同じもの世界も同じ噂

この問題は米国でも発生しており、中国で一般的に話されている「噂」は英語で「Rumor」と訳されることが多く、より厳密な報道機関では「False Rumor」と訳されることもあります。つまりデマです。

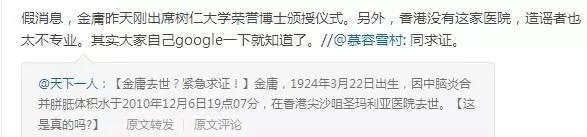

興味深いことに、どの種類の噂が広く広まる可能性が最も高いかを比較したいと考えた場合、世界中の噂作成者が有名人の死亡ニュースを選んだことがわかりました。

AI を使用してニュースを純化する

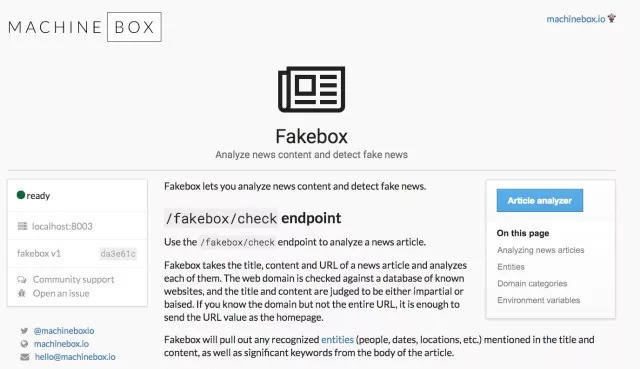

米国では、エンジニアのアーロン・エデル氏が AI による「FakeBox フェイクニュース検出器」を完成させました。精度は比較的高いものの、これらのコンテンツは第一に英語の文脈での中国のシステムには適していません。実際に商用利用されていますが、まだ改善の余地がたくさんあります。しかし、彼の研究プロセスは、同様の研究に従事する専門家にとって間違いなく非常に参考になるでしょう。

「FakeBox Fake News Detector」の設計プロセスは順風満帆ではありませんでしたが、その成功における最も重要なターニングポイントは、目的をフェイクニュースの判断から本物のニュースの判断に変更したことでした。真実は常に同じですが、幻想は多様です。 。

FakeBox を設計する際の彼の考えは次のとおりです。

最初の質問: フェイクニュースをどう定義するか

私が最初に直面した困難は、さらに予想外のものでした。いくつかのフェイク ニュースを調査したところ、すべてのフェイク ニュースがフェイクであるわけではなく、一部のニュースは誇張されており、一部のニュースは検証されていないことがわかりました。実際、フェイクニュースは、明らかな誤り、真実と虚偽の混合、完全な疑似科学、フェイクニュースの解説など、さまざまなタイプに分類する必要があります。

したがって、フェイクニュースは徹底的に選別され、一つ一つ排除されなければなりません。

最初の実験: 感情分析モデルを使用して問題を解決する

最初は、クローラーを使用して記事のタイトル、説明、著者、内容を取得し、結果を感情分析モデルに送信する小さなツールを自分で作成しました。私はテキストボックスを使用しました。これは結果をすぐにフィードバックでき、非常に便利です。各記事について、Textbox はスコアをフィードバックします。5 を超えるスコアは肯定的なフィードバックであり、5 未満のスコアは否定的なフィードバックです。また、テキストのタイトル、内容、著者などのスコアを個別に計算し、それらを合計してスコアが総合的かつ総合的であることを保証する小さなアルゴリズムも作成しました。

最初はうまくいきましたが、7 番目か 8 番目の記事をテストした後はうまくいきませんでした。しかし、このプロトタイプのデザインは、私が想像していた噂探知システムに非常に近いものでした。

しかし結果は失敗でした。

2 番目の実験: NLP モデルを使用して問題を解決する

私の友人の David Hernandez は、テキスト自体でモデルをトレーニングすることを勧めました。私は、Web サイトのソースや作成者名などのフェイク ニュースの特徴を理解し、モデルをトレーニングするためのデータセットをすぐに構築できるかどうかを確認しようとしていました。

私たちは数日間にわたってさまざまな種類のデータセットを多数収集しましたが、そのすべてがモデルのトレーニングに役立つと思われました。データ セットは十分な大きさであると考えましたが、実際には、データ セットの内容は最初から正しく分類されていませんでした。「偽」または「誤解を招く」とマークされた一部の Web サイトには、本物の記事が含まれていたり、単に他の記事を転送したりする場合があるためです。ウェブサイトのコンテンツのため、結果は理想的ではありません。

私はすべての記事を個人的に読み始め、データを処理するのに長い時間を費やしましたが、このプロセスは非常に困難でしたが、最近のこれらの誤った、悪意のある、さらには暴力的なニュースを見ると、インターネットが生み出した文明に疑問を抱くようになりました。また、より多くの人がより良いツールを使用して、風評被害を避けることができるようになることを願っています。データセットの人によるレビューに介入した後、テストで約 70% の精度を達成しました。

しかし、この方法には致命的な欠点があり、データセット外の記事をランダムにチェックしてみたところ、情報の真偽を正しく判断できませんでした。

それで、やはり失敗しました。

3 番目の実験: データセットとしてのフェイクニュースを探すのではなく、本物のニュースを探す

この問題の成功のターニングポイントは、私を目覚めさせた David からの提案でした。精度を向上させる鍵は問題を単純化することかもしれないという提案でした。おそらく、私たちがしなければならないのは、フェイク ニュースを検出するのではなく、本物のニュースを検出することです。なぜなら、本物のニュースは分類しやすいからです。記事はすべて事実と重要なポイントであり、冗長な説明はほとんどなく、ニュースの信頼性を確認するためのリソースが豊富にあります。そこで再びデータを集め始めました。

私はニュースを現実と非現実の 2 つのラベルに分けているだけです。 虚偽には、風刺、意見記事、フェイクニュース、および純粋に事実に基づいて書かれていないその他の記事が含まれます。

今度は成功し、精度は 95% を超えました。

Fakebox という名前のモデルは、各記事にスコアを付けます。スコアが非常に低い場合、その記事はフェイク、解説、風刺、またはその他のものである可能性があります。また、Fakebox には REST API もあり、あらゆる環境に統合でき、Docker にデプロイすることもできます。

しかし、それでも欠点はあります。記事が短すぎたり、他人の意見や引用が中心だったりすると、真偽の判断が難しくなる可能性があります。

したがって、Fakebox は最終的な解決策ではありませんが、 アーロン・エデル このモデルが真と偽を区別する必要がある記事に役立つことを願っています。