Google 2018 の冒頭で、Sundar Pichai 氏は、診断と治療、音声とビデオの処理に参加するために人工知能を使用する Google の能力を簡単に紹介し、予想通り、カンファレンス全体の C ポジションを TPU に譲りました。この Google は深い目的のために構築されました。学習 テンソル プロセッサは、人工知能の分野における Google の最も強力な武器となっています。

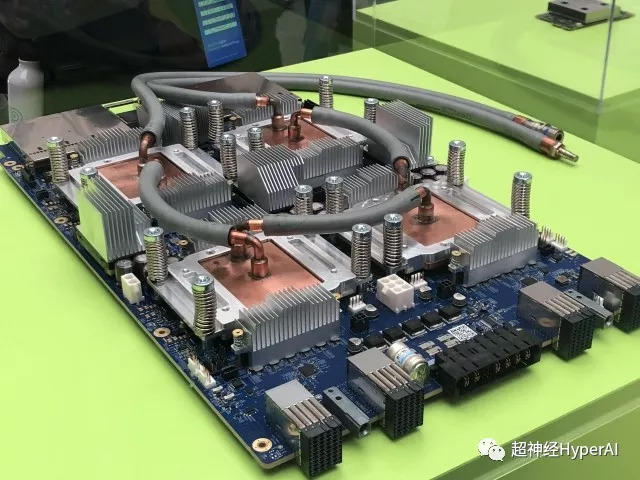

TPUv3 のパフォーマンスは、昨年リリースされたもののまだ一般には公開されていない TPUv2 に比べて大幅に向上しています。そのピーク値はバージョン 2.0 の 8 倍です。パフォーマンスの向上には代償も伴いますが、発熱量が増加したため、エンジニアはラジエーターを真鍮の導管に交換する必要がありました。ご想像のとおり、Sundar Pichai 氏も、この世代の TPU の冷却ソリューションは液体冷却であると認めました。

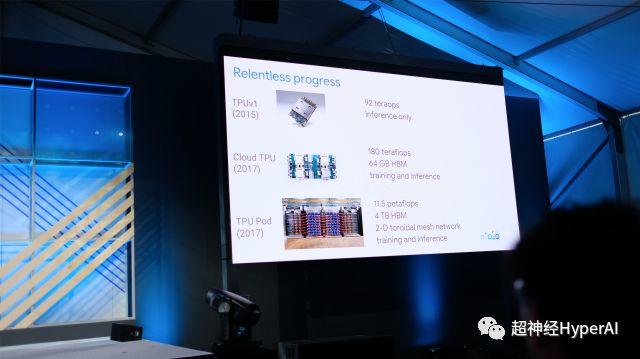

TPUv2 は、180Tflops のピーク計算能力と 64GB HBM キャッシュを備えており、第 1 世代の TPU と比較してトレーニング機能が向上しています。分科会セッションで TPU テーマについて講演した Zak Stone 氏は、Tensor2Tensor を使用した複数のモデル トレーニング プロセスをデモンストレーションし、そのパフォーマンスは確かに非常に満足のいくものでした。会議後の Zak Stone への質問で、Super Neuron は、他の開発フレームワークに対する TPU の適応性について尋ねましたが、残念なことに、TPU は TensorFlow 関連のツール チェーンのみをサポートしており、Pytorch を含む他の開発フレームワークはサポートしていません。サポートが提供されます。 Zak はまた、オープンソース プロジェクト Tensor2Tensor が非常に急速に進歩していると述べました (非常に素晴らしい)。

同じ支店の Google エンジニアであるフランク・チェン氏は SuperNeural に対し、TPU の 3.0 バージョンでは消費電力が「わずかに増加」していると同時に、コンピュータ ルーム内の TPU ポッド間の通信に高い電力が使用されていると語った。最適化されたケーブルは、Infinity Band などの光ファイバー ソリューションではありません。帯域幅とキャッシュが十分に提供されるため、クラスター全体の機能が向上しますが、当然、エネルギー消費にもある程度の負担がかかります。今年中に開発者にバージョン 3.0 へのアクセスを提供できるかと尋ねると、同氏は不自然な笑みを浮かべて「そうなることを願っています」と答えた。

こんにちは。まだ遅延がないサービスはどれですか? しかし、ちょっと待ってください。3.0 をすぐに使用できない場合、TPUv2 はクォータを申請する必要がなくなるのはいつですか?ザック・ストーン氏は、オフィスに戻るとすぐに、レビュー申請を待っているすべての開発者に電子メールが送信され、サービスの使用許可が得られると述べた。

さて、ザックが前を向いて走り、できるだけ早く自分の机に戻ることを楽しみにしましょう。

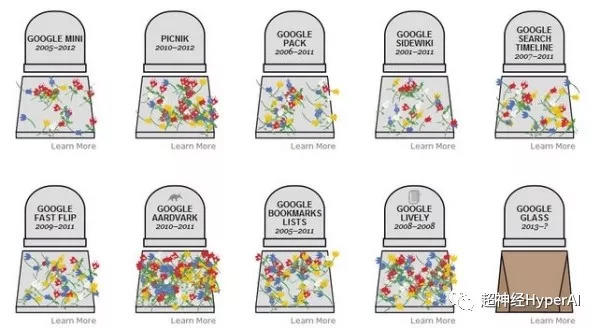

歴史記事(画像をクリックするとご覧いただけます)

「Google I/O、通称「プログラマーのための春祭り」

どのような大物キラーが解放されましたか? 》

「優秀な頭脳を持った日本人はAIに本気で取り組むつもりすらない」

「Google I/Oで発表された大ヒット商品の内訳」》