Command Palette

Search for a command to run...

Huake チームが OVIS オクルージョン ビデオ インスタンス セグメンテーション ベンチマーク データ セットをリリース

インスタンスのセグメンテーションは、コンピューター ビジョンの分野における重要な研究の方向性として、さまざまなアプリケーション シナリオで広く使用できますが、同時に難しく、挑戦的なものでもあります。多くのシーンでは、オクルージョンが原因で、インスタンスのセグメンテーションが困難な問題になります。最近、華中大学、アリババ、その他の機関の研究者は、この問題を解決するために大規模なオクルージョン ビデオ インスタンス セグメンテーション データ セット OVIS を提案しました。

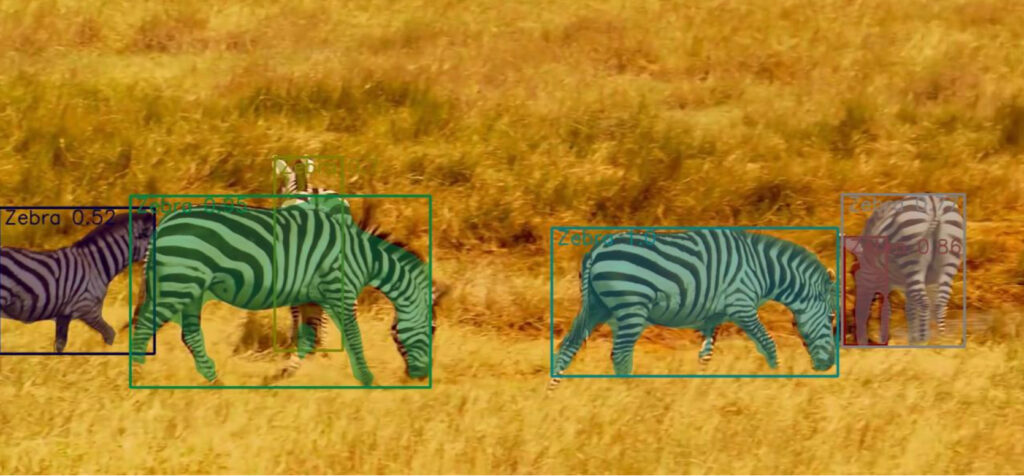

コンピュータ ビジョンでは、ターゲットの検出が中心的な問題です。ターゲットの検出では、インスタンスのセグメンテーションが最も困難なタスクの 1 つとみなされます。インスタンスのセグメンテーションは、ターゲットの検出に基づいてオブジェクトのピクセルをセグメント化することです。

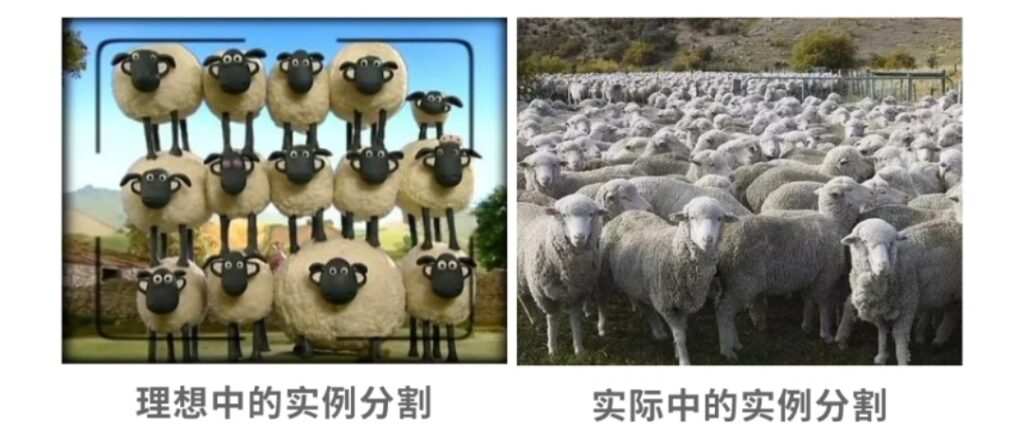

オブジェクトは相互にブロックし合うことが多く、エンジニアにとっては頭痛の種となっています。私たち人間は、遮蔽されたオブジェクトを見ると、経験や連想に基づいてそれらを識別できます。

では、コンピュータービジョンでは、人間のような遮蔽されたオブジェクトを正確に識別できるのでしょうか?インスタンス セグメンテーションの研究課題では、オクルージョンによって引き起こされる干渉を解決することが常に重要な研究方向でした。

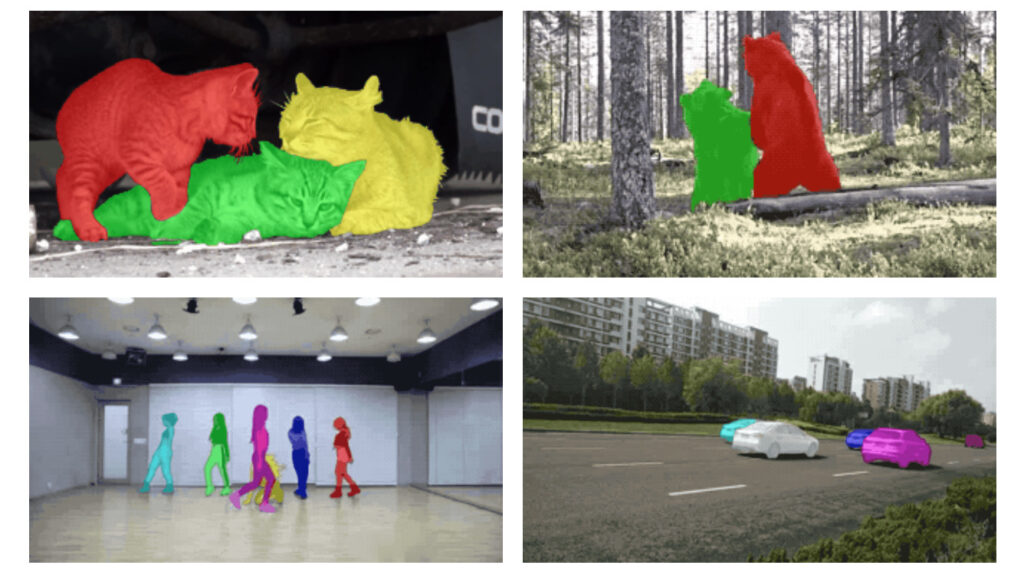

この困難を解決するために、華中科学技術大学、アリババ、コーネル大学、ジョンズ・ホプキンス大学、オックスフォード大学のチームが、遮蔽されたビデオ インスタンス セグメンテーションのための大規模なデータセットである OVIS (Occluded Video Instance Segmentation) が収集され、これを使用して遮蔽されたシーン内のインスタンスを同時に検出、セグメント化、追跡することができます。

これは、Google の YouTube-VIS データセットに次ぐ 2 番目の大規模なオクルージョン ビデオ インスタンス セグメンテーション データセットです。

OVIS: 901 件のひどく隠蔽されたビデオから誕生

私たちが普段見ているものすべてにおいて、単独で現れる物体はほとんどなく、すべてが多かれ少なかれブロックされています。しかし、研究によると、人間の視覚システムでは、オクルージョン下でもターゲット オブジェクトの実際の境界を区別できることがわかっていますが、コンピュータ ビジョン システムにとっては、オクルージョン ビデオのセグメンテーションの問題が大きな問題となっています。インスタンス。

この問題をさらに調査して解決するために、Huake、Alibaba、その他の機関のチームは、オリジナルのオープンソース インスタンス セグメンテーション アルゴリズムに基づいて、より優れたモデルの開発を試みました。

この作業を達成するために、チームはまず、オクルージョン シーンでのビデオ インスタンスのセグメンテーション用に特別に設計された OVIS データセットを収集しました。最近出版された論文で《遮蔽されたビデオインスタンスのセグメンテーション》で、このデータセットについて詳しく説明します。

論文アドレス: https://arxiv.org/pdf/2102.01558.pdf

このデータセットを収集するには、チームは合計 10,000 件近くのビデオを収集し、最終的に、深刻なオクルージョン、動きの多い、複雑なシーンを含む 901 個のクリップを選択しました。各ビデオには、少なくとも 2 つのターゲット オブジェクトが互いにブロックされていました。

ほとんどのビデオの解像度は 1920×1080、長さは 5 秒から 60 秒です。彼らは、5 フレームごとに 1 フレームの密度で高品質のアノテーションを実行し、最終的に OVIS データセットを取得しました。

OVIS には、5,223 個のターゲット オブジェクトの合計 296,000 個の高品質マスク アノテーションが含まれています。以前の Google Youtube-VIS データセットの 4883 個のターゲット オブジェクトと 131k のマスク アノテーションと比較して、OVIS には明らかにより多くのターゲット オブジェクトとマスク アノテーションがあります。

ただし、OVIS が実際に使用するビデオは YouTube-VIS よりも少ないです。これは、チームの哲学が長期追跡機能のために長いビデオを好むためです。 OVIS の平均ビデオ継続時間と平均インスタンス継続時間はそれぞれ 12.77 秒と 10.55 秒で、これに対応して、YouTube-VIS の 2 つのパラメータはそれぞれ 4.63 秒と 4.47 秒です。

遮蔽されたビデオ インスタンスをセグメント化するタスクをより困難にするために、チームは一定数のビデオ セグメントを犠牲にして、より長く複雑なビデオに注釈を付けました。

OVIS データ セットには、生活の中で一般的な合計 25 のカテゴリが含まれています。以下の図に示すように、特定のカテゴリには、人、魚、乗り物、馬、羊、シマウマ、ウサギ、鳥、家禽、象、オートバイ、犬、猿、ボート、カメ、猫、牛、オウム、自転車、キリンが含まれます。 、トラ、ジャイアントパンダ、飛行機、クマ、トカゲ。

これらのカテゴリは、次の 3 つの主な考慮事項に基づいて選択されました。

- これらのターゲットは動いていることが多く、深刻な閉塞が発生する傾向があります。

- それらは人生においてよくあることです。

- これらのカテゴリは、現在普及している大規模な画像インスタンス セグメンテーション データ セット (MS COCO、LVIS、Pascal VOC など) との重複が高く、研究者がモデルを移行してデータを再利用するのに便利です。

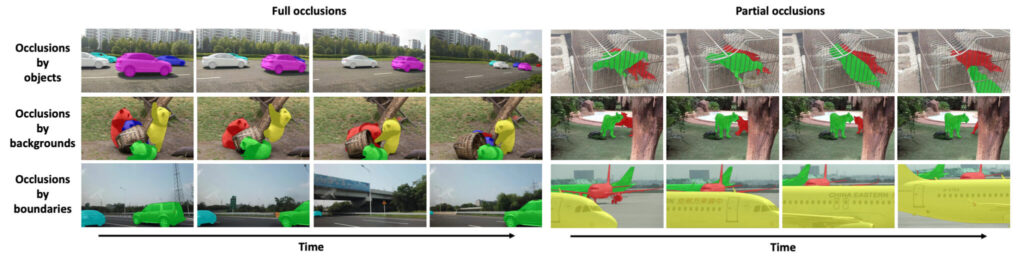

他の以前の VIS データセットと比較すると、OVIS データ セットの最も顕著な特徴は、オブジェクトの大部分がさまざまな要因によりひどく遮蔽されていることです。したがって、OVIS は、深刻なオクルージョンを処理する際のビデオ インスタンス セグメンテーション モデルを評価するための効果的なテストベッドです。

オクルージョンの重症度を定量化するために、チームはオクルージョンの程度を大まかに反映する指標平均境界ボックス オーバーラップ レート (mBOR) を提案しました。 mBOR は、画像内の重複する境界ボックスの面積とすべての境界ボックスの面積の比率を指します。パラメータ比較リストからわかるように、OVIS は YouTube-VIS よりも深刻なオクルージョンを持っています。

OVIS データセットの詳細は次のとおりです。

遮蔽されたビデオインスタンスのセグメンテーション

オクルージョン ビデオ インスタンス セグメンテーション データセット

データソース:《遮蔽されたビデオインスタンスのセグメンテーション》

含まれる数量:5223 個のターゲット オブジェクト、296k マスク

種類数:25種

データ形式:フレーム: jpg 注釈: Json

ビデオ解像度:1920×1080 データサイズ:12.7GB

ダウンロードアドレス:https://orion.hyper.ai/datasets/14585

OVIS はビデオ インスタンスのセグメンテーションに対してより高いベンチマークを設定します

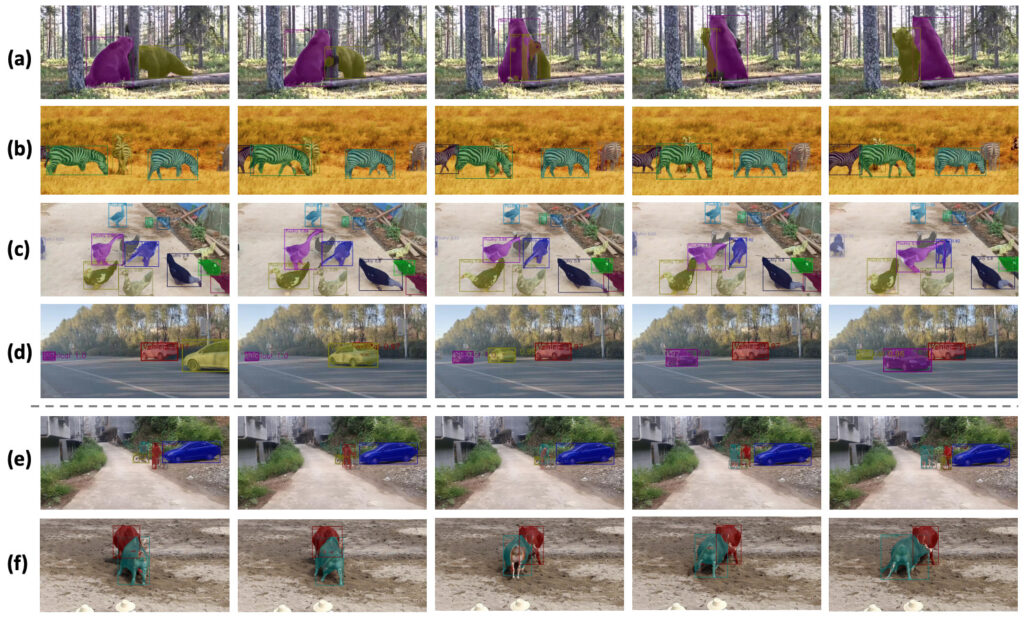

OVIS データセットは、607 個のトレーニング ビデオ、140 個の検証ビデオ、および 154 個のテスト ビデオにランダムに分割されます。チームは、OVIS 上の 5 つの既存のオープンソース ビデオ インスタンス セグメンテーション アルゴリズムの包括的な評価を実施しました。これは、OVIS データ セットのベースライン パフォーマンスのベンチマーク テストでもありました。

評価結果を以下の表に示します。

YouTube0-VIS と比較して、FEELVOS、IoUTracker+、MaskTrack R-CNN、SipMask、STEM-Seg の 5 つのアルゴリズムのパフォーマンスは、OVIS 上で少なくとも 50% 低下しました。たとえば、SipMask の AP は 32.5 から 12.1 に低下し、STem-Seg の AP は 30.6 から 14.4 に低下しました。これらの結果は、研究者に、ビデオ インスタンスのセグメンテーションの問題にさらに注意を払う必要があることを思い出させます。

さらに、チームはキャリブレーション モジュールを使用することで、オリジナルのアルゴリズムに基づいてパフォーマンスを大幅に向上させました。開発した CMaskTrack R-CNN の AP は、オリジナル アルゴリズムの MaskTrack R-CNN の 12.6 から 15.2 に比べて 2.6 向上しており、CSipMask は SipMask の 12.1 から 15.0 に比べ 2.9 向上しています。

上図(c)では、アヒルが密集しているシーンにおいて、研究チームの手法はほぼ正確にすべてのアヒルを検出・追跡できましたが、2フレーム目の左端のアヒルの検出に失敗しました。しかし、アヒルは後続のフレームで再追跡され、チームのモデルが時間的手がかりをうまく捉えていたことが証明されました。

チームはさらに、提案された CMaskTrack R-CNN および CSipMask アルゴリズムを YouTube-VIS データセットで評価しました。元の方法と比較して、結果は AP の元の方法を上回りました。

将来のアプリケーション: ビデオ パノラマ セグメンテーション、合成オクルージョン データ

研究チームは、OVIS で一般的に使用されるビデオ セグメンテーション アルゴリズムのベースライン パフォーマンスは YouTube-VIS のパフォーマンスよりもはるかに低いため、研究者は将来、遮蔽されたビデオ オブジェクトの処理により多くのエネルギーを投資する必要があると述べています。

さらに、チームは、時間的コンテキストの手がかりを使用してオクルージョン問題を解決する方法を検討し、将来的には、教師なし、半教師あり、またはインタラクティブな設定でのビデオ オブジェクト セグメンテーション シナリオにおける OVIS の実験軌跡を形式化する予定です。さらに、OVIS をビデオ パノラマ セグメンテーションに拡張することも重要です (注: ビデオ パノラマ セグメンテーションは、背景のセマンティック セグメンテーションと前景のインスタンス セグメンテーションを同時に実現します。これは、インスタンス セグメンテーションの分野における最近の傾向です)。

さらに、合成オクルージョン データも、チームがさらに調査する必要がある方向性です。チームは、OVIS データセットが、複雑で多様なシナリオにおけるビデオを理解するためのさらなる研究のきっかけとなるだろうとの信念を表明しました。

この技術は将来、映画やテレビの特殊効果、ショートビデオ、生放送などでキャラクターと背景を分離する際に重要な役割を果たすことになるでしょう。

参考文献:

論文アドレス: https://arxiv.org/pdf/2102.01558.pdf

プロジェクト公式サイト:http://songbai.site/ovis/

Google YouTube-VIS データセット: