Command Palette

Search for a command to run...

MMVP マルチモーダル モーション キャプチャ データセット

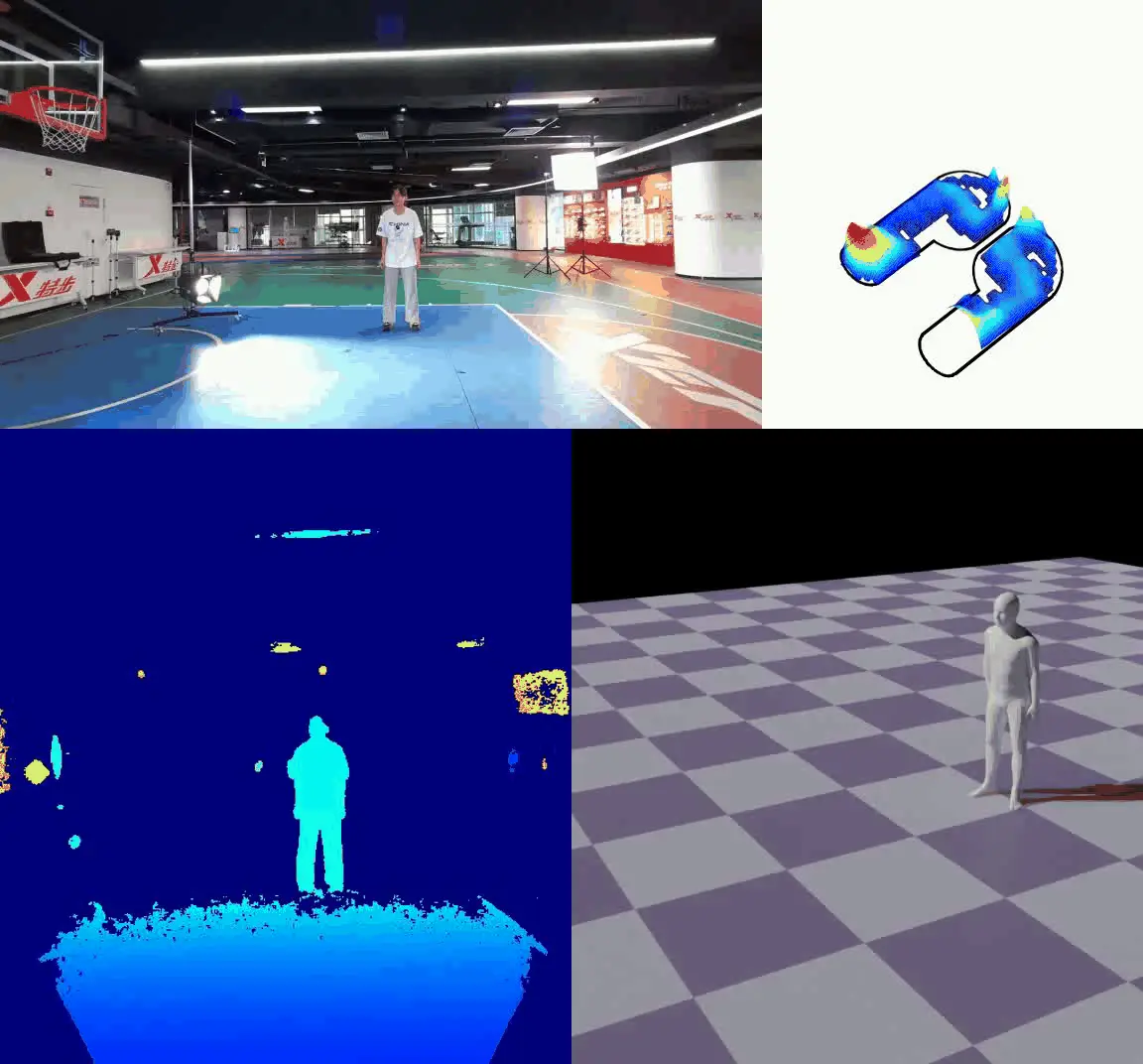

MMVP (Multimodal MoCap Dataset with Vision and Pressure Sensors) は、北杭大学、清華大学、南京大学が共同開発した視覚センサーと圧力センサーを組み合わせたマルチモーダル モーション キャプチャ データセットです。

このデータセットには、走る、スキップする、立ち幅跳びなど、大規模で素早い人間の動きが多く含まれており、合計 44,000 を超える同期 RGBD フレームと 16 人の被験者の圧力データが収集されました。研究者らは、Azure Kinect カメラを使用して RGBD ビデオを 30 フレーム/秒の頻度で記録し、Xsensor 圧力インソールを使用して最大 150 フレーム/秒の速度で足底圧データをキャプチャし、2 つのデータ ストリームを手動で同期しました。 FPP-Net や CLIFF などのディープラーニング アルゴリズムを組み合わせることで、データの詳細な処理と分析が可能になります。このデータセットは、視覚センサーと圧力センサーに基づくヒューマン モーション キャプチャ研究に新しいデータ リソースを提供し、この分野の進歩を促進できます。

説明する: MMVP (マルチモーダル ビジョン パターン) ベンチマークは、「CLIP ブラインド ペア」、つまり視覚的に明らかな違いがあるにもかかわらず CLIP が類似しているとみなす画像の識別に焦点を当てています。 MMVP は、9 つの基本的なビジョン モードにわたって、GPT-4V を含む最先端システムのパフォーマンスをベンチマークします。これは、単純な質問に答える際にこれらのシステムが直面し、しばしば誤った応答や幻想的な解釈につながるという課題を浮き彫りにしています。

- コンテンツタイプ: 画像(CLIP-ブラインドペア)

- 量: 300枚の写真

- データソース: ImageNet-1k と LAION-Aesthetics より

- データ収集方法: 比較分析を通じて CLIP ブラインド ペアを特定する