Command Palette

Search for a command to run...

Jusqu'à 20 Fois Plus Efficace ! L'Université De Californie Développe OmniCast Pour Résoudre Le Problème De l'accumulation d'erreurs Dans Les Modèles Autorégressifs De Prévision météorologique.

Les prévisions météorologiques sub-saisonnières à saisonnières (S2S) se situent entre les prévisions météorologiques à court terme et les prévisions climatiques à long terme, en se concentrant sur l'évolution du temps au cours des deux à six prochaines semaines. Elles comblent avec précision les lacunes des prévisions météorologiques à moyen et long terme, fournissant des informations cruciales pour la planification agricole et la prévention des catastrophes. Cependant, les prévisions S2S peinent à exploiter les informations atmosphériques initiales qui se dégradent rapidement (conditions de prévision à court et moyen terme) et ne parviennent pas non plus à saisir les signaux aux limites qui évoluent lentement et qui ne sont pas encore pleinement apparents (conditions de prévision climatique). La difficulté de prévision augmente considérablement en présence de systèmes atmosphériques chaotiques et d'interactions terre-mer complexes.

Ces dernières années, les évolutions technologiques des systèmes traditionnels de prévision numérique du temps (PNT) vers les méthodes de prévision météorologique basées sur l'apprentissage profond ont joué un rôle déterminant dans le développement de la prévision météorologique S2S. Cependant, de nombreux défis subsistent quant à l'application pratique de la S2S. Par exemple, les méthodes numériques traditionnelles reposent principalement sur la résolution d'équations physiques complexes, ce qui est non seulement coûteux en ressources de calcul, mais aussi très chronophage.Alors que les méthodes basées sur les données permettent d'obtenir rapidité, exactitude et précision dans les prévisions à court terme, les approches basées sur un modèle autorégressif calculent l'étape suivante en fonction des résultats de la prévision précédente.Dans les applications S2S à plus long terme, l'erreur s'accumule comme une boule de neige, tout en ignorant le signal de forçage de limite crucial à variation lente dans les prévisions météorologiques S2S.

Pour remédier à ce problème, une équipe de l'UCLA, en collaboration avec le Laboratoire national d'Argonne, a proposé OmniCast, un nouveau modèle de diffusion latente pour la prévision météorologique probabiliste S2S de haute précision. Ce modèle combine un auto-encodeur variationnel (VAE) et un modèle Transformer, utilisant une approche d'échantillonnage conjointe dans le temps et l'espace.Elle permet d'atténuer considérablement le problème d'accumulation d'erreurs des méthodes autorégressives, tout en étant capable d'apprendre la dynamique météorologique au-delà des conditions initiales.Les expériences ont démontré que le modèle offre les meilleures performances parmi les méthodes actuelles en termes de précision, de cohérence physique et de métriques probabilistes.

Les recherches connexes, intitulées « OmniCast : un modèle de diffusion latente masqué pour les prévisions météorologiques à différentes échelles de temps », ont été sélectionnées pour NeurIPS 2025, une conférence académique de premier plan en IA.

Points saillants de la recherche :

En prenant simultanément en compte les dimensions spatio-temporelles pour générer les prévisions météorologiques futures, OmniCast résout le problème de l'accumulation des erreurs dans les modèles basés sur des schémas autorégressifs.

OmniCast peut prendre simultanément en compte les informations atmosphériques initiales nécessaires aux prévisions météorologiques à court terme et les conditions de forçage aux limites à variation lente nécessaires aux prévisions climatiques.

OmniCast surpasse les méthodes existantes en termes de précision, de cohérence physique et de prédiction probabiliste, et sa vitesse de calcul est 10 à 20 fois plus rapide que les méthodes courantes actuelles.

Adresse du document :

Autres articles sur les frontières de l'IA :

https://hyper.ai/papers

Jeu de données : Basé sur le jeu de données ERA5 largement utilisé, adapté à différentes tâches de prédiction.

Afin de garantir qu'OmniCast bénéficie d'un soutien adéquat et pertinent en matière de formation et d'évaluation, l'étude a adopté comme source de données de base l'ensemble de données de réanalyse haute résolution ERA5, largement utilisé en météorologie. Un prétraitement des données a été effectué pour deux tâches de prévision différentes : la prévision météorologique à moyen terme et la prévision S2S (Stream-to-Sea), afin de constituer un ensemble de référence adapté aux exigences de chaque tâche.

Spécifiquement,L'étude a d'abord extrait 69 variables météorologiques de l'ensemble de données de réanalyse ERA5.Il couvre deux grandes catégories d'indicateurs clés :

Variables au sol (4 catégories) :Température de l'air à 2 mètres (T2m), composante de vitesse du vent U à 10 mètres (U10), composante de vitesse du vent V à 10 mètres (V10) et pression moyenne au niveau de la mer (MSLP) ;

Variables atmosphériques (5 catégories) :Hauteur géopotentielle (Z), température de l'air (T), composantes U et V de la vitesse du vent, et humidité spécifique (Q). Les variables atmosphériques couvrent 13 couches de pression (unité : hPa), à savoir 50, 100, 150, 200, 250, 300, 400, 500, 600, 700, 850, 925 et 1000.

Par la suite, pour différentes tâches de prévision, l'étude a divisé les données en ensembles d'entraînement, de validation et de test en fonction de la plage temporelle :

Tâche de prévision météorologique à moyen terme :WeatherBench2 (WB2) a été utilisé comme ensemble de tests de référence.L'ensemble d'entraînement couvre la période de 1979 à 2018, l'ensemble de validation l'année 2019 et l'ensemble de test l'année 2020. Les conditions initiales utilisent les données de 00:00 et 12:00 (UTC). La résolution est la résolution native de 0,25° (grille de 721 x 1440 points).

Tâche de prévision météorologique S2S : ChaosBench est utilisé comme jeu de données de référence. L’ensemble d’entraînement couvre la période de 1979 à 2020, l’ensemble de validation la période à partir de 2021 et l’ensemble de test la période à partir de 2022. Les conditions initiales utilisent les données de 00:00 (UTC). La résolution est de 1,40625° (grille de 128 × 256 points).

Modèle OmniCast : une conception en deux étapes pour un nouveau paradigme de prévision météorologique S2S

La principale force d'OmniCast réside dans sa capacité à éviter le problème d'accumulation d'erreurs des modèles autorégressifs traditionnels, ce qui lui permet de prendre en compte les exigences des prévisions météorologiques à court terme et des prévisions climatiques à long terme, offrant ainsi un outil utilisable et fiable pour l'application pratique des prévisions météorologiques S2S. L'architecture de base du modèle SeasonCast repose sur une conception en « deux phases ».Tout d'abord, la réduction de la dimensionnalité des données est réalisée à l'aide d'un VAE, puis la génération de séries temporelles est réalisée à l'aide d'un Transformer avec une tête de diffusion.

Le module principal de la première phase est un VAE implémenté à l'aide de l'architecture UNet.Sa fonction principale est la « réduction de dimensionnalité » et la « reconstruction », compressant les données météorologiques brutes de haute dimension en jetons latents continus de faible dimension (vecteurs de caractéristiques latentes), ce qui réduit les problèmes d'efficacité de calcul liés au grand nombre de variables et à la haute résolution spatiale. Le VAE possède 69 canaux d'entrée/sortie, correspondant à 69 variables météorologiques. Par exemple, dans une tâche de prévision météorologique S2S, l'encodeur VAE peut compresser des données météorologiques brutes de taille 69 × 128 × 256 en une projection latente de taille 1024 × 8 × 16, atteignant un taux de compression de dimensionnalité spatiale de 16. Lors de la génération, le VAE restaure ensuite les jetons latents produits par le Transformer pour obtenir les données météorologiques dimensionnelles originales (telles que la température et la pression atmosphérique).

Il convient de noter que l'étude a utilisé un VAE continu plutôt qu'un VAE discret. En effet, les VAE discrets présentent des problèmes tels que des taux de compression excessivement élevés et une perte d'information importante due au grand nombre de variables météorologiques, ce qui peut nuire aux performances de la modélisation générative de la seconde étape. Les VAE continus, quant à eux, ont un taux de compression de seulement 100, ce qui permet de conserver davantage d'informations météorologiques essentielles pour des conditions météorologiques pouvant comporter des centaines de variables physiques.

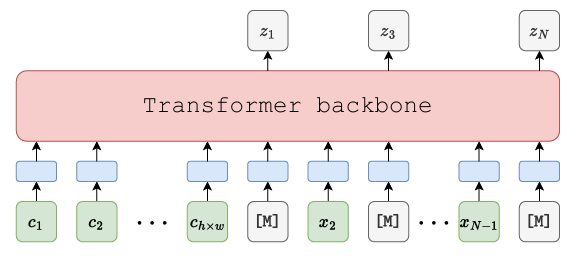

Le module principal du deuxième étage est le transformateur générateur de masque (comme illustré dans la figure ci-dessous).Une architecture encodeur-décodeur à auto-encodeur masqué (MAE) est employée. Elle est essentielle pour obtenir une génération cumulative sans erreur, modélisant directement les jetons latents de la séquence complète future grâce à l'apprentissage du masque et à la prédiction par diffusion. Structurellement, une architecture encodeur-décodeur bidirectionnelle est utilisée, permettant la prédiction simultanée de la partie masquée à partir des conditions initiales et des jetons visibles déjà générés. L'architecture Transformer comprend un réseau à 16 couches, chacune dotée de 16 nœuds d'attention, une couche cachée de dimension 1024 et un taux d'abandon de 0,1.

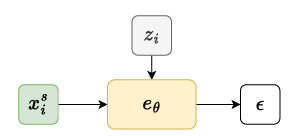

De plus, comme les jetons latents sont des vecteurs continus, les modules de classification traditionnels ne peuvent pas modéliser leur distribution. Par conséquent, un module de diffusion (une petite implémentation MLP) est connecté après la sortie du Transformer pour prédire la distribution des jetons latents dans le masque (comme illustré dans la figure ci-dessous).

Pour améliorer la précision des prévisions à court terme, l'étude a également introduit une perte d'erreur quadratique moyenne auxiliaire. Plus précisément,Dans les prévisions météorologiques à court terme,Étant donné que le caractère chaotique du système météorologique s'accentuera considérablement après 10 jours, l'importance des prévisions déterministes diminuera progressivement. En ajoutant un en-tête déterministe MLP supplémentaire, il est possible de calculer l'erreur quadratique moyenne (MSE) pour les jetons latents des 10 premières trames. De plus, l'adoption d'une stratégie de pondération à décroissance exponentielle permet de souligner l'importance d'une prévision précise dans les premières trames.

Présentation des résultats : Comparée à deux autres méthodes, l’efficacité est 10 à 20 fois supérieure à celle du modèle de référence.

Pour vérifier l'efficacité et les progrès d'OmniCast,Les chercheurs l'ont comparée à deux méthodes courantes.Une catégorie regroupe les méthodes d'apprentissage profond de pointe, et l'autre les méthodes numériques basées sur des modèles physiques traditionnels. Comme mentionné précédemment, la vérification expérimentale comprenait deux tâches : la prévision météorologique à moyen terme et la prévision météorologique S2S. Les indicateurs d'analyse incluaient la précision, la cohérence physique et la performance probabiliste.

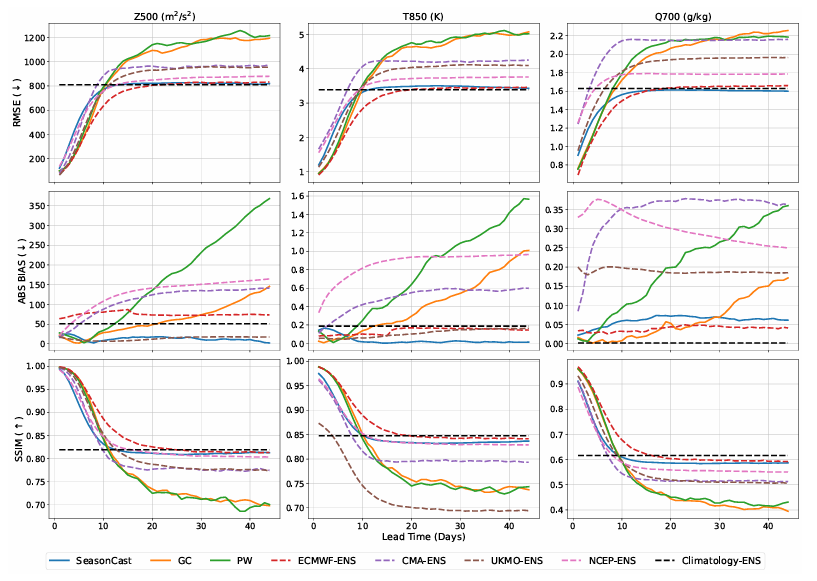

Premièrement, dans la tâche de prévision météorologique S2S,Les chercheurs ont comparé OmniCast avec deux méthodes d'apprentissage profond, PanguWeather (PW) et GraphCast (GC), ainsi qu'avec des systèmes d'ensemble de modèles numériques provenant de quatre pays et régions : UKMO-ENS (Royaume-Uni), NCEP-ENS (États-Unis), CMA-ENS (Chine) et ECMWF-ENS (Europe).

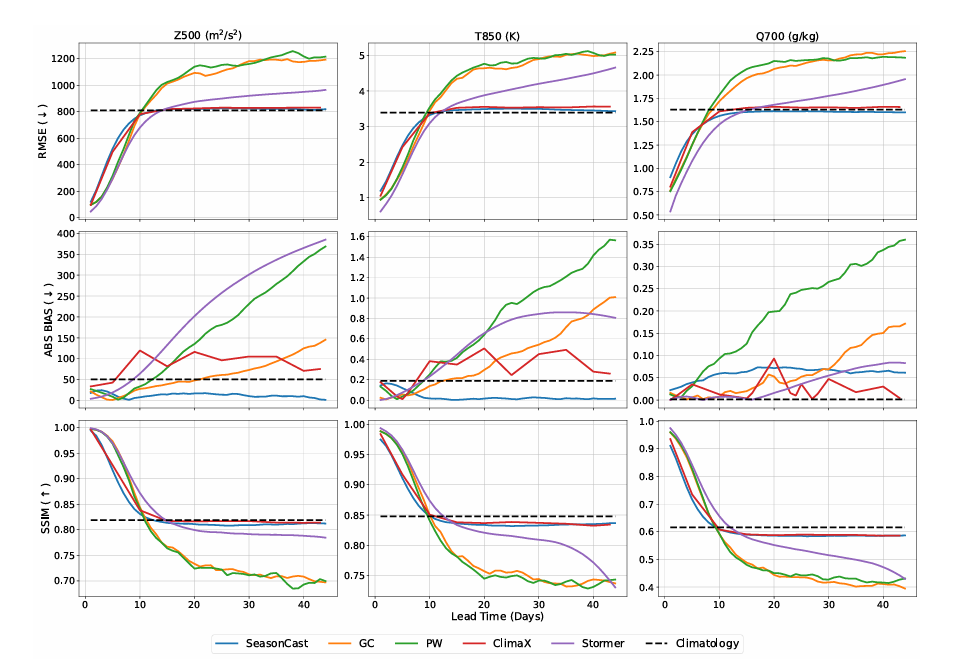

En termes de précision (erreur quadratique moyenne (RMSE), biais absolu (ABS BIAS) et phase de similarité structurelle multi-échelle (SSIM)), OmniCast affiche des performances inférieures à celles des autres modèles de référence, tant pour la RMSE que pour le SSIM, sur le court terme. Ceci s'explique par ses objectifs d'apprentissage, mais ses performances relatives s'amélioreront progressivement avec l'allongement de l'horizon de prévision.Elle atteint des performances optimales comparables à celles d'ECMWF-ENS après 10 jours.Comme le montre la figure suivante :

Il convient de noter queOmniCast présente la plus faible déviation parmi tous les modèles de référence.Les prévisions pour les trois types de variables cibles ont conservé un biais quasi nul.

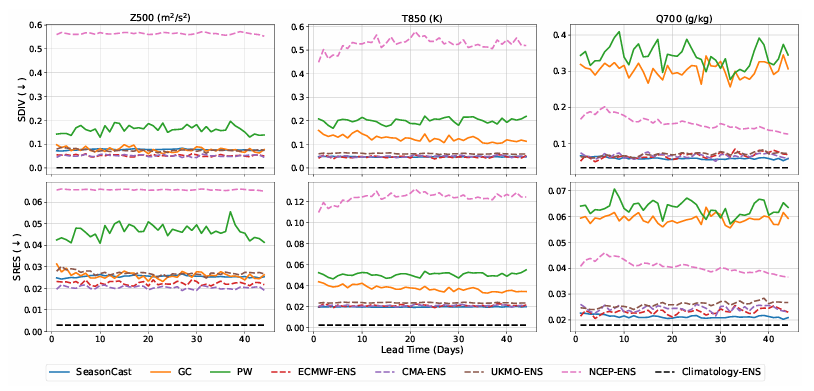

En termes de consistance physique,La cohérence physique d'OmniCast est nettement supérieure à celle des autres méthodes d'apprentissage profond.De plus, dans la plupart des cas, ses performances surpassent celles de tous les modèles de référence. Ce résultat démontre qu'OmniCast peut préserver efficacement les signaux sur différentes bandes de fréquences, garantissant ainsi la plausibilité physique des prévisions. (Voir figure ci-dessous.)

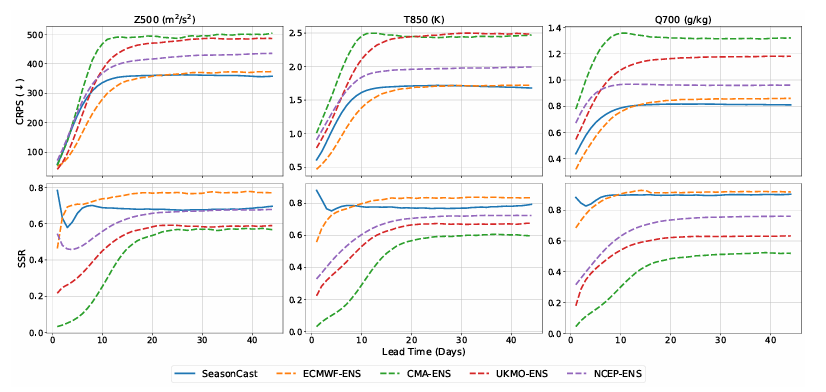

En ce qui concerne les indicateurs probabilistes (score de probabilité de classement continu (CRPS) et ratio de compétence discret (SSR), ce dernier étant meilleur lorsqu'il est plus proche de 1), similaires aux indicateurs de précision, dans un délai de prévision plus court,OmniCast est légèrement moins performant qu'ECMWF-ENS, mais il le surpassera après 15 jours.En résumé, OmniCast et ECMWF-ENS sont les deux méthodes les plus performantes, quelles que soient les variables et les échéances de prévision. (Voir figure ci-dessous.)

Outre les expériences mentionnées ci-dessus, l'équipe de recherche a également comparé OmniCast aux méthodes d'apprentissage profond proposées cette année pour la prévision météorologique à long terme, notamment ClimaX (basé sur l'architecture Transformer) et Stormer (basé sur un réseau neuronal graphique amélioré). Les résultats montrent qu'OmniCast surpasse les deux méthodes pour tous les indicateurs. Concernant l'erreur quadratique moyenne (RMSE), les valeurs de T850 et Z500 sont respectivement inférieures de 16,81 et 16,01 TP3T à celles de ClimaX, et de 11,61 et 10,21 TP3T à celles de Stormer. Concernant le coefficient de précision (CRPS), il est inférieur de 20,21 et 17,11 TP3T à celui de ClimaX, et de 13,91 et 11,01 TP3T à celui de Stormer. Ces résultats démontrent la supériorité d'OmniCast. Elle présente des avantages significatifs en matière de prévisions météorologiques à long terme.En combinant un modèle de diffusion latente avec un cadre de génération de masques, sa capacité à modéliser les dépendances à long terme dans les séquences météorologiques surpasse les architectures d'apprentissage profond traditionnelles. (Voir figure ci-dessous.)

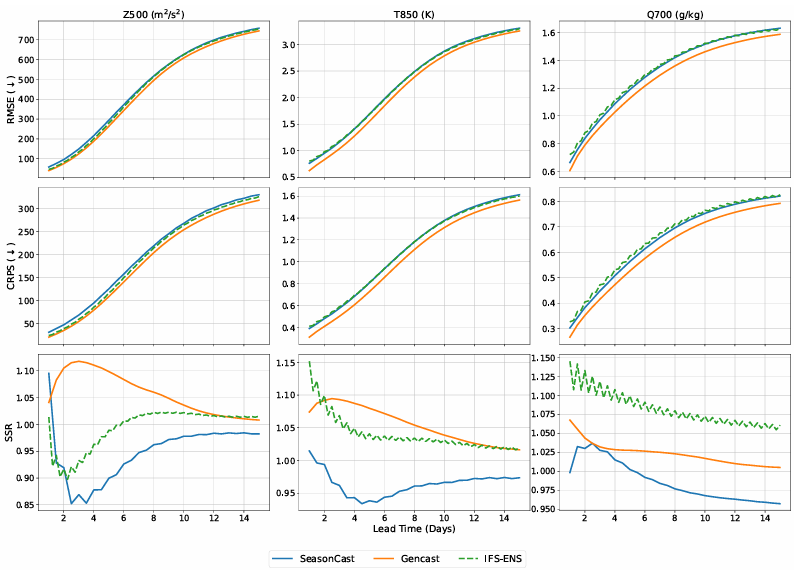

Ensuite, dans le cadre de la mission de prévision météorologique à moyen terme,L'équipe de recherche a comparé OmniCast à deux modèles de référence : Gencast, une méthode d'apprentissage profond courante pour la prévision probabiliste, et IFS-ENS, la référence en matière de systèmes de prévision d'ensemble numérique, en utilisant l'erreur quadratique moyenne (RMSE), le CRPS et le SSR comme indicateurs d'évaluation. Voir la figure ci-dessous :

Les résultats ont montré qu'OmniCast offrait des performances comparables à celles d'IFS-ENS pour l'ensemble des variables et indicateurs, légèrement inférieures à celles de Gencast. Cependant, des tests d'efficacité complémentaires ont révélé qu'OmniCast bénéficiait de sa modélisation spatiale latente, utilisant des jetons latents de faible dimension au lieu de données météorologiques brutes de haute dimension pour les calculs. Il est 10 à 20 fois plus rapide que tous les modèles de référence.

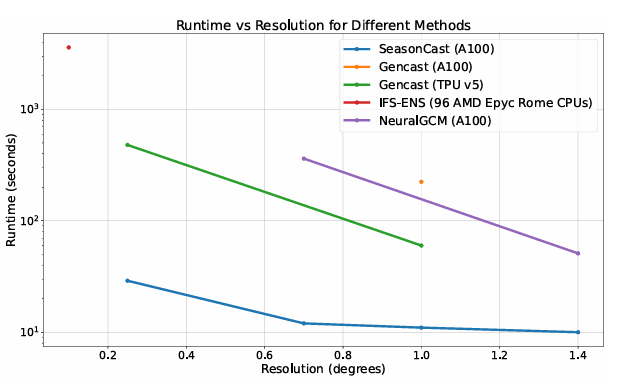

De plus, comme le montre l'image ci-dessous,OmniCast ne nécessite que 4 jours de formation sur 32 GPU NVIDIA A100.En comparaison, Gencast nécessite 5 jours d'entraînement sur 32 processeurs TPUv5e, plus puissants que l'A100, tandis que NeuralGCM requiert 10 jours sur 128 processeurs TPUv5e. De plus, Gencast nécessite un processus d'entraînement en deux étapes, contrairement à SeasonCast qui n'en requiert qu'une seule. Lors de l'inférence, OmniCast est également plus rapide. À une résolution de 0,25°, Gencast met 480 secondes, tandis qu'OmniCast effectue la même prédiction en seulement 29 secondes ; à une résolution de 1,0°, le temps d'inférence d'OmniCast est de seulement 11 secondes, contre 224 secondes pour Gencast sur le même matériel.

Dépassant sans cesse les limites des prévisions S2S, comblant avec précision les lacunes des prévisions météorologiques à moyen et long terme.

Grâce à sa capacité unique à connecter harmonieusement les prévisions météorologiques à court terme et les prévisions climatiques à long terme, la prévision météorologique S2S occupe depuis longtemps une place centrale dans la recherche en météorologie. Aujourd'hui, elle a mis en place un réseau de communication performant qui couvre de multiples sujets et dimensions, allant des discussions théoriques académiques aux avancées technologiques expérimentales, en passant par les applications pratiques.

Par exemple, fin mai de cette année, le « Symposium international sur l'IA et la prévision des catastrophes et l'alerte précoce », organisé par l'Organisation météorologique mondiale et l'Université du Shandong, a réuni plus de 300 experts et chercheurs de plus de 30 pays et régions, en présentiel et en ligne. La conférence a porté sur l'intégration des nouvelles technologies d'intelligence artificielle aux applications de prévision S2S, soulignant ainsi le rôle prometteur de la prévision S2S dans la prévention et l'atténuation des catastrophes.

Outre les séminaires universitaires, les résultats expérimentaux se sont également révélés concluants. L'équipe du chercheur Li Hao et du professeur Qi Yuan, de l'Institut d'innovation et d'industrie de l'intelligence artificielle de l'Université Fudan et de l'Institut des sciences intelligentes de Shanghai, a collaboré avec l'équipe du chercheur Lu Bo, du Laboratoire ouvert de recherche sur le climat de l'Administration météorologique chinoise.Un modèle prédictif appelé « FuXi-S2S » a été développé sur la base de l'apprentissage automatique.Il peut générer rapidement et efficacement des prévisions d'ensemble à grande échelle, réalisant une prévision complète sur 42 jours en 7 secondes.

Titre de l'article :Un modèle d'apprentissage automatique qui surpasse les modèles de prévision subsaisonnière globaux conventionnels

Adresse du document :https://www.nature.com/articles/s41467-024-50714-1

Des équipes de l'Université technique de Berlin, de l'Université de Reading et d'autres ont introduit le phénomène de « téléconnexion » dans la recherche sur les prévisions météorologiques S2S, comme le vortex polaire stratosphérique (SPV) au-dessus de l'Arctique et l'oscillation tropicale de Madden-Julian (MJO).La vérification a été effectuée en concevant trois modèles d'apprentissage profond dont la complexité augmente progressivement.Dans un premier temps, un modèle LSTM (Long Short-Term Memory) de base a été développé. Ensuite, en intégrant les indices de téléconnexion SPV et MJO, le modèle Index-LSTM a été obtenu. Enfin, des améliorations supplémentaires ont été apportées, abandonnant les indices précalculés et traitant directement les champs de vent en altitude dans l'Arctique et les données de rayonnement de grandes longueurs d'onde dans les tropiques par analyse visuelle afin de construire le modèle Vit-LSTM. Grâce à une analyse comparative des trois modèles, l'équipe a vérifié l'importance des informations de téléconnexion pour améliorer la précision des prévisions S2S. Notamment, après quatre semaines, le modèle Vit-LSTM a même surpassé le modèle ECMWF dans la prévision des configurations météorologiques du blocage scandinave et de la dorsale atlantique.

Titre de l'article :Apprentissage profond et téléconnexions : améliorer les prévisions S2S pour les conditions météorologiques hivernales européennes

Adresse du document :https://arxiv.org/abs/2504.07625

En conclusion, les problèmes qui affectent les prévisions météorologiques S2S diminuent grâce aux progrès technologiques. À l'avenir, avec l'intégration accrue de l'intelligence artificielle et de l'apprentissage profond dans le domaine météorologique, la conception traditionnelle du « temps imprévisible » sera inévitablement bouleversée. De la sagesse ancestrale consistant à observer les nuages pour prédire le temps aux modèles d'IA actuels qui génèrent des prévisions à plus d'un mois en quelques secondes, la compréhension et la maîtrise du climat par l'humanité évoluent vers une précision sans précédent.