Command Palette

Search for a command to run...

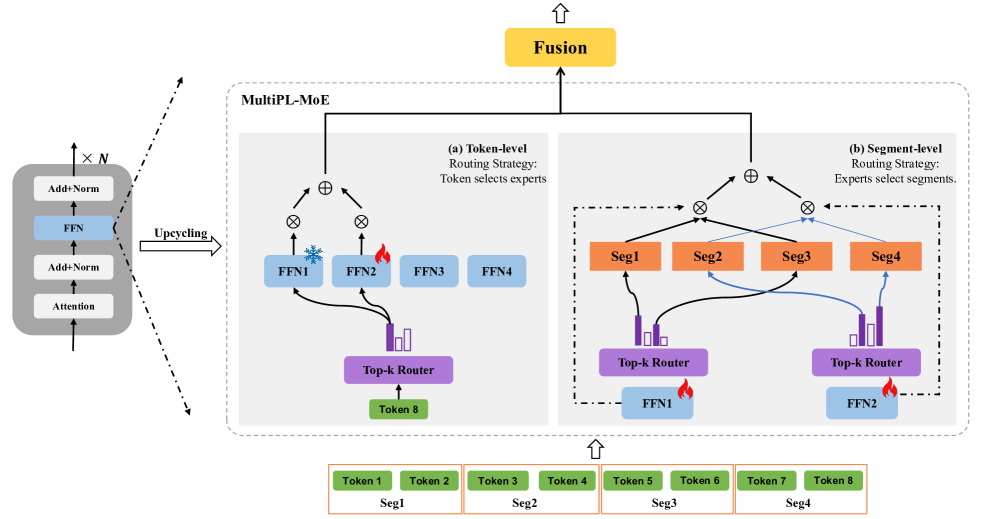

MultiPL-MoE-Architektur

MultiPL-MoE wurde im August 2025 vom China Mobile Research Institute vorgeschlagen, und die entsprechenden Forschungsergebnisse wurden in dem Artikel „MultiPL-MoE: Multiprogrammierungs- und sprachübergreifende Erweiterung großer Sprachmodelle durch hybride ExpertenmischungDie Studie wurde von EMNLP 2025 angenommen.

MultiPL-MoE ist eine Erweiterung von LLMs für mehrere Programmiersprachen (MultiPL), die mittels eines hybriden Expertenmodells (MoE) implementiert wird. Im Gegensatz zu bisherigen MoE-Methoden für Erweiterungen mehrerer natürlicher Sprachen, die sich auf die interne Sprachkonsistenz durch die Vorhersage nachfolgender Tags konzentrieren, die interne syntaktische Struktur von Programmiersprachen jedoch vernachlässigen, verwendet MultiPL-MoE eine neuartige hybride MoE-Architektur für das detaillierte Lernen semantischer Merkmale auf Tag-Ebene und syntaktischer Merkmale auf Fragment-Ebene. Dadurch kann das Modell die Codestruktur ableiten, indem es verschiedene syntaktische Elemente erkennt und klassifiziert.

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.