Command Palette

Search for a command to run...

Hypernetzwerke

Datum

Tags

HyperNetworks ist eine neuronale Netzwerkstruktur, die im Vergleich zu herkömmlichen neuronalen Netzwerken einige Unterschiede in der Modellparametrisierung aufweist. Google Brain veröffentlichte 2016 ein Papier mit dem Titel „Hypernetzwerke„In HyperNetworks wird ein neuronales Netzwerk verwendet, um die Gewichte oder andere Parameter eines anderen neuronalen Netzwerks zu generieren. Dieses generierte Netzwerk wird als HyperNetwork bezeichnet, und das von ihm generierte Netzwerk wird als Zielnetzwerk bezeichnet.

Normalerweise empfängt HyperNetwork einige zusätzliche Eingaben, z. B. die Eingabe des Zielnetzwerks, und generiert dann die Parameter des Zielnetzwerks. Ein wesentlicher Vorteil dieses Ansatzes besteht darin, dass er eine dynamische Generierung von Zielnetzwerkparametern ermöglicht, wodurch das Modell flexibler an unterschiedliche Aufgaben oder Umgebungen angepasst werden kann.

Hypernetzwerke haben potenzielle Anwendungen in Bereichen wie Meta-Lernen und Architektursuche. Durch die Verwendung von HyperNetworks können die Modellstruktur oder -parameter automatisch angepasst und optimiert werden, wodurch die Generalisierungsfähigkeit und Anpassungsfähigkeit des Modells verbessert wird.

Hypernetzwerke in stabiler Diffusion

HyperNetworks ist ein früher Anwender von Stable Diffusion Neuartige KI Entwickelte Feinabstimmungstechnologie. Es handelt sich um ein kleines neuronales Netzwerk, das an das stabile Diffusionsmodell angeschlossen ist, um dessen Stil zu ändern.

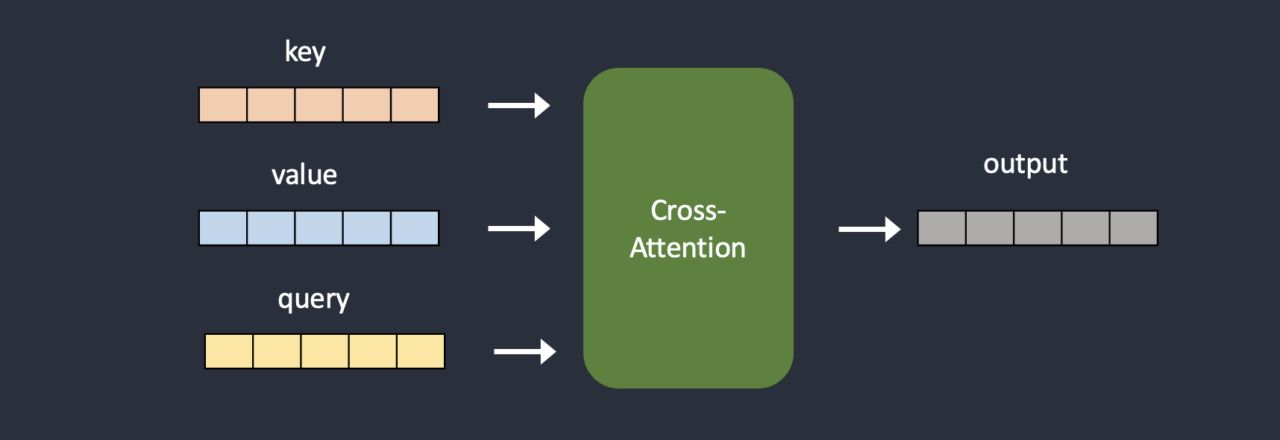

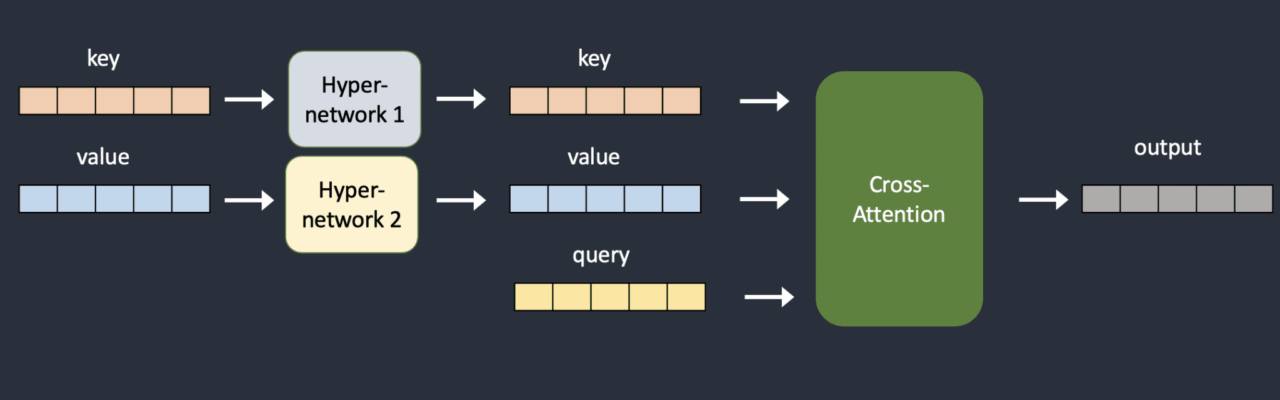

Hypernetzwerke sind normalerweise einfache neuronale Netzwerke: ein vollständig verbundenes lineares Netzwerk mit Verlust- und Aktivierungsfunktionen. Genau wie das, was Sie im Einführungskurs zu neuronalen Netzwerken lernen. Sie kapern das Criss-Cross-Attention-Modul, indem sie zwei Netzwerke einfügen, um den Schlüsselvektor und den Abfragevektor zu transformieren. Nachfolgend finden Sie einen Vergleich der ursprünglichen Modellarchitektur und der entführten Modellarchitektur.

Während des Trainings sind stabile Diffusionsmodelle gesperrt, angeschlossene HyperNetworks dürfen sich jedoch ändern. Da das Hypernetzwerk klein ist, erfolgt das Training schnell und erfordert nur begrenzte Ressourcen. Das Training kann auf einem normalen Computer durchgeführt werden.

Verweise

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.