Command Palette

Search for a command to run...

Hunyuan-MT-7B: Übersetzungsmodell-Demo

Datum

Größe

1.34 GB

Lizenz

Other

1. Einführung in das Tutorial

Hunyuan-MT-7B ist ein leichtgewichtiges Übersetzungsmodell, das im September 2025 vom Tencent Hunyuan-Team veröffentlicht wurde. Mit nur 7 Milliarden Parametern unterstützt es die Übersetzung zwischen 33 Sprachen und fünf ethnischen chinesischen Sprachen/Dialekten. Es erzielte herausragende Leistungen und belegte beim WMT2025-Wettbewerb der Association for Computational Linguistics (ACL) in 30 von 31 Sprachkategorien den ersten Platz. Das Modell versteht Internet-Slang, klassische chinesische Poesie und soziale Konversationen präzise und bietet kontextualisierte Übersetzungen. Es bietet ein umfassendes Trainingsparadigma, vom Vortraining bis zum integrierten Verstärkungslernen. Es zeichnet sich durch eine hohe Inferenzgeschwindigkeit aus, und die Leistung wird durch 30% nach der Verarbeitung mit Tencents proprietärem Komprimierungstool AngelSlim weiter verbessert.

Dieses Tutorial verwendet Ressourcen für eine einzelne RTX 4090-Karte.

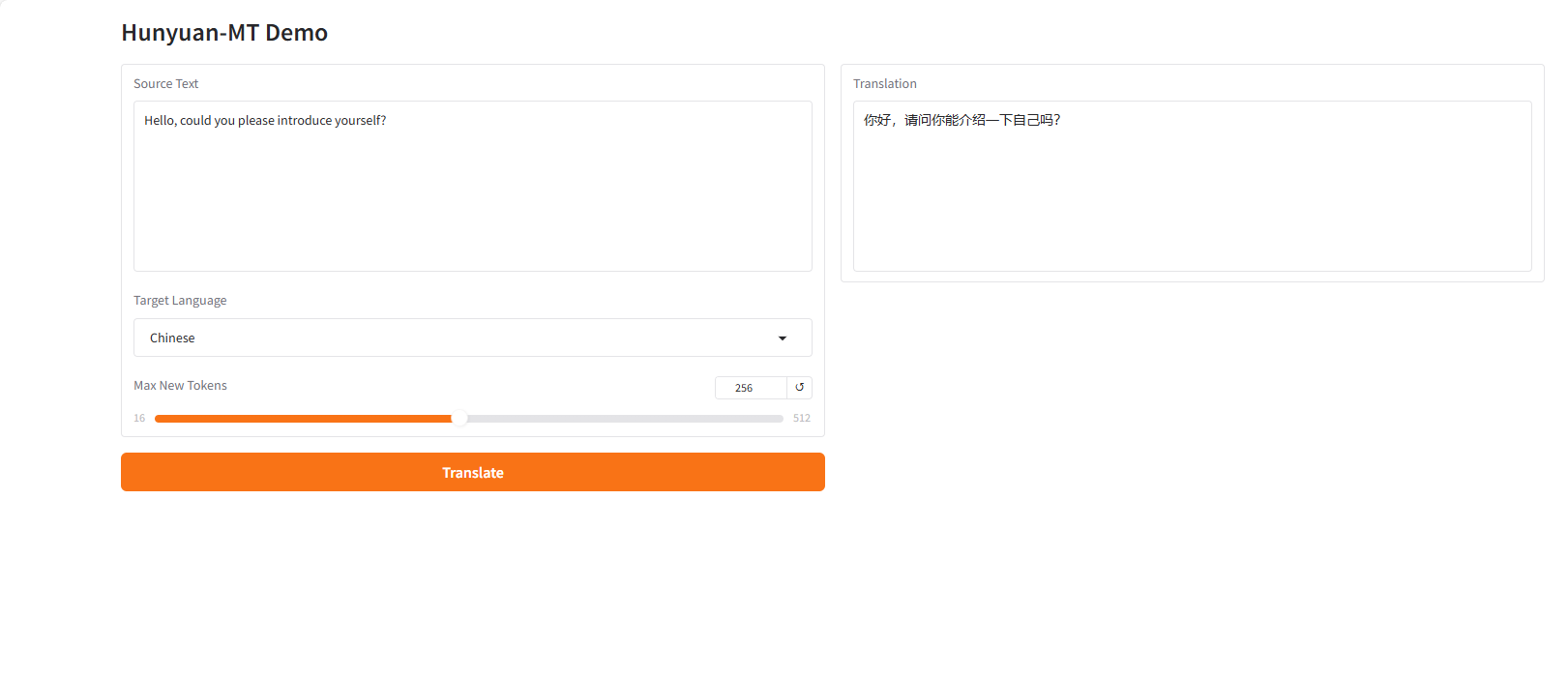

2. Projektbeispiele

3. Bedienungsschritte

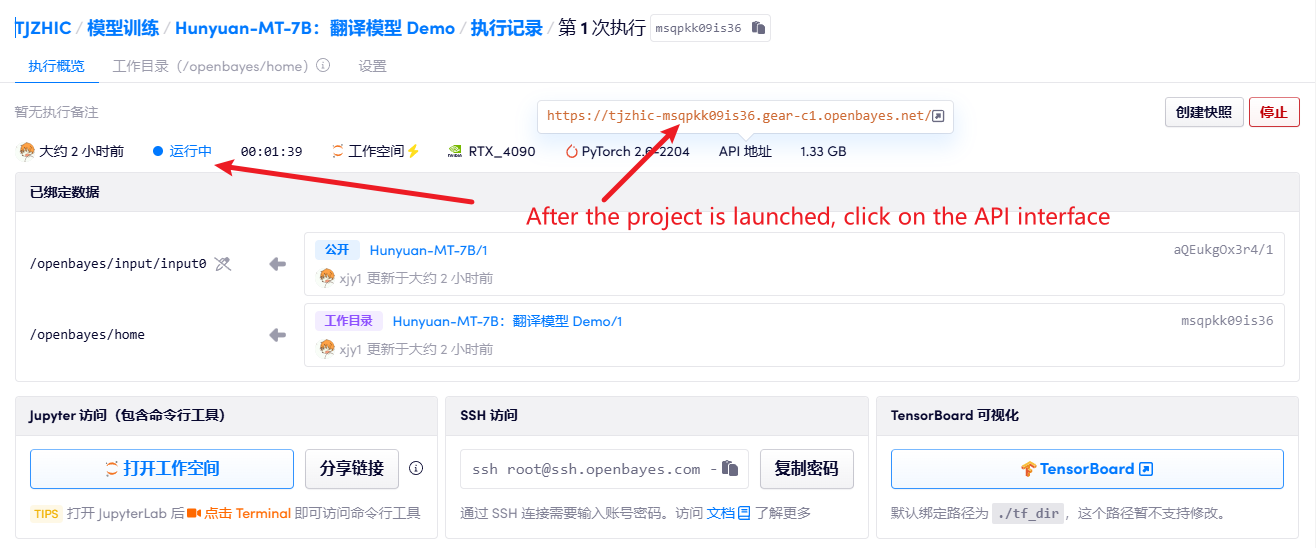

1. Klicken Sie nach dem Starten des Containers auf die API-Adresse, um die Weboberfläche aufzurufen

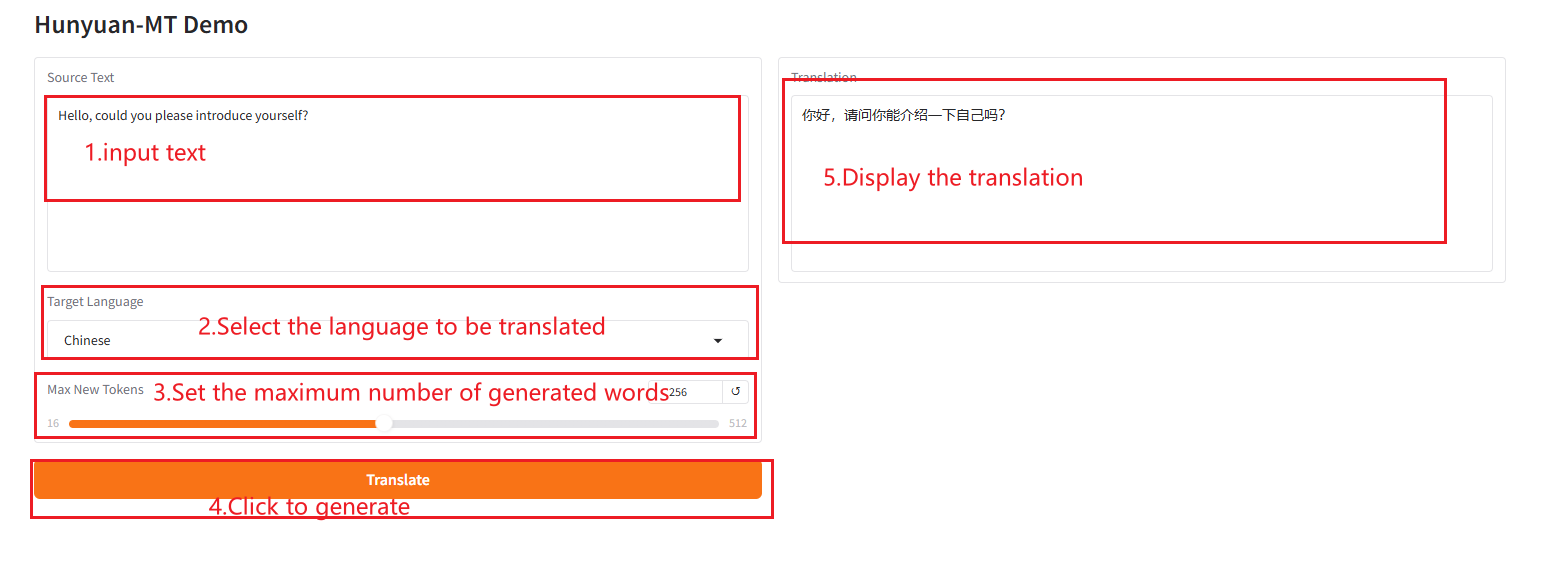

2. Anwendungsschritte

Wenn „Bad Gateway“ angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte etwa 2–3 Minuten und aktualisieren Sie die Seite.

4. Diskussion

🖌️ Wenn Sie ein hochwertiges Projekt sehen, hinterlassen Sie bitte im Hintergrund eine Nachricht, um es weiterzuempfehlen! Darüber hinaus haben wir auch eine Tutorien-Austauschgruppe ins Leben gerufen. Willkommen, Freunde, scannen Sie den QR-Code und kommentieren Sie [SD-Tutorial], um der Gruppe beizutreten, verschiedene technische Probleme zu besprechen und Anwendungsergebnisse auszutauschen ↓

Zitationsinformationen

Die Zitationsinformationen für dieses Projekt lauten wie folgt:

@misc{hunyuanmt2025,

title={Hunyuan-MT Technical Report},

author={Mao Zheng, Zheng Li, Bingxin Qu, Mingyang Song, Yang Du, Mingrui Sun, Di Wang, Tao Chen, Jiaqi Zhu, Xingwu Sun, Yufei Wang, Can Xu, Chen Li, Kai Wang, Decheng Wu},

howpublished={\url{https://github.com/Tencent-Hunyuan/Hunyuan-MT}},

year={2025}

}KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.