Command Palette

Search for a command to run...

MiniCPM-V4.0: Extrem Effizientes End-to-End-Modell Im Großen Maßstab

1. Einführung in das Tutorial

MiniCPM-V 4.0 ist ein äußerst effizientes Edge-Side-Modell für große Systeme, das im August 2025 vom Natural Language Processing Laboratory der Tsinghua-Universität in Zusammenarbeit mit Wallfacer Intelligence als Open Source veröffentlicht wurde. Es basiert auf SigLIP2-400M und MiniCPM4-3B und umfasst insgesamt 4,1 Milliarden Parameter. MiniCPM-V 4.0 übernimmt die hohe Leistungsfähigkeit von MiniCPM-V 2.6 im Bereich der Einzelbild-, Mehrbild- und Videoanalyse und bietet dabei eine deutlich verbesserte Effizienz. Wallfacer Intelligence veröffentlichte gleichzeitig iOS-Apps für iPhone und iPad. Im OpenCompass-Benchmark übertrifft MiniCPM-V 4.0 in der Bildanalyse die Modelle GPT-4.1-mini-20250414, Qwen2.5-VL-3B-Instruct und InternVL2.5-8B. Zugehörige Forschungsarbeiten sind verfügbar. MiniCPM-V: Ein MLLM auf GPT-4V-Ebene auf Ihrem Telefon .

Dieses Tutorial verwendet eine einzelne RTX 4090-Grafikkarte als Rechenressource. Zum Testen stehen drei Beispiele zur Verfügung: Chat mit einem oder mehreren Bildern, Chat mit Video und Wenige Aufnahmen.

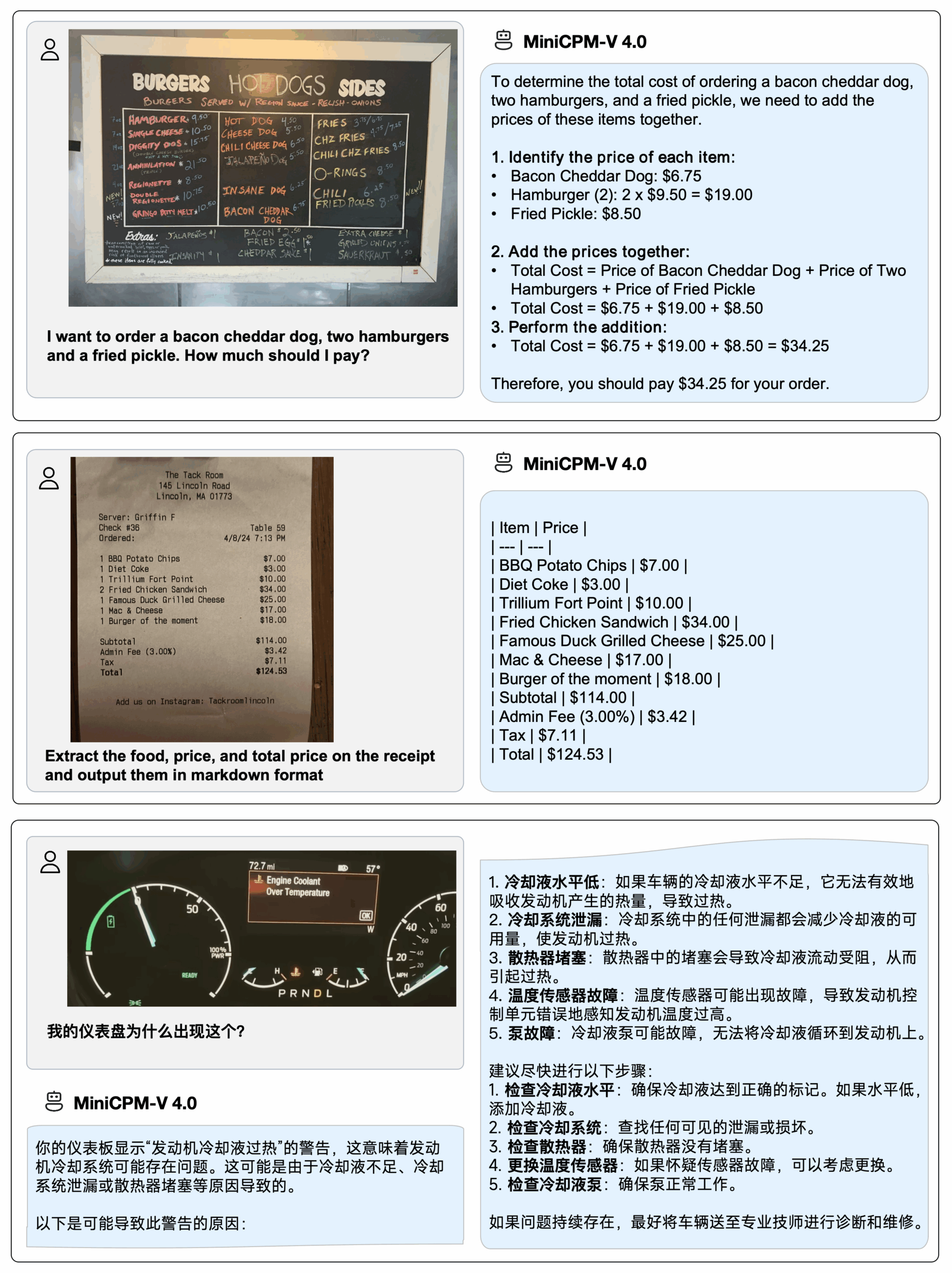

2. Effektanzeige

Stellen Sie MiniCPM-V 4.0 auf dem iPhone 16 Pro Max bereit,iOS-DemoDas Demovideo ist eine unbearbeitete Bildschirmaufnahme:

3. Bedienungsschritte

1. Starten Sie den Container

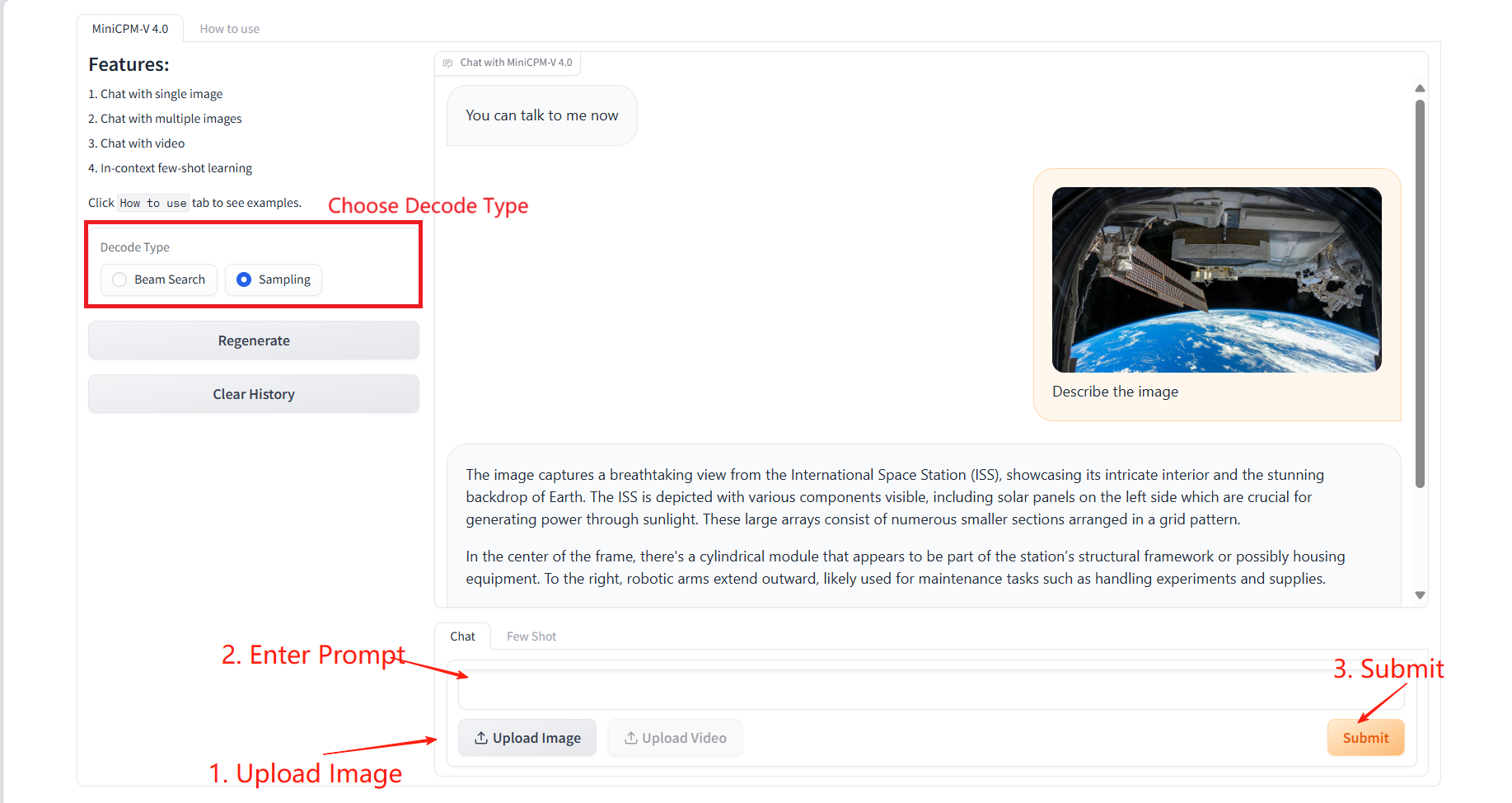

2. Anwendungsschritte

Wenn „Bad Gateway“ angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte etwa 2–3 Minuten und aktualisieren Sie die Seite.

Klicken Sie auf „Verwendung“, um die Gebrauchsanleitung anzuzeigen.

1. Chatten Sie mit einzelnen oder mehreren Bildern

Spezifische Parameter:

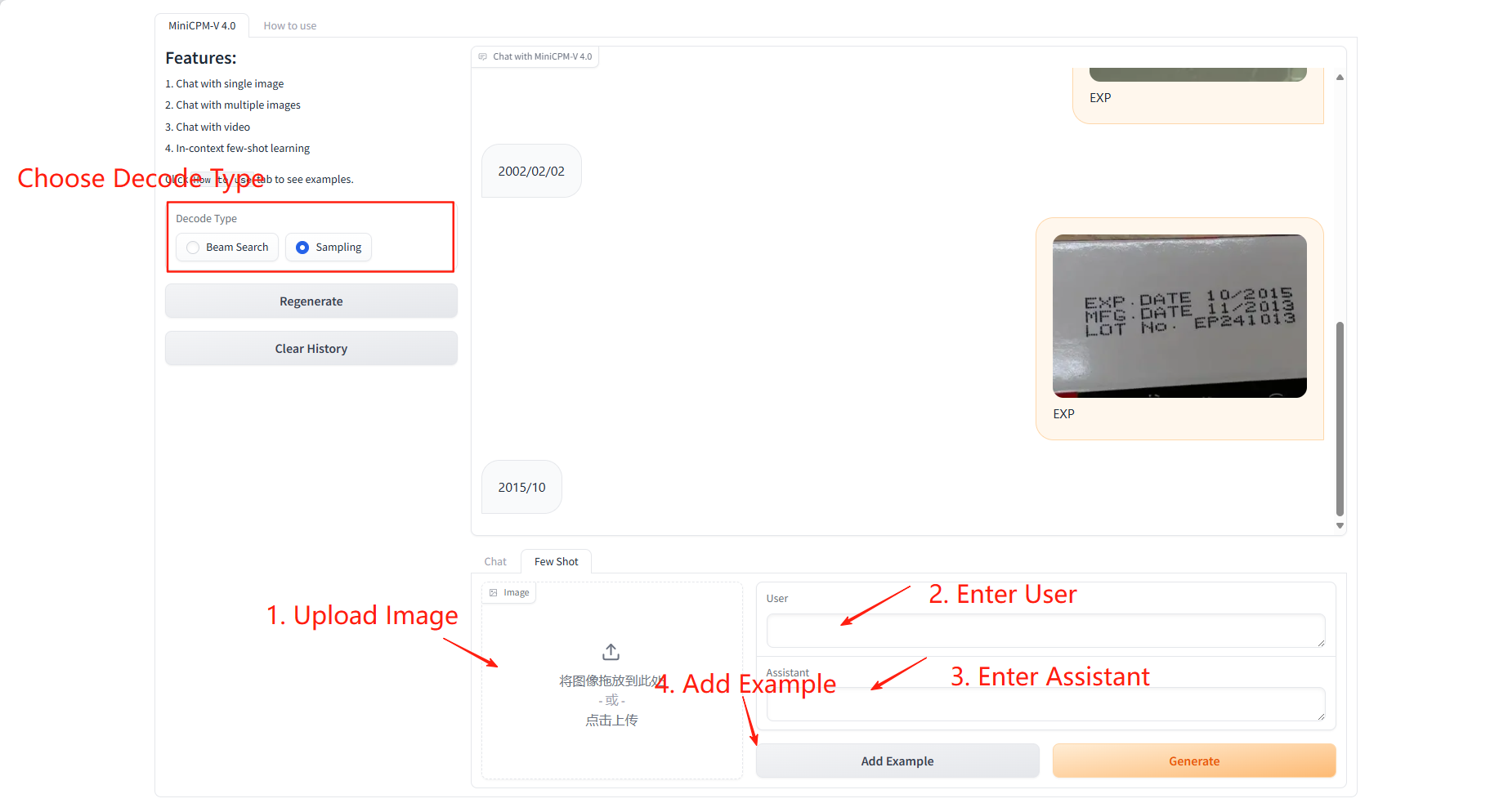

- Dekodierungstyp:

- Beam Search: Eine hochgradig deterministische Dekodierungsmethode, die versucht, die wahrscheinlichsten Kandidatensequenzen beizubehalten. Sie eignet sich besser für Szenarien, die eine genaue und konsistente Ausgabe erfordern.

- Sampling: Zufällige Auswahl des nächsten Wortes basierend auf einer Wahrscheinlichkeitsverteilung. Das Ergebnis ist kreativer, kann aber instabil sein.

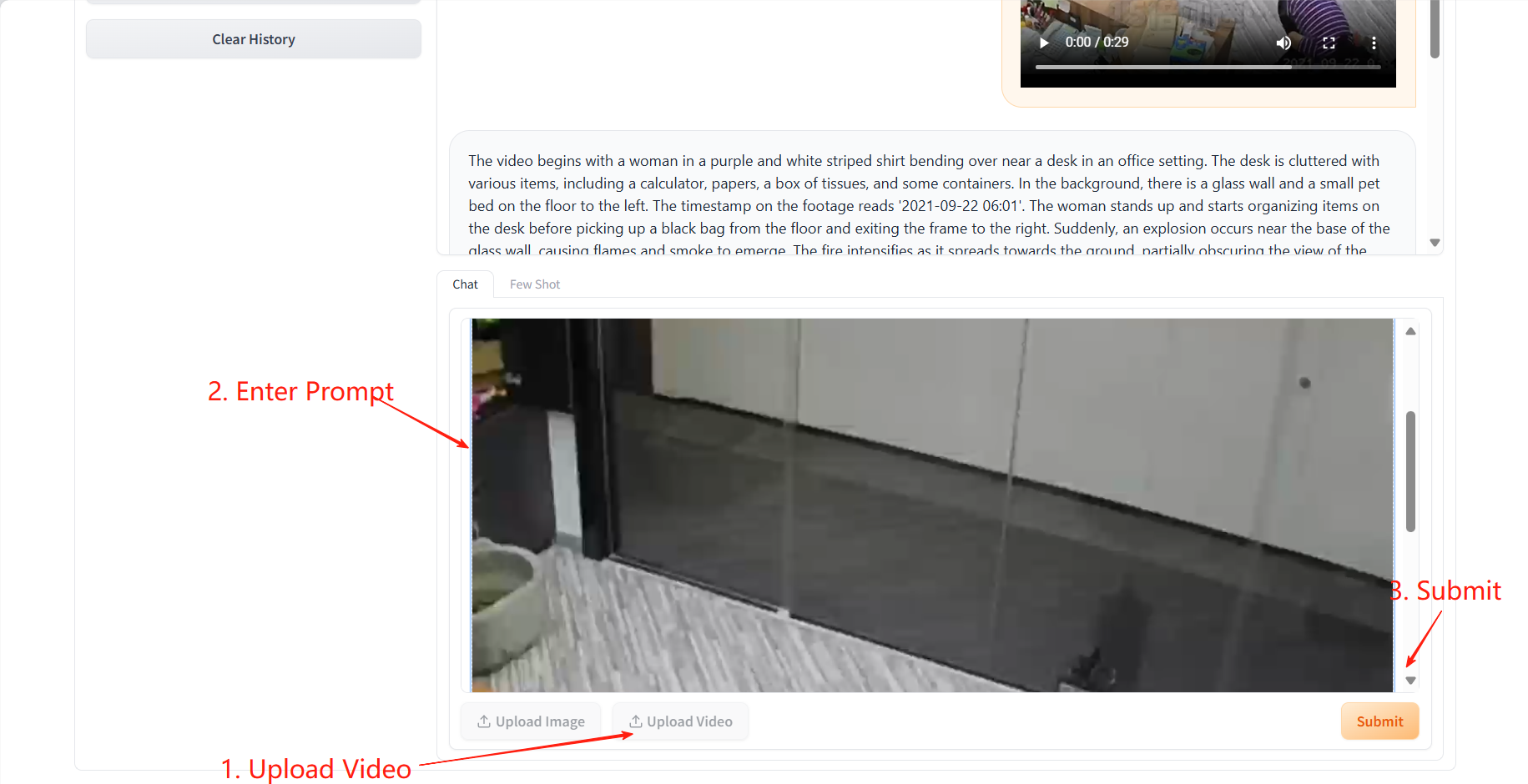

2. Chatten Sie mit Video

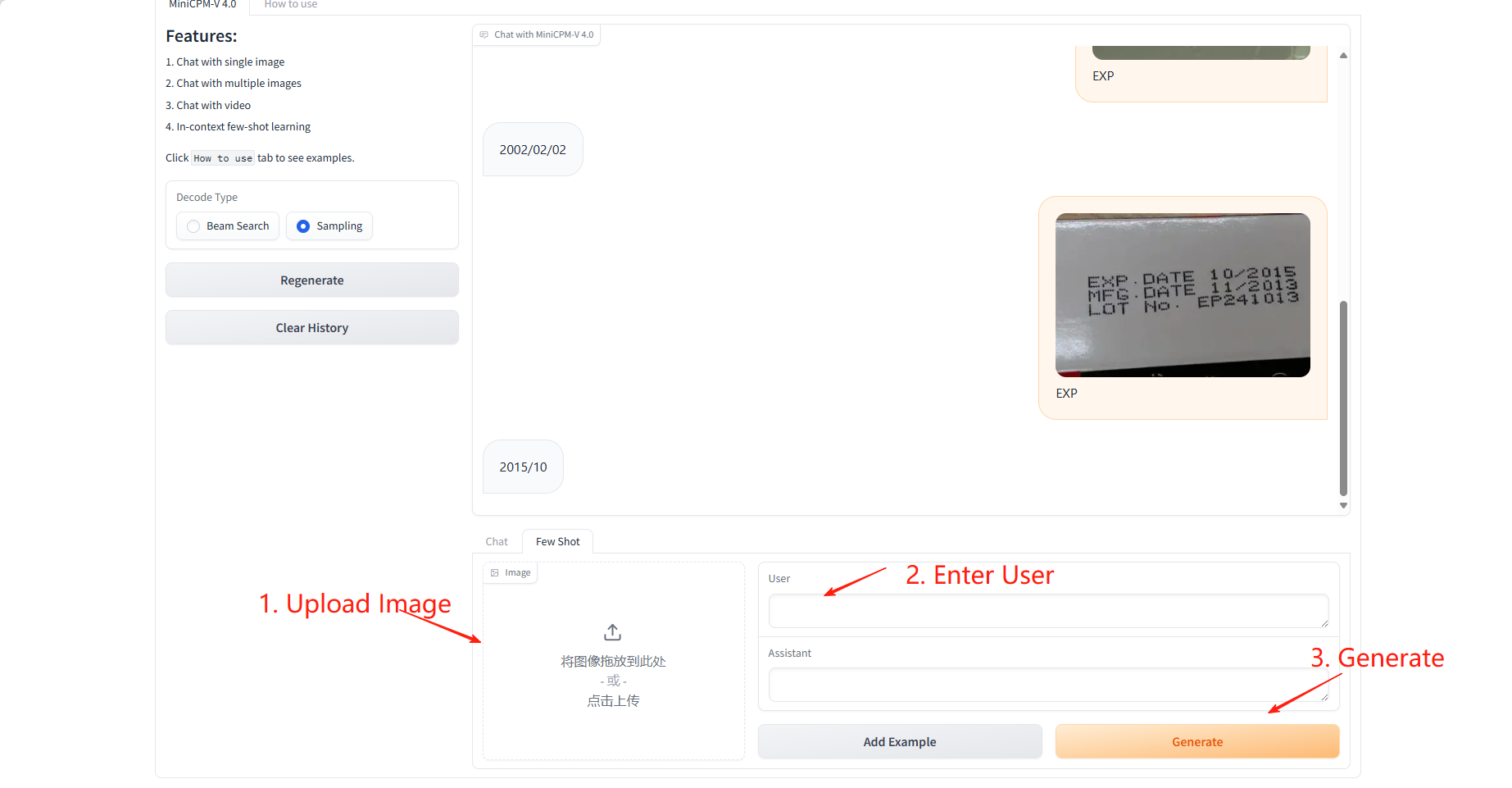

3. Wenige Schüsse

Beispiellernen

Spezifische Parameter:

- Benutzer: Geben Sie das Feld ein, das für diese Stichprobe vorhergesagt oder gelernt werden soll.

- Assistent: Geben Sie den Wert ein, der dem zu lernenden Feld für dieses Beispiel entspricht.

Ergebnisvorhersage

4. Diskussion

🖌️ Wenn Sie ein hochwertiges Projekt sehen, hinterlassen Sie bitte im Hintergrund eine Nachricht, um es weiterzuempfehlen! Darüber hinaus haben wir auch eine Tutorien-Austauschgruppe ins Leben gerufen. Willkommen, Freunde, scannen Sie den QR-Code und kommentieren Sie [SD-Tutorial], um der Gruppe beizutreten, verschiedene technische Probleme zu besprechen und Anwendungsergebnisse auszutauschen ↓

Zitationsinformationen

Die Zitationsinformationen für dieses Projekt lauten wie folgt:

@article{yao2024minicpm,

title={MiniCPM-V: A GPT-4V Level MLLM on Your Phone},

author={Yao, Yuan and Yu, Tianyu and Zhang, Ao and Wang, Chongyi and Cui, Junbo and Zhu, Hongji and Cai, Tianchi and Li, Haoyu and Zhao, Weilin and He, Zhihui and others},

journal={Nat Commun 16, 5509 (2025)},

year={2025}

}

@article{yao2024minicpm,

title={MiniCPM-V: A GPT-4V Level MLLM on Your Phone},

author={Yao, Yuan and Yu, Tianyu and Zhang, Ao and Wang, Chongyi and Cui, Junbo and Zhu, Hongji and Cai, Tianchi and Li, Haoyu and Zhao, Weilin and He, Zhihui and others},

journal={arXiv preprint arXiv:2408.01800},

year={2024}

}KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.