Command Palette

Search for a command to run...

EvoSearch-Codes: Evolutionäres Algorithmus-Framework

Datum

Größe

964.11 MB

Lizenz

Apache 2.0

Paper-URL

1. Einführung in das Tutorial

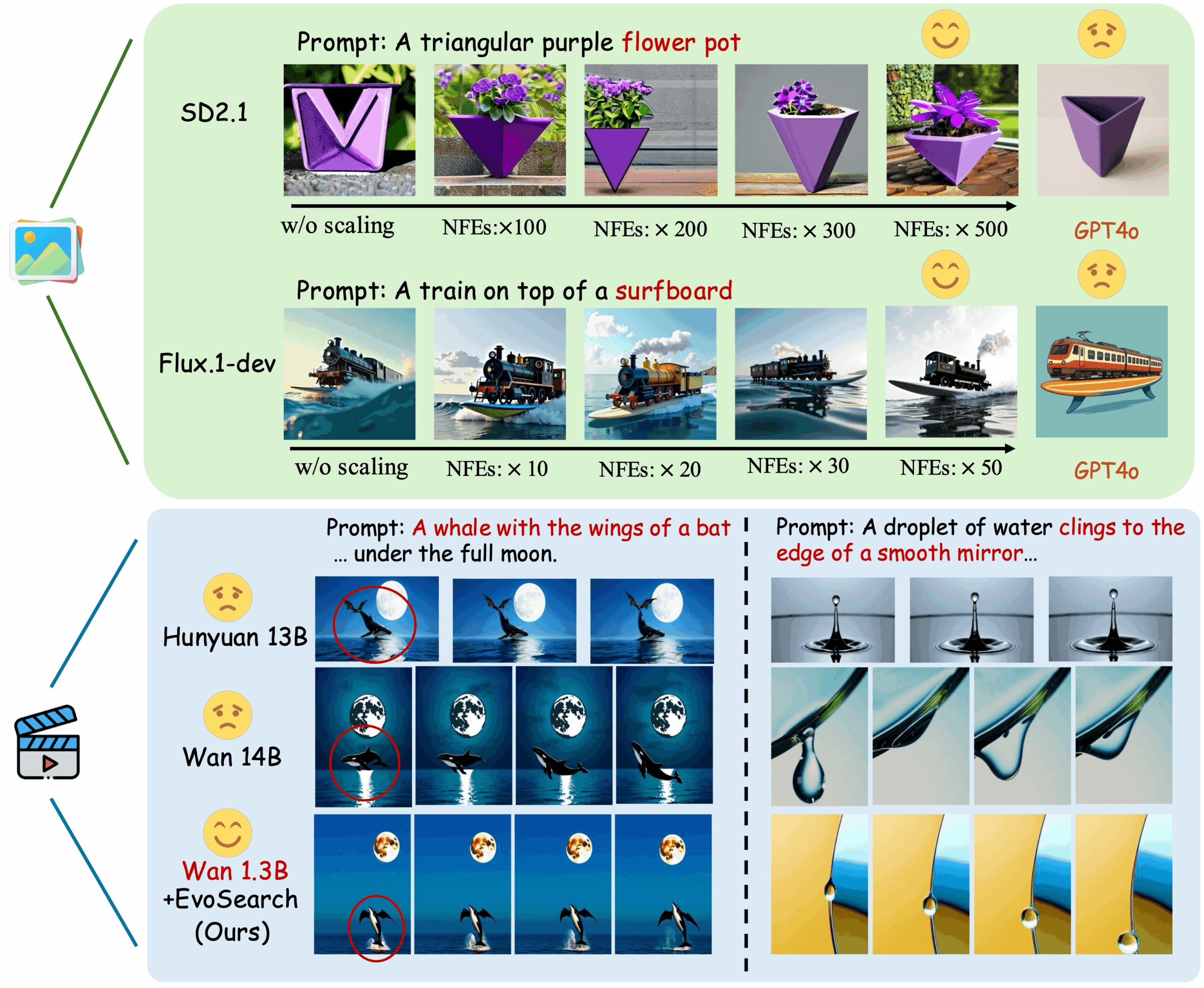

EvoSearch-Codes, veröffentlicht am 1. Mai 2025 von der Hong Kong University of Science and Technology und dem Team um Kuaishou Keling, ist ein evolutionäres Suchverfahren. Es verbessert die Generierungsqualität von Modellen signifikant, indem es den Rechenaufwand während der Inferenz erhöht, die Bild- und Videogenerierung unterstützt und mit modernsten diffusions- und flussbasierten Modellen kompatibel ist. EvoSearch erzielt ohne Training oder Gradientenaktualisierungen hervorragende Ergebnisse bei einer Reihe von Aufgaben und demonstriert damit gute Skalierbarkeit, Robustheit und Generalisierungsfähigkeit. Mit erhöhtem Rechenaufwand zur Testzeit zeigt EvoSearch, dass SD2.1 und Flux.1-dev das Potenzial haben, mit GPT-4o zu konkurrieren oder es sogar zu übertreffen. Bei der Videogenerierung übertrifft Wan 1.3B ebenfalls Wan 14B und Hunyuan 13B und demonstriert damit das Potenzial und den Forschungsraum für die Skalierung zur Testzeit als Ergänzung zur Skalierung zur Trainingszeit. Zugehörige Publikationen sind verfügbar. Skalierung der Bild- und Videogenerierung über die evolutionäre Suche zur Testzeit .

Dieses Tutorial verwendet eine einzelne RTX A6000-Karte als Ressource. Es bietet drei Testbeispiele: WAN-Videogenerierung, SD-Bildgenerierung und FLUX-Bildgenerierung.

2. Projektbeispiele

3. Bedienungsschritte

1. Klicken Sie nach dem Starten des Containers auf die API-Adresse, um die Weboberfläche aufzurufen

2. Anwendungsschritte

Wenn „Bad Gateway“ angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte etwa 2–3 Minuten und aktualisieren Sie die Seite.

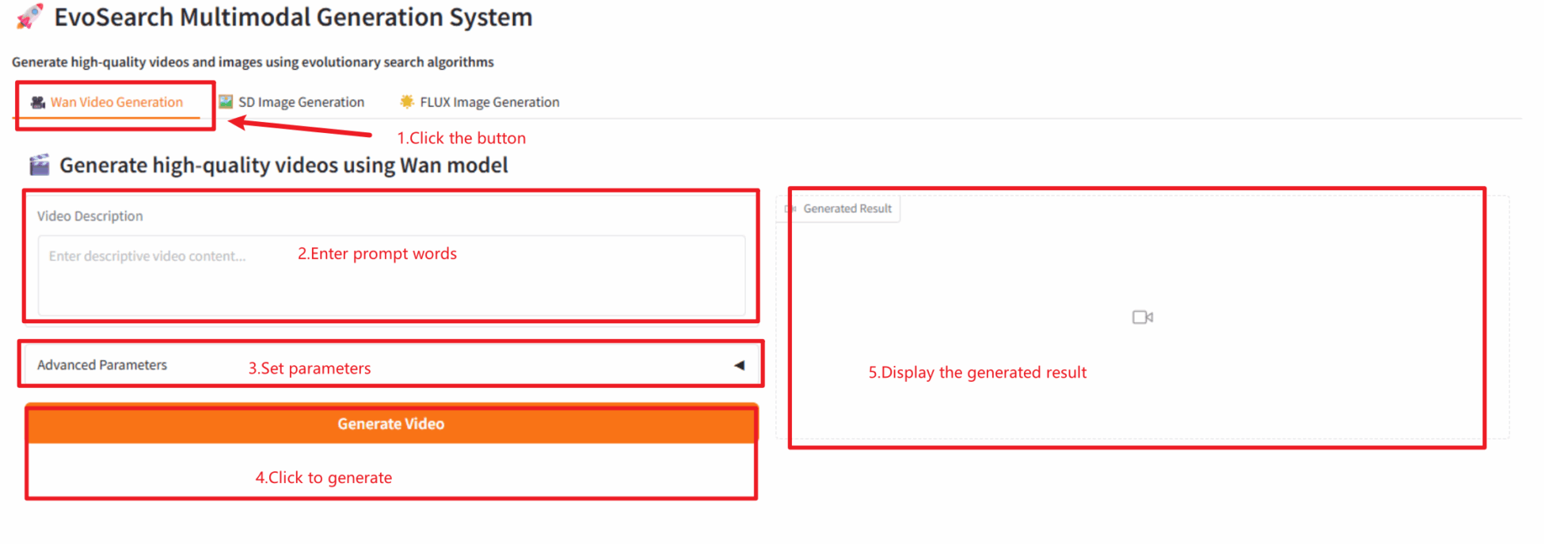

2.1 WAN-Videogenerierung

Tipp: Die Erstellung des Videos dauert etwa 5–8 Minuten.

Parameterbeschreibung

- Erweiterte Einstellungen

- Zufälliger Seed: Zufälliger Seed.

- Höhe: Höhe der Videogenerierung.

- Breite: Breite der Videogenerierung.

- Videodauer: Steuert die Videodauer.

- Inferenzschritte: Inferenzschritte.

- Anleitungsskala: Steuert die Stärke des Einflusses von Texthinweisen auf das generierte Video.

- Iteration: Anzahl der Iterationen.

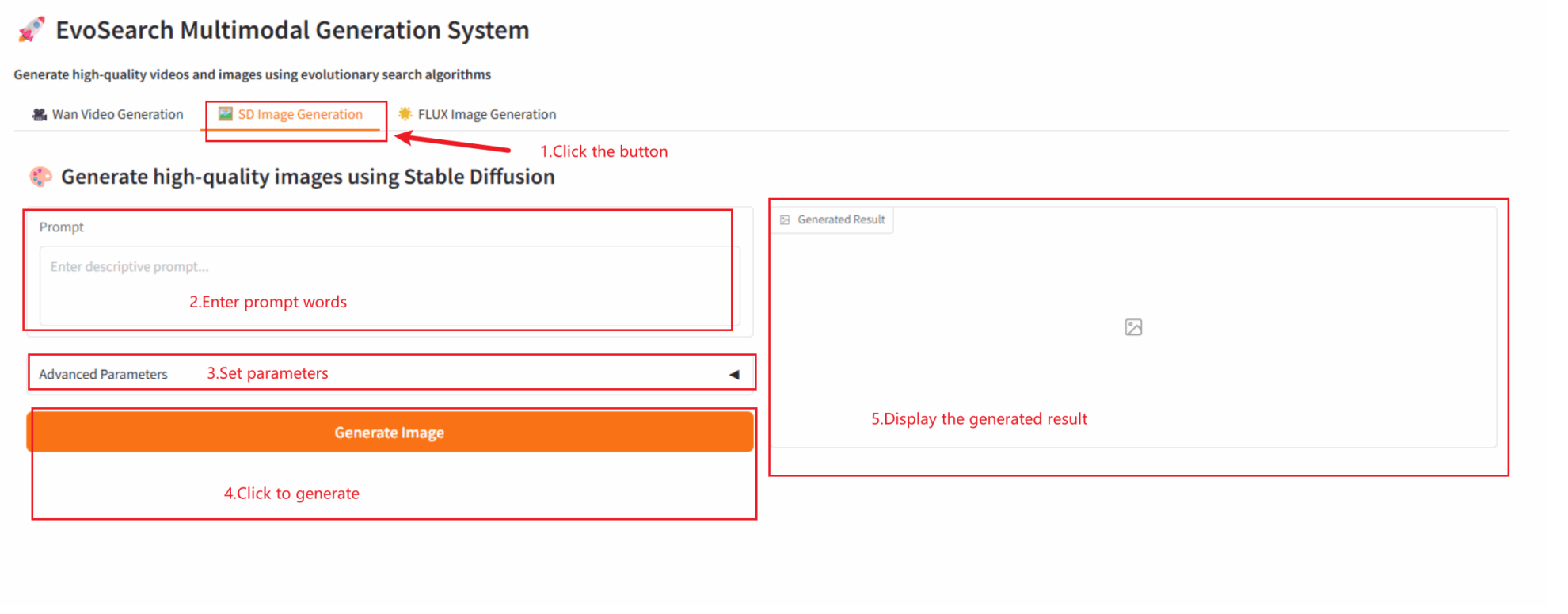

2.2 SD-Bilderzeugung

Tipp: Es ist besser, Englisch als Eingabewort zu verwenden.

- Erweiterte Einstellungen

- Zufälliger Seed: Zufälliger Seed.

- Bildgröße: Bildgröße.

- Inferenzschritte: Inferenzschritte.

- CFG-Skala: Steuert die Stärke des Einflusses von Texthinweisen auf das generierte Bild.

- Iteration: Anzahl der Iterationen.

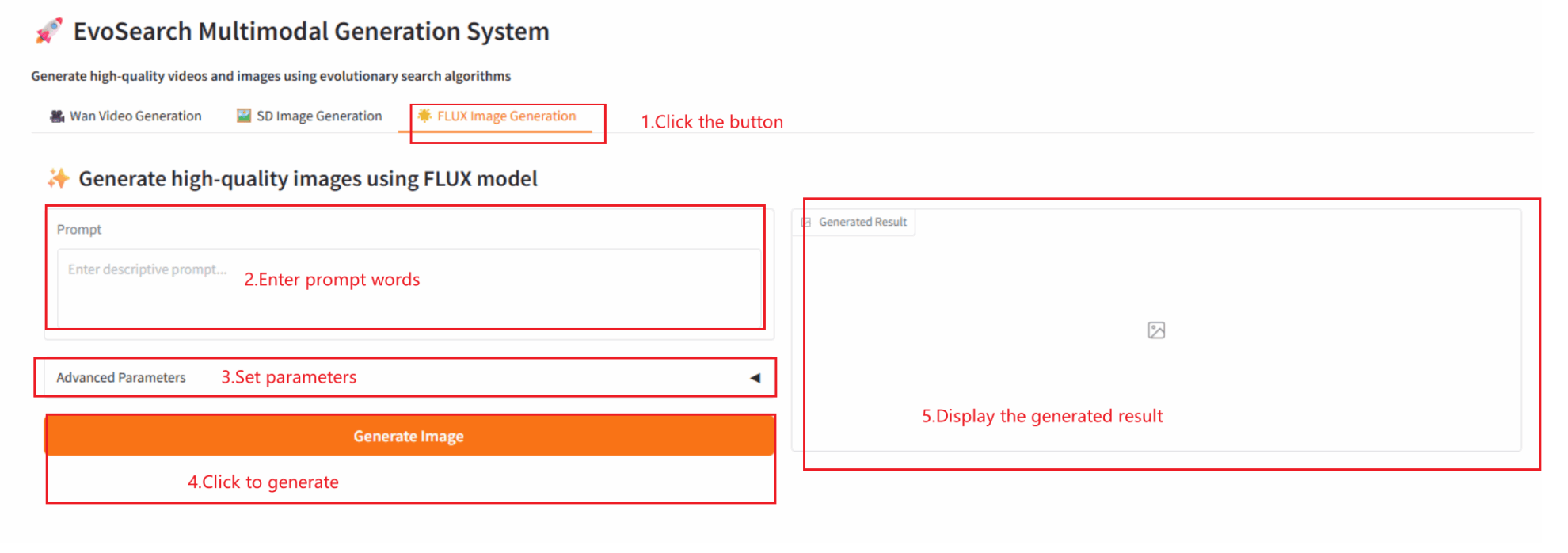

2.3 FLUX-Bilderzeugung

4. Diskussion

🖌️ Wenn Sie ein hochwertiges Projekt sehen, hinterlassen Sie bitte im Hintergrund eine Nachricht, um es weiterzuempfehlen! Darüber hinaus haben wir auch eine Tutorien-Austauschgruppe ins Leben gerufen. Willkommen, Freunde, scannen Sie den QR-Code und kommentieren Sie [SD-Tutorial], um der Gruppe beizutreten, verschiedene technische Probleme zu besprechen und Anwendungsergebnisse auszutauschen ↓

Zitationsinformationen

Die Zitationsinformationen für dieses Projekt lauten wie folgt:

@misc{he2025scaling,

title={Scaling Image and Video Generation via Test-Time Evolutionary Search},

author={Haoran He and Jiajun Liang and Xintao Wang and Pengfei Wan and Di Zhang and Kun Gai and Ling Pan},

year={2025},

eprint={2505.17618},

archivePrefix={arXiv},

primaryClass={cs.CV}

}KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.