Command Palette

Search for a command to run...

OmniGen2: Erforschung Fortschrittlicher Multimodaler Generierung

Datum

Größe

1.62 GB

Tags

Lizenz

Apache 2.0

GitHub

Paper-URL

1. Einführung in das Tutorial

OmniGen2 ist ein Open-Source-Modell für multimodale Generierung, das von der Beijing Academy of Artificial Intelligence (BAAI) am 16. Juni 2025 veröffentlicht wurde. Es bietet eine einheitliche Lösung für verschiedene generative Aufgaben, darunter Text-zu-Bild-Konvertierung, Bildbearbeitung und Kontextgenerierung. Im Gegensatz zu OmniGen v1 verwendet OmniGen2 zwei unabhängige Dekodierungspfade für Text- und Bildmodalitäten mit nicht-gemeinsamen Parametern und separaten Bildsegmentierern. Dadurch kann OmniGen2 auf bestehenden Modellen zur multimodalen Datenverarbeitung aufbauen, ohne an VAE-Eingaben angepasst werden zu müssen, und behält somit seine ursprünglichen Fähigkeiten zur Textgenerierung bei. Die Kerninnovationen liegen in der Dual-Path-Architektur und dem Selbstreflexionsmechanismus, die einen neuen Maßstab für aktuelle Open-Source-Modelle für multimodale Daten setzen. Zugehörige Forschungsarbeiten sind verfügbar. OmniGen2: Erkundung der fortschrittlichen multimodalen Stromerzeugung .

Die Rechenressourcen dieses Tutorials verwenden eine einzelne RTX A6000-Karte und die englischen Eingabeaufforderungen sind derzeit effektiver.

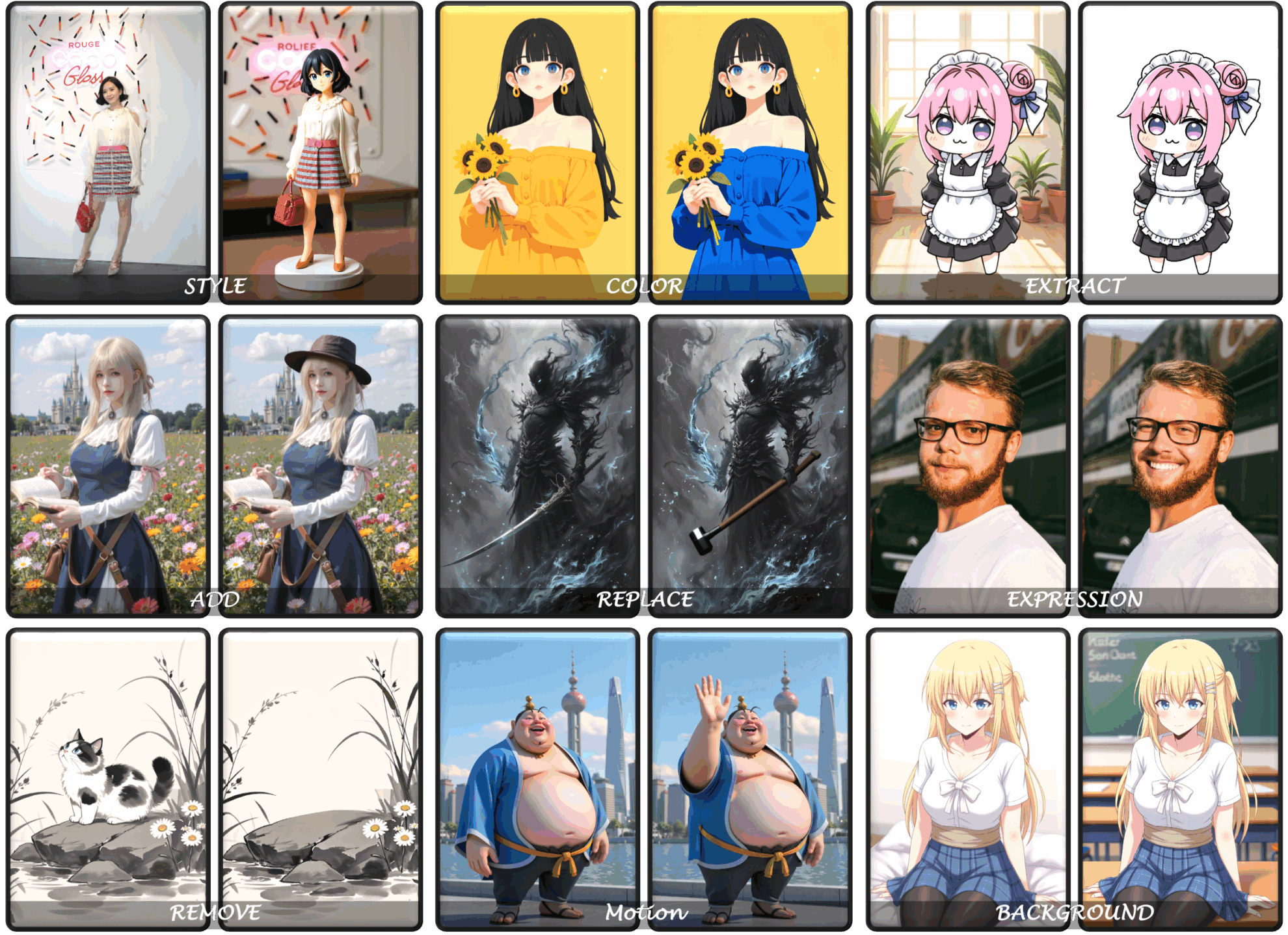

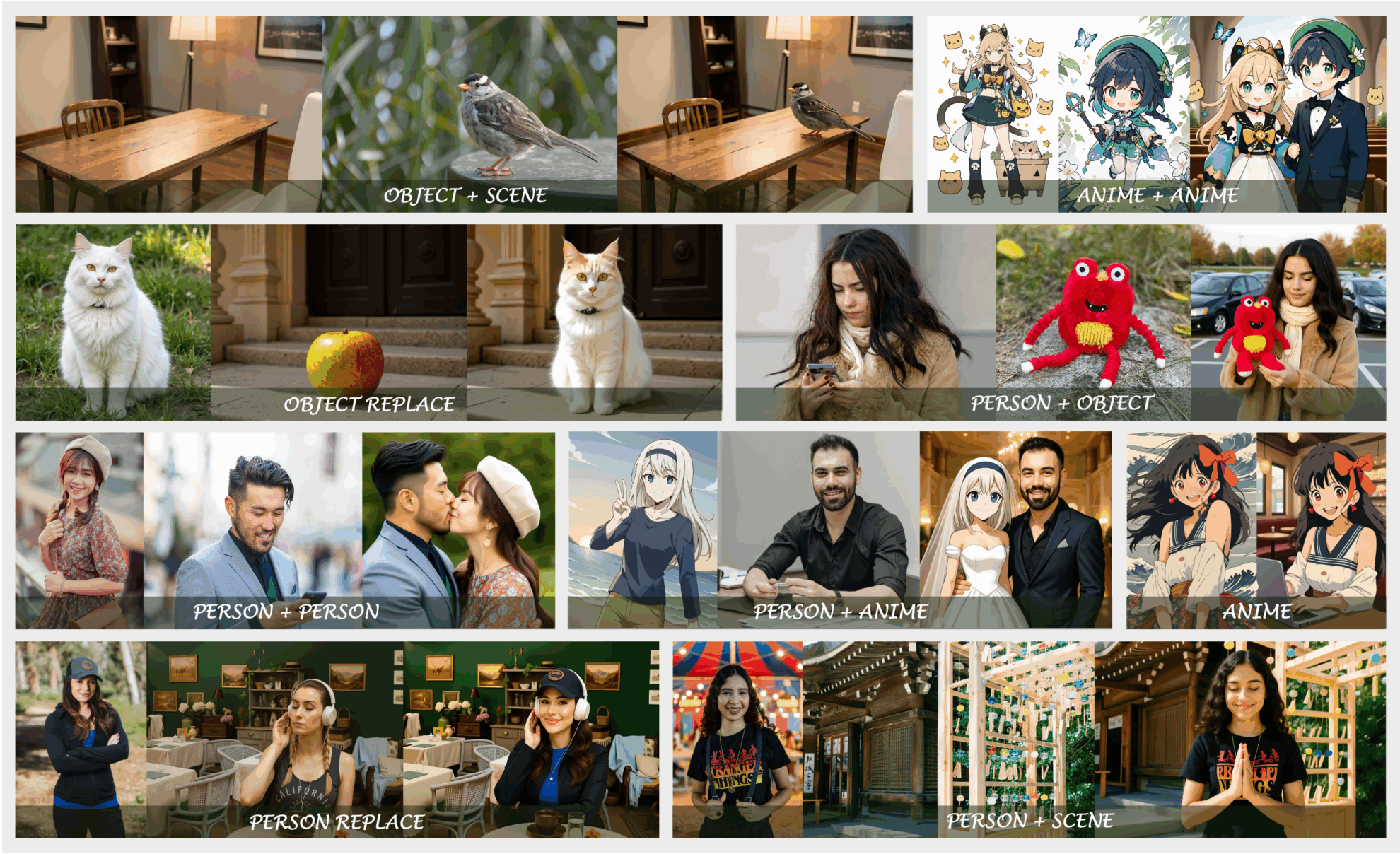

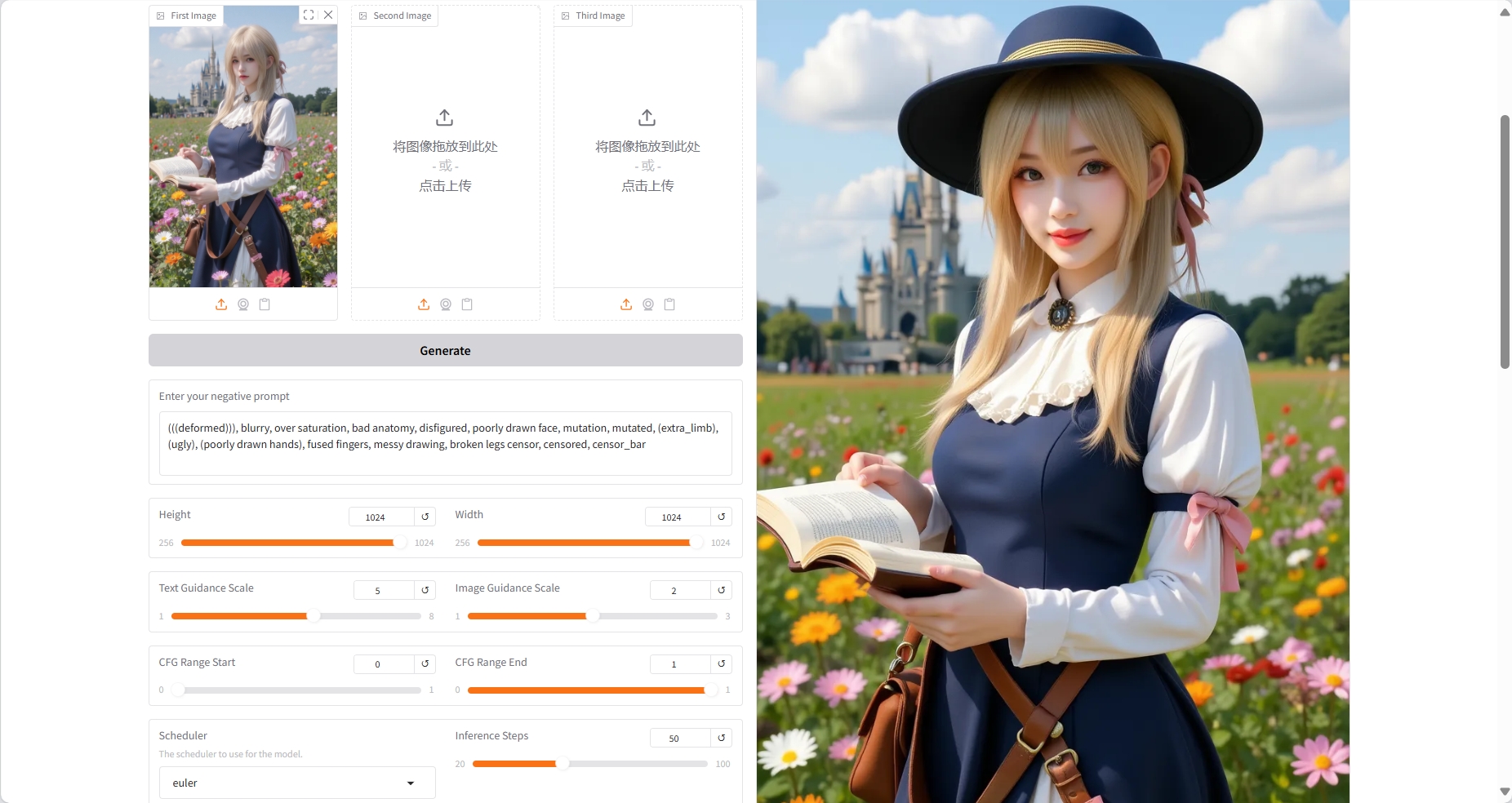

2. Effektanzeige

Einige Beispiele für Effekte mit OmniGen2:

3. Bedienungsschritte

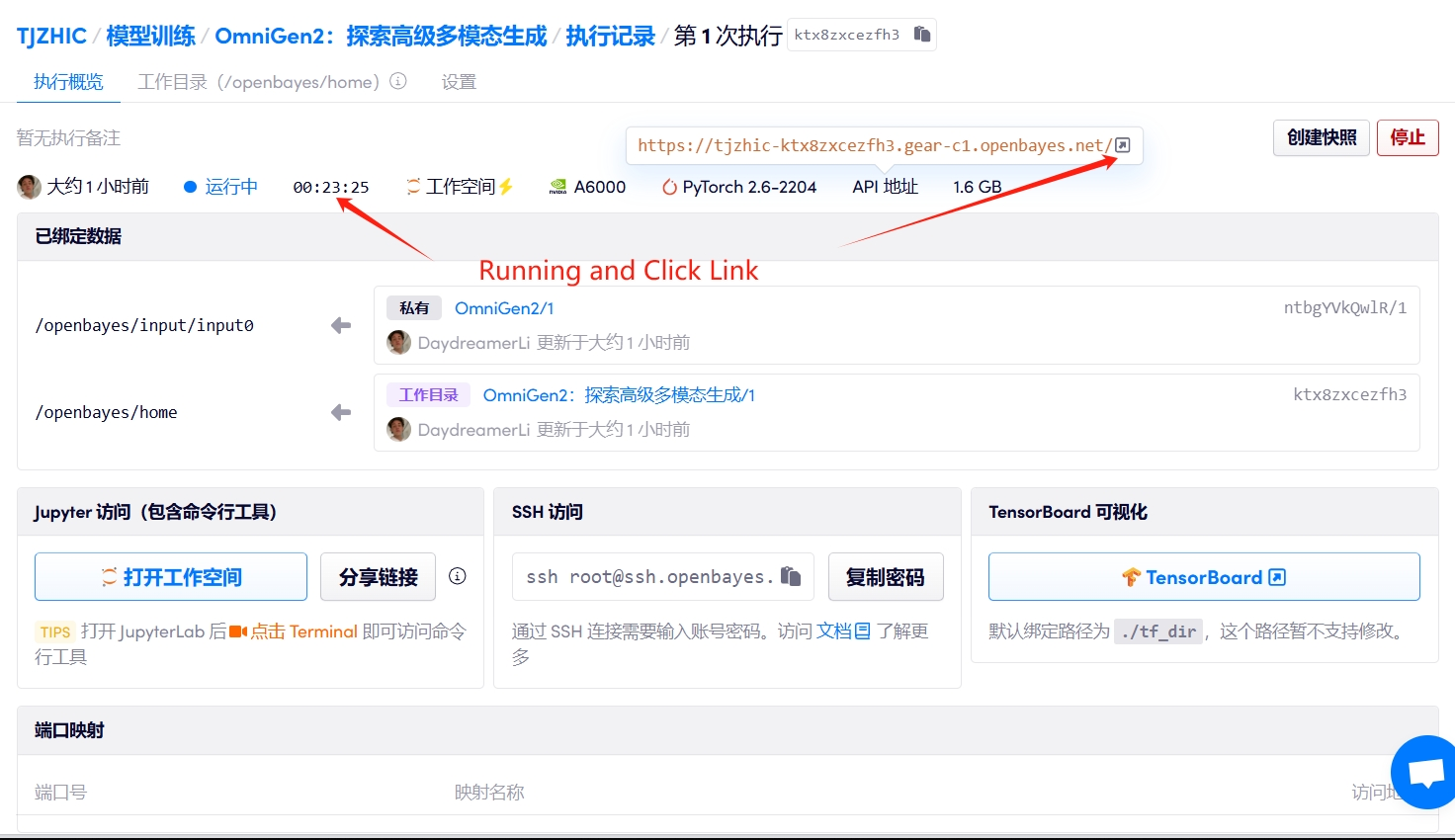

1. Starten Sie den Container

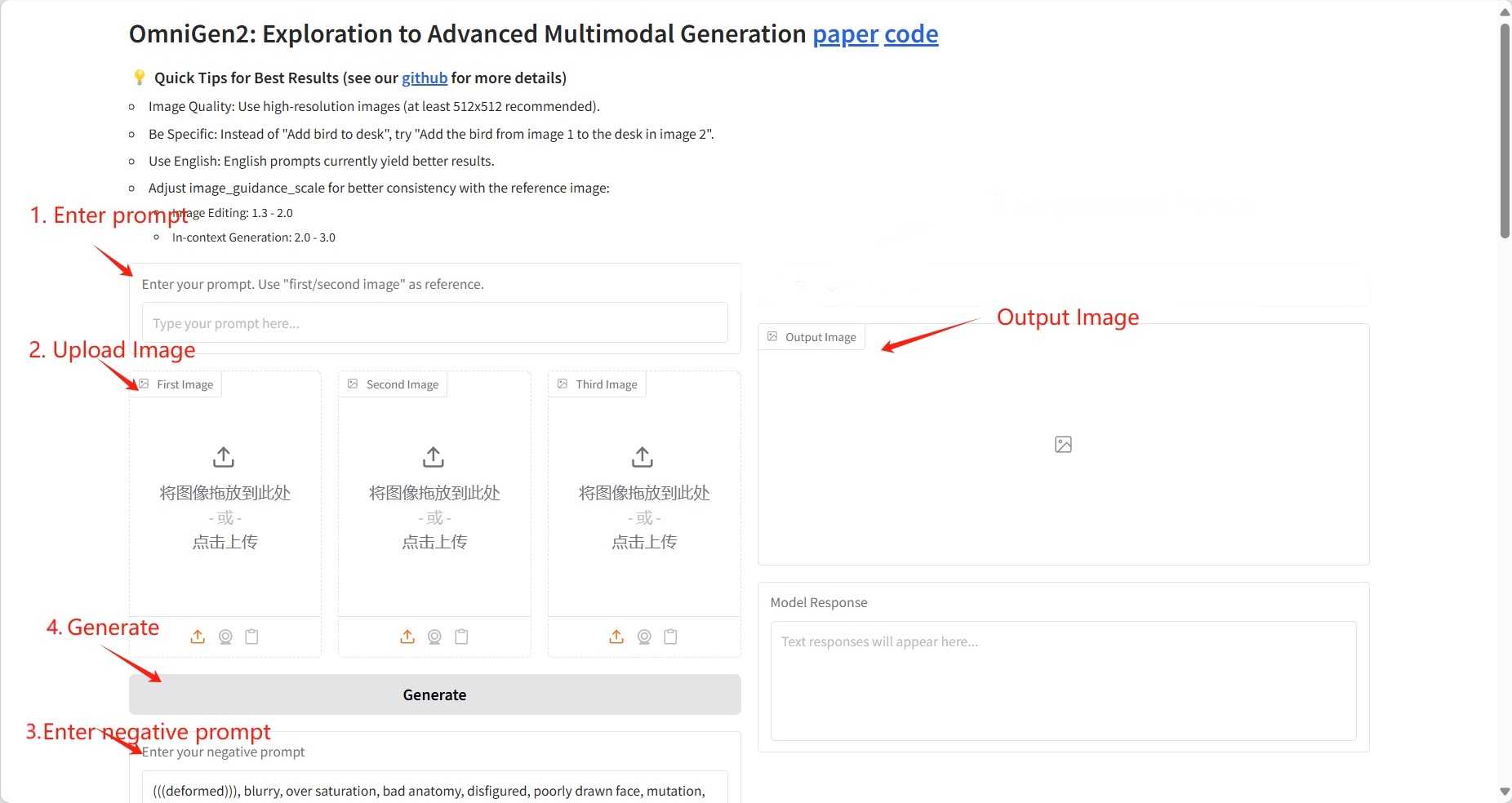

2. Anwendungsschritte

Wenn „Bad Gateway“ angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte etwa 2–3 Minuten und aktualisieren Sie die Seite.

Das erste Beispiel ist eine Bildbeschreibung, das zweite und dritte Beispiel sind Visualisierungsbilder und die restlichen Beispiele sind Bildbearbeitungen.

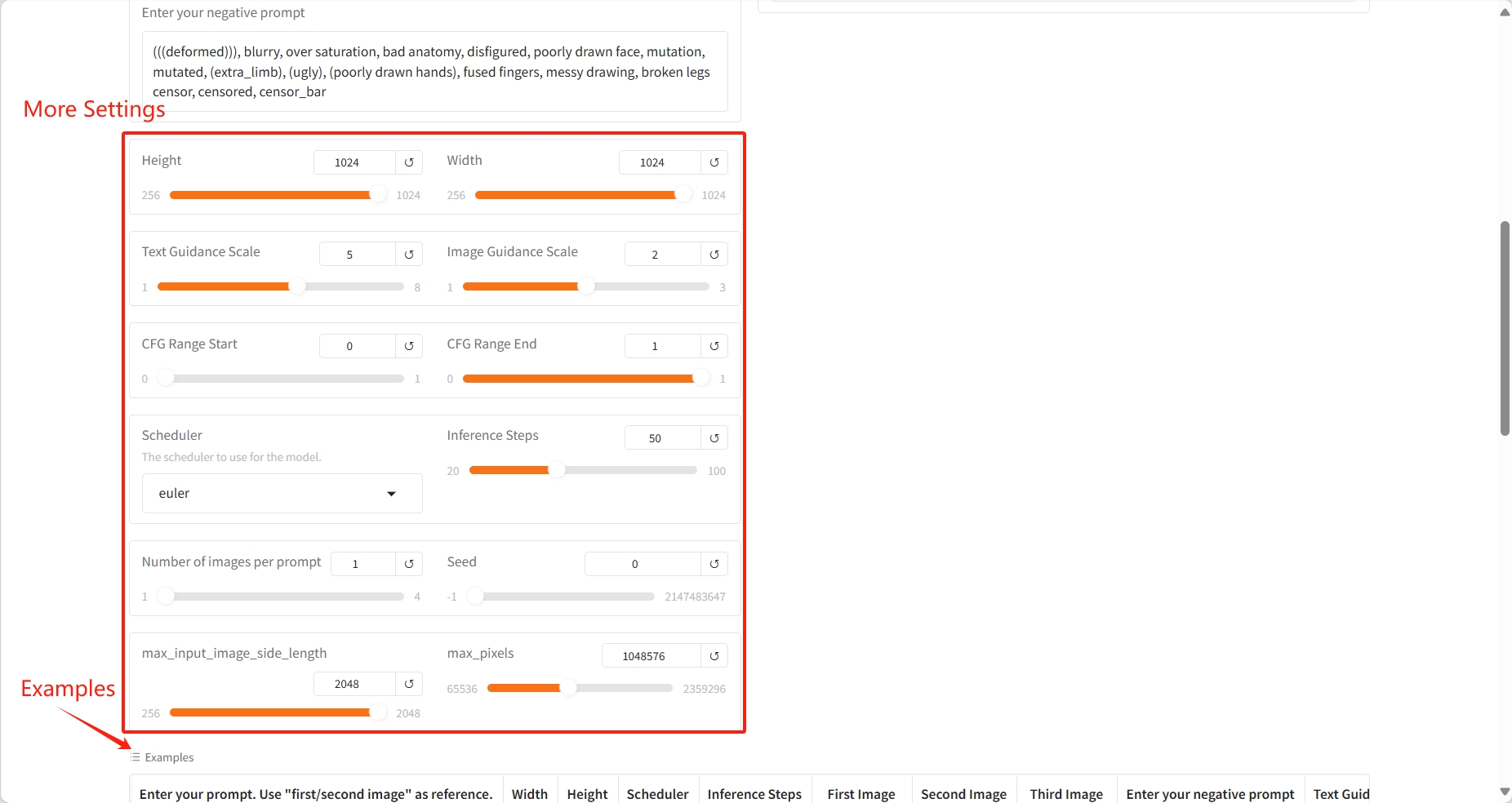

Spezifische Parameter:

- Höhe: Höhe.

- Breite: Breite.

- Textführungsskala: Textführungsskala.

- Bildführungsskala: Bildführungsskala.

- CFG Bereichsanfang: Bereichsanfang.

- CFG-Bereichsende: Bereichsende.

- Planer: Planer.

- Inferenzschritte: Inferenzschritte.

- Anzahl der Bilder pro Eingabeaufforderung: Die Anzahl der Bilder pro Eingabeaufforderung.

- Samen: Samen.

- max_input_image_side_length: Maximale Seitenlänge des Eingabebildes.

- max_pixels: Maximale Pixelanzahl.

Ergebnis

4. Diskussion

🖌️ Wenn Sie ein hochwertiges Projekt sehen, hinterlassen Sie bitte im Hintergrund eine Nachricht, um es weiterzuempfehlen! Darüber hinaus haben wir auch eine Tutorien-Austauschgruppe ins Leben gerufen. Willkommen, Freunde, scannen Sie den QR-Code und kommentieren Sie [SD-Tutorial], um der Gruppe beizutreten, verschiedene technische Probleme zu besprechen und Anwendungsergebnisse auszutauschen ↓

Zitationsinformationen

Die Zitationsinformationen für dieses Projekt lauten wie folgt:

@article{wu2025omnigen2,

title={OmniGen2: Exploration to Advanced Multimodal Generation},

author={Chenyuan Wu and Pengfei Zheng and Ruiran Yan and Shitao Xiao and Xin Luo and Yueze Wang and Wanli Li and Xiyan Jiang and Yexin Liu and Junjie Zhou and Ze Liu and Ziyi Xia and Chaofan Li and Haoge Deng and Jiahao Wang and Kun Luo and Bo Zhang and Defu Lian and Xinlong Wang and Zhongyuan Wang and Tiejun Huang and Zheng Liu},

journal={arXiv preprint arXiv:2506.18871},

year={2025}

}KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.