Command Palette

Search for a command to run...

vLLM+Open WebUI-Bereitstellung QwenLong-L1-32B

Datum

Größe

96.23 MB

Tags

Lizenz

Apache 2.0

Paper-URL

1. Einführung in das Tutorial

QwenLong-L1-32B ist ein Long-Text-Reasoning-Modell, das am 26. Mai 2025 von Tongyi Lab und der Alibaba Group veröffentlicht wurde. Es ist das erste Long-Text-Reasoning-Modell, das mit Reinforcement Learning (RL) trainiert wurde und sich auf die Lösung von Problemen wie mangelndem Speicher und logischen Inkonsistenzen konzentriert, die bei der Verarbeitung extrem langer Kontexte (z. B. 120.000 Token) bei traditionellen, großskaligen Modellen auftreten. Es überwindet die Kontextbeschränkungen traditioneller, großskaliger Modelle und bietet eine kostengünstige und leistungsstarke Lösung für anspruchsvolle Anwendungsbereiche wie Finanzen und Recht. Zugehörige Forschungsarbeiten sind verfügbar. QwenLong-L1: Auf dem Weg zu Long-Context Large Reasoning-Modellen mit Reinforcement Learning .

Dieses Tutorial verwendet Dual-Card-RTX-A6000-Ressourcen.

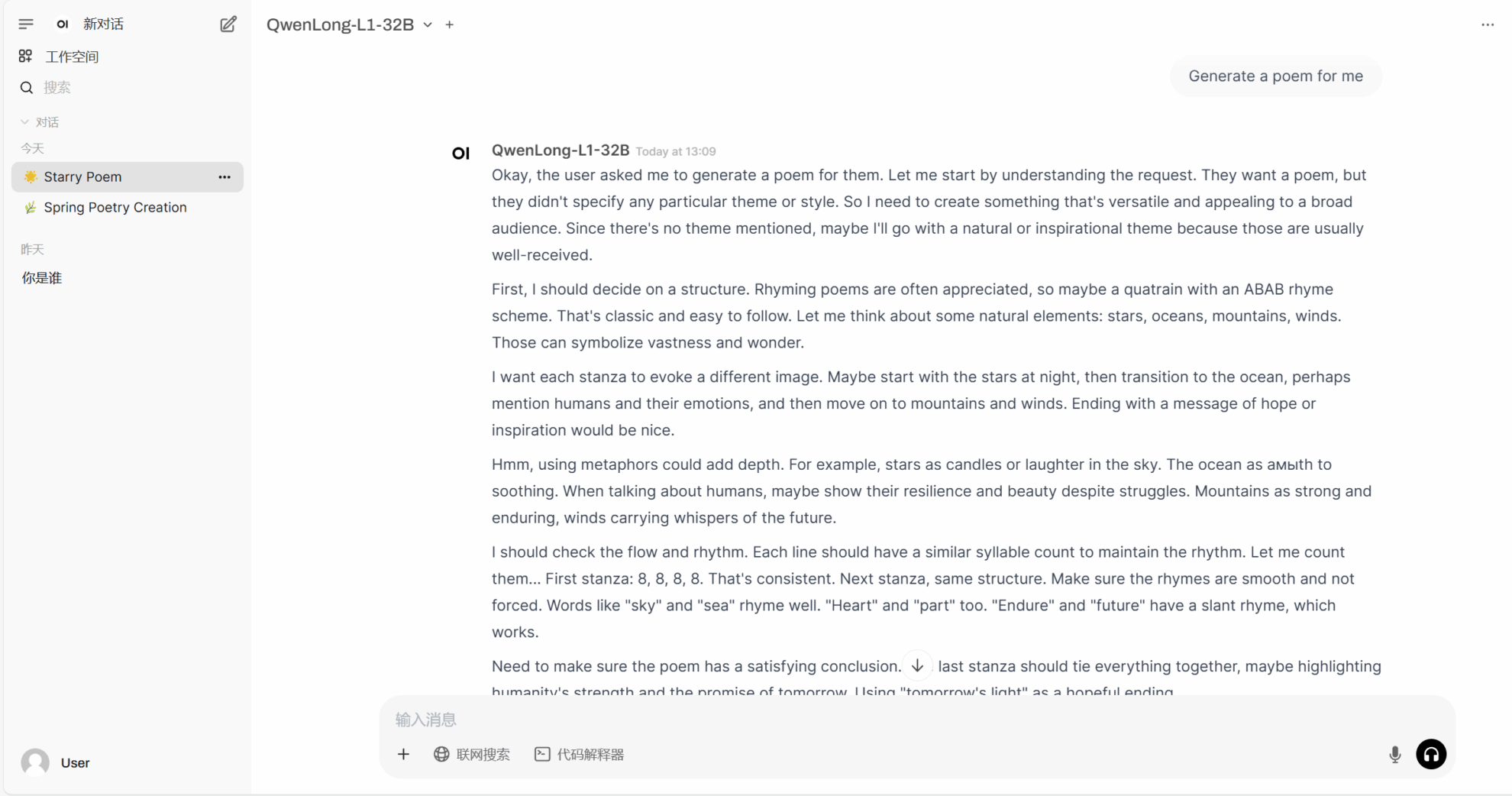

2. Projektbeispiele

3. Bedienungsschritte

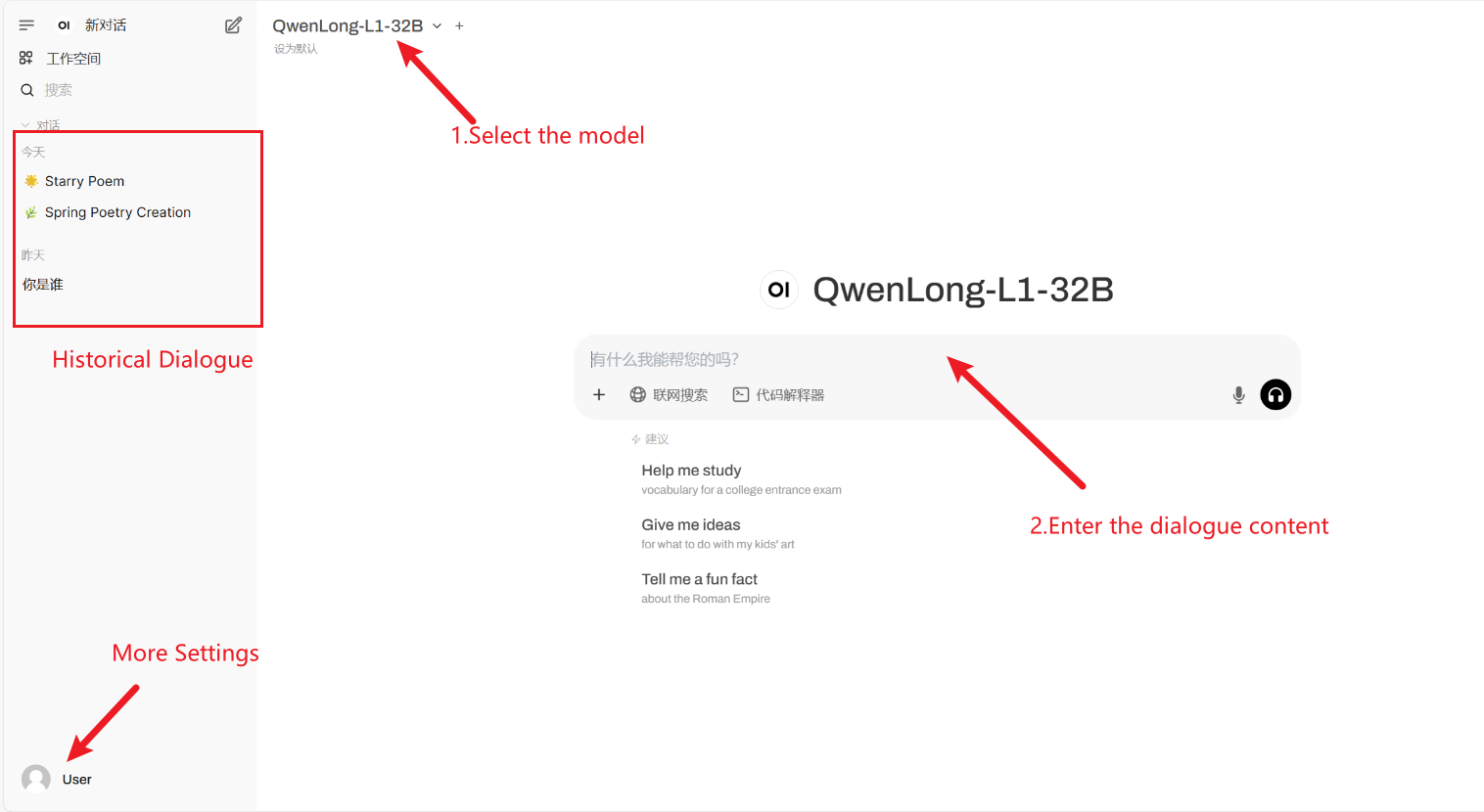

1. Klicken Sie nach dem Starten des Containers auf die API-Adresse, um die Weboberfläche aufzurufen

Wenn „Modell“ nicht angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte etwa 2–3 Minuten und aktualisieren Sie die Seite.

2. Nachdem Sie die Webseite aufgerufen haben, können Sie ein Gespräch mit dem Modell beginnen

Anwendung

4. Diskussion

🖌️ Wenn Sie ein hochwertiges Projekt sehen, hinterlassen Sie bitte im Hintergrund eine Nachricht, um es weiterzuempfehlen! Darüber hinaus haben wir auch eine Tutorien-Austauschgruppe ins Leben gerufen. Willkommen, Freunde, scannen Sie den QR-Code und kommentieren Sie [SD-Tutorial], um der Gruppe beizutreten, verschiedene technische Probleme zu besprechen und Anwendungsergebnisse auszutauschen ↓

Zitationsinformationen

Dank an den Github-Benutzer xxxjjjyyy1 Bereitstellung dieses Tutorials. Die Zitationsinformationen für dieses Projekt lauten wie folgt:

@article{wan2025qwenlongl1,

title={QwenLong-L1: : Towards Long-Context Large Reasoning Models with Reinforcement Learning},

author={Fanqi Wan, Weizhou Shen, Shengyi Liao, Yingcheng Shi, Chenliang Li, Ziyi Yang, Ji Zhang, Fei Huang, Jingren Zhou, Ming Yan},

journal={arXiv preprint arXiv:2505.17667},

year={2025}

}KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.