Command Palette

Search for a command to run...

vLLM+Open WebUI-Bereitstellung MiniCPM4-8B

1. Einführung in das Tutorial

MiniCPM 4.0, veröffentlicht von OpenBMB am 6. Juni 2025, ist ein leistungsstarkes Edge-basiertes Modell für große Sprachmodelle (LLM). Dank seiner Sparse-Architektur, Quantisierungskomprimierung und eines effizienten Inferenz-Frameworks ermöglicht es eine hohe Inferenzleistung bei geringem Rechenaufwand und eignet sich daher besonders für die Verarbeitung langer Texte, datenschutzrelevante Szenarien und den Einsatz auf Edge-Computing-Geräten. MiniCPM4-8B bietet im Vergleich zu Qwen3-8B eine deutlich höhere Verarbeitungsgeschwindigkeit bei der Verarbeitung langer Sequenzen. Zugehörige Forschungsarbeiten sind verfügbar. MiniCPM4: Ultraeffiziente LLMs auf Endgeräten .

Dieses Tutorial verwendet Ressourcen für eine einzelne RTX 4090-Karte.

2. Projektbeispiele

3. Bedienungsschritte

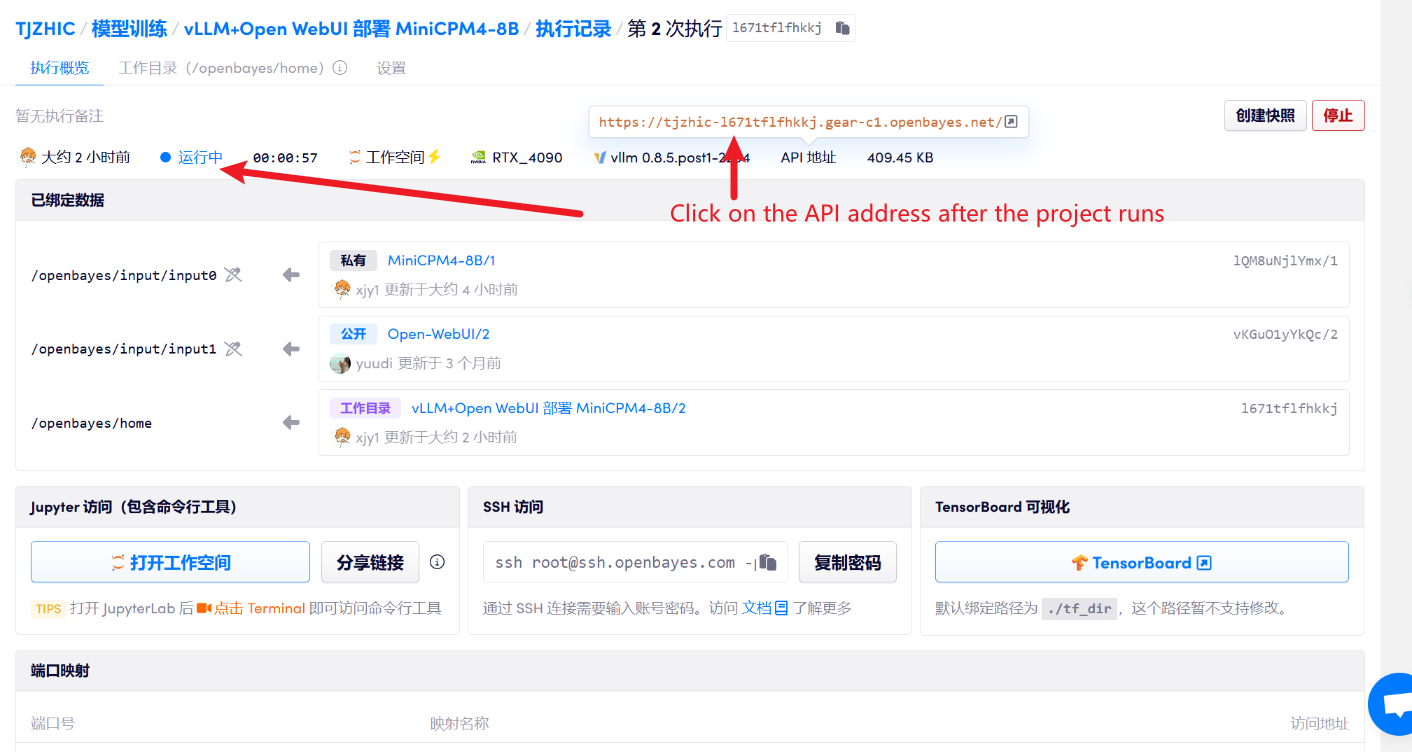

1. Klicken Sie nach dem Starten des Containers auf die API-Adresse, um die Weboberfläche aufzurufen

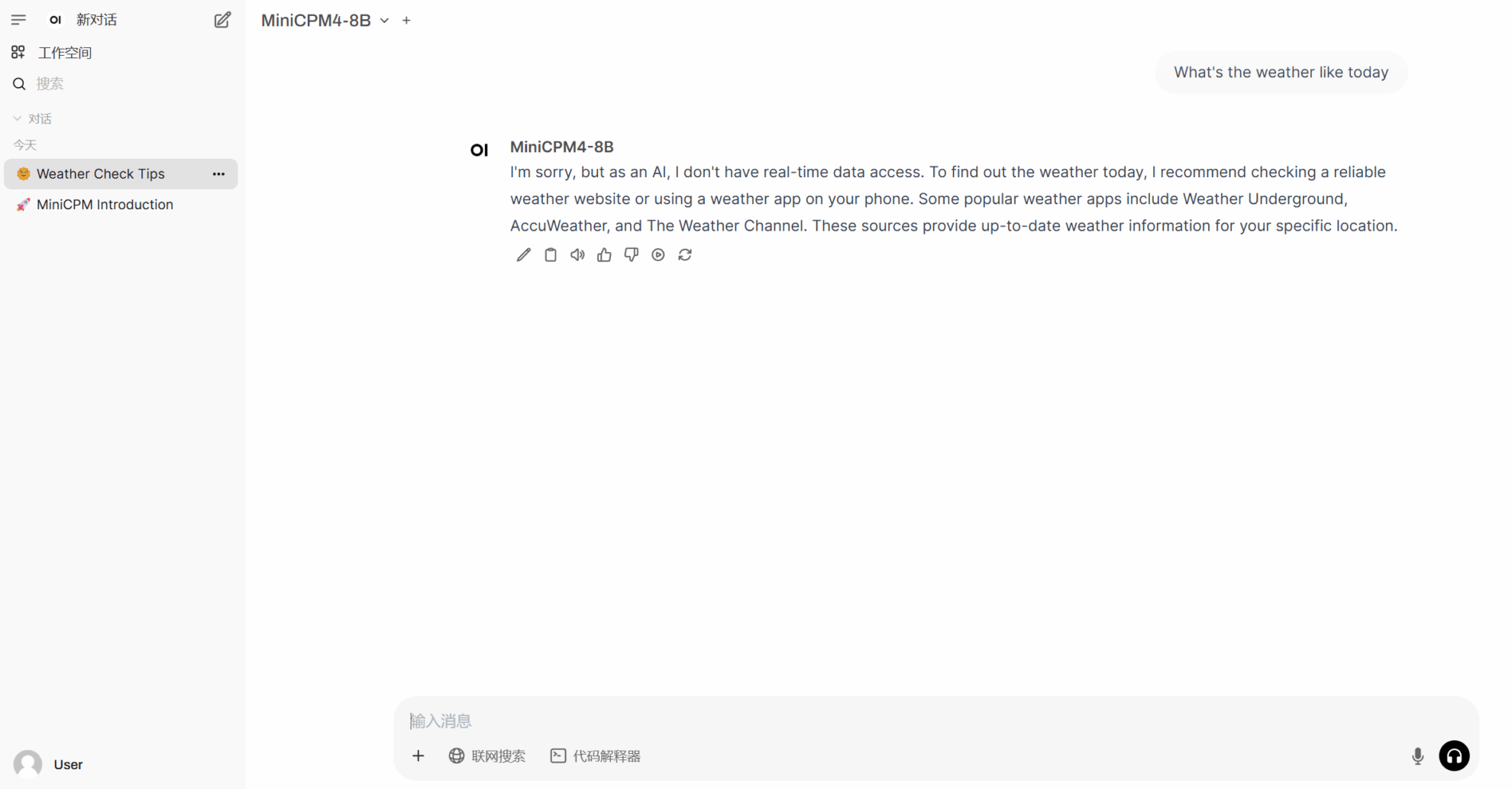

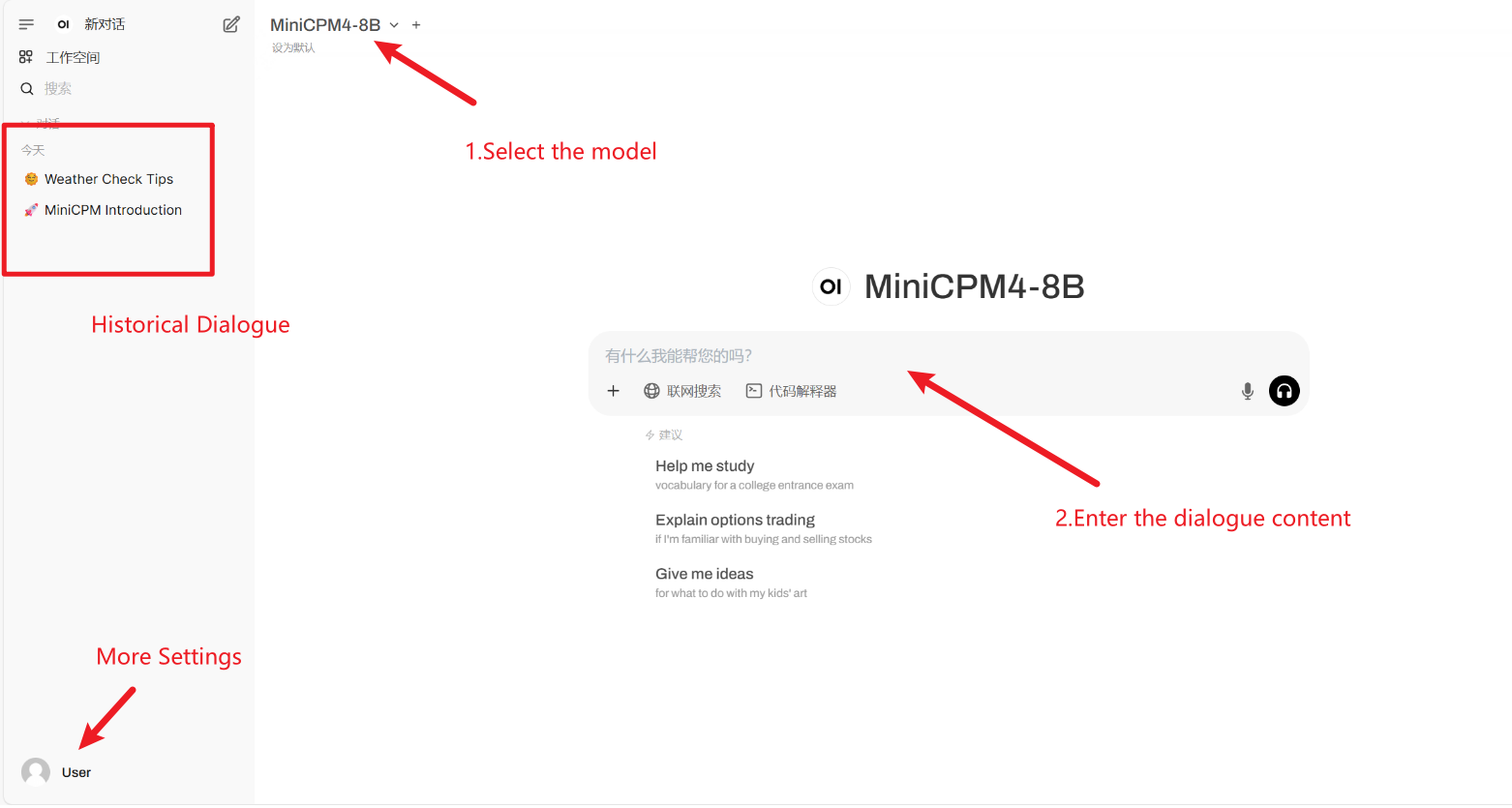

2. Nachdem Sie die Webseite aufgerufen haben, können Sie ein Gespräch mit dem Modell beginnen

Wenn „Modell“ nicht angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte etwa 2-3 Minuten und aktualisieren Sie die Seite.

Anwendung

4. Diskussion

🖌️ Wenn Sie ein hochwertiges Projekt sehen, hinterlassen Sie bitte im Hintergrund eine Nachricht, um es weiterzuempfehlen! Darüber hinaus haben wir auch eine Tutorien-Austauschgruppe ins Leben gerufen. Willkommen, Freunde, scannen Sie den QR-Code und kommentieren Sie [SD-Tutorial], um der Gruppe beizutreten, verschiedene technische Probleme zu besprechen und Anwendungsergebnisse auszutauschen ↓

Zitationsinformationen

Dank an den Github-Benutzer xxxjjjyyy1 Bereitstellung dieses Tutorials. Die Zitationsinformationen für dieses Projekt lauten wie folgt:

@article{minicpm4,

title={MiniCPM4: Ultra-Efficient LLMs on End Devices},

author={MiniCPM Team},

year={2025}

}

@inproceedings{huminicpm,

title={MiniCPM: Unveiling the Potential of Small Language Models with Scalable Training Strategies},

author={Hu, Shengding and Tu, Yuge and Han, Xu and Cui, Ganqu and He, Chaoqun and Zhao, Weilin and Long, Xiang and Zheng, Zhi and Fang, Yewei and Huang, Yuxiang and others},

booktitle={First Conference on Language Modeling},

year={2024}

}KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.