Command Palette

Search for a command to run...

Vchitect-2.0 Video-Diffusionsmodell-Demo

Datum

Größe

395.28 MB

Lizenz

Apache 2.0

GitHub

Paper-URL

Projektübersicht

Vchitect-2.0 ist ein hochwertiges Videogenerierungssystem, das im September 2024 vom Team des Shanghai Artificial Intelligence Laboratory entwickelt wurde. Dieses Modell nutzt eine innovative parallele Transformer-Architektur, verfügt über 2 Milliarden Parameter und kann flüssige, qualitativ hochwertige Videoinhalte auf Basis von Texteingaben generieren. Zugehörige Veröffentlichungen haben dies bereits erfolgreich umgesetzt. Vchitect-2.0: Paralleler Transformator zum Skalieren von Videodiffusionsmodellen .

Dieses Tutorial verwendet Ressourcen für eine einzelne Karte A6000.

Schritte ausführen

1. Klicken Sie nach dem Starten des Containers auf die API-Adresse, um die Weboberfläche aufzurufen

Wenn „Bad Gateway“ angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte etwa 1–2 Minuten und aktualisieren Sie die Seite.

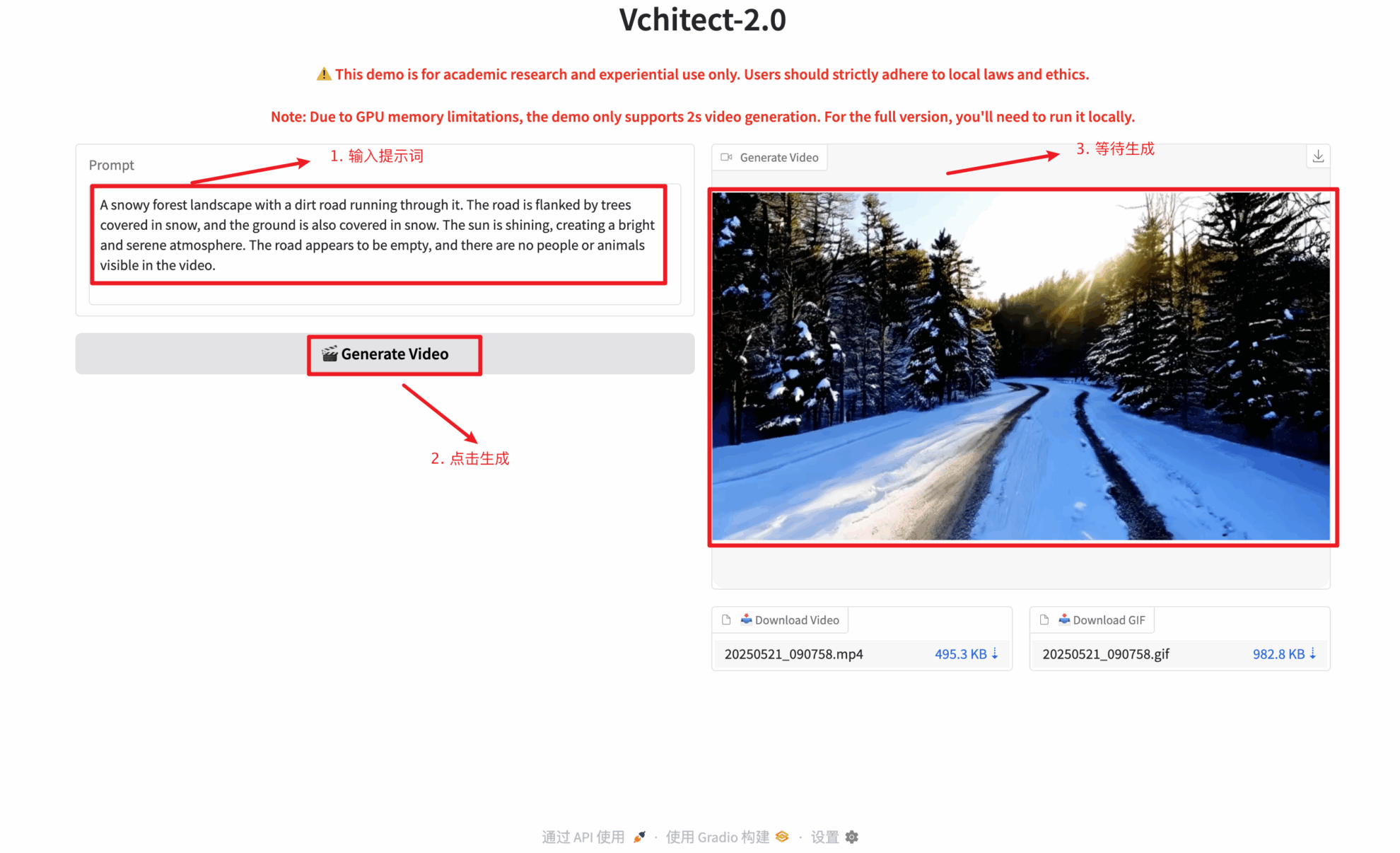

2. Sobald Sie die Webseite betreten, können Sie mit dem Modell interagieren

Sie müssen eine Texteingabe eingeben, um ein Video zu generieren. Die Texteingabe unterstützt nur Englisch. Die Texteingabe kann beliebig lang sein, es wird jedoch empfohlen, maximal 100 Zeichen zu verwenden. Andernfalls kann das generierte Video zu lang werden und die Videoqualität beeinträchtigen. Das Video benötigt ca. 2–5 Minuten Wartezeit. Bitte haben Sie Geduld.

Austausch und Diskussion

🖌️ Wenn Sie ein hochwertiges Projekt sehen, hinterlassen Sie bitte im Hintergrund eine Nachricht, um es weiterzuempfehlen! Darüber hinaus haben wir auch eine Tutorien-Austauschgruppe ins Leben gerufen. Willkommen, Freunde, scannen Sie den QR-Code und kommentieren Sie [SD-Tutorial], um der Gruppe beizutreten, verschiedene technische Probleme zu besprechen und Anwendungsergebnisse auszutauschen ↓

Zitationsinformationen

Dank an den Github-Benutzer zhangjunchang Für die Bereitstellung dieses Lernprogramms lauten die Projektreferenzinformationen wie folgt:

@article{fan2025vchitect,

title={Vchitect-2.0: Parallel Transformer for Scaling Up Video Diffusion Models},

author={Fan, Weichen and Si, Chenyang and Song, Junhao and Yang, Zhenyu and He, Yinan and Zhuo, Long and Huang, Ziqi and Dong, Ziyue and He, Jingwen and Pan, Dongwei and others},

journal={arXiv preprint arXiv:2501.08453},

year={2025}

}

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.