Command Palette

Search for a command to run...

PixelFlow: Eine Lösung Zur Bildgenerierung Im Pixelbereich

Datum

Größe

52.78 MB

Lizenz

Other

GitHub

Paper-URL

1. Einführung in das Tutorial

Das im April 2025 vom Adobe-Team an der Universität Hongkong veröffentlichte Projekt PixelFlow ist eine Reihe von KI-Bildgenerierungsmodellen, die direkt im ursprünglichen Pixelraum arbeiten – im Gegensatz zu den gängigen Modellen, die mit dem latenten Raum arbeiten. Verwandte Veröffentlichungen umfassen… PixelFlow: Generative Pixel-Space-Modelle mit Flow .

Dieser Ansatz vereinfacht den Bildgenerierungsprozess, da kein vortrainierter Variational Autoencoder (VAE) mehr erforderlich ist und das gesamte Modell durchgängig trainierbar ist. Durch effiziente Kaskadenflussmodellierung erreicht PixelFlow erschwingliche Rechenkosten im Pixelraum. Es erreicht einen FID von 1,98 im 256×256 ImageNet-Benchmark für die klassenbedingte Bildgenerierung. Qualitative Ergebnisse der Text-zu-Bild-Konvertierung zeigen, dass PixelFlow hinsichtlich Bildqualität, künstlerischer Gestaltung und semantischer Kontrolle gute Leistungen erbringt. Wir hoffen, dass dieses neue Paradigma die nächste Generation generativer Visionsmodelle inspirieren und neue Möglichkeiten eröffnen wird.

Dieses Tutorial verwendet Ressourcen für eine einzelne RTX 4090-Karte.

👉 Dieses Projekt bietet ein Modell für:

- Klasse zu Bild: Es erreicht einen FID von 1,98 im 256×256 ImageNet-Benchmark für die klassenbedingte Bildgenerierung.

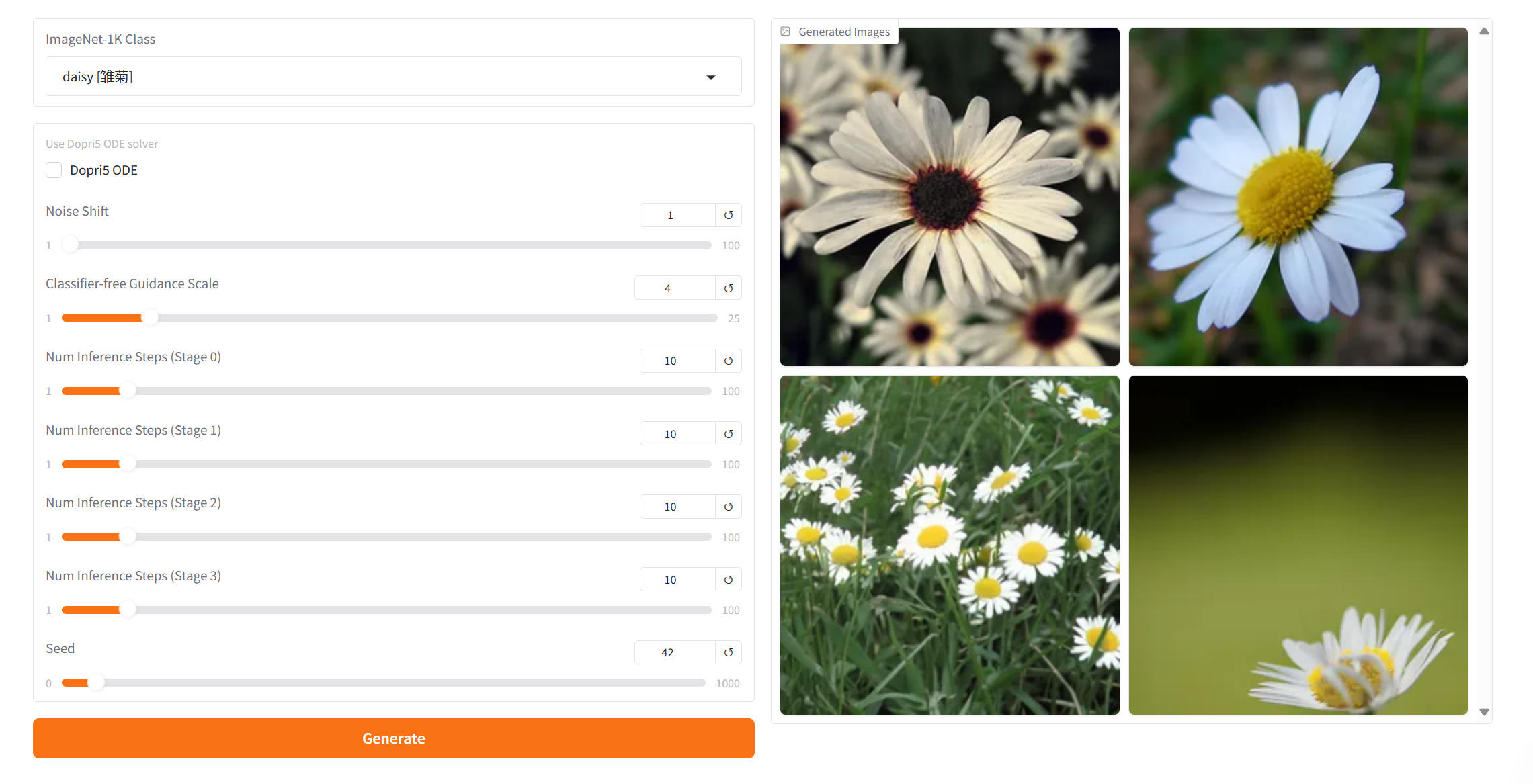

Projektbeispiele

2. Bedienungsschritte

1. Klicken Sie nach dem Starten des Containers auf die API-Adresse, um die Weboberfläche aufzurufen

Wenn „Bad Gateway“ angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte etwa 1–2 Minuten und aktualisieren Sie die Seite.

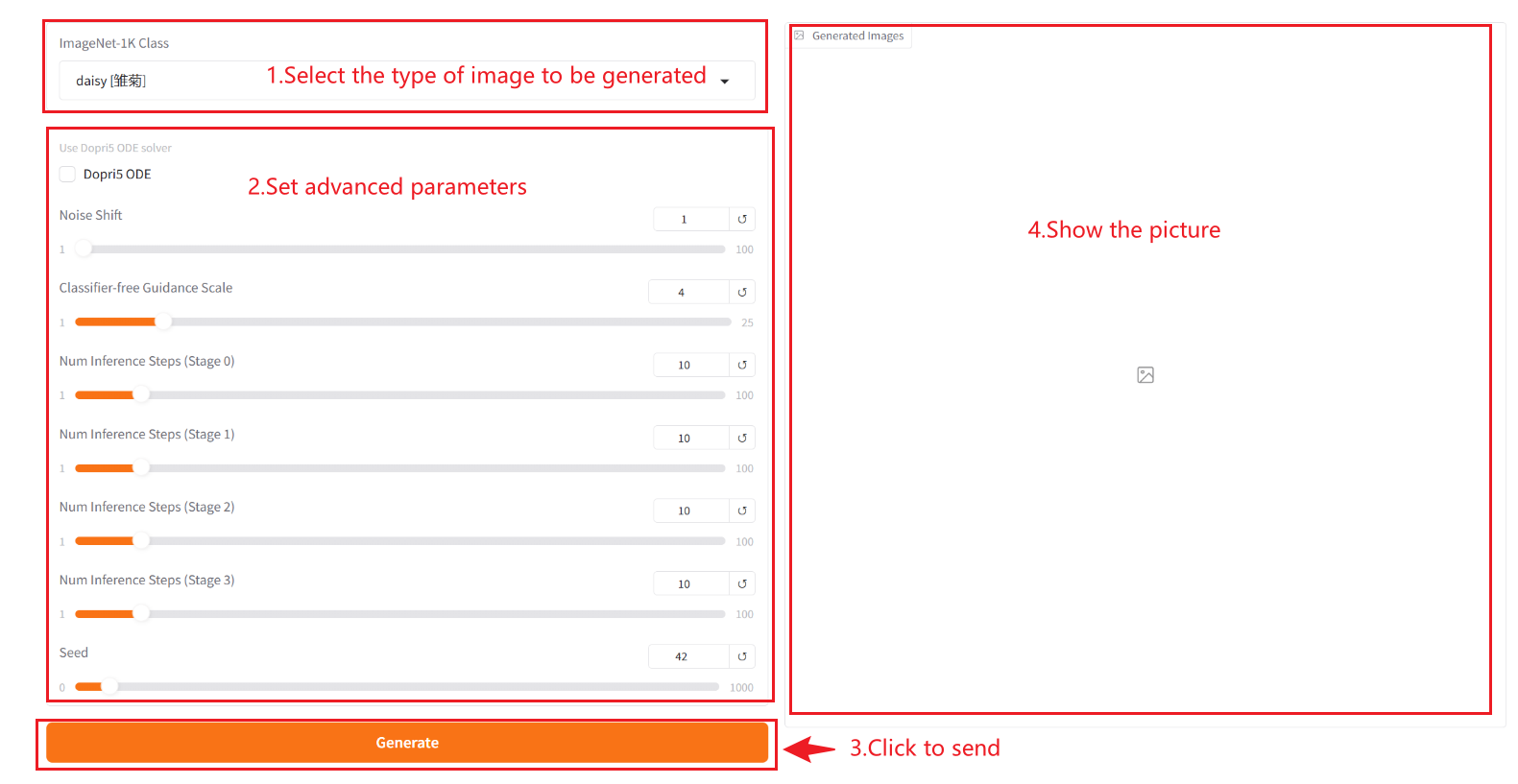

2. Nachdem Sie die Webseite aufgerufen haben, können Sie ein Gespräch mit dem Modell beginnen

❗️Wichtige Anwendungstipps:

- ImageNet-1k-Klasse: Die generierten Bilder können nur aus den im Dropdown-Feld angegebenen Kategorien ausgewählt werden und können nicht angepasst werden.

- Dopri5 ODE: Es handelt sich um einen adaptiven Dormand-Prince-ODE-Solver mit fünfter Schrittweite und wird aktiviert, wenn eine Generierung in hoher Qualität erforderlich ist (z. B. Generierung von hochauflösenden Bildern).

- Rauschverschiebung: Steuert den Offset des Rauschens im Generierungsprozess. Ein höherer Wert erhöht die Intensität des Rauschens und macht die generierten Ergebnisse zufälliger und vielfältiger. Ein kleinerer Wert verringert die Störungen durch das Rauschen und sorgt dafür, dass die generierten Ergebnisse näher an der Verteilung der Trainingsdaten liegen (konservativer).

- Klassifikatorfreie Orientierungsskala: Es wird verwendet, um zu steuern, inwieweit bedingte Eingaben (wie Text oder Bilder) in generativen Modellen die generierten Ergebnisse beeinflussen. Höhere Richtwerte führen dazu, dass die generierten Ergebnisse besser mit den Eingabebedingungen übereinstimmen, während niedrigere Werte mehr Zufälligkeit beibehalten.

- Anzahl der Inferenzschritte [Stufe 0]: Stellt die Anzahl der Iterationen des Modells oder die Anzahl der Schritte im Inferenzprozess dar und stellt die Anzahl der Optimierungsschritte dar, die das Modell zum Generieren des Ergebnisses verwendet. Eine höhere Anzahl von Schritten führt im Allgemeinen zu genaueren Ergebnissen, kann aber die Rechenzeit verlängern. [Stufe 0] gibt das generierte Bild an. Die Zahl dahinter plus 1 gibt die Kapitelnummer an. Insgesamt sind es vier Bilder.

- Samen: Ist der Startwert der Zufallszahl, der zur Steuerung der Zufälligkeit des Generierungsprozesses verwendet wird. Derselbe Seed-Wert kann dieselben Ergebnisse erzeugen (vorausgesetzt, dass die anderen Parameter gleich sind), was für die Reproduktion von Ergebnissen sehr wichtig ist.

Anwendung

Zitationsinformationen

Die Zitationsinformationen für dieses Projekt lauten wie folgt:

@article{chen2025pixelflow,

title={PixelFlow: Pixel-Space Generative Models with Flow},

author={Chen, Shoufa and Ge, Chongjian and Zhang, Shilong and Sun, Peize and Luo, Ping},

journal={arXiv preprint arXiv:2504.07963},

year={2025}

}

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.