Command Palette

Search for a command to run...

Paints-Undo-Demo Des Gesamten Prozesses Zum Erstellen Eines Gemäldes Aus Einem Bild

Einführung in das Tutorial

Dieses Tutorial ist eine Demo von PaintsUndo, die Sie mit einem Klick ausführen können. Die relevante Umgebung und die Abhängigkeiten wurden installiert. Sie können es erleben, indem Sie es klonen und mit einem Klick starten.

PaintsUndo ist ein Basismodell, das menschliches Malverhalten simulieren kann. Ziel ist es, ein grundlegendes Modell des Malverhaltens des Menschen bereitzustellen. Gleichzeitig besteht die Hoffnung, dass zukünftige KI-Modelle den tatsächlichen Bedürfnissen menschlicher Künstler besser gerecht werden können. Dieses Projekt bietet eine Reihe von Modellen, die ein Bild als Eingabe verwenden und eine Folge von Zeichnungen dieses Bildes ausgeben. Das Modell simuliert das menschliche Verhalten während des Zeichenprozesses, einschließlich, aber nicht beschränkt auf Skizzieren, Einfärben, Schattieren, Transformieren, Spiegeln nach links und rechts, Anpassen von Farbkurven, Ändern der Ebenensichtbarkeit und sogar Ändern der Gesamtidee während des Zeichenprozesses. Der Name „Paints-Undo“ wurde von der Ähnlichkeit inspiriert, dass die Ausgabe des Modells so aussieht, als würde man in einer KI-Malsoftware mehrmals die Schaltfläche „Rückgängig“ (normalerweise Strg+Z) drücken.

Das Projekt veröffentlicht derzeit zwei Modelle: ein Single-Frame-Modell und ein Multi-Frame-Modell.

- paints_undo_single_frame

- malt_undo_multi_frame

Das Einzelbildmodell verwendet ein Bild und ein als Eingabe und gibt ein Bild aus.

- Gehen Sie davon aus, dass das Kunstwerk immer durch 1000 manuelle Zeichnungen erstellt werden kann und die Reihenfolge der Zeichnungen eine Ganzzahl zwischen 0 und 999 ist. Die durch 0 dargestellte Reihenfolge ist das endgültige Kunstwerk und 999 ist der erste Pinselstrich, der auf die rein weiße Leinwand gemalt wurde. Dieses Modell kann als das „Rückgängig“-Modell (oder Strg+Z-Modell) betrachtet werden.

- Geben Sie das endgültige Bild ein und geben Sie an, wie oft Sie „Strg+Z“ drücken möchten. Nach dem Drücken von „Strg+Z“ generiert das Modell entsprechend viele Screenshots vom Malvorgang. Wenn die ausgewählte Anzahl 100 beträgt, bedeutet dies, dass Sie „Strg+Z“ 100 Mal auf diesem Bild simulieren möchten, um nach 100-maligem Drücken von „Strg+Z“ einen Screenshot zu erhalten.

Das Multi-Frame-Modell verwendet zwei Bilder als Eingabe und gibt 16 Zwischenbilder zwischen den beiden Eingabebildern aus.

- Im Vergleich zum Einzelbildmodell ist der Unterschied zwischen den beiden Bildern geringer, die Geschwindigkeit ist jedoch auch viel langsamer und weniger zufällig.

- Die Bildgenerierung ist auf 16 Frames begrenzt.

In den Build-Methoden dieses Projekts besteht die Standardmethode darin, sie zusammen zu verwenden. Verwenden Sie zunächst das Einzelbildmodell, um etwa 5–7 Mal zu inferieren, um 5–7 „Schlüsselbilder“ zu erhalten, und verwenden Sie dann das Mehrbildmodell, um diese Schlüsselbilder zu „interpolieren“, um tatsächlich ein relativ langes Video zu generieren. Am Ende sind es meist etwa 100 Zwischenbilder.

Theoretisch kann das System auf verschiedene Weise verwendet werden, sogar um unendlich lange Videos bereitzustellen. In der Praxis funktioniert es derzeit jedoch am besten, wenn die endgültige Bildanzahl bei etwa 100 bis 500 liegt.

Dieses Tutorial verwendet eine einzelne RTX 5090-Karte als Ressource.

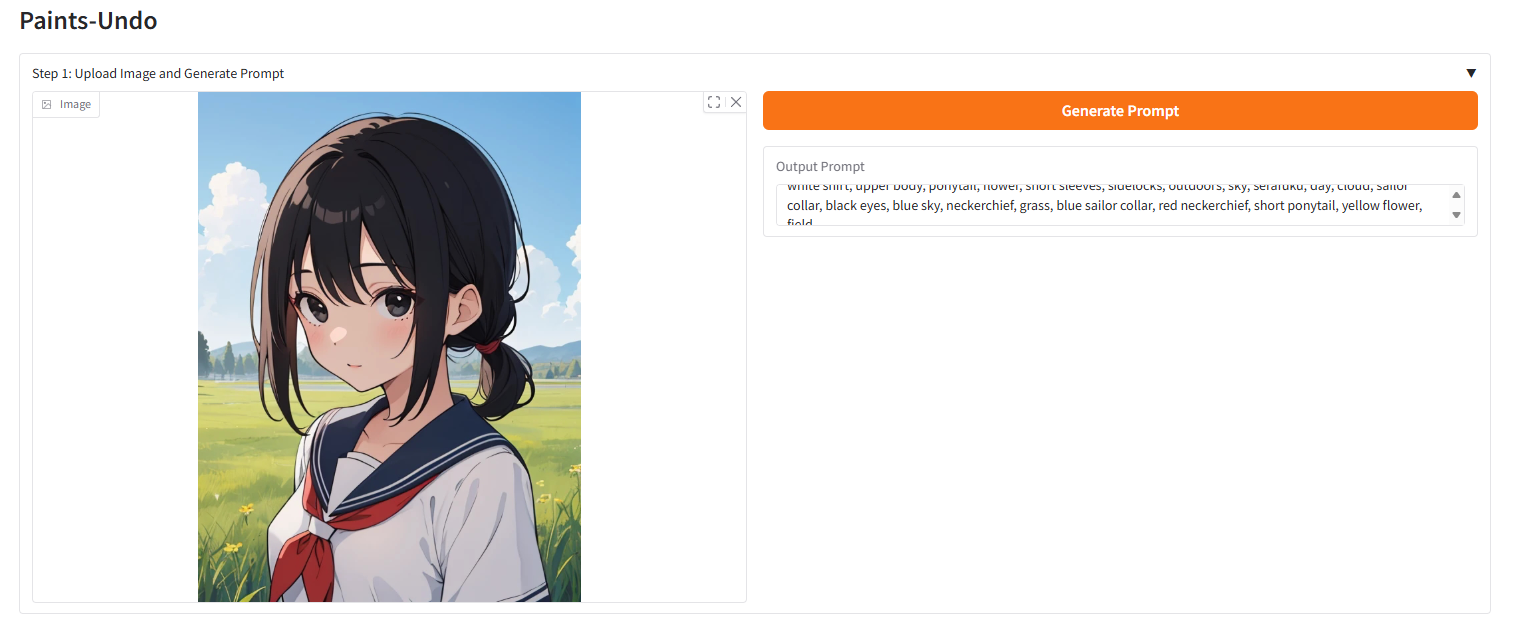

Effektanzeige

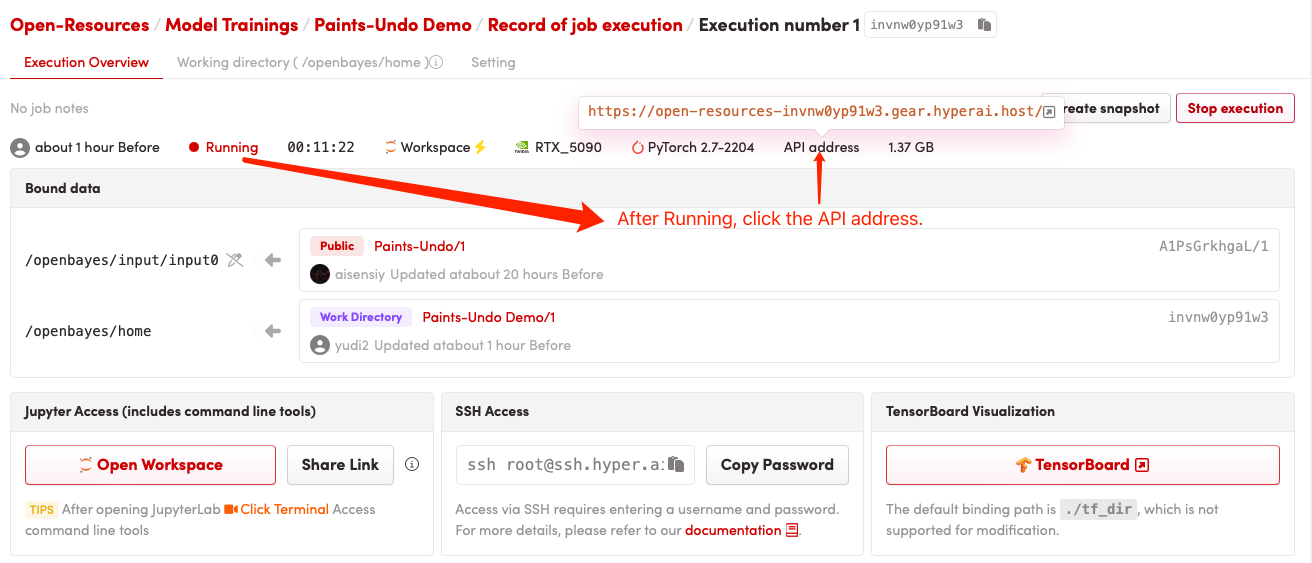

Ausführungsmethode (nach dem Starten des Containers dauert die Initialisierung etwa 10 Sekunden, anschließend werden die folgenden Vorgänge ausgeführt)

1. Kopieren Sie nach dem Klonen und Starten des Containers die API in Ihren Browser

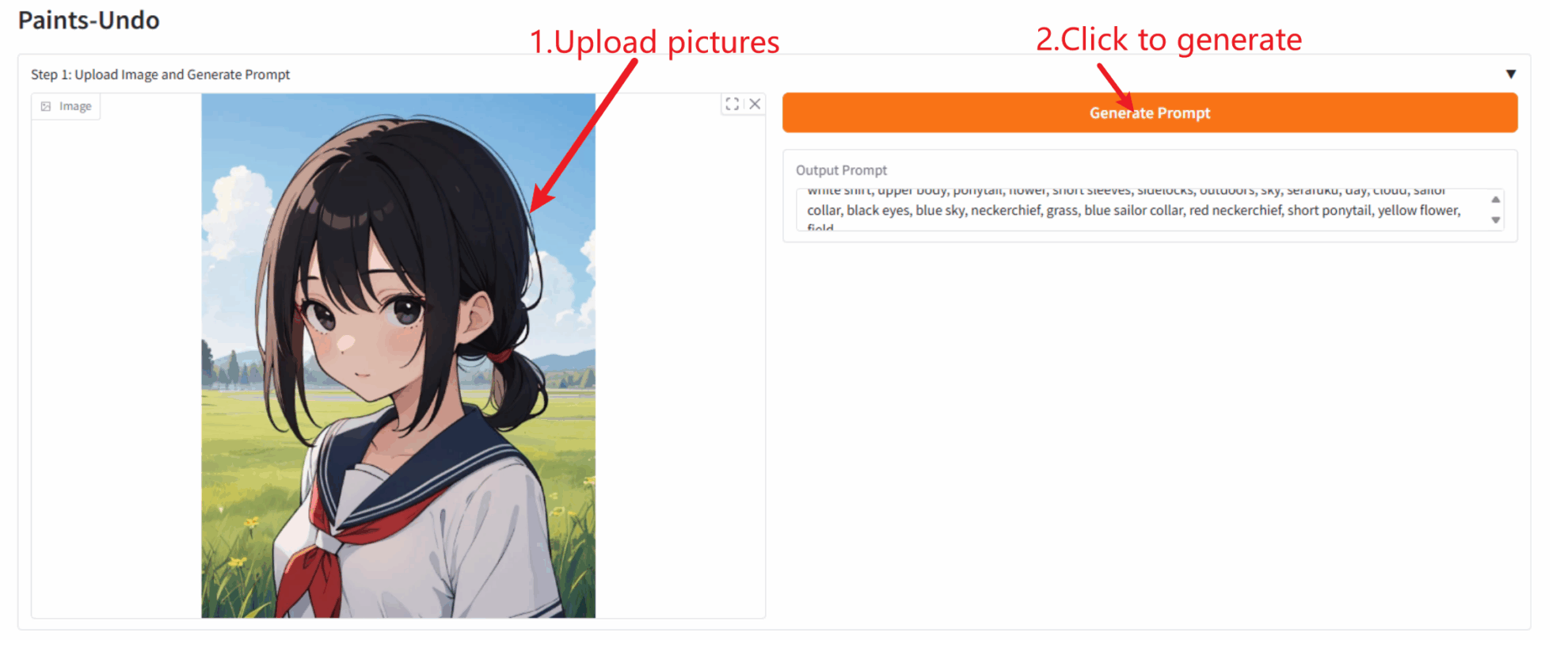

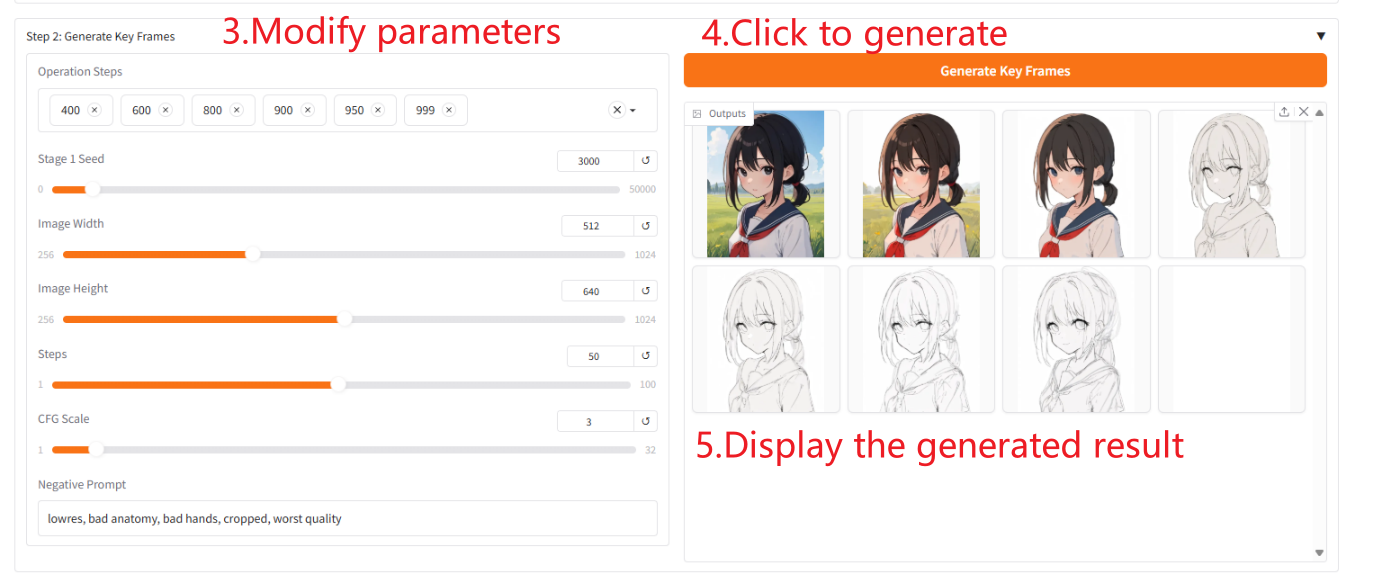

2. Anwendungsschritte

Wenn „Bad Gateway“ angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte etwa 2–3 Minuten und aktualisieren Sie die Seite.

Einzelbildmodellausgabe

Gesamtmodellausgabe

Parameterbeschreibung

- „Operationsschritte“: Sie können die Reihenfolge der auszugebenden Keyframes auswählen. Je größer die von Ihnen gewählte Ordnung ist, desto ähnlicher wird das generierte Bild dem Originalbild.

- „Stage 1 Seed“: Sie können einen Seed für die Keyframe-Generierung zufällig auswählen.

- „Schritte“: Sie können die Anzahl der Schritte auswählen, die das Modell pro Frame ausführt.

- „CFG-Skala“: Sie können die Zufälligkeit des generierten Bildes steuern. Je kleiner der Wert, desto zufallsabhängiger ist das erzeugte Bild.

- „Nagative Eingabeaufforderung“: Füllen Sie negative Wörter aus, um die Situation zu verbessern, in der die generierten Bilder diese negativen Wörter enthalten.

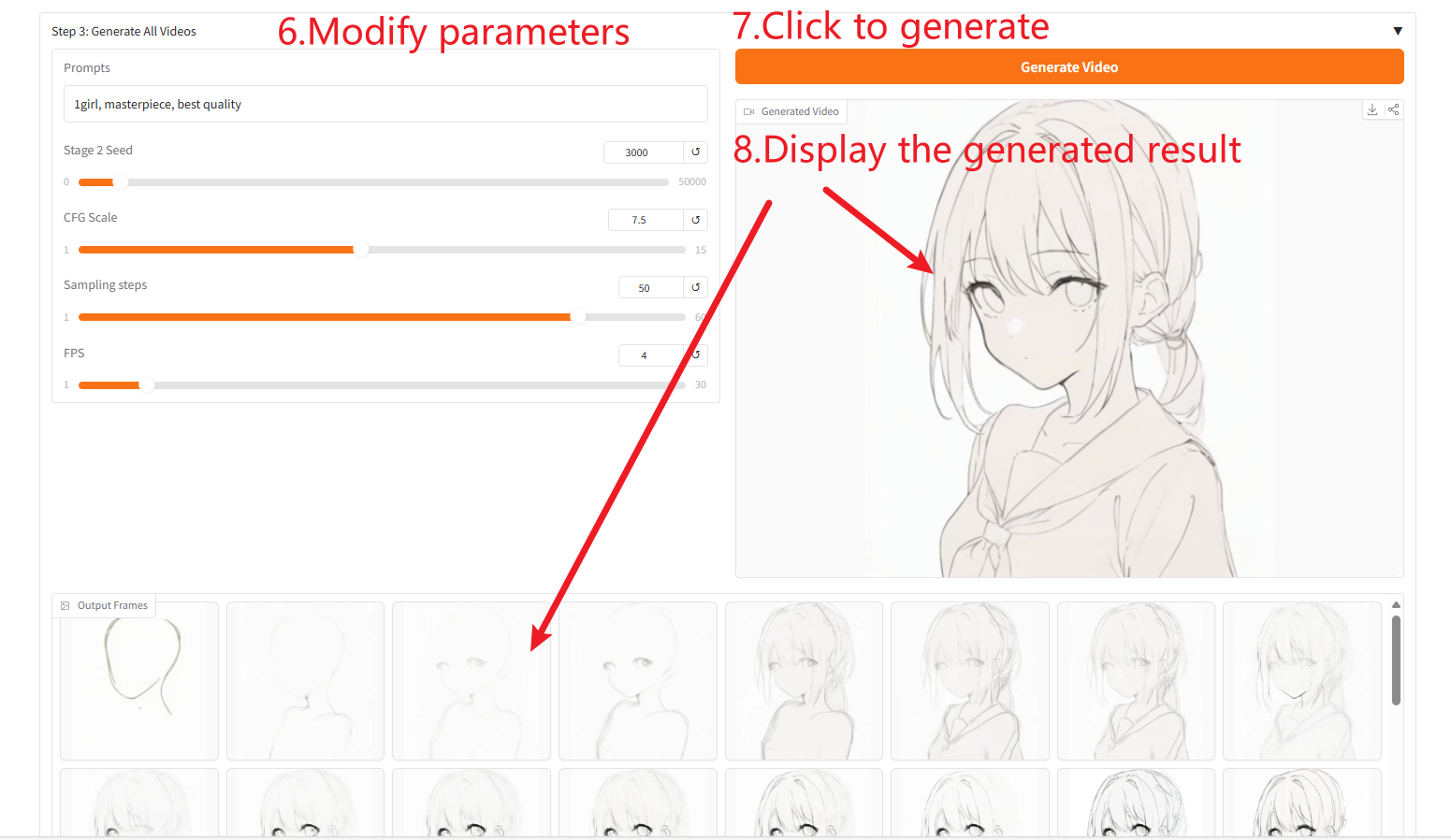

Video generieren

Parameterbeschreibung

- „Eingabeaufforderungen“: Geben Sie positive Eingabeaufforderungen ein, um die Qualität und den Inhalt der generierten Bilder zu verbessern.

- „Stage 2 Seed“: Sie können Seeds für die Bildgenerierung zufällig auswählen.

- „CFG-Skala“: Sie können die Zufälligkeit des generierten Bildes steuern. Je kleiner der Wert, desto zufallsabhängiger ist das erzeugte Bild.

- „Sampling-Schritte“: Sie können die Anzahl der Iterationen des Samplings ändern. Je größer der Wert, desto genauer ist das generierte Bild.

- „FPS“: Sie können die Bildrate des generierten Videos ändern. Der Standardwert beträgt 4 Frames, was bedeutet, dass das Video vier generierte Bilder pro Sekunde enthält.

Zitationsinformationen

Die Zitationsinformationen für dieses Projekt lauten wie folgt:

@Misc{paintsundo,

author = {Paints-Undo Team},

title = {Paints-Undo GitHub Page},

year = {2024},

}

@article{paintsalter,

author = {Zhang, Lvmin and Yan, Chuan and Guo, Yuwei and Xing, Jinbo and Agrawala, Maneesh},

title = {Generating Past and Future in Digital Painting Processes},

journal = {ACM Transactions on Graphics (SIGGRAPH 2025)},

year = {2025},

volume = {44},

number = {4},

articleno = {127},

numpages = {13},

}KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.