Command Palette

Search for a command to run...

Im Gespräch Mit Dem Co-Autor Des Nature-Titelartikels Über Die Forschungsgeschichte Der Bewegung

Am 17. Oktober fand die Veranstaltung „Von AlphaGo zum gehirnähnlichen Tianji-Chip: Wohin entwickelt sich die künstliche Intelligenz?“ statt. Die Veranstaltung, organisiert vom Spark Forum der Tsinghua University Association for Science and Technology, dem Brain-Like Computing Research Center der Tsinghua University und HyperAI, fand erfolgreich im Meng Minwei-Gebäude der Tsinghua University statt. Beim Eröffnungsforum am runden Tisch berichtete Deng Lei, Tsinghuas erster Doktorand auf dem Gebiet des gehirnähnlichen Computing, von seinen Erfahrungen mit dem gehirnähnlichen Computing, interpretierte das gehirnähnliche Computing aus mehreren Perspektiven, beantwortete Fragen der Studenten und vermittelte uns ein neues Verständnis für die Entwicklung des gehirnähnlichen Computing und der künstlichen Intelligenz.

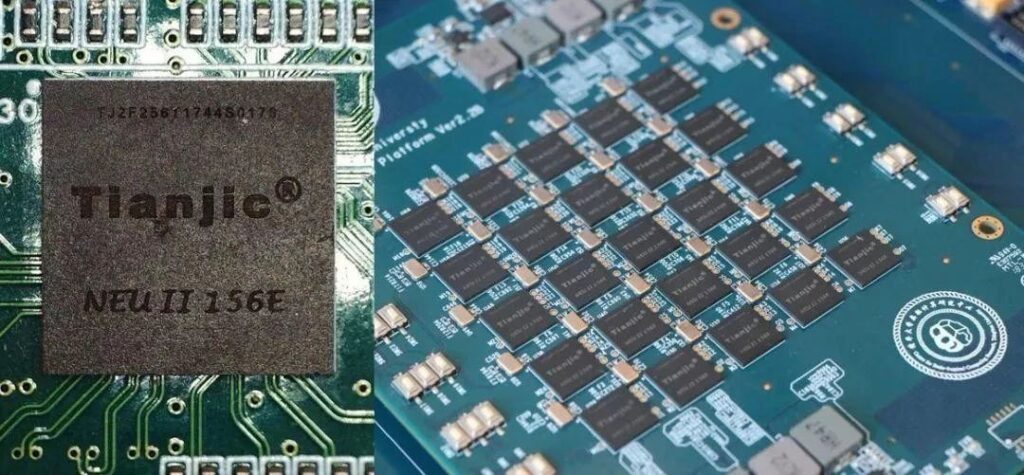

Deng Lei ist der erste Doktorand der Tsinghua-Universität im Bereich Brain-Inspired Computing und Postdoktorand an der University of California, Santa Barbara. Das Cover der Ausgabe vom 1. August des Magazins Nature zeigt den ArtikelHeterogene Tianjic-Chiparchitektur für künstliche allgemeine Intelligenzwar als Erstautor für das Chipdesign und die Algorithmusdetails verantwortlich.

Letzten Donnerstag veranstaltete das Spark Forum der Tsinghua University Association for Science and Technology in Zusammenarbeit mit dem Brain-Inspired Computing Research Center der Tsinghua University und HyperAI ein Forum mit dem Thema „Von AlphaGo zum Brain-Inspired Tianji Chip, wohin geht die Reise der künstlichen Intelligenz?“ Deng Lei wurde als besonderer Gast eingeladen und teilte einige seiner Ansichten in Form eines Rundtischforums. In diesem Artikel werden die Fragen aus dem Forum aufgegriffen und einige seiner Erkenntnisse im Bereich der KI und des gehirnähnlichen Computing besprochen.

Lernen und Entdecken: Der erste Doktorand am Center for Brain-Inspired Computing

Frage: Wie sind Sie zum Forschungsgebiet des Brain-Like Computing gekommen? Was genau beinhaltet dieses Thema?Als ich im Bereich Brain-Like Computing promovierte, war dieses Thema noch nicht weit verbreitet. Ich habe damals danach gesucht, aber nicht viele nützliche Informationen gefunden. Später habe ich meinen Vorgesetzten ausdrücklich gefragt ...

Als erster Doktorand am Brain-Inspired Computing Research Center habe ich die Entwicklung des Zentrums von den Anfängen bis zu seinem heutigen Stand miterlebt.Dazu gehört auch, später ein Unternehmen zu gründen und Forschung zu betreiben. Nach meinem Abschluss im Jahr 2017 ging ich in die USA und wechselte dann zur Informatik. Jetzt haben wir 50% für Theorie und 50% für Chips.

Im Grundstudium hatte ich Mechanik als Schwerpunkt, später stellte ich jedoch fest, dass ich für Mechanik nicht viel Talent hatte, und wechselte daher allmählich zum Instrumentenbau. Später habe ich auch Roboter gebaut und einige Werkstoffe und Mikroelektronik studiert. Danach begann ich, an einigen Algorithmen und Theorien der KI zu arbeiten, wechselte schließlich zu Chips und betrat langsam das Feld der gehirnähnlichen Computertechnik.Der Prozess läuft wahrscheinlich so ab: Machen Sie weiter und lernen Sie dabei weiter.

Hinweis: Das Forschungszentrum für Brain-Inspired Computing der Tsinghua-Universität wurde im September 2014 gegründet und deckt mehrere Ebenen ab, darunter Grundlagentheorie, vom Gehirn inspirierte Chips, Software, Systeme und Anwendungen. Dieses Zentrum wurde gemeinsam von sieben Schulen und Abteilungen der Tsinghua-Universität gegründet und vereint Disziplinen wie Gehirnforschung, Elektronik, Mikroelektronik, Computer, Automatisierung, Materialien und Präzisionsinstrumente.

Die Forschung zum Brain-Like Computing erfordert die bereichsübergreifende Integration mehrerer Disziplinen.Die Quelle ist definitivMedizin (Gehirnforschung)Die heutige künstliche Intelligenz wurde ursprünglich aus der Psychologie und Medizin abgeleitet, die einige Grundlagen für das Modell lieferten.

Als nächstesmaschinelles LernenSie werden in Zukunft definitiv zusammengeführt, werden jetzt aber getrennt diskutiert, da maschinelles Lernen in der Produktentwicklung mehr Erfahrung hat und normalerweise aus einer Anwendungsperspektive betrachtet wird.

ZusätzlichInformatikJetzt gibt es Probleme, die GPUs nicht lösen können, daher haben Alibaba und Huawei begonnen, ihre eigenen dedizierten Chips herzustellen. Auch Studierende der Informatikarchitektur können eine Entwicklung in diese Richtung in Erwägung ziehen.

Weiter unten istChips und andere HardwareDabei geht es um Mikroelektronik und sogar Materialien, da wir einige neue Geräte bereitstellen müssen. Derzeit verwenden wir noch einige sehr einfache Speichereinheiten, aber in Zukunft wird es sicherlich einige neue Geräte geben, wie etwa Kohlenstoffnanoröhren, Graphen und andere Materialien, die eingesetzt werden können.

ZusätzlichAutomatisierungsrichtungViele Leute, die sich mit maschinellem Lernen beschäftigen, kommen normalerweise aus den Informatik- und Automatisierungsabteilungen, da es bei der Automatisierung um Steuerung und Optimierung geht, was dem maschinellen Lernen ähnelt. Beim Brain-Like Computing sind diese Disziplinen gut integriert.

Frage: Was war die treibende Kraft oder Gelegenheit, die Sie dazu bewogen hat, diese Richtung einzuschlagen?

Mit einem Wort:Der größte Reiz dieser Richtung besteht darin, dass sie nie fertig ist.

Ich habe einmal über ein philosophisches Paradoxon nachgedacht: Das Studium der gehirnähnlichen Informatik ist untrennbar mit dem menschlichen Gehirn verbunden, doch wenn wir das menschliche Gehirn verwenden, um über das menschliche Gehirn nachzudenken, wissen wir nicht, wie weit wir gelangen können, und das Studium wird nie enden. Denn das Denken des Menschen über sich selbst wird es immer geben. Es wird immer einen Höhepunkt geben, dann eine Flaute, und plötzlich kommt es zum Durchbruch. Es wird nie aufhören. Diese Perspektive ist eine Untersuchung wert.

Frage: Welche Unterschiede gibt es in Ihrer Forschung während Ihrer aktuellen Postdoc-Zeit?

Als ich an der Tsinghua-Universität an Chips arbeitete, war ich eher an praktischen Aspekten interessiert und dachte, ich könnte ein Gerät oder ein Instrument herstellen. Aber nachdem ich in die Vereinigten Staaten gegangen war, betrachtete ich dieses Thema eher aus einer disziplinären Perspektive, beispielsweise aus der Computerarchitektur von Informatikstudenten und vielen ACM Turing Awards, die das Problem alle aus dieser Perspektive betrachten. Obwohl wir dasselbe tun, sind die Denkansätze unterschiedlich.

Aus der Perspektive der ComputerarchitekturJeder Chip besteht aus drei Teilen: Recheneinheit, Speichereinheit und Kommunikationseinheit.Egal, was Sie tun, es fällt in den Rahmen dieser drei Dinge.

Tianji-Chip und gehirnähnliches Computing: Fahrräder stehen nicht im Mittelpunkt

Frage: Dieser Artikel in Nature ist ein Meilenstein. Welche Meilensteine gab es Ihrer Meinung nach in den letzten Jahrzehnten? Welche Ereignisse haben im Bereich des gehirnähnlichen Computing die Entwicklung der Branche vorangetrieben?

Das Gebiet des gehirnähnlichen Computing ist relativ komplex. Wenn ich es aus dem Kontext der künstlichen Intelligenz herauslöse, wird es klarer. Künstliche Intelligenz ist keine einzelne Disziplin und kann grundsätzlich in vier Richtungen unterteilt werden.

Das erste ist der Algorithmus, das zweite sind die Daten, das dritte ist die Rechenleistung und das letzte sind die Programmiertools.Meilensteinereignisse können aus diesen vier Perspektiven betrachtet werden.

Bei den Algorithmen handelt es sich natürlich um tiefe neuronale Netzwerke, daran besteht kein Zweifel; Aus Datensicht ist ImagNet ein Meilenstein. Ohne die Unterstützung von Big Data wären tiefe neuronale Netzwerke beinahe untergegangen. Aus Sicht der Rechenleistung ist die GPU eine großartige Erfindung. Programmiertools, beispielsweise beliebte Anwendungen wie TensorFlow von Google, sind ein wichtiger Faktor für die Entwicklung.

Diese Dinge fördern die Weiterentwicklung der KI und sind ein iterativer Entwicklungsprozess. Ohne sie wäre die Situation nicht so, wie wir sie heute haben. Aber KI hat auch ihre eigenen Grenzen. Beispielsweise kann AlphaGo nur eine einzige Aufgabe ausführen und nichts anderes tun, als Schach zu spielen. Dies ist etwas anderes als beim Gehirn.

Der zweite Punkt ist die Interpretierbarkeit. Wir verwenden tiefe neuronale Netzwerke zur Anpassung und fügen auch bestärkendes Lernen hinzu, aber es ist noch unklar, was in ihnen passiert. Manche Leute versuchen, diesen Prozess zu visualisieren oder seine Prinzipien herauszufinden.

Der dritte Punkt ist Robustheit. KI ist nicht so stabil wie Menschen. Beim autonomen Fahren beispielsweise wird die aktuelle KI nur zum assistierten Fahren eingesetzt, da sie keine absolute Sicherheit gewährleisten kann. Aufgrund dieser Mängel müssen wir der Entwicklung der Gehirnforschung Aufmerksamkeit schenken und mehr Mechanismen der Gehirnforschung einführen.Meiner Ansicht nach besteht das Dringendste darin, Intelligenz universeller zu machen.

AlphaGo ist eines der Meilenstein-Ereignisse. Weil KI dadurch ins öffentliche Bewusstsein gerückt wurde und jeder auf sie aufmerksam wurde. Bestärkendes Lernen wurde erst danach populär. Aus der Perspektive der Chips gibt es zwei Arten von Chips: solche, die sich auf Algorithmen konzentrieren und solche, die von biologischen Gehirnen inspiriert sind. In der Entwicklung dieser beiden Chiptypen gibt es zwei Meilensteine.

Die erste Kategorie ist maschinelles Lernen. Tiefe neuronale Netzwerke werden jetzt auf GPUs berechnet, aber GPUs sind nicht die effizientesten. Eine Gruppe von Unternehmen wie Cambrian sucht nach Lösungen zum Ersetzen von GPUs. Dies ist ein wichtiges Ereignis.

Die andere Kategorie ist nicht auf maschinelles Lernen beschränkt. Es geht darum, Modelle aus der Perspektive des Gehirns zu finden und spezielle Chips herzustellen. IBM oder Intel schneiden in dieser Hinsicht besser ab.

Der Grund, warum der Tianji-Chip so viel Aufmerksamkeit erregt hat, liegt darin, dass er die jeweiligen Vorteile dieser beiden Kategorien in einer Architektur integriert.

Frage: Ihr Team hat den Test des Tianji-Chips auf Fahrrädern veröffentlicht. Können Sie uns hierzu nähere Einzelheiten nennen?

Fahrräder waren im Internet für alle attraktiv, aber unser Team wusste, dass Fahrräder nicht unser Schwerpunkt waren. Es handelte sich lediglich um eine Demo-Plattform, da wir damals darüber nachdachten, eine gute Plattform zu finden, die wir allen zeigen konnten.

Die Fahrraddemonstration umfasst Sehen, Hören und Bewegungskontrolle. Die Erfüllung dieser Funktionen mit einem Chip macht ihn zu einer idealen Plattform. Aus dieser Perspektive haben wir damals darüber nachgedacht. Die Fahrradkontrolle ist nicht sehr schwierig. Wir wollten lediglich ein neues Modell vorführen.

Die Zukunft des gehirnähnlichen Computing: Die Von-Neumann-Architektur durchbrechen

Frage: Welche Verbindung besteht zwischen zukünftiger künstlicher Intelligenz oder gehirnähnlichem Computing und der bestehenden Von-Neumann-Architektur? Werden sie die Form des menschlichen Gehirns annehmen?

Dies ist ein sehr wichtiges Thema. Es gibt einen grundlegenden Trend in der aktuellen Halbleiterindustrie, zu dem auch der Turing Award 2018 gehört, der ebenfalls an Forscher verliehen wurde, die sich mit der Erforschung der Computerarchitektur beschäftigen. Es gibt zwei Möglichkeiten, die Leistung der GPU zu verbessern. Die erste besteht darin, den Transistor kleiner zu machen, also eine physikalische Miniaturisierung gemäß dem Mooreschen Gesetz durchzuführen. Doch in den letzten zwei Jahren wurde allen klar, dass das Mooresche Gesetz zu scheitern beginnt, die damit verbundenen Entwicklungen immer langsamer voranschreiten und es eines Tages nicht mehr möglich sein wird, es zu verkleinern.

Eine weitere Richtung besteht darin, eine Computerarchitektur zu entwickeln und zu versuchen, durch Framework-Design die Recheneinheit, die Speichereinheit und die Kommunikation mit hoher Effizienz arbeiten zu lassen. Das menschliche Gehirn ist erstaunlich. Durch die Anhäufung von Wissen wächst das Wissen jeder Generation. Wir sollten aus der Entwicklung dieses Wissens lernen.

Im letzten Jahrhundert folgte die Entwicklung von Allzweckprozessoren im Wesentlichen dem Mooreschen Gesetz. Da die Transistoren immer kleiner gemacht werden konnten, geriet die Entwicklung der Computerarchitektur in gewissem Maße ins Stocken. Da das Mooresche Gesetz nun außer Kraft gesetzt ist und Anwendungen wie KI das Streben nach hoher Verarbeitungseffizienz erfordern, hat die Forschung zur Computerarchitektur erneut an Bedeutung gewonnen und das nächste Jahrzehnt wird das goldene Zeitalter dedizierter Prozessoren sein.

Wenn es um gehirnähnliche Forschung geht, lautet die am häufigsten gestellte Frage: Was kann gehirnähnliches Computing leisten?

Dies ist ein fatales Problem. Vielen Menschen, die im Bereich der künstlichen Intelligenz oder der Gehirnforschung arbeiten, ist der Mechanismus dahinter nicht klar. Nehmen wir zum Beispiel die Gehirnforschung: Hier gibt es drei Ebenen, die derzeit ziemlich voneinander getrennt sind.

Die erste ist, wie Nervenzellen genau funktionieren. Viele Mediziner und Biologen führen zu diesem Thema noch immer schwierige Untersuchungen und Forschungen durch.

Der zweite Punkt ist die Art und Weise, wie Nervenzellen miteinander verbunden sind. Im Gehirn gibt es 10 hoch 11 Nervenzellen. Auch ihre Zusammenhänge sind schwer zu verstehen und erfordern die Erkenntnisse der Optik und Physik.

Schließlich müssen wir wissen, wie sie lernen. Dies ist die schwierigste, aber wichtigste Frage.

Es gibt in jeder Hinsicht eine Lücke, aber Schwierigkeiten dürfen kein Grund sein, die Erkundung aufzugeben.Wer nichts tut, hat keine Chance. Wenn man auf jeder Ebene etwas tut, entsteht immer etwas Neues, und dann geht es weiter mit der Iteration.

Wenn wir mit unseren weiteren Schritten warten, bis die Gehirnforschung vollständig verstanden ist, wird es zu spät sein und andere werden uns sicherlich zuvorkommen.

Beispielsweise ist die Herstellung einer CPU nicht so einfach, wie alle denken. Es ist nicht so, dass die Chinesen nicht schlau wären. Das Gleiche gilt für Motoren. Jeder versteht die Grundsätze, aber es ist nicht einfach, sie gut umzusetzen. Die technischen Schwierigkeiten und die technische Anhäufung können nicht über Nacht erreicht werden.

Einer der Gründe dafür ist, dass viele Dinge eine große industrielle Kette haben. Wenn Sie dies nicht gleich zu Beginn tun, verpassen Sie viele Gelegenheiten zum Ausprobieren. Auf diesem Gebiet wird es keine schnellen Durchbrüche geben und wir können nur bodenständig vorgehen. Was die Zukunft betrifft, so werden die aktuelle künstliche Intelligenz, die starke künstliche Intelligenz, die künstliche Intelligenz 2.0 und das gehirnähnliche Computing meiner Meinung nach alle am selben Punkt enden, da sie alle aus dem Gehirn stammen, nur in unterschiedliche Richtungen gehen.

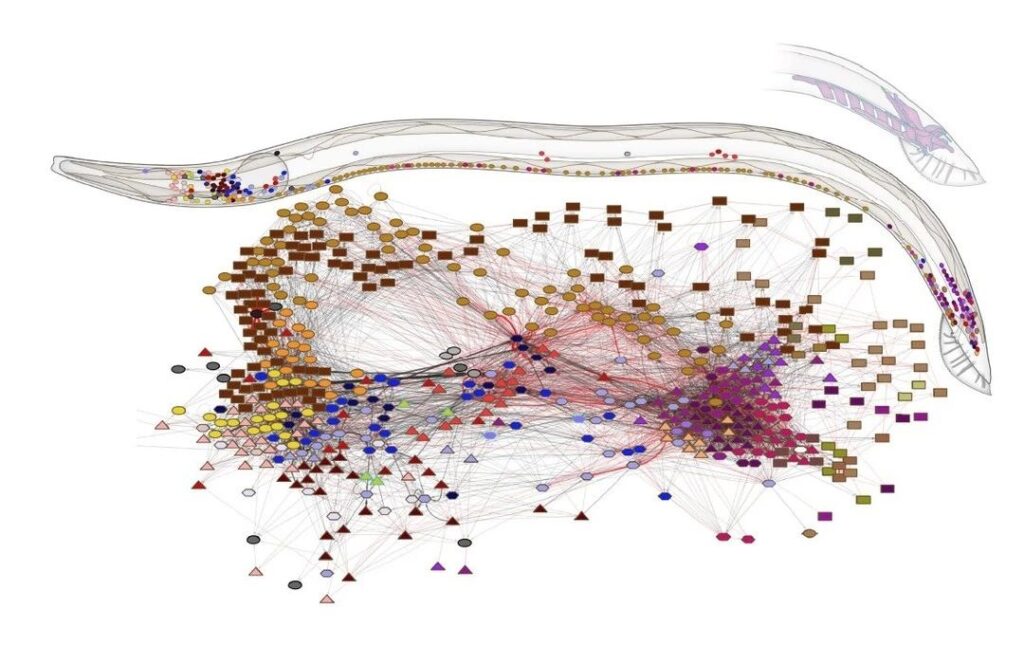

Frage: Vor einiger Zeit gab es in Nature einen weiteren Artikel, in dem Forscher eine vollständige Karte aller Neuronen in Fadenwürmern und aller 7.000 Verbindungen zwischen allen Neuronen zeichneten.

Frage: Hat diese Arbeit etwas mit der Forschung zu Gehirnfunktionen zu tun? Können wir vorhandene Technologie oder die CPU von Neumann verwenden, um die Nematodenaufgabe zu simulieren? Was können wir in den nächsten drei bis fünf Jahren erwarten?

Ich habe die Forschungsergebnisse zur Struktur von Fadenwürmern gelesen und sie haben einen großen Einfluss auf die Forschung zu Gehirnfunktionen. Tatsächlich sind die Verbindungsstrukturen aktueller KI-Modelle – ob gehirnähnliches Computing oder künstliche Intelligenz – größtenteils von den aktuellen hierarchischen tiefen neuronalen Netzwerken abgeleitet, die eigentlich sehr oberflächlich sind.

Unser Gehirn ist kein einfaches, geschichtetes Netzwerk, es ähnelt eher einem Graphen. Darüber hinaus sind die Verbindungen zwischen verschiedenen Gehirnregionen sehr komplex. Die Bedeutung dieser Studie liegt darin, dass sie uns zum Nachdenken darüber anregt, ob wir aus dieser Art der Verbindung lernen können.

Es gab zuvor einen Standpunkt, der in der Struktur des neuronalen Netzwerks,Die Rolle der Verbindungsstruktur ist tatsächlich größer als das spezifische Gewicht jeder Verbindung, d. h. die Bedeutung der Verbindung ist größer als die Bedeutung jedes Parameters.

Der Grund, warum Faltungsneuronale Netzwerke leistungsfähiger sind als frühere neuronale Netzwerke, liegt darin, dass sie eine andere Verbindungsstruktur haben und daher besser in der Lage sind, Merkmale zu extrahieren. Dies zeigt auch, dass die Verbindungsstruktur zu Änderungen in den Ergebnissen führen wird.

Tatsächlich ist es etwas schwierig, dieses Ergebnis auf herkömmlichen Prozessoren zu erzielen. Das typischste Merkmal der Von-Neumann-Architektur ist die Notwendigkeit einer sehr übersichtlichen Speichereinheit und einer sehr übersichtlichen Recheneinheit.

Doch in unserem Gehirn gibt es keine so klaren Grenzen. Obwohl wir einen Hippocampus haben, der speziell für das Langzeitgedächtnis zuständig ist, ist aus Sicht des neuronalen Netzwerks nicht klar, welche Zellgruppen im Gehirn für die Speicherung und welche nur für die Berechnung zuständig sind.

Das Gehirn gleicht eher einem chaotischen Netzwerk, in dem Berechnung und Speicherung schwer zu unterscheiden sind. Aus dieser Perspektive ist es schwierig, herkömmliche Chip- oder Prozessortechnologien zu verwenden.

Daher müssen wir einige neue Nicht-von-Neumann-Methoden entwickeln und neue architektonische Unterstützung nutzen, um gehirnähnliche Forschung zu betreiben.

So wurde beispielsweise beim Turing Award 2018 angekündigt, dass Chips für den Spezialbereich immer beliebter werden. Was NVIDIA derzeit fördert, ist eine heterogene Architektur, bei der sich auf einer Plattform mehrere kleine Chip-IP-Kerne befinden, die dem menschlichen Gehirn ähneln könnten.

Daher ist es nicht mehr wie früher, dass eine CPU alle Probleme lösen kann, und es gibt keinen Chip, der alle Probleme effizient lösen kann. In Zukunft werden nach und nach verschiedene effiziente und spezialisierte Entwicklungstechnologien entstehen, das ist der aktuelle Trend.

Derzeit ist das Verständnis der Menschen für die Gehirnforschung oder gehirnähnliche Computertechnik noch nicht so umfassend wie für die künstliche Intelligenz. Ein ganz wichtiger Grund ist, dass Investoren und Industrie sich bisher noch nicht so stark engagiert haben. Daher sind sowohl die Datenrechenleistung als auch die Tools schwierig zu implementieren. Die Entwicklung gehirnähnlicher Computertechnik befindet sich noch in einem sehr frühen Stadium. Ich bin überzeugt, dass die Dinge viel klarer werden, wenn sich immer mehr Universitäten und Unternehmen engagieren.

Frage: Was sind die Unterschiede zwischen der Architektur gehirnähnlicher Chips und der traditionellen Von-Neumann-Architektur?

Gehirnähnliche Chips können in gehirnähnliche und Computerchips unterteilt werden. Aus gehirnähnlicher Sicht handelt es sich bei der KI nicht nur um das tiefe neuronale Netzwerk, sondern es werden auch einige Berechnungen der Gehirnforschung kombiniert.

Aus architektonischer Sicht gibt es einen Engpass im Von-Neumann-System. Tatsächlich ist die Architektur der gesamten Halbleiterindustrie mit diesem Problem konfrontiert: Je größer die Speicherkapazität wird, desto langsamer wird ihre Geschwindigkeit. Wenn Sie den Maßstab erweitern und gleichzeitig die Geschwindigkeit erhöhen möchten, ist dies nicht möglich. Im Grunde beschäftigen sich Leute, die Architekturdesign betreiben, hauptsächlich damit, wie man die Speicherhierarchie optimieren und beschleunigen kann.

Tianji unterscheidet sich von anderen Architekturen und verwendet keinen Speicher, der erweitert werden muss.Der Tianji-Chip ähnelt eher einem Gehirn, das aus Zellen besteht, die zu vielen kleinen Schaltkreisen verbunden sind, die sich wiederum zu vielen Netzwerken ausdehnen und schließlich Funktionsbereiche und -systeme bilden.Es handelt sich um eine leicht skalierbare Struktur, nicht wie eine GPU.

Die dezentrale Multi-Core-Architektur des Tianji-Chips ermöglicht eine einfache Erweiterung zu einem großen System ohne Einschränkungen durch Speicherwände. Tatsächlich handelt es sich um eine Nicht-von-Neumann-Architektur, die Speicher und Datenverarbeitung integriert. Dies ist der größte Unterschied zwischen diesem und vorhandenen Prozessoren auf Architekturebene. Der vorherige ist der Unterschied auf Modellebene, der im Wesentlichen die Unterschiede zwischen diesen beiden Kategorien darstellt.