Command Palette

Search for a command to run...

IJCAI 2019 Papers: Chinesische Teams Machen 38% Aus, Die Peking-Universität Und Die Universität Nanjing Sind Auf Der Liste

Die führende KI-Konferenz IJCAI 2019 ging am 16. August erfolgreich zu Ende. Während des siebentägigen Technologie-Events lernten die Teilnehmer in Workshops die Anwendungsszenarien der KI-Technologie in verschiedenen Bereichen kennen, lauschten Keynote-Vorträgen von KI-Veteranen und hatten die Möglichkeit, in Roundtable-Diskussionen die historischen Geschichten der KI-Entwicklung sowie die neuesten Fortschritte und Trends kennenzulernen. Darüber hinaus zählen die in der Konferenz enthaltenen Beiträge zweifellos zu den beliebtesten Inhalten. Wir haben speziell für Sie eine Reihe ausgewählter Beiträge nach Fachgebieten zusammengestellt.

Top-KI-Konferenzen IJCAI 2019 Sie fand vom 10. bis 16. August in Macau, China, statt und wurde erfolgreich abgeschlossen.

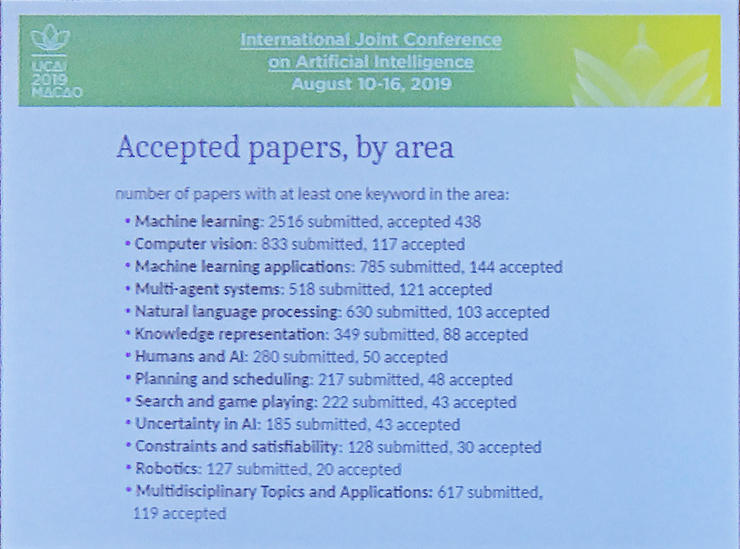

Bei der Eröffnungszeremonie am 13. August überprüften die Organisatoren der Konferenz die in der Konferenz enthaltenen Beiträge. Der Konferenzvorsitzende Thomas Eiter gab folgende Informationen bekannt: Beim diesjährigen IJCAI gingen insgesamt 4.752 Beiträge ein, und die endgültige Zahl der aufgenommenen Beiträge erreichte einen Rekordwert. 850 Artikel,Die Annahmequote beträgt 17,9%.

Anschließend gab Sarit Kraus, die Vorsitzende des Programmkomitees der Konferenz, eine detaillierte Erläuterung zum Status der Beiträge. Im Vergleich zu den 3.470 Artikeln im letzten Jahr beträgt die Wachstumsrate in diesem Jahr 37%. Unter den 850 enthaltenen ArtikelnEs gibt 327 Artikel aus China, die 38% ausmachen.

Zum Thema des Papiers:Maschinelles Lernen ist immer noch das heißeste Feld.Die Anzahl der enthaltenen Artikel beträgt 438, mehr als die Hälfte,Darüber hinaus ist das Feld mit der größten Anzahl von ArtikelnDazu zählen Computer Vision, Anwendungen für maschinelles Lernen und die Verarbeitung natürlicher Sprache.

In diesem Jahr nahmen insgesamt 73 Bereichsleiter, 740 hochrangige Programmausschussmitglieder und 2.696 Programmausschussmitglieder an der Papierprüfung teil. Welche herausragenden Arbeiten werden von ihnen begutachtet?

Einzigartiges, preisgekröntes Papier

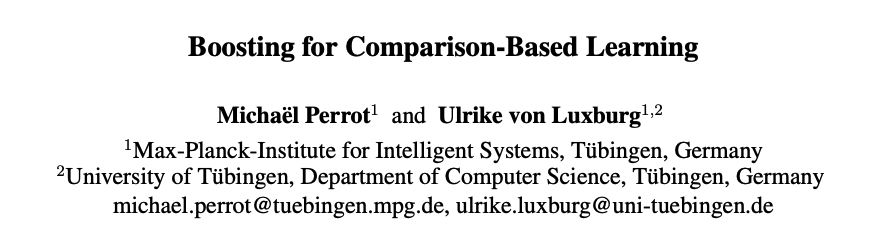

IJCAI 2019 wählte einen Beitrag aus 850 Beiträgen ausHervorragende Arbeiten(Ausgezeichnetes Papier):

Zusammenfassung: Die Autoren untersuchten eineKlassifizierungsprobleme basierend auf Kontrastbedingungen.Bei dieser Art von Problem läuft es im Allgemeinen so ab: Aus einem gegebenen Satz können wir nur dreifache Informationen gewinnen, nämlich den Vergleich von drei Zielen. Wenn beispielsweise die Distanz von x_i zu x_j kleiner ist als die Distanz von x_i zu x_k, wie klassifizieren wir dann x_i? In diesem Artikel schlugen die Forscher vor TripletBoostAus solchen Triplettdaten kann ein Algorithmus einen Klassifikator erlernen. Die Hauptidee des Papiers besteht darin, dass die durch das Triplett bereitgestellten Distanzinformationen in einen schwachen Klassifikator eingegeben werden, der schrittweise seriell zu einem starken Klassifikator aufgerüstet werden kann.

Zu diesen Methoden gehörenZwei Vorteile:Zunächst einmal kann diese Methode in verschiedenen Matrixräumen angewendet werden. Darüber hinaus kann diese Methode die dreifache Information lösen, die in vielen Bereichen nur passiv gewonnen werden kann oder verrauscht ist. In ihrer Arbeit haben die Forscher die Durchführbarkeit dieser Methode theoretisch überprüft und eine Untergrenze für die Anzahl der zu erhaltenden Tripletts vorgeschlagen. Durch Experimente haben sie herausgefunden, dass diese Methode besser als bestehende Methoden und resistenter gegen Lärm ist.

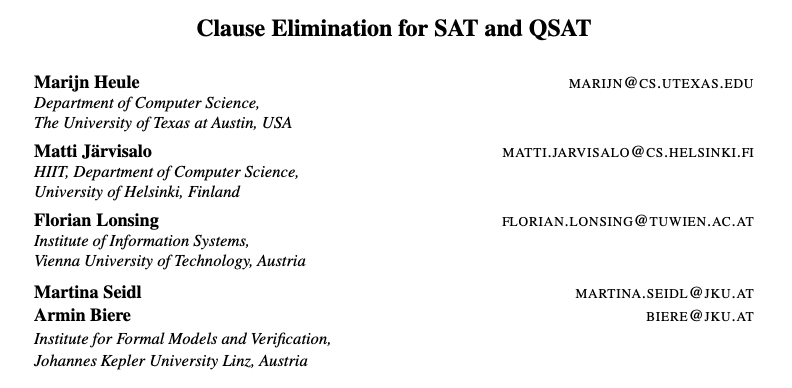

IJCAI-JAIR erhalten Bestes PapierDas beste Papier ist:

Hinweis: Diese Auszeichnung wird für Artikel verliehen, die in den letzten fünf Jahren in JAIR veröffentlicht wurden.

Zusammenfassung: In dem Artikel wird festgestellt, dass das typischste NP-vollständige Problem, die Boolesche Erfüllbarkeit (SAT) und ihre PSPACE-vollständige Verallgemeinerung, die Quantifizierte Boolesche Erfüllbarkeit (QAT), den Kern des Paradigmas der deklarativen Programmierung bilden.Es kann verschiedene reale Fälle rechnerisch komplexer Probleme effizient lösen.Erfolge in diesem Bereich werden erzielt durch SAT und QSAT Dies wird durch einen Durchbruch bei der praktischen Umsetzung von Entscheidungsverfahren, nämlich SAT- und QSAT-Lösern, erreicht. In diesem Artikel entwickeln und analysieren die Forscher ein Verfahren zur Klauseleliminierung für die Vor- und Nachverarbeitung. Der Prozess der Klauseleliminierung bildet eine Reihe von (P)CNF-Techniken zur formalen Vereinfachung, sodass Klauseln mit bestimmten redundanten Eigenschaften in polynomieller Zeit entfernt werden können, während die Erfüllbarkeit der Formel erhalten bleibt.

Zusätzlich zu diesen preisgekrönten Arbeiten zählt die IJCAI als eine der angesagtesten Top-Konferenzen im Bereich der künstlichen Intelligenz im Laufe der Jahre zu den Top-Konferenzen hinsichtlich der Anzahl der eingereichten und angenommenen Arbeiten und es wurden viele hervorragende Arbeiten erstellt.

Daher Super Neuro von dieser IJCAI-KonferenzHeiß 3In jeder Ausgabe wählen wir ein oder zwei ausgewählte Beiträge aus und geben eine kurze Einführung, um einen Einblick in das Gesamtbild des IJCAI zu erhalten.

Heißestes Feld Hot 1: Maschinelles Lernen

Ausgewählte Beiträge zum maschinellen Lernen 1

Zusammenfassung: Bei der offenen Video-Frage-Antwort-Aufgabe geht es darum, basierend auf einer gegebenen Frage automatisch Textantworten aus Referenzvideoinhalten zu generieren.

Derzeit werden bei bestehenden Methoden häufig multimodale rekurrierende Encoder-Decoder-Netzwerke verwendet, ihnen fehlt jedoch die Modellierung langfristiger Abhängigkeiten, was sie bei der Beantwortung langer Videofragen unwirksam macht.

Um dieses Problem zu lösen, schlugen die Autoren eineSchnelles hierarchisches Convolutional Self-Attention Encoder-Decoder-Netzwerk (HCSA).Mithilfe eines Self-Attention-Encoders mit geschichteten Faltungen,Modellieren Sie lange Videoinhalte effizient.

HCSA erstellt eine hierarchische Struktur von Videosequenzen und erfasst fragenbewusste langfristige Abhängigkeiten aus dem Videokontext. Darüber hinaus wird ein mehrskaliger Aufmerksamkeitsdecoder entwickelt, der mehrere Darstellungsebenen zusammenführt, um die Antwort zu generieren und so den Informationsverlust der obersten Codierungsebene zu vermeiden.

Experimentelle Ergebnisse zeigen, dass diese Methode bei mehreren Datensätzen gute Ergebnisse liefert.

Ausgewählte Beiträge zum Thema Maschinelles Lernen 2

Zusammenfassung: Die Anwendung des maschinellen Lernens wird häufig durch die Menge der effektiv gekennzeichneten Daten begrenzt, und halbüberwachtes Lernen kann dieses Problem effektiv lösen.

In diesem Artikel wird ein einfacher und effektiver Algorithmus für halbüberwachtes Lernen vorgeschlagen.Interpolationskonsistenztraining(Interpolationskonsistenztraining, ICT).

ICT sorgt dafür, dass die interpolierten Vorhersagen für nicht gekennzeichnete Punkte mit den interpolierten Vorhersagen für diese Punkte übereinstimmen.Bei Klassifizierungsproblemen verschiebt die IKT die Entscheidungsgrenze in Bereiche der Datenverteilung mit geringer Dichte. Es erfordert fast keine zusätzlichen Berechnungen und kein Trainieren eines generativen Modells. Auch ohne umfangreiche Hyperparameter-Optimierung liefert es eine sehr gute Leistung, wenn es auf Standardarchitekturen neuronaler Netzwerke auf den Benchmark-Datensätzen CIFAR-10 und SVHN angewendet wird.Erzielte Leistung auf dem neuesten Stand der Technik.

Heißestes Feld Hot 2: Computer Vision

Ausgewählte Beiträge zum Thema Computer Vision 1

Zusammenfassung: Merkmale aus mehreren Maßstäben können die Aufgabe der semantischen Kantenerkennung erheblich erleichtern. Gängige Methoden zur semantischen Kantenerkennung wenden jedoch eine Strategie zur Fusion fester Gewichte an, bei der Bilder mit unterschiedlicher Semantik gezwungen werden, dieselben Gewichte zu verwenden. Dies führt zu universellen Fusionsgewichten für alle Bilder und Standorte, ungeachtet ihrer unterschiedlichen Semantik oder ihres lokalen Kontexts.

Diese Arbeit schlägt eineNeuartige dynamische Feature-Fusion-Strategie,Weisen Sie verschiedenen Eingabebildern und -orten adaptiv unterschiedliche Fusionsgewichte zu. Dies wird durch den vorgeschlagenen Gewichtslerner erreicht, der geeignete Fusionsgewichte für eine bestimmte Eingabe mit mehrstufigen Merkmalen an jeder Position der Merkmalskarte ableitet.

Auf diese Weise kann die Heterogenität der Beiträge verschiedener Standorte der Feature-Maps und Eingabebilder besser berücksichtigt werden, was die Generierung vonGenauere und schärfere Kantenvorhersagen.

Ausgewählte Beiträge zum Thema Computer Vision 2

Zusammenfassung: Die monokulare Tiefenschätzung ist eine wichtige Aufgabe beim Szenenverständnis. Objekte und die zugrunde liegenden Strukturen von Objekten in komplexen Szenen sind für genau wiederhergestellte und optisch ansprechende Tiefenkarten von entscheidender Bedeutung. Die globale Struktur spiegelt das Szenenlayout wider und die lokale Struktur spiegelt die Formdetails wider. Die in den letzten Jahren entwickelten CNN-basierten Tiefenschätzungsmethoden haben die Leistung der Tiefenschätzung erheblich verbessert. Allerdings berücksichtigen nur wenige von ihnen die mehrstufigen Strukturen in komplexen Szenen.

Dieses Papier schlägt eineStrukturbewusstes Residualpyramidennetzwerk für hochpräzise Vorhersagen unter Verwendung mehrskaliger Strukturen(SARPN) wird ein Residual Pyramid Decoder (RPD) vorgeschlagen, der die globale Szenenstruktur in der oberen Schicht darstellt, um das Layout darzustellen, und die lokale Struktur in der unteren Schicht, um die Formdetails darzustellen. In jeder Schicht wird ein Residual-Refinement-Modul (RRM) der vorhergesagten Residual-Map vorgeschlagen, um der in der oberen Schicht vorhergesagten Grobstruktur schrittweise feinere Strukturen hinzuzufügen. Um die Funktionen von Bildern mit mehreren Maßstäben voll auszunutzen, wird ein Modul zur adaptiven dichten Merkmalsfusion (ADFF) vorgeschlagen, das die effektiven Merkmale jedes Maßstabs adaptiv fusioniert, um auf die Struktur jedes Maßstabs zu schließen. Experimentelle Ergebnisse zum NYU-Depth v2-Datensatz zeigen, dass die vorgeschlagene Methode sowohl bei der qualitativen als auch bei der quantitativen Auswertung eine hochmoderne Leistung erzielt.Die Präzision erreichte 0,749, die Rückrufrate 0,554 und der F1-Score 0,630.

Heißestes Feld Hot 3: Natürliche Sprachverarbeitung (NLP)

NLP Ausgewählte Artikel 1

Zusammenfassung: Rekurrierende neuronale Netzwerke (RNNs) werden häufig im Bereich der natürlichen Sprachverarbeitung (NLP) verwendet, einschließlich Textklassifizierung, Beantwortung von Fragen und maschineller Übersetzung. Normalerweise können RNNs nur von Anfang bis Ende überprüfen und sind nicht gut imstande, lange Texte zu verarbeiten. Bei Textklassifizierungsaufgaben sind viele Wörter in langen Dokumenten irrelevant und können übersprungen werden. Angesichts dieser Situation schlägt der Autor dieses Papiers vorVerbessertes LSTM:Sprung-LSTM.

Leap-LSTM kann Text lesenSpringen Sie dynamisch zwischen Wörtern.In jedem Schritt verwendet Leap-LSTM mehrere Feature-Encoder, um Informationen aus dem vorherigen Text, dem folgenden Text und dem aktuellen Wort zu extrahieren und entscheidet dann, ob das aktuelle Wort übersprungen werden soll. Auf fünf Benchmark-Datensätzen, darunter AGNews, DBPedia, Yelp F. Yelp P. und Yahoo,Der Vorhersageeffekt von Leap-LSTM ist höher als der von Standard-LSTM und Leap-LSTM hat eine höhere Lesegeschwindigkeit.

NLP Ausgewählte Artikel 2

Zusammenfassung: In diesem Artikel werdenProblem der Entitätsausrichtung basierend auf der Einbettung von Wissensgraphen.Frühere Arbeiten konzentrieren sich hauptsächlich auf die relationale Struktur von Entitäten, und einige integrieren zur Verfeinerung darüber hinaus andere Arten von Merkmalen, wie etwa Attribute.

Allerdings werden viele Entitätsmerkmale immer noch nicht gleich behandelt, was die Genauigkeit und Robustheit der einbettungsbasierten Entitätsausrichtung beeinträchtigt.

Dieses Dokument schlägt einen neuen Rahmen vor.Es vereinheitlicht mehrere Ansichten von Entitäten, um entitätsausgerichtete Einbettungen zu erlernen.Insbesondere werden in diesem Dokument mehrere kombinierte Strategien zum Einbetten von Entitäten basierend auf Ansichten von Entitätsnamen, Beziehungen und Attributen verwendet.

Darüber hinaus werden in diesem Dokument einige Methoden zur übergreifenden Argumentation über Wissensgraphen hinweg entwickelt, um die Ausrichtung zwischen zwei Wissensgraphen zu verbessern. Die Experimente mit realen Datensätzen zeigen, dass die Leistung dieses Frameworks deutlich besser ist als die der fortschrittlichsten einbettungsbasierten Entity-Alignment-Methode. Die ausgewählten Ansichten, das übergreifende Denken in Wissensgraphen und die Kombinationsstrategien tragen alle zur verbesserten Leistung bei.

-- über--