Command Palette

Search for a command to run...

Online-Tutorial: Multimodales Framework Zur Kollaborativen Videogenerierung HuMo-1.7B: Erzielen Eines Videoerstellungserlebnisses Mit Integrierten Grafiken, Text Und Audio

Heutzutage werden KI-generierte Videos immer realistischer. Auf den ersten Blick sind sie oft atemberaubend, doch bei näherer Betrachtung scheint etwas nicht zu stimmen. Dieser „Unheimliche-Tal“-Effekt zwischen dem Echten und dem Falschen ist erstaunlich und unvermeidlich zugleich.

Denken Sie an ein typisches Szenario in der Kreativarbeit. Wenn der Kunde nur eine vage Idee vorlegt, erfüllt das Endprodukt oft nicht die Erwartungen. Erst wenn die Anforderungen in Dimensionen wie Stil, Charaktere, Ton und Atmosphäre verfeinert werden, kommt das Ergebnis dem Ideal näher. Dasselbe gilt für die Videoerstellung. Im Gegensatz zu Bildern und Texten enthalten Videos mehrere Informationen wie Ton, Charaktere und Aktionen.Dies bedeutet, dass das Modell nicht nur die Semantik des Textes „verstehen“ muss, sondern auch die visuellen und auditiven Ausdrücke „koordinieren“ muss.

Die meisten aktuellen Modelle basieren jedoch auf einer einzigen Modalität für die Eingabe. Neuere Versuche einer multimodalen Steuerung stoßen oft auf Schwierigkeiten bei der effektiven Zusammenarbeit zwischen Stimme, Ausdruck und Bewegung. Die Ermöglichung einer echten Zusammenarbeit dieser verschiedenen Modalitäten und die Erstellung natürlicher und glaubwürdiger, menschenähnlicher Videos bleibt eine gewaltige Herausforderung.

In Anbetracht dessenDie Tsinghua-Universität und das ByteDance Intelligent Creation Lab haben gemeinsam das HuMo-Framework veröffentlicht. HuMo schlägt das Konzept der „kooperativen multimodalen bedingten Generierung“ vor, bei dem Text, Referenzbilder und Audio in dasselbe generative Modell integriert werden und durch eine progressive Trainingsstrategie und einen zeitadaptiven Führungsmechanismus die Führungsgewichte im Rauschunterdrückungsschritt dynamisch angepasst werden.Es erzielt nicht nur Durchbrüche bei der Aufrechterhaltung der Konsistenz des Erscheinungsbilds der Charaktere sowie von Audio und Video, sondern entwickelt auch die Videogenerierung vom „mehrstufigen Spleißen“ zur „One-Stop-Generierung“ weiter.

Papieradresse:

https://arxiv.org/abs/2509.08519

Ursprüngliches Lager:

https://github.com/phantom-video/humo

Darüber hinaus hat die Leistung von HuMo bei mehreren Unteraufgaben wie Textverfolgung und Bildkonsistenz SOTA erreicht.Das Projekt bietet zwei Modelle, 1.7B und 17B, die leichtgewichtig, spielbar, professionell und recherchierbar sind und den unterschiedlichen Anforderungen von Entwicklern und Schöpfern gerecht werden. Werfen wir einen Blick auf die generierten Effekte des 17B-Modells:

„HuMo-1.7B: Multimodal Video Generation Framework“ + „HuMo-17B: Trimodal Collaborative Creation“ sind jetzt im Bereich „Tutorials“ auf der offiziellen HyperAI-Website (hyper.ai) verfügbar. Probieren Sie es doch einfach mal aus! Kann das Modell mit mehr Informationen ein Video erstellen, das Sie zufriedenstellt?

Link zum Tutorial:

HuMo-1.7B:https://go.hyper.ai/BGQT1

HuMo-17B:https://go.hyper.ai/RSYA

Demolauf

1. Wählen Sie auf der Homepage von hyper.ai die Seite „Tutorials“ aus, wählen Sie „HuMo-1.7B: Multimodal Video Generation Framework“ und klicken Sie auf „Dieses Tutorial online ausführen“.

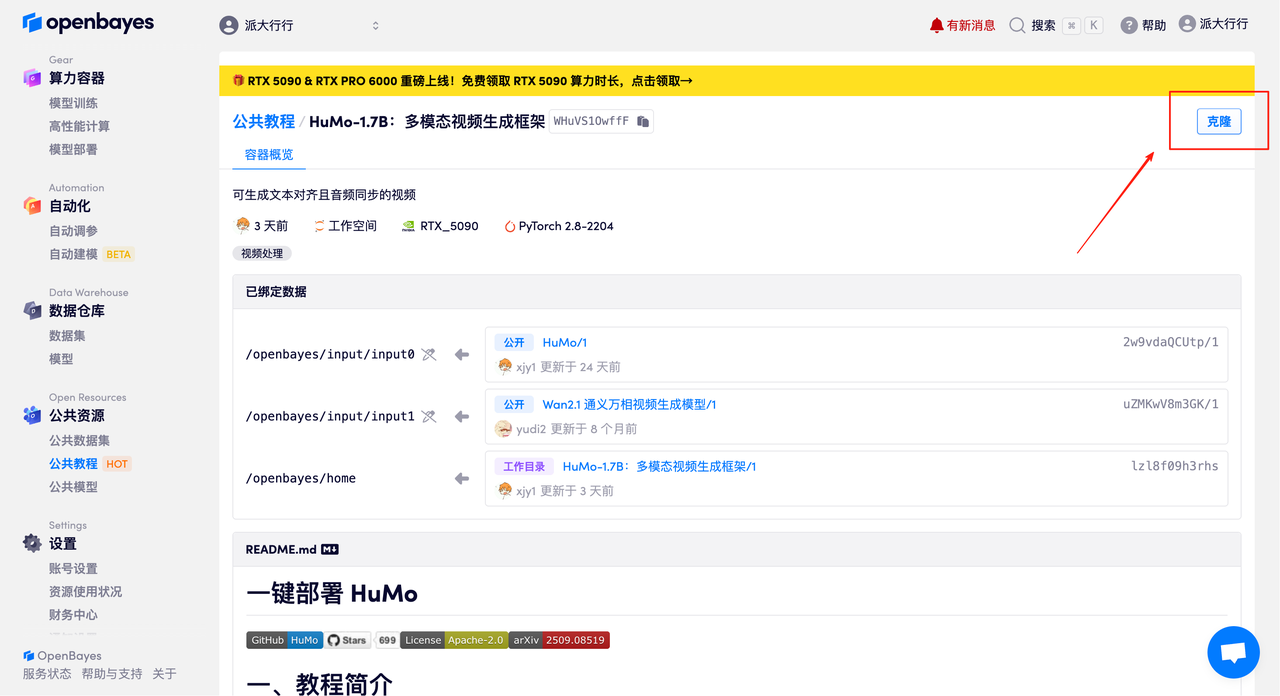

2. Klicken Sie nach dem Seitensprung oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

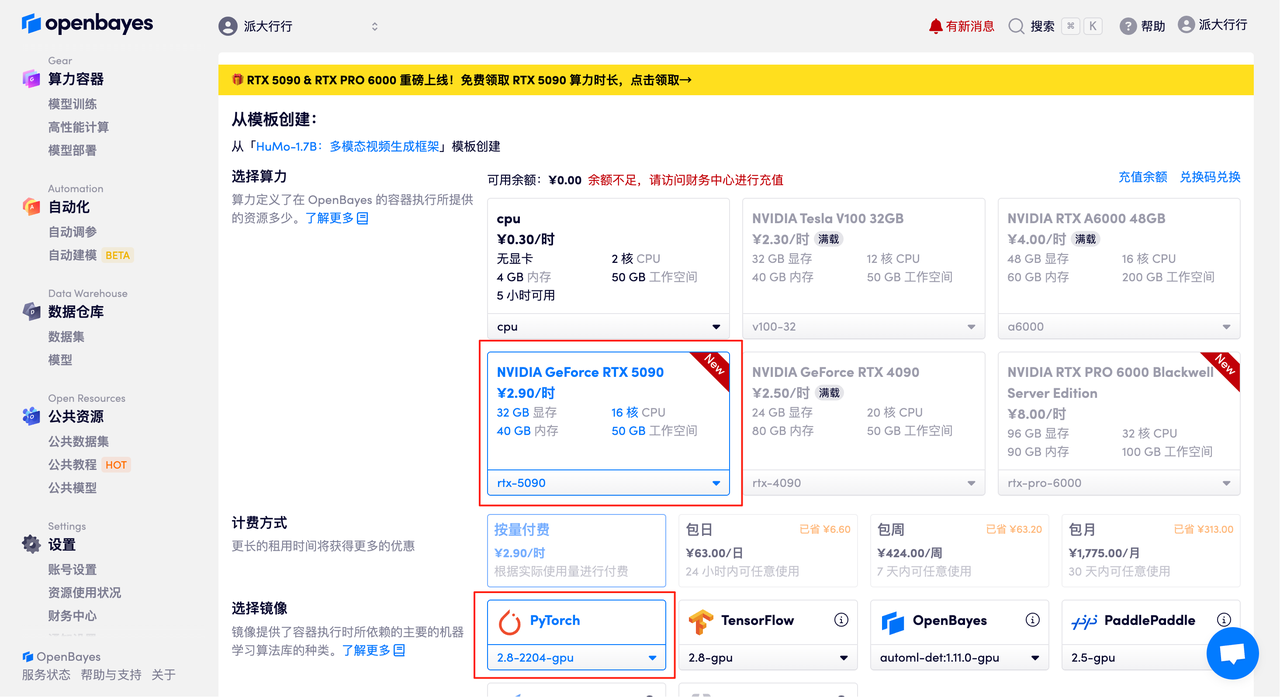

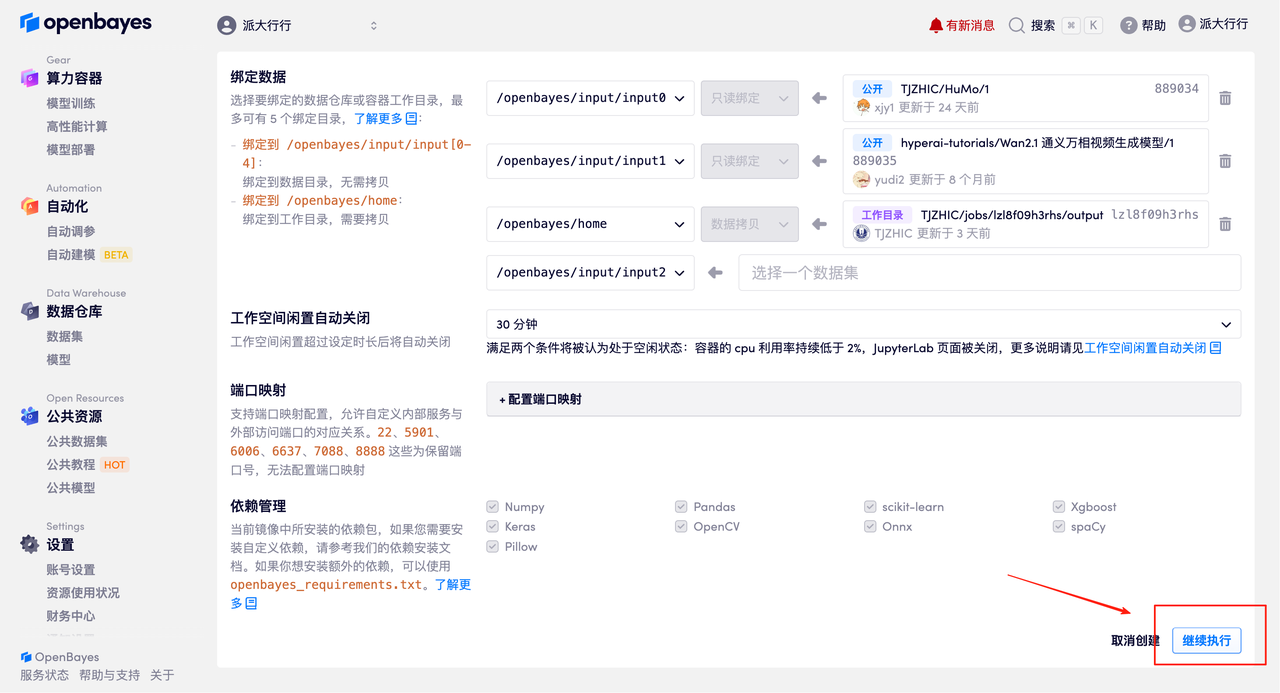

3. Wählen Sie die NVIDIA GeForce RTX 5090 und PyTorch-Images aus und klicken Sie auf „Weiter“. Die OpenBayes-Plattform bietet vier Abrechnungsoptionen: Pay-as-you-go oder Tages-/Wochen-/Monatstarife. Neue Benutzer können sich über den unten stehenden Einladungslink registrieren und erhalten 4 Stunden kostenlose RTX 5090 und 5 Stunden kostenlose CPU-Zeit!

Exklusiver Einladungslink von HyperAI (kopieren und im Browser öffnen):

https://openbayes.com/console/signup?r=Ada0322_NR0n

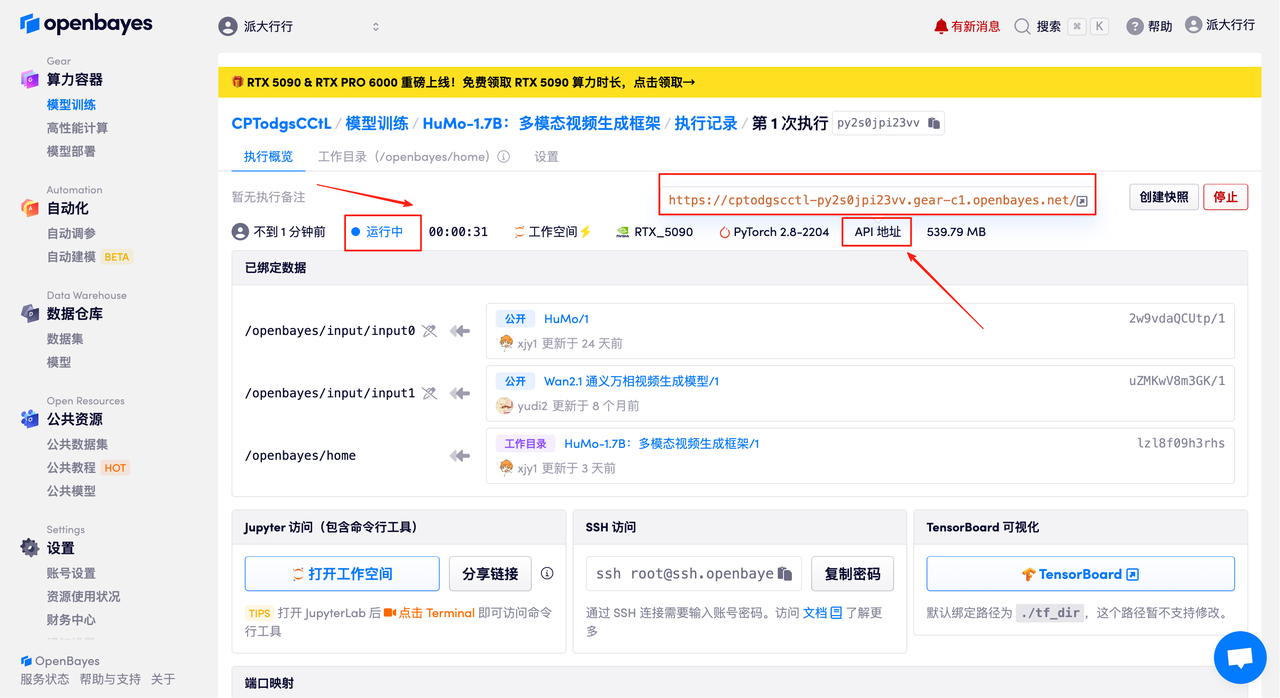

4. Warten Sie, bis die Ressourcen zugewiesen sind. Der erste Klon dauert etwa 2 Minuten. Wenn der Status auf „Läuft“ wechselt, klicken Sie auf „Arbeitsbereich öffnen“, um zur Demoseite zu gelangen.

Effektdemonstration

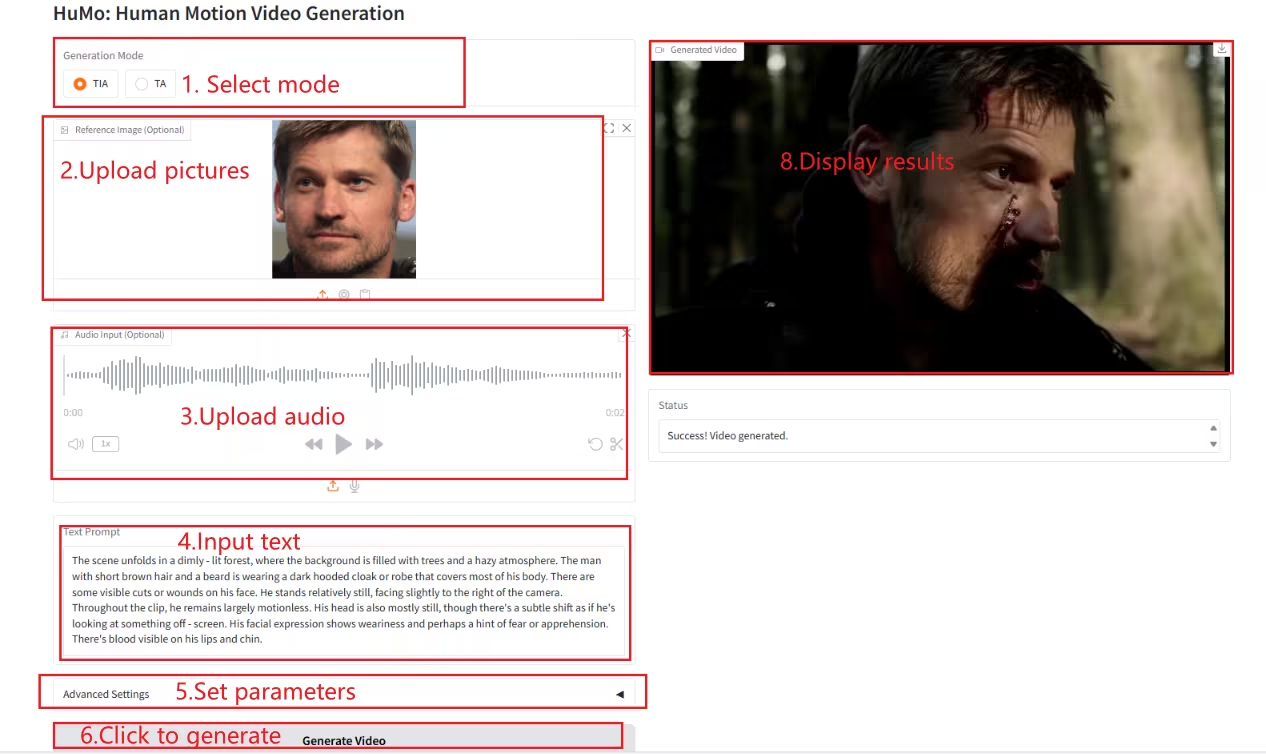

Sobald Sie auf der Demo-Seite sind, geben Sie eine Beschreibung in das Textfeld ein, laden Sie Bilder und Audio hoch, passen Sie die Parameter nach Bedarf an und klicken Sie auf „Video generieren“, um das Video zu generieren. (Hinweis: Wenn die Sampling-Schritte auf 10 eingestellt sind, dauert die Videogenerierung etwa 3–5 Minuten.)

Beispiel generieren

Das Obige ist das diesmal von HyperAI empfohlene Tutorial. Jeder ist herzlich eingeladen, vorbeizukommen und es auszuprobieren!

Link zum Tutorial:

HuMo-1.7B:https://go.hyper.ai/BGQT1

HuMo-17B:https://go.hyper.ai/RSYAich