Command Palette

Search for a command to run...

NVIDIA Wurde Für NeurIPS 2025 Ausgewählt Und Schlug Das ERDM-Modell Zur Lösung Langfristiger Prognoseherausforderungen vor. Seine Mittel- Bis Langfristigen Prognosen Sind Weiterhin Führend Im EDM-Benchmark.

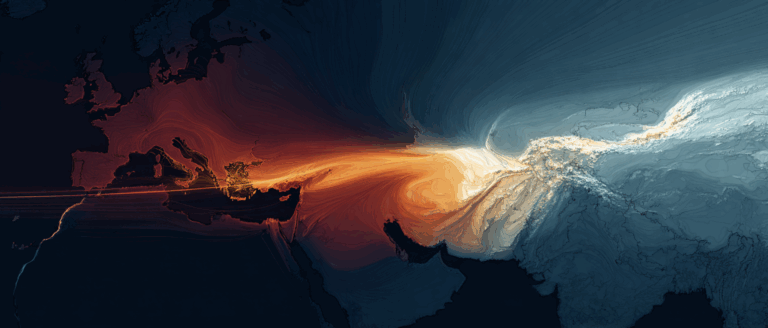

Mittelfristige Wettervorhersagen (≤15 Tage) stellen für die Wissenschaft eine große und langjährige Herausforderung dar. Als typisches chaotisches System reagiert die Atmosphäre extrem empfindlich auf Anfangsbedingungen, und kleine Fehler können sich schnell verstärken, sodass Prognosen von der Realität abweichen. Während sich die Ensemble-Numerische Wettervorhersage, die mehrere Störungssimulationen zur Abschätzung der Unsicherheit nutzt, zu einem gängigen Ansatz entwickelt hat,Allerdings wachsen die Rechenressourcen exponentiell mit der Verbesserung der Anforderungen an Genauigkeit und Aktualität.Dieser Engpass zwingt die Wissenschaft dazu, sich neuen datengesteuerten Ansätzen zuzuwenden, um Durchbrüche zu erzielen.

In den letzten Jahren haben Durchbrüche in der generativen Modellierung neue Lösungen für dieses Problem bereitgestellt. Unter ihnen ist das Rolling Sequence Diffusion Model (RSDM) ein typischer Vertreter des Diffusionsmodells.Um dem langfristigen Prognosezustand stärkeres Rauschen aufzuerlegen, wird ein progressiver Rauschplanungsmechanismus verwendet.Dieser Ansatz simuliert die allmähliche Anhäufung von Unsicherheit im Laufe der Zeit in der realen Welt und verbessert so effektiv die Authentizität von Vorhersagen. Das aktuelle RSDM basiert jedoch immer noch auf dem Framework des früheren Denoised Diffusion Probabilistic Model (DDPM), und die Einschränkungen der zugrunde liegenden Architektur haben weitere Verbesserungen der Gesamtleistung des Modells bis zu einem gewissen Grad eingeschränkt.

Es ist erwähnenswert, dassNVIDIAs Elucidated Diffusion Model (EDM), vorgestellt im besten Paper von NeurIPS 2022,Durch die Vereinheitlichung und Verbesserung des klassischen DDPM konnten die Trainingsstabilität und die Generierungsqualität deutlich verbessert werden. Wenn wichtige Optimierungsstrategien wie der Zeitverlustgewichtungsmechanismus in EDM effektiv in RSDM integriert werden können, dürften sich dessen Modellierungsgenauigkeit und Betriebseffizienz deutlich verbessern.

Darauf aufbauend verbesserte das Forschungsteam von NVIDIA und der University of California, San Diego, auf der Grundlage des EDM-Frameworks systematisch die Rauschplanung, die Parametrisierung des Rauschunterdrückungsnetzwerks, den Vorverarbeitungsprozess, die Verlustgewichtungsstrategie und den Sampling-Algorithmus, um den Anforderungen der Sequenzmodellierung gerecht zu werden, und konstruierte ein verbessertes, erläutertes Rolling-Diffusion-Modell (ERDM).Diese Forschung konzentriert sich auf die Überwindung des kollaborativen Designproblems der „progressiven Rauschplanung“ und der „Zeitverlustgewichtung“.Es bietet einen neuen und effizienten Weg für die probabilistische Vorhersage chaotischer dynamischer Systeme.

Die entsprechenden Forschungsergebnisse tragen den Titel „Elucidated Rolling Diffusion Models for Probabilistic Weather Forecasting“.Es wurde für NeurIPS 2025 ausgewählt, eine hochkarätige akademische Konferenz im Bereich der künstlichen Intelligenz.

Papieradresse:

https://doi.org/10.48550/arXiv.2506.20024

Folgen Sie dem offiziellen Konto und antworten Sie mit „ERDM“, um das vollständige PDF zu erhalten

Weitere Artikel zu den Grenzen der KI:

https://hyper.ai/papers

Datensatz: Navier-Stokes- und ERA5-Wetterdaten

Zur Unterstützung des Modelltrainings und der Modellvalidierung wurden in dieser Studie zwei Arten von Benchmark-Datensätzen mit klarem Anwendungshintergrund ausgewählt, die jeweils der Modellierung der Strömungsdynamik und der mittelfristigen Wettervorhersage entsprechen.

In Fluiddynamik-ExperimentenDie Forscher verwendeten den Benchmark-Datensatz zur Strömungsdynamik von Navier-Stokes.Der Datensatz basiert auf einer 221×42-Gitterstruktur. In jedem Simulationsfall werden zufällig kreisförmige Hindernisse platziert, die den Flüssigkeitsweg verändern. Um konsistente Versuchsbedingungen zu gewährleisten, ist die Viskosität der Flüssigkeit in allen Simulationen auf 1×10⁻³ festgelegt. Der Datensatz erfasst die wichtigsten physikalischen Feldinformationen der Flüssigkeitsbewegung, einschließlich der Geschwindigkeitsfelder in x- und y-Richtung sowie des Druckfelds. Während des Trainings und Tests des Modells dienen Randbedingungen und Hindernismasken als zusätzliche Eingaben, damit das Modell Randeffekte und Hinderniseinflüsse genau erfassen kann. Ziel der Testphase ist es, den Flüssigkeitsentwicklungsprozess für die nächsten 64 Zeitschritte basierend auf einem einzigen Anfangszustand vorherzusagen.

Im Benchmarktest der mittelfristigen WettervorhersageDie Forscher nutzten den ERA5-Reanalyse-Datensatz, umDie räumliche Auflösung beträgt 1,5°, entsprechend einer Rastergröße von 240×212. Der Datensatz enthält insgesamt 69 Prognosevariablen, die zwei Arten wichtiger meteorologischer Elemente abdecken: Höhenluft und Boden. Zu den Variablen der Höhenluft zählen Temperatur (t), geopotentielle Höhe (z), spezifische Luftfeuchtigkeit (q) und u- und v-Komponenten von Windfeldern von 13 Druckschichten (Einheit: hPa); zu den Bodenvariablen zählen Temperatur in 2 m Höhe (2t), mittlerer Luftdruck auf Meereshöhe (mslp) und u- und v-Komponenten von Windfeldern in 10 m Höhe (10u und 10v). In der Trainingsphase des Modells werden stündliche ERA5-Daten von 1979 bis 2020 verwendet, um langfristige Klimaeigenschaften abzudecken; in der Evaluierungsphase werden 64 verschiedene meteorologische Ausgangsbedingungen um 00:00 und 12:00 Uhr (UTC) im Jahr 2021 ausgewählt, um die mittelfristige Prognoseleistung des Modells unter verschiedenen Ausgangsbedingungen zu testen.

ERDM-Modell: Integration von Innovation und Kernarchitekturdesign, um einen neuen Weg zur Modellierung chaotischer dynamischer Systeme zu bieten

Der Kernbeitrag von ERDM besteht darin, die Idee des „Rauschens nimmt mit der Prognoselänge allmählich zu“ im Rolling Sequence Diffusion Model (RSDM) mit dem bewährten normalisierten Design von EDM zu kombinieren.Es bietet einen neuen Weg, der theoretische Genauigkeit und praktische Robustheit für die Modellierung chaotischer dynamischer Systeme wie Flüssigkeitsbewegungsbahnen und Wettervorhersagesequenzen kombiniert.

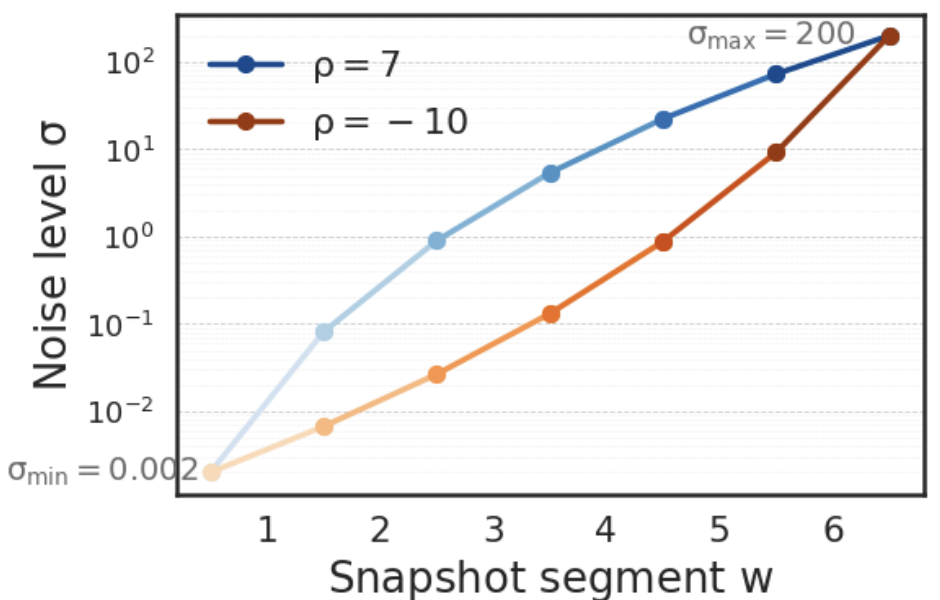

ERDM verbessert zunächst den Rauschplanungsmechanismus.Im Gegensatz zur herkömmlichen linearen oder Kosinus-Planung wird ein auf die Eigenschaften der Sequenzgenerierung zugeschnittener Rollrauschplan verwendet. Dieser Ansatz unterteilt das Generierungsfenster in mehrere aufeinanderfolgende Zeiträume, wobei jedem Zeitraum unterschiedliche Rauschintensitäten zugewiesen werden und fließende Übergänge zwischen benachbarten Zeiträumen gewährleistet werden. Während des Trainings, wie in der folgenden Abbildung dargestellt, prüft das Modell zufällig verschiedene Rauschpegel, um zu lernen, sich an verschiedene Rauschszenarien anzupassen. Während der Generierung wird das Rauschen von einem hohen Anfangspegel aus schrittweise gedämpft, was schließlich klare Ergebnisse liefert. ERDM passt außerdem wichtige Krümmungsparameter an, um sie besser an Aufgaben der Sequenzgenerierung anzupassen und so während des Rauschunterdrückungsprozesses effektivere Informationen zu erhalten.

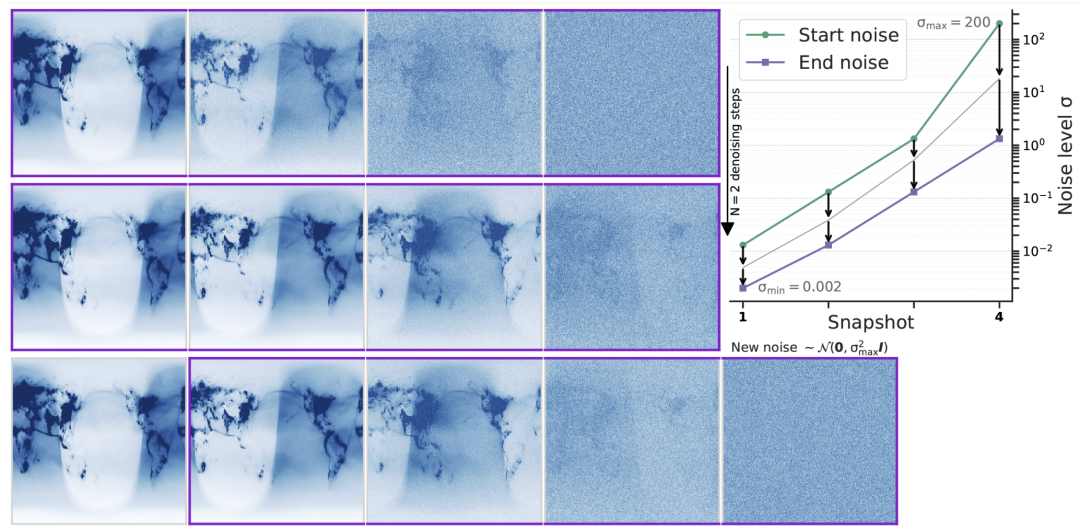

Auf dieser GrundlageERDM führt die probabilistische gewöhnliche Differentialgleichung (ODE) ein,Mit dieser Gleichung lässt sich das Hinzufügen und Entfernen von Rauschen präzise steuern. Sie beschreibt die vollständige Flugbahn der Datenentwicklung von einem verrauschten Zustand bis zu einem klaren Ergebnis und kann als „Navigationskarte“ für den Generierungsprozess betrachtet werden. Wie in der folgenden Abbildung dargestellt, löst das Modell während der Inferenz die ODE iterativ mithilfe numerischer Methoden: Die Daten werden im ersten Moment vollständig entrauscht und als Vorhersageergebnis ausgegeben, während in den verbleibenden Momenten etwas Rauschen erhalten bleibt. Anschließend wird ein Rollmechanismus aktiviert, der diese teilweise entrauschten Daten als Vorordnungszustand für die nächste Generation verwendet, ergänzt durch einen neuen Rauschmoment, und der ODE-Lösungsprozess wird wiederholt, wodurch eine kontinuierliche Generierung langer Sequenzen erreicht wird.

Das Training von ERDM dreht sich um das Denoiser-Netzwerk.Dieses Netzwerk nutzt die standardisierte Vorverarbeitungsmethode von EDM und kann Daten jederzeit adaptiv entsprechend dem Rauschpegel verarbeiten, um die Originalinformationen aus der verrauschten Sequenz wiederherzustellen. Als Trainingsstrategie verwendet ERDM eine „unsicherheitsbewusste“ Gewichtungsmethode, die nicht nur die herkömmliche Gewichtung zur Stabilisierung des Trainings beibehält, sondern auch informationsreicheren Zwischenrauschproben höhere Gewichte zuweist, wodurch sich das Modell auf das Erlernen von Zwischenzuständen konzentriert, die für den Generierungsprozess entscheidend sind. Beim spezifischen Training beginnt das Modell mit einer sauberen Sequenz, fügt Rauschen mit zufälliger Intensität hinzu und versucht, die Originaldaten wiederherzustellen. Anschließend optimiert es die Parameter durch Vergleichen der Differenz zwischen Vorhersage und wahrem Wert. Experimente haben gezeigt, dass die Einführung eines zeitbezogenen Rauschdesigns die Stabilität langfristiger Vorhersagen weiter verbessern kann.

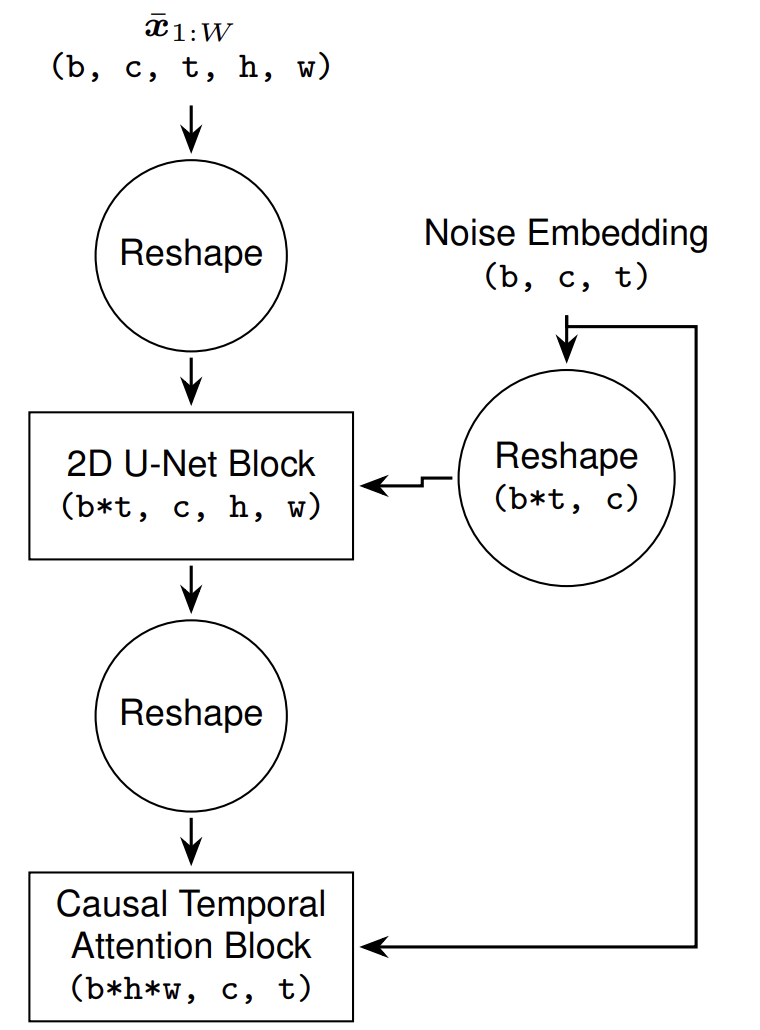

Um die dynamischen Eigenschaften von Zeitreihendaten besser zu erfassen, hat ERDM die Denoiser-Struktur weiter optimiert. Es verzichtet auf die 2D-Faltung, die die zeitliche Korrelation zerstört, und die rechenintensive 3D-Faltung und verwendet stattdessen eine Hybridarchitektur aus 2D-U-Net und zeitlicher Aufmerksamkeit. Das 2D-U-Net-Backbone extrahiert die räumlichen Merkmale jedes Moments, die zeitliche Aufmerksamkeitsschicht erfasst die Abhängigkeiten zwischen den Momenten, und die Rauschinformationen werden in die Regularisierungsschicht eingebettet, um das Netzwerkverhalten zu regulieren. Dieses Design schafft ein Gleichgewicht zwischen Effizienz und Leistung. Obwohl es etwas komplexer als die reine 2D-Struktur ist, verbessert es die Qualität der Sequenzvorhersage deutlich. Darüber hinausDie Studie ergab außerdem, dass das Vorabtraining von Zeitreihendaten effektiver ist als deren nachträgliche Anpassung.Es kann eine gute Synergie mit dem Gesamtrahmen bilden.

Experimentelle Auswertung: Die Leistung ist vergleichbar mit dem fortschrittlichsten Wettervorhersagesystem, mit höherer Rechenleistung

Um die Wirksamkeit von ERDM bei der Modellierung chaotischer dynamischer Systeme zu überprüfen, führten die Forscher eine systematische Bewertung durch, die sich auf die beiden Hauptziele der probabilistischen Vorhersagegenauigkeit und der Zuverlässigkeit der Unsicherheitsquantifizierung konzentrierte.Das Experiment verwendet zwei Arten von Kernindikatoren:Der Continuous Graded Probability Score (CRPS) dient zur umfassenden Bewertung der Gesamtabweichung zwischen Prognosewert und tatsächlicher Beobachtung. Je niedriger der Wert, desto besser die Leistung. Die Spread Skill Ratio (SSR) beurteilt die Rationalität der Unsicherheitsschätzung durch Vergleich der Ensemblevarianz mit dem mittleren Ensemblefehler. Ein SSR unter 1 zeigt eine Unterschätzung der Unsicherheit an, ein SSR über 1 eine Überschätzung. Idealerweise sollte der Wert nahe 1 liegen.

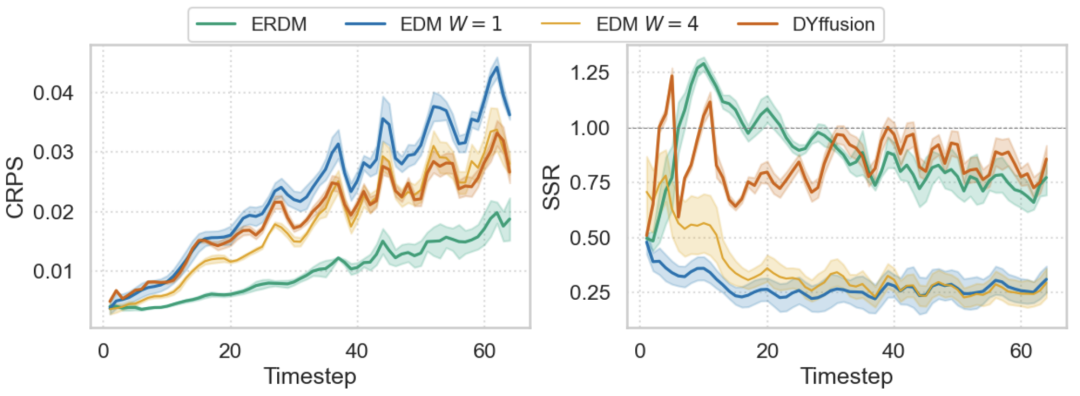

Im Navier-Stokes-Fluidmodellierungsexperiment verwendeten die Forscher Benchmark-Modelle, darunter DYffusion und eine Reihe von Benchmark-Modellen, die auf EDM basieren. Die experimentellen Ergebnisse zeigen, dassERDM zeigt im späten Vorhersagestadium erhebliche Vorteile, wobei sich sein CRPS im Vergleich zum besten EDM-Basiswert um etwa 50% verbessert.Während EDM-Modelle anfangs etwas besser abschnitten, nahmen ihre Fehler mit der Zeit schneller zu. DYffusion konnte den EDM-Benchmark während der gesamten Prognose nicht übertreffen. Aus Sicht der Unsicherheitskalibrierung übertraf ERDM den EDM-Benchmark durchweg mit erheblicher Unterdispersion. Die Studie ergab jedoch, dass letzterer Schwierigkeiten hatte, die Kalibrierung zu verbessern und gleichzeitig die CRPS-Leistung aufrechtzuerhalten.

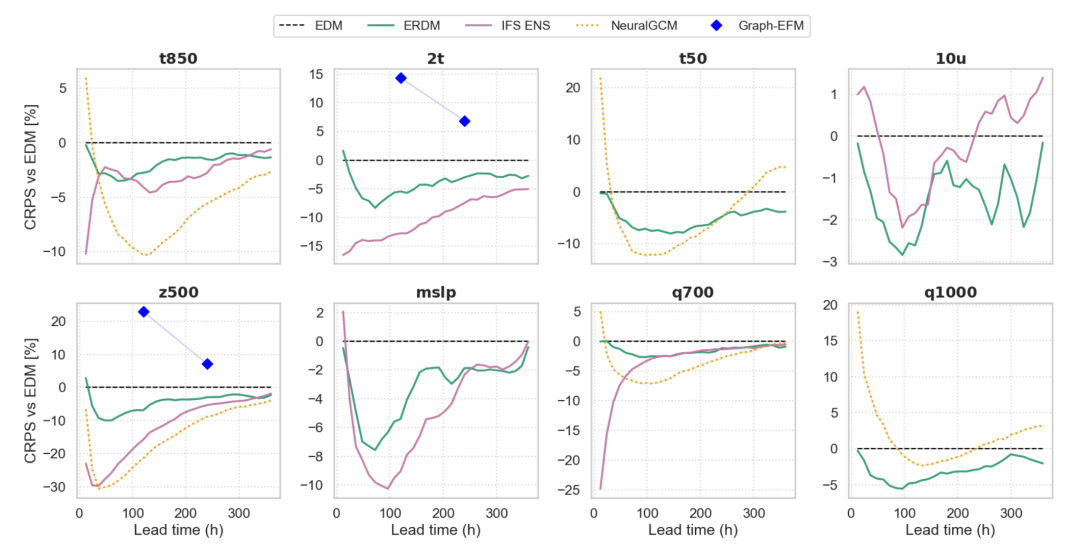

Bei der anspruchsvolleren ERA5-Aufgabe zur mittelfristigen Wettervorhersage umfassen die Benchmarks des Instituts interne EDM-Benchmarks und externe Geschäftsmodelle wie IFS ENS, NeuralGCM ENS und Graph-EFM. In Bezug auf die RecheneffizienzERDM benötigt für 5 Trainingstage nur 4 H100-GPUs, was viel weniger ist als bei anderen datengesteuerten Methoden.Experimentelle Ergebnisse zeigen, dass ERDM hinsichtlich der CRPS-Indikatoren durchweg besser abschneidet als der EDM-Benchmark, wobei die maximale Verbesserung 10% erreicht. Es übertrifft auch Graph-EFM. Im Vergleich zu IFS ENS und NeuralGCM ist ERDM konkurrenzfähig, liegt aber bei der kurzfristigen Vorhersage einiger Variablen immer noch knapp hinter IFS ENS. Analysen zeigen, dass dies mit der Art und Weise zusammenhängt, wie das Anfangsfeld aufgebaut ist, und dass es zukünftig durch die Initialisierungsstrategie von IFS ENS weiter verbessert werden kann. Es ist erwähnenswert, dass ERDM und IFS ENS gemeinsam die beste Leistung bei der Wahrscheinlichkeitskalibrierung aufweisen, während andere datengesteuerte Modelle im Allgemeinen Probleme mit der kurzfristigen Unterdiffusion haben. In Bezug auf die physikalische KonsistenzDas von ERDM erstellte 14-tägige Prognoseleistungsspektrum weist eine hohe Übereinstimmung mit dem IFS ENS auf.Es weist einen physikalischen Realismus auf, der den meisten Modellen des maschinellen Lernens überlegen ist, während NeuralGCM eine offensichtliche Unterschätzung der Energie in den mittleren und hohen Frequenzbändern aufweist.

Eine neue Ära der Chaosvorhersage: Eine neue Brücke zwischen Gewissheit und Zufälligkeit

Im Bereich der chaotischen dynamischen Systemmodellierung und Sequenzvorhersage, auf die sich ERDM konzentriert, fördern die globale akademische und geschäftliche Gemeinschaft kontinuierlich innovative Durchbrüche in dieser Richtung durch interdisziplinäre Integration und Technologieimplementierung. Diese Untersuchungen setzen nicht nur die Kernlogik der „Kombination physikalischer Vorannahmen mit datengesteuerten“ fort, sondern erweitern auch die Anwendungsgrenzen der probabilistischen Vorhersage und der Unsicherheitsquantifizierung.

Einerseits konzentrieren sich die akademischen Durchbrüche auf tiefgreifende Innovationen in der Strömungsdynamik und der Diffusionsmodellarchitektur. Google DeepMind hat mit Teams der New York University, der Stanford University und anderen Institutionen zusammengearbeitet, umKombination eines Physical Information Neural Network (PINN) mit einem hochpräzisen Gauss-Newton-Optimierer,Zum ersten Mal wurden in drei Arten von Fluidgleichungen, darunter den Navier-Stokes-Gleichungen, systematisch neue instabile Singularitäten entdeckt, was ein neues Paradigma für die Erforschung der komplexen Landschaft nichtlinearer partieller Differentialgleichungen darstellt.

Titel des Papiers:Entdeckung instabiler Singularitäten

Papieradresse:https://go.hyper.ai/iGh6t

Auf der Ebene der Optimierung der DiffusionsmodellarchitekturDas vom MIT CSAIL-Team vorgeschlagene Diffusion Force (DF)-Framework kombiniert die Vorteile des Vollsequenz-Diffusionsmodells mit autoregressiver Vorhersage.Durch die Zuweisung eines unabhängigen Rauschpegels zu jedem Token und die Verwendung einer kausalen Architektur werden die Stabilität und Flexibilität der Generierung langer Sequenzen verbessert. Die abgeleitete Monte-Carlo-Tree-Guidance-Strategie (MCTG) kann die Sampling-Effizienz von Trajektorien mit hoher Belohnung deutlich verbessern und hat sich in Bereichen wie der Roboterplanung und der Videovorhersage als effektiv erwiesen.

Titel des Papiers:Diffusionserzwingung: Nächste Token-Vorhersage trifft auf vollständige Sequenzdiffusion

Papieradresse:https://arxiv.org/pdf/2407.01392

auf der anderen Seite,Die innovativen Praktiken in der Geschäftswelt konzentrieren sich stärker auf die szenariobasierte Implementierung von Technologie und die Verbesserung ihrer Effizienz.Es hat sich als erheblicher Wert bei der Wettervorhersage und der Vorhersage von Zeitreihen in mehreren Domänen erwiesen. Huawei hat in Zusammenarbeit mit dem Wetteramt Chongqing das KI-Wettervorhersagemodell „Tian Zi 12h“ (V2.0) veröffentlicht. Basierend auf der verschachtelten Architektur des großskaligen Pangu-Modells integriert es minutengenaue Radarmosaike und hochpräzise Geländedaten. Durch räumlich-zeitliche Gewichtsoptimierung erhöht es die Vorhersageauflösung auf 1 km/h. Während des Regensturms in Chongqing stellte es Regenbandmuster und Niederschlagsintensität genau dar. Im Bereich der allgemeinen Zeitreihenvorhersage erreicht das DeepAR-Modell von Amazon mithilfe einer LSTM-Architektur und einer gemeinsamen Trainingsstrategie eine probabilistische Vorhersage von multivariaten Zeitreihen. Die generierte Wahrscheinlichkeitsverteilung quantifiziert effektiv Unsicherheit und wird in Szenarien wie der Bestandsverwaltung im Einzelhandel und der Prognose des Energieverbrauchs eingesetzt. Es verbessert die Prognosegenauigkeit, indem es Korrelationen zwischen Zeitreihen erfasst.

Mit der Weiterentwicklung grundlegender Modelle und der Integration interdisziplinären Wissens bauen ERDM und ähnliche technische Ansätze künftig schrittweise eine Brücke zwischen deterministischen Gleichungen und der Unsicherheit in der Praxis. Sie werden nicht nur für traditionelle wissenschaftliche Rechenaufgaben wie Wettervorhersagen und Flüssigkeitssimulationen eingesetzt, sondern auch eine neue Generation probabilistischer Modellierungsgrundlagen für komplexe sequenzielle Entscheidungsfindungsprobleme wie Roboterplanung, Energieplanung und sogar Biodynamik bieten.

Referenzlinks:

1.https://mp.weixin.qq.com/s/v7uuViL8gF0-5dNEGBR_aw

2.https://mp.weixin.qq.com/s/e5WVUW-HtoOPj4Kef9JwGA

3.https://mp.weixin.qq.com/s/58ZxgFiXqT4efdfygm_t9g