Command Palette

Search for a command to run...

NeurIPS 2025: Die Huazhong University of Science and Technology Und Andere Veröffentlichen OCRBench v2. Gemini Belegt Den Ersten Platz Im Chinesischen Sprachranking, Erhält Aber Nur Eine Ausreichende Punktzahl.

In den letzten Jahrzehnten hat sich die Bedeutung der optischen Zeichenerkennung (OCR) enorm weiterentwickelt – von einem traditionellen Bilderkennungstool zu einer Kernfunktion intelligenter Informationssysteme. Ursprünglich extrahierte sie hauptsächlich gedruckten oder handschriftlichen Text aus Bildern und wandelte ihn in computerlesbare Textdaten um. Heute erweitern sich die Einsatzmöglichkeiten der OCR-Technologie stetig, da Deep Learning und multimodale Modelle aufgrund vielfältiger Anforderungen entwickelt werden. Sie erkennt nicht nur Zeichen, sondern versteht auch die Struktur und Semantik von Dokumenten.Analysieren Sie Tabellen, Layouts und gemischten Text und Grafiken in komplexen Szenarien präzise.

Darüber hinaus wird das Modell beim groß angelegten multimodalen Vortraining einer großen Menge an Bilddaten mit Text ausgesetzt, wie z. B. Screenshots von Webseiten, Benutzeroberflächen, Postern, Dokumenten usw., und im unüberwachten Lernprozess entwickeln sich auf natürliche Weise OCR-Funktionen. Dadurch ist das große Modell nicht mehr von externen OCR-Modulen abhängig.Stattdessen kann es das Erkennen, Verstehen und Beantworten im End-to-End-Argumentationsprozess direkt abschließen.Noch wichtiger ist, dass die OCR-Technologie zur Voraussetzung für intelligente Aufgaben auf höherer Ebene wird. Nur wenn das Modell Text in Bildern genau erkennen kann, ist es in der Lage, Diagramme zu analysieren, Fragen zu Dokumenten zu beantworten, Wissen zu extrahieren und sogar Code zu verstehen.

Man kann sagen, dass die Leistung bei OCR-Aufgaben auch ein wichtiger Indikator für die Bewertung der Fähigkeiten großer multimodaler Modelle ist. Die aktuellen Anforderungen gehen längst über das „Vorlesen von Text“ hinaus. Tabellen, Diagramme, handschriftliche Notizen, komplexe Layouts in Dokumenten, die Textpositionierung von Textbildern und textbasiertes Denken sind allesamt schwierige Herausforderungen, die die Modelle bewältigen müssen.Die meisten herkömmlichen OCR-Bewertungsbenchmarks umfassen jedoch Einzelaufgaben und begrenzte Szenarien, was zu einer schnellen Sättigung der Modellbewertungen führt und es schwierig macht, ihre Fähigkeiten in komplexen Anwendungen wirklich widerzuspiegeln.

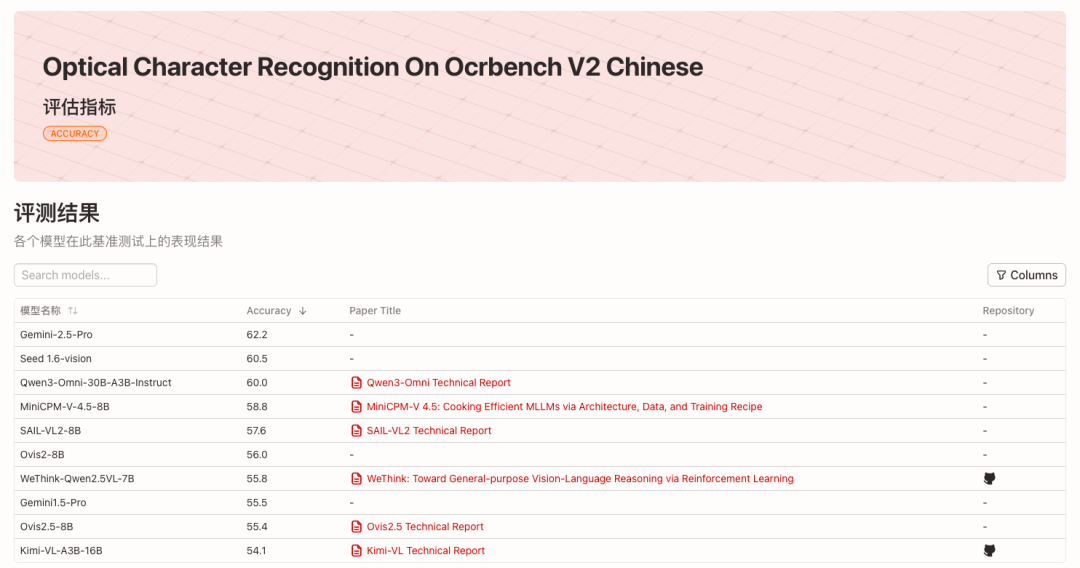

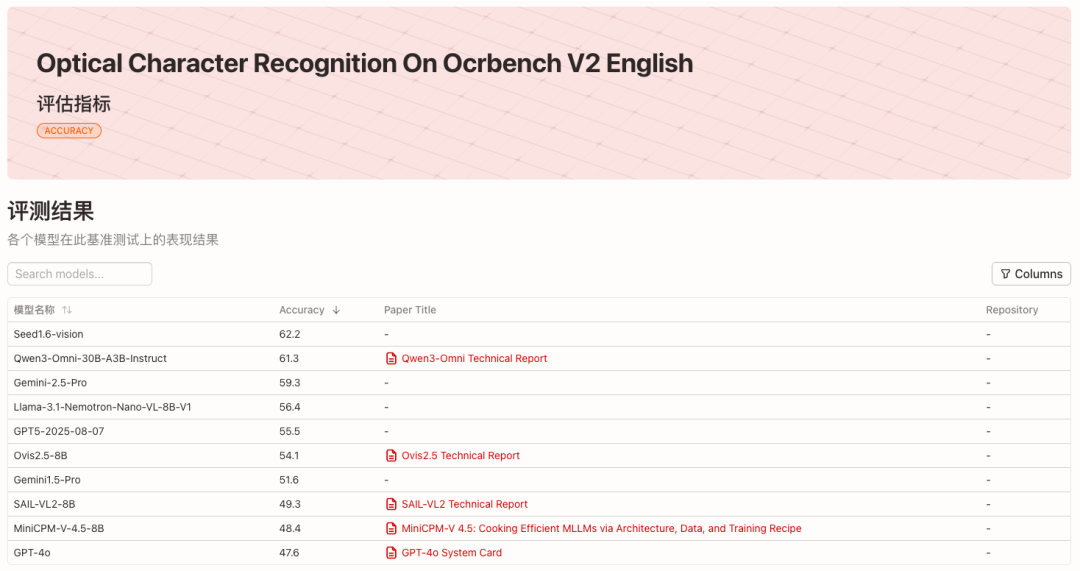

In Anbetracht dessenDas Team von Bai Xiang an der Huazhong University of Science and Technology hat in Zusammenarbeit mit der South China University of Technology, der University of Adelaide und ByteDance den OCR-Benchmark der nächsten Generation OCRBench v2 herausgebracht.Wir haben 58 gängige multimodale Modelle von 2023 bis 2025 sowohl auf Chinesisch als auch auf Englisch bewertet. Die Top-10-Modelle in jeder Liste sind in der folgenden Abbildung dargestellt:

* Sehen Sie sich die englischen Ranglisten an:

* Sehen Sie sich die chinesische Liste an:

* Open-Source-Adresse des Projekts:

https://github.com/Yuliang-Liu/MultimodalOCR

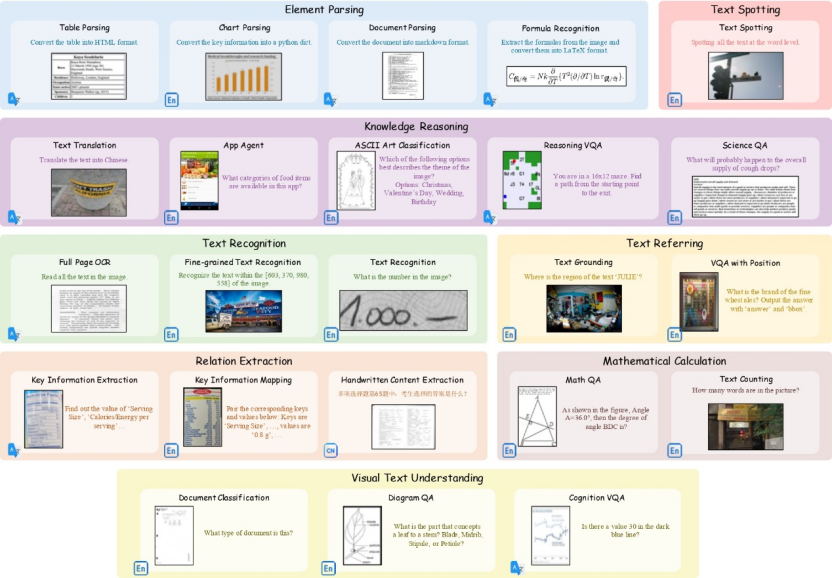

23 Unteraufgaben, die verschiedene Szenarien abdecken

OCRBench v2 deckt 23 Unteraufgaben und 8 Kernfähigkeitsdimensionen ab.——Texterkennung, Textpositionierung, Texterkennung und -erkennung, Beziehungsextraktion, Elementanalyse, mathematische Berechnung, visuelles Textverständnis und Wissensschlussfolgerung.

Der öffentliche Datensatz von OCRBench v2 umfasst 10.000 hochwertige Qualitätssicherungsberichte aus über 80 akademischen Datensätzen und einige proprietäre Daten. Diese wurden manuell überprüft, um sicherzustellen, dass sie vielfältige Szenarien realer OCR-Anwendungen abdecken. Darüber hinaus enthält OCRBench v2 unabhängige private Daten, bestehend aus 1.500 manuell erfassten und kommentierten Qualitätssicherungsberichten. Die Aufgabeneinstellungen und die Szenarioabdeckung entsprechen denen des öffentlichen Datensatzes.

* Adresse zum Herunterladen des Datensatzes:

https://go.hyper.ai/VNHSX

Die Experimente des Teams ergaben, dass die Rangfolge öffentlicher und privater Daten sehr konsistent ist.Dies beweist die Rationalität des Aufgabendesigns, der Datenkonstruktion und der Bewertungsindikatoren von OCRBench v2.Dies zeigt, dass es für die Messung der bestehenden Einschränkungen großer multimodaler Modelle von großem Wert ist.

Das zugehörige Forschungspapier mit dem Titel „OCRBench v2: Ein verbesserter Benchmark zur Bewertung großer multimodaler Modelle zur visuellen Textlokalisierung und -begründung“ wurde in den NeurIPS 2025 (Datasets and Benchmarks Track) aufgenommen.

* Papieradresse:

https://go.hyper.ai/VNHSX

Mainstream-Modelle sind im Allgemeinen voreingenommen und die höchste Punktzahl ist gerade noch ausreichend.

In der neuesten Bewertungsliste von OCRBench v2,Gemini-2.5-Pro errang den ersten Platz in der chinesischen Liste und den dritten Platz in der englischen Liste, während Seed1.6-vision den ersten Platz in der englischen Liste und den zweiten Platz in der chinesischen Liste gewann.Im Open-Source-Lager belegte Qwen3-Omni-30B-A3B-Instruct den zweiten Platz auf der englischen Liste und den dritten Platz auf der chinesischen Liste.

Durch die Analyse der Leistung der Kernfunktionen der Modelle können wir feststellen, dass diese großen multimodalen Modelle im Allgemeinen ein „verzerrtes“ Phänomen aufweisen. Nur wenige Modelle können in allen Kernfunktionen eine gute Leistung erbringen.Selbst die bestplatzierten Modelle erreichten bei den Aufgaben in Englisch und Chinesisch nur eine Durchschnittspunktzahl von etwa 60 von 100.Darüber hinaus weist jedes Modell leicht unterschiedliche Stärken auf. So haben kommerzielle Modelle wie Gemini-2.5-Pro einen klaren Vorteil bei Rechenaufgaben und demonstrieren ihre ausgeprägten Fähigkeiten zum logischen Denken. Llama-3.1-Nemotron-Nano-VL-8B-V1 erreichte mit seinen leistungsstarken Textlokalisierungsfunktionen den vierten Platz auf der englischen Liste.

Während die meisten Modelle bei der grundlegenden Texterkennung recht gute Ergebnisse erzielen, schneiden sie bei Aufgaben, die eine fein abgestufte räumliche Wahrnehmung und ein strukturiertes Verständnis erfordern, wie z. B. Referenzieren, Erkennen und Parsen, im Allgemeinen schlecht ab. Beispielsweise erreichte selbst das am höchsten bewertete Seed1.6-Vision-Modell beim Erkennen nur 38,0 Punkte. Dies schränkt seine Effektivität in realen Szenarien wie textbasierten Szenen und Dokumenten mit gemischtem Text und Bildern ein.

Darüber hinaus durch den Vergleich der chinesischen und englischen Listen,Es lässt sich feststellen, dass die Mehrsprachigkeit vieler Modelle uneinheitlich ist.Beispielsweise belegt Llama-3.1-Nemotron-Nano-VL-8B-V1 den vierten Platz auf der englischen Liste (durchschnittliche Punktzahl 56,4), aber nur den 31. Platz auf der chinesischen Liste (durchschnittliche Punktzahl 40,1). Dies weist darauf hin, dass es in englischen Szenarien einen größeren Vorteil hat, was mit der Datenverteilung oder der Trainingsstrategie zusammenhängen könnte.

Obwohl Closed-Source-Modelle weiterhin führend sind, sind hervorragende Open-Source-Modelle äußerst wettbewerbsfähig geworden. Von den Closed-Source-Modellen wie der Gemini-Serie, GPT5 und Seed1.6-Vision weisen sie eine bessere Gesamtleistung auf, während Open-Source-Modelle wie Qwen-Omni, InternVL, SAIL-VL und Ovis äußerst wettbewerbsfähig geworden sind.Fünf der Top-10-Modelle auf der englischen Liste sind Open-Source-Modelle, während sieben der Top-10-Modelle auf der chinesischen Liste Open-Source-Modelle sind.Open-Source-Modelle können auch bei Aufgaben wie Textlokalisierung, Elementextraktion und visuellem Textverständnis eine hochmoderne Leistung erzielen.

Die OCRBench v2-Ranglisten werden vierteljährlich aktualisiert und HyperAI wird weiterhin die neuesten Bewertungsergebnisse verfolgen.