Command Palette

Search for a command to run...

Online-Tutorial: Wan2.2-S2V-14B, Ein Videogenerierungsmodell in Filmqualität, Generiert Minutenlange Digitale Menschenvideos Nur Unter Verwendung Von Statischen Bildern Und Audio.

HyperAI hat kürzlich ein Online-Tutorial für Wan2.2 veröffentlicht, das Open-Source-KI-Videogenerierungsmodell von Alibabas Tongyi Wanxiang Lab. Als weltweit erstes MoE-basiertes Videomodell beeindruckte uns Wan2.2 mit seiner filmischen Qualität und hohen Rechenleistung. Was halten Sie von der Verwendung? Teilen Sie uns Ihre Meinung gerne im Kommentarbereich mit.

Im August dieses Jahres machte das Tongyi Wanxiang-Team neue Fortschritte: Basierend auf dem Text-zu-Video-Basismodell Wan2.2 bauten sie den Wan-14B.Darauf basierend wurde ein Open-Source-Modell zur audiogesteuerten Videogenerierung, Wan2.2-S2V-14B, eingeführt.Das Modell erfordert nur ein statisches Bild und einen Audioclip.Es kann digitale Menschenvideos mit einer Textur auf Filmniveau und einer Dauer von bis zu Minuten generieren und unterstützt eine Vielzahl von Bildtypen und Rahmen.Das Forschungsteam führte Experimente durch, bei denen es mit bestehenden Spitzenmodellen verglichen wurde. Die Ergebnisse zeigten, dass Wan2.2-S2V-14B sowohl hinsichtlich der Ausdruckskraft als auch der Authentizität der generierten Inhalte erhebliche Verbesserungen aufweist.

Um die Generierungsqualität des Modells in komplexen Szenarien zu unterstützen, verfolgte das Forschungsteam eine zweigleisige Strategie, um einen umfassenderen Trainingsdatensatz zusammenzustellen.Das Team filterte einerseits automatisch Daten aus umfangreichen Open-Source-Datensätzen wie OpenHumanViD. Andererseits wählten die Forscher auch manuell hochwertige Beispieldaten aus und passten sie an. Beide Datensätze wurden einheitlich durch mehrere Methoden gefiltert, darunter Haltungsverfolgung, Beurteilung von Klarheit und Ästhetik sowie Erkennung audiovisueller Synchronisation, um schließlich einen Datensatz mit sprechenden Köpfen zu erstellen. Mithilfe einer hybriden parallelen Trainingsstrategie erreichten sie ein effizientes Model Performance Mining.

„Wan2.2-S2V-14B: Cinematic Audio-Driven Video Generation“ ist jetzt im Bereich „Tutorials“ der offiziellen Website von HyperAI (hyper.ai) verfügbar. Kommen Sie und erstellen Sie Ihren eigenen digitalen Menschen!

Link zum Tutorial:

Demolauf

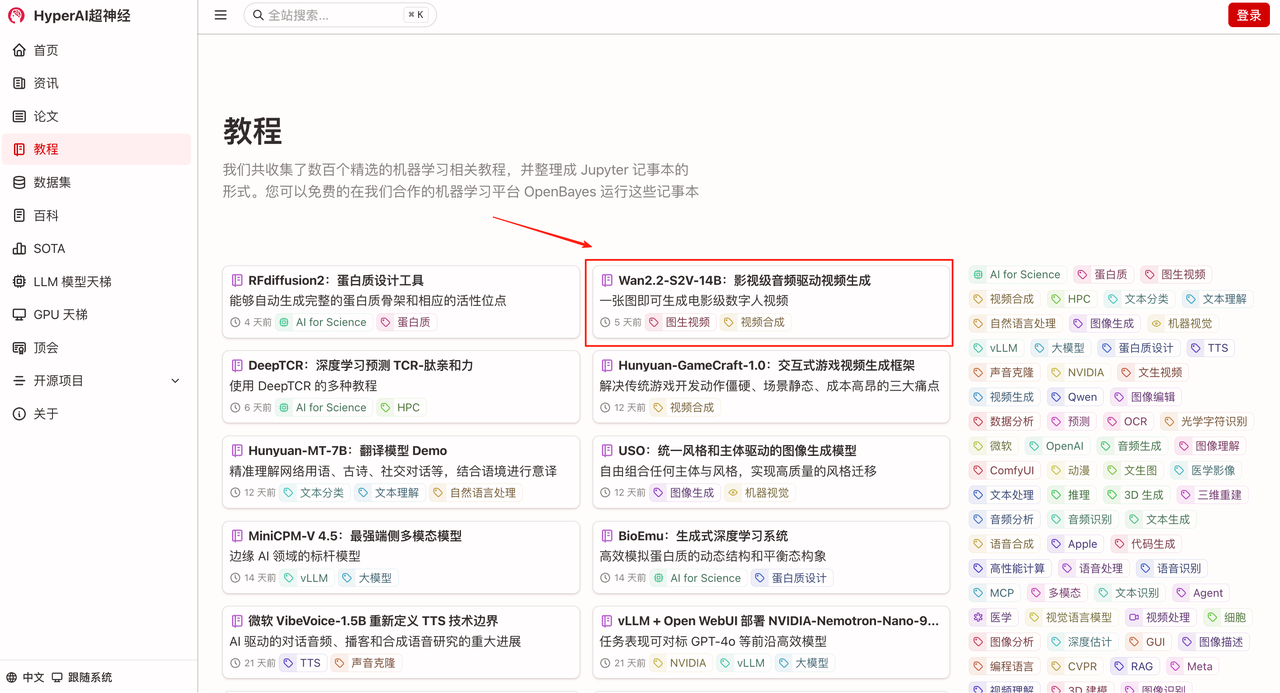

1. Wählen Sie auf der Homepage von hyper.ai die Seite „Tutorials“ aus, wählen Sie „Wan2.2-S2V-14B: Audiogesteuerte Videogenerierung in Filmqualität“ und klicken Sie auf „Dieses Tutorial online ausführen“.

2. Klicken Sie nach dem Seitensprung oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

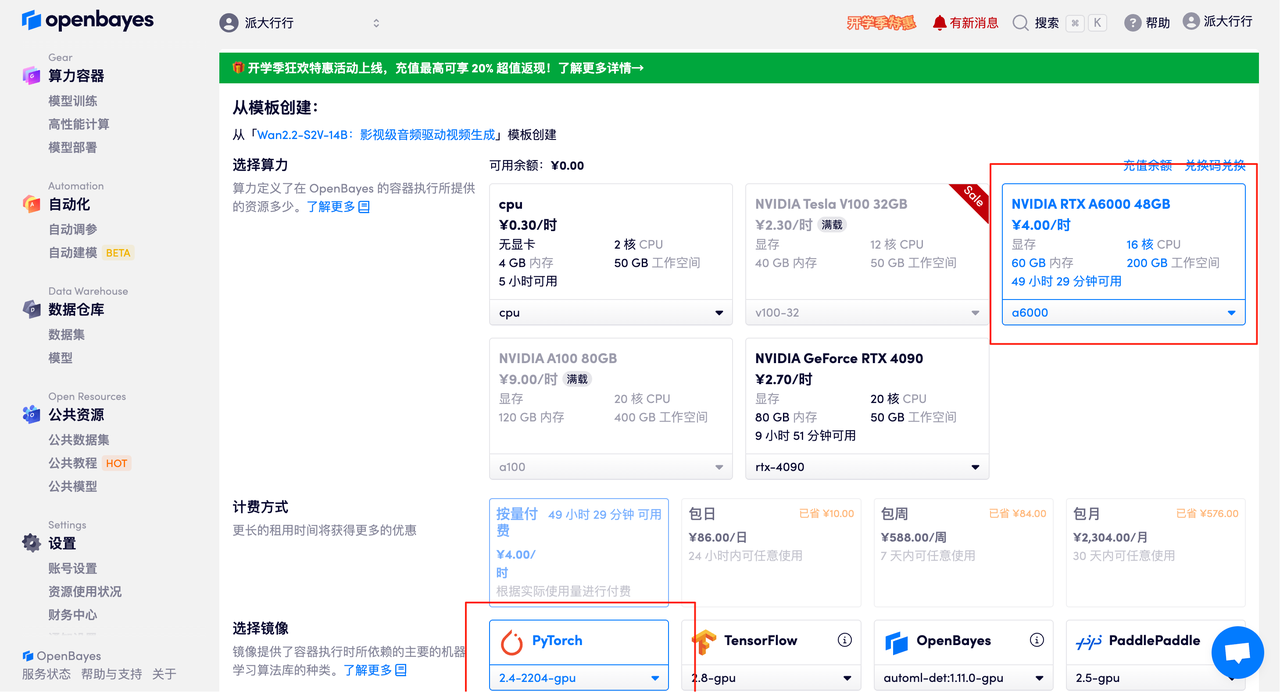

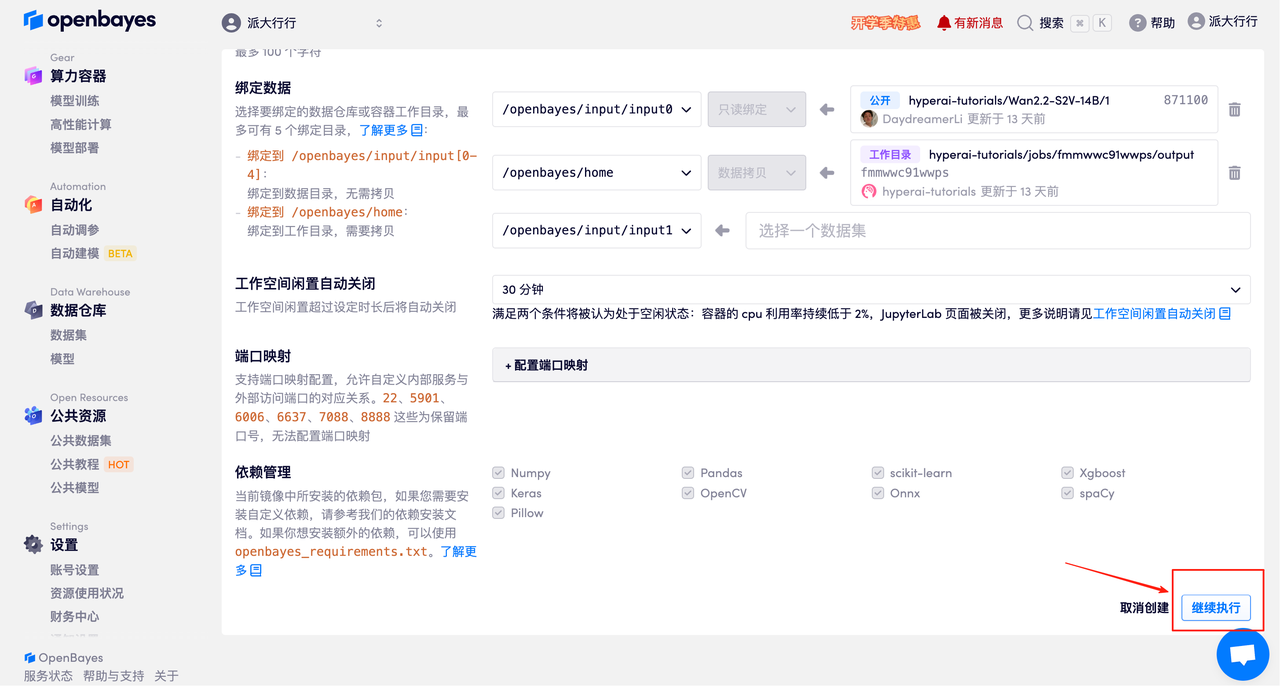

3. Wählen Sie die NVIDIA RTX A6000 48 GB und PyTorch-Images aus und klicken Sie auf „Weiter“. Die OpenBayes-Plattform bietet vier Abrechnungsoptionen: Pay-as-you-go oder Tages-/Wochen-/Monatstarife. Neue Benutzer können sich über den unten stehenden Einladungslink registrieren und erhalten 4 Stunden kostenlose RTX 4090 und 5 Stunden kostenlose CPU-Zeit!

Exklusiver Einladungslink von HyperAI (kopieren und im Browser öffnen):

https://openbayes.com/console/signup?r=Ada0322_NR0n

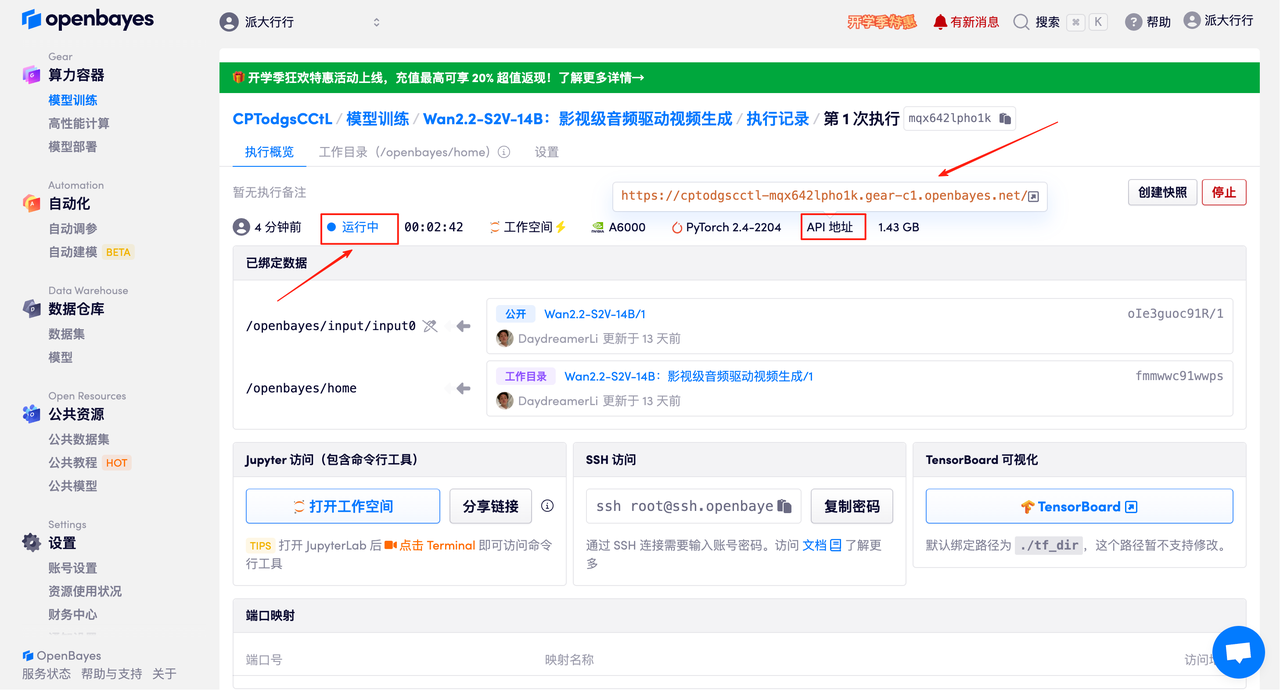

4. Warten Sie, bis die Ressourcen zugewiesen sind. Der erste Klonvorgang dauert etwa 3 Minuten. Wenn der Status auf „Läuft“ wechselt, klicken Sie auf den Pfeil neben „API-Adresse“, um zur Demoseite zu gelangen. Bitte beachten Sie, dass Benutzer vor der Verwendung der API-Adresse eine Echtnamen-Authentifizierung durchführen müssen.

Effektdemonstration

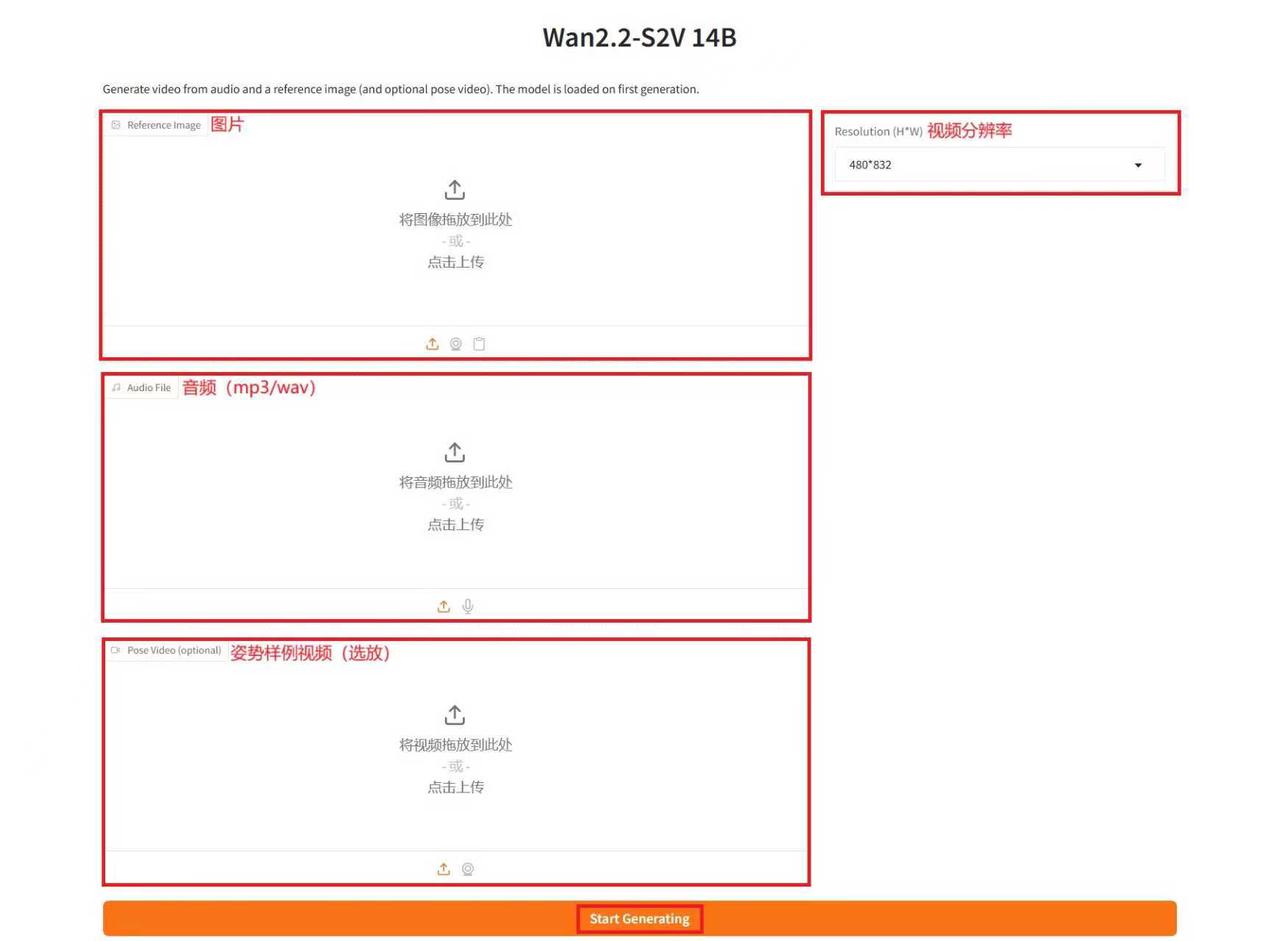

Geben Sie auf der Demo-Run-Seite eine Beschreibung in das Textfeld ein, laden Sie Bilder und Audio hoch, passen Sie die Parameter nach Bedarf an und klicken Sie auf „Generierung starten“, um das Video zu generieren. (Hinweis: Eine höhere Anzahl von Inferenzschritten führt zu besseren Ergebnissen, dauert aber auch länger. Stellen Sie daher die Anzahl der Inferenzschritte entsprechend ein. Bei 10 Inferenzschritten dauert die Generierung eines Videos beispielsweise etwa 15 Minuten.)

Beispiel generieren

Das Obige ist das diesmal von HyperAI empfohlene Tutorial. Jeder ist herzlich eingeladen, vorbeizukommen und es auszuprobieren!

Link zum Tutorial: