Command Palette

Search for a command to run...

Wöchentlicher KI-Bericht: NVIDIAs Neustes Sprachmodell/technischer Bericht Zu Ovis 2.5 … Ein Kurzer Blick Auf Die Neuesten Fortschritte Bei Der Optimierung Großer Modellarchitekturen/3D-Modellierung/Ausrichtung Und Selbstverifizierung

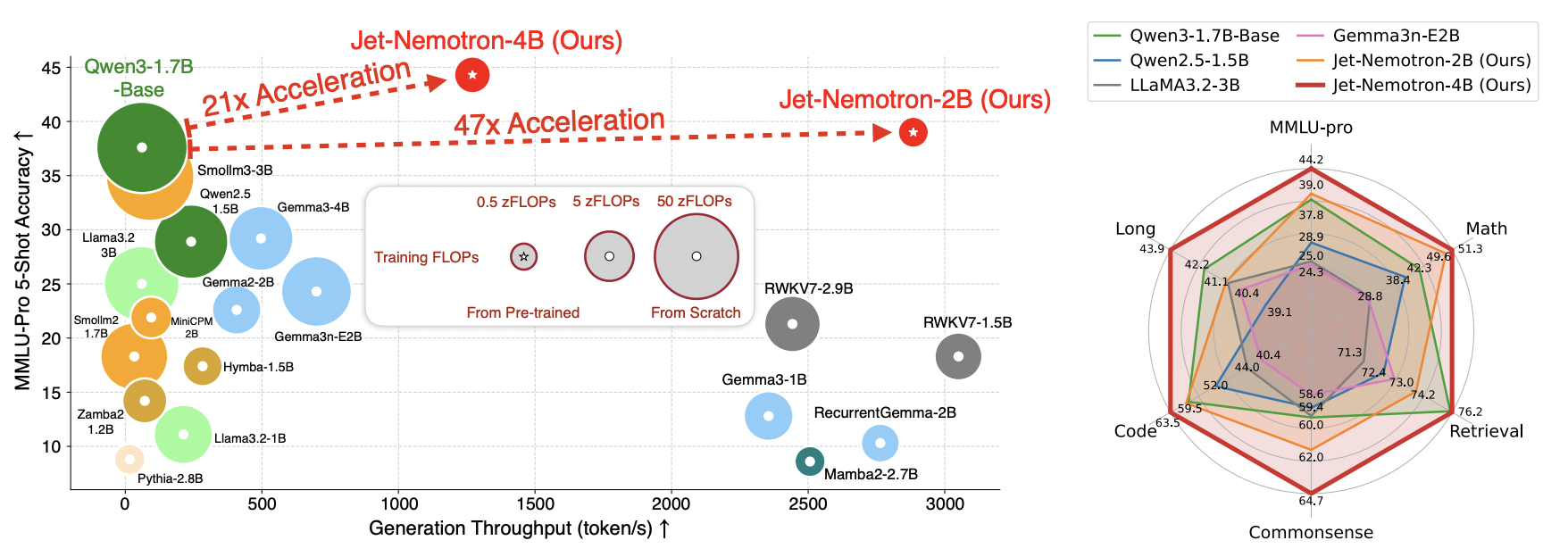

Mit der rasanten Entwicklung groß angelegter Sprachmodelle haben Full-Attention-Mechanismen eine beeindruckende Genauigkeit bewiesen. Ihre Rechenkomplexität von O(n²) führt jedoch zu einem erheblichen Speicher- und Rechenleistungsverbrauch bei Aufgaben mit langen Kontexten, was ihre effiziente Anwendung einschränkt. Bestehende Architekturen basieren oft auf einem Training von Grund auf, was kostspielig und für kleine und mittlere Forschungseinrichtungen ungeeignet ist. Hybridarchitekturen vereinen zwar Genauigkeit und Effizienz, stehen aber immer noch vor Herausforderungen hinsichtlich Designkomplexität und Hardwareanpassung.

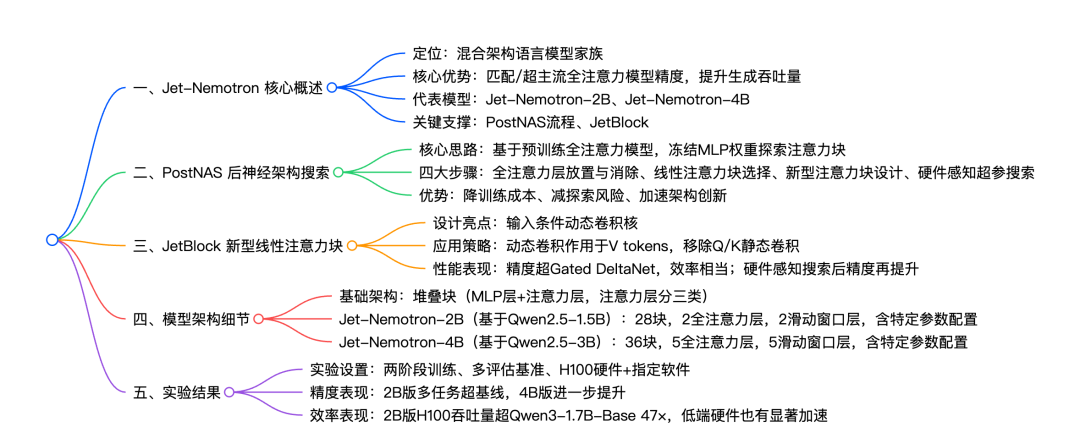

Um diese Herausforderungen zu bewältigen, schlug das Forschungsteam Jet-Nemotron vor. Dabei wird Post-Neural Architecture Search (PostNAS) verwendet, um die MLP-Gewichte auf einem vortrainierten Full-Attention-Modell einzufrieren, das optimale Design des Aufmerksamkeitsmoduls zu erkunden und den Generierungsdurchsatz deutlich zu verbessern, während die Genauigkeit des Full-Attention-Modells beibehalten oder übertroffen wird. Dies bietet einen gangbaren Weg für ein effizientes Sprachmodelldesign.

Link zum Artikel:https://go.hyper.ai/8MhfF

Neueste KI-Artikel:https://go.hyper.ai/hzChC

Um mehr Benutzer über die neuesten Entwicklungen im Bereich der künstlichen Intelligenz in der Wissenschaft zu informieren, wurde auf der offiziellen Website von HyperAI (hyper.ai) jetzt der Bereich „Neueste Artikel“ eingerichtet, in dem täglich hochmoderne KI-Forschungsartikel aktualisiert werden.Hier sind 5 beliebte KI-Artikel, die wir empfehlenGleichzeitig haben wir auch die Mindmap der Papierstruktur für alle zusammengefasst. Werfen wir einen kurzen Blick auf die KI-Spitzenleistungen dieser Woche ⬇️

Die Zeitungsempfehlung dieser Woche

1. Jet-Nemotron: Effizientes Sprachmodell mit postneuronaler Architektursuche

Dieses Dokument stellt Jet-Nemotron vor, eine Familie neuartiger Sprachmodelle mit hybrider Architektur, die den Generierungsdurchsatz deutlich verbessert und gleichzeitig die Genauigkeit führender Full-Attention-Modelle beibehält oder übertrifft. Jet-Nemotron wurde mithilfe eines neuartigen Prozesses zur Erkundung neuronaler Architekturen namens „Post-Neural Architecture Search“ entwickelt, der eine effiziente Modellentwicklung ermöglicht. Im Gegensatz zu herkömmlichen Ansätzen beginnt PostNAS mit einem vortrainierten Full-Attention-Modell und friert dessen mehrschichtige Perzeptron-Gewichte ein, was eine effiziente Erkundung der Strukturen von Aufmerksamkeitsmodulen ermöglicht.

Link zum Artikel:https://go.hyper.ai/8MhfF

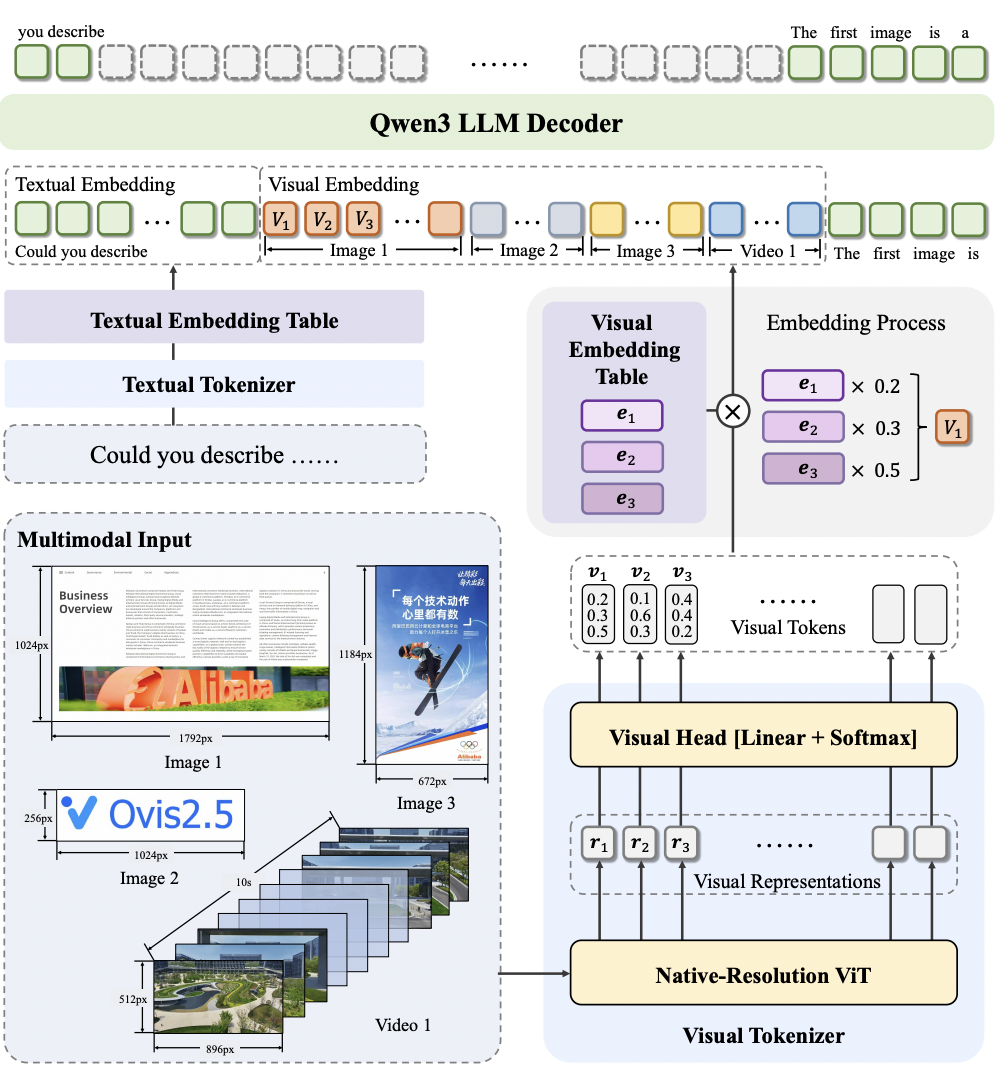

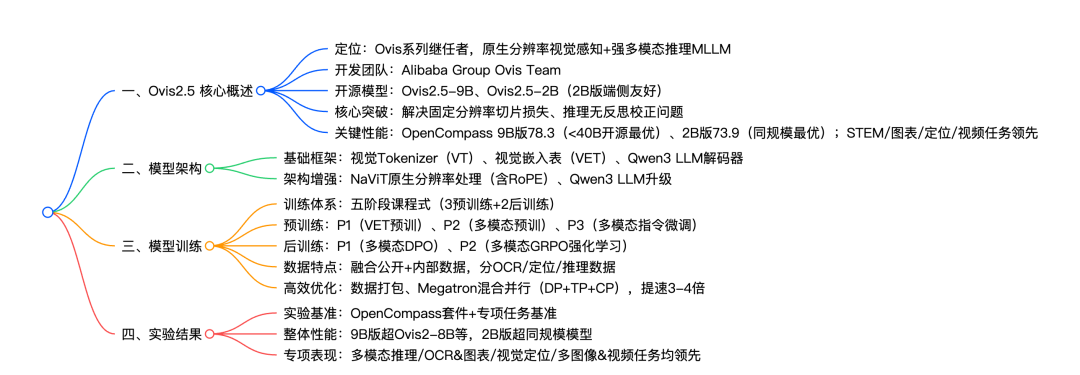

2. Technischer Bericht zu Ovis2.5

Dieses Dokument stellt Ovis2.5 vor, das für visuelle Wahrnehmung in nativer Auflösung und leistungsstarkes multimodales Denken entwickelt wurde. Ovis2.5 integriert einen visuellen Transformator in nativer Auflösung, der Bilder direkt in ihrer nativen, variablen Auflösung verarbeitet. Dadurch werden die mit der Segmentierung in fester Auflösung verbundenen Qualitätseinbußen vermieden, während feine Details und das globale Layout vollständig erhalten bleiben.

Link zum Artikel:https://go.hyper.ai/nZOmk

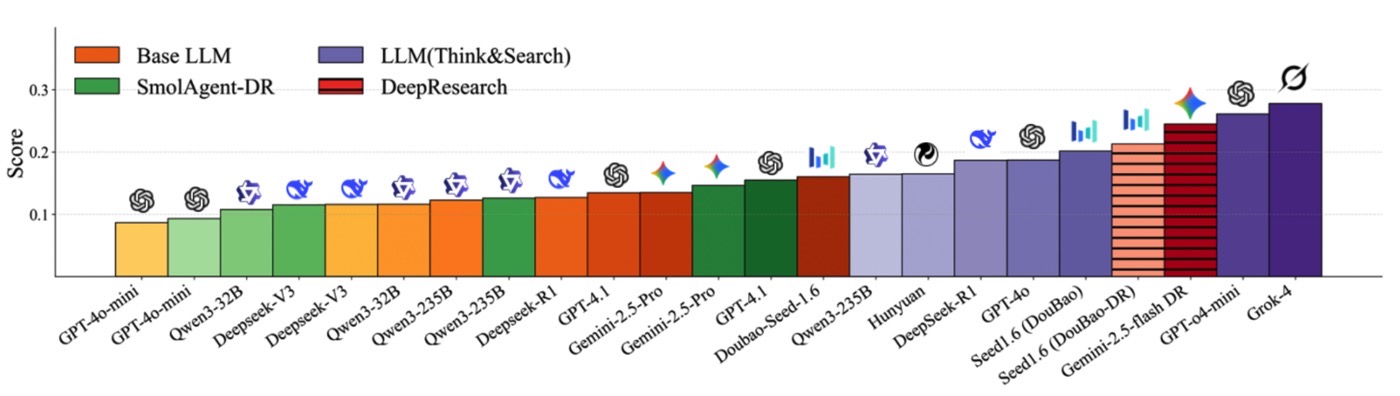

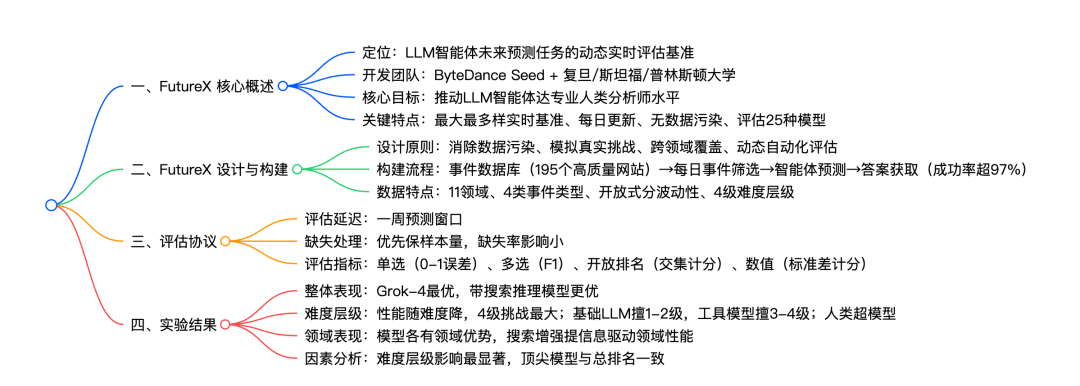

3. FutureX: Ein erweiterter Live-Benchmark für LLM-Agenten in der Zukunftsprognose

Zukunftsvorhersagen erfordern Agenten mit komplexem Denkvermögen und dynamischer Anpassungsfähigkeit – eine komplexe Aufgabe für Agenten großer Sprachmodelle. Derzeit mangelt es an groß angelegten Benchmarks, die in Echtzeit aktualisiert werden und ihre Vorhersageleistung präzise bewerten können. Dieses Dokument stellt FutureX vor, einen dynamischen Echtzeit-Evaluierungs-Benchmark, der speziell für Zukunftsvorhersagen für LLM-Agenten entwickelt wurde. FutureX ist das bislang größte und vielfältigste Framework zur Echtzeit-Vorhersagebewertung. Es unterstützt tägliche Echtzeit-Updates und nutzt automatisierte Prozesse zur Fragen- und Antworterfassung, wodurch Datenkontamination effektiv vermieden wird.

Link zum Artikel:https://go.hyper.ai/rjbaU

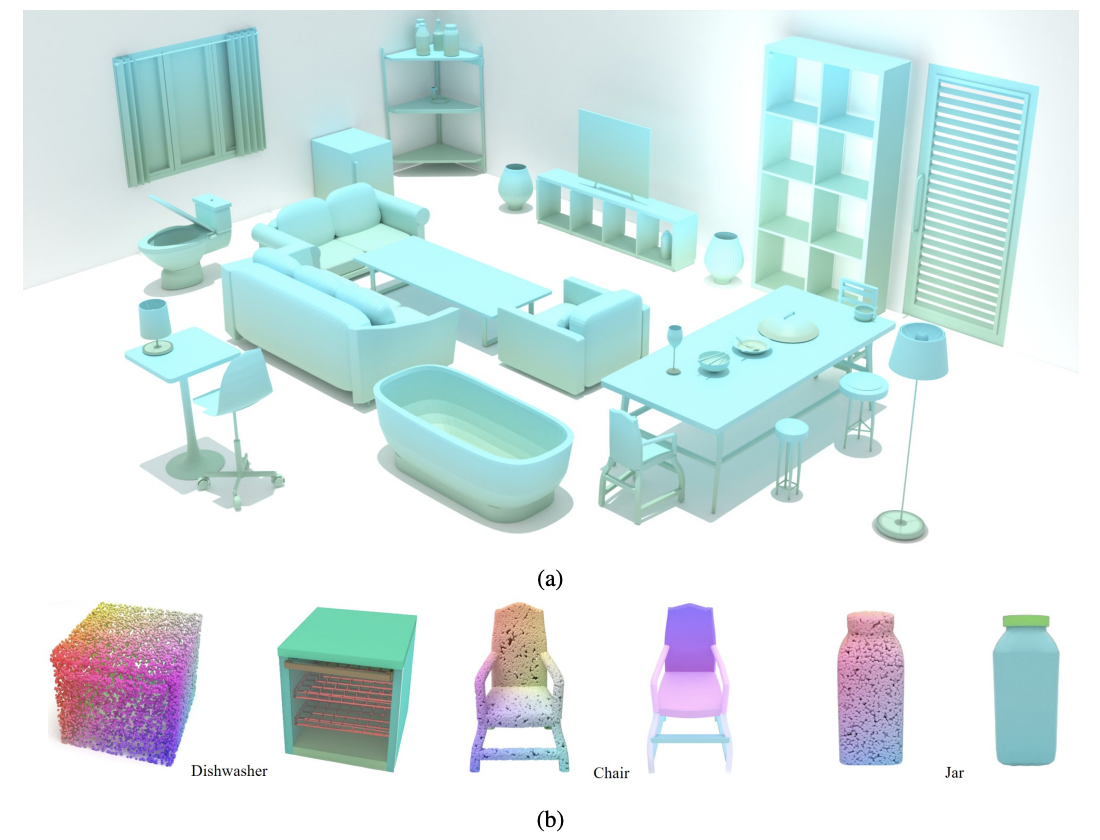

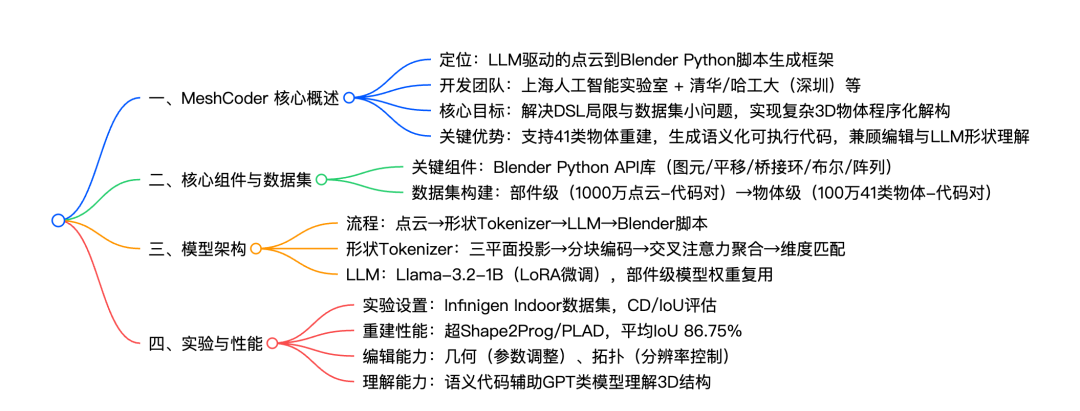

4. MeshCoder: LLM-gestützte strukturierte Mesh-Code-Generierung aus Punktwolken

Die Rekonstruktion von 3D-Objekten in editierbare Programme ist für Anwendungen wie Reverse Engineering und Formbearbeitung entscheidend, doch bestehende Methoden weisen noch viele Einschränkungen auf. Dieses Dokument stellt MeshCoder vor, ein neues Framework, das komplexe 3D-Objekte aus Punktwolken in editierbare Blender-Python-Skripte rekonstruiert. Durch die Entwicklung einer umfangreichen API, den Aufbau eines umfangreichen Objektcode-Datensatzes und das Training eines multimodalen Large Language Models wird eine hochpräzise Form-zu-Code-Konvertierung erreicht. Dies verbessert nicht nur die 3D-Rekonstruktionsleistung, sondern unterstützt auch die intuitive Geometrie- und Topologiebearbeitung und verbessert die Argumentationsfähigkeiten von LLM für das Verständnis von 3D-Formen.

Link zum Artikel:https://go.hyper.ai/EAWIn

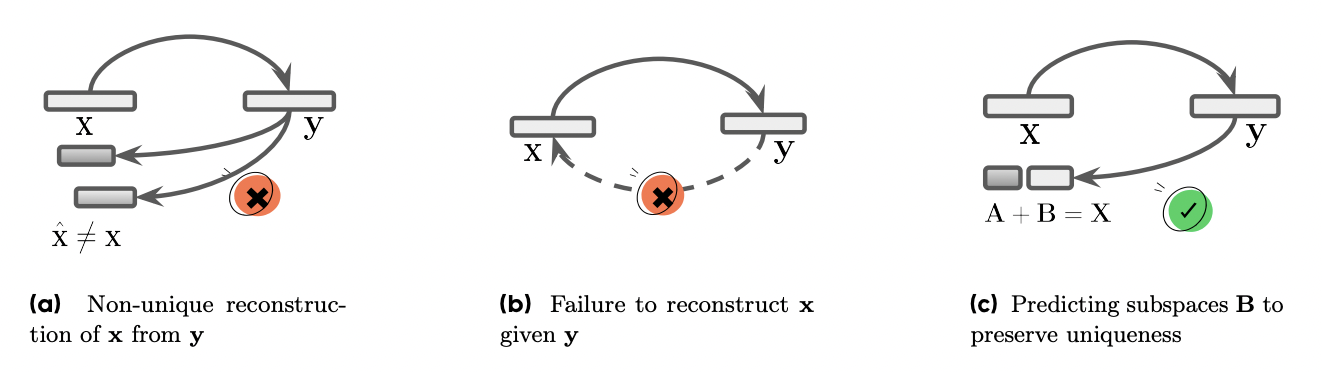

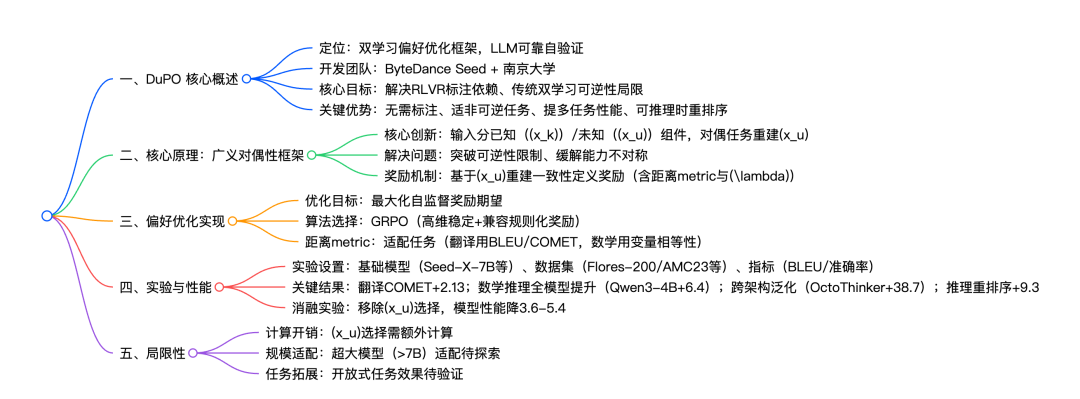

5. DuPO: Ermöglichung einer zuverlässigen LLM-Selbstverifizierung durch DualPreference-Optimierung

Dieser Artikel stellt DuPO vor, ein auf dualem Lernen basierendes Framework zur Präferenzoptimierung, das mittels verallgemeinerter Dualität unmarkiertes Feedback generiert. DuPO behebt zwei wesentliche Einschränkungen: Erstens basiert Reinforcement Learning mit verifizierbaren Belohnungen (RLVR) auf aufwendigen Annotationen und ist nur auf verifizierbare Aufgaben anwendbar; zweitens ist traditionelles duales Lernen auf strikt duale Aufgabenpaare (z. B. Übersetzung und Rückübersetzung) beschränkt.

Link zum Artikel:https://go.hyper.ai/2Gycl

Dies ist der gesamte Inhalt der Papierempfehlung dieser Woche. Weitere aktuelle KI-Forschungsarbeiten finden Sie im Bereich „Neueste Arbeiten“ auf der offiziellen Website von hyper.ai.

Wir freuen uns auch über die Einreichung hochwertiger Ergebnisse und Veröffentlichungen durch Forschungsteams. Interessierte können sich im NeuroStar WeChat anmelden (WeChat-ID: Hyperai01).

Bis nächste Woche!