Command Palette

Search for a command to run...

Ein-Klick-Bereitstellung Von gpt-oss-20b, Testen Von Open-Source-Inferenzmodellen Mit Modernster Leistung, Die an Die Des o3-mini Heranreicht

Sechs Jahre nach GPT-2 hat OpenAI endlich ein weiteres großes Open-Source-Modell veröffentlicht – gpt-oss-120b und gpt-oss-20b.Ersteres ist für komplexe Schlussfolgerungen und wissensintensive Szenarien mit Hunderten von Milliarden Parametern konzipiert, während Letzteres eher für lokale oder spezialisierte vertikale Anwendungen mit geringer Latenz geeignet ist und reibungslos auf Consumer-Hardware wie Laptops und Edge-Geräten läuft. Diese duale Version aus „Vielseitigkeit großer Modelle + Professionalität kleiner Modelle“ bietet differenzierte Positionierungs- und Bereitstellungsflexibilität und erfüllt so effektiv die unterschiedlichen Bedürfnisse der Benutzer.

Auf technischer Ebene verwendet gpt-oss die MoE-Architektur, um eine starke Leistung sicherzustellen und gleichzeitig den Rechen- und Speicherbedarf deutlich zu reduzieren.Unter diesen kann gpt-oss-120b effizient auf einer einzelnen 80-GB-GPU ausgeführt werden, während gpt-oss-20b auf Edge-Geräten mit nur 16 GB Speicher ausgeführt werden kann.

Bei tatsächlichen Aufgabenbewertungen übertraf gpt-oss-120b o3-mini in Codeforces, MMLU, HLE und dem Tool-Call TauBench und war gleichauf mit o4-mini oder übertraf es sogar.Darüber hinaus übertrifft es o4-mini bei HealthBench und AIME 2024 und 2025. Trotz einer kleineren Modellparametergröße schneidet gpt-oss-20b bei denselben Bewertungen fast genauso gut ab wie o3-mini.

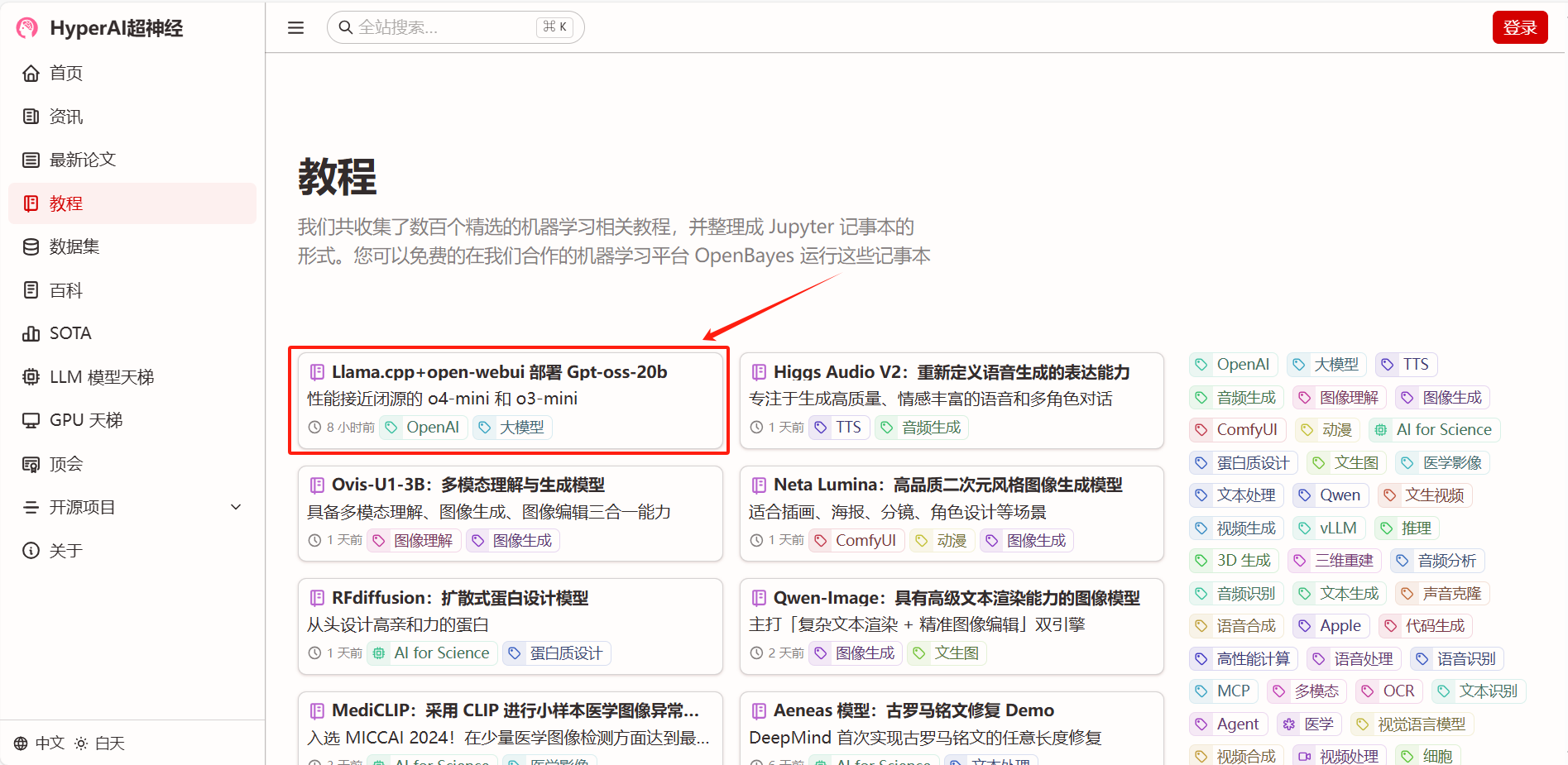

Damit jeder gpt-oss reibungsloser erleben kann,Das Tutorial „Llama.cpp+open-webui-Bereitstellung von Gpt-oss-20b“ ist jetzt im Abschnitt „Tutorials“ der offiziellen Website von HyperAI (hyper.ai) verfügbar.Beginnen Sie mit einem Klick und erleben Sie die leistungsstarken Funktionen des Open-Source-SOTA-Modells basierend auf einer einzelnen NVIDIA RTX 4090-Karte.

Zusätzlich,Auch das Tutorial für gpt-oss-120b ist in vollem Gange und wir freuen uns darauf!

Link zum Tutorial:

Demolauf

1. Wählen Sie auf der Homepage von hyper.ai die Seite „Tutorials“ aus, wählen Sie Llama.cpp+open-webui, um gpt-oss-20b bereitzustellen, und klicken Sie auf „Dieses Tutorial online ausführen“.

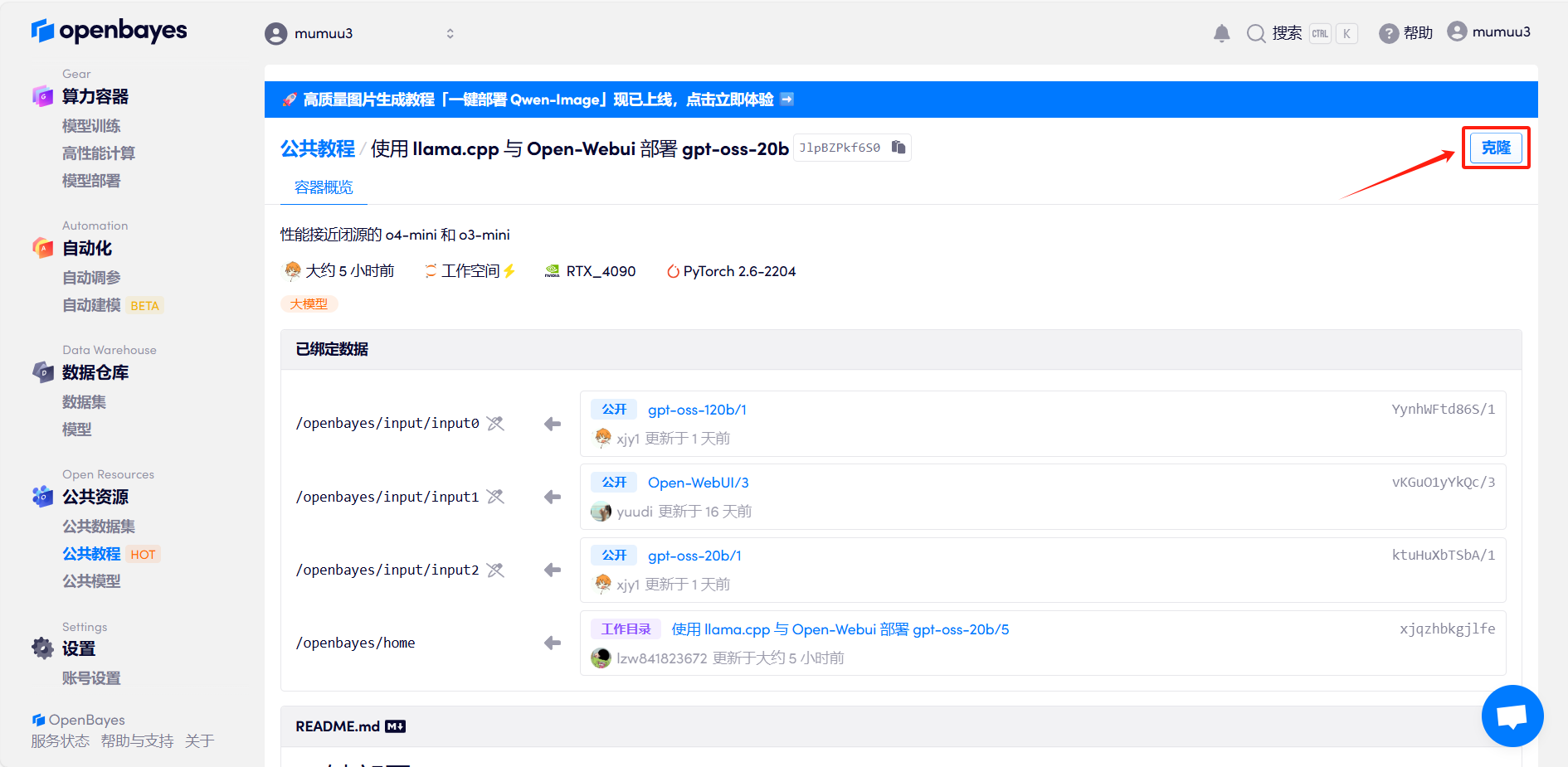

2. Klicken Sie nach dem Seitensprung oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

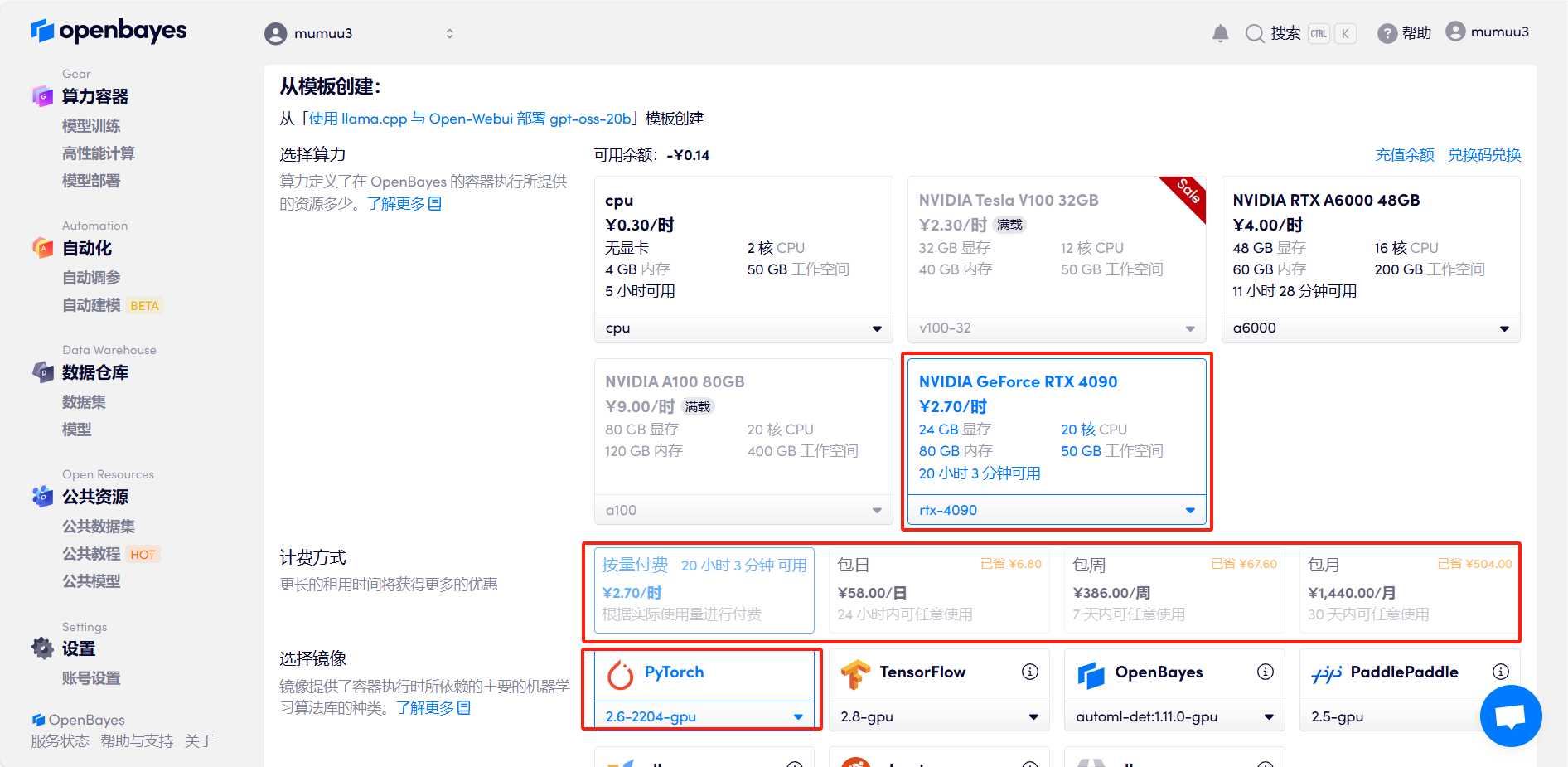

3. Wähle die Bilder „NVIDIA GeForce RTX 4090“ und „PyTorch“ aus, wähle je nach Bedarf „Pay as you go“ oder „Tages-/Wochen-/Monatspaket“ und klicke auf „Weiter“. Neue Benutzer können sich über den unten stehenden Einladungslink registrieren und erhalten 4 Stunden RTX 4090 + 5 Stunden CPU-freie Zeit!

Exklusiver Einladungslink von HyperAI (kopieren und im Browser öffnen):

https://openbayes.com/console/signup?r=Ada0322_NR0n

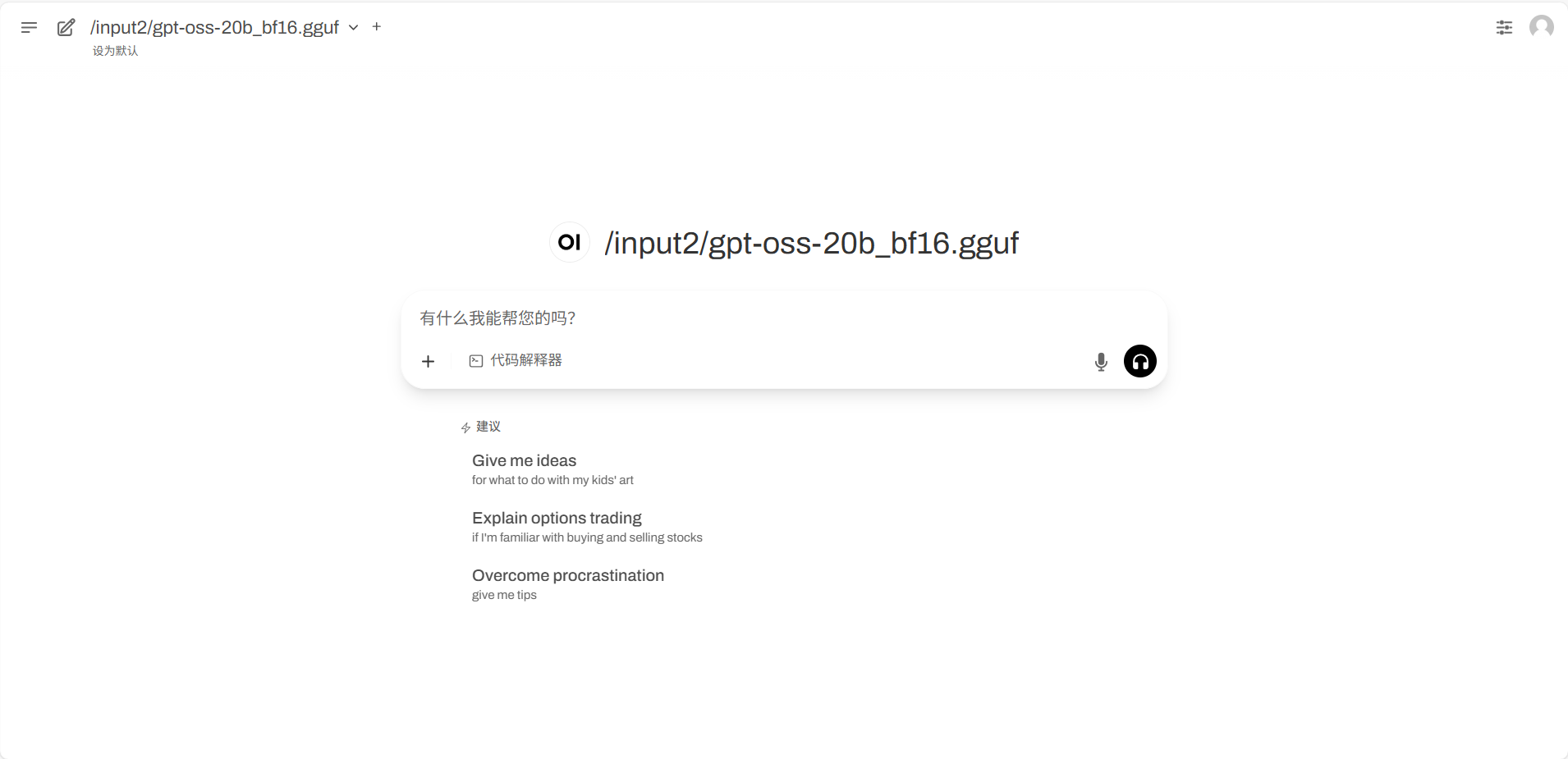

4. Warten Sie, bis die Ressourcen zugewiesen sind. Der erste Klonvorgang dauert etwa 3 Minuten. Wenn der Status auf „Läuft“ wechselt, klicken Sie auf den Pfeil neben „API-Adresse“, um zur Demoseite zu gelangen. Bitte beachten Sie, dass Benutzer vor der Verwendung der API-Adresse eine Echtnamen-Authentifizierung durchführen müssen.

Effektdemonstration

Nachdem Sie die Seite „Demo ausführen“ aufgerufen haben, geben Sie im Dialogfeld „Eingabeaufforderung“ ein und klicken Sie auf „Ausführen“.

Der Autor hat einen einfachen Test zur Inhaltserstellung, zur mathematischen Problemlösung und zur Argumentationsfähigkeit des Modells durchgeführt und die Antworten von gpt-oss waren alle recht gut.

Aufforderung: Bitte schreiben Sie ein Comedy-Drehbuch über die Crazy Thursdays von KFC, etwa 300 Wörter.

Eingabeaufforderung: Was sind die erste und zweite Ziffer nach dem Komma von (Quadratwurzel aus 2 + Quadratwurzel aus 3) hoch 2006?

Eingabeaufforderung: Stellen Sie fest, ob die Logik richtig ist: Da der Mörder kein Rucksacktourist ist und Sie kein Rucksacktourist sind, sind Sie der Mörder.

Das Obige ist das diesmal von HyperAI empfohlene Tutorial. Jeder ist herzlich eingeladen, vorbeizukommen und es auszuprobieren!

Link zum Tutorial: