Command Palette

Search for a command to run...

NVIDIA/UC Berkeley Und Andere Haben Das Maschinell Lernende Wettervorhersagesystem FCN3 Vorgeschlagen, Das Eine 15-Tage-Vorhersage in 1 Minute Erstellen Kann Und Ultraschnelle Inferenz Mit Einer Karte unterstützt.

Seit ihrer Entstehung und schrittweisen Weiterentwicklung im 20. Jahrhundert hat die numerische Wettervorhersage (NWP) unser Verständnis und unsere Vorhersage atmosphärischer Phänomene revolutioniert. Die anfänglichen Fortschritte in der NWP wurden durch die Leistungseinschränkung von Computern gebremst. Erst mit Durchbrüchen in der Computertechnologie in den 1950er Jahren erzielten NWP-Experimente erste Erfolge. In den 1970er Jahren, mit der zunehmenden Leistungsfähigkeit von Supercomputern, fand die NWP breite Anwendung im operativen Bereich. Heute ist die NWP dank kontinuierlicher Optimierung der mathematischen Modellierung, drastischer Steigerungen der Rechenleistung und kontinuierlicher Verbesserungen der Datenassimilationstechnologie ein unverzichtbares Werkzeug in zahlreichen Bereichen, darunter Wettervorhersage, Katastrophenschutz, Energiemanagement und Klimaforschung.

Allerdings waren herkömmliche NWP-Modelle schon immer mit großen Herausforderungen konfrontiert.Da es auf der numerischen Lösung von Gleichungen der Strömungsmechanik und Thermodynamik basiert, ist der Rechenaufwand extrem groß.Bei hochauflösenden Vorhersagen und großräumigen Ensemblevorhersagen steigen die Rechenkosten herkömmlicher NWP-Modelle dramatisch an, sodass es schwierig wird, den Anforderungen schneller, genauer und großräumiger probabilistischer Ensemblevorhersagen gerecht zu werden, was ihre weitere Verbreitung in der praktischen Anwendung ernsthaft einschränkt.

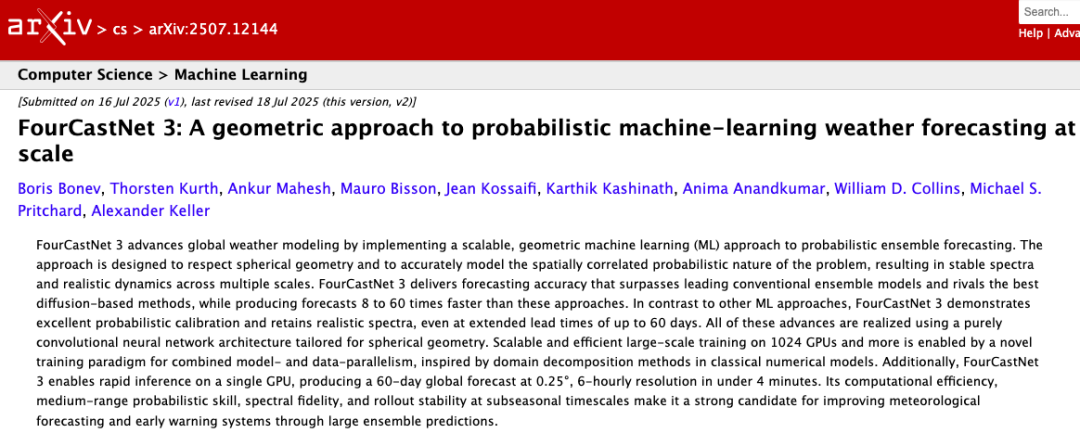

Um diese Probleme zu lösen, hat ein gemeinsames Forschungsteam von NVIDIA, dem Lawrence Berkeley National Laboratory, der University of California, Berkeley und dem California Institute of Technology,Einführung von FourCastNet 3 (FCN3), einem probabilistischen Wettervorhersagesystem auf Basis maschinellen Lernens, das sphärische Signalverarbeitung mit einem Hidden-Markov-Ensemble-Framework kombiniert.

Die Prognosefähigkeit des Modells übertrifft den traditionellen NWP-Goldstandard IFS-ENS und ist bei mittelfristigen Prognosen mit dem führenden probabilistischen ML-Modell GenCast vergleichbar, mit der doppelten zeitlichen Auflösung.Basierend auf einer einzelnen NVIDIA H100-GPU kann eine 15-Tage-Wettervorhersage in 60 Sekunden erstellt werden.Die Geschwindigkeit ist 8-mal so hoch wie bei GenCast und 60-mal so hoch wie bei IFS-ENS. Es unterstützt ultraschnelle Inferenz mit einer Karte und kann innerhalb von 4 Minuten eine globale Vorhersage für 60 Tage mit einer Auflösung von 0,25° und einem Intervall von 6 Stunden erstellen.

Die entsprechenden Forschungsergebnisse wurden auf arXiv unter dem Titel „FourCastNet 3: A geometric approach to probabilistic machine-learning weather forecasting at scale“ veröffentlicht.

Papieradresse:

https://arxiv.org/pdf/2507.12144

Folgen Sie dem offiziellen Konto und antworten Sie mit „FCN3“, um das vollständige PDF zu erhalten

Weitere Artikel zu den Grenzen der KI: https://go.hyper.ai/owxf6

Der ERA5-Datensatz, die Kernunterstützung für das FourCastNet 3-Training

Die Kerntrainingsdaten von FourCastNet 3 (FCN3) stammen aus dem ERA5-Datensatz.Dies ist eine stündliche Neuanalyse des atmosphärischen Zustands der Erde über einen Zeitraum von Jahrzehnten, erstellt vom Europäischen Zentrum für mittelfristige Wettervorhersage (EZMW). ERA5 verwendet ein vierdimensionales Variationsassimilationssystem, um Beobachtungsdaten aus verschiedenen Quellen seit 1979 (darunter Radiosonden, Satelliten, Flugzeuge, Bodenstationen und Bojen) mit IFS-Modellzuständen zu integrieren. Dadurch entsteht ein globales atmosphärisches Feld mit einer räumlichen Auflösung von 0,25° × 0,25° (dargestellt auf einem 721 × 1440 Breiten- und Längengradraster) und insgesamt ca. 39,5 TB an Daten.

Ein wesentlicher Vorteil von ERA5 besteht darin, dass sein Reanalyseprozess immer auf demselben IFS-Zyklus basiert (wie CY41R2 und nachfolgende feste Konfigurationen).Dadurch kann die dynamische Konsistenz auf der Zeitachse aufrechterhalten und Klimadriften, die durch Modellaktualisierungen in der Geschäftsanalyse verursacht werden, effektiv vermieden werden.Dies liefert einen wiederholbaren und nachvollziehbaren Maßstab für die „reale Atmosphäre“ für maschinelle Lernmodelle. Durch die Integration mehrerer Datenquellen und die vollständige Berücksichtigung ihrer jeweiligen Unsicherheitsschätzungen kann die Atmosphärengeschichte der Erde konsistent charakterisiert werden. Dies macht sie zu einem idealen Ziel für maschinelle Lernmodelle zur Approximation der Atmosphärendynamik auf planetarischer Ebene.

Für das Training von FCN3 wählten die Forscher 72 Variablen aus ERA5 aus, darunter sieben Oberflächenvariablen und fünf atmosphärische Variablen auf 13 isobaren Oberflächen. Obwohl das Modell letztendlich in einem Sechs-Stunden-Intervall trainiert wurde, wurden stündliche Stichprobendaten aus den Jahren 1980 bis 2018 verwendet, um die Datensatzgröße zu maximieren und die Generalisierungsfähigkeit des Modells zu verbessern.

Der Datensatz ist klar in drei Teile gegliedert:1980–2016 ist der Trainingsdatensatz, 2017 ist der Testdatensatz und 2018–2021 ist der unabhängige Validierungsdatensatz (alle gemeldeten Indikatoren werden auf der Grundlage des Validierungsdatensatzes 2020 berechnet). Durch diese Aufteilung kann Zeitverlust wirksam vermieden werden.

Vor dem Training müssen die Daten normalisiert werden:Sowohl Ein- als auch Ausgaben sind Z-Score- oder Min-Max-normalisiert und über eine Kugeloberfläche gemittelt. Wasserdampfbezogene Variablen werden mittels Min-Max-Normalisierung auf [0, 1] skaliert, um die Nicht-Negativitätsbedingung zu erfüllen. Windfelder werden mit einem Mittelwert von Null angenommen und mit der Standardabweichung der Gesamtwindgeschwindigkeit normalisiert, um die Vektorrichtungsinformationen zu erhalten. Die Normalisierungskonstante wird berechnet, indem zunächst eine räumliche Mittelung über die Kugel und anschließend eine zeitliche Mittelung über den gesamten Trainingssatz vorgenommen wird.

Dieser sorgfältig ausgewählte, aufgeteilte und verarbeitete Datensatz bietet eine solide Grundlage für FCN3, um die probabilistische Entwicklung der globalen Atmosphäre durchgängig auf über 1.000 GPUs zu erlernen und so ein effektives Modelltraining und genaue Prognosen zu gewährleisten.

Probabilistisches maschinelles Lernwettervorhersagesystem FourCastNet 3

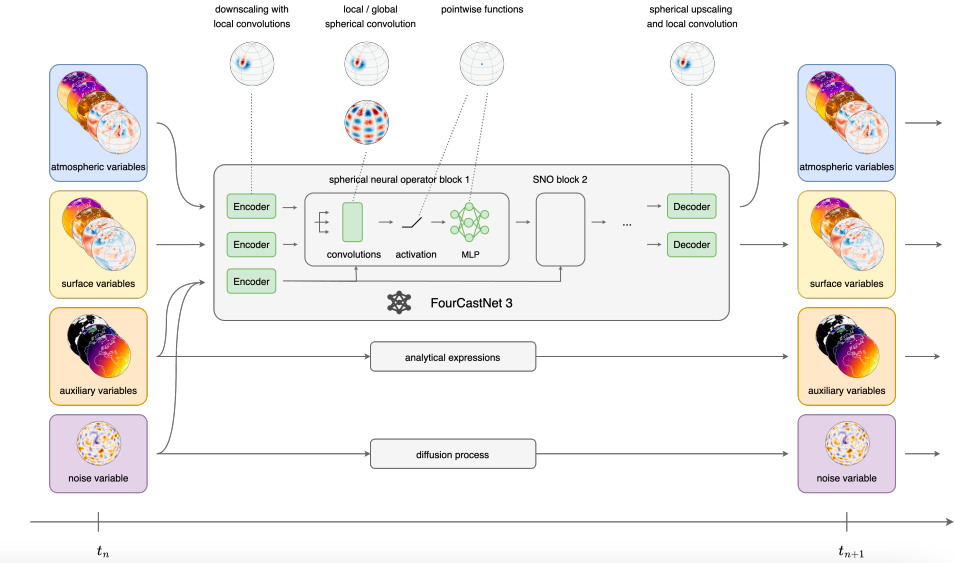

FourCastNet 3 (FCN3) ist ein probabilistisches Modell, das aus einem Encoder, einem Decoder und 8 neuronalen Operatorblöcken besteht.Basierend auf dem Hidden-Markov-Modell-Rahmen kann das Modell bei einem atmosphärischen Zustand uₙ mit einem Raster von 0,25° zu einem bestimmten Zeitpunkt tₙ den Zustand uₙ₊₁=F_θ(uₙ, tₙ, zₙ) 6 Stunden später vorhersagen, wobei Zufälligkeit durch den zufälligen Rauschvektor (Rauschvariablen) zₙ eingeführt wird – zₙ stammt aus mehreren sphärischen Diffusionsprozessen mit unterschiedlichen Raum-Zeit-Skalen und erfasst so die Unsicherheit der atmosphärischen Entwicklung.

In Bezug auf die Modellarchitektur verwendet FCN3 ein sphärisches neuronales Operatordesign, dessen Kern die lokale und globale sphärische Gruppenfaltung ist – d. h. eine Faltung, die unter der Wirkung der Rotationsgruppe SO(3) die Äquivarianz aufrechterhält.Unter ihnen wird der globale Faltungskern im Spektralbereich mithilfe des sphärischen Faltungstheorems und der sphärischen harmonischen Transformation parametrisiert, ähnlich der klassischen pseudospektralen Methode; die lokale Faltung basiert auf dem diskret-kontinuierlichen (DISCO) Faltungsrahmen, der numerische Integration verwendet, um die Faltung im kontinuierlichen Bereich anzunähern, anisotrope Filter unterstützt und besser mit den geometrischen Eigenschaften atmosphärischer Phänomene übereinstimmt.

Die Gesamtarchitektur ist in Encoder, Prozessor und Decoder unterteilt.Der Encoder wandelt das 721×1440-Ein-/Ausgangssignal durch eine Schicht lokaler sphärischer Faltung mit einer Einbettungsdimension von 641 in ein 360×720-Gauß-Gitter um; der Prozessor besteht aus mehreren sphärischen neuronalen Operatorblöcken mit der ConvNeXt-Struktur. Experimente zeigen, dass die Vorhersagefähigkeit am besten ist, wenn vier lokale Blöcke mit einem globalen Block gepaart werden und die Schichtnormalisierung weggelassen wird, um den Absolutwert des physikalischen Prozesses beizubehalten; der Decoder kombiniert bilineare sphärische Interpolation mit Upsampling der lokalen sphärischen Faltung, um die ursprüngliche Auflösung wiederherzustellen und Aliasing zu unterdrücken.

Es ist erwähnenswert, dass im Gegensatz zu den meisten Wettermodellen mit maschinellem Lernen, die den „Bias“ (den Unterschied zwischen der Vorhersage und der Eingabe) vorhersagen,FCN3 sagt den Zustand im nächsten Moment direkt voraus und unterdrückt hochfrequente Artefakte effektiv.Darüber hinaus vermischen sich weder Encoder noch Decoder über die Kanäle hinweg, und der Wasserdampfkanal wird durch eine glatte Spline-Ausgabeaktivierungsfunktion verarbeitet, um positive Werte sicherzustellen und hochfrequentes Rauschen zu reduzieren.

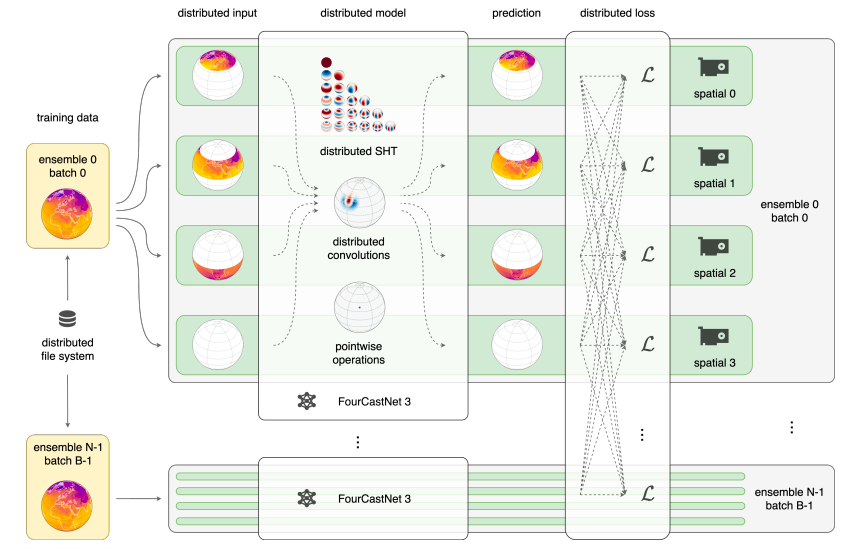

Da die interne Darstellung von FCN3 riesig ist, ist es für einen einzelnen GPU-Speicher schwierig, sie zu verarbeiten. Darüber hinaus muss der autoregressive Rollout mehrere Berechnungsergebnisse gleichzeitig speichern, was zu erheblicher Speicherbeanspruchung führt. Aus diesem Grund, wie in der folgenden Abbildung dargestellt,Das Forschungsteam verfolgte eine hybride Parallelstrategie, um ein skalierbares Training zu erreichen:Einerseits nutzen wir die räumliche Modellparallelität (Domänenparallelität) traditioneller numerischer Methoden. Durch die räumliche Domänenzerlegung verteilen wir Modell und Daten gleichzeitig auf verschiedene GPUs, was die Neuschreibung aller räumlichen Algorithmen als verteilte Versionen erfordert. Andererseits integrieren wir Datenparallelität, einschließlich Set- und Batch-Parallelität. Da alle Elemente vor der Verlustberechnung unabhängig voneinander sind, ist Kommunikation nur während der Verlustphase erforderlich, was zu extrem hoher Effizienz führt. Diese Funktionen sind im Makani-Framework implementiert und unterstützen die Skalierbarkeit auf Tausende von GPUs.

Der Trainingsprozess gliedert sich in drei Phasen:Das anfängliche Vortraining konzentrierte sich auf 6-Stunden-Prognosefähigkeiten. Es verwendete stündliche Stichproben aus dem ERA5-Trainingsset von 1980 bis 2016, um 6-Stunden-Eingabe-Ziel-Paare zu erstellen, beginnend zu jeder UTC-Stunde. Das Training erfolgte auf 1.024 H100s auf einem NVIDIA Eos-Supercomputer mit einer Batchgröße von 16 und einer Ensemblegröße von 16 über 208.320 Schritte und dauerte 78 Stunden.

Die zweite Phase des Vortrainings basierte auf einem 6-stündigen Anfangsfeld mit einem 4-stufigen autoregressiven Rollout und wurde für 5.040 Schritte (Reduzierung der Lernrate alle 840 Schritte) auf einem NERSC-Perlmutter-System mit 512 A100 trainiert, was 15 Stunden dauerte.

Die Feinabstimmungsphase dauerte acht Stunden und umfasste sechs Stunden Proben aus den Jahren 2012 bis 2016. Sie wurde auf 256 H100-GPUs auf dem Eos-System durchgeführt. Dadurch wurden potenzielle Verteilungsdrifts korrigiert und die Leistung bei aktuellen Daten verbessert. Aufgrund des begrenzten Videospeichers von 80 GB auf einer einzelnen Grafikkarte erfolgte das Training durch räumlich paralleles Slicing der Daten und des Modells. Das Vortraining wurde in vier Slicing-Schritte unterteilt, die Feinabstimmung aufgrund der höheren autoregressiven Anforderungen in 16 Slicing-Schritte. Dies ermöglichte letztendlich ein effizientes Training großer Modelle.

Leistungsbewertung: FCN3 übertrifft herkömmliche NWP-Modelle bei weitem und holt zu sehr geringen Kosten mit den fortschrittlichsten Diffusionsmodellen auf.

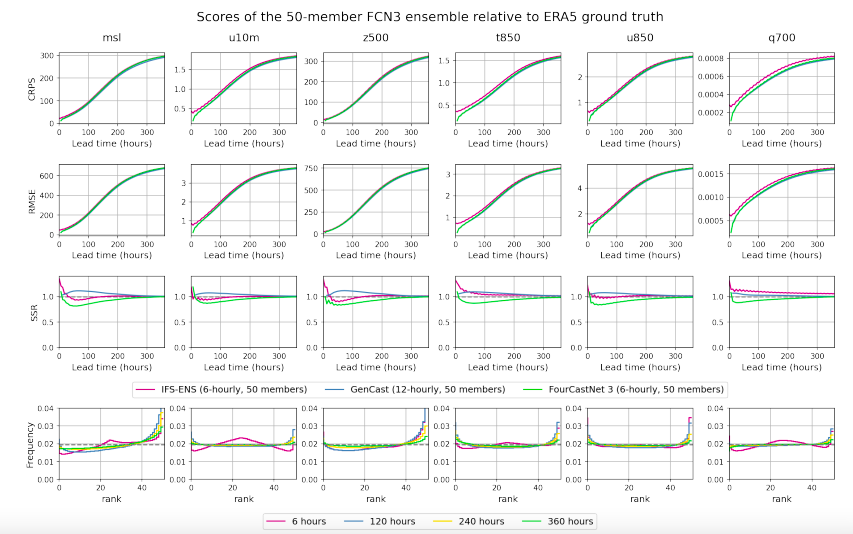

Um die Leistung von FourCastNet 3 (FCN3) umfassend zu bewerten, entwickelte das Forschungsteam Experimente in mehreren Schlüsseldimensionen, darunter Prognosegenauigkeit, Rechenleistung, Wahrscheinlichkeitskalibrierung und physikalische Genauigkeit. Wie in der folgenden Abbildung dargestellt, sind die durchschnittlichen Ergebnisse des anfänglichen Feldes alle 12 Stunden im Jahr 2020 (ohne Trainingsdatensatz) in Bezug auf die wichtigsten Leistungsindikatoren:,FCN3s kontinuierlich abgestufter Wahrscheinlichkeitswert (CRPS) und der mittlere quadratische Fehler (RMSE) des Ensembles funktionieren gut,Es übertrifft nicht nur den Goldstandard IFS-ENS für traditionelle physikalische numerische Wettervorhersagen bei weitem, sondern die Lücke zum derzeit besten datengesteuerten Modell GenCast ist nahezu vernachlässigbar.

In Bezug auf die Rechenleistung ist es dank des Designs, Set-Mitglieder direkt in einem Schritt zu generieren,FCN3 kann eine Prognose mit einem 15-tägigen, 6-Stunden-Intervall und einer räumlichen Auflösung von 0,25° in nur etwa 60 Sekunden auf einer einzelnen NVIDIA H100-GPU durchführen.Im Vergleich dazu benötigt GenCast 8 Minuten für eine gleich lange Prognose (mit einer zeitlichen Auflösung von nur der Hälfte der von FCN3) auf einer Cloud TPU v5-Instanz, während IFS bei einer Betriebsauflösung von 9 km auf 96 AMD Epyc Rome CPUs etwa 1 Stunde benötigt. Wenn wir die Unterschiede in Hardware und Auflösung außer Acht lassen,FCN3 ist etwa 8-mal schneller als GenCast und etwa 60-mal schneller als IFS-ENS.

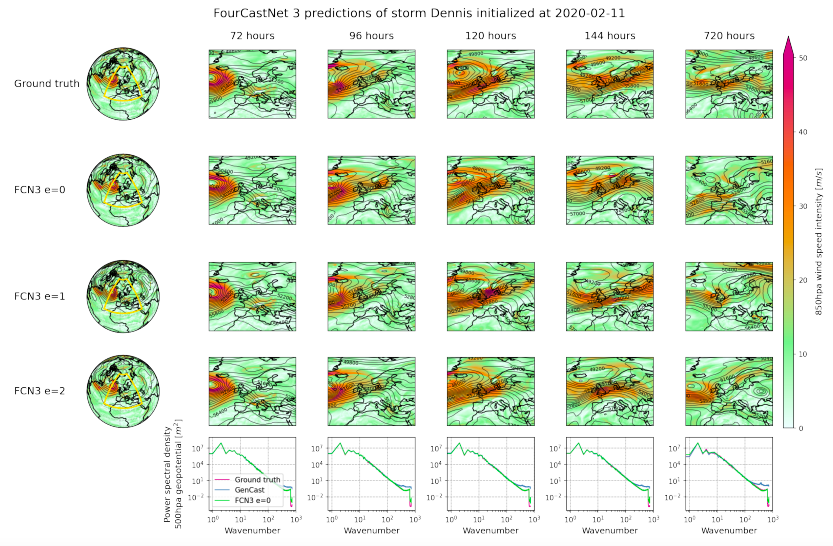

Da CRPS und RMSE nur punktweise ausgewertet werden können und keine räumlich-zeitlichen Korrelationen messen können, ergänzte das Forschungsteam die physikalische Genauigkeit des Modells durch Fallstudien. Wie in der folgenden Abbildung dargestellt, zeigen die Ergebnisse der Vorhersage der Windgeschwindigkeit bei 850 hPa und der geopotentiellen Höhe bei 500 hPa 48 Stunden vor seinem Landgang in Irland und den Britischen Inseln am Beispiel des außertropischen Sturms Dennis, der am 11. Februar 2020 um 00 UTC gemeldet wurde, Folgendes:FCN3 kann dieses Wetterereignis reproduzieren und die Kovarianzbeziehung zwischen Windgeschwindigkeit und Druckfeld ist vernünftig.Die Winkelleistungsspektraldichte (PSD) der geopotentiellen Höhe von 500 hPa behält die richtige Neigung bei; selbst wenn der Vorhersagezeitraum auf 30 Tage verlängert wird, nimmt das Winkelleistungsspektrum nicht ab und die Vorhersage behält immer eine scharfe Auflösung bei.

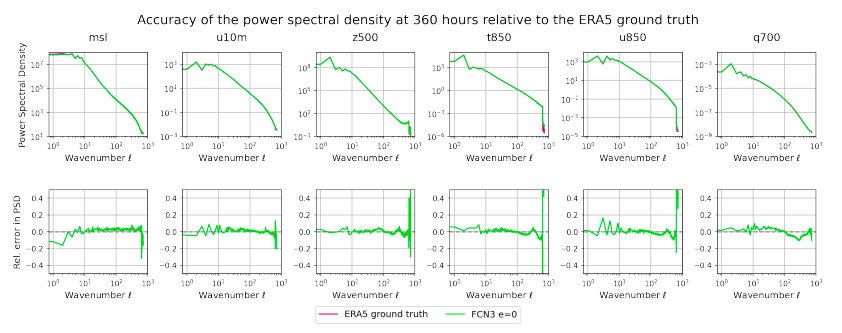

Die Analyse der Leistungsspektraldichte für das gesamte Jahr 2020 und ihres relativen Fehlers zum wahren ERA5-Wert zeigt, dass der Fehler in Bereichen mit hohen Wellenzahlen immer begrenzt ist (zwischen -0,2 und 0,2), dank der geometrischen und Signalverarbeitungsprinzipien, denen die Modellarchitektur folgt, sowie des CRPS-Verlusts, der sowohl lokale als auch globale Verteilungen berücksichtigt.Ermutigen Sie das Modell, die richtige räumliche Korrelation zu erlernen.

Im Gegensatz dazu leiden die meisten deterministischen Wettermodelle auf Basis maschinellen Lernens unter einer erheblichen Dämpfung hochfrequenter Informationen und mehrdeutigen Prognoseergebnissen. Selbst das mit CRPS trainierte Hybridmodell NeuralGCM weist erhebliche Mehrdeutigkeiten in hochfrequenten Modi auf. Die neuesten probabilistischen Modelle GenCast und AIFS-CRPS können die korrekte spektrale Form nicht vollständig beibehalten und können sogar eine Akkumulation hochfrequenter Modi aufweisen, die oft ein Vorläufer von Musterdivergenzen in traditionellen numerischen Wettervorhersagen ist.

Umfassende Tests von Diagonalspektren, Zonenspektren und physikalischer Konsistenz bestätigen, dass FCN3 ein Wettermodell ist, das beispiellose spektrale Genauigkeit und physikalischen Realismus in Bezug auf Wahrscheinlichkeitstechniken, Rechenleistung und globalen Maßstab vereint.Seine Prognose bleibt auf der 60-Tage-Subsaisonskala stabil.Es ebnete den Weg für die Entwicklung von subsaisonalen Vorhersagen und großräumigen Ensemblevorhersagen.

Leistungsspektraldichte für das gesamte Jahr 2020 und ihr relativer Fehler im Verhältnis zum wahren Wert von ERA5

Durchbrüche und Aussichten probabilistischer Wettervorhersagesysteme mit maschinellem Lernen

Tatsächlich haben Industrie, Wissenschaft und Forschungseinrichtungen weltweit umfassende Forschungen im Bereich probabilistischer Wettervorhersagesysteme auf Basis maschinellen Lernens durchgeführt und dabei eine Reihe einflussreicher Ergebnisse erzielt.

GenCast, gestartet vom DeepMind-Team von Google,Dieses probabilistische Wettermodell, das auf dem bedingten Diffusionsmodell basiert und einen Maßstab auf seinem Gebiet darstellt, kann innerhalb von 8 Minuten eine Reihe zufälliger globaler 15-Tage-Vorhersagen mit einem Zeitschritt von 12 Stunden und einer Auflösung von 0,25° erstellen und dabei mehr als 80 Oberflächen- und Atmosphärenvariablen abdecken.

In einer vergleichenden Bewertung mit dem weltweit führenden mittelfristigen Vorhersagesystem, dem Ensemble Forecast (ENS) des Europäischen Zentrums für mittelfristige Wettervorhersage (ECMWF),GenCast übertrifft TP3T in 97,21 der 1320 Bewertungsmetriken und die von ihm generierten Rand- und gemeinsamen Prognoseverteilungen sind genauer.

Das Aurora AI-Wettervorhersagemodell von Microsoft integriert Deep Learning und groß angelegte heterogene Datenverarbeitungstechnologie.Es kann nicht nur das Wetter genau vorhersagen, sondern nach Feinabstimmung auch in verschiedenen Bereichen der natürlichen Umweltüberwachung eingesetzt werden, beispielsweise zur Überwachung von Meeresströmungen und der Luftqualität.Die Trainingsdaten sind umfangreich und umfassen mehr als eine Million Stunden meteorologischer und Umweltdaten aus verschiedenen Quellen, darunter Satelliten, Radare, Wetterstationen und Computersimulationen.

Laut Testdaten des Microsoft-Forschungsteams war Aurora bei der globalen Vorhersage tropischer Wirbelstürme von 2022 bis 2023 der Leistung der Flugbahnvorhersage der Konkurrenz in der Branche sowie herkömmlichen Beobachtungs- und Inferenzalgorithmen deutlich überlegen. Auch in komplexen Umweltszenarien wie der Vorhersage von Meereswellen und der Vorhersage der Luftqualität zeigte sich eine hohe Genauigkeit.

Auch die akademische Forschung hat fruchtbare Ergebnisse hervorgebracht. Viele Universitäten haben eingehende Forschungen zu probabilistischen Wettervorhersagesystemen auf Basis maschinellen Lernens durchgeführt und Durchbrüche erzielt. Forschungsteams der Universität Cambridge und des Alan Turing Institute verfolgten einen anderen Ansatz und entwickelten das Aardvark Weather-System.Es ist das erste System, das auf einem Desktop-Computer trainiert und ausgeführt werden kann und alle Schritte im Wettervorhersageprozess durch ein einziges KI-Modell ersetzen kann.Die Verarbeitungsgeschwindigkeit ist tausendmal schneller als bei herkömmlichen Methoden.

Das System kann multimodale komplexe Daten von Satelliten, Wetterstationen und Wetterballons effizient verarbeiten, um eine globale 10-Tage-Vorhersage zu erstellen. Auf vier NVIDIA A100-GPUs dauert es nur etwa eine Sekunde, um aus Beobachtungsdaten eine vollständige Vorhersage zu erstellen.

Das vom FuXi-Team der Fudan-Universität vorgeschlagene FuXi-Wettersystem,Es handelt sich um das erste durchgängige Framework für die globale Wettervorhersage auf Basis maschinellen Lernens, das die Datenassimilation (DA) und Zyklusprognosen unabhängig durchführen kann.Durch die Kombination von Satellitenbeobachtungsdaten aus mehreren Quellen erstellt es zuverlässige 10-Tage-Vorhersagen mit einer Auflösung von 0,25°. Selbst in spärlich beobachteten Gebieten wie Zentralafrika übertrifft seine Leistung sogar die hochauflösende Vorhersage (HRES) des Europäischen Zentrums für mittelfristige Wettervorhersage (EZMW).

Diese Forschungen und Durchbrüche ermöglichen nicht nur die Steigerung der Genauigkeit, Effizienz und Anwendungsbreite probabilistischer Wettervorhersagesysteme auf Basis maschinellen Lernens, sondern bieten auch umfassende technische Unterstützung bei der Bewältigung globaler Probleme wie dem Klimawandel, der Eindämmung der Auswirkungen von Wetterkatastrophen und der Optimierung der Energienutzung. Durch die kontinuierliche Weiterentwicklung der Technologie und die Vertiefung der interdisziplinären Zusammenarbeit werden zukünftige probabilistische Wettervorhersagesysteme auf Basis maschinellen Lernens die komplexe Dynamik der Atmosphäre präziser erfassen und so einen robusteren Wetterschutz schaffen.

Referenzartikel: