Command Palette

Search for a command to run...

HyperAI Super Neural X Apache|Community Over Code Asia 2025 KI-Spezial

Vom 25. bis 27. Juli wird Community Over Code Asia 2025, die offizielle globale Konferenzreihe der Apache Software Foundation (ASF), im Konferenzzentrum der Zhongguancun National Independent Innovation Demonstration Zone in Peking eröffnet!

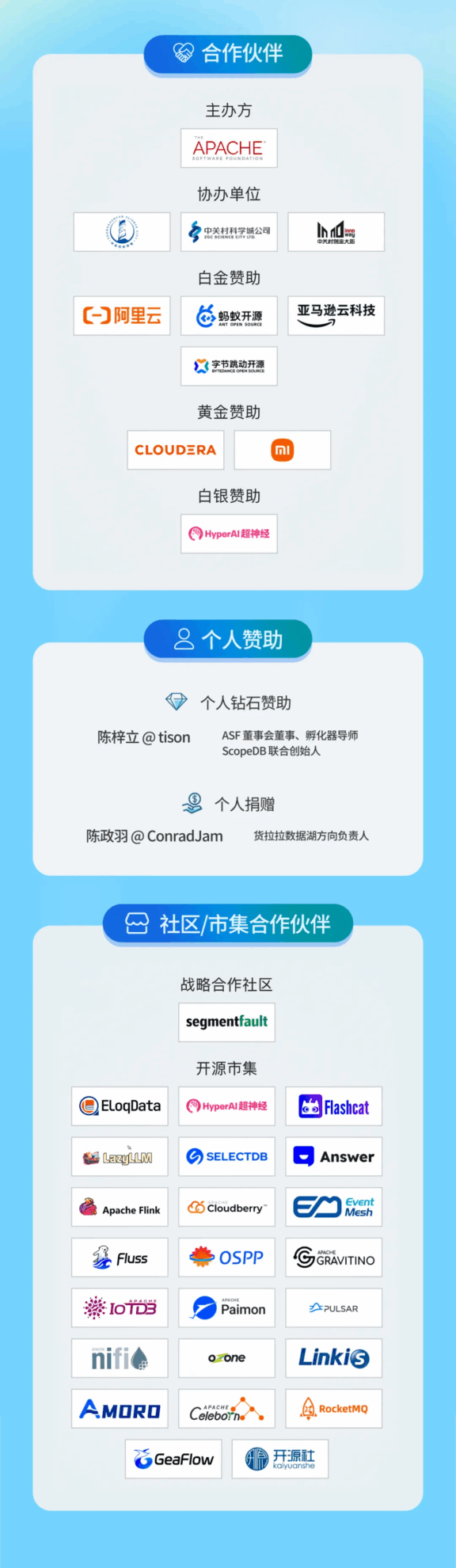

Das KI-Thema dieser Konferenz wird gemeinsam von Wang Chenhan, Gründer und CEO von OpenBayes Bayesian Computing, Tan Zhongyi, Mitglied der Apache Software Foundation, und Du Junping, Gründer und CEO von Datastrato, als Experten präsentiert. Sie werden Ihnen außerdem am 25. Juli von 14:00 bis 17:15 Uhr die neuesten Informationen und modernsten Praktiken zum Aufbau und zur Entwicklung der Apache-Community präsentieren. HyperAI wird als kooperative Community an dieser Veranstaltung teilnehmen und einen Marktstand aufbauen. Jeder ist herzlich eingeladen, vorbeizukommen und mitzuspielen.

Spezialthema

Das KI-Forum ist eine professionelle Kommunikationsplattform, die sich auf die Kombination von Künstlicher Intelligenz (KI) und Apache-Open-Source-Projekten konzentriert. Ziel des Forums ist es, Entwickler, Forscher und Branchenanwender weltweit zusammenzubringen, um die Anwendung und Entwicklung von KI-Technologie im Open-Source-Ökosystem zu diskutieren, Spitzentechnologien zu präsentieren, praktische Erfahrungen auszutauschen und die Implementierung von Open-Source-KI-Lösungen in verschiedenen Branchen zu fördern.

Geeignete Themen für dieses Forum sind:

- KI-bezogene Projekte im Rahmen der Apache Foundation (z. B. mit Schwerpunkt auf Open-Source-KI-Frameworks und grundlegenden Bibliotheksprojekten wie Apache TVM, Mahout, Singa, SystemML usw.)

- Optimierung von Apache-Einzelprojekten in KI-Szenarien (wie Spark MLib, Flink ML usw.)

- KI-Lösungen für industrielle Szenarien basierend auf der Kombination mehrerer Apache-Projekte, wie beispielsweise die KI-Geschäftskonstruktionsmethode eines bestimmten Unternehmens

Produzent

Wang Chenhan

Gründer und CEO von OpenBayes Bayesian Computing, einer der Übersetzer chinesischer Apache TVM-Dokumente und stellvertretender Direktor des Bayesian Computing Joint Research Center der Universität Tianjin. Er arbeitete für Technologieunternehmen wie die Walt Disney Interactive Media Group und AVOS Systems und war Generalsekretär der Open-Source-Organisation CLUE Benchmarks Foundation.

Tan Zhongyi

Stellvertretender Generalsekretär der COPU, seit über 20 Jahren Open-Source-Veteran, Mitglied der Apache Software Foundation.

Du Junping

Gründer und CEO von Datastrato, Direktor der LF AI & DATA Foundation, Mitglied der Apache Software Foundation, Experte für Big Data-Technologie und Open Source, Mitglied der Apache Open Source Foundation, Committer und PMC von Apache Hadoop, OZone, YuniKorn und anderen Projekten, Mentor von Apache Gravitino, NuttX und anderen Projekten. Ehemaliger Vorsitzender des Open Source Committee der Fortune 500-Unternehmen, Direktor für Forschung und Entwicklung der Big Data-Plattform, General Manager von Open Source Business, ehemaliger Leiter des Hortonworks Hadoop Computing Teams usw.

Höhepunkte der Tagesordnung

📅 25. Juli 14:00 – 17:15

Vortragsthema: Maximierung der heterogenen GPU-Auslastung auf Cloud-native Weise | Die Leistungsfähigkeit von HAMi entfesseln

Austauschzeit: 25. Juli, 14:00-14:30

Themeneinführung: Mit der zunehmenden Popularität von KI hat sich Kubernetes zum De-facto-Standard für KI-Infrastrukturen entwickelt. Die zunehmende Anzahl von Clustern mit mehreren KI-Geräten (wie NVIDIA, Intel, Huawei Ascend, Haiguang, Muxi, Cambrian, Tianshu Zhixin, Suiyuan usw.) bringt jedoch große Herausforderungen mit sich. KI-Geräte sind teuer. Wie lässt sich die Ressourcenauslastung verbessern? Wie lässt sich eine bessere Integration in K8s-Cluster erreichen? Die einheitliche Verwaltung heterogener KI-Geräte, die Unterstützung flexibler Planungsstrategien und die Gewährleistung der Beobachtbarkeit stehen vor zahlreichen Herausforderungen. Das HAMi-Projekt entstand. Dieser Vortrag umfasst:

- Wie Kubernetes heterogene KI-Geräte verwaltet (einheitliche Planung, Beobachtbarkeit)

- Verbesserung der Geräteauslastung durch GPU-Sharing

- Sicherstellung der QoS für Aufgaben mit hoher Priorität in GPU-Sharing-Szenarien

- Unterstützt flexible GPU-Planungsrichtlinien (NUMA-Affinität/Anti-Affinität, Packung/Verteilung usw.)

- Integration mit anderen Projekten (wie Volcano, Scheduler-Plugin usw.)

- Echte Fallfreigabe von Benutzern auf Produktionsebene

- Aktuelle Herausforderungen und Zukunftspläne

Sprecher:

Xiao Zhang|dynamia.ai-Gründer, Cloud-Native-Enthusiast und Community-Betreuer mit Schwerpunkt auf der KI-Infrastruktur

Xiao Zhang ist Gründer von dynamia.ai (mit Schwerpunkt auf Infrastruktur, KI, Multi-Cluster-Management, Cluster-Lebenszyklusmanagement (LCM) und der Open Container Initiative (OCI)). Er engagiert sich aktiv in der Community und begeistert sich für Cloud-native-Technologien. Er ist Mitglied der Kubernetes/Kubernetes Special Interest Group (Kubernetes-sigs) und fungiert als Maintainer der Projekte Karmada, Kubean und Cloudtty. Darüber hinaus ist er Co-Sponsor und Maintainer des CNCF HAMi-Projekts mit der GitHub-ID wawa0210.

Yu Yin|Produktinhaber @dynamia.ai, Open-Source-Betreuer @HAMi, treibt GPU-Virtualisierung und KI-Infrastrukturinnovation auf Kubernetes voran

Yu Yin ist Produktinhaber von dynamia.ai und Hauptverantwortlicher für HAMi, ein Open-Source-Projekt für GPU-Virtualisierung und heterogenes Computing auf Kubernetes. Mit praktischer Erfahrung im Aufbau von KI-Infrastrukturen konzentriert sich Yu auf die Ermöglichung skalierbarer GPU-Freigabe, Gerätepooling und intelligenter Planung für Multiarchitekturumgebungen. Er unterstützt Unternehmensanwender in Logistik, Telekommunikation und Finanzwesen bei der Einführung heterogenen Ressourcenmanagements in der Produktion. Gleichzeitig engagiert sich Herr Yu aktiv für Open-Source-Anwendungen in China und leitet die Internationalisierung der HAMi-Community.

Vortragsthema: Apache Doris‘ Erforschung und Praxis im Bereich der KI

Austauschzeit: 25. Juli, 14:30-15:00

Themeneinführung: Als beliebte OLAP-Datenbank für Echtzeitanalysen hat Apache Doris im Kontext der aktuellen Ära rasanter KI-Veränderungen weitere KI-bezogene Funktionen und Peripheriekomponenten wie Vektorabruf, MCP, RAG und andere Funktionsmodule entwickelt bzw. plant diese. In diesem Vortrag werden Doris‘ aktuelle Fortschritte in Richtung KI durch Kommunikation und Demonstration vorgestellt.

Sprecher:

YiJia Su|Apache Doris Committer, SelectDB Solutions Architect, PowerData Sponsor

Apache Doris Committer, Apache Doris Community-Evangelist, Doris-MCP-Mitwirkender, leitender Lösungsarchitekt von SelectDB, Initiator der PowerData-Community, hat Hunderte von Unternehmen in der Apache Doris-Community beim Aufbau und der Weiterentwicklung von Echtzeit-Data-Warehouses unterstützt.

Vortragsthema: Apache Gravitino | Metadatenmanagement-Lösungen im KI-Zeitalter

Austauschzeit: 25. Juli, 15:00-15:30

Themeneinführung:

Metadatenmanagement ist zum Eckpfeiler der KI-Ära geworden. In diesem Vortrag wird erläutert, wie Apache Gravitino die Verwaltung unstrukturierter Daten und Modelle im großen Maßstab ermöglicht und wie Xiaomi Gravitino für die Datenverarbeitung großer Sprachmodelle (LLM) und das Modell-Lebenszyklusmanagement einsetzt.

Redegliederung:

1. Herausforderungen der Datensatz- und Modellverwaltung in KI-Workflows und wie Gravitino diese Probleme mit seinem Fileset Catalog (strukturierte KI-Datensatzverwaltung) und Model Catalog (einheitliches Modell-Lebenszyklusmanagement) angeht

2. Maximieren Sie die Betriebseffizienz und die Einhaltung von Governance-Vorgaben durch die Nutzung des Tagging-Systems, der Herkunftsverfolgung und der Anmeldeinformationsverwaltungsfunktionen von Gravitino

3. Fileset-Praxis in der Datenverarbeitung von Xiaomi: In KI-Szenarien umfasst die Datenverarbeitung mehrere Schritte wie Herunterladen, Extrahieren, Filtern, Deduplizieren und Trainieren. Der Einsatz von Fileset verbessert die Pipeline-Effizienz zwischen Daten und KI-Engines, implementiert ein durchgängiges Datensatzmanagement und ermöglicht eine einheitliche Metadatenansicht.

4. Xiaomi AI Big Model Management Practice: Wie Xiaomi große Modellmetadaten verwaltet, Modelldienste bereitstellt und unsere Zukunftspläne für die Integration mit Gravitino

Sprecher:

Xiaojing Fang|Apache Gravitino PPMC & Datastrato Softwareentwickler

Apache Gravitino PPMC-Mitglied mit Schwerpunkt auf Daten- und KI-Infrastruktursystemen.

Han Zhang|Software-R&D-Ingenieur bei Xiaomi

Apache Gravitino-Mitarbeiter, verantwortlich für die Forschung und Entwicklung der Xiaomi AI-Entwicklungsplattform.

Vortragsthema: Katalog als Kontext | Nutzung von Metadaten zur Förderung und Verwaltung der nächsten Welle der KI-Entwicklung

Austauschzeit: 25. Juli, 15:45-16:15

Themeneinführung: Die Entwicklung leistungsstarker KI-Tools ist unser diesjähriges Thema. Intelligente Agenten und Basismodelle haben in verschiedenen Bereichen erhebliche Fortschritte erzielt. Die Kernfragen bleiben jedoch bestehen: Wie versorgen wir diese Anwendungen mit effektiven Daten? Wie lässt sich unternehmensweite Skalierung erreichen? Was ist das Wesentliche am Kontext? Dieser Vortrag beleuchtet den aktuellen Stand des Big-Data-Ökosystems, die Herausforderungen für KI-Datenplattformen und warum Datenkataloge und Metadaten der einzig gangbare Weg zu einer effizienten und kontrollierbaren KI-Entwicklung sind. Am Beispiel des Open-Source-Frameworks Apache Gravitino erläutern wir, warum solche Lösungen herstellerneutral bleiben müssen.

Sprecher:

Jerry Shao|Datastrato, CTO

Jerry Shao ist Mitbegründer und CTO von Datastrato und arbeitet seit über einem Jahrzehnt im Bereich Open Source Big Data. Als Apache-Mitglied ist er Committer und PMC-Mitglied von Apache Spark und Apache Inlong sowie Gründer des Apache Gravitino-Projekts (Inkubationsprojekt).

Vortragsthema: Von Daten zu KI | Aufbau einer einheitlichen Analyseplattform auf Basis von Apache Cloudberry

Austauschzeit: 25. Juli, 16:15-16:45

Themeneinführung:

Unternehmen haben heute Schwierigkeiten, das volle Potenzial von KI auszuschöpfen. Dies liegt an fragmentierten Datensystemen, ineffizienten Verarbeitungsabläufen und der Kluft zwischen Analytik und maschinellem Lernen. Apache Cloudberry, ein Open-Source-MPP-Data-Warehouse, definiert dieses Paradigma neu, indem es Datenverarbeitung und KI-Funktionen tief integriert, Barrieren beseitigt und Innovationen beschleunigt.

In diesem Vortrag wird gezeigt, wie Cloudberry Folgendes kann:

- Einheitliche Ausführung: Führen Sie native KI/ML-Modelle (wie PyTorch, Scikit-learn) direkt im Data Warehouse aus

- Multimodale Analyse: Verarbeitung strukturierter und unstrukturierter Daten (PDF, Bilder etc.) in einem einheitlichen Rahmen

- Intelligente Datenanwendungen: Aufbau von RAG-erweiterten Frage-Antwort-Systemen, Conversational BI und multimodaler Suche

Sie erfahren, wie Sie Daten und Informationen auf einer einheitlichen Plattform zusammenführen, um Ihre Architektur zu vereinfachen und gleichzeitig KI-Workloads zu skalieren.

Sprecher:

Chuanxin Bian|HashData, Daten- und KI-Ingenieur

Dr. Chuanxin Bian ist Datenwissenschaftler und angewandter Mathematiker mit Spezialgebiet Deep Learning, natürlicher Sprachverarbeitung und Zeitreihenmodellierung. Er promovierte in Angewandter Mathematik an der Hong Kong Polytechnic University. Derzeit arbeitet er bei HashData und leitet die Entwicklung von KI-Tools wie HashML und ChatData sowie von AIGC-Anwendungen. Er war leitender Forschungs- und Entwicklungsingenieur bei Baidu, wo er an der Entwicklung des Wenxin-Modells beteiligt war, ein PaddleTS-basiertes Zeitreihenmodell entwickelte und die Weiterentwicklung des Benutzerporträtsystems vorantrieb. Er beherrscht Python und Deep-Learning-Frameworks und versteht es, Theorie und Praxis zu verknüpfen, um KI-Innovationen voranzutreiben.

Vortragsthema: Analyse der hybriden Suchtechnologie Apache Doris

Austauschzeit: 25. Juli, 16:45-17:15

Themeneinführung:

Die hybride Suchfunktion von Apache Doris kombiniert die traditionelle Volltextsuche (stichwortbasierte Wörterbuchsuche) mit der Vektorsuche (semantikbasierte Suche) und liefert so präzisere Suchergebnisse. Diese Funktion eignet sich besonders für komplexe Suchszenarien, die sowohl die Übereinstimmung von Stichwörtern als auch semantisches Verständnis erfordern, wie z. B. E-Commerce, Inhaltsempfehlungen und die Suche in Wissensdatenbanken.

1. Grundprinzipien der Hybridabfrage

Die Hybridsuche nutzt die Vorteile beider Suchmethoden voll aus:

- Volltextsuche (BM25): Basierend auf invertiertem Index und Schlüsselwortabgleich ermöglicht sie eine präzise Zuordnung der vom Benutzer eingegebenen Suchbegriffe. Doris verwendet den BM25-Algorithmus (Standard), um den Relevanzwert zwischen Dokument und Abfrage zu berechnen. Dieser eignet sich für die strukturierte Textsuche.

- Vektorabruf (semantische Suche): Durch die Konvertierung von Text in Vektoren (Einbettung) wird mithilfe eines maschinellen Lernmodells die semantische Ähnlichkeit zwischen Abfrage und Dokument berechnet. Es ist gut geeignet, die Abfrageabsicht und den Kontext zu verstehen.

- Fusionsmechanismus: Verwenden Sie spezielle Bewertungs- und Rankingtechniken (wie Reciprocal Rank Fusion/RRF oder Convex Combination/CC), um die Suchergebnisse der beiden Methoden zu integrieren und die lexikalische und semantische Relevanz auszugleichen.

2. Technische Implementierungsarchitektur

Die Doris Hybridsuche basiert auf den folgenden technischen Komponenten und Arbeitsabläufen:

1. Feldtypunterstützung

- Textfeld: Generieren Sie einen invertierten Index durch einen Wortsegmentierer, um die Volltextsuche zu unterstützen

- Vektorfeld: Verwenden Sie das Modell, um Text in einen Vektortypspeicher zu konvertieren

2. Zusammengesetzter Index

- Unterstützt die Speicherung von Text- und Vektorfeldern

- Aktivieren der Hybridabfragefunktion

3. Abfrageausführungsprozess

- Wörterbuchabfrage: Verwenden Sie die Übereinstimmungsabfrage, um Dokumente abzurufen, die mit Schlüsselwörtern übereinstimmen (basierend auf dem BM25-Algorithmus).

- Vektorabfrage: Verwenden Sie eine KNN-Abfrage oder einen ANN-Index, um semantisch ähnliche Dokumente abzurufen (basierend auf Kosinusähnlichkeit usw.).

- Hybridabfrage: Führen Sie zwei Abfragen parallel aus und kombinieren Sie die Ergebnisse durch einen Fusionsalgorithmus

4. Ergebnisfusionsstrategie

- RRF (Reverse Ranking Fusion): Berechnet eine umfassende Punktzahl basierend auf dem Ranking des Dokuments in verschiedenen Abfrageergebnissen und hebt Dokumente hervor, die bei mehreren Suchmethoden einen hohen Rang einnehmen

- CC (Convex Combination): Integrieren Sie BM25- und Vektorabfragewerte durch gewichtete Summation und passen Sie die Gewichtsbalance manuell an

- Unterstützt die weitere Optimierung des Ergebnisrankings durch script_score oder Rerank-Modell

Sprecher:

Lee Happen|SelectDB Senior-RD

Apache Doris PMC-Mitglied

📅 26. Juli 14:00 – 16:45

Vortragsthema: Integration großer Sprachmodelle in CI/CD-Pipelines | Praxisbeispiele zur Verbesserung der Codequalität in Apache-Projekten

Austauschzeit: 26. Juli, 14:00-14:30

Themeneinführung: Dieser Vortrag untersucht, wie große Sprachmodelle (LLMs) systematisch in GitHub Actions integriert werden können, um die Codequalität und Sicherheit von Apache-Projekten zu verbessern. Der Inhalt basiert auf dem realen Fall von apache/brpc#2911. Er eignet sich insbesondere für Entwickler und Betreuer, die nach umsetzbaren, kostengünstigen Strategien für die Entwicklung, Implementierung und Bereitstellung von KI-Agenten zur Sicherstellung der Codequalität suchen.

Wir werden das Publikum dazu anregen, über die folgenden Aspekte nachzudenken:

- Mensch-Maschine-Zusammenarbeit: Vergleich des traditionellen „Copilot“-Modells (menschlich gesteuert, synchron) mit asynchronen KI-Agent-Workflows in Pipelines, unter Hervorhebung von Effizienzgewinnen und Kompromissen

- Praxis: Erfahren Sie, wie Sie LLMs verwenden, um gezielte Aufgaben wie Code-Robustheits-Scans und CVE-Erkennung unter Ressourcenbeschränkungen durchzuführen – ohne auf RAG, Feinabstimmung oder MCP angewiesen zu sein.

Sprecher:

Yi Yuan|Softwareentwickler

CNCF-Kepler-Projektbetreuer, hauptsächlich verantwortlich für Arbeiten im Zusammenhang mit der Projektpipeline.

Vortragsthema: Lance | Datenformate für die Zukunft der multimodalen KI

Austauschzeit: 26. Juli, 14:30-15:00

Themeneinführung: Modernes Training multimodaler Modelle erfordert die Verarbeitung multimodaler KI-Daten auf PB-Ebene, einschließlich Videos, Bildern und langen Texten. Die Komplexität und der Umfang neuer KI-Daten stellen Herausforderungen für die bestehende Dateninfrastruktur dar.

Das Apache-lizenzierte Lance-Format basiert auf Apache Arrow und Apache Datafusion, wobei der Kern in Rust geschrieben ist. Das Entwicklungsteam besteht aus PMC-Mitgliedern von Apache Hadoop, Apache HBase, Apache Iceberg, Apache Arrow und Delta Lake. Das Lance-Format ist ein neues spaltenbasiertes Speicher- und Tabellenformat mit Fokus auf KI, das stark von den Projekten Apache Parquet, Apache Iceberg und Apache Hudi inspiriert ist. Die herausragenden Merkmale des Lance-Formats sind der wahlfreie Zugriff und die kostenlose Schemaentwicklung – zwei beliebte Funktionen von KI-Ingenieuren. Diese Merkmale unterscheiden Lance von Apache Parquet, Apache ORC oder Apache Iceberg und machen es besser geeignet für Feature Engineering und Training multimodaler KI.

Das Lance-Format wurde von vielen führenden KI-Unternehmen wie MidJourney, WorldLabs, Runway ML, Character AI usw. übernommen.

Diese Konferenz wird gemeinsam von LanceDB CTO Xu Lei (Apache Hadoop PMC-Mitglied) und ByteDance Volcano Engine-Experte Yang Hua (Apache Hudi PMC-Mitglied) präsentiert:

- Infrastrukturelle Herausforderungen bei der Unterstützung von Workloads bei führenden multimodalen KI-Unternehmen

- Die wichtigsten Designprinzipien des Lance-Formats

- Wie ByteDance Volcano Engine den Lance-Datensee basierend auf dem Lance-Format erstellt und die weltweit führenden KI-Unternehmen unterstützt

Sprecher:

Lei Xu|CTO @ LanceDB

Chief Technology Officer von LanceDB. Mitglied des Apache Hadoop/HDFS PMC. Zuvor leitete er die Machine-Learning-Plattform und das Dateninfrastrukturteam bei Cruise Automation.

Vino Yang: Technischer Experte für Vulkanmotoren, Lance Committer.

Technischer Experte für Volcano Engine, Lance Committer. Apache Hudi/Kyuubi PMC-Mitglied.

Vortragsthema: Quanten-KI | Der Beginn der Ära der Superintelligenz

Austauschzeit: 26. Juli, 15:00-15:30

Themeneinführung: Die Integration von Quantencomputing und künstlicher Intelligenz wird die Grenzen des klassischen Computings sprengen und das Zeitalter der Superintelligenz einläuten. Wenn quantengestützte Modelle exponentielles Lernen erreichen, komplexe Probleme in Sekundenschnelle lösen und den Entscheidungsprozess neu definieren können, treten wir dann in eine neue Ära ein, in der KI den Rahmen des menschlichen Verständnisses übersteigt?

In diesem Vortrag werden die nächsten Grenzen der künstlichen Intelligenz erkundet, mit Schwerpunkt auf:

Quantum Machine Learning (QML): Wie KI mithilfe der Quantenmechanik beispiellose Problemlösungsfähigkeiten erreichen kann

Quantenneuronale Netzwerke: Kann KI in einem unvorstellbaren Ausmaß lernen?

Quantensuperposition und Parallelität: Wird sich die KI vom sequentiellen Denken zum multidimensionalen Denken entwickeln?

Theoretische Inspiration: Wird Quanten-KI zum Eckpfeiler der künstlichen Superintelligenz (ASI)?

Während wir uns auf KI-gestützte wissenschaftliche Entdeckungen, posthumane Intelligenz und eine potenzielle Wissenssingularität zubewegen, wird dieser Vortrag traditionelle KI-Paradigmen in Frage stellen und die Möglichkeiten erkunden, wenn KI nicht mehr wie Menschen denkt – sondern weitaus besser als Menschen.

Sprecher:

Prakul Hiremath|VISVESVARAYA TECHNOLOGICAL UNIVERSITY, B.TECH-STUDENTIN UND BIOLOOP, CEO UND GRÜNDER

Prakul Hiremath ist Forscher, Technologe und Innovator an der VTU Belagavi, Indien. Er arbeitet an der Schnittstelle von künstlicher Intelligenz, Cybersicherheit und Systemoptimierung. Mit seiner großen Leidenschaft für künstliche Intelligenz, Computersysteme und Zukunftstechnologien engagiert er sich aktiv in der Forschung zu KI-gestützter Cybersicherheit, medizinischer Signalanalyse und Innovationen im Bereich Industrie 4.0.

Seine Arbeit umfasst KI-gestützte Bedrohungserkennung, prädiktive Analytik und Hochleistungsrechnen. Dabei konzentriert er sich darauf, die Grenzen intelligenter Systeme und autonomer Entscheidungsfindung zu erweitern. Er erforscht außerdem KI-gestütztes Leben, posthumane Intelligenz und Wissensentwicklung und engagiert sich für bahnbrechende Erkenntnisse zu Zukunftstechnologien.

Neben der KI- und Cybersicherheitsforschung engagiert sich Prakul aktiv in Bioloop, einem innovativen Forschungsprojekt, das Biotechnologie und künstliche Intelligenz kombiniert, um innovative Lösungen in den Bereichen Nachhaltigkeit, Gesundheitswesen und industrielle Automatisierung zu entwickeln. Bioloop zielt darauf ab, Bio-KI-Systeme zu revolutionieren, indem eine neue Generation intelligenter Ökosysteme geschaffen wird, die biologische und technologische Prozesse optimieren.

Bei Community Over Code Asia 2025 wird Prakul über den unaufhaltsamen Aufstieg der KI, die damit verbundenen Herausforderungen und ihre tiefgreifenden Auswirkungen auf die Zukunft der Technologie, die soziale Entwicklung und die menschliche Intelligenz sprechen.

Thema: MCP verwenden oder nicht? Entwurf zusammensetzbarer KI-Systeme mit offenen Protokollen

Austauschzeit: 26. Juli, 15:45-16:15

Themeneinführung: Mit der diversifizierten Entwicklung von KI-Anwendungen hat die Punkt-zu-Punkt-Integration maßgeschneiderter Tools und Dienste zu Problemen wie Fragmentierung und hohen Wartungskosten geführt. Als offenes Protokoll etabliert das Model Context Protocol (MCP) eine einheitliche Verbindungsmethode zwischen KI-Agenten und externen Tools durch standardisierte Erkennungs-, Aufruf- und Interaktionsprozesse. Die gemeinsame Nutzung stellt die Herausforderungen der Interoperabilität im aktuellen KI-Ökosystem vor. Am Beispiel von Llama-Nexus wird gezeigt, wie die Zusammensetzbarkeit und flexible Orchestrierung von KI-Systemen durch nativ entwickelte MCP-Dienste erreicht werden kann. Abschließend wird die strategische Bedeutung offener Protokolle für die Förderung der Vernetzung und Interoperabilität von KI-Systemen, die Reduzierung der Integrationskomplexität und die Förderung von Innovationen sowie die zukünftige Entwicklungsrichtung des zusammensetzbaren KI-Ökosystems erörtert. github.com/LlamaEdge/llama-nexus

Sprecher:

Miley Fu|CNCF-Botschafterin, Gründungsmitglied der Open-Source-Runtime WasmEdge

Miley ist eine engagierte Entwicklerin, die Entwicklern die Möglichkeit gibt, Open-Source-Projekte zu entwickeln und zu ihnen beizutragen. Sie ist Co-Vorsitzende und Hauptrednerin des KubeCon+Open Source Summit 2024 und des AI Dev China 2024. Sie ist Gründungsmitglied der WasmEdge-Runtime in der CNCF-Sandbox, arbeitet seit über sechs Jahren an dem Projekt und hat auf Veranstaltungen wie KubeCon, KCD, CloudDay Italy, DevRelCon, Japan Open Source Summit, AWS User Group, Global AI Note, KubeDay Singapore usw. gesprochen. Miley verfasst technische Inhalte und organisiert Entwicklerveranstaltungen, darunter Meetups zu KCD Beijing, KCD Shenzhen, WebAssembly & Rust Taipei, Singapur usw.

Vortragsthema: Warum brauchen wir ein Open-Source-KI-Gateway?

Austauschzeit: 26. Juli, 16:15-16:45

Themeneinführung: Im Zeitalter der explosionsartigen Zunahme von KI-Anwendungen ist der API-Verkehr stark angestiegen, doch Herausforderungen wie Kostenkontrolle, Sicherheitskonformität und Multi-Modell-Management bleiben bestehen. Apache APISIX, das weltweit aktivste Open-Source-API-Gateway, wird 2025 offiziell KI-Gateway-Funktionen einführen, um Entwicklern und Unternehmen eine Komplettlösung zu bieten.

Warum APISIX AI Gateway wählen?

Einheitliches KI-Servicemanagement: Nahtlose Proxy-Anfragen für gängige große Modelle wie OpenAI, Deepseek und QWen, Vermeidung der Abhängigkeit von einem Anbieter und Optimierung des Kosten-Leistungs-Verhältnisses durch dynamische Verkehrsorchestrierung.

Sicherheit und Compliance: Integrierte KI-Schutz-Plugins (wie etwa „ai-prompt-guard“ zum Filtern bösartiger Eingaben und „ai-rate-limiting“ zum Implementieren einer tokenbasierten Ratenbegrenzung) gewährleisten Datenschutz und Compliance.

Entwickler-First-Erfahrung: Hot-Reload-Plugins, mehrsprachige Unterstützung (Java/Python/Go) und native Integration mit Microservices und dem Kubernetes-Ökosystem.

Egal, ob Sie Entwickler oder Unternehmen sind, APISIX AI Gateway kann die Implementierung von KI-Anwendungen beschleunigen und das Innovationspotenzial freisetzen.

Sprecher:

Yuansheng Wang|API7.ai, CTO

Apache APISIX PMC-Mitglied. Apache Foundation-Mitglied.

🌟 Klicken Sie auf den QR-Code unten, um Tickets zu scannen und zu kaufen

Die Menge ist begrenzt, also kommt vorbei und macht mit 👆