Command Palette

Search for a command to run...

ICML 2025 | Die Technische Universität München Und Andere Haben Eine Auf SD3 Basierende Methode Zur Generierung Von Satellitenbildern Entwickelt, Um Den Derzeit Größten Fernerkundungsdatensatz Zu Erstellen

Satellitenbilder sind Aufnahmen der Erdoberfläche, die mithilfe von Satellitenfernerkundungstechnologie gewonnen werden. Sie digitalisieren Erdinformationen durch die Schaffung einer „Weltraumperspektive“, um eine großflächige Erfassung, dynamische Verfolgung und Datenunterstützung zu ermöglichen. Im Alltag der Menschen sind sowohl die makroökonomische Umweltpolitik als auch das mikrostädtische Leben untrennbar miteinander verbunden. Beispielsweise können Satellitenbilder bei der Forstüberwachung schnell das Verbreitungsgebiet von Wäldern abgrenzen, den Bedeckungsgrad verschiedener Waldarten berechnen und Veränderungen der Waldbedeckung durch Abholzung, Anpflanzung, Schädlinge und Krankheiten usw. erkennen.

Jedoch,Die Satellitenüberwachung wird leicht durch zahlreiche Faktoren beeinträchtigt, was ihre Leistung und Anwendungswirkung erheblich reduziert.Besonders gravierend sind Störungen durch die Wolkendecke. In Gebieten mit häufigen Wolken kann die Satellitenüberwachung beispielsweise tage- oder sogar wochenlang unterbrochen sein. Dies erschwert nicht nur die dynamische Echtzeitüberwachung von Satelliten, sondern stellt auch neue Anforderungen an die Kombination von Satellitenbildern mit Klimadaten zur Verbesserung der Vorhersagegenauigkeit. Die rasante Entwicklung von künstlicher Intelligenz und maschinellen Lernalgorithmen bietet die Möglichkeit, diese Anforderung zu erfüllen. Die meisten aktuellen Methoden sind jedoch auf spezifische Aufgaben oder Regionen ausgelegt und nicht universell genug, um global eingesetzt werden zu können.

Um die oben genannten Probleme zu lösen,Ein Team der Technischen Universität München in Deutschland und der Universität Zürich in der Schweiz schlug eine neue Methode zur Generierung von Satellitenbildern vor, die auf geografischen Klimamerkmalen basieren und Stable Diffusion 3 (SD3) verwenden. Gleichzeitig erstellte es mit EcoMapper den bislang größten und umfassendsten Fernerkundungsdatensatz.Der Datensatz umfasst mehr als 2,9 Millionen RGB-Satellitenbilddaten von Sentinel-2 von 104.424 Standorten weltweit und deckt 15 Landbedeckungstypen sowie entsprechende Klimadaten ab. Er bildet die Grundlage für zwei Methoden zur Satellitenbildgenerierung unter Verwendung eines optimierten SD3-Modells. Durch die Kombination synthetischer Bildgenerierung mit Klima- und Landbedeckungsdaten fördert die vorgeschlagene Methode die Entwicklung generativer Modellierungstechnologien in der Fernerkundung, schließt Beobachtungslücken in Gebieten mit anhaltender Bewölkung und bietet neue Werkzeuge für die globale Klimaanpassung und Geodatenanalyse.

Die Forschungsergebnisse mit dem Titel „EcoMapper: Generative Modeling for Climate-Aware Satellite Imagery“ wurden für ICML 2025 ausgewählt.

Forschungshighlights:

* Erstellung von EcoMapper, dem bislang größten und umfassendsten Fernerkundungsdatensatz mit mehr als 2,9 Millionen Satellitenbildern

* Entwicklung eines generativen Text-zu-Bild-Modells basierend auf der fein abgestimmten stabilen Diffusion 3, um mithilfe von Texthinweisen, die Klima- und Landbedeckungsdetails enthalten, realistische synthetische Bilder bestimmter Bereiche zu erzeugen.

* Entwicklung eines multikonditionalen (Text + Bild) Modellrahmens unter Verwendung von ControlNet zur Kartierung von Klimadaten oder zur Generierung von Zeitreihen zur Simulation der Landschaftsentwicklung

Papieradresse:

Adresse zum Herunterladen des Datensatzes:

Weitere Artikel zu den Grenzen der KI:

Datensatz: Der bislang größte und umfassendste Fernerkundungsdatensatz

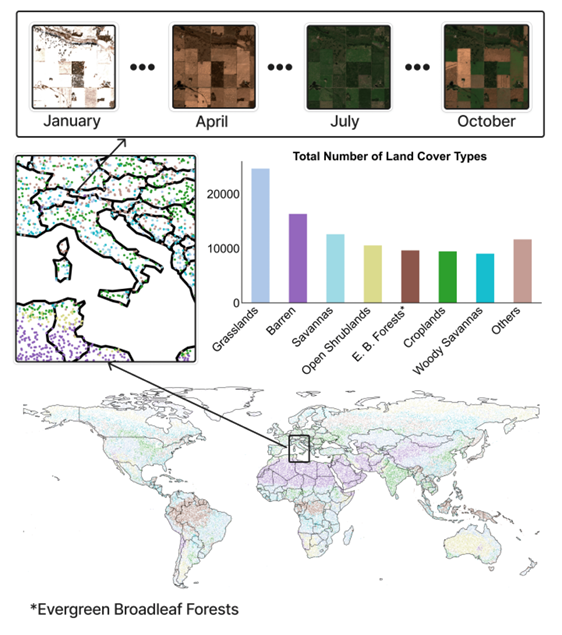

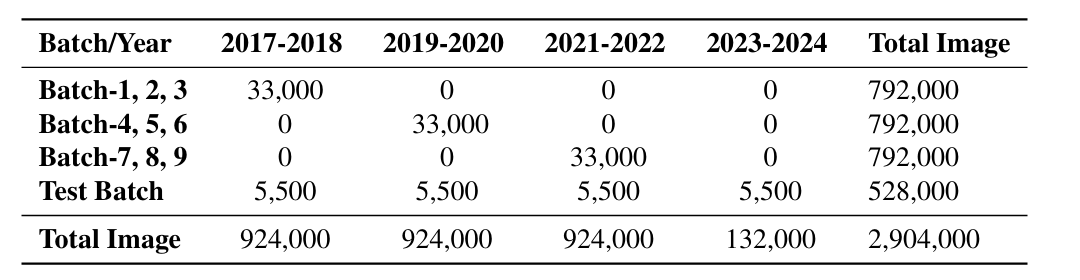

EcoMapper ist der bislang größte und umfassendste Fernerkundungsdatensatz.Der Datensatz besteht aus 2.904.000 Satellitenbildern mit Klimametadaten, die an 104.424 geografischen Standorten auf der ganzen Welt gesammelt wurden.Es umfasst 15 verschiedene Bodenbedeckungstypen. Wie in der folgenden Abbildung dargestellt:

In,Der Trainingssatz enthält 98.930 geografische Punkte und der Beobachtungszeitraum für jeden Punkt beträgt 24 Monate.Die Forscher wählten für jeden Standort über zwei Jahre hinweg eine Beobachtung pro Monat aus, basierend auf den Tagen mit der geringsten Wolkenbedeckung. So entstand eine Sequenz von 24 Bildern pro Standort. Der zweijährige Beobachtungszeitraum wurde zufällig zwischen 2017 und 2022 verteilt.

Der Testsatz enthält 5.494 geografische Punkte.Der Beobachtungszeitraum beträgt für jeden Standort 96 Monate (8 Jahre) und erstreckt sich von 2017 bis 2024. Das Monitoring erfolgt ebenfalls monatlich.

Aus räumlicher Sicht beträgt der räumliche Abdeckungsbereich jeder Beobachtung ungefähr 26,21 Quadratkilometer.Der gesamte Datensatz umfasst ungefähr 2.704.000 Quadratkilometer, was ungefähr 2,05% der gesamten Landfläche der Erde entspricht.Diese Daten gewährleisten eine ausreichende räumliche und zeitliche Unabhängigkeit bei der Auswertung und ermöglichen eine robuste Beurteilung der Generalisierung des Modells auf verschiedene Regionen und unbekannte Klimabedingungen.

Darüber hinaus wird jeder Probenahmeort mit Metadaten angereichert, darunter geografischer Standort (Breiten- und Längengrad), Beobachtungsdatum (Jahr und Monat), Bodenbedeckungsart und Wolkenbedeckung sowie monatliche Durchschnittstemperatur, Sonneneinstrahlung und Gesamtniederschlagsmenge von NASA Power. Diese Daten zeigen Vorteile für Landwirtschaft, Forstwirtschaft, Bodenbedeckung und Biodiversität.

Modellarchitektur: Text-Bild-Generierungsmodell und multibedingtes Generierungsmodell

Das Ziel dieser Forschung besteht darin, Satellitenbilder auf der Grundlage geografischer und klimatischer Metadaten zu synthetisieren, um realistische Vorhersagen der Umweltbedingungen zu ermöglichen.Die Forscher mussten zwei Hauptaufgaben bewältigen: die Generierung von Text zu Bild und die Generierung multikonditionaler Bilder.

Die Forscher bewerteten die Fähigkeit zweier generativer Modelle, Klimametadaten in die Synthese von Satellitenbildern zu integrieren:

Die erste ist Stabile Diffusion 3.Es handelt sich um ein multimodales latentes Diffusionsmodell, das CLIP- und T5-Textencoder integriert, um flexible Einstellungen der Eingabebedingungen zu ermöglichen. Die Forscher nutzten den gesammelten Datensatz, um Stable Diffusion 3 so zu optimieren, dass es auf realistischen Satellitenbildern mit geografischen, klimatischen und zeitlichen Metadaten basiert.

Der zweite ist DiffusionSat,Dies ist ein Basismodell speziell für Satellitenbilder, das auf Stable Diffusion 2 basiert und um eine spezielle Metadaten-Einbettungsschicht für die numerische Konditionierung erweitert wurde. Im Vergleich zu allgemeinen Diffusionsmodellen ist dieses Modell speziell für Fernerkundungsaufgaben konzipiert, kann wichtige räumliche und zeitliche Attribute kodieren und verfügt über Superauflösung, Bildwiederherstellung und zeitliche Vorhersagefunktionen.

Für die Aufgabe der Text-zu-Bild-Generierung verglichen die Forscher verschiedene Konfigurationen von Stable Diffusion 3 und DiffusionSat, darunter fein abgestimmte und nicht fein abgestimmte Modelle, und führten Experimente mit unterschiedlichen Auflösungen durch:

* Basismodelle: Beide Modelle werden ohne Feinabstimmung mit einer Auflösung von 512 x 512 ausgewertet.

* Feinabgestimmte Modelle (-FT): Beide Modelle wurden nach der Feinabstimmung mithilfe von Klimametadaten in einer Auflösung von 512 x 512 ausgewertet.

* SD3-Modell mit hoher Auflösung: SD3 wird mithilfe von Klimametadaten mit einer Auflösung von 1024 x 1024, bezeichnet als SD3-FT-HR, feinabgestimmt und getestet.

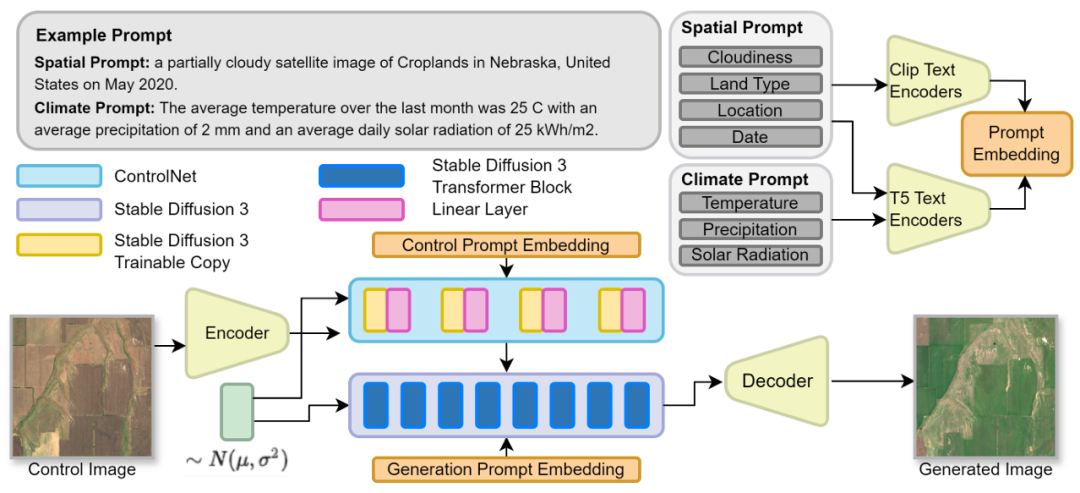

Für Aufgaben zur Bildgenerierung mit mehreren Bedingungen,Die Forscher entschieden sich für die Verwendung eines fein abgestimmten Stable Diffusion 3-Modells, das mit der LoRA-Technologie (Low-Rank Adaption) erweitert wurde, um Aufgaben zur Bildgenerierung mit mehreren Bedingungen durchzuführen.Das Modell wurde mit einer Auflösung von 512 x 512 Pixeln trainiert, um qualitativ hochwertige und kontextrelevante Bilder zu generieren. Die Studie nutzte die ControlNet-Technologie, um einen dual-bedingten Mechanismus zu entwickeln:

* ControlNet verbessert das Diffusionsmodell durch die Integration expliziter räumlicher Steuerung in den Generierungsprozess. Dieses Design stellt sicher, dass der Kontrollblock zunächst nur minimale Auswirkungen auf den Hauptblock hat und wie ein Sprunglink funktioniert.

* Satellitenbilder als Steuersignale:Satellitenbilder der letzten Monate dienen als Kontrollsignale, um die räumliche Struktur der generierten Bilder zu erhalten und sicherzustellen, dass Landschaftsformen, Stadtpläne und andere geografische Merkmale unverändert bleiben. Dadurch kann das Modell Veränderungen im Laufe der Zeit berücksichtigen und so Umweltveränderungen in der realen Welt widerspiegeln.

* Klimatipps:Geben Sie die klimatischen und atmosphärischen Bedingungen für die Generierung von Satellitenbildern mit Hilfe eines Textkonditionierungsmechanismus an.

Durch die Kombination dieser beiden Anpassungsfaktoren ermöglicht die Studie dem Modell, realistische Satellitenbilder zu generieren, die den Klimawandel berücksichtigen und gleichzeitig die räumliche Konsistenz wahren. Dieser Ansatz unterstützt auch die Generierung von Zeitreihen, die die Landschaftsentwicklung unter veränderten Klimabedingungen simulieren können. Wie in der folgenden Abbildung dargestellt:

Das Framework von Stable Diffusion 3 und ControlNet ist integriert, um die Generierung von Satellitenbildern unter verschiedenen Bedingungen zu ermöglichen

Um Satellitenbilder effektiv zu erzeugen, müssen Sie eine schnelle Struktur haben.Die Forscher entwickelten zwei Arten von Eingabeaufforderungen zur Steuerung der Satellitenbildgenerierung, nämlich räumliche Eingabeaufforderungen und Klimaeingabeaufforderungen.Ersteres dient zur Kodierung grundlegender Metadaten, darunter Informationen zu Bodenbedeckungsart, Standort, Datum und Wolkenbedeckung, um sicherzustellen, dass das generierte Bild dem geografischen und zeitlichen Kontext entspricht. Letzteres integriert monatliche Klimavariablen (Temperatur, Niederschlag und Sonneneinstrahlung) basierend auf räumlichen Hinweisen, um umfassendere Informationen zu den Umweltbedingungen für die Bildgenerierung bereitzustellen. Beide Hinweise nutzen den Textencoder von Stable Diffusion 3, wobei die räumlichen Informationen von CLIP und die Klimadaten vom T5-Encoder verarbeitet werden.

Experimentelle Ergebnisse: Die Erzeugungsleistung übertrifft das Basismodell, es besteht jedoch noch Verbesserungsbedarf

Die Forscher entwarfen ein mehrdimensionales experimentelles System und überprüften die Leistung des entworfenen generativen Modells bei der Generierung klimabewusster Satellitenbilder durch mehrere horizontale und vertikale Vergleiche und Experimente.

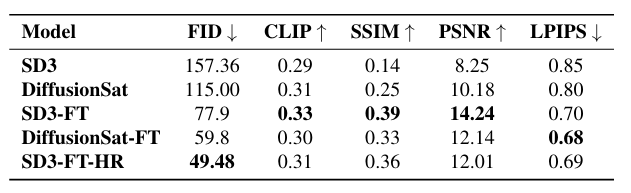

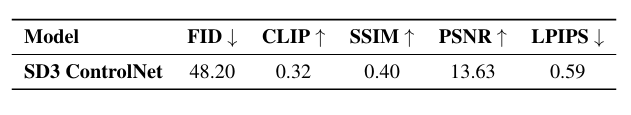

Zunächst identifizierten die Forscher fünf etablierte Indikatoren:Einschließlich FID (Fréchet Inception Distance), LPIPS (Learned Perceptual Image Patch Similarity), SSIM (Structural Similarity Index), PSNR (Peak Signal-to-Noise Ratio) und CLIP Score. FID und LPIPS bewerten die Ähnlichkeit der Bildverteilung und Wahrnehmungsunterschiede, SSIM und PSNR messen die strukturelle Konsistenz und Rekonstruktionsqualität und CLIP Score bewertet die Text-Bild-Ausrichtung.

In Bezug auf die Text-zu-Bild-Generierung überprüften die Forscher die Wirksamkeit des entwickelten Modells, indem sie die Leistung von Stable Diffusion 3 und DiffusionSat und ihren fein abgestimmten Versionen (SD3-FT und DiffusionSat-FT) und SD3-FT-HR an 5.500 geografischen Punkten verglichen.

Wie in der Abbildung unten gezeigt. Die Basismodelle SD3 und DiffusionSat weisen die niedrigsten Bewertungswerte auf.Allerdings ist die Leistung des letzteren deutlich besser als die des ersteren, was die Vorteile des Vortrainings durch Fernerkundung zeigt; außerdem werden die Indikatoren aller Feinabstimmungsmodelle deutlich verbessert.SD3-FT schneidet bei CLIP, SSIM und PSNR besser ab, während DiffusionSat-FT bei FID und LPIPS besser abschneidet. SD3-FT-HR hat den niedrigsten FID (niedrigere FID-Werte weisen auf eine höhere Authentizität hin), nämlich 49,48, was darauf hinweist, dass die von ihm generierten Bilder feinere Details aufweisen.

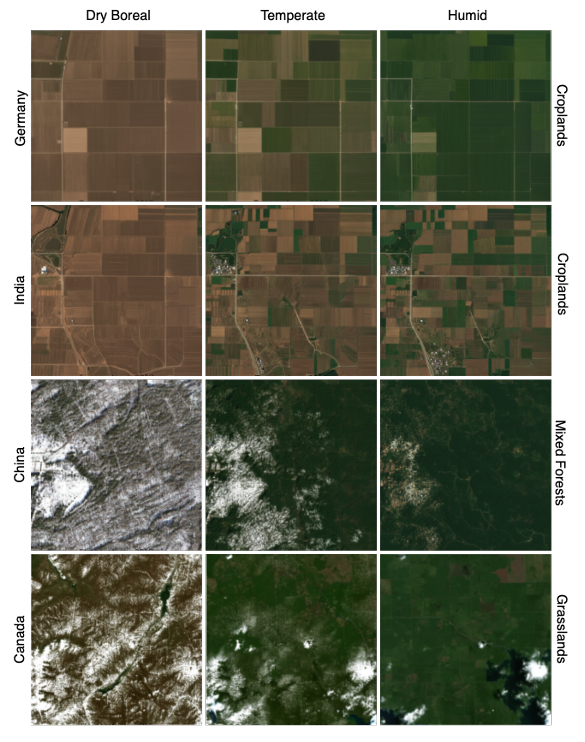

Die qualitative Ergebnisanalyse zeigt, dass das entwickelte Modell die regelmäßige Beschaffenheit von Ackerland und Grasland sowie die Charakteristika von bergigem Gelände erfassen kann. Insbesondere bei Änderungen der Vegetationsdichte und hochauflösenden Details schneidet SD3-FT-HR besser ab.

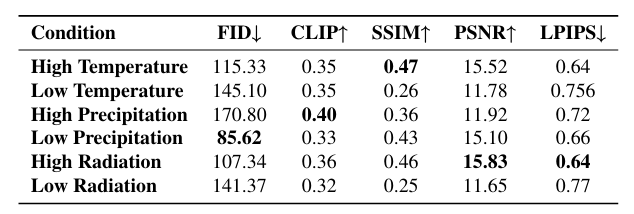

In der Klimasensitivitätsanalyse, wie in der folgenden Abbildung dargestellt,Die vom Modell generierte Vegetationsdichte korreliert signifikant mit dem Klimawandel.Die Studie führte einen quantitativen Stresstest des SD3-FT-Modells an Proben mit extremen Wetterbedingungen durch. Die Ergebnisse zeigten, dass bei hohen Temperaturen und hoher Strahlung der FID der vom Modell generierten Bilder niedriger war (z. B. lag der FID bei hoher Strahlung bei 107,34) und die Vegetation deutlicher zu erkennen war. Bei niedrigen Temperaturen und niedriger Strahlung war das Gegenteil der Fall, und der Simulationseffekt war etwas schlechter.

Von SD3-FT erstellte Satellitenbilder für verschiedene Regionen unter extremen Klimabedingungen

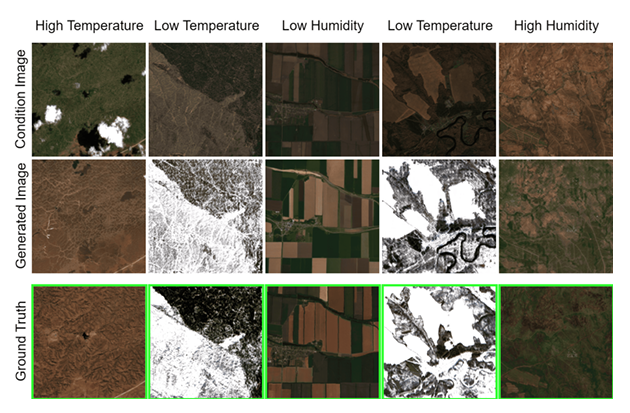

Bei der Aufgabe der mehrbedingten Bildgenerierung übertrifft die mehrbedingte Generierung in Kombination mit ControlNet das Text-zu-Bild-Modell in allen Indikatoren.Beispielsweise beträgt der FID von SD3 ControlNet 48,20. Darüber hinaus weisen das generierte Bild und das Echtzeitbild eine starke räumliche Übereinstimmung auf, wobei wichtige geografische Merkmale erhalten bleiben und gleichzeitig spezifische Klimaveränderungen berücksichtigt werden. Wie in der folgenden Abbildung dargestellt:

Im Robustheitstest hat die Art der Landbedeckung einen größeren Einfluss auf die Stabilität der Modellgenerierung.Gängige Arten wie Grasland und Savannen weisen eine hohe Generationsstabilität und einen niedrigen FID auf; komplexe oder seltene Arten wie Feuchtgebiete und Städte weisen höhere FIDs auf, beispielsweise 284,65 für Städte, was auf unzureichende Trainingsdaten zurückzuführen ist. Darüber hinaus ist die Leistung des Modells im Testdatensatz von 2017 bis 2024 stabil, und es gibt keine Leistungseinbußen im Datensatz von 2023 bis 2024. Dies beweist, dass das entworfene Modell weiterhin eine hohe Anpassungsfähigkeit an bisher unbekannte räumlich-zeitliche Szenarien aufweist.

Zusammenfassend stellt EcoMapper ein generatives Framework zur Simulation von Satellitenbildern basierend auf Klimavariablen vor, mit dem Ziel, die Reaktion von Landschaften auf Wetter und langfristigen Klimawandel zu modellieren. Dies eröffnet neue Möglichkeiten zur Visualisierung von Klimawandelauswirkungen, zur Szenarienanalyse und zur Verbesserung nachgelagerter Modelle, die Satelliten- und Klimadaten integrieren, beispielsweise zur Vorhersage von Ernteerträgen, zur Überwachung der Landnutzung oder zur Bildfüllung bewölkter Gebiete.

Algorithmen des maschinellen Lernens eröffnen ein neues Paradigma für die Generierung von Satellitenbildern

Die Anwendung generativer Modelle in der Satellitenbilderzeugung erzielt dank Deep-Learning-Technologie Durchbrüche. Diese kombiniert die Deep-Learning-Fähigkeiten neuronaler Netze mit umfangreichen Satellitendaten, um realistische, hochauflösende, multimodale Fernerkundungsbilder zu erzeugen. Darüber hinaus hat die Forschungsgemeinschaft in diesem Bereich schon lange einen „Staffellauf“ durchgeführt und durch kontinuierliche Innovation von Methoden und Ansätzen einen soliden Weg für die Forschung im Bereich der Satellitenbilder geebnet.

Beispielsweise ist DiffusionSat, das im Artikel erwähnt wird, das erste groß angelegte Diffusionsmodell, das speziell für Satellitenbilder entwickelt wurde und multispektrale Eingabe, Zeitreihengenerierung und Superauflösung unterstützt.Es verwendet auf innovative Weise Metadaten wie den geografischen Standort als bedingte Informationen, um das Problem fehlender Textanmerkungen in Satellitenbildern zu lösen.Die entsprechende Forschungsarbeit wurde von einem Team der Stanford University unter dem Titel „DIFFUSIONSAT: A GENERATIVE FOUNDATION MODEL FOR SATELLITE IMAGERY“ veröffentlicht und in ICLR 2024 aufgenommen.

Papieradresse:

https://arxiv.org/pdf/2312.03606

Darüber hinaus veröffentlichte ein Team der Universität für Luft- und Raumfahrt Peking eine Studie mit dem Titel „MetaEarth: Ein generatives Basismodell für die globale Fernerkundungsbildgenerierung“. Sie schlugen ein globales Generierungsmodell namens MetaEarth vor.Durch das auflösungsgesteuerte selbstkaskadierende Framework ist das Modell in der Lage, schrittweise hochauflösende geografische Bilder aus niedriger Auflösung zu generieren.Um randloses Stitching zu erreichen, werden die Sliding Window- und Noise Sharing-Strategie verwendet.

Papieradresse:

https://arxiv.org/pdf/2405.13570

Darüber hinaus demonstrierten Forscher des MIT, der Columbia University, der Oxford University und anderer Teams den Forschungsfortschritt bei der Synthese generativer visueller Modelle zur Visualisierung von Satellitenbildern im Zusammenhang mit dem Klimawandel. Sie schlugen eine Methode namens Earth Intelligence Engine (EIE) vor.Kombination physikalisch basierter Hochwassermodellprojektionen und Satellitenbilder als Input für ein tiefgreifendes generatives visuelles Modell,Dies wird durch die Auswertung der Schnittmenge des generierten Bildes und der Hochwasserdaten erreicht. Die Ergebnisse zeigen, dass die Methode hinsichtlich physikalischer Konsistenz und visueller Qualität gut abschneidet, das Basismodell ohne physikalische Bedingungen übertrifft und Generalisierungsmöglichkeiten für verschiedene Fernerkundungsdaten und Klimaereignisse bietet. Der Titel der Arbeit lautet „Generierung physikalisch konsistenter Satellitenbilder für Klimavisualisierungen“.

Papieradresse:

https://arxiv.org/html/2104.04785v5

Es besteht kein Zweifel, dass generative Modelle die Generierung und den Anwendungsbereich von Satellitenbildern verändern – von der Hochwasserwarnung bis hin zu generativen Oberflächenmodellen im globalen Maßstab, von der multispektralen Datenfusion bis hin zur raumzeitlichen dynamischen Simulation. Dies stellt nicht nur einen technologischen Durchbruch dar, sondern bietet auch großes Anwendungspotenzial. Ich bin überzeugt, dass generative Modelle in naher Zukunft mit der weiteren Optimierung von Technologien wie Diffusionsmodellen und selbstkaskadierenden Frameworks der Entwicklung von Satellitenbildern weitere Impulse verleihen werden.

Quellen:

1.https://arxiv.org/pdf/2312.03606

2.https://arxiv.org/html/2104.04785v5

3.https://arxiv.org/pdf/2405.13570