Command Palette

Search for a command to run...

Online-Tutorial | Das Universelle 3D-Vision-Modell VGGT Hat Den Preis Für Das Beste Papier Des CVPR 2025 Gewonnen Und Kann Eine Inferenzgeschwindigkeit Von Sekunden Erreichen

Am 13. Juni gab die CVPR 2025, eine der drei weltweit führenden Computer Vision-Konferenzen, die Auszeichnungen für die besten Beiträge bekannt. Offiziellen Angaben zufolge gingen bei der CVPR 2025 13.008 Beiträge von über 40.000 Autoren ein, ein Anstieg von 131.000 Beiträgen im Vergleich zum Vorjahr.Die Konferenz akzeptierte schließlich 2.872 Beiträge, mit einer Gesamtakzeptanzrate von ungefähr 22,1%.

Von den knapp 3.000 ausgewählten Arbeiten konnte sich nur eine durchsetzen und den Titel „Bestes Paper“ gewinnen. Man kann sich vorstellen, wie wertvoll das ist.Diese Errungenschaft ist ein allgemeines 3D-Vision-Modell (VGGT), das auf einer reinen Feedforward-Transformer-Architektur basiert, die gemeinsam von der Universität Oxford und Meta AI vorgeschlagen wurde.Es überwindet die Herausforderung, dass frühere Modelle auf eine einzige Aufgabe beschränkt waren, und kann alle wichtigen 3D-Eigenschaften der Szene direkt aus einer, mehreren oder Hunderten von Perspektiven ableiten, einschließlich Kameraparametern, Punktkarten, Tiefenkarten und 3D-Punktspuren.

* Titel des Artikels:「VGGT: Visuelle Geometrie geerdeter Transformator"

* Link zum Artikel:https://go.hyper.ai/Nmgxd

Noch wichtiger ist, dass diese Methode einfach und effizient ist.Kann die Bildrekonstruktion in weniger als 1 Sekunde abschließen.Die Leistung von VGGT übertrifft die von Alternativen, die auf Nachbearbeitungstechniken zur visuellen Geometrieoptimierung basieren. Experimentelle Ergebnisse zeigen, dass VGGT bei mehreren 3D-Aufgaben eine Leistung auf SOTA-Niveau erreicht hat, darunter bei der Schätzung von Kameraparametern, der Tiefenschätzung mehrerer Ansichten, der Rekonstruktion dichter Punktwolken und der 3D-Punktverfolgung.

derzeit,Der Tutorial-Bereich von HyperAI Hyper.ai hat „VGGT: Ein universelles 3D-Vision-Modell“ eingeführt.Unterstützen Sie den Ein-Klick-Bereitstellungseffekt und spüren Sie die kraftvolle Kraft dieses Durchbruchs ⬇️

* Link zum Tutorial:https://go.hyper.ai/GX3bC

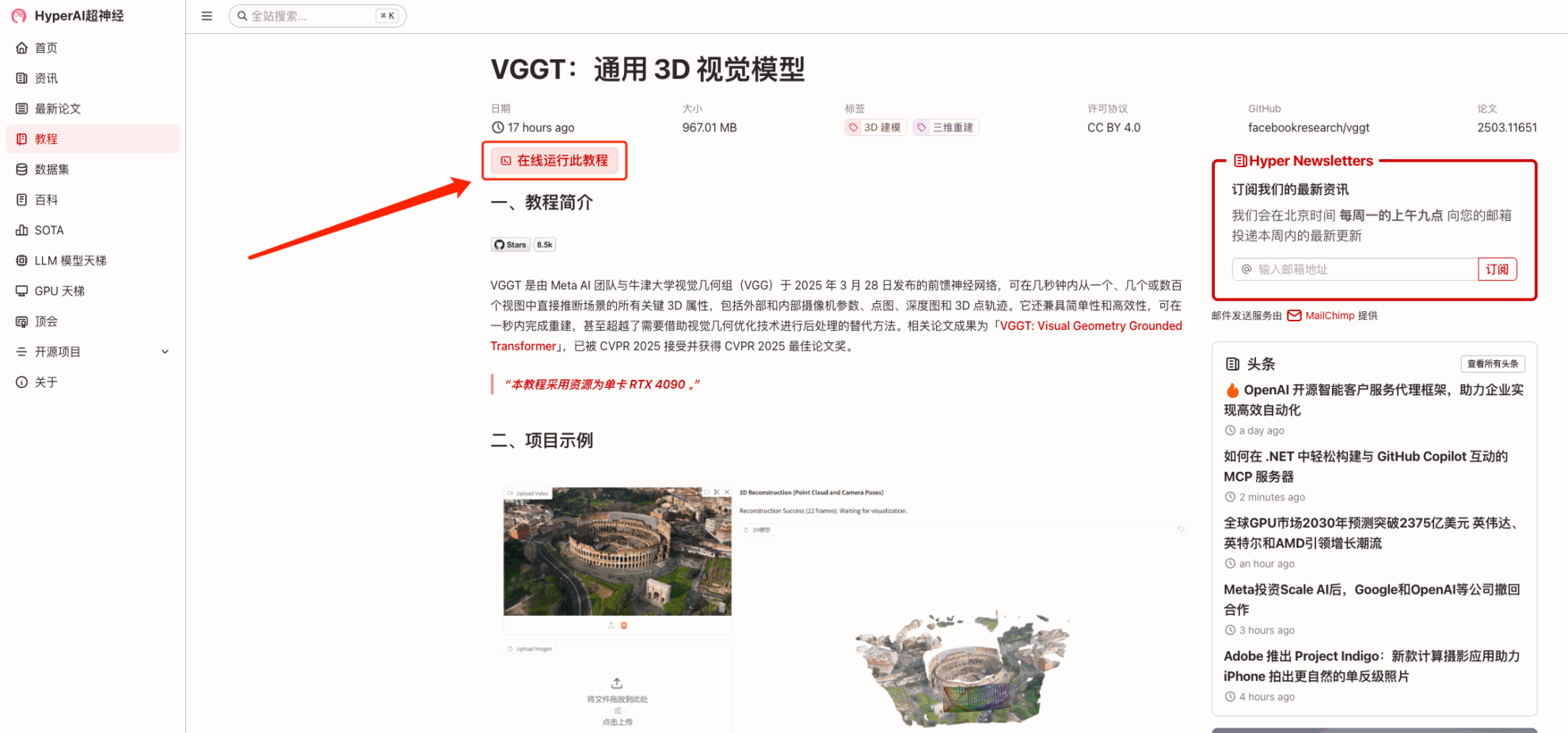

Demolauf

1. Nachdem Sie die Homepage von hyper.ai aufgerufen haben, wählen Sie die Seite „Tutorial“, wählen Sie „VGGT: Allgemeines 3D-Vision-Modell“ und klicken Sie auf „Dieses Tutorial online ausführen“.

2. Klicken Sie nach dem Seitensprung oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

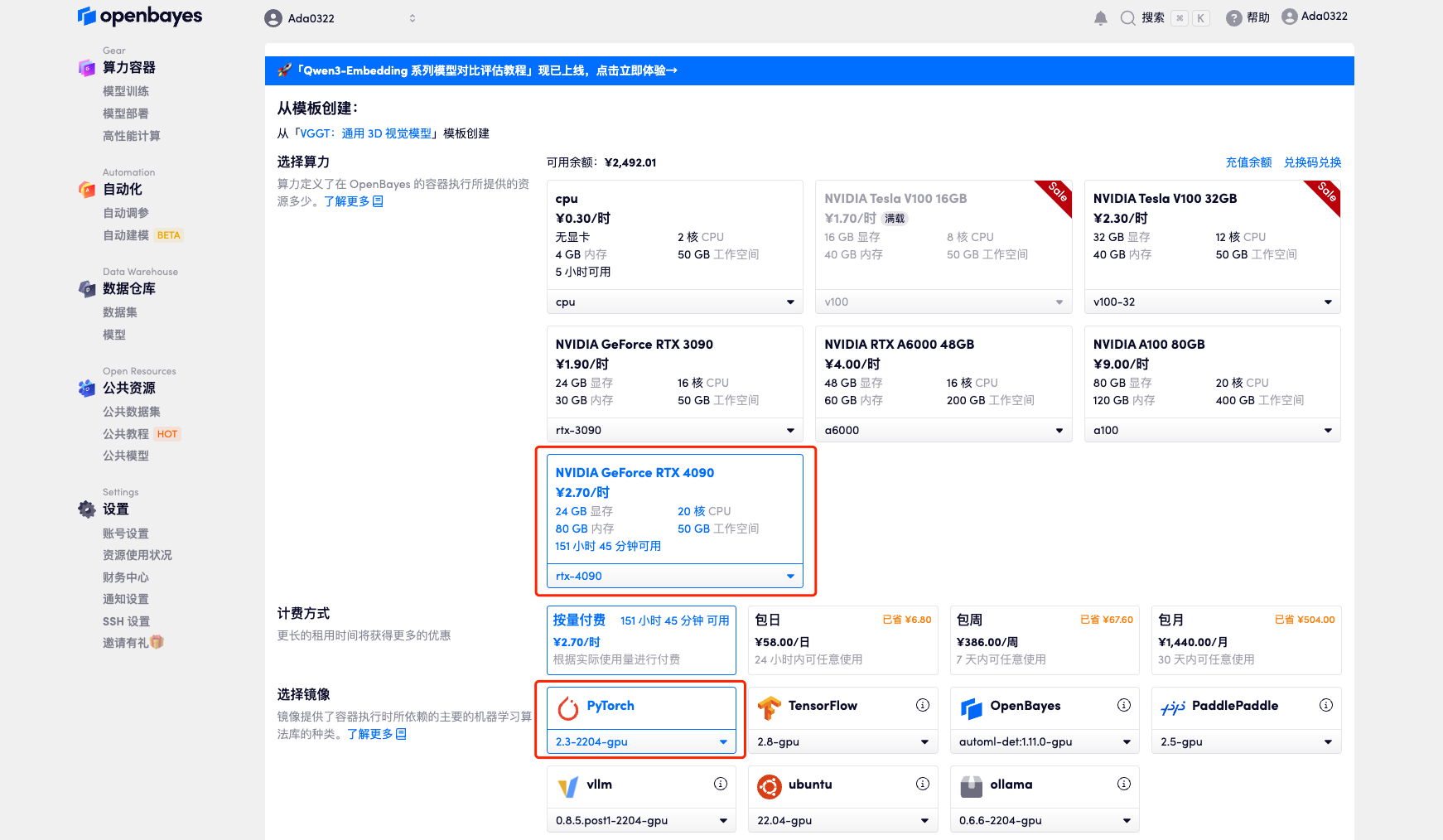

3. Wählen Sie die Bilder „NVIDIA RTX 4090“ und „PyTorch“ aus. Die OpenBayes-Plattform bietet vier Abrechnungsmethoden. Sie können je nach Bedarf zwischen „Pay as you go“ oder „Pay per day/week/month“ wählen. Klicken Sie auf „Weiter“. Neue Benutzer können sich über den unten stehenden Einladungslink registrieren und erhalten 4 Stunden RTX 4090 + 5 Stunden CPU-freie Zeit!

Exklusiver Einladungslink von HyperAI (kopieren und im Browser öffnen):

https://openbayes.com/console/signup?r=Ada0322_NR0n

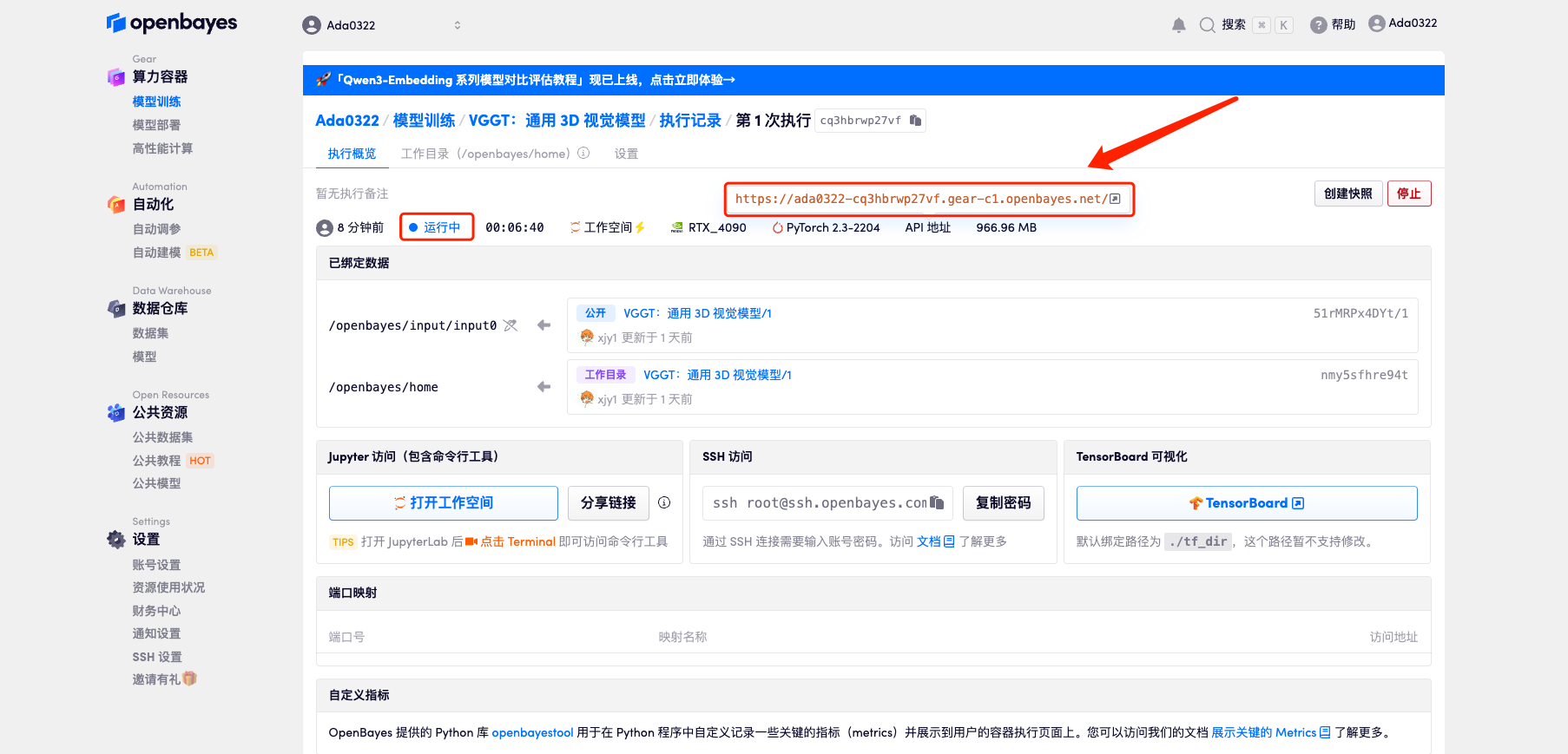

4. Warten Sie, bis die Ressourcen zugewiesen wurden. Der erste Klonvorgang dauert etwa 2 Minuten. Wenn sich der Status in „Läuft“ ändert, klicken Sie auf den Sprungpfeil neben „API-Adresse“, um zur Demoseite zu springen. Da das Modell groß ist, dauert es etwa 3 Minuten, bis die WebUI-Schnittstelle angezeigt wird, andernfalls wird „Bad Gateway“ angezeigt. Bitte beachten Sie, dass Benutzer vor der Verwendung der API-Adresszugriffsfunktion eine Echtnamenauthentifizierung durchführen müssen.

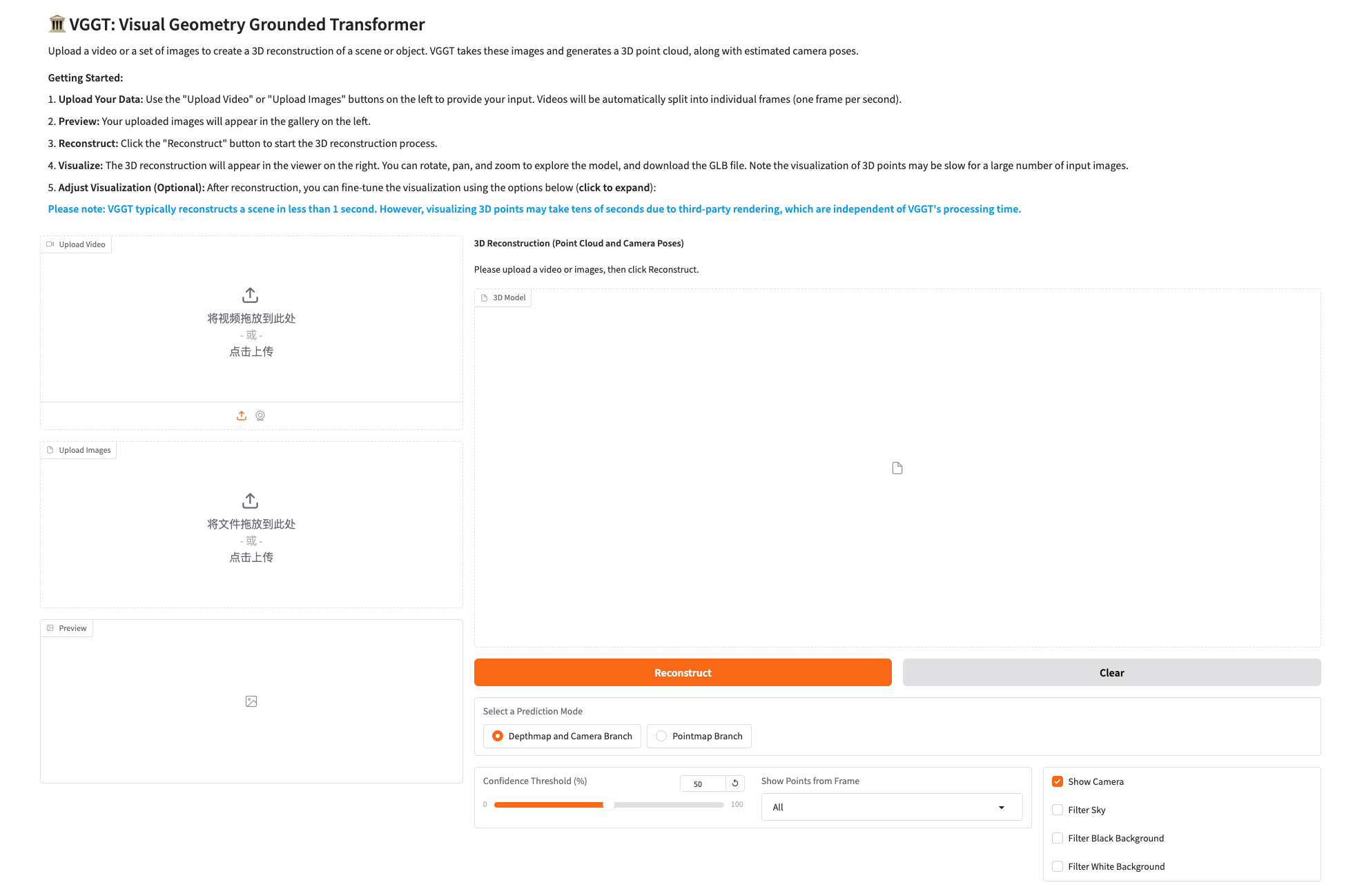

Effektdemonstration

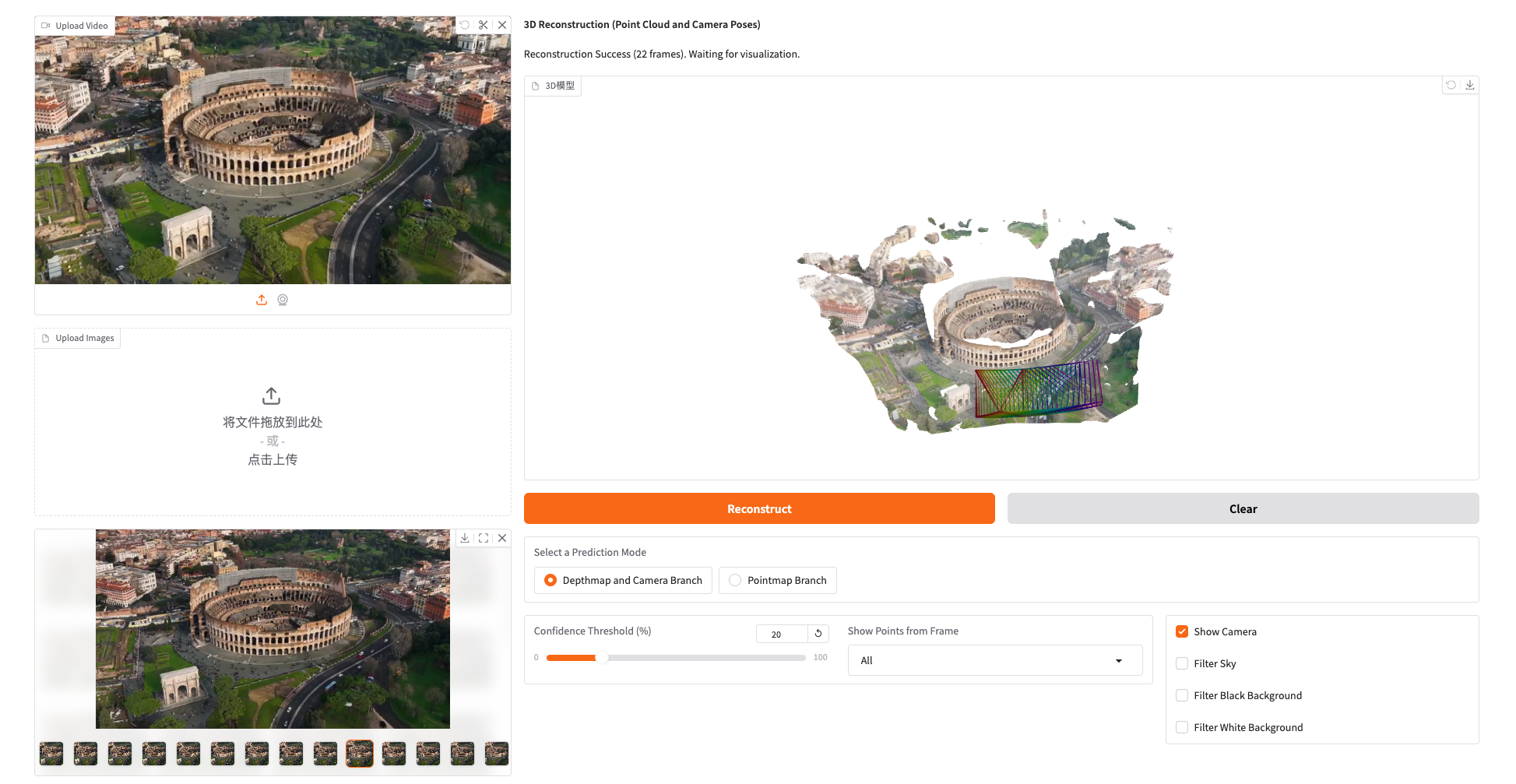

1. Klicken Sie auf die API-Adresse, um die Demoseite aufzurufen und das Modell auszuprobieren, wie unten gezeigt:

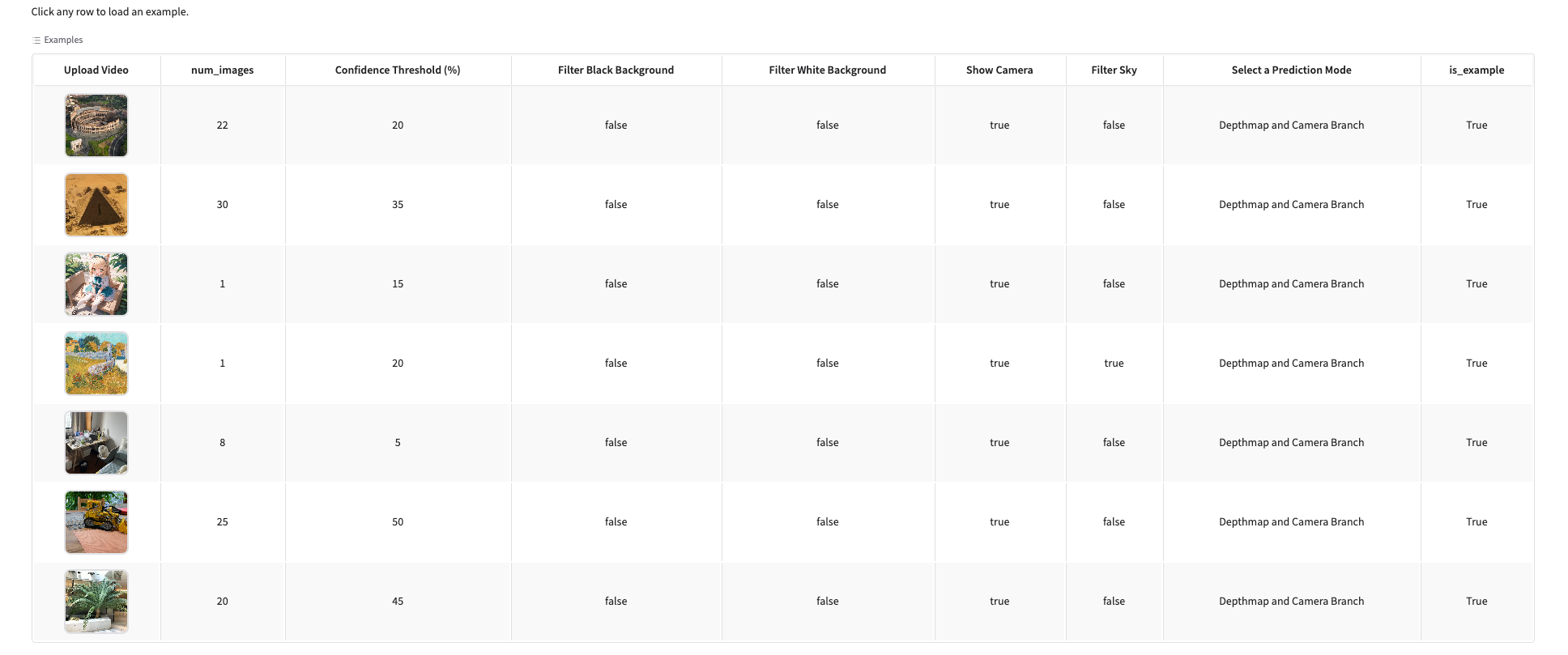

2. Wir haben im Tutorial Beispiele für Sie vorbereitet. Sie können die Modellwirkung direkt erleben, indem Sie darauf klicken, wie unten gezeigt.

Dies ist das empfohlene Tutorial für dieses Problem. Jeder ist herzlich eingeladen, es selbst auszuprobieren.

* Link zum Tutorial:https://go.hyper.ai/GX3bC