Command Palette

Search for a command to run...

Google Veröffentlicht MedGemma, Basierend Auf Gemma 3, Spezialisiert Auf Medizinisches Text- Und Bildverständnis

In den letzten zwei Tagen erfreute sich Google I/O 2025 großer Beliebtheit. In seiner Keynote-Rede am ersten Tag der Veranstaltung stellte der CEO des Unternehmens, Sundar Pichai, zahlreiche Neuerungen vor, darunter die komplette Palette an Upgrades für Gemini 2.5, die Einführung des Agentenmodus in Chrome, die öffentliche Beta des Codieragenten Jules, die offizielle Version von Android XR und so weiter. Zu den umwerfenden Updates gehörenDarin verbirgt sich auch eine große Open-Source-Errungenschaft im medizinischen Bereich – MedGemma.

Laut offizieller EinführungDie Modelle der MedGemma-Reihe basieren auf Gemma 3.Enthält Googles leistungsstärkstes Open-Source-Modell zum Verständnis medizinischer Texte und Bilder, verfügbar in 2 Versionen.Es gibt vier Milliarden Parameter für die multimodale Version und 27 Milliarden Parameter für die Nur-Text-Version.

Unter anderem verwendet die multimodale Version von MedGemma 4B den SigLIP-Bildkodierer, der speziell vortrainiert ist und Daten verwendet, die anonymisierte medizinische Bilder umfassen, darunter Röntgenaufnahmen des Brustkorbs, dermatologische Bilder, ophthalmologische Bilder und Gewebepathologieabschnitte. Seine umfangreiche Sprachmodellkomponente wird anhand einer Vielzahl medizinischer Daten trainiert, darunter radiologische Bilder, histopathologische Bildausschnitte, ophthalmologische und dermatologische Bilder sowie medizinische Texte.Und MedGemma 27B wurde speziell anhand medizinischer Texte trainiert und für Berechnungen in der Inferenzphase optimiert.

Für das Verständnis medizinischer Texte und klinischer Entscheidungsfindungsszenarien kann MedGemma mehrere Aufgaben übernehmen, beispielsweise Patientenberatung, Triage, Unterstützung klinischer Entscheidungen und Zusammenfassung medizinischer Texte. Um den Lesern zu helfen, die leistungsstarken Funktionen von MedGemma intuitiver zu erleben,Im Abschnitt „Tutorial“ der offiziellen Website von HyperAI wurde jetzt die „Ein-Klick-Bereitstellung des medizinischen Argumentationsmodells MedGemma-27b-text-it“ eingeführt.Kommen Sie und erleben Sie die KI-Arztberatung!

* Adresse des Tutorials:https://go.hyper.ai/Urygb

Wir haben auch Überraschungsvorteile für neu registrierte Benutzer vorbereitet. Verwenden Sie den Einladungscode „MedGemma“, um sich auf der OpenBayes-Plattform zu registrieren.Sie können RTX A6000 4 Stunden lang kostenlos nutzen (die Ressource ist 1 Monat gültig).Begrenzte Menge, wer zuerst kommt, mahlt zuerst!

Auch,Im Tutorial-Bereich der offiziellen Website wurde außerdem „vLLM+Open WebUI Deployment II-Medical-8B Medical Reasoning Model“ eingeführt.Das Modell basiert auf Qwen3-8B und die Modellleistung wird durch überwachte Feinabstimmung mithilfe eines medizindomänenspezifischen Inferenzdatensatzes und Training von DAPO (einer möglichen Optimierungsmethode) auf einem harten Inferenzdatensatz optimiert.

* Adresse des Tutorials:https://go.hyper.ai/8fFFY

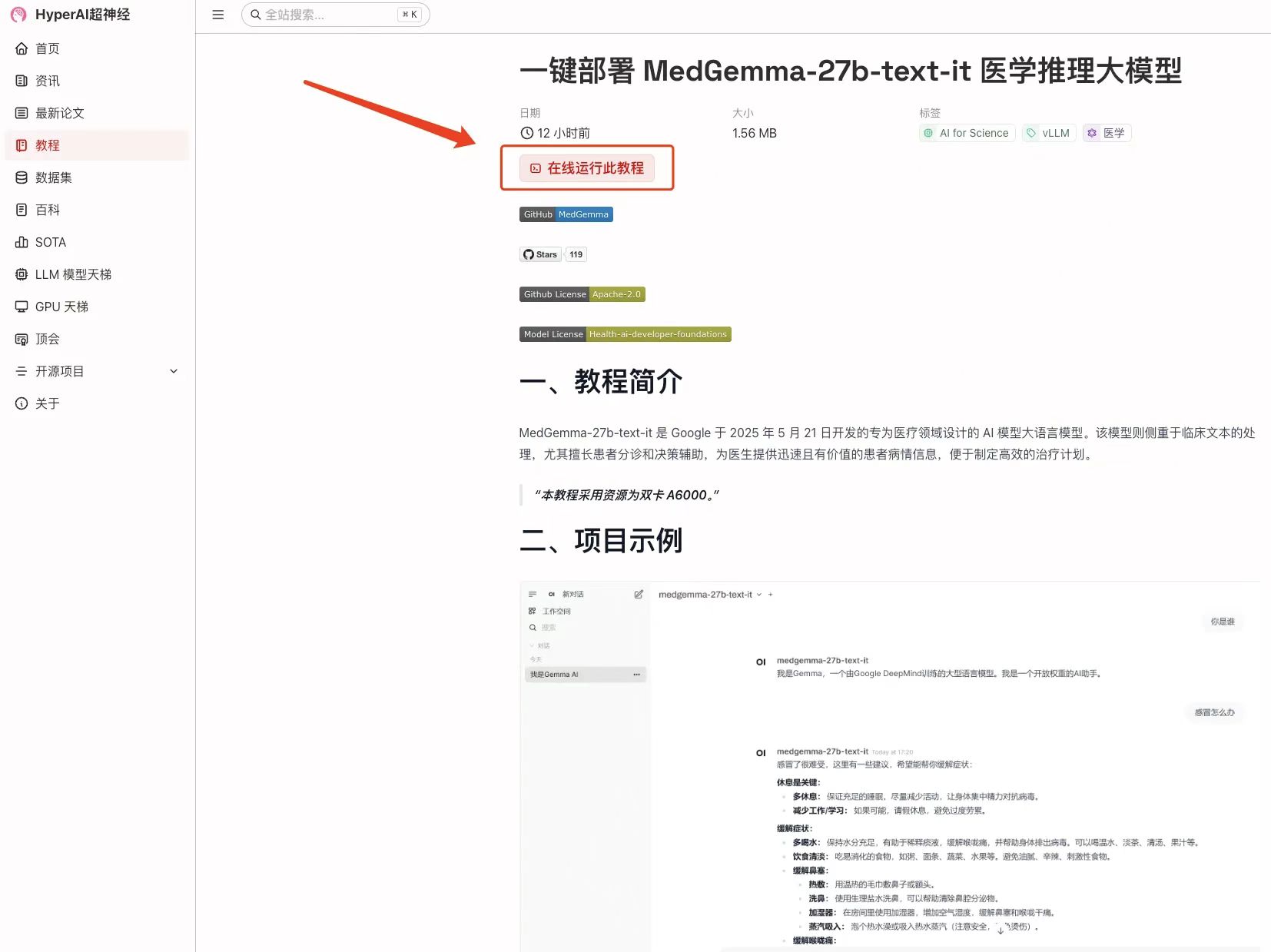

Demolauf

1. Nachdem Sie die Homepage von hyper.ai aufgerufen haben, wählen Sie die Seite „Tutorial“, wählen Sie „Ein-Klick-Bereitstellung des medizinischen Argumentationsmodells MedGemma-27b-text-it“ und klicken Sie auf „Dieses Tutorial online ausführen“.

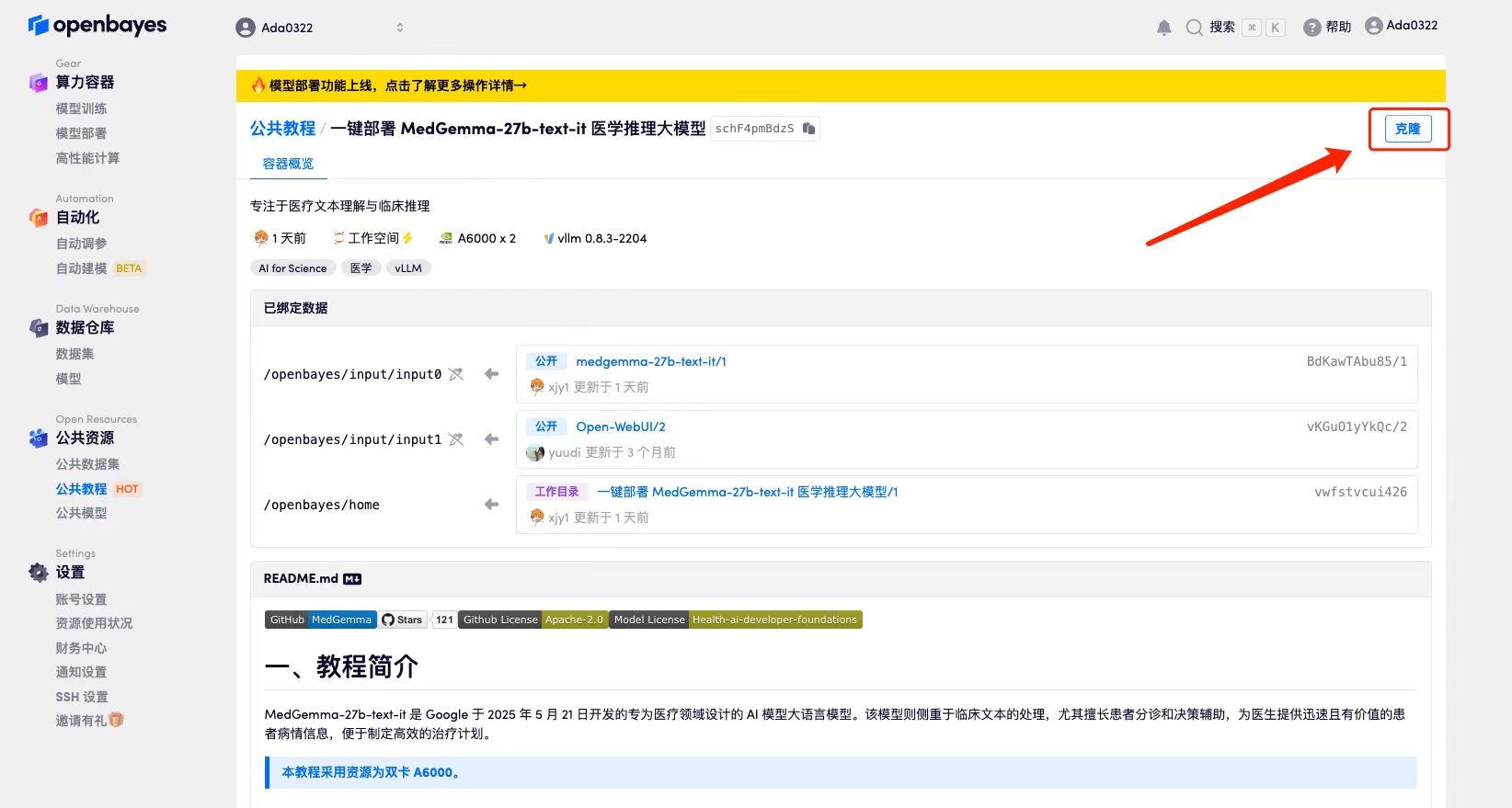

2. Klicken Sie nach dem Seitensprung oben rechts auf „Klonen“, um das Tutorial in Ihren eigenen Container zu klonen.

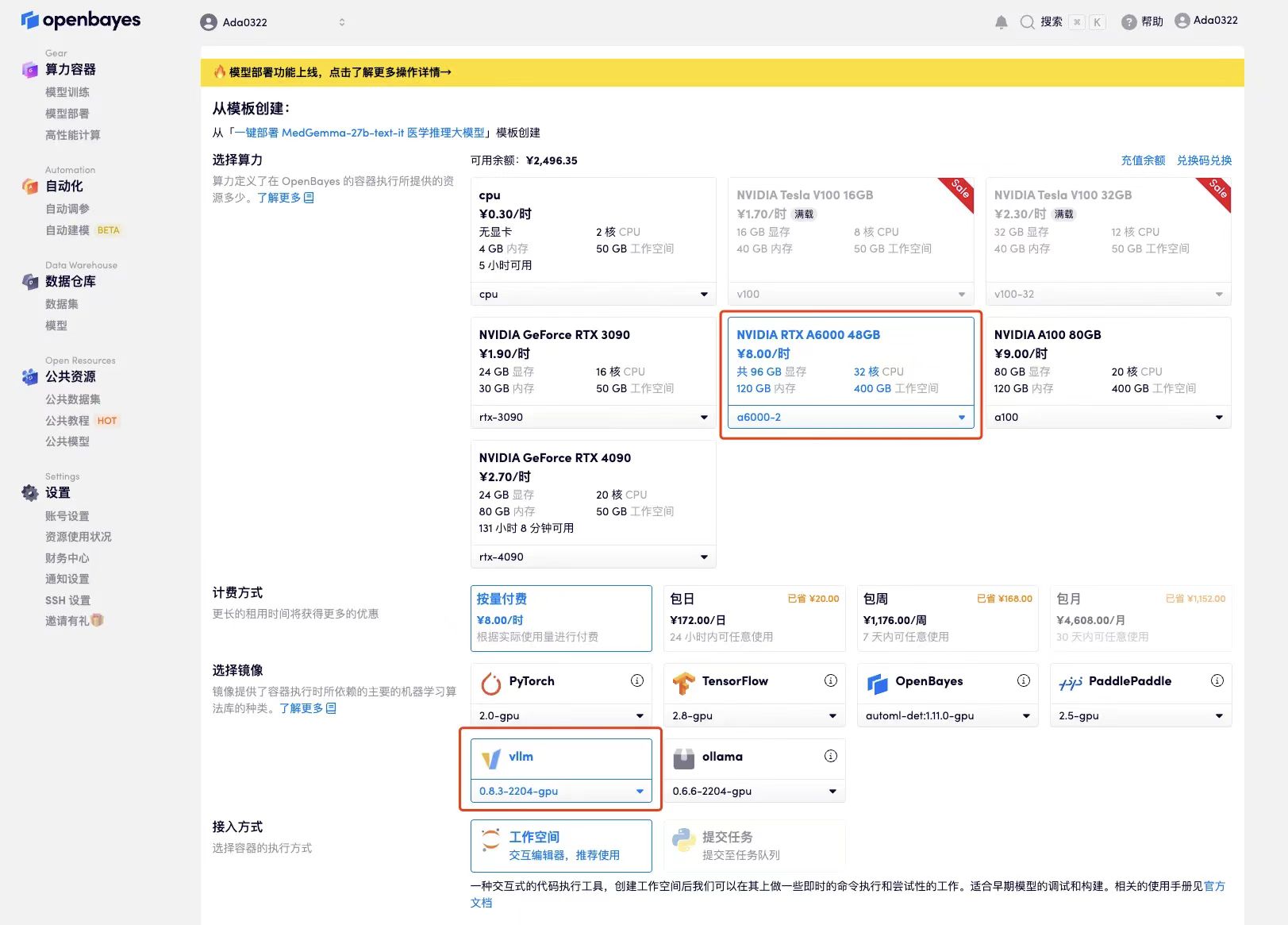

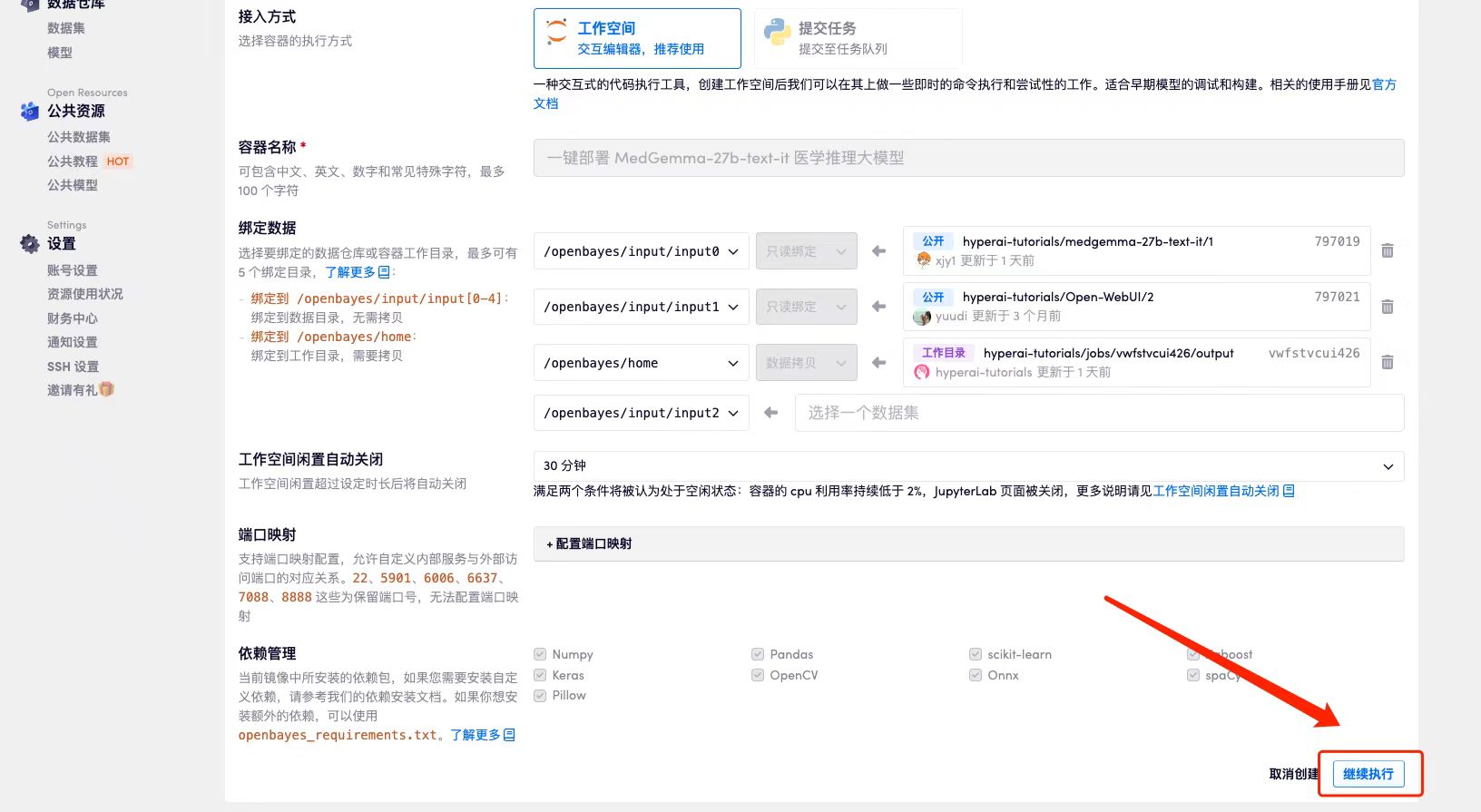

3. Wählen Sie das Image „NVIDIA A6000 48 GB“ und „vLLM“ aus. Die OpenBayes-Plattform bietet vier Abrechnungsmethoden. Sie können je nach Bedarf zwischen „Pay as you go“ oder „Täglich/Wöchentlich/Monatlich“ wählen. Klicken Sie auf „Weiter“. Neue Benutzer können sich über den unten stehenden Einladungslink registrieren, um 4 Stunden RTX 4090 + 5 Stunden CPU-freie Zeit zu erhalten!

Exklusiver Einladungslink von HyperAI (kopieren und im Browser öffnen):

https://openbayes.com/console/signup?r=Ada0322_NR0n

4. Warten Sie, bis die Ressourcen zugewiesen wurden. Der erste Klonvorgang dauert etwa 2 Minuten. Wenn sich der Status in „Läuft“ ändert, klicken Sie auf den Sprungpfeil neben „API-Adresse“, um zur Demoseite zu springen. Da das Modell groß ist, dauert es etwa 3 Minuten, bis die WebUI-Schnittstelle angezeigt wird, andernfalls wird „Bad Gateway“ angezeigt. Bitte beachten Sie, dass Benutzer vor der Verwendung der API-Adresszugriffsfunktion eine Echtnamenauthentifizierung durchführen müssen.

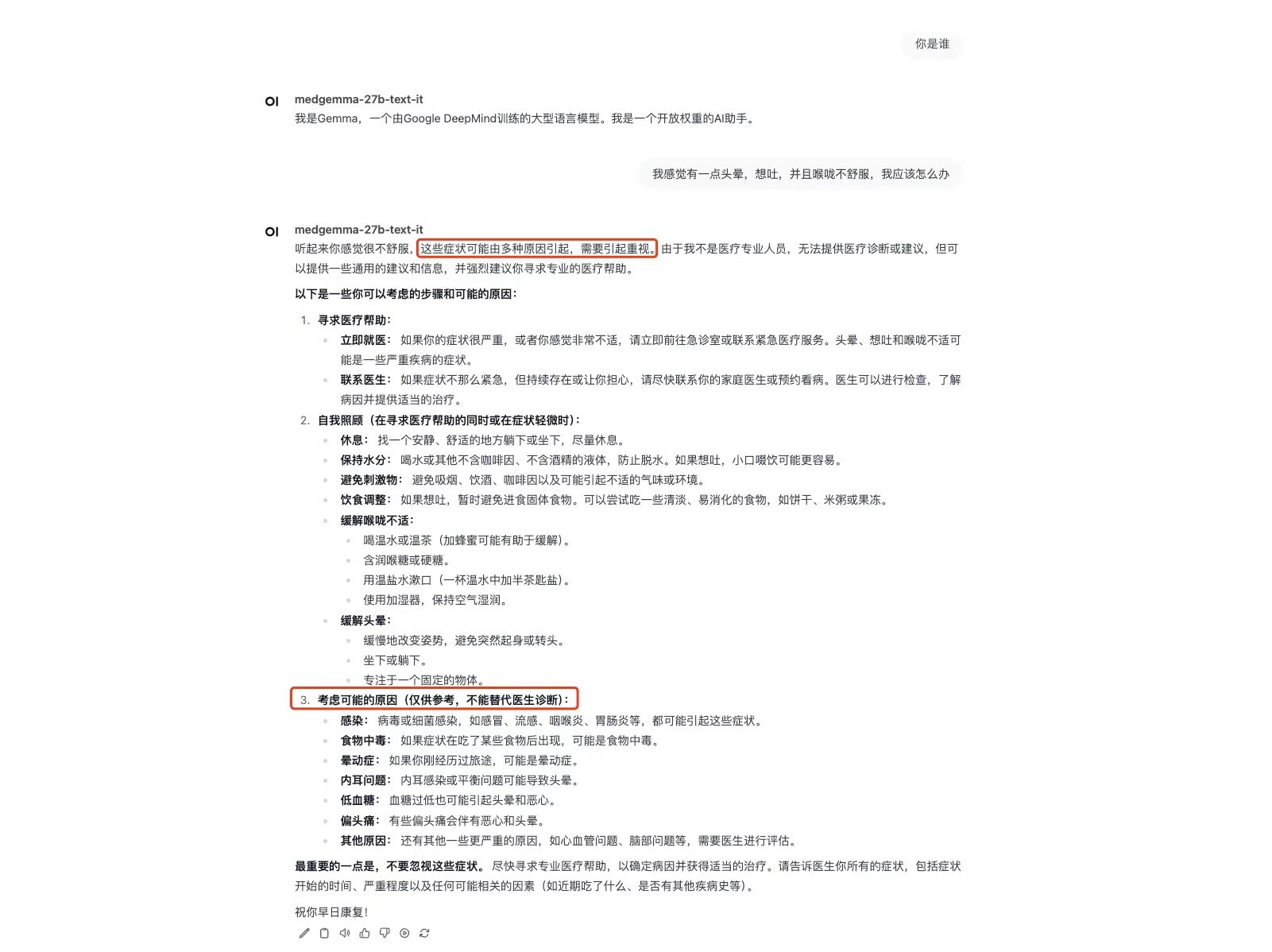

Effektdemonstration

Die vom Autor beschriebenen Symptome sind: „Mir ist etwas schwindelig, ich muss mich übergeben und habe Halsschmerzen. Was soll ich tun?“ Es ist ersichtlich, dass MedGemma nicht nur verschiedene Lösungen für die „sofortige medizinische Behandlung“ und die „Selbstpflege“ bietet, sondern auch die möglichen Ursachen dieser Reihe von Symptomen aufzeigt.